Hunyuan Video | Video a Video

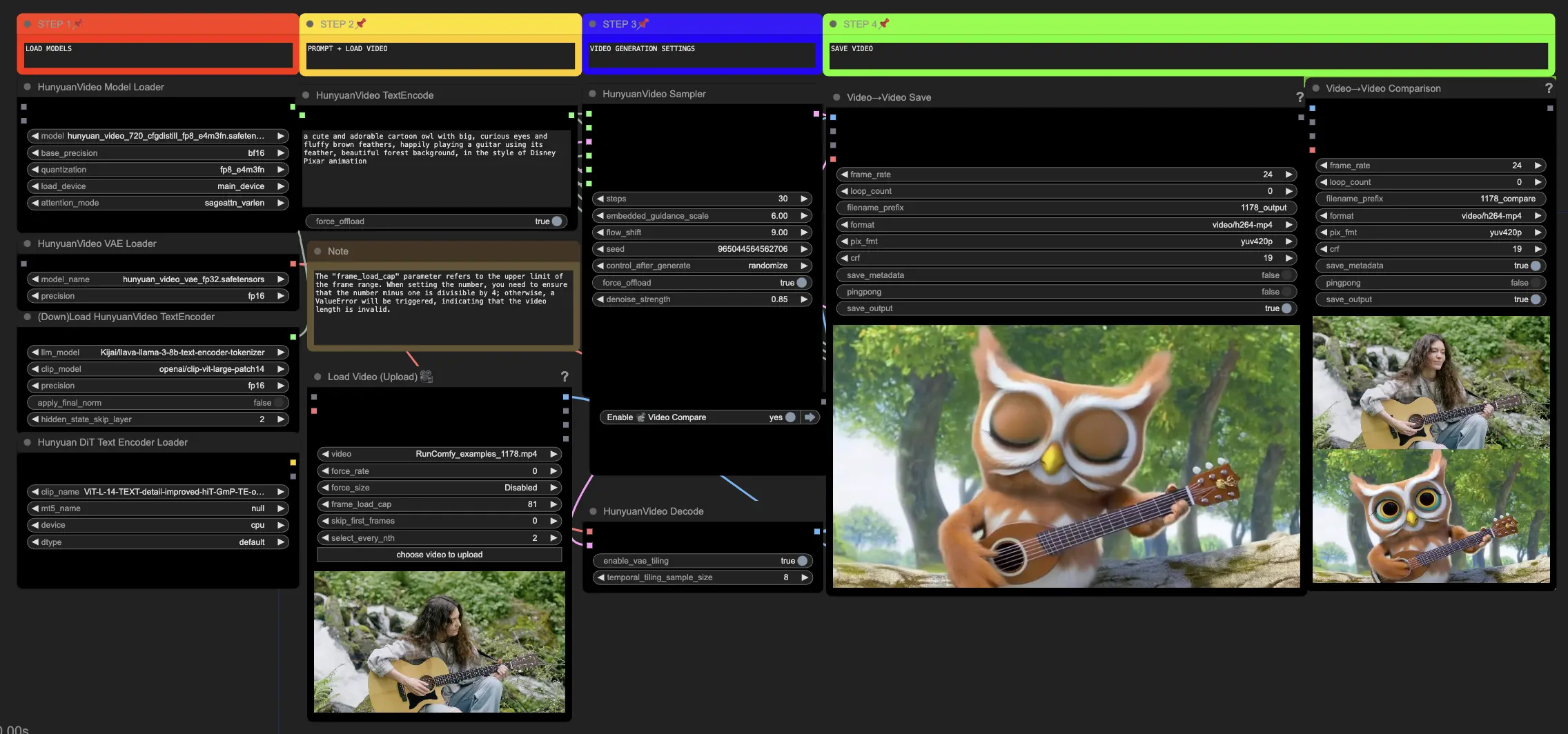

Este flujo de trabajo Hunyuan en ComfyUI te permite transformar visuales existentes en nuevos visuales impresionantes. Al ingresar avisos de texto y un video fuente, el modelo Hunyuan genera traducciones impresionantes que incorporan el movimiento y los elementos clave del origen. Con arquitectura avanzada y técnicas de entrenamiento, Hunyuan produce contenido de alta calidad, diverso y estable.ComfyUI Hunyuan Video to Video Flujo de trabajo

- Flujos de trabajo completamente operativos

- Sin nodos ni modelos faltantes

- No se requiere configuración manual

- Presenta visuales impresionantes

ComfyUI Hunyuan Video to Video Ejemplos

ComfyUI Hunyuan Video to Video Descripción

El video Hunyuan, un modelo de IA de código abierto desarrollado por Tencent, te permite generar visuales impresionantes y dinámicos con facilidad. El modelo Hunyuan aprovecha la arquitectura avanzada y las técnicas de entrenamiento para comprender y generar contenido de alta calidad, diversidad de movimiento y estabilidad.

Acerca del Flujo de Trabajo de Video a Video de Hunyuan

Este flujo de trabajo Hunyuan en ComfyUI utiliza el modelo Hunyuan para crear nuevo contenido visual combinando avisos de texto de entrada con un video conductor existente. Aprovechando las capacidades del modelo Hunyuan, puedes generar traducciones de video impresionantes que incorporan sin problemas el movimiento y los elementos clave del video conductor mientras alineas la salida con tu aviso de texto deseado.

Cómo Usar el Flujo de Trabajo de Video a Video de Hunyuan

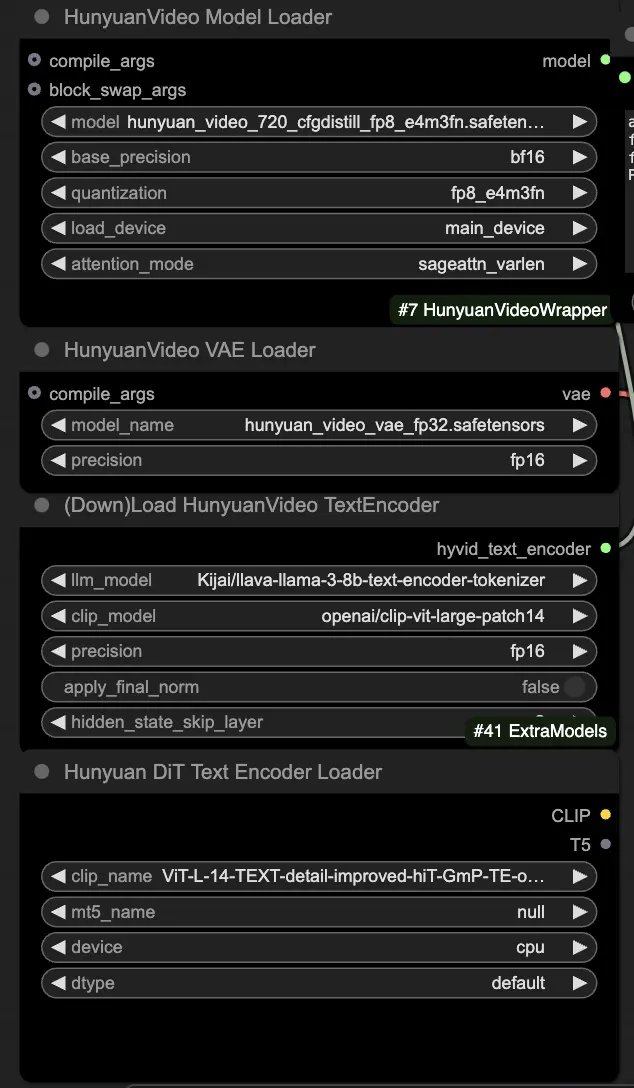

🟥 Paso 1: Cargar Modelos Hunyuan

- Carga el modelo Hunyuan seleccionando el archivo "hunyuan_video_720_cfgdistill_fp8_e4m3fn.safetensors" en el nodo HyVideoModelLoader. Este es el modelo transformador principal.

- El modelo HunyuanVideo VAE se descargará automáticamente en el nodo HunyuanVideoVAELoader. Se utiliza para codificar/decodificar fotogramas de video.

- Carga un codificador de texto en el nodo DownloadAndLoadHyVideoTextEncoder. El flujo de trabajo por defecto utiliza el codificador LLM "Kijai/llava-llama-3-8b-text-encoder-tokenizer" y el codificador CLIP "openai/clip-vit-large-patch14", que se descargarán automáticamente. También puedes usar otros codificadores CLIP o T5 que hayan funcionado con modelos anteriores.

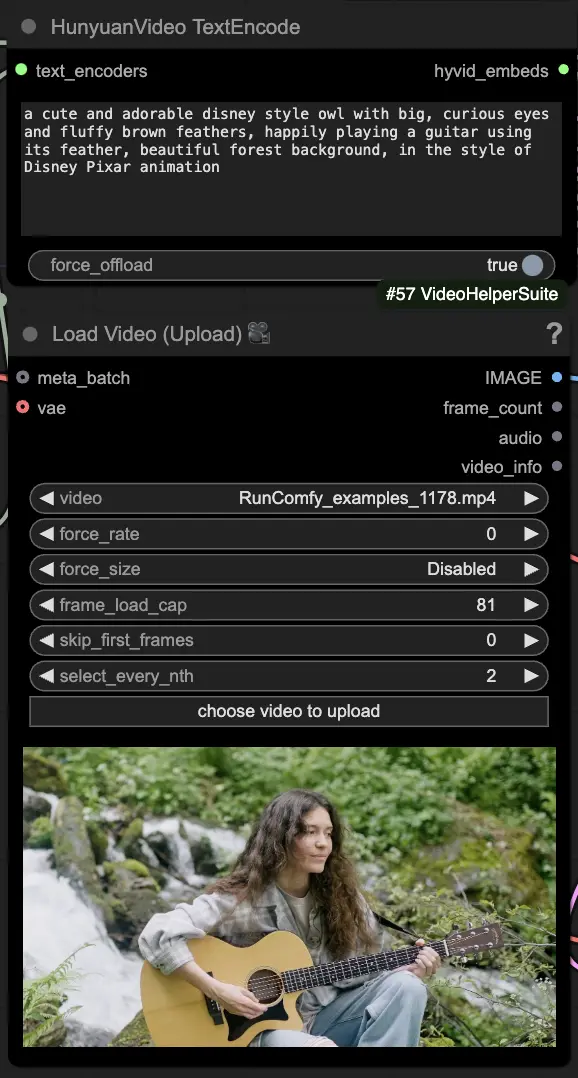

🟨 Paso 2: Introducir el Aviso y Cargar el Video Conductor

- Introduce tu aviso de texto describiendo el visual que deseas generar en el nodo HyVideoTextEncode.

- Carga el video conductor que deseas usar como referencia de movimiento en el nodo VHS_LoadVideo.

- frame_load_cap: Número de fotogramas a generar. Al establecer el número, debes asegurarte de que el número menos uno sea divisible por 4; de lo contrario, se generará un ValueError, indicando que la longitud del video es inválida.

- skip_first_frames: Ajusta este parámetro para controlar qué parte del video se utiliza.

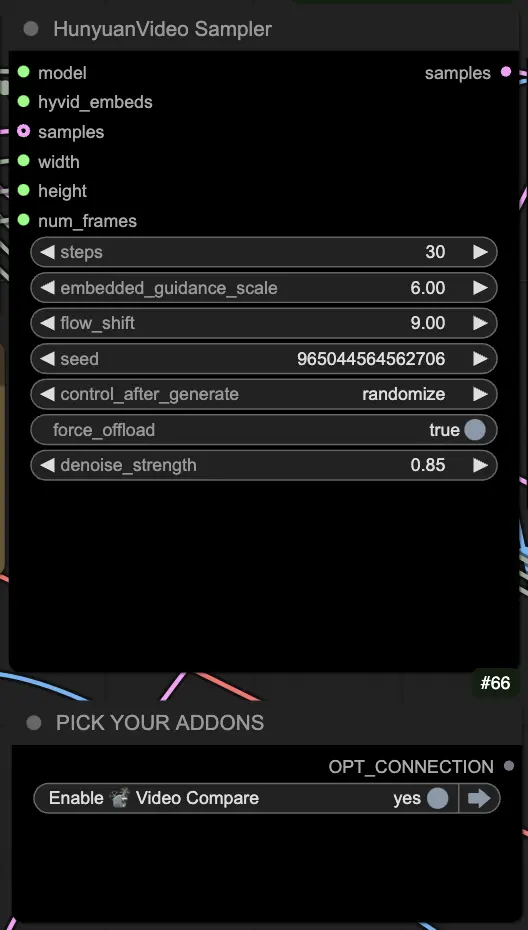

🟦 Paso 3: Configuraciones de Generación Hunyuan

- En el nodo HyVideoSampler, configura los hiperparámetros de generación de video:

- Steps: Número de pasos de difusión por fotograma, un número mayor significa mejor calidad pero generación más lenta. Por defecto 30.

- Embedded_guidance_scale: Cuánto adherirse al aviso, valores más altos se acercan más al aviso.

- Denoise_strength: Controla la fuerza de uso del video conductor inicial. Valores más bajos (por ejemplo, 0.6) hacen que la salida se parezca más al inicio.

- Elige complementos y alternadores en el nodo "Fast Groups Bypasser" para habilitar/deshabilitar funciones extra como el video de comparación.

🟩 Paso 4: Generar Video Huanyuan

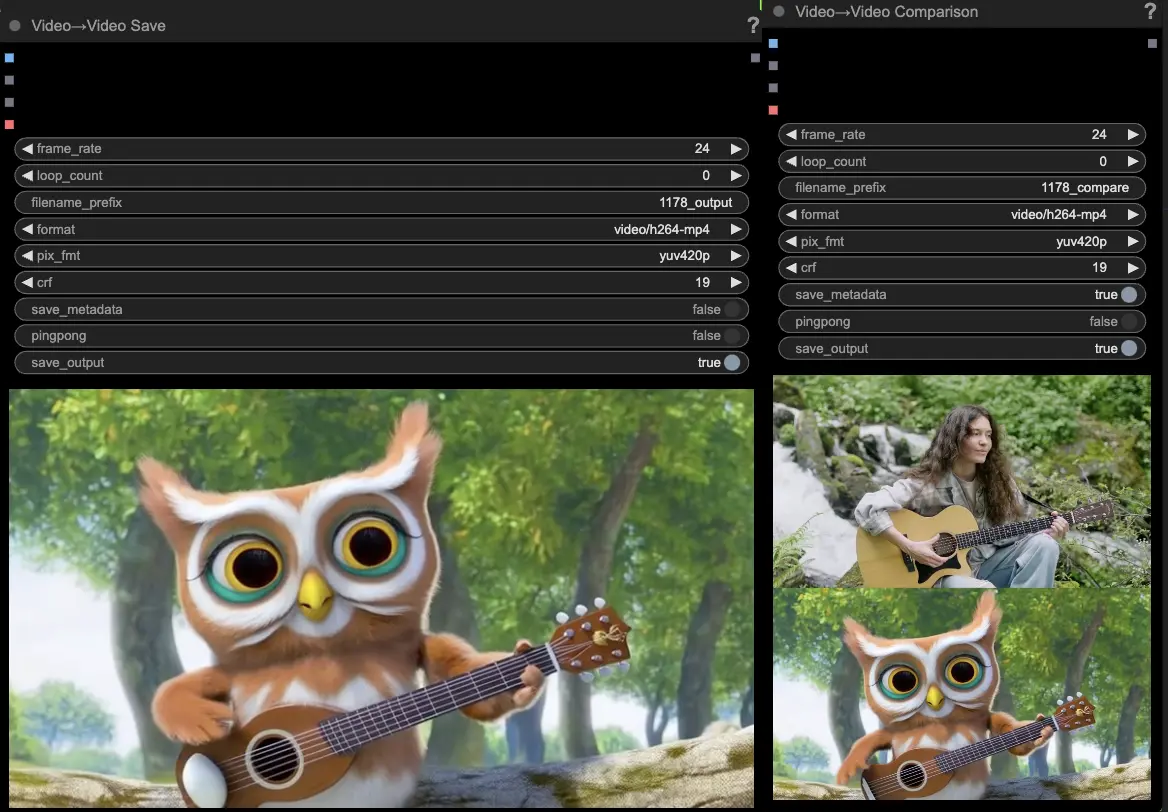

- Los nodos VideoCombine generarán y guardarán dos salidas por defecto:

- El resultado del video traducido

- Un video de comparación mostrando el video conductor y el resultado generado

Modificar el aviso y las configuraciones de generación permite una flexibilidad impresionante en la creación de nuevos videos impulsados por el movimiento de un video existente utilizando el modelo Hunyuan. Diviértete explorando las posibilidades creativas de este flujo de trabajo Hunyuan!

Este flujo de trabajo Hunyuan fue diseñado por Black Mixture. Por favor visita para más información. También agradecimientos especiales a nodos y ejemplos de flujo de trabajo.