Personaggi Coerenti con Flux

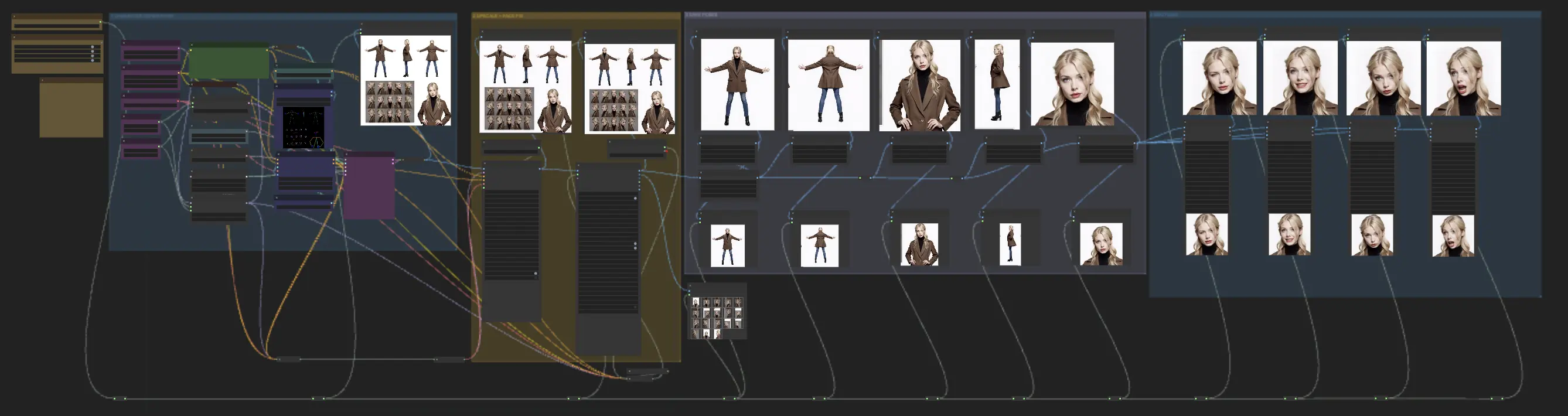

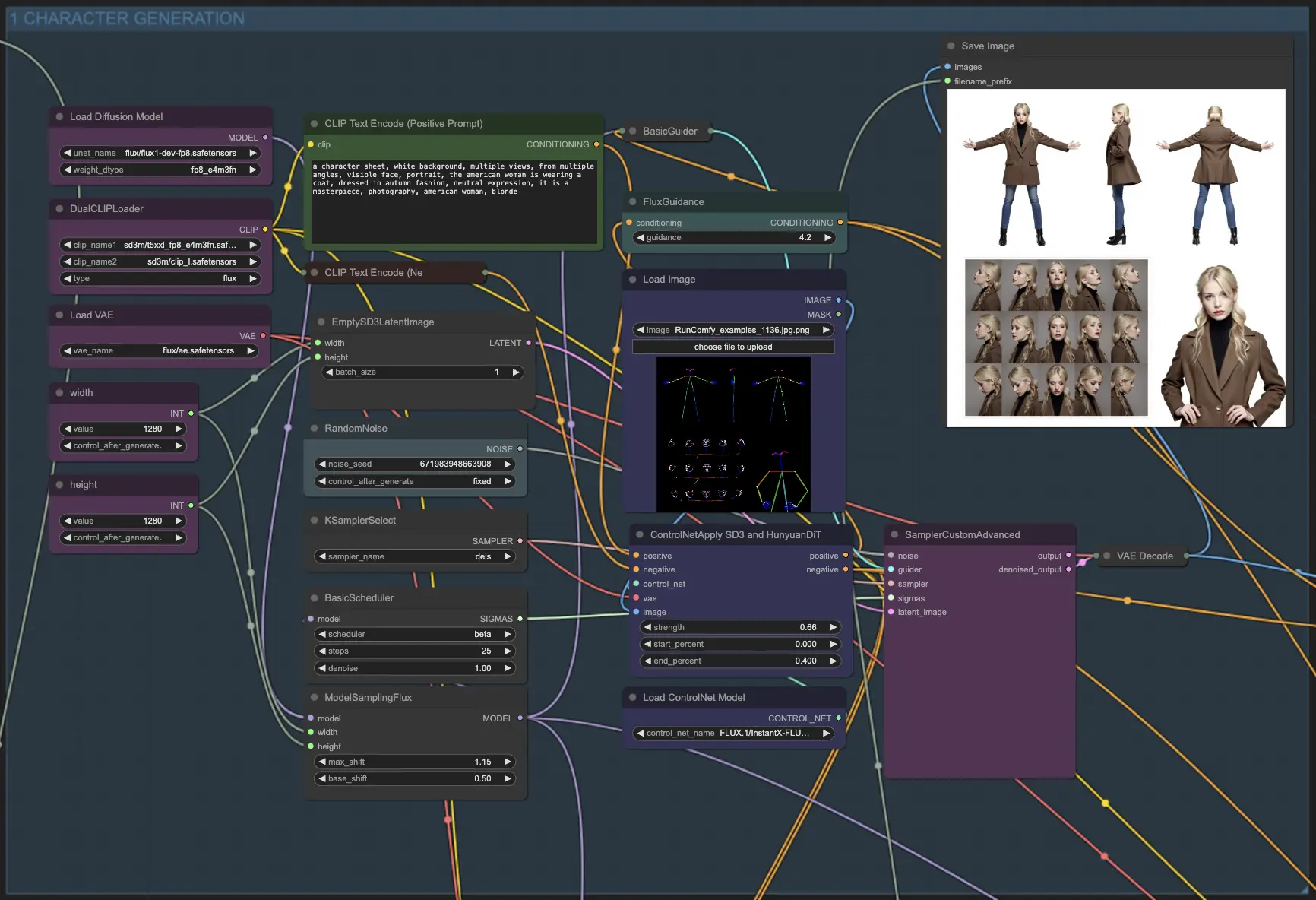

Il flusso di lavoro Personaggi Coerenti con Flux, creato da Mickmumpitz, è un potente strumento ComfyUI che mantiene la coerenza dei personaggi generati dall'AI su più output. Ideale per film AI cinematografici, libri per bambini o qualsiasi progetto che richieda apparizioni stabili dei personaggi, questo flusso di lavoro basato su Flux semplifica il processo di ottenere look uniformi dei personaggi, riducendo la necessità di più prompt e fine-tuning.ComfyUI Consistent Characters with Flux Flusso di lavoro

- Workflow completamente operativi

- Nessun nodo o modello mancante

- Nessuna configurazione manuale richiesta

- Presenta visuali mozzafiato

ComfyUI Consistent Characters with Flux Esempi

ComfyUI Consistent Characters with Flux Descrizione

Questo flusso di lavoro Personaggi Coerenti con Flux è stato creato da . Consigliamo vivamente di consultare il suo tutorial dettagliato per imparare a utilizzare efficacemente questo potente flusso di lavoro Personaggi Coerenti. Sebbene abbiamo riprodotto il flusso di lavoro Personaggi Coerenti e impostato l'ambiente per la tua comodità, tutti i meriti vanno a Mickmumpitz per il suo eccellente lavoro nello sviluppo di questa soluzione Personaggi Coerenti basata su Flux.

I Personaggi Coerenti con Flux

Il flusso di lavoro Personaggi Coerenti con Flux è un potente strumento ComfyUI che mantiene la coerenza dei personaggi generati dall'AI su più output. È ideale per creare film AI cinematografici, libri per bambini o qualsiasi progetto che richieda apparizioni stabili dei Personaggi Coerenti. Questo flusso di lavoro basato su Flux semplifica il processo di ottenere apparizioni uniformi dei Personaggi Coerenti, riducendo la necessità di più prompt e fine-tuning. Utilizzando il modello dev di Flux.1, migliora la stabilità dei Personaggi Coerenti generati, assicurando che mantengano lo stesso aspetto e sensazione, sia animati che resi realisticamente.

Come utilizzare il flusso di lavoro Personaggi Coerenti con Flux?

Il flusso di lavoro Personaggi Coerenti con Flux è diviso in quattro moduli (Generazione Personaggi, Upscale + Correzione Viso, Pose, Emozioni), ciascuno progettato per ottimizzare il processo di generazione di Personaggi Coerenti con un aspetto uniforme su più output.

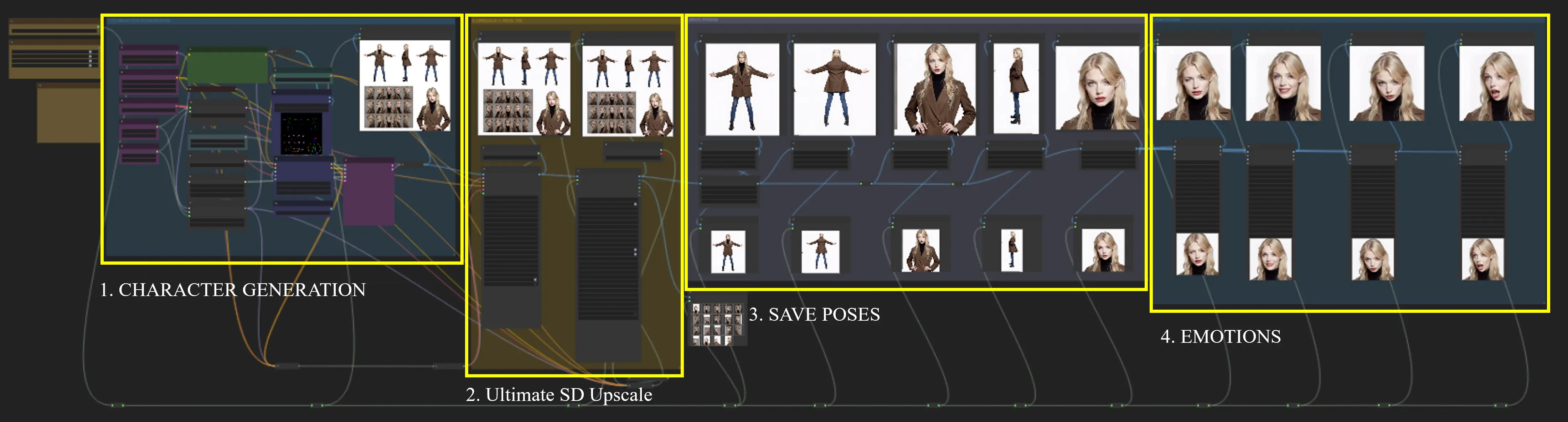

Nodo Fast Groups Muter (rgthree)

Dopo aver caricato il nodo Fast Groups Muter (rgthree), i moduli 2, 3 e 4 vengono eseguiti automaticamente, e non è richiesta alcuna configurazione aggiuntiva. Questo nodo controlla gli interruttori per tutti e quattro i moduli, rendendo il processo dei Personaggi Coerenti più fluido ed efficiente.

Controllo del modulo del nodo Fast Groups Muter (rgthree) (sì/no).

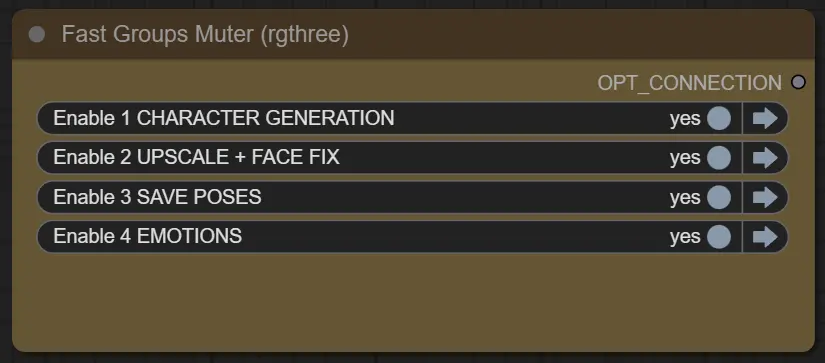

1. Generazione Personaggi

Questo modulo utilizza i modelli Flux e il modello Flux ControlNet per generare una tabella di Personaggi Coerenti guidando il processo di generazione con prompt. L'input, che è un foglio di pose, funge da riferimento per guidare la generazione dei Personaggi Coerenti. Creando prompt appropriati, puoi guidare il modello a creare i fogli di Personaggi Coerenti desiderati.

Ecco alcuni esempi di prompt:

Un foglio di personaggi con una donna americana che indossa un cappotto, vestita in moda autunnale, con un'espressione neutra. Il foglio dovrebbe avere uno sfondo bianco, viste multiple da varie angolazioni e un ritratto del viso visibile. Lo stile generale dovrebbe assomigliare a una fotografia capolavoro.

Un foglio di personaggi che rappresenta un ranger elfico con un mantello fatto di foglie autunnali, vestito con colori della foresta, con un'espressione determinata. Il foglio dovrebbe avere uno sfondo di pergamena, viste multiple da angolazioni diverse e un ritratto del viso visibile. Il ranger dovrebbe essere accompagnato da un maestoso cervo, portando un arco lungo e una faretra sulla schiena. Lo stile generale dovrebbe assomigliare a un dipinto digitale capolavoro di un'elfa con lunghi capelli dorati.

Consiglio: Se il foglio di Personaggi Coerenti generato non soddisfa le tue aspettative, prova a regolare il valore del seed per rigenerare l'output con variazioni.

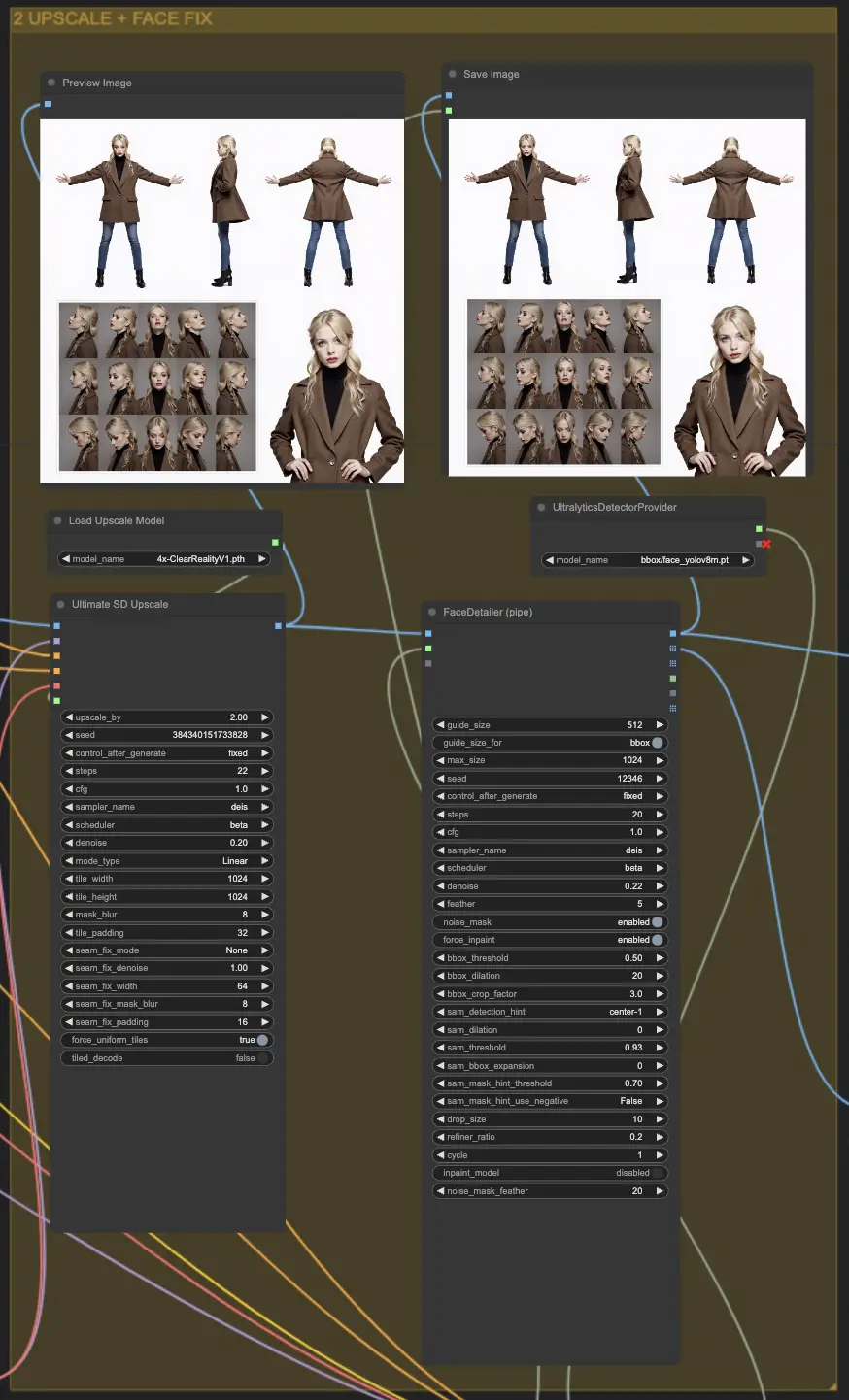

2. Upscale + Correzione Viso

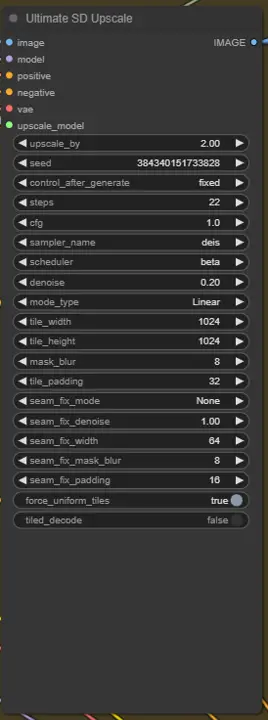

2.1 Ultimate SD Upscale

Ultimate SD Upscale è un nodo utilizzato nelle pipeline di generazione di immagini per migliorare la risoluzione dell'immagine dividendo l'immagine in riquadri più piccoli, elaborando ciascun riquadro individualmente e poi ricucendoli insieme. Questo processo consente di generare immagini ad alta risoluzione gestendo l'uso della memoria e riducendo gli artefatti che possono verificarsi durante l'upscaling.

Parametri:

upscale_by: Il fattore di moltiplicazione della larghezza e dell'altezza dell'immagine. Per dimensioni precise, usa la versione "No Upscale".seed: Controlla la casualità nel processo di generazione. Utilizzare lo stesso seed produce gli stessi risultati.control_after_generate: Regola i dettagli dell'immagine post-generazione.steps: Il numero di iterazioni durante la generazione dell'immagine. Più passi producono dettagli più fini ma richiedono più tempo di elaborazione.cfg: Scala di Guida Senza Classificatore che regola quanto strettamente il modello segue i prompt di input.sampler_name: Specifica il metodo di campionamento utilizzato per la generazione delle immagini.scheduler: Definisce come le risorse computazionali sono allocate durante la generazione.denoise: Controlla il livello di rimozione del rumore, influenzando la conservazione dei dettagli dall'immagine originale. Consigliato: 0,35 per miglioramenti, 0,15-0,20 per cambiamenti minimi.mode_type: Determina il modo di elaborazione, come vengono elaborati i riquadri.tile_widthetile_height: Dimensioni dei riquadri utilizzati nell'elaborazione. Dimensioni maggiori riducono le cuciture ma richiedono più memoria.mask_blur: Sfoca i bordi delle maschere utilizzate per la fusione dei riquadri, lisciando le transizioni tra i riquadri.tile_padding: Numero di pixel dei riquadri vicini considerati durante l'elaborazione per ridurre le cuciture.seam_fix_mode: Metodo per correggere le cuciture visibili tra i riquadri:- Bands pass: Corregge le cuciture lungo righe e colonne.

- Half tile offset pass: Applica un offset per meglio fondere le cuciture.

- Half tile offset + intersections pass: Include passaggi aggiuntivi alle intersezioni.

seam_fix_denoise: Intensità della riduzione del rumore durante la correzione delle cuciture.seam_fix_width: Larghezza delle aree elaborate durante la correzione delle cuciture.seam_fix_mask_blur: Sfoca la maschera per correzioni delle cuciture più lisce.seam_fix_padding: Padding intorno alle cuciture durante la correzione per garantire risultati più lisci.force_uniform_tiles: Assicura che i riquadri mantengano una dimensione uniforme estendendo i riquadri ai bordi quando necessario, minimizzando gli artefatti.tiled_decode: Elabora i riquadri delle immagini individualmente per ridurre l'uso della memoria durante la generazione ad alta risoluzione.- Target size type: Determina come viene impostata la dimensione finale dell'immagine:

- From img2img settings: Usa larghezza e altezza predefinite.

- Custom size: Consente di impostare manualmente larghezza e altezza (max 8192px).

- Scale from image size: Scala in base alla dimensione iniziale dell'immagine.

- Upscaler: Il metodo per l'upscaling delle immagini prima dell'ulteriore elaborazione (es. ESRGAN).

- Redraw: Controlla come l'immagine viene ridisegnata:

- Linear: Elabora i riquadri in sequenza.

- Chess: Utilizza un pattern a scacchiera per l'elaborazione per ridurre gli artefatti.

- None: Disabilita il ridisegno, concentrandosi solo sulla correzione delle cuciture.

2.2. FaceDetailer (pipe)

FaceDetailerPipe è un nodo progettato per migliorare i dettagli del viso nelle immagini, utilizzando tecniche avanzate di elaborazione delle immagini per migliorare la nitidezza e la chiarezza delle caratteristiche facciali. Fa parte del ComfyUI Impact Pack, con l'obiettivo di fornire miglioramenti di alta qualità dei dettagli facciali per varie applicazioni.

Parametri:

image: L'immagine di input da migliorare, che funge da soggetto principale per il dettaglio facciale.guide_size: Un parametro che controlla la dimensione dell'area di guida utilizzata per migliorare le caratteristiche facciali, influenzando quanto contesto viene considerato.guide_size_for: Determina se la dimensione della guida deve essere applicata per regioni specifiche.max_size: Imposta il limite massimo di dimensione per le immagini elaborate, garantendo la gestione della memoria.seed: Controlla la casualità nel processo di miglioramento delle immagini, consentendo risultati riproducibili utilizzando lo stesso seed.steps: Il numero di iterazioni per migliorare i dettagli. Più passaggi producono dettagli più fini ma richiedono più tempo di elaborazione.cfg: La scala di Guida Senza Classificatore, che regola quanto strettamente il modello segue la guida di input.sampler_name: Definisce il metodo di campionamento utilizzato per il raffinamento dei dettagli.scheduler: Determina la strategia di pianificazione computazionale durante l'elaborazione.denoise: Controlla la forza della riduzione del rumore applicata durante il processo di miglioramento. Valori più bassi mantengono più dettagli originali, mentre valori più alti producono risultati più lisci.feather: Controlla la levigatezza della transizione tra aree migliorate e originali, aiutando a fondere i cambiamenti senza soluzione di continuità.noise_mask: Abilita o disabilita l'uso di una maschera di rumore per mirare a specifiche aree per la riduzione del rumore.force_inpaint: Forza il ritocco in regioni che necessitano di miglioramenti o correzioni aggiuntivi.bbox_threshold: Imposta la soglia per il rilevamento delle caselle di delimitazione attorno alle caratteristiche facciali, influenzando la sensibilità.bbox_dilation: Espande le aree di caselle di delimitazione rilevate per garantire che tutte le caratteristiche rilevanti siano incluse durante il miglioramento.bbox_crop_factor: Regola il fattore di ritaglio per le caselle di delimitazione rilevate, controllando l'area di messa a fuoco per il miglioramento.sam_detection_hint: Specifica suggerimenti o guide aggiuntivi per il processo di rilevamento.sam_dilation: Regola la dilatazione applicata alle regioni rilevate, consentendo una copertura più ampia.sam_threshold: Definisce la soglia per la sensibilità del rilevamento all'interno del processo SAM (Segment Anything Model).sam_bbox_expansion: Espande le caselle di delimitazione rilevate dal SAM, aiutando a includere più contesto circostante.sam_mask_hint_threshold: Regola la soglia per i suggerimenti delle maschere forniti dal SAM, controllando come le regioni sono definite per la mascheratura.sam_mask_hint_use_negative: Determina se utilizzare suggerimenti negativi, influenzando la mascheratura di determinate regioni.drop_size: Imposta la dimensione delle gocce applicate durante il processo di miglioramento, che può influenzare il livello di raffinamento.refiner_ratio: Controlla il rapporto per il raffinamento dei dettagli facciali, bilanciando tra la conservazione delle caratteristiche originali e l'aggiunta di chiarezza.cycle: Specifica il numero di cicli di raffinamento da applicare, influenzando la profondità del miglioramento.- inpaint_model (Optional): Abilita l'uso di un modello di ritocco per riempire aree mancanti o poco chiare durante il processo di dettaglio.

noise_mask_feather: Regola la sfumatura della maschera di rumore, fornendo una transizione più liscia tra aree rumorose e denoise.

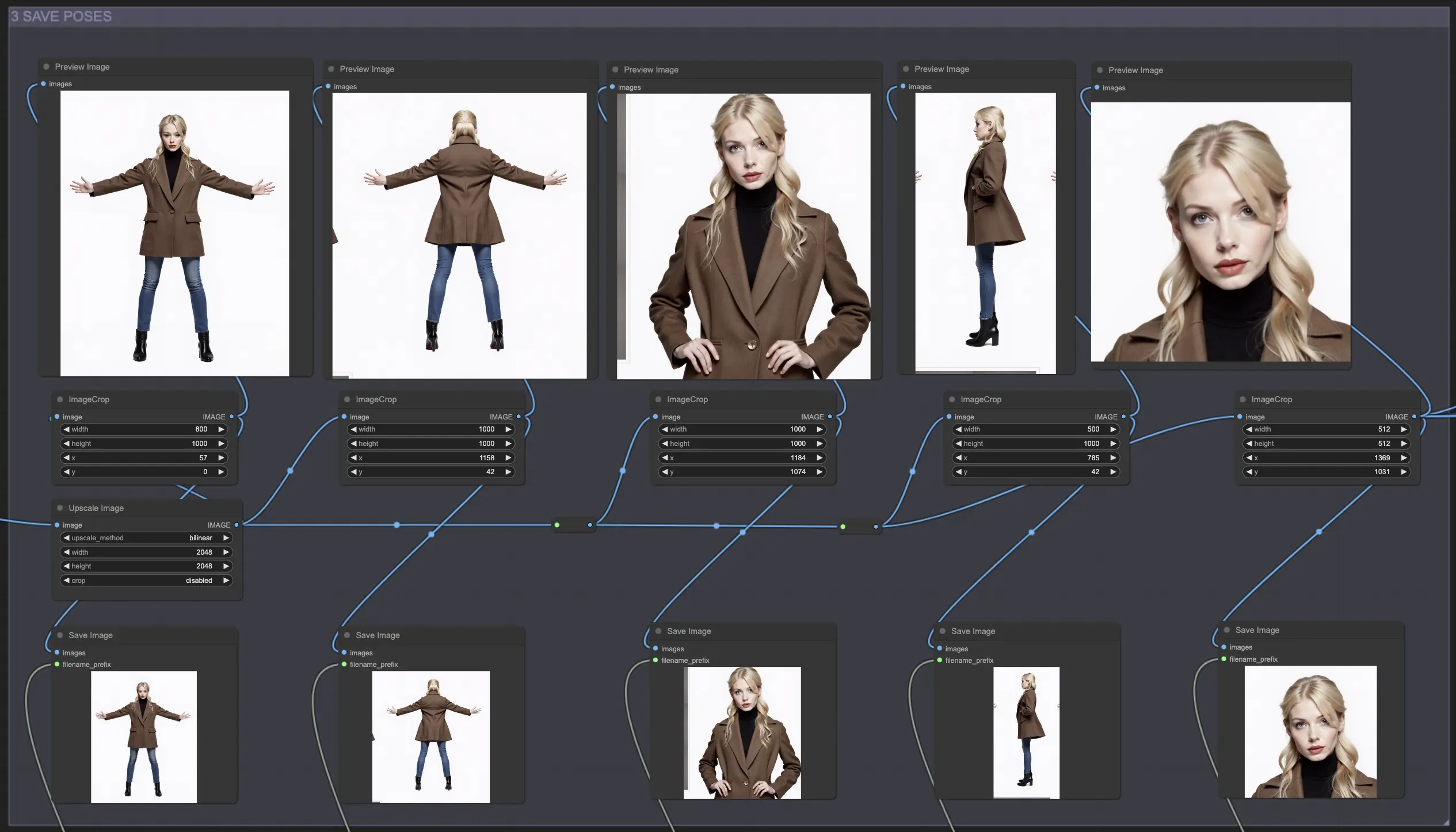

3. Pose

Questo modulo ti consente di utilizzare il nodo di ritaglio immagine per separare ogni posa dal foglio di personaggi generato e salvare le pose individuali del personaggio per un uso o regolazioni future.

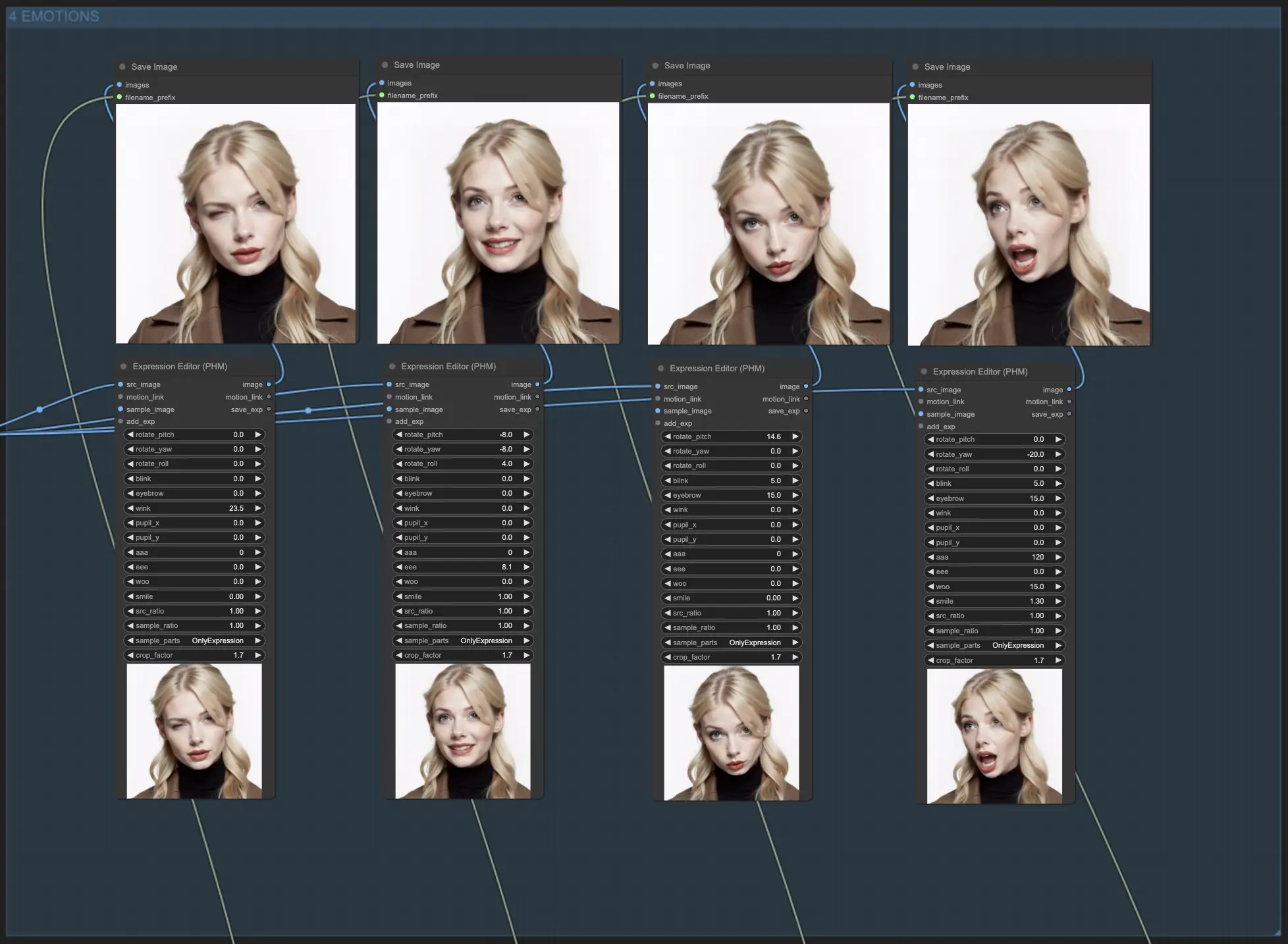

4. Emozioni

Questo modulo utilizza il nodo Photo Expression Editor (PHM) per regolare le espressioni facciali nelle foto. I parametri consentono di perfezionare vari aspetti facciali, come i movimenti della testa, il battito delle palpebre e il sorriso.

Parametri dell'Editor di Espressione:

rotate_pitch: Controlla il movimento su e giù della testa.rotate_yaw: Regola il movimento laterale della testa.rotate_roll: Determina l'angolo di inclinazione della testa.blink: Controlla l'intensità dei battiti di ciglia.eyebrow: Regola i movimenti delle sopracciglia.wink: Controlla l'ammiccamento.pupil_x: Muove le pupille orizzontalmente.pupil_y: Muove le pupille verticalmente.aaa: Controlla la forma della bocca per il suono vocale "aaa".eee: Controlla la forma della bocca per il suono vocale "eee".woo: Controlla la forma della bocca per il suono vocale "woo".smile: Regola il grado di un sorriso.src_ratio: Determina il rapporto dell'espressione sorgente da applicare.sample_ratio: Determina il rapporto dell'espressione campione da applicare.sample_parts: Specifica quali parti dell'espressione campione applicare ("OnlyExpression", "OnlyRotation", "OnlyMouth", "OnlyEyes", "All").crop_factor: Controlla il fattore di ritaglio della regione del viso.

I modelli Flux e i moduli semplificati del flusso di lavoro rendono facile per te mantenere le apparizioni dei Personaggi Coerenti su vari output. Sarai in grado di dare vita ai tuoi personaggi come mai prima, creando un'esperienza veramente immersiva per il tuo pubblico!