このガイドは、"Wonder3D"モデルを使用して3Dコンテンツを作成するための包括的な紹介を提供し、"ComfyUI 3D Pack"ノードの高度な機能を活用してワークフローを効率化し、出力品質を向上させます。

パート1: ComfyUI 3D Pack

1.1. ComfyUI 3D Packの紹介

ComfyUI 3D Packは、メッシュやUVテクスチャなどの3D入力を処理するための広範なノードスイートであり、最先端のアルゴリズムやモデルを使用してComfyUIを強化します。3DGS(Gaussian Splatting)やNeRF(Neural Radiance Fields)といった高度な3D処理アルゴリズムを統合し、Hunyuan3D、StableFast3D、InstantMesh、CRM、TripoSRなどの最先端モデルを含みます。

ComfyUI 3D Packを使用すると、ユーザーは直感的なComfyUIインターフェース内で高品質な3Dコンテンツをインポート、操作、生成できます。OBJ、PLY、GLBなどの幅広い3Dファイル形式をサポートし、既存の3Dモデルの統合を容易にします。このパックには、3Dジオメトリを編集、クリーンアップ、最適化するための強力なメッシュ処理ユーティリティも含まれています。

注目すべき点の一つは、2D画像からのフォトリアリスティックな3D再構築を可能にするNeRF技術の統合です。3DGSノードはポイントクラウドのレンダリングとスタイライズを可能にします。InstantMeshとTripoSRモデルは、3Dメッシュの高解像度アップスケーリングとスーパー解像度を可能にします。CRM(Convolutional Reconstruction Model)は、マルチビュー画像から3D形状を復元し、CCM(Color Correction Map)を提供します。

ComfyUI 3D Packは、MrForExampleによって開発され、すべてのクレジットはMrForExampleに帰属します。詳細情報は、ComfyUI 3D Packをご覧ください。

1.2. ComfyUI 3D Pack: RunComfyで実行可能

現在、ComfyUI 3D Packは完全にセットアップされ、RunComfyウェブサイトで使用可能です。ユーザーは追加のソフトウェアや依存関係をインストールする必要はありません。必要なモデル、アルゴリズム、ツールはすべて事前に設定され、ウェブベースのComfyUI環境で効率よく動作するように最適化されています。

パート2: ComfyUI 3D Packノードを使用したWonder3Dモデルの使用

2.1. Wonder3Dとは?

Wonder3Dは、単一ビュー画像から高品質なテクスチャ付きメッシュを効率的に生成するための最先端の方法です。クロスドメイン拡散モデルの力を利用して、マルチビュー法線マップとそれに対応するカラー画像を生成します。Wonder3Dは、単一ビュー3D再構築タスクにおける忠実性、一貫性、一般化可能性、効率性の課題に対処することを目的としています。

Wonder3Dは、香港大学、清華大学、VAST、ペンシルバニア大学、上海科技大学、MPI Informatik、テキサスA&M大学の研究者チームによって開発され、Xiaoxiao LongとYuan-Chen Guoが同等の貢献をした最初の著者です。すべてのクレジットは彼らの貢献に帰属します。詳細については、彼らのプロジェクトページをこちらでご覧ください。

2.2. Wonder3Dの背後にある技術

Wonder3Dの核心は、その革新的なクロスドメイン拡散モデルにあります。このモデルは、複数のビューにわたる法線マップとカラー画像の結合分布をキャプチャするように設計されています。これを達成するために、Wonder3Dはドメインスイッチャーとクロスドメインアテンションスキームを導入しています。ドメインスイッチャーは、法線マップまたはカラー画像のシームレスな生成を可能にし、クロスドメインアテンションメカニズムは、2つのドメイン間の情報交換を促進し、一貫性と品質を向上させます。

Wonder3Dのもう一つの重要な要素は、そのジオメトリ認識法線融合アルゴリズムです。このアルゴリズムは、不正確さがある場合でも、生成されたマルチビュー2D表現から高品質な表面を堅牢に抽出します。法線マップとカラー画像にエンコードされた豊富な表面詳細を活用することにより、Wonder3Dはクリーンで詳細なジオメトリを再構築します。

2.3. Wonder3Dの利点/可能性のある制限

Wonder3Dは、既存の単一ビュー再構築手法に対していくつかの利点を提供します。それは、良好な効率を維持しながら、幾何学的詳細を高いレベルで達成し、様々なアプリケーションに適しています。クロスドメイン拡散モデルは、Wonder3Dが異なるオブジェクトカテゴリやスタイルにうまく一般化することを可能にします。クロスドメインアテンションメカニズムによって強制されるマルチビューの一貫性は、一貫性のある信頼性の高い3D再構築をもたらします。

しかし、どの方法にも限界があるように、Wonder3Dにもいくつかの制限があるかもしれません。生成されたメッシュの品質は、トレーニングデータと拡散モデルが基礎となる3D構造をキャプチャする能力に依存します。非常に複雑または曖昧な形状は課題を提起する可能性があります。さらに、Wonder3Dの現在の実装は単一のオブジェクトに焦点を当てており、複数のオブジェクトや全体のシーンを扱うことに拡張することは将来の研究の分野となる可能性があります。

2.4. Wonder3Dワークフローの使用方法

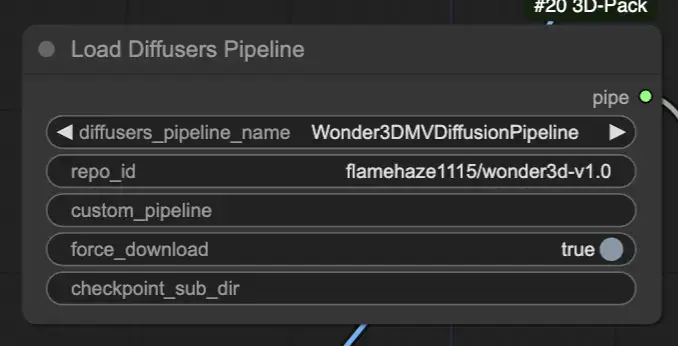

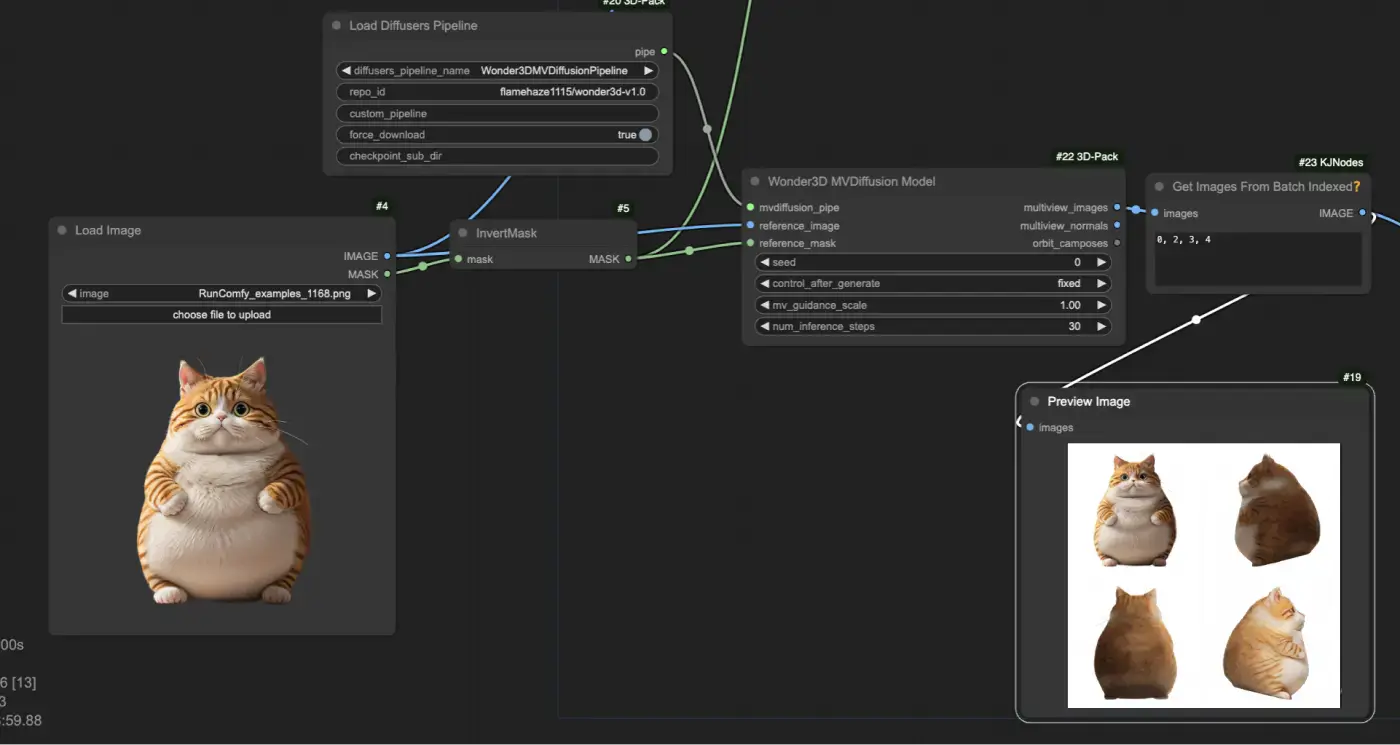

"[Comfy3D] Load Diffusers Pipeline"ノードを使用して、事前にトレーニングされたWonder3D拡散パイプラインをロードし、必要なモデルチェックポイントと構成をインポートします。

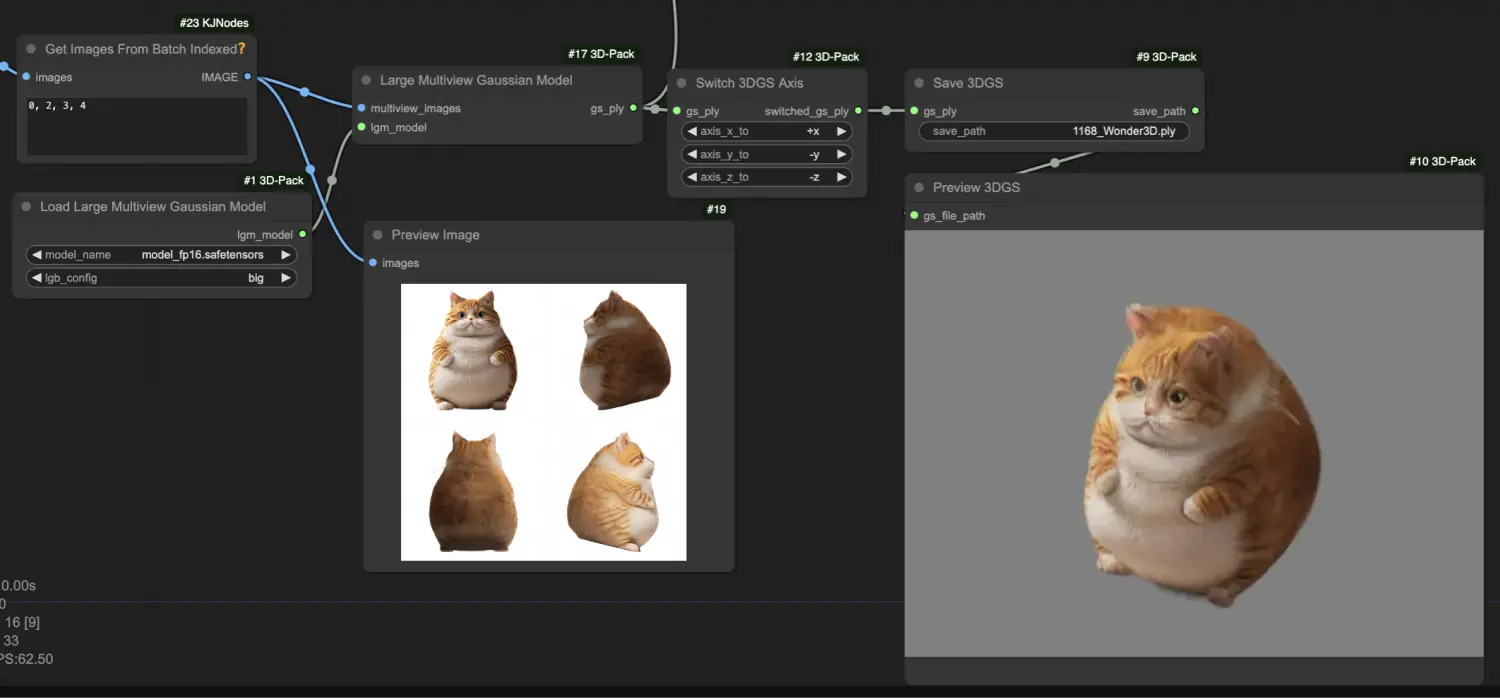

"LoadImage"および"InvertMask"ノードを使用して入力画像とその対応するマスクを提供します。その後、入力画像とマスクを"[Comfy3D] Wonder3D MVDiffusion Model"ノードにフィードし、マルチビュー法線マップとカラー画像を生成します。

生成されたマルチビュー画像を"[Comfy3D] Large Multiview Gaussian Model"ノードで処理し、それらを3D Gaussian Splatting (3DGS) 表現に変換し、ポイントクラウド形式でオブジェクトの幾何学的詳細をキャプチャします。

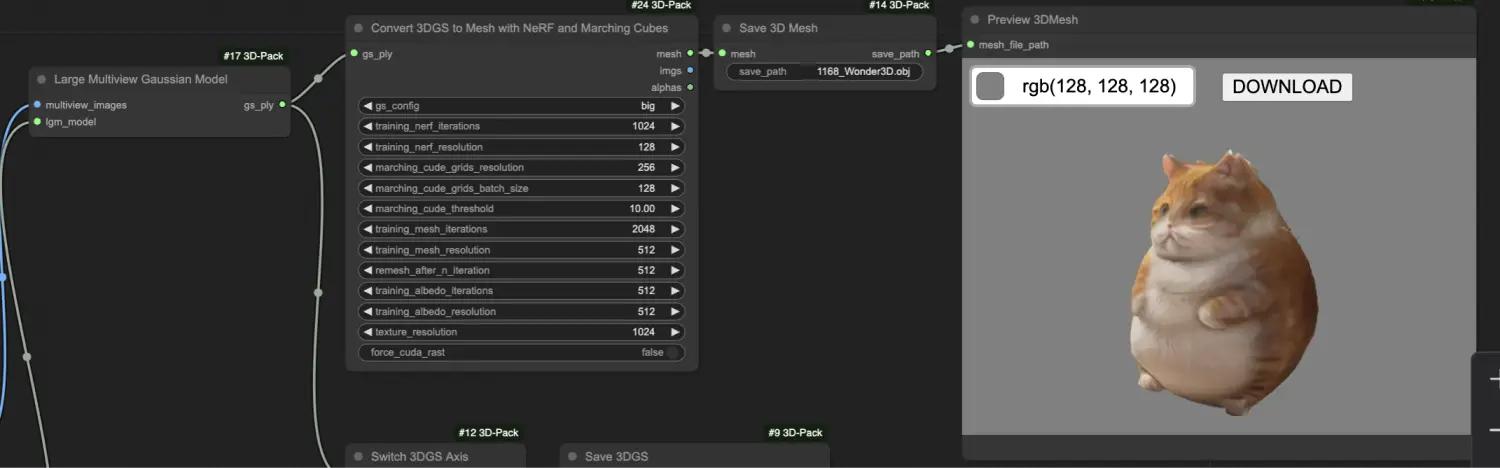

"[Comfy3D] Convert 3DGS to Mesh with NeRF and Marching Cubes"ノードを使用して、3DGS表現をテクスチャ付きメッシュに変換し、ニューラルラジアンスフィールド(NeRF)とマーチングキューブアルゴリズムを使用して高品質なメッシュを抽出します。