1. ComfyUI AnimateLCM 워크플로우

ComfyUI AnimateLCM 워크플로우는 AI 애니메이션 속도를 향상시키기 위해 설계되었습니다. ComfyUI-AnimateDiff-Evolved의 기반 위에서, 이 워크플로우는 특히 텍스트 기반 비디오(t2v) 애니메이션 제작 속도를 가속화하기 위해 AnimateLCM을 통합합니다. 다양한 프롬프트와 단계를 실험하여 원하는 결과를 얻을 수 있습니다.

2. AnimateLCM 개요

SDXL, LCM, SDXL Turbo와 같은 기술의 출현으로 이미지 생성 속도가 크게 향상되었습니다. AnimateLCM은 AI 애니메이션의 발전을 더욱 가속화합니다. 이는 이미지 기반 비디오 생성 속도를 지원하며, 정적 이미지나 텍스트 설명에서 애니메이션 비디오를 제작하는 속도와 효율성을 높이는 데 초점을 맞추고 있어, 개인화된 애니메이션 효과를 빠르게 제작하는 데 특히 유용합니다.

2.1. AnimateLCM 소개

AnimateLCM은 분리된 일관성 학습을 통해 개인화된 확산 모델과 어댑터의 애니메이션 속도를 가속화하도록 설계되었습니다. 이는 사전 학습된 이미지 확산 모델을 증류하여 샘플링 프로세스를 가속화하는 Consistency Model(CM)과 조건부 이미지 생성에 초점을 맞춘 확장인 Latent Consistency Model(LCM)에서 영감을 받았습니다. AnimateLCM은 이러한 기반을 활용하여 몇 단계만으로 고품질의 비디오를 생성할 수 있게 하며, 이미지 확산과 생성 기술의 성공을 기반으로 그 능력을 비디오 영역으로 확장합니다.

2.2. ComfyUI 워크플로우에서 AnimateLCM 사용 방법

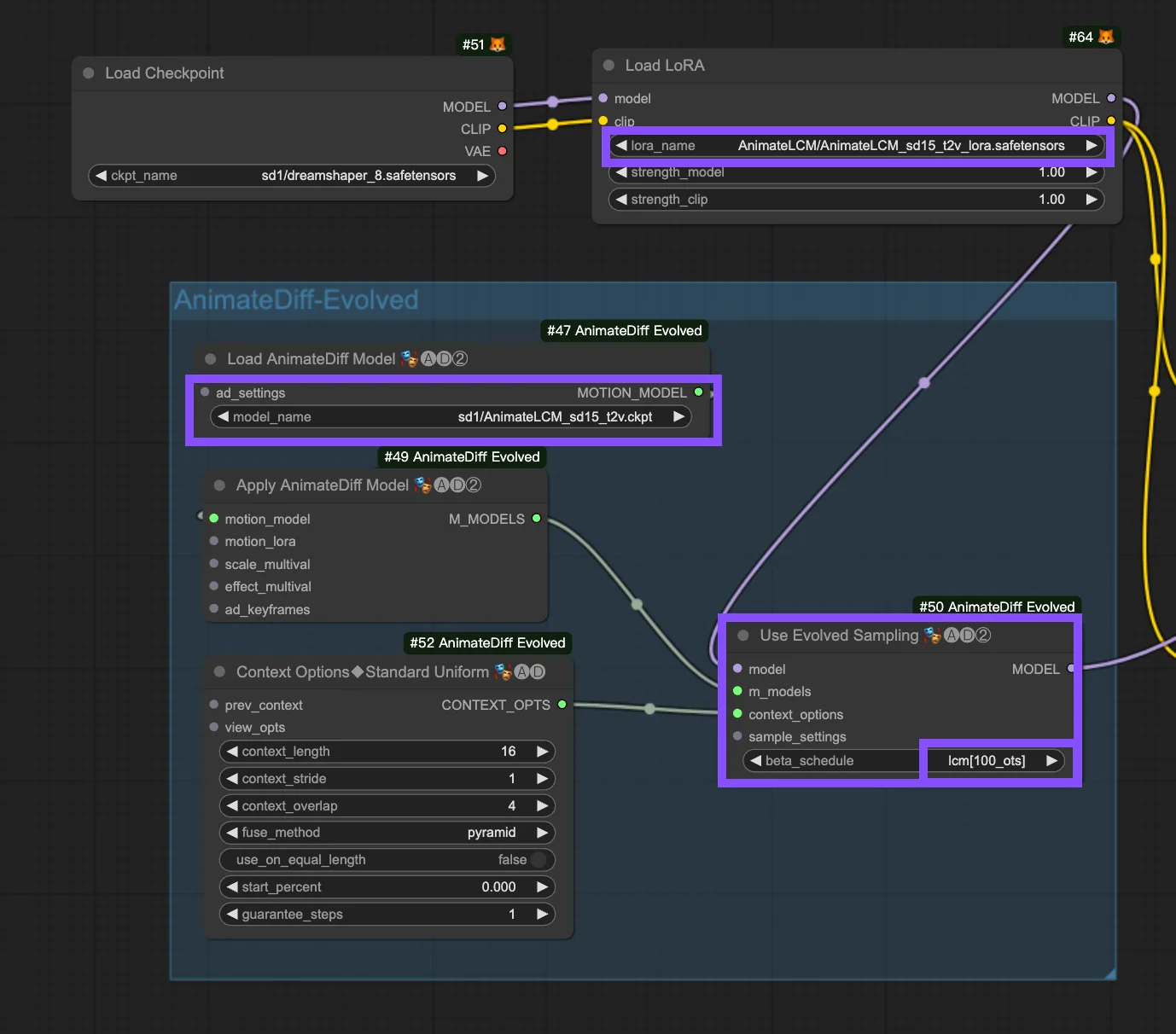

이 워크플로우는 ComfyUI-AnimateDiff-Evolved 워크플로우를 기반으로 합니다. 다음은 "Use Evolved Sampling" 노드의 구성 매개변수입니다.

Models: 체크포인트 모델과 LoRA 모델을 설정합니다.

- Checkpoint: 애니메이션 제작에 사용되는 StableDiffusion(SD) 모델 입력과 관련이 있습니다. 선택한 모션 모델에 따라 SD1.5나 SDXL과 같은 SD 버전 간 호환성이 다를 수 있습니다.

- LoRA: AnimateLCM LoRA 모델을 통합하여 다양한 기능을 위한 기존 어댑터를 원활하게 통합하고, 샘플링 속도를 희생하지 않으면서 일관성 학습에 초점을 맞춰 효율성과 출력 품질을 향상시킵니다.

Motion Models (M Models): Apply AnimateDiff Model 프로세스의 출력으로, AnimateLCM Motion Model을 사용할 수 있게 합니다.

Context Options: 이러한 설정은 애니메이션 제작 중 AnimateDiff의 작동 방식을 조정하여 전체 Unet에 걸쳐 또는 모션 모듈 내에서 슬라이딩 컨텍스트 윈도우를 통해 임의 길이의 애니메이션을 가능하게 하며, 복잡한 애니메이션 시퀀스에 대한 타이밍 조정도 가능하게 합니다. AnimateDiff에 대한 종합 가이드를 참조하세요.

Beta Schedule in Sample Settings: LCM을 선택하세요. ComfyUI의 AnimateDiff 샘플 설정에서 "lcm", "lineart" 등을 포함한 "beta schedule" 선택은 확산 프로세스 전반에 걸쳐 노이즈 수준을 조절하는 beta 값을 미세 조정합니다. 이 사용자 정의는 애니메이션의 시각적 스타일과 유동성에 영향을 미칩니다. 각 설정은 특정 애니메이션 또는 모션 모델 요구 사항에 맞춰져 있습니다.

- LCM(Latent Consistency Module): "lcm" 설정은 LCM LoRA에 맞춰져 있으며, 애니메이션 균일성을 높이고 제작 시간을 단축시킵니다. 더 적은 단계로 더 빠른 수렴을 달성하며, 최적의 디테일 유지를 위해서는 단계 감소(최소 ~4 단계)와 기타 매개변수 조정이 필요합니다.

- Linear(AnimateDiff-SDXL): SDXL 모션 모듈이 있는 AnimateDiff에 권장되는 이 옵션은 디테일 보존과 부드러운 모션 간의 균형을 맞추며, 특정 모션 모델 버전과의 호환성을 나타냅니다.

- Sqrt_lineart(AnimateDiff): "lineart"와 유사한 이 변형은 특히 V2 모션 모듈이 있는 AnimateDiff 프로세스를 위해 설계되었으며, 모션 모델의 출력과 조화를 이루도록 노이즈 레벨을 수정하여 더 유동적인 전환이나 움직임을 만듭니다.