Vid2Vid Parte 1 | Composição e Mascaramento

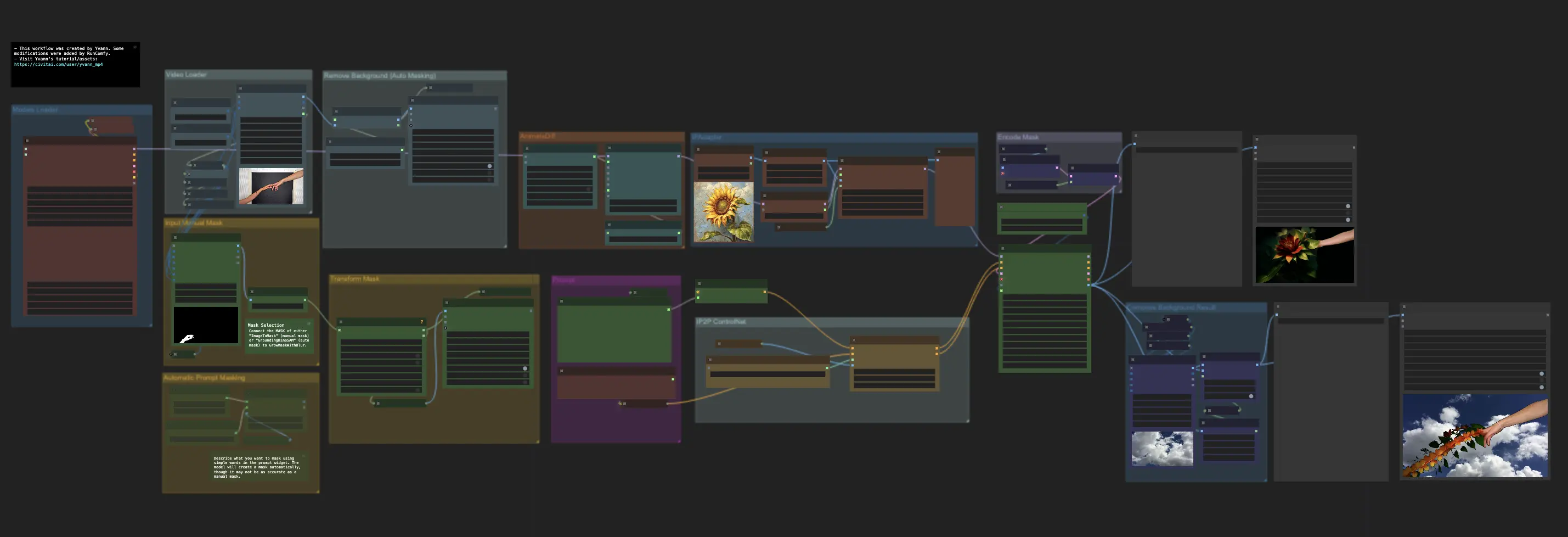

O ComfyUI Vid2Vid oferece dois fluxos de trabalho distintos para criar animações de alta qualidade e profissionais: Vid2Vid Parte 1, que aprimora sua criatividade ao focar na composição e mascaramento do seu vídeo original, e Vid2Vid Parte 2, que utiliza SDXL Style Transfer para transformar o estilo do seu vídeo para coincidir com a estética desejada. Esta página cobre especificamente a Vid2Vid Parte 1ComfyUI Vid2Vid Fluxo de Trabalho

- Fluxos de trabalho totalmente operacionais

- Sem nós ou modelos ausentes

- Nenhuma configuração manual necessária

- Apresenta visuais impressionantes

ComfyUI Vid2Vid Exemplos

ComfyUI Vid2Vid Descrição

O fluxo de trabalho ComfyUI Vid2Vid, criado por , introduz dois fluxos de trabalho distintos para alcançar animações de alta qualidade e profissionais.

- O primeiro fluxo de trabalho ComfyUI: ComfyUI Vid2Vid Parte 1 | Composição e Mascaramento

- O segundo fluxo de trabalho:

ComfyUI Vid2Vid Parte 1 | Composição e Mascaramento

Este fluxo de trabalho aprimora a criatividade ao focar na composição e mascaramento do seu vídeo original.

Passo 1: Carregador de Modelos | ComfyUI Vid2Vid Workflow Parte1

Selecione os modelos apropriados para sua animação. Isso inclui escolher o modelo de checkpoint, modelo VAE (Variational Autoencoder) e modelo LoRA (Low-Rank Adaptation). Esses modelos são cruciais para definir as capacidades e o estilo da sua animação.

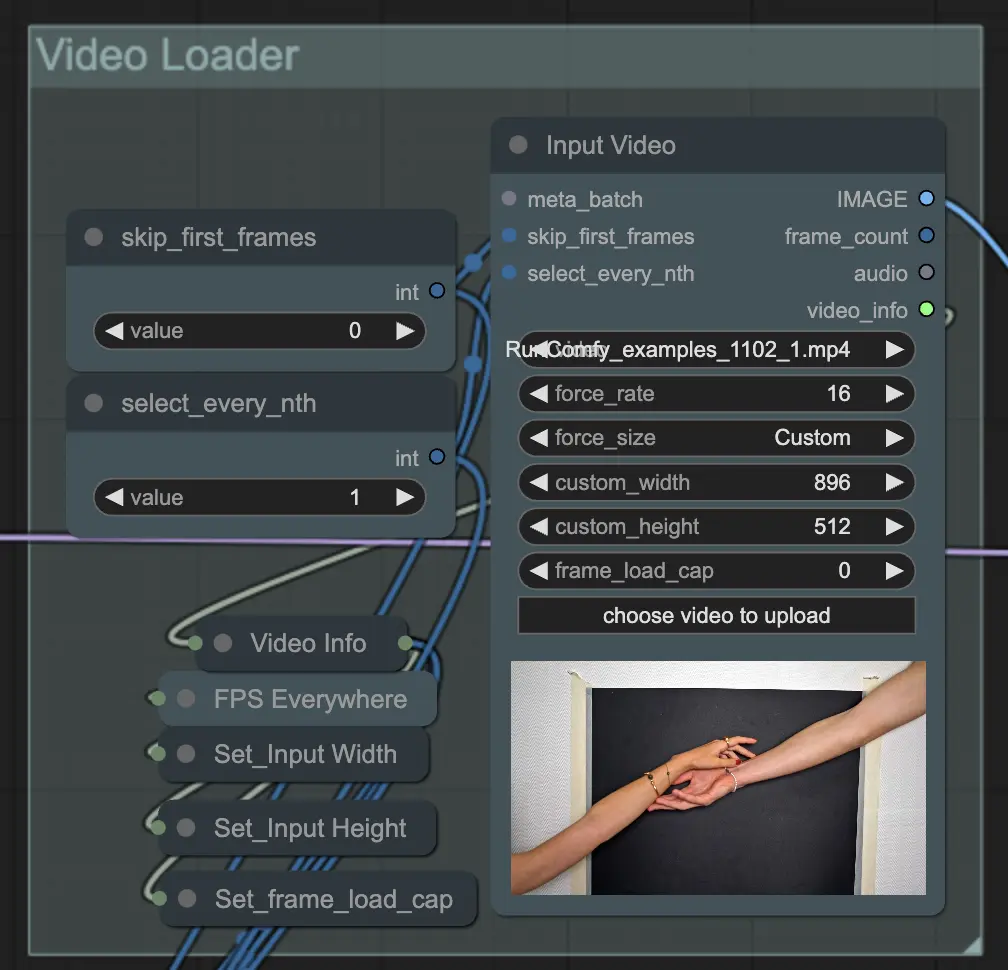

Passo 2: Carregador de Vídeo | ComfyUI Vid2Vid Workflow Parte1

O nó Input Video é responsável por importar o arquivo de vídeo que será usado para a animação. O nó lê o vídeo e o converte em quadros individuais, que são processados em etapas subsequentes. Isso permite uma edição e aprimoramento detalhados quadro a quadro.

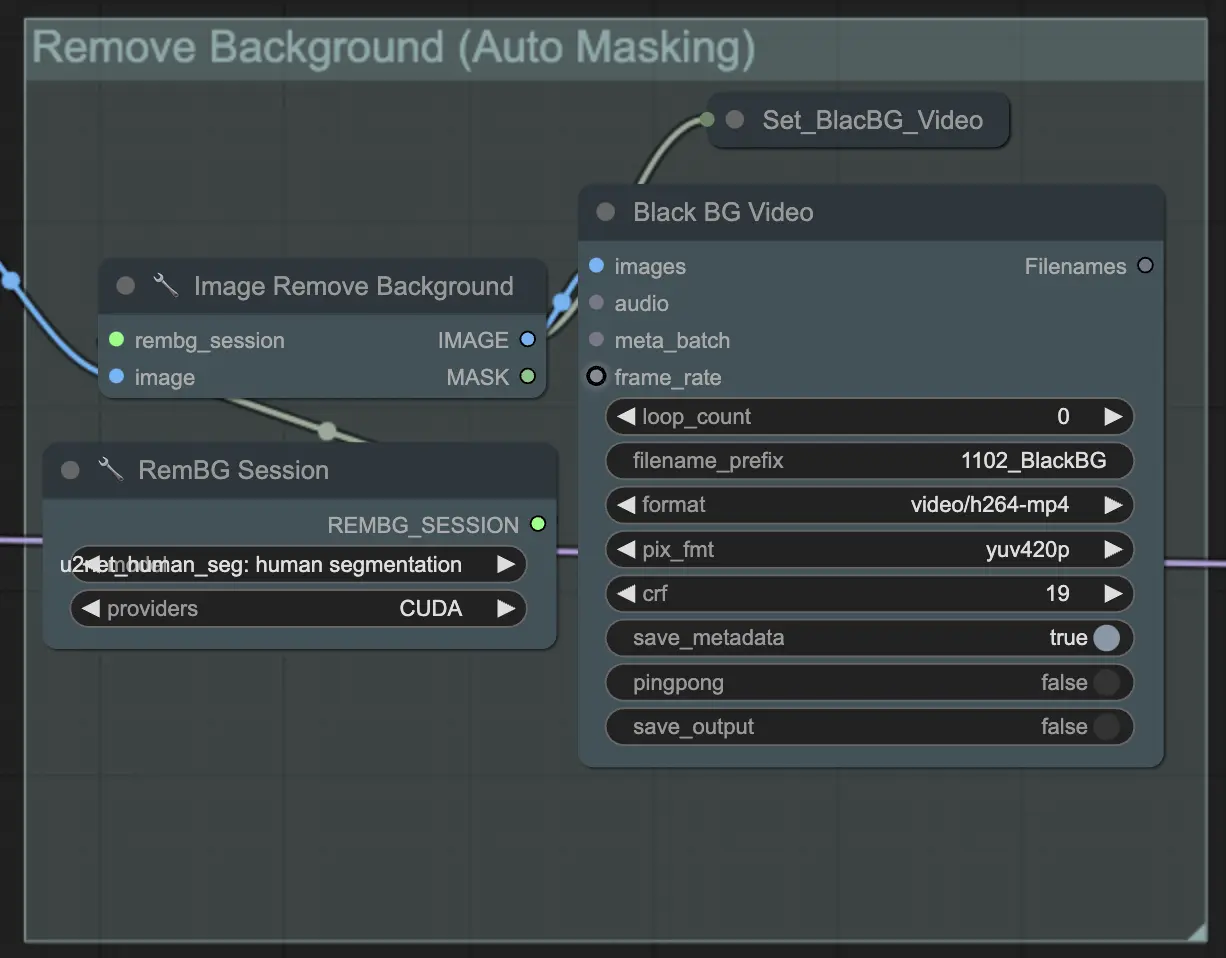

Passo 3: Remover Fundo (Mascaramento Automático) | ComfyUI Vid2Vid Workflow Parte1

Remover Fundo (Mascaramento Automático) isola o sujeito do fundo usando uma técnica de mascaramento automatizada. Isso envolve modelos que detectam e separam o sujeito em primeiro plano do fundo, criando uma máscara binária. Esta etapa é crucial para garantir que o sujeito possa ser manipulado independentemente do fundo.

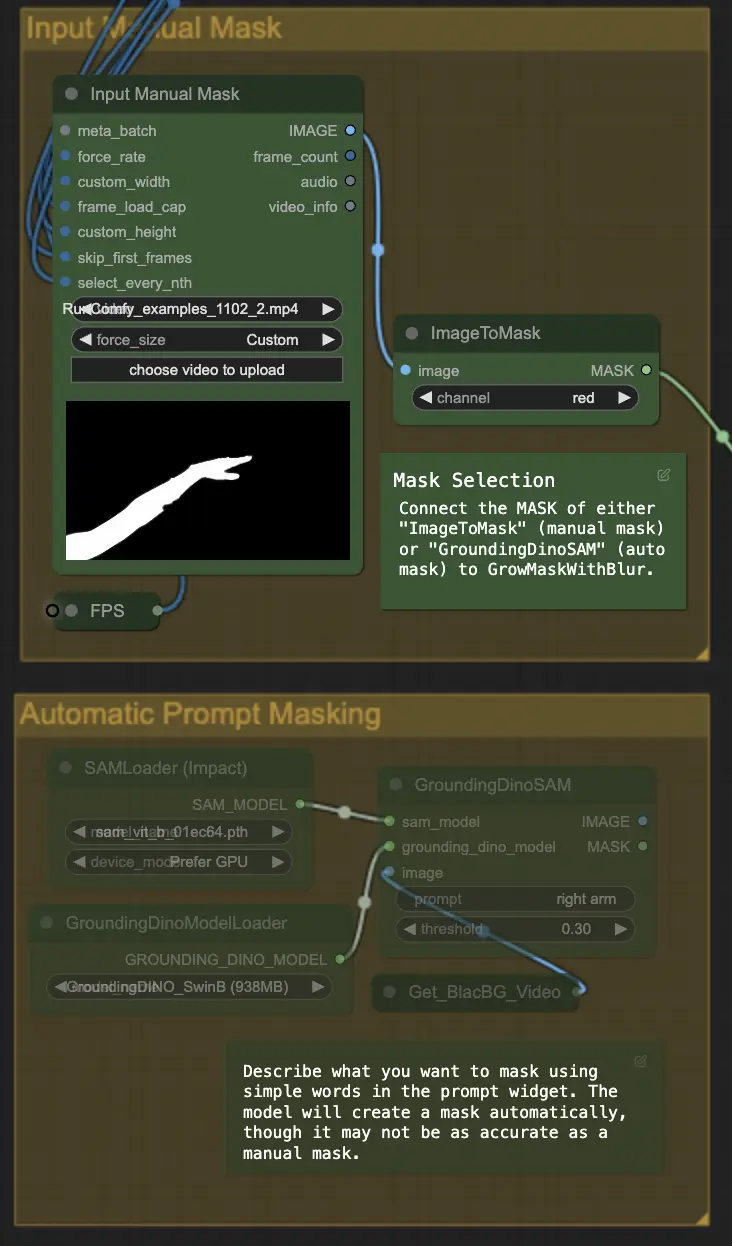

Passo 4: Mascaramento de Área Específica (Máscara Manual ou Automática) | ComfyUI Vid2Vid Workflow Parte1

Esta etapa permite o refinamento da máscara criada na etapa anterior. Você pode mascarar manualmente áreas específicas usando outro software ou contar com o recurso de máscara automatizada 'Segment Anything' do ComfyUI.

- Máscara Manual: Isso precisa ser feito por outro software fora do ComfyUI para controle preciso.

- Máscara Automática: Usando o recurso de máscara automática, você pode descrever o que deseja mascarar usando palavras simples no widget de prompt. O modelo criará uma máscara automaticamente, embora possa não ser tão precisa quanto uma máscara manual.

A versão padrão usa uma máscara manual. Se você quiser tentar a automática, ignore o grupo de máscara manual e habilite o grupo de máscara automática. Além disso, conecte a MÁSCARA de 'GroundingDinoSAM' (máscara automática) a 'GrowMaskWithBlur' em vez de conectar 'ImageToMask' (máscara manual) a 'GrowMaskWithBlur'.

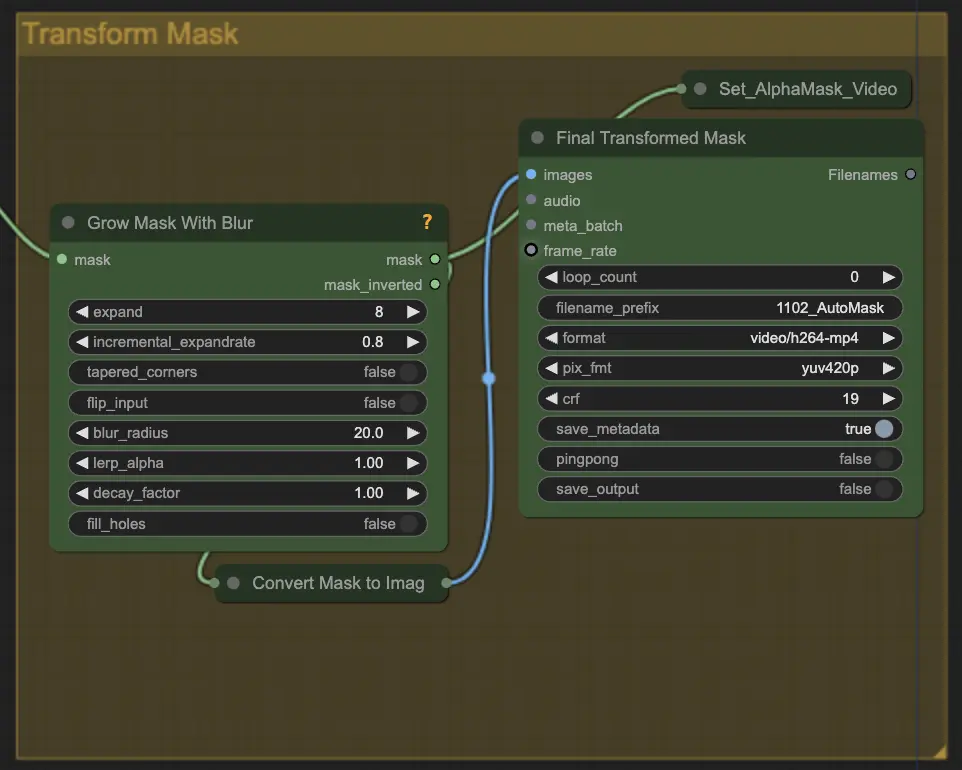

Passo 5: Transformar Máscara | ComfyUI Vid2Vid Workflow Parte1

Transform Mask converte a máscara em uma imagem e permite ajustes adicionais, como adicionar desfoque à máscara original. Isso ajuda a suavizar as bordas e fazer com que a máscara se misture mais naturalmente com o restante da imagem.

Passo 6: Prompt de Entrada | ComfyUI Vid2Vid Workflow Parte1

Insira prompts textuais para guiar o processo de animação. O prompt pode descrever o estilo desejado, aparência ou ações do sujeito. É crucial para definir a direção criativa da animação, garantindo que o resultado final coincida com o estilo artístico imaginado.

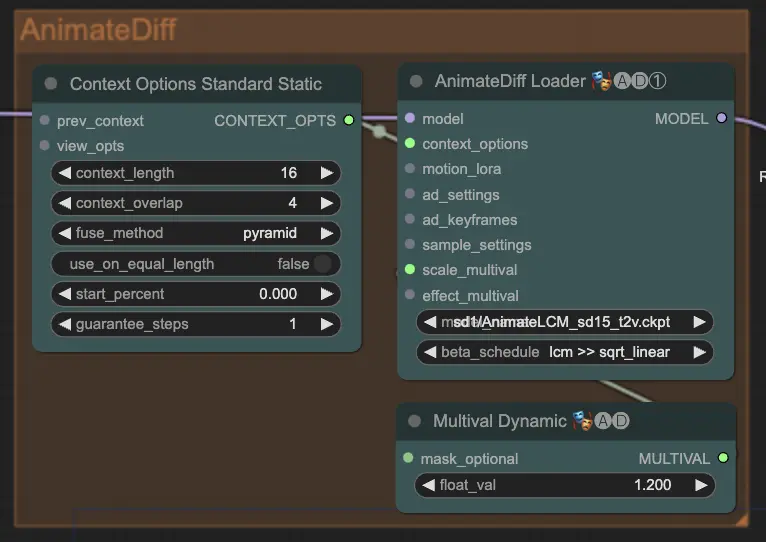

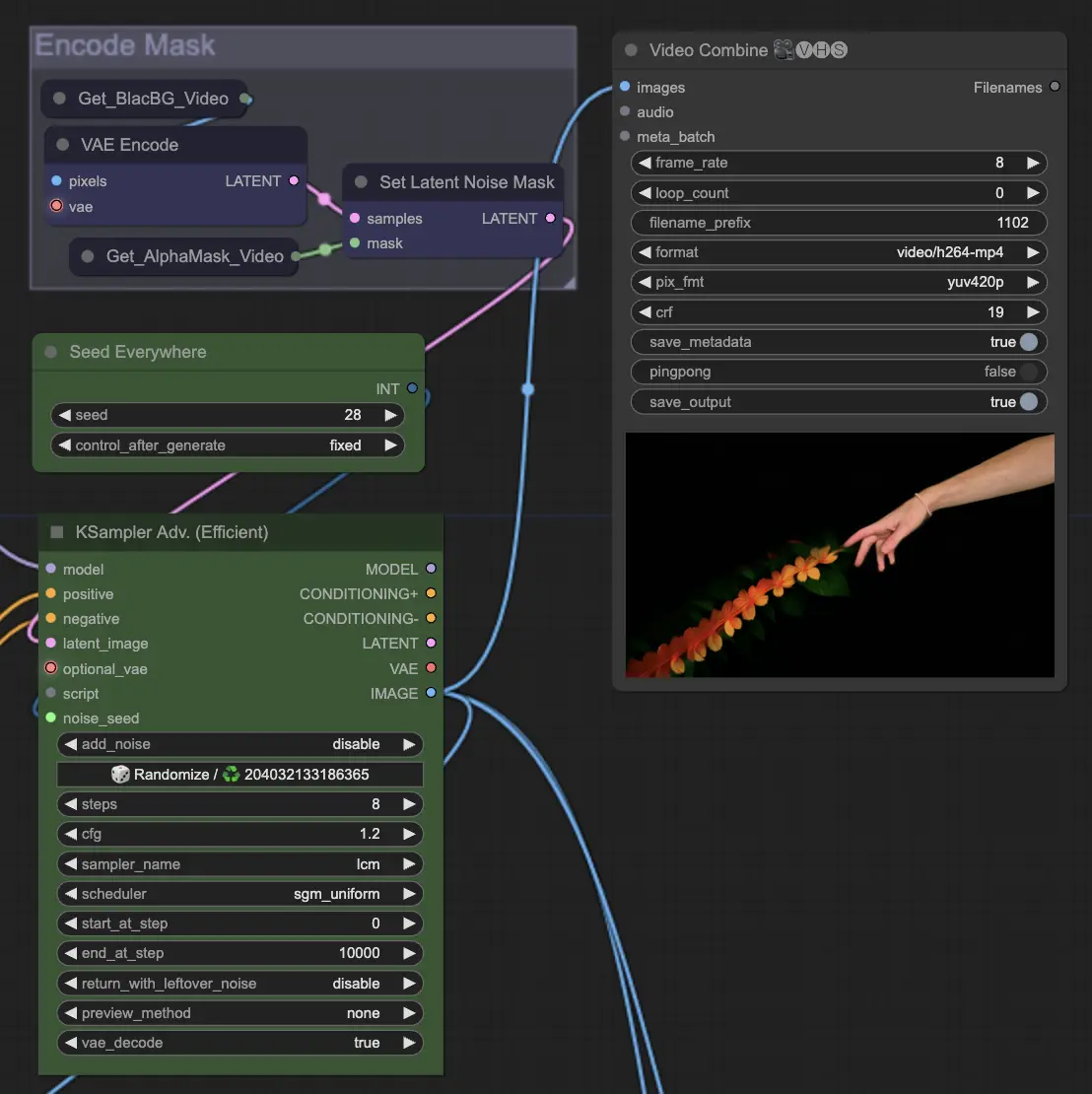

Passo 7: AnimateDiff | ComfyUI Vid2Vid Workflow Parte1

O nó AnimateDiff cria animações suaves identificando diferenças entre quadros consecutivos e aplicando essas mudanças incrementalmente. Isso ajuda a preservar a coerência do movimento e reduzir mudanças abruptas na animação, resultando em uma aparência mais fluida e natural.

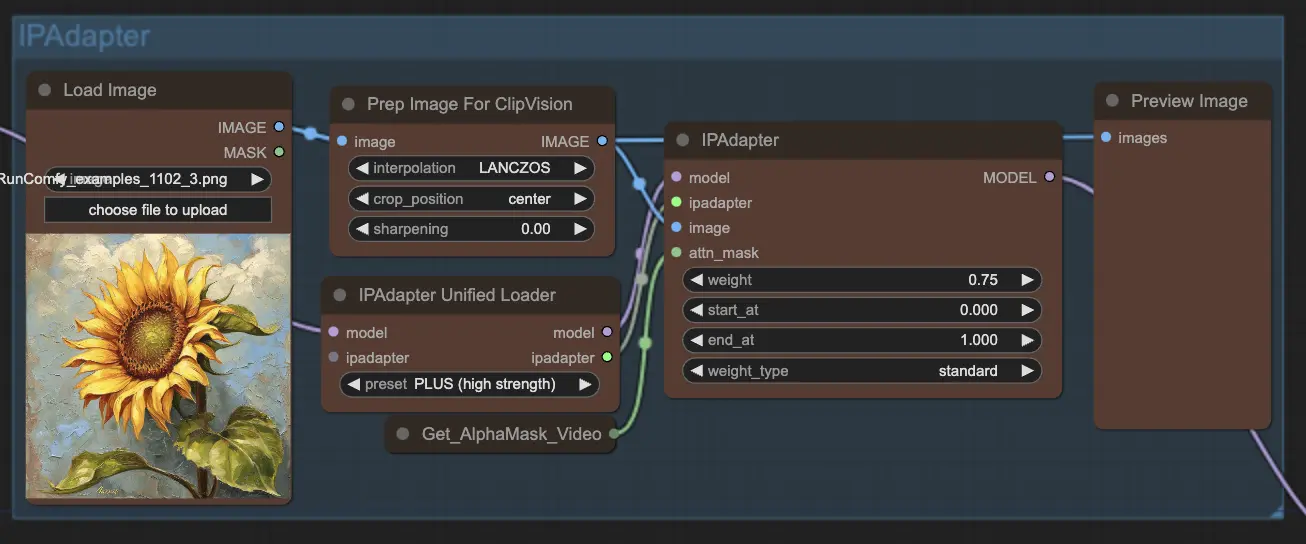

Passo 8: IPAdapter | ComfyUI Vid2Vid Workflow Parte1

O nó IPAdapter adapta as imagens de entrada para alinhar com os estilos ou características desejados. Isso inclui tarefas como colorização e transferência de estilo, garantindo que cada quadro da animação mantenha uma aparência consistente.

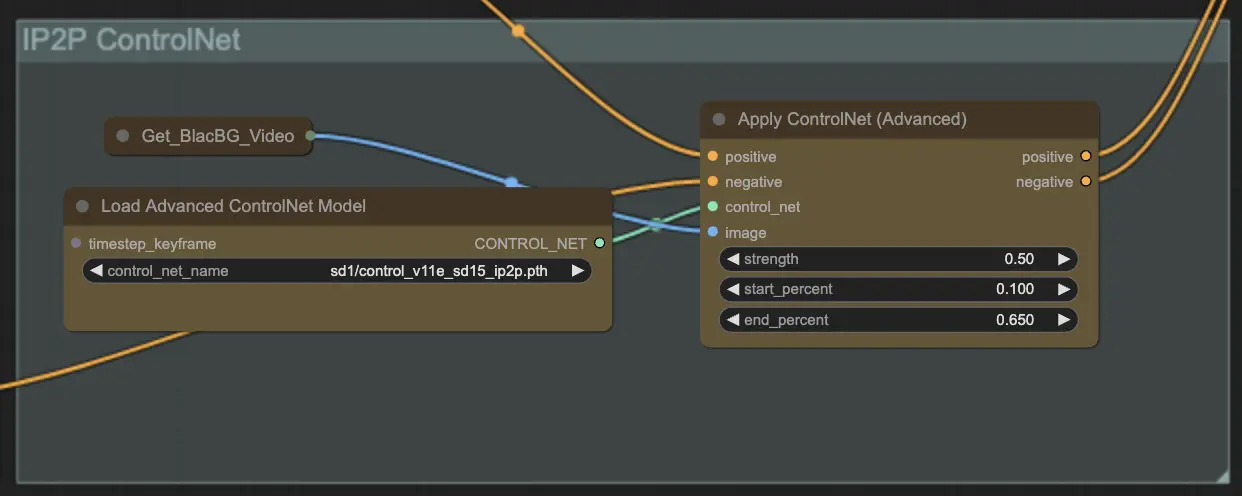

Passo 9: ControlNet | ComfyUI Vid2Vid Workflow Parte1

Usando ControlNet - v1.1 - Instruct Pix2Pix Version model aprimora modelos de difusão permitindo que eles processem condições de entrada adicionais (por exemplo, mapas de borda, mapas de segmentação). Facilita a geração de texto-para-imagem controlando esses modelos pré-treinados com condições específicas de tarefa de maneira ponta a ponta, permitindo aprendizado robusto mesmo com conjuntos de dados menores.

Passo 10: Renderizar | ComfyUI Vid2Vid Workflow Parte1

Na etapa de Render, os quadros processados são compilados em uma saída final de vídeo. Esta etapa garante que todos os quadros individuais sejam combinados perfeitamente em uma animação coerente, pronta para exportação e uso posterior.

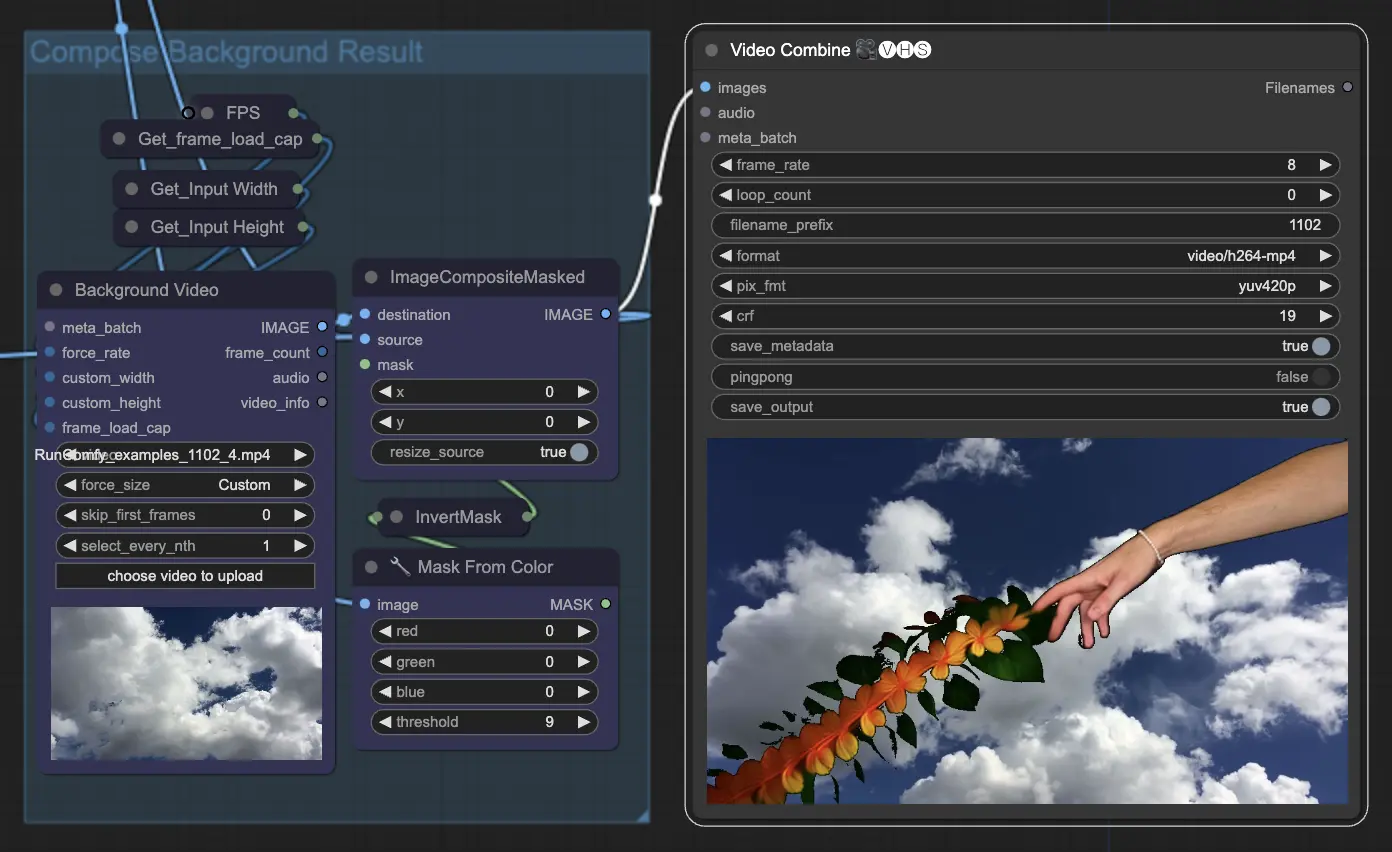

Passo 11: Compor Fundo | ComfyUI Vid2Vid Workflow Parte1

Isso envolve compor o sujeito animado com o fundo. Você pode adicionar um fundo estático ou dinâmico à animação, garantindo que o sujeito se integre suavemente com o novo fundo para criar um produto final visualmente atraente.

Ao utilizar o fluxo de trabalho ComfyUI Vid2Vid Parte1, você pode criar animações intrincadas com controle preciso sobre todos os aspectos do processo, desde a composição e mascaramento até a renderização final.