CogVideoX Tora | Bild-zu-Video Modell

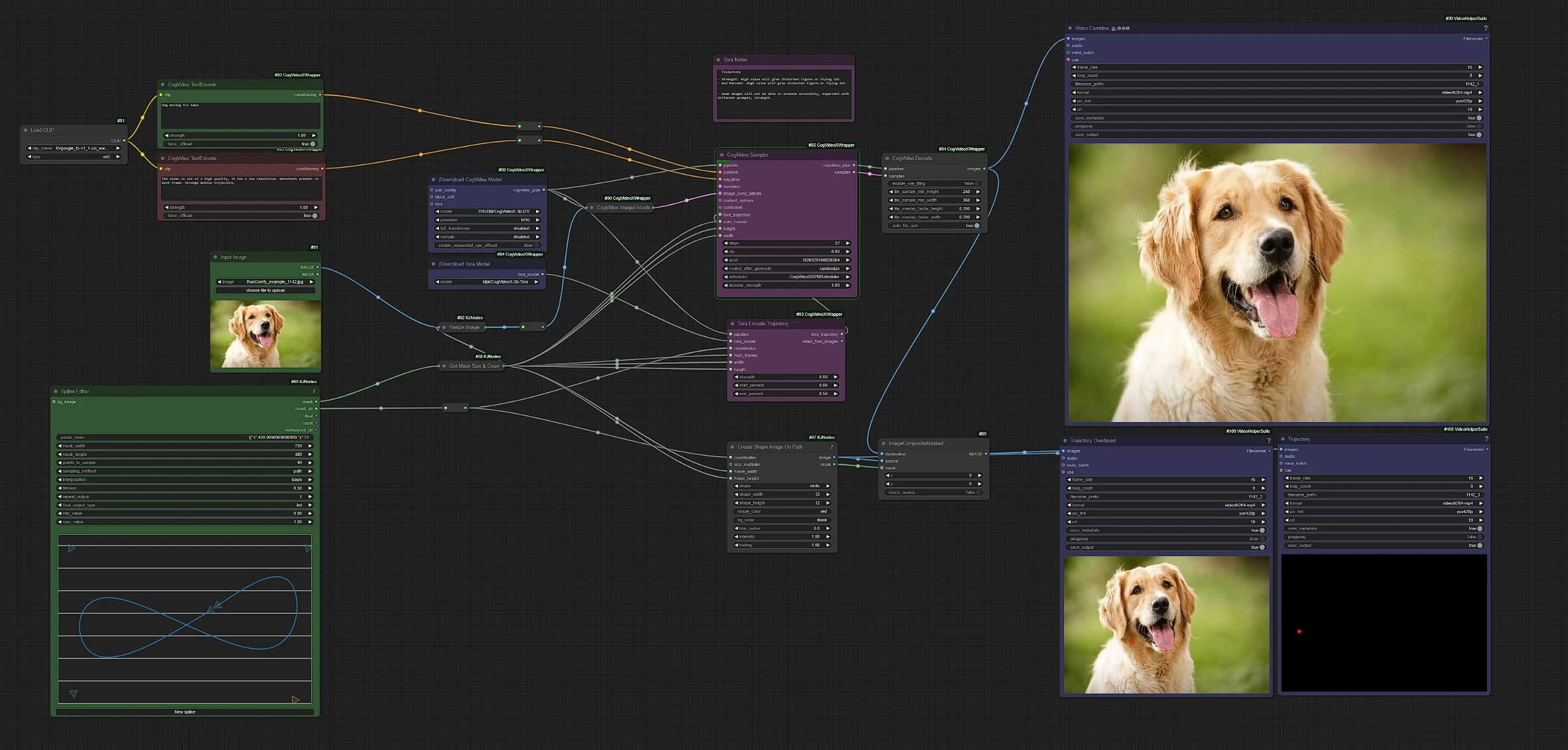

CogVideoX Tora kombiniert die Stärken von Diffusionsmodellen und Transformern, indem es Bewegungstrajektorien explizit modelliert und so eine präzise Kontrolle über Objektbewegungen und Dynamik in der Videogenerierung ermöglicht. Dieser trajektorienorientierte Ansatz verbessert die zeitliche Konsistenz und visuelle Qualität, was Tora zu einem bedeutenden Fortschritt für Aufgaben wie Videobearbeitung, Synthese und Animation macht. Verwenden Sie den CogVideoX Tora-Workflow, um dynamische Videos zu erstellen und nahtlose Übergänge und Bewegungen in animierten Szenen zu erreichen.ComfyUI CogVideoX Tora Arbeitsablauf

- Voll funktionsfähige Workflows

- Keine fehlenden Nodes oder Modelle

- Keine manuelle Einrichtung erforderlich

- Beeindruckende Visualisierungen

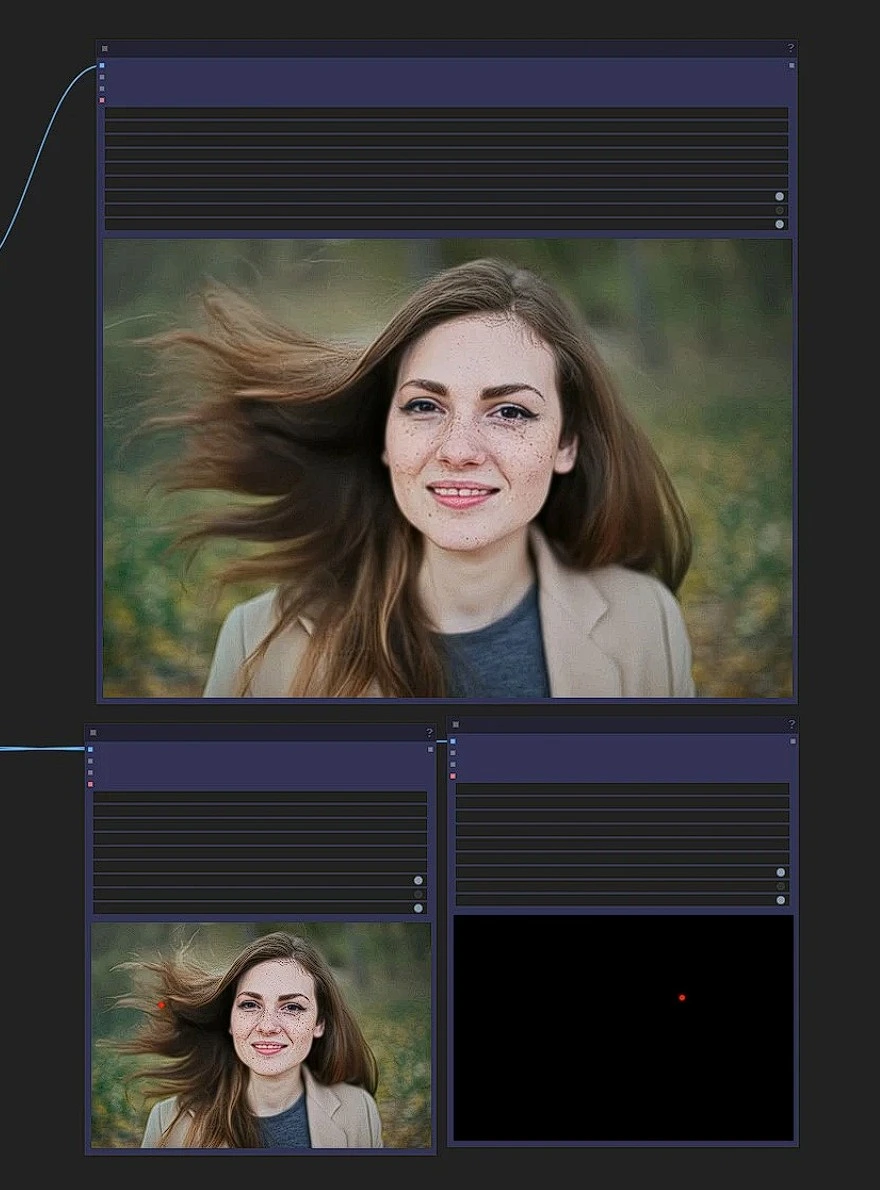

ComfyUI CogVideoX Tora Beispiele

ComfyUI CogVideoX Tora Beschreibung

Die Knoten und der zugehörige Workflow wurden vollständig von Kijai entwickelt. Wir geben Kijai alle gebührende Anerkennung für diese innovative Arbeit. Auf der RunComfy-Plattform präsentieren wir lediglich die Beiträge von Kijai an die Community. Es ist wichtig zu beachten, dass es derzeit keine formelle Verbindung oder Partnerschaft zwischen RunComfy und Kijai gibt. Wir schätzen Kijai’s Arbeit sehr!

CogVideoX Tora

Tora führt ein neuartiges Framework zur Generierung hochwertiger Videos ein, indem es trajektorienbasierte Führung in einem Diffusions-Transformer-Modell nutzt. Durch den Fokus auf Bewegungstrajektorien erreicht Tora eine realistischere und zeitlich kohärente Videosynthese. Dieser Ansatz überbrückt die Lücke zwischen räumlich-zeitlicher Modellierung und generativen Diffusions-Frameworks.

Bitte beachten Sie, dass diese Version von Tora auf dem CogVideoX-5B Modell basiert und nur für akademische Forschungszwecke vorgesehen ist. Für Lizenzdetails, siehe .

1.1 Wie verwendet man den CogVideoX Tora Workflow?

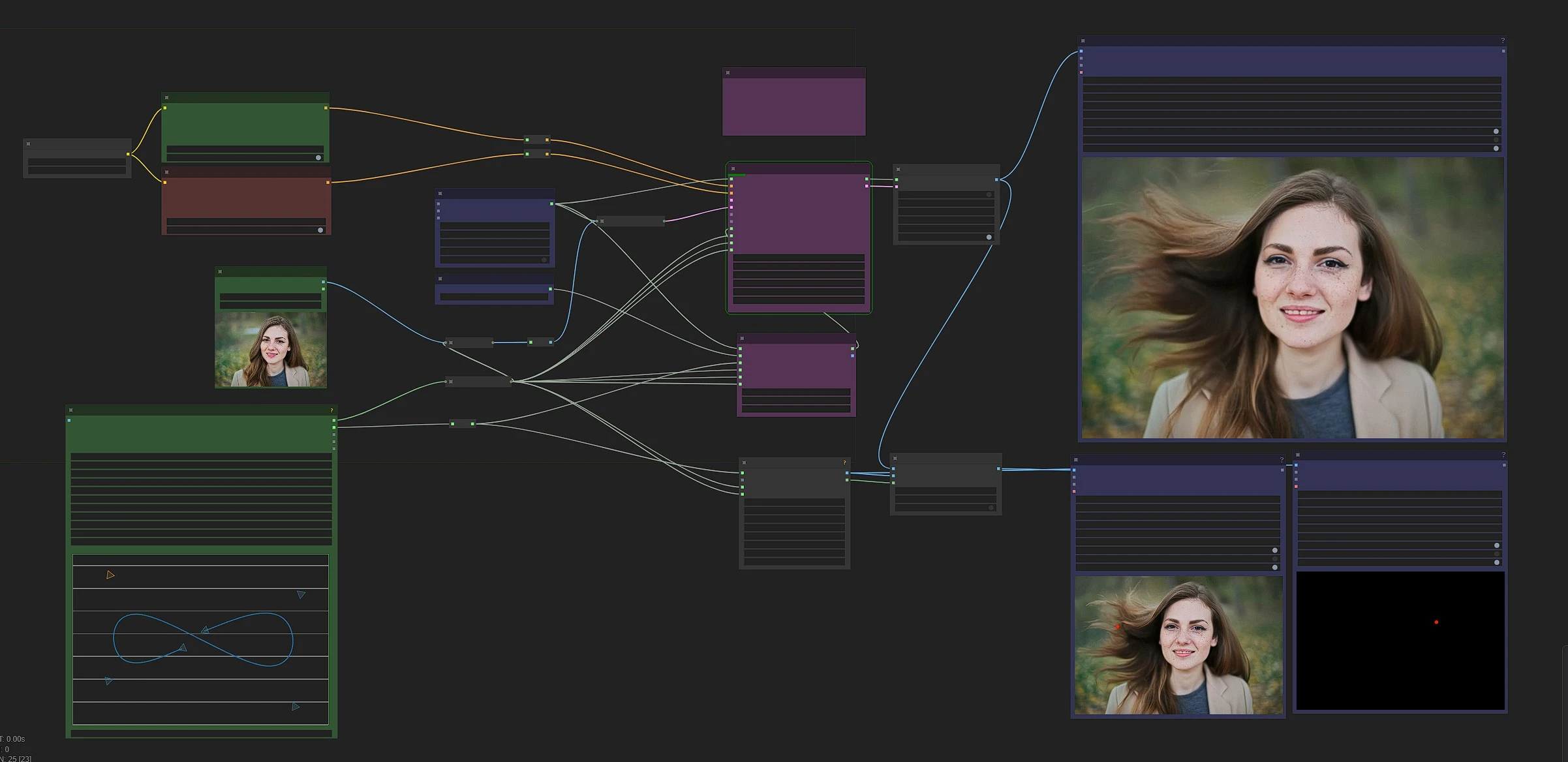

Dies ist der CogVideoX Tora Workflow, linke Seite Knoten sind Eingaben, Mitte sind Verarbeitungsknoten von Tora, und rechte Seite sind die Ausgabeknoten.

- Ziehen und ablegen Sie Ihr horizontales Bild in den Eingabeknoten.

- Schreiben Sie Ihre Aktionsaufforderungen

- Erstellen Sie einen Trajektorienpfad

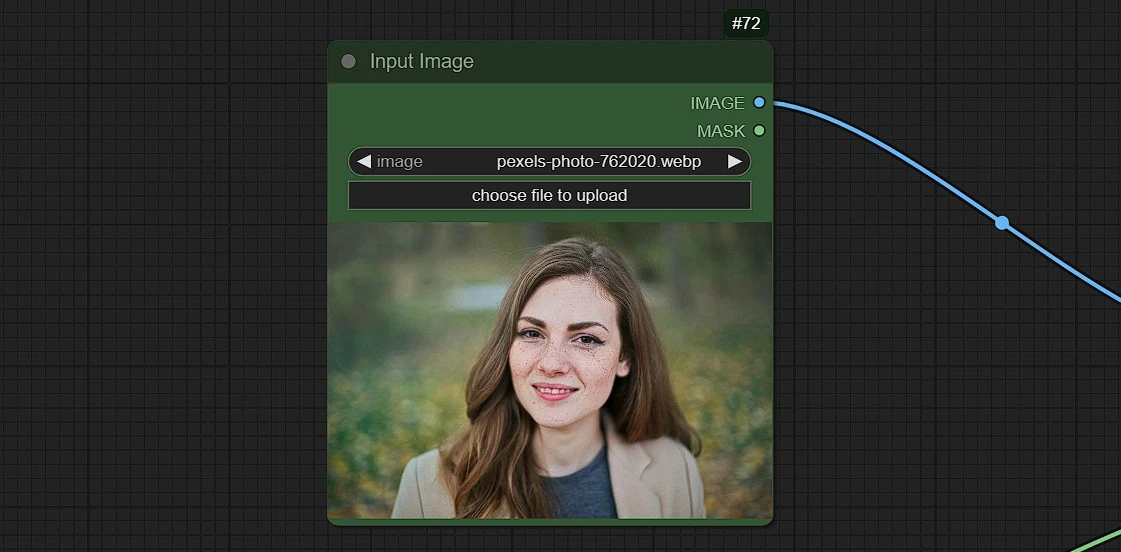

1.2 Eingabebild laden

- Laden, Ziehen und Ablegen oder Kopieren und Einfügen (Strg+V) Ihres Bildes im Ladebildknoten

[!CAUTION] Nur horizontale Formatbilder mit den Abmessungen - 720*480 funktionieren. Andere Abmessungen führen zu Fehlern.

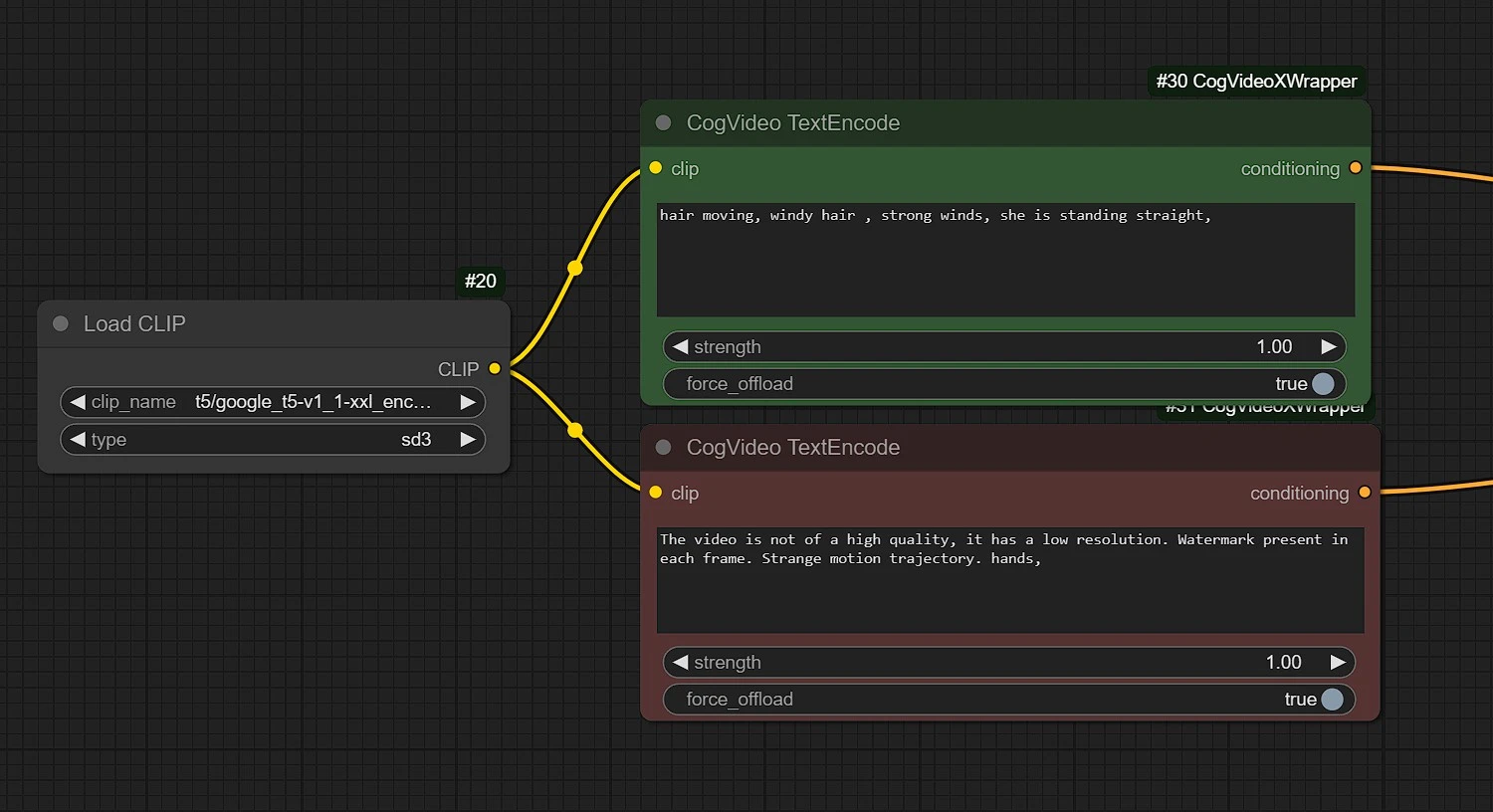

1.3 Fügen Sie Ihre positiven und negativen Aufforderungen hinzu

Positiv: Geben Sie die Aktionen ein, die basierend auf der im Trajektorienknoten definierten Trajektorie mit dem Subjekt stattfinden (bewegend, fließend...etc).Negativ: Geben Sie ein, was Sie nicht passieren lassen wollen (Verzerrte Hände, verschwommen...etc)

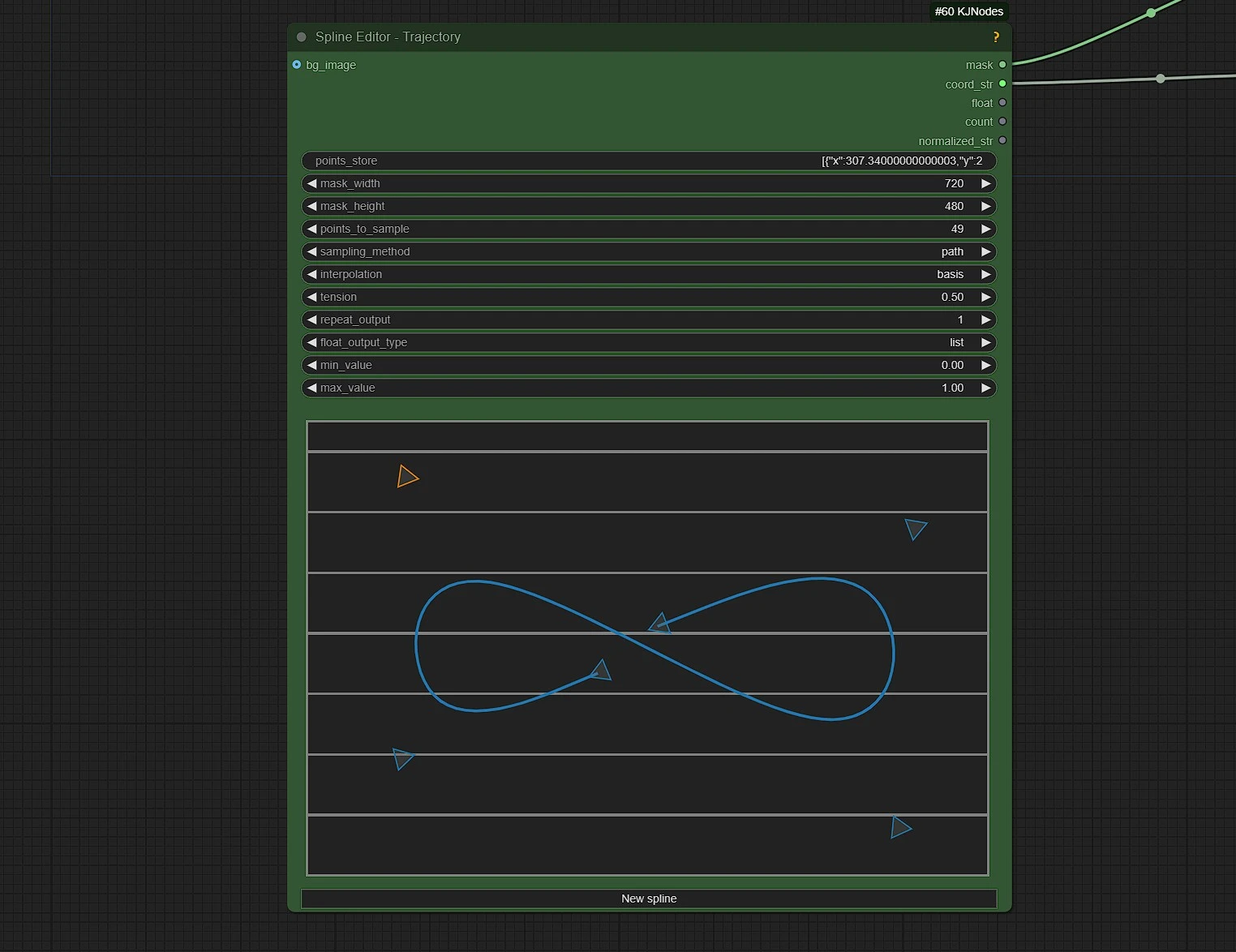

1.4 Trajektorie für Bewegung erstellen

Hier legen Sie den Trajektorienpfad der Bewegung des Subjekts im hochgeladenen Foto fest.

points_to_sample: Dies legt die Anzahl der Frames für das Rendering oder die Dauer Ihres Videos in Frames fest.mask_width: Standard ist 720. NICHT ÄNDERN!mask_height: Standard ist 480. NICHT ÄNDERN!

Knotenführer:

- Shift + Klick, um Kontrollpunkt am Ende hinzuzufügen. Strg + Klick, um Kontrollpunkt (unterteilen) zwischen zwei Punkten hinzuzufügen.

- Rechtsklick auf einen Punkt, um ihn zu löschen.

- Beachten Sie, dass Sie nicht von Anfang/Ende löschen können.

- Rechtsklick auf die Leinwand für das Kontextmenü:

- Dies sind rein visuelle Optionen, die sich nicht auf die Ausgabe auswirken:

Griffe Sichtbarkeit umschalten

- Anzeigepunkte: die anzuzeigenden Punkte anzeigen.

- points_to_sample-Wert legt die Anzahl der Proben fest

- von der gezeichneten Kurve selbst zurückgegeben werden, dies ist unabhängig von den

- tatsächlichen Kontrollpunkten, daher ist die Interpolationstyp wichtig.

Sampling_method:

- Zeit: Proben entlang der Zeitachse, verwendet für Zeitpläne

- Pfad: Proben entlang des Pfades selbst, nützlich für Koordinaten

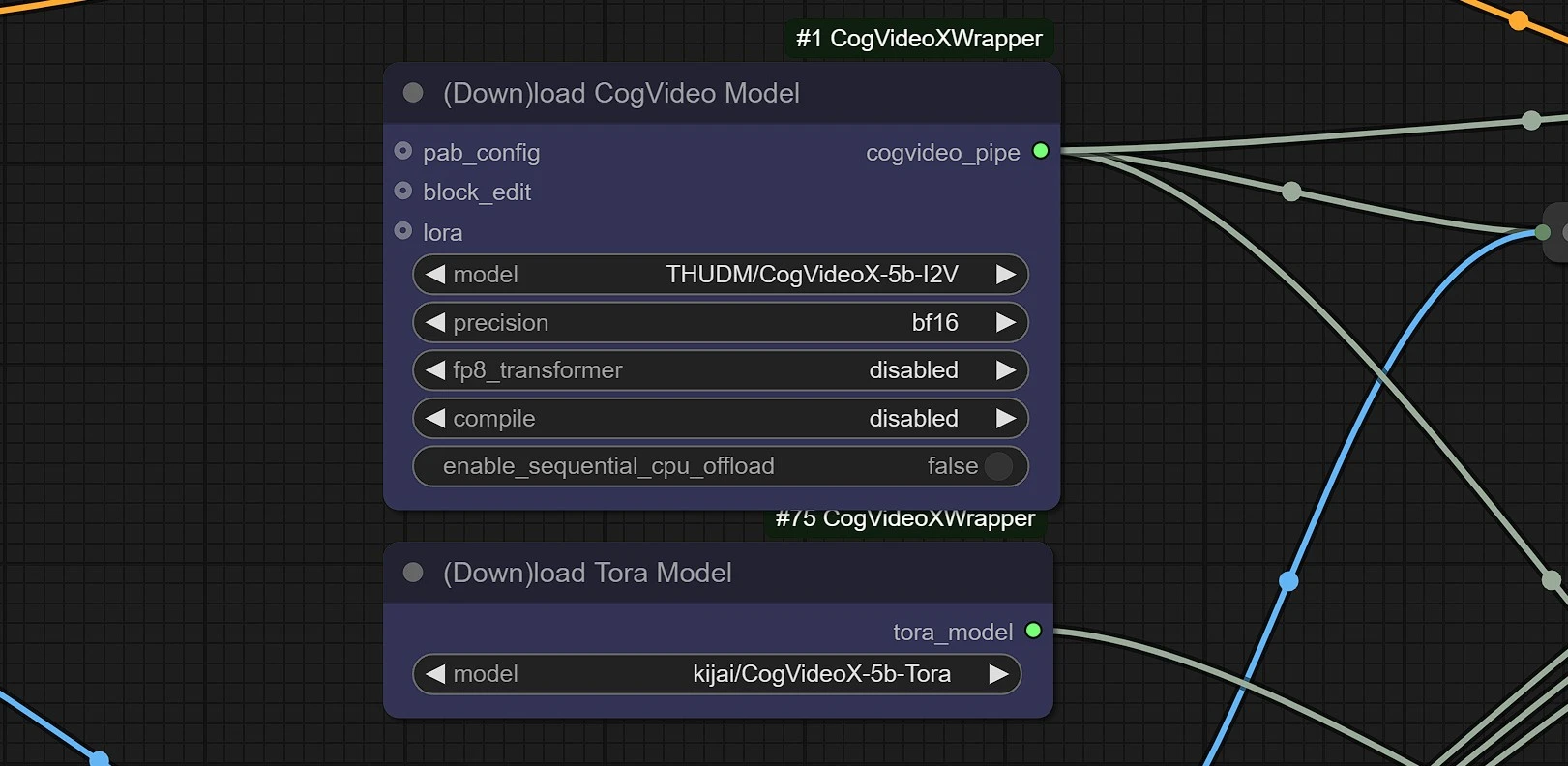

1.5 CogVideoX & Tora Modelle laden

Dies sind die Modell-Downloader-Knoten, die Modelle automatisch in Ihrem comfyui in 2-3 Minuten herunterladen.

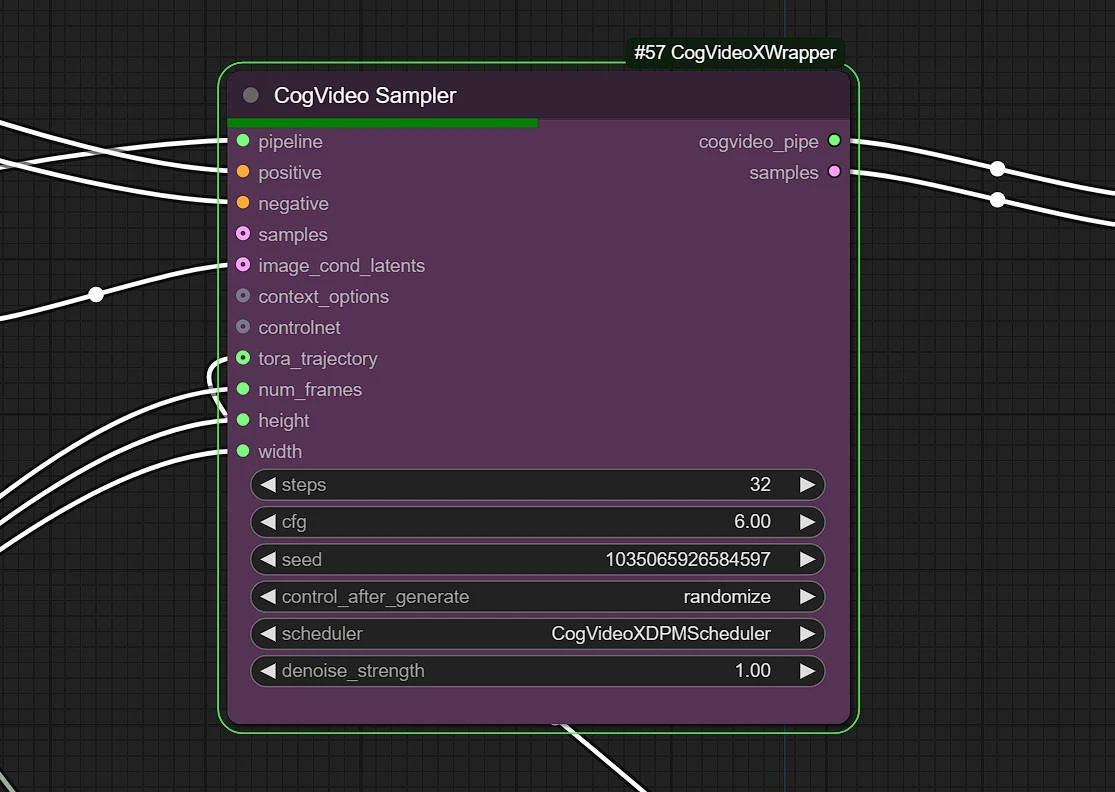

1.6 CogVideo Sampler

Schritte: Dieser Wert entscheidet über die Qualität Ihres Renders. Halten Sie zwischen 25 - 35 für den besten und effizientesten Wert.cfg: Standardwert ist 6.0 für CogVideo Sampling.Denoising-StärkeundScheduler: Ändern Sie dies nicht.

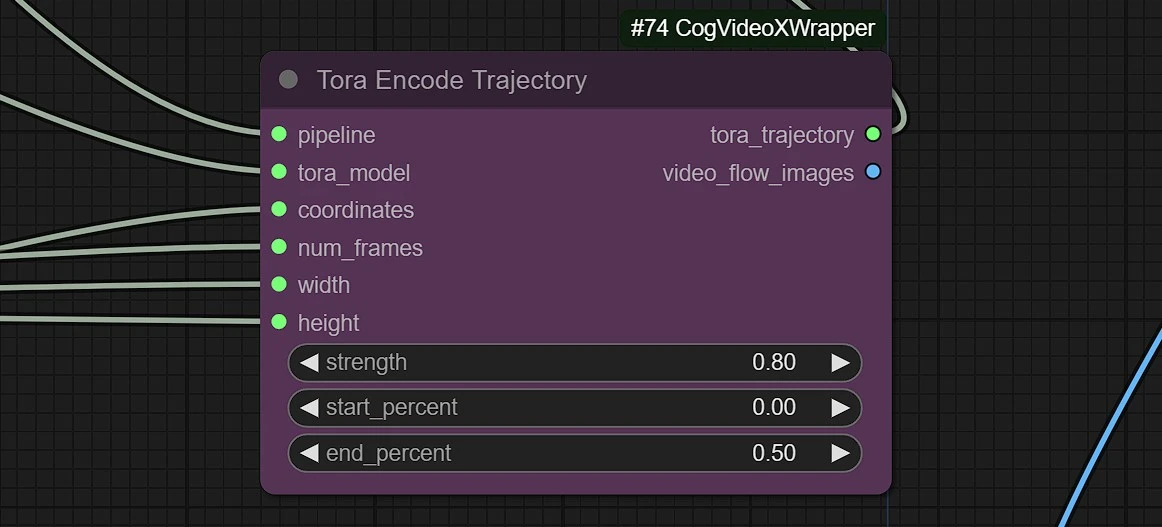

1.7 Trajektoriengewichte und Stärke

Dieser Knoten setzt die Stärke Ihrer Bewegungstrajektorie.

Stärke: Hoher Wert führt zu verzerrten Figuren oder fliegenden Punkten. Verwenden Sie zwischen 0.5 - 0.9.start_percent: Verwenden Sie diesen Wert, um den Effekt der Bewegungsstärke zu erleichtern.end_percent: - Hoher Wert führt zu verzerrten Figuren oder fliegenden Punkten. Verwenden Sie zwischen 0.3 - 0.7

1.8 Ausgaben

Diese Knoten geben Ihnen 3 Ausgaben.

- Gerendertes Video ausgeben

- Trajektorienpfad überlagert auf gerendertem Video

- Trajektorienvideo auf schwarzem Hintergrund

"CogVideoX Tora: Trajektorienorientierter Diffusions-Transformer für die Videogenerierung" präsentiert einen innovativen Ansatz zur Videogenerierung, indem er trajektorienbasierte Führung innerhalb eines Diffusions-Transformer-Frameworks einführt. Anders als traditionelle Videosynthesemodelle, die Schwierigkeiten haben, zeitliche Konsistenz und realistische Bewegung aufrechtzuerhalten, konzentriert sich CogVideoX Tora explizit auf die Modellierung von Bewegungstrajektorien. Dies ermöglicht es dem System, kohärente und visuell überzeugende Videos zu erzeugen, indem es versteht, wie sich Objekte und Elemente im Laufe der Zeit entwickeln. Durch die Kombination der Leistungsfähigkeit von Diffusionsmodellen, bekannt für hochwertige Bildgenerierung, mit den zeitlichen Denkfähigkeiten von Transformern, überbrückt CogVideoX Tora die Lücke zwischen räumlicher und zeitlicher Modellierung.

CogVideoX Toras trajektorienorientierter Mechanismus bietet eine feinkörnige Kontrolle über Objektbewegungen und dynamische Interaktionen, was es besonders geeignet für Anwendungen macht, die präzise Bewegungsguidance erfordern, wie Videobearbeitung, Animation und Spezialeffekterzeugung. Die Fähigkeit des Modells, zeitliche Konsistenz und realistische Übergänge aufrechtzuerhalten, verbessert seine Anwendbarkeit bei der Erstellung von glattem und kohärentem Videoinhalt. Durch die Integration von Trajektorien-Prämissen verbessert CogVideoX Tora nicht nur Bewegungsdynamiken, sondern reduziert auch Artefakte, die häufig in framebasierter Generierung zu sehen sind. Dieser Durchbruch setzt einen neuen Maßstab für die Videosynthese und bietet ein leistungsstarkes Werkzeug für Kreative und Entwickler in Bereichen wie Filmproduktion, virtueller Realität und videobasierte KI.