AnimateLCM | Beschleunigen Sie Text-zu-Video

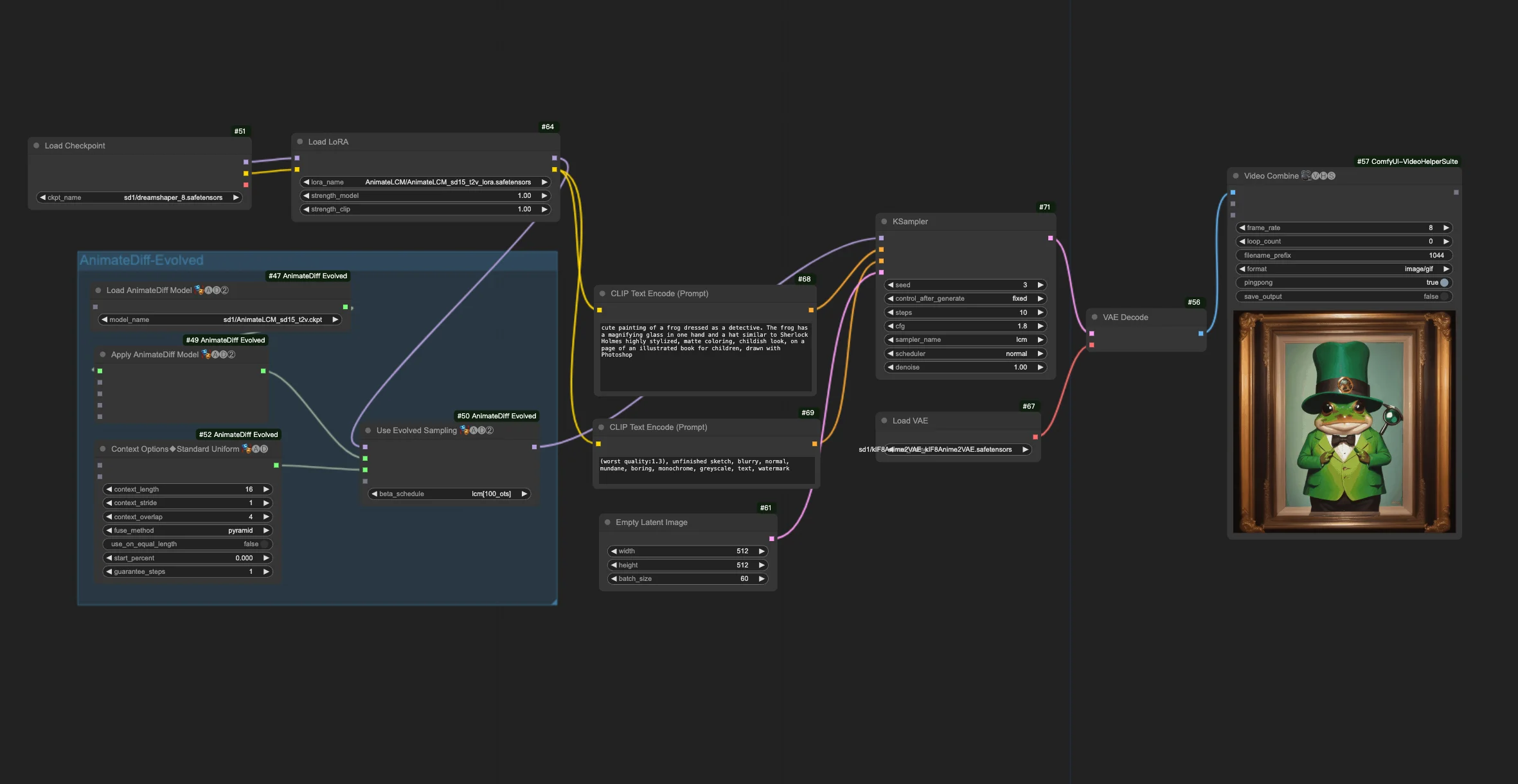

Dieser Workflow baut auf dem AnimateDiff-Evolved-Workflow auf, indem er AnimateLCM durch "Load AnimateLCM LoRA" und "Apply AnimateLCM Motion Model in AnimateDiff" integriert. Er macht die Erstellung personalisierter Animationseffekte schneller und effizienter.ComfyUI AnimateLCM Arbeitsablauf

- Voll funktionsfähige Workflows

- Keine fehlenden Nodes oder Modelle

- Keine manuelle Einrichtung erforderlich

- Beeindruckende Visualisierungen

ComfyUI AnimateLCM Beispiele

ComfyUI AnimateLCM Beschreibung

1. ComfyUI AnimateLCM Workflow

Der ComfyUI AnimateLCM Workflow wurde entwickelt, um die Geschwindigkeit von KI-Animationen zu verbessern. Aufbauend auf den Grundlagen von ComfyUI-AnimateDiff-Evolved integriert dieser Workflow AnimateLCM, um speziell die Erstellung von Text-zu-Video (t2v) Animationen zu beschleunigen. Sie können mit verschiedenen Prompts und Schritten experimentieren, um die gewünschten Ergebnisse zu erzielen.

2. Überblick über AnimateLCM

Das Aufkommen von Technologien wie SDXL, LCM und SDXL Turbo hat das Tempo der Bilderzeugung erheblich gesteigert. AnimateLCM treibt den Fortschritt bei KI-Animationen weiter voran. Es unterstützt die schnelle Bild-zu-Video-Generierung und zielt darauf ab, die Geschwindigkeit und Effizienz bei der Erstellung animierter Videos aus statischen Bildern oder Textbeschreibungen zu verbessern, was es besonders nützlich für die schnelle Erstellung personalisierter Animationseffekte macht.

2.1. Einführung in AnimateLCM

AnimateLCM wurde entwickelt, um die Animation personalisierter Diffusionsmodelle und Adapter durch entkoppeltes Konsistenzlernen zu beschleunigen. Es ist inspiriert vom Consistency Model (CM), das vortrainierte Bilddiffusionsmodelle destilliert, um den Abtastprozess zu beschleunigen, und seiner Erweiterung, dem Latent Consistency Model (LCM), das sich auf die bedingte Bilderzeugung konzentriert. AnimateLCM nutzt diese Grundlagen, um die Erstellung von Videos mit hoher Wiedergabetreue in wenigen Schritten zu ermöglichen, aufbauend auf dem Erfolg von Bilddiffusions- und Generierungstechniken, um deren Fähigkeiten auf den Videobereich auszuweiten.

2.2. Wie man AnimateLCM in Ihrem ComfyUI-Workflow verwendet

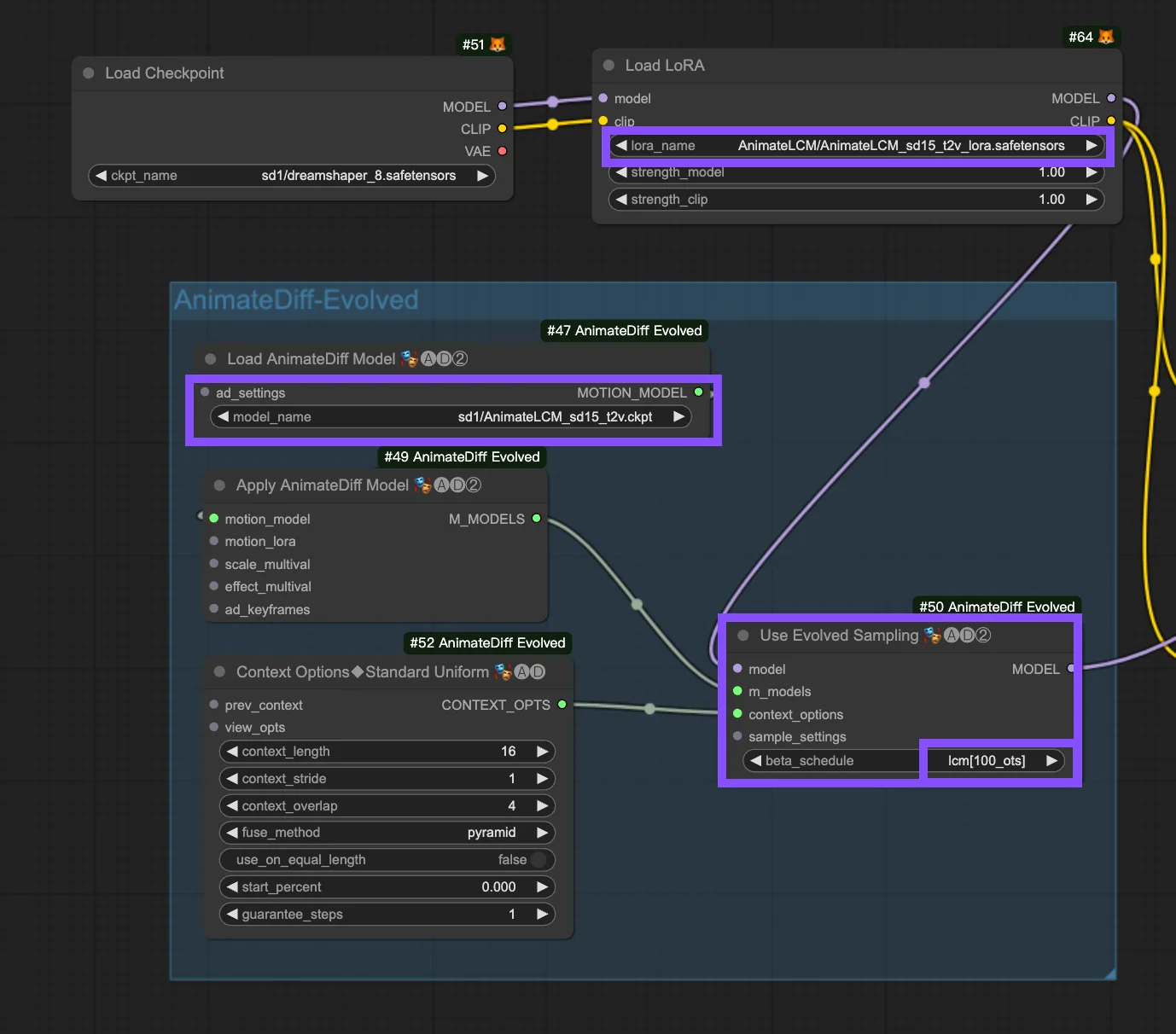

Dieser Workflow baut auf dem Workflow auf. Im Folgenden sind die Konfigurationsparameter im Knoten "Use Evolved Sampling" aufgeführt.

Models: Legen Sie das Checkpoint-Modell und das LoRA-Modell fest.

- Checkpoint: Dies bezieht sich auf die StableDiffusion (SD) Modelleingaben, die für die Erstellung von Animationen verwendet werden. Je nach ausgewähltem Bewegungsmodell kann die Kompatibilität zwischen verschiedenen SD-Versionen wie SD1.5 oder SDXL variieren.

- LoRA: Integrieren Sie das AnimateLCM LoRA-Modell, um vorhandene Adapter für eine Vielzahl von Funktionen nahtlos zu integrieren und die Effizienz und Ausgabequalität mit Fokus auf Konsistenzlernen zu verbessern, ohne die Abtastgeschwindigkeit zu beeinträchtigen.

Motion Models (M Models): Dies sind die Ausgaben aus dem Apply AnimateDiff Model-Prozess, die die Verwendung des AnimateLCM Motion Model ermöglichen.

Context Options: Diese Einstellungen passen die Funktionsweise von AnimateDiff während der Animationsproduktion an und ermöglichen Animationen beliebiger Länge durch gleitende Kontextfenster über das gesamte Unet oder speziell innerhalb des Bewegungsmoduls. Sie erlauben auch Zeitanpassungen für komplexe Animationssequenzen. Hier finden Sie .

Beta Schedule in Sample Settings: Wählen Sie LCM. Innerhalb der Sample Settings von AnimateDiff in ComfyUI steuert die Auswahl des "Beta-Zeitplans", einschließlich Optionen wie "lcm", "lineart" usw., die Beta-Werte, die den Rauschpegel während des gesamten Diffusionsprozesses regulieren. Diese Anpassung beeinflusst den visuellen Stil und die Flüssigkeit der Animation. Jede Einstellung ist auf spezifische Animations- oder Bewegungsmodellanforderungen zugeschnitten.

- LCM (Latent Consistency Module): Die Einstellung "lcm" ist auf LCM LoRAs zugeschnitten und verbessert die Gleichmäßigkeit der Animation und reduziert die Erstellungszeit. Sie erreicht eine schnellere Konvergenz mit weniger Schritten, erfordert aber eine Reduzierung der Schritte (auf mindestens ~4 Schritte) und andere Parameteranpassungen für eine optimale Detailerhaltung.

- Linear (AnimateDiff-SDXL): Empfohlen für AnimateDiff mit SDXL-Bewegungsmodulen, bietet diese Option ein Gleichgewicht zwischen Detailerhaltung und flüssiger Bewegung und zeigt die Kompatibilität mit bestimmten Bewegungsmodellversionen an.

- Sqrt_lineart (AnimateDiff): Ähnlich wie "lineart" ist diese Variante für AnimateDiff-Prozesse konzipiert, insbesondere mit V2-Bewegungsmodulen, und modifiziert die Rauschpegel, um die Ausgabe des Bewegungsmodells für flüssigere Übergänge oder Bewegungen zu ergänzen.