Mochi Edit UnSampling | Video-zu-Video

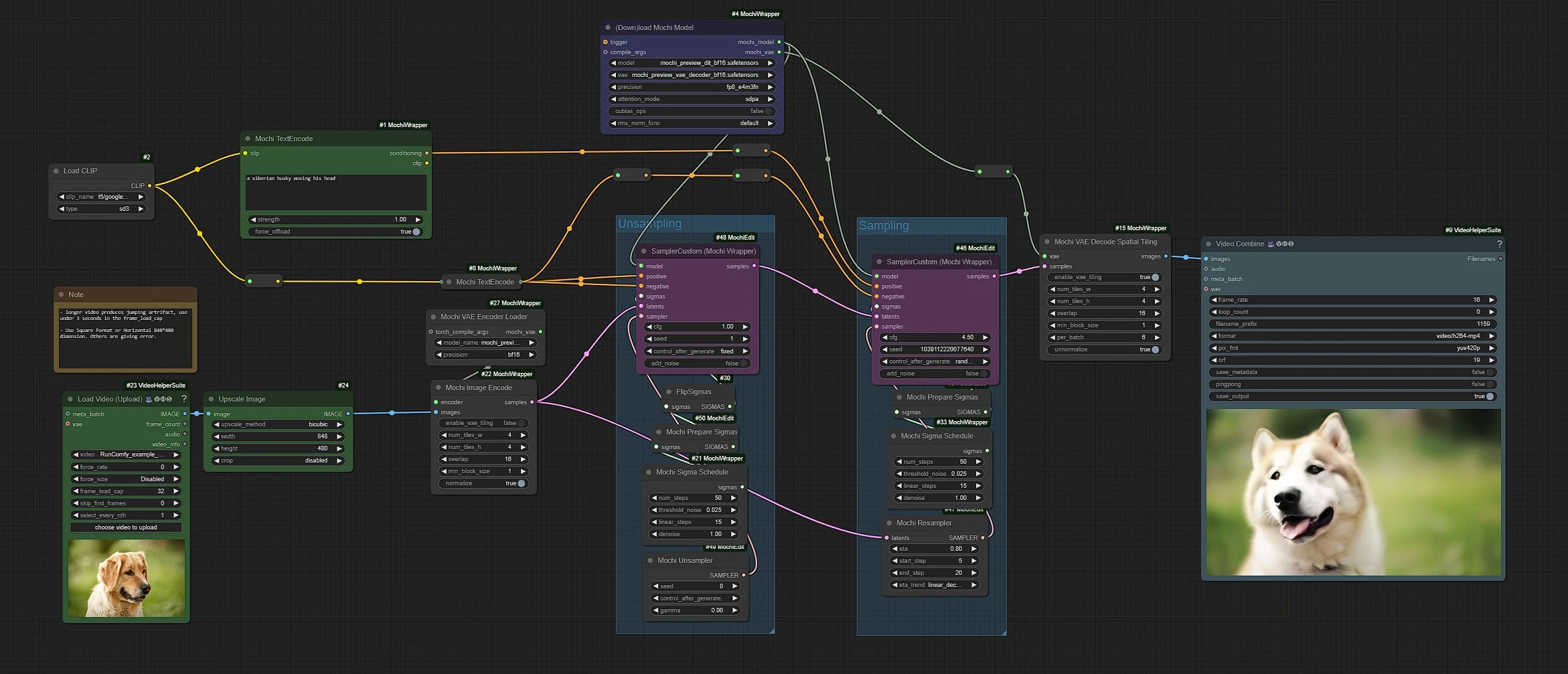

Mochi Edit verwendet Genmo Mochi und diffusionsbasierte Techniken, um Videoframes zu transformieren, indem sie in Rauschen umgewandelt und mit prompt-gesteuerten Bearbeitungen, auch bekannt als Unsampling, neu abgetastet werden. Mit Mochi Edit nahtlos in ComfyUI integriert, können Benutzer einen nahtlosen Stiltransfer, Objektmodifikationen und flüssige Animationsbearbeitungs-Workflows erreichen.ComfyUI Mochi Edit Arbeitsablauf

- Voll funktionsfähige Workflows

- Keine fehlenden Nodes oder Modelle

- Keine manuelle Einrichtung erforderlich

- Beeindruckende Visualisierungen

ComfyUI Mochi Edit Beispiele

ComfyUI Mochi Edit Beschreibung

Die Knoten und der zugehörige Workflow wurden vollständig von logtd und Kijai entwickelt. Wir geben logtd und Kijai alle Anerkennung für diese innovative Arbeit. Auf der RunComfy-Plattform präsentieren wir lediglich ihre Beiträge an die Community. Wir schätzen die Arbeit von logtd und Kijai sehr!

Der Mochi Edit Workflow ist ein Werkzeug, das es Benutzern ermöglicht, Videoinhalte mit textbasierten Prompts zu modifizieren. Es unterstützt Aufgaben wie das Hinzufügen oder Ändern von Elementen (z.B. das Platzieren von Hüten auf Charakteren), das Anpassen des Gesamtstils oder das Ersetzen von Subjekten im Filmmaterial.

1. Mochi Edit Unsampling

Im Kern von Mochi Edit liegt die Unsampling-Technik. Mochi Edit's Unsampling-Technik nutzt einen vereinfachten Ansatz zur Bearbeitung von Videos und Bildern, der Transformationen durch multi-modale Prompts ermöglicht, ohne dass zusätzliche Vorverarbeitungsschritte oder externe Netzwerkmodule erforderlich sind. Die Kernidee hinter Mochi Edit's Unsampling besteht darin, die latente Darstellung des Videos direkt zu manipulieren, anstatt komplexe Operationen wie Gesichtserkennung oder Posenabschätzung durchzuführen, die in traditionellen Bildgenerierungspipelines üblich sind. Diese Methode ist auf das übergeordnete Ziel ausgerichtet, einen flexibleren und schlankeren Prozess zur Bildgenerierung zu schaffen, ähnlich wie GPT Text aus jedem Eingabeprompt generieren kann. Mit der Unsampling-Technik von Mochi Edit können Benutzer verschiedene Stile und Modifikationen direkt aus einer multi-modalen Beschreibung generieren, was den Prozess weitaus intuitiver und effizienter macht.

Kurz gesagt, Mochi Edit ermöglicht es Ihnen, kleine Variationen des hochgeladenen Videos zu erstellen. Wie das Kopieren und Übersetzen der Bewegung des Subjekts auf ein anderes Subjekt oder das Ändern der Hintergrundeinstellungen, das Ändern der Eigenschaften des Subjekts usw.

2. Wie benutzt man den Mochi Edit Workflow?

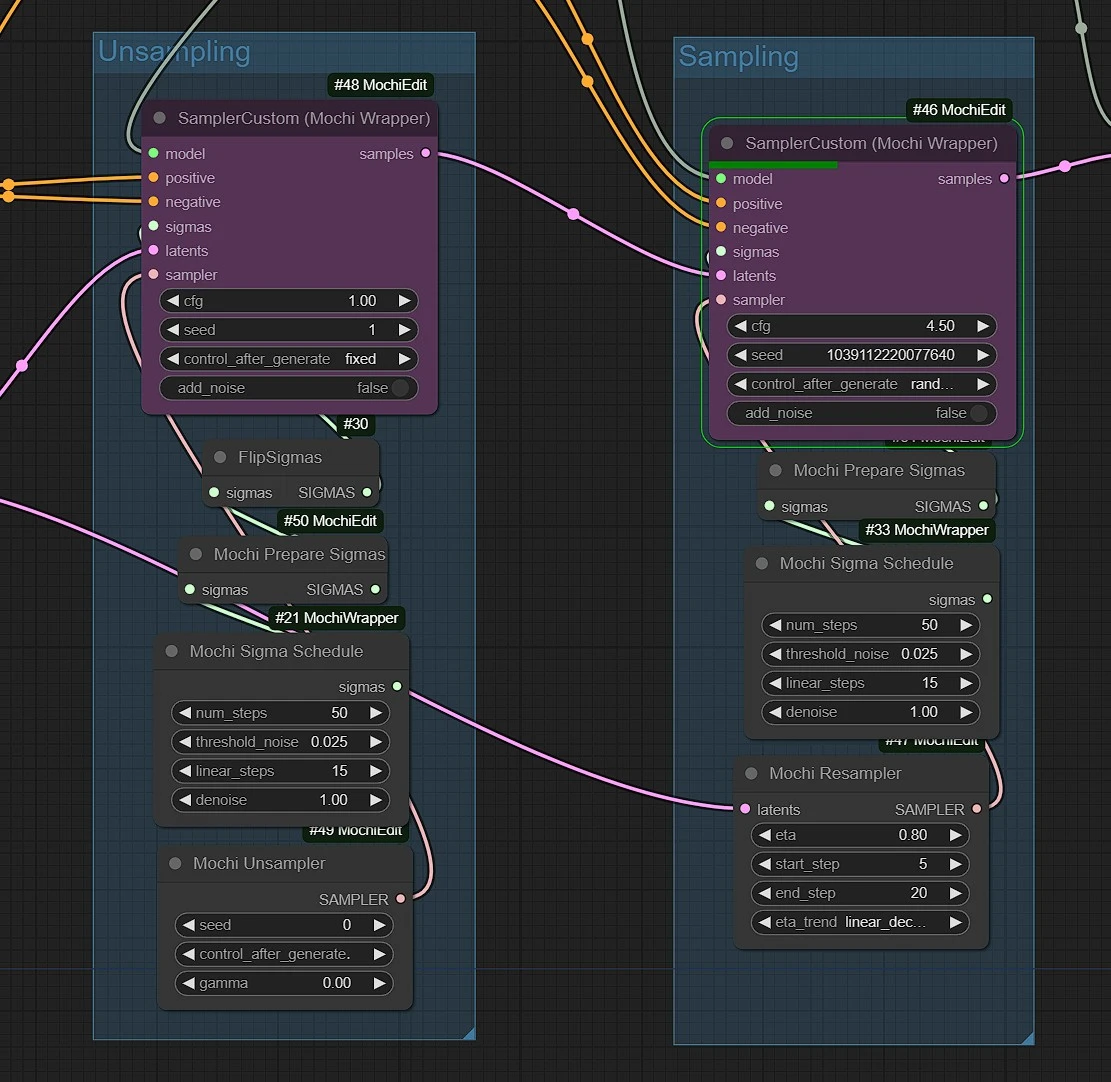

In diesem Workflow sind die linken grünen Knoten die Eingaben für Video und Text, die mittleren lila Knoten sind die Mochi Unsampler und Sampler Knoten, und rechts blau ist der Videoausgabeknoten.

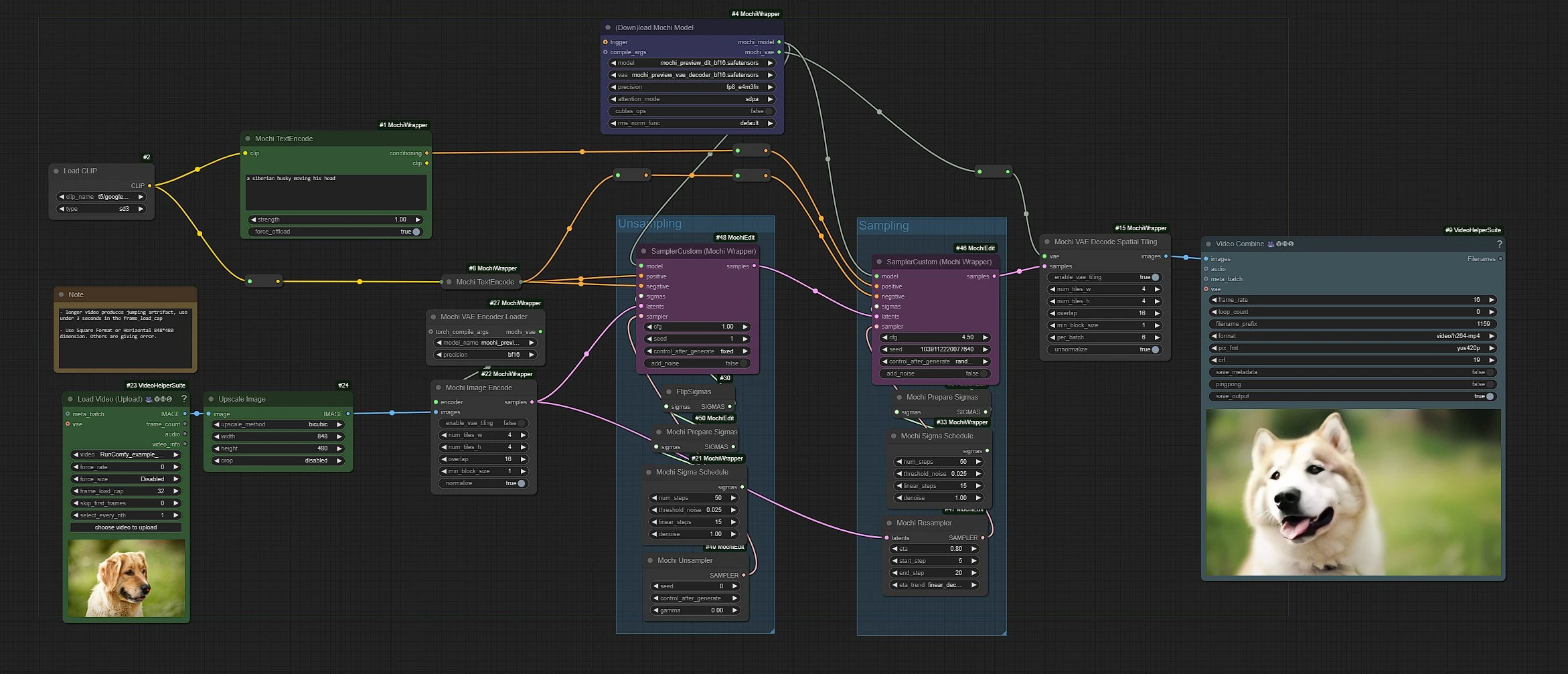

2.1 Video-Knoten laden

- Klicken Sie und laden Sie Ihr Video im Video-Laden-Knoten hoch

frame_load_cap: ist standardmäßig auf 32 Frames gesetzt. Über 32 Frames werden Springartefakte beobachtet. Halten Sie unter 3 Sekunden (32) Frames für beste Ergebnisse.skip_frames: Überspringen Sie Frames, wenn Sie von einem bestimmten Frame aus starten möchten.

Verwenden Sie das quadratische Format (512 x 512) oder das horizontale (848 x 480) Format im Upscale-Knoten. Andere führen zu Fehlern.

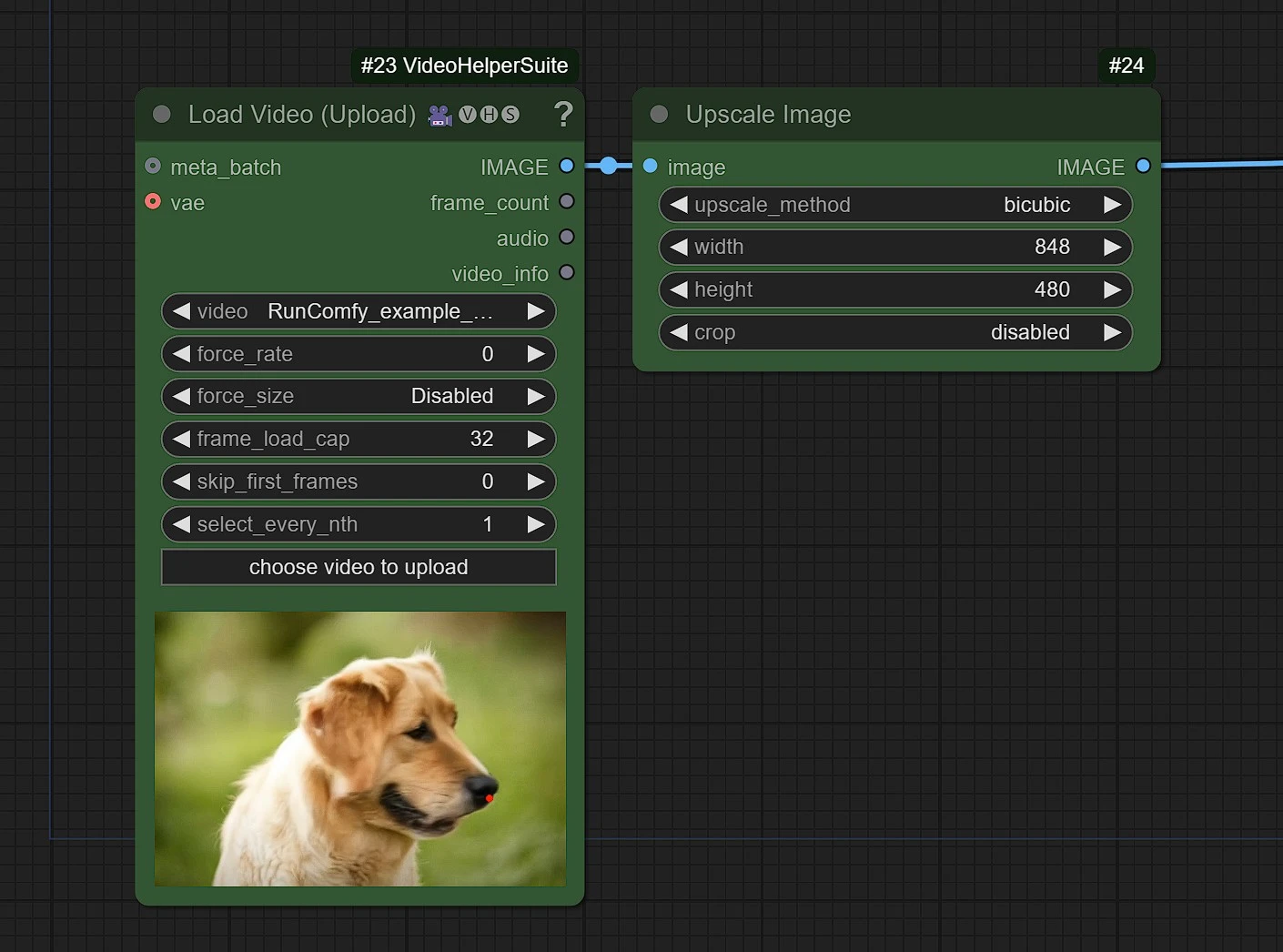

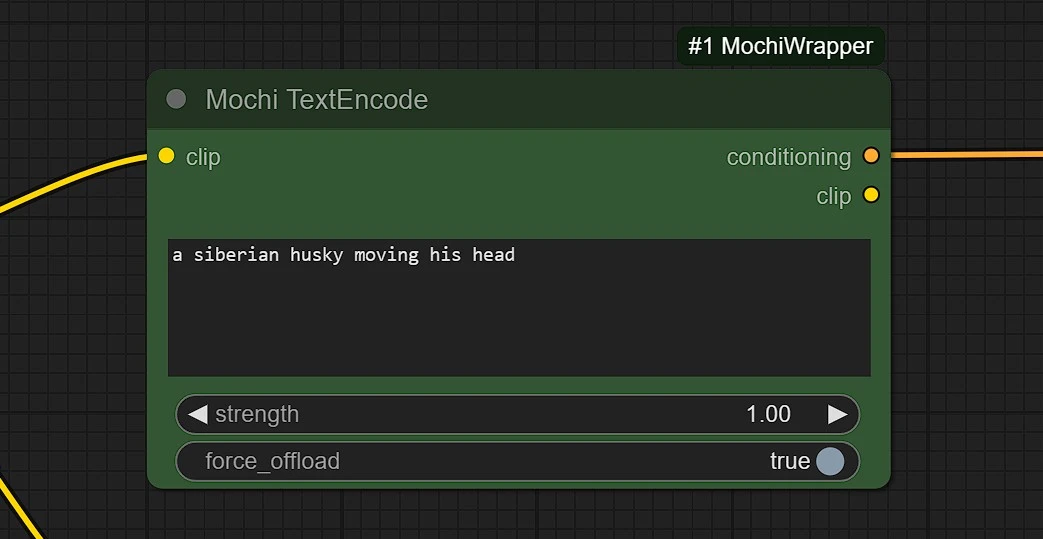

2.2 Prompts

Dies ist ein experimenteller Gebrauch, manchmal kann es funktionieren oder manchmal nicht oder manchmal das Originalvideo vollständig verändern.

- Verwenden Sie kleine Variationen des Subjekts als Prompt.

- Starke Variationen können das Bild komplett verzerren und verändern.

- Versuchen Sie einen anderen Seed, wenn Sie nicht die gewünschten Ergebnisse erzielen.

2.3 Sampling und Unsampling Knoten-Gruppen

Die Sampling und Unsampling Ksampler sind vom Autor auf die besten Einstellungen gesetzt. Wenn die Einstellungen vage bearbeitet werden, können seltsame, unerwünschte Ergebnisse entstehen. Experimentieren Sie mit:

- Sampler's

Seedfür Variationen num_stepsundlinear_step, um die Rendering-Qualität oder Geschwindigkeit zu ändern.eta,start_stepundend_Step, um die Unsampling-Stärke, den Start- und Endprozentsatz zu ändern.

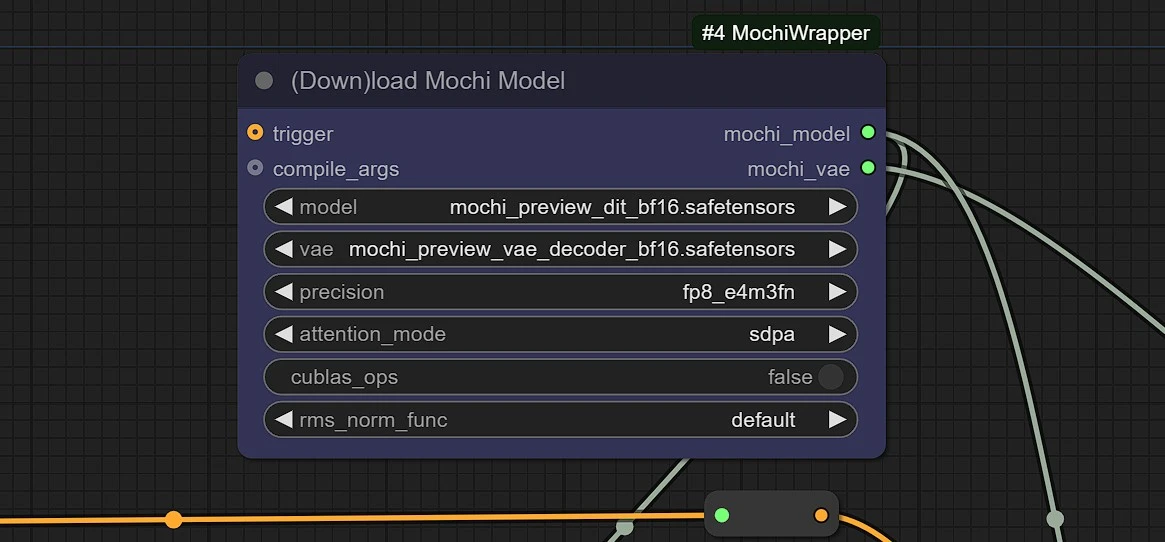

2.4 Mochi Modelle

Modelle werden automatisch aus diesem in Ihr ComfyUI heruntergeladen. Es dauert etwa 5-10 Minuten, um das 10,3-GB-Modell beim ersten Mal herunterzuladen.

Mochi Edit's Unsampling-Technik revolutioniert die Video- und Bildbearbeitung, indem sie den Prozess vereinfacht und die Notwendigkeit für komplexe Vorverarbeitung oder zusätzliche Module beseitigt. Dieser innovative Ansatz ermöglicht es Benutzern, mühelos hochwertige, maßgeschneiderte Visuals durch multi-modale Prompts zu erzeugen. Durch die Kombination von Flexibilität und Zugänglichkeit ebnet Mochi Edit den Weg für eine intuitivere und kreativere Zukunft der Bildgenerierung.