Eine detaillierte Anleitung zum Beherrschen von ComfyUI IPAdapter Plus (IPAdapter V2)

Updated: 5/16/2024

Willkommen! In dieser Anleitung werden wir die spannenden Funktionen des ComfyUI IPAdapter Plus, auch bekannt als ComfyUI IPAdapter V2, erkunden.

IPAdapter-Modelle sind sehr leistungsfähig für die Image-to-Image-Konditionierung und ermöglichen die einfache Übertragung des Motivs oder Stils von Referenzbildern auf neue Kreationen. Stellen Sie sich das wie einen 1-Bild-LoRA vor.

Die Einführung von IPAdapter Plus (IPAdapter V2) hat eine Fülle neuer Funktionen mit sich gebracht, die darauf abzielen, den Modellintegrationsprozess zu optimieren, die Benutzerfreundlichkeit zu verbessern und die kreativen Möglichkeiten zu erweitern.

Es ist wichtig zu beachten, dass ein Upgrade auf ComfyUI IPAdapter Plus (IPAdapter V2) Ihre vorherigen Workflows, die auf dem ComfyUI IPAdapter V1-Knoten basieren, beeinträchtigen wird. Folglich müssen Sie Ihre Projekte mit ComfyUI IPAdapter Plus neu aufbauen.

Wir werden behandeln:

1. ComfyUI IPAdapter Plus - IPAdapter Basic-Knoten

- 1.1. Der einfachste ComfyUI IPAdapter Workflow

- 1.2. Eingaben des ComfyUI "IPAdapter"-Knotens

- 1.3. Parameter im ComfyUI "IPAdapter"-Knoten

- 1.4. Der Unterschied bei der Verwendung von ComfyUI IPAdapter Plus mit SD1.5- und SDXL-Checkpoint-Modellen

2. ComfyUI IPAdapter Plus - IPAdapter Advanced-Knoten

- 2.1. Der ComfyUI IPAdapter Advanced Workflow

- 2.2. Erweiterte Parameter im ComfyUI "IPAdapter Advanced"-Knoten

3. ComfyUI IPAdapter Plus - FaceID

- 3.1. ComfyUI IPAdapter FaceID Workflow

4. ComfyUI IPAdapter Plus - Image Merge-Funktion

- 4.1. Methode 1: Nutzung des ComfyUI "Batch Image"-Knotens

- 4.2. Methode 2: Präzise Kontrolle über Referenzgewichtungen mit dem ComfyUI "IPAdapter Encoder"-Knoten

5. ComfyUI IPAdapter Plus - IPAdapter Tile für große Bilder

- 5.1 ComfyUI IPAdapter Tile Workflow

6. ComfyUI IPAdapter Plus - Stil und Komposition

- 6.1. ComfyUI IPAdapter Plus für die Stilübertragung

- 6.2. ComfyUI IPAdapter Plus zum Beibehalten der Komposition

- 6.3. ComfyUI IPAdapter Plus zum Beibehalten von Komposition und Stilübertragung

🌟🌟🌟 ComfyUI Online - Erleben Sie den IPAdapter Plus Workflow jetzt 🌟🌟🌟

Wenn Sie daran interessiert sind, den ComfyUI IPAdapter Plus (IPAdapter V2) Workflow zu erkunden, nutzen Sie das folgende ComfyUI-Web. Es ist vollständig mit allen wichtigen Customer-Knoten und -Modellen ausgestattet und ermöglicht nahtlose Kreativität ohne manuelle Setups. Sammeln Sie sofort praktische Erfahrungen oder fahren Sie mit diesem Tutorial fort, um zu lernen, wie Sie IPAdapter Plus effektiv nutzen können.

Für fortgeschrittenere und Premium-ComfyUI-Workflows besuchen Sie unsere 🌟ComfyUI-Workflow-Liste🌟

1. ComfyUI IPAdapter Plus - IPAdapter Basic-Knoten

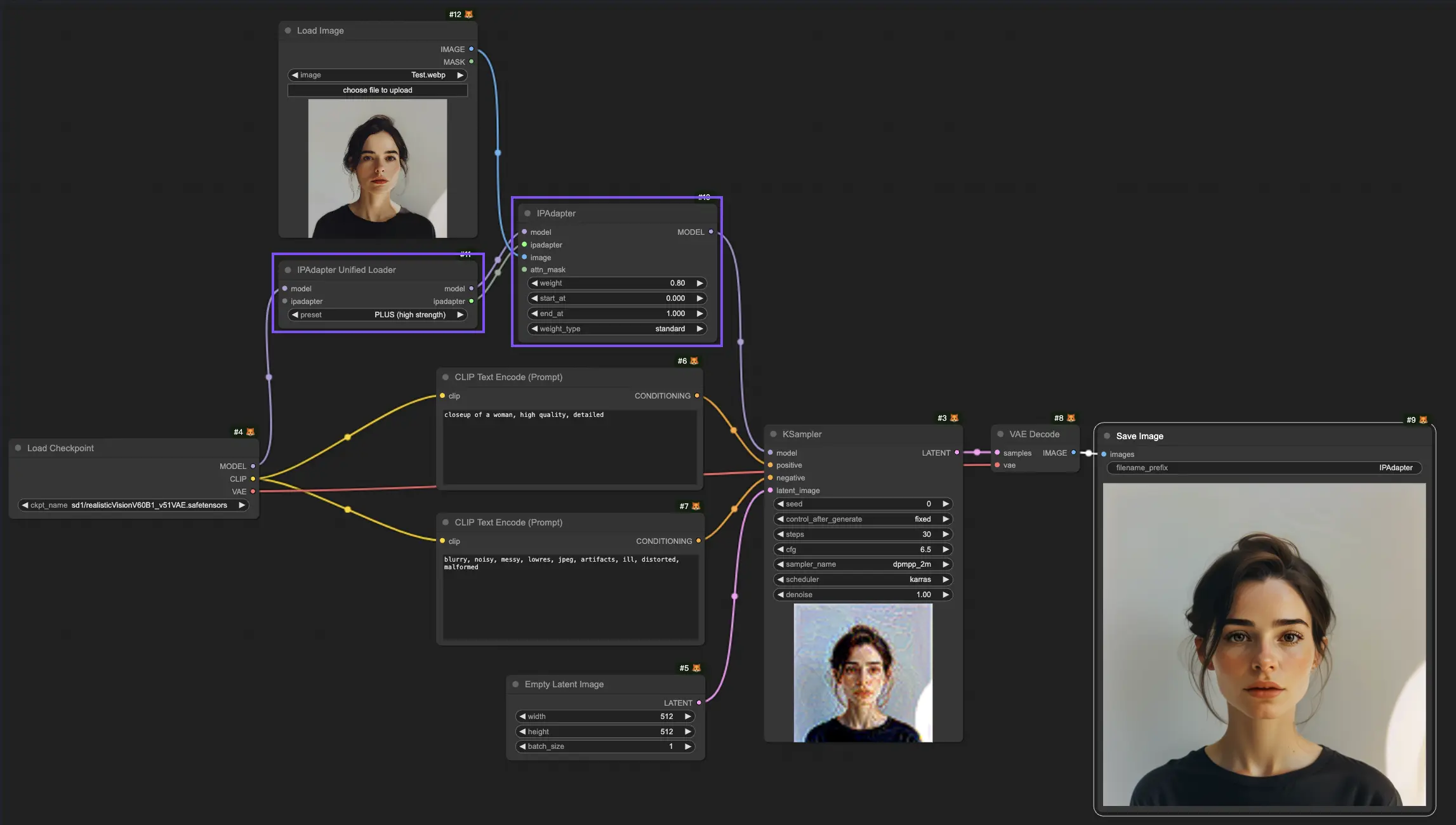

1.1. Der einfachste ComfyUI IPAdapter Workflow

1.2. Eingaben des ComfyUI "IPAdapter"-Knotens

1.2.1. Eingaben des "IPAdapter"-Knotens: Modell und IPAdapter

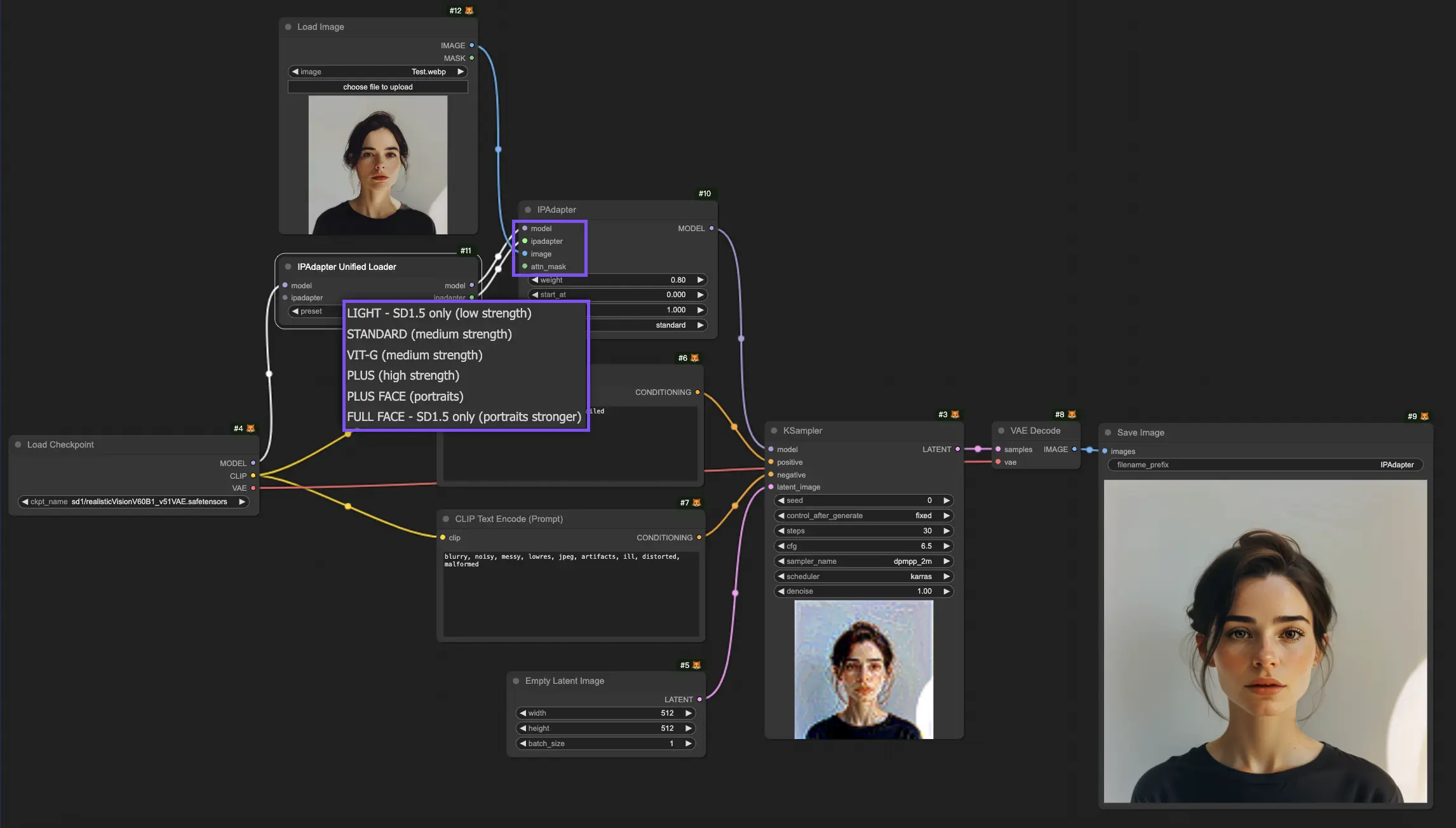

Die Eingaben "Modell" und "IPAdapter" des "IPAdapter"-Knotens sind mit dem Ausgang des "IPAdapter Unified Loader"-Knotens verbunden. Hier können Sie aus verschiedenen IPAdapter-Modellen wählen, die jeweils auf unterschiedliche Anforderungen zugeschnitten sind:

- Light - Nur SD1.5 (geringe Stärke): Dieses Modell eignet sich für minimale Anpassungen und ist ausschließlich mit dem SD1.5-Modell kompatibel.

- Standard (mittlere Stärke): Dieses Modell erzielt Modifikationen mittlerer Intensität, die für eine breite Palette von Anwendungen geeignet sind und subtile und spürbare Änderungen ausbalancieren.

- VIT-G (mittlere Stärke): Obwohl es ähnlich wie Standard mittlere Anpassungen bietet, ist das VIT-G-Modell für komplexere oder vielfältigere Bilddaten optimiert, was die Leistung in bestimmten Szenarien potenziell verbessert.

- PLUS (hohe Stärke): Für diejenigen, die substanzielle Modifikationen benötigen, bietet das PLUS-Modell leistungsstarke kreative Möglichkeiten und ermöglicht erhebliche Änderungen.

- PLUS FACE (Porträts): Speziell für die Verbesserung von Porträts entwickelt, konzentriert sich PLUS FACE auf die Optimierung von Gesichtsmerkmalen und ist ideal für Porträtfotografie und -kunst.

- Full FACE - Nur SD1.5 (stärkere Porträts): Als intensivere Version von PLUS FACE ist das Full FACE-Modell für dramatische Transformationen in Porträts konzipiert, ist aber nur mit dem SD1.5-Modell kompatibel.

1.2.2. Eingaben des "IPAdapter"-Knotens: Bild

Die Eingabe "Bild" des "IPAdapter"-Knotens ist das Referenzbild, das für die Image-to-Image-Konditionierung verwendet wird. Hier wendet der "IPAdapter"-Knoten seine transformativen Fähigkeiten an und verändert das Referenzbild basierend auf den definierten Parametern und Funktionen des Modells. Durch diesen Prozess werden neue Bilder generiert, die Attribute aus dem Referenzbild übernehmen und mit dem kreativen Potenzial des IPAdapter-Modells verschmelzen.

1.2.3. Eingaben des "IPAdapter"-Knotens: Attn Mask (Aufmerksamkeitsmaske)

Mit der "Attn Mask" können Sie bestimmte Bildbereiche für eine fokussierte Verarbeitung hervorheben oder die Aufmerksamkeit des Modells lenken, um bestimmte Bildmerkmale zu verstärken oder zu erhalten, während Sie den Fokus des Modells steuern.

1.3. Parameter im ComfyUI "IPAdapter"-Knoten

1.3.1. Parameter im "IPAdapter"-Knoten: Gewicht

Der Parameter "Gewicht" passt die Intensität der angewandten Modifikationen an; höhere Werte führen zu ausgeprägteren Effekten, während niedrigere Werte subtilere Änderungen bewirken.

1.3.2. Parameter im "IPAdapter"-Knoten: Start bei & Ende bei

Die Parameter "Start bei" und "Ende bei" legen die Anfangs- und Endschritte fest, bei denen die Effekte des IPAdapter angewendet werden, und bieten Kontrolle über die Verarbeitung.

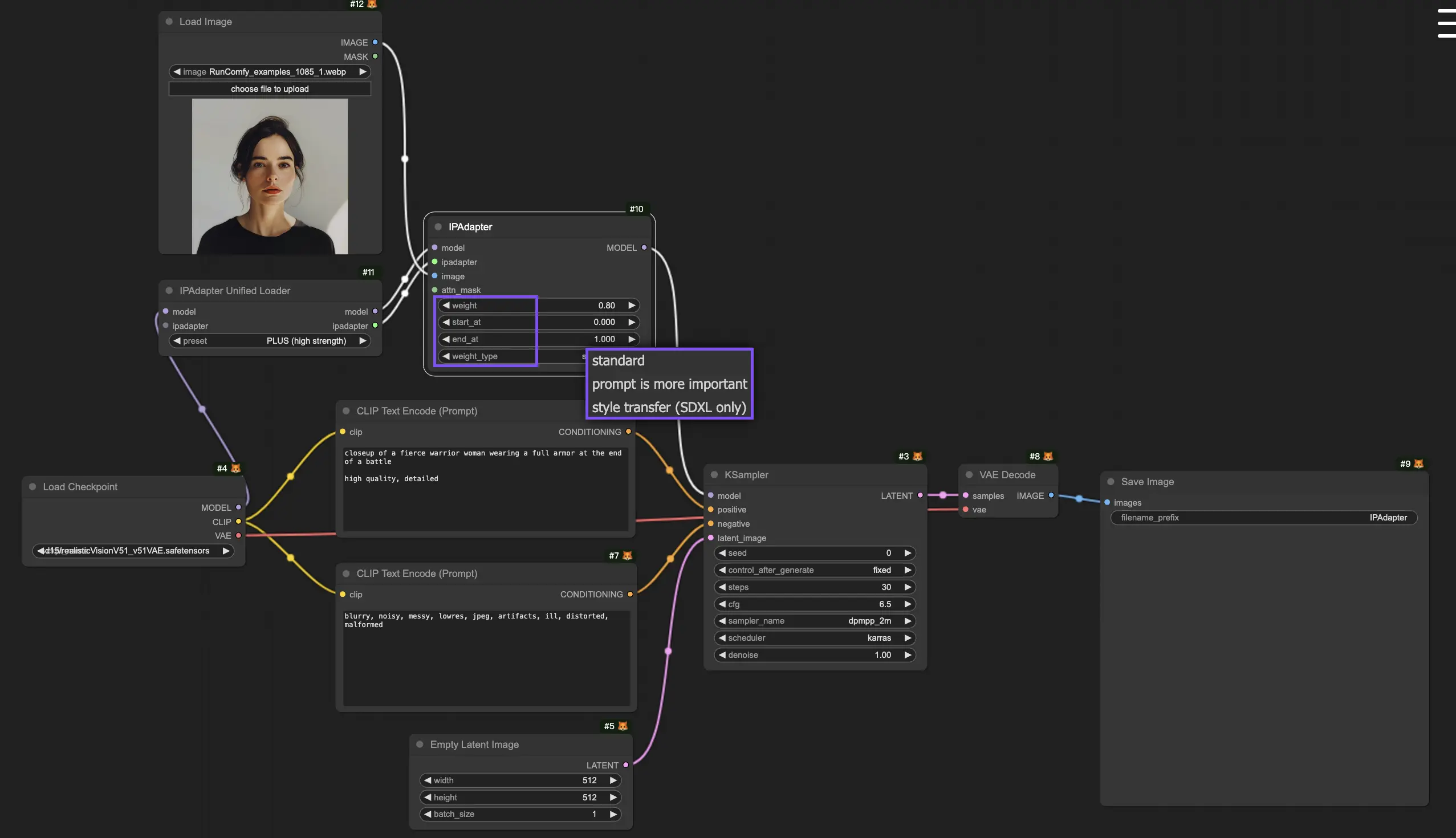

1.3.3. Parameter im "IPAdapter"-Knoten: Gewichtstyp

Der "Gewichtstyp" für die Anwendung von Gewicht durch die Verarbeitungsstufen variiert, wobei jeder Typ die Ausgabe auf eine eigene Weise beeinflusst:

- Standard

- Prompt ist wichtiger

- Stilübertragung (nur SDXL)

1.4. Der Unterschied bei der Verwendung von ComfyUI IPAdapter Plus mit SD1.5- und SDXL-Checkpoint-Modellen

Bei der Arbeit mit SDXL-Modellen integriert sich das IPAdapter Plus-Modell nahtlos und passt sich automatisch an die Eigenschaften des SDXL-Modells an. Es ist jedoch wichtig, die Latentgröße entsprechend anzupassen, um sie an die Anforderungen des SDXL-Modells anzugleichen.

2. ComfyUI IPAdapter Plus - IPAdapter Advanced-Knoten

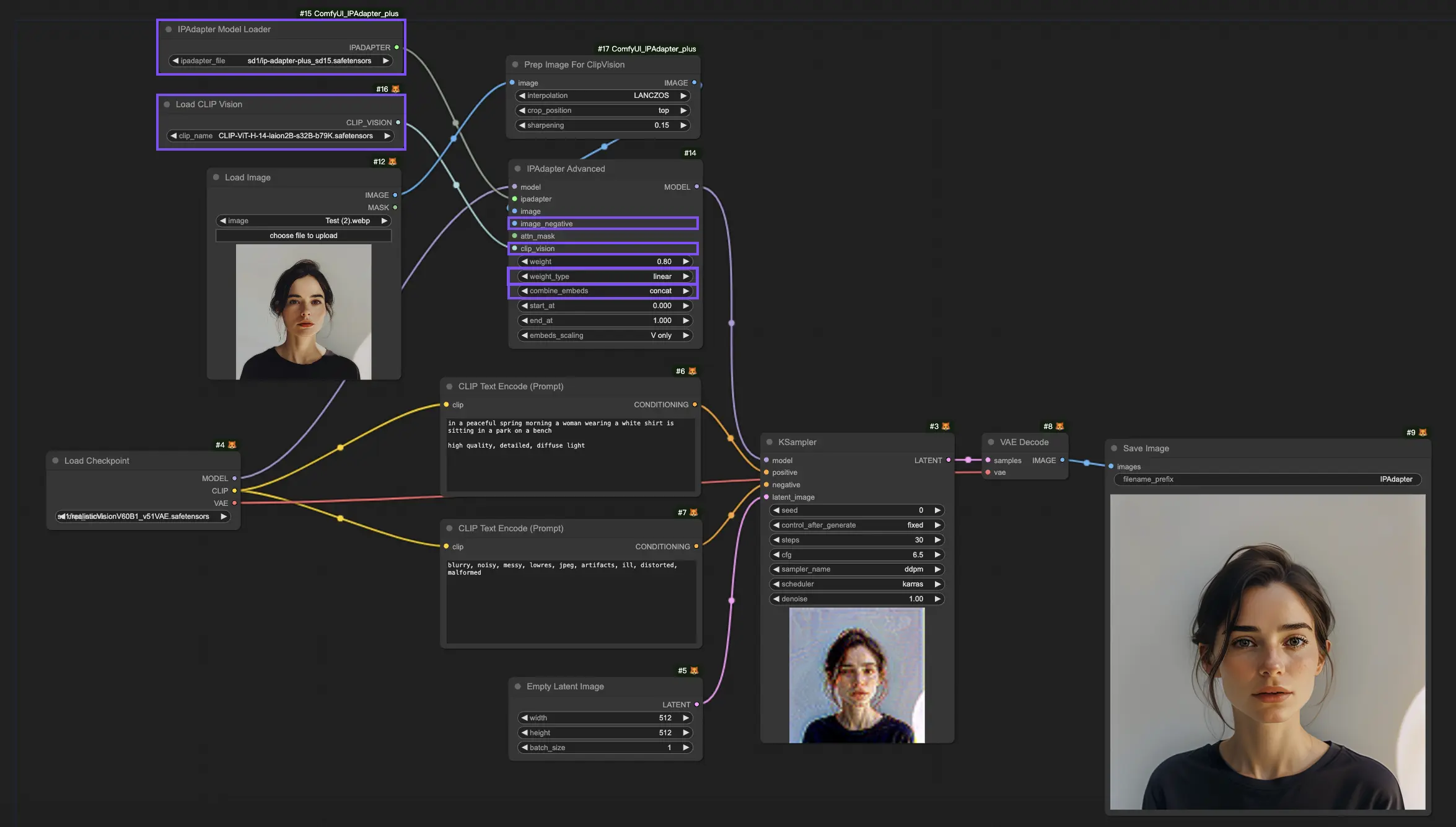

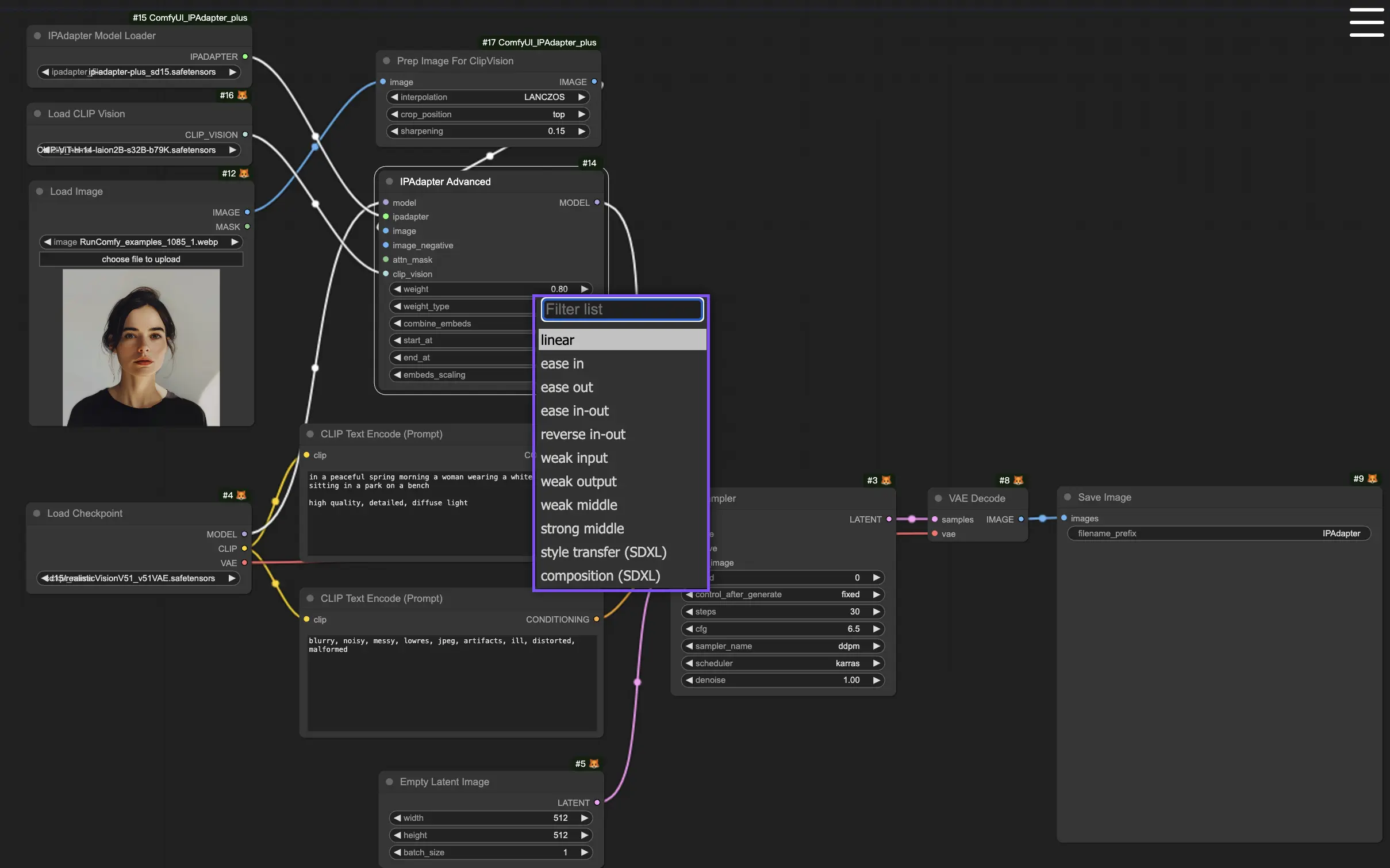

2.1. Der ComfyUI IPAdapter Advanced Workflow

Der ComfyUI IPAdapter Advanced-Knoten bietet eine umfassendere Funktionspalette und verbessert die Kontrolle über den Generierungsprozess durch Parameter wie "Image Negative", "CLIP Vision", "Combine Embeds" und weitere Optionen für "Weight Type", um Bilder näher an Ihre kreative Vision anzupassen.

2.2. Erweiterte Parameter im ComfyUI "IPAdapter Advanced"-Knoten

2.2.1. Erweiterte Parameter im "IPAdapter Advanced"-Knoten: Image Negative

Der Parameter "Image Negative" ermöglicht es Ihnen zu definieren, was nicht im finalen Bild erscheinen soll. Durch die Angabe negativer Beispiele wird das Modell von unerwünschten Elementen weggelenkt und in Richtung eines wünschenswerteren Ergebnisses gesteuert. Diese Funktion ist entscheidend, um bestimmte Themen, Objekte oder Muster im generierten Bild zu vermeiden und sicherzustellen, dass die Ausgabe den Vorlieben des Benutzers entspricht.

2.2.2. Erweiterte Parameter im "IPAdapter Advanced"-Knoten: CLIP Vision

Im Knoten "IPAdapter Advanced" finden Sie die Eingabe "CLIP Vision". Diese verbindet sich mit dem Ausgang des Knotens "Load CLIP Vision", wo Sie aus verschiedenen CLIP-ViT-Modellen wählen können.

- CLIP-ViT-H-14-laion2B-s32B-b79K.safetensors: Diese Modellvariante gehört zur Familie CLIP (Contrastive Language–Image Pre-training) und wurde speziell entwickelt, um visuelle Inhalte in Bezug auf Textinformationen zu verstehen und zu interpretieren. Sie wurde auf einem großen Datensatz (laion2B) mit einer Modellgröße von 32 Milliarden Parametern (s32B) trainiert und optimiert, um Leistung und Sicherheit bei der Inhaltsgenerierung (b79K weist auf eine bestimmte Benchmark- oder Versionsangabe hin) auszubalancieren. Dieses Modell ist in der Lage, eine breite Palette von Aufgaben zur visuellen Erkennung zu bewältigen, was es für die Generierung qualitativ hochwertiger, kontextuell präziser Bilder geeignet macht.

- CLIP-ViT-bigG-14-laion2B-39B-b160k.safetensors: Ähnlich wie sein Gegenstück ist auch dieses Modell auf dem laion2B-Datensatz trainiert, hat aber eine größere Modellgröße von 39 Milliarden Parametern, was es in die Lage versetzt, noch nuanciertere Beziehungen zwischen Text und Bildern zu verstehen. Das "bigG" bezeichnet möglicherweise eine größere oder fortschrittlichere Version innerhalb der CLIP-ViT-Serie, wobei "b160k" dessen Benchmark oder Version kennzeichnet. Dieses Modell zeichnet sich bei der Erstellung detaillierter und komplexer Bilder aus, die eng mit Textbeschreibungen übereinstimmen, und eignet sich für Anwendungen, die eine hohe Wiedergabetreue und ein tiefes semantisches Verständnis erfordern.

Der Hauptunterschied zwischen CLIP-ViT-H-14-laion2B-s32B-b79K.safetensors und CLIP-ViT-bigG-14-laion2B-39B-b160k.safetensors liegt in ihrer Größe und potenziellen Komplexitätsbewältigung, wobei letzteres mit 39 Milliarden Parametern größer ist, was darauf hindeutet, dass es nuanciertere Text-Bild-Beziehungen interpretieren kann als die 32 Milliarden Parameter des ersteren.

2.2.3. Erweiterte Parameter im "IPAdapter Advanced"-Knoten: Gewichtstyp

Im Vergleich zum "IPAdapter"-Knoten bietet der "IPAdapter Advanced"-Knoten mehr Optionen für den "Gewichtstyp", die sich jeweils auf unterschiedliche Weise auf die Ausgabe auswirken:

- Linear: Wendet das Gewicht gleichmäßig vom Anfang bis zum Ende der Verarbeitungspipeline an und stellt so einen konsistenten Einfluss ohne Modulationen der Intensität sicher.

- Ease In: Erhöht das Gewicht schrittweise vom Beginn an, was eine sanfte Einführung des Effekts ermöglicht, während er durch die Pipeline fortschreitet.

- Ease Out: Beginnt mit einem starken Einfluss, der allmählich abnimmt und den Effekt effektiv gegen Ende der Verarbeitung ausläuft.

- Ease In-Out: Eine Kombination aus den Effekten "Ease In" und "Ease Out"; beginnt und endet mit einem milderen Einfluss und erreicht in der Mitte die maximale Wirkung.

- Weak Input: Reduziert gezielt den Einfluss des Effekts zu Beginn der Verarbeitungskette, wodurch die Anfangselemente weniger ausgeprägt sind.

- Weak Output: Verringert den Einfluss gegen Ende der Verarbeitungskette und schwächt die abschließenden Aspekte des Bildes ab.

- Weak Middle: Minimiert den Einfluss des Effekts in der Mitte der Verarbeitungskette, oft um die Klarheit oder den Fokus auf die Anfangs- und Endaspekte beizubehalten.

- Strong Middle: Verstärkt den Effekt im zentralen Teil der Verarbeitungskette und intensiviert die Auswirkungen auf die Kernelemente des Bildes.

- Style Transfer (SDXL): Speziell für SDXL-Modelle entwickelt, konzentriert sich diese Option auf die Anpassung des Stils aus dem Referenzbild an das Zielbild und nutzt dabei die Fähigkeiten von SDXL für eine nuancierte stilistische Transformation.

- Composition (SDXL): Ebenfalls auf SDXL-Modelle zugeschnitten, zielt diese Option darauf ab, die Kompositionselemente der Referenz- und Zielbilder zu verschmelzen, wobei der Schwerpunkt auf der Anordnung und Interaktion der Elemente innerhalb des Raums liegt.

2.2.4. Erweiterte Parameter im "IPAdapter Advanced"-Knoten: Combine Embeds

Die Funktion "Combine Embeds" ist unverzichtbar für diejenigen, die Eingaben aus mehreren Quellen zu einer einzigen, kohärenten visuellen Ausgabe zusammenführen möchten. Durch die Nutzung von "Combine Embeds" haben Sie die Flexibilität, Bilder zu erstellen, die eine breite Palette von künstlerischen Einflüssen und Inspirationen integrieren, was zu wirklich personalisierten und innovativen Kreationen führt. Die bereitgestellten Methoden zum Kombinieren von Embeds, wie Concat, Add, Subtract, Average und Norm Average, bieten vielfältige Ansätze zum Zusammenführen dieser Einflüsse. Diese werden in Abschnitt 4, "ComfyUI IPAdapter Image Merge-Funktion", ausführlich erläutert.

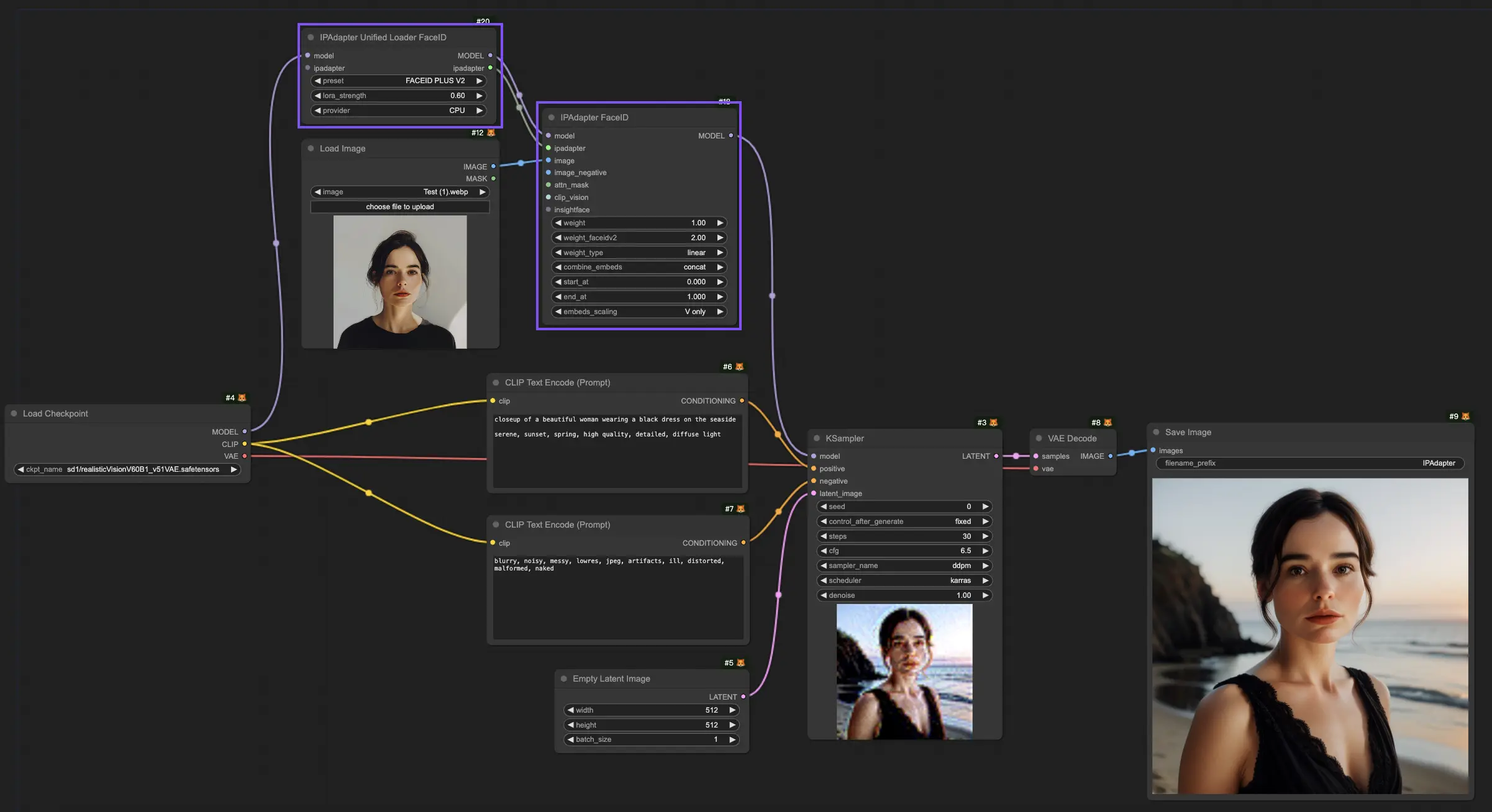

3. ComfyUI IPAdapter Plus - FaceID

In der oben erwähnten Konfiguration ist Ihnen möglicherweise das Fehlen des FaceID-Modells aufgefallen. Um das Face ID Model in Ihren Workflow zu integrieren, sind zwei spezielle Knoten erforderlich: der "IPAdapter Unified Loader FaceID"-Knoten und der "IPAdapter FaceID"-Knoten.

3.1. ComfyUI IPAdapter FaceID Workflow

Bei der Arbeit mit dem Knoten "IPAdapter Unified Loader FaceID" können Sie im Dropdown-Menü der verfügbaren Modelle das neueste "Face ID Plus V2" auswählen. Diese Aktion weist den Loader an, automatisch alle erforderlichen Abhängigkeiten zu sammeln und vorzubereiten, die speziell für das Face ID Plus V2-Modell erforderlich sind.

Entscheiden Sie sich für die CPU als Provider. Trotz der potenziellen Verfügbarkeit einer Hochleistungs-GPU wird empfohlen, das Face ID-Modell so zu konfigurieren, dass es die CPU als Provider nutzt. Diese Empfehlung basiert auf dem Vorteil, wertvolles Video-RAM (VRAM) zu sparen, eine Strategie, die sich als vorteilhaft erweist und dazu beiträgt, die Gesamteffizienz und Effektivität der Ressourcenzuweisung Ihres Projekts zu optimieren.

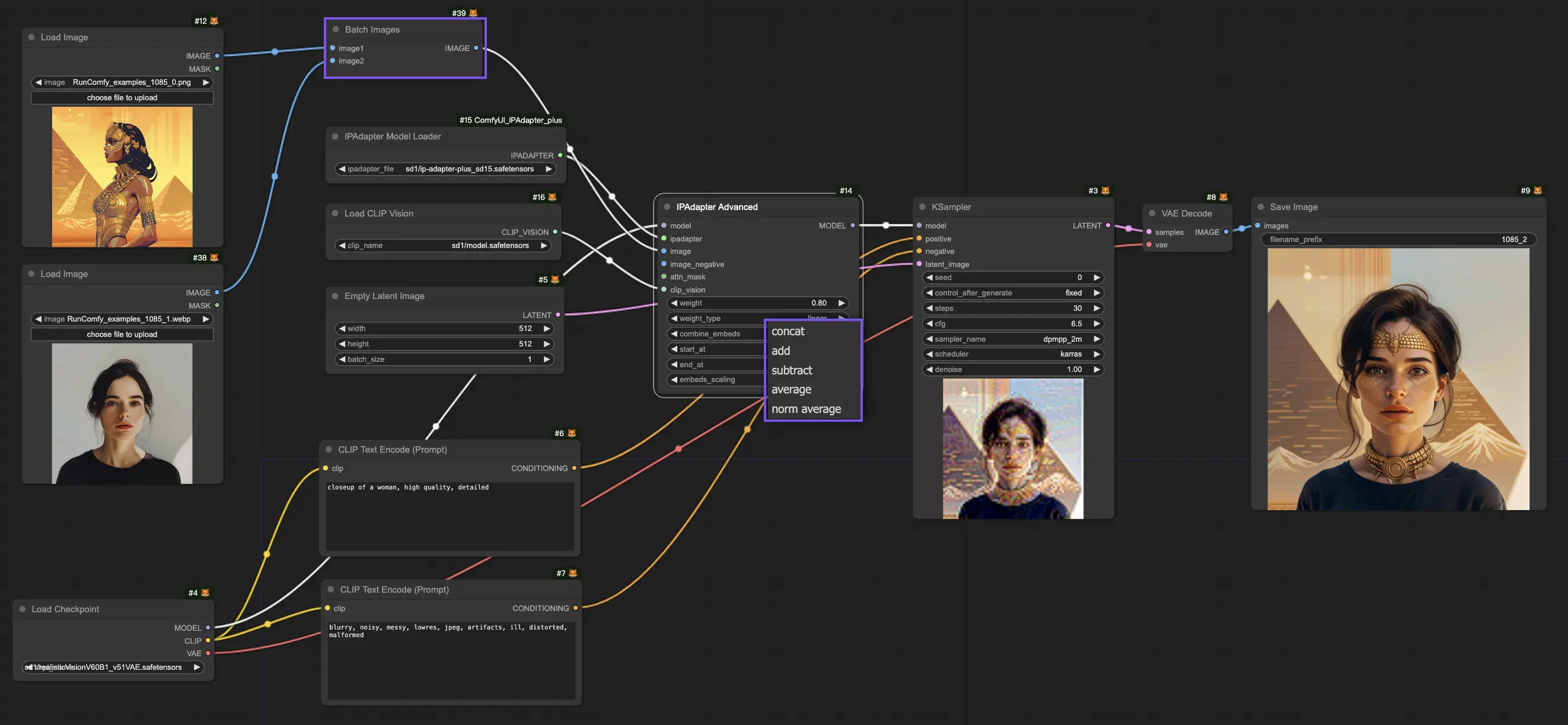

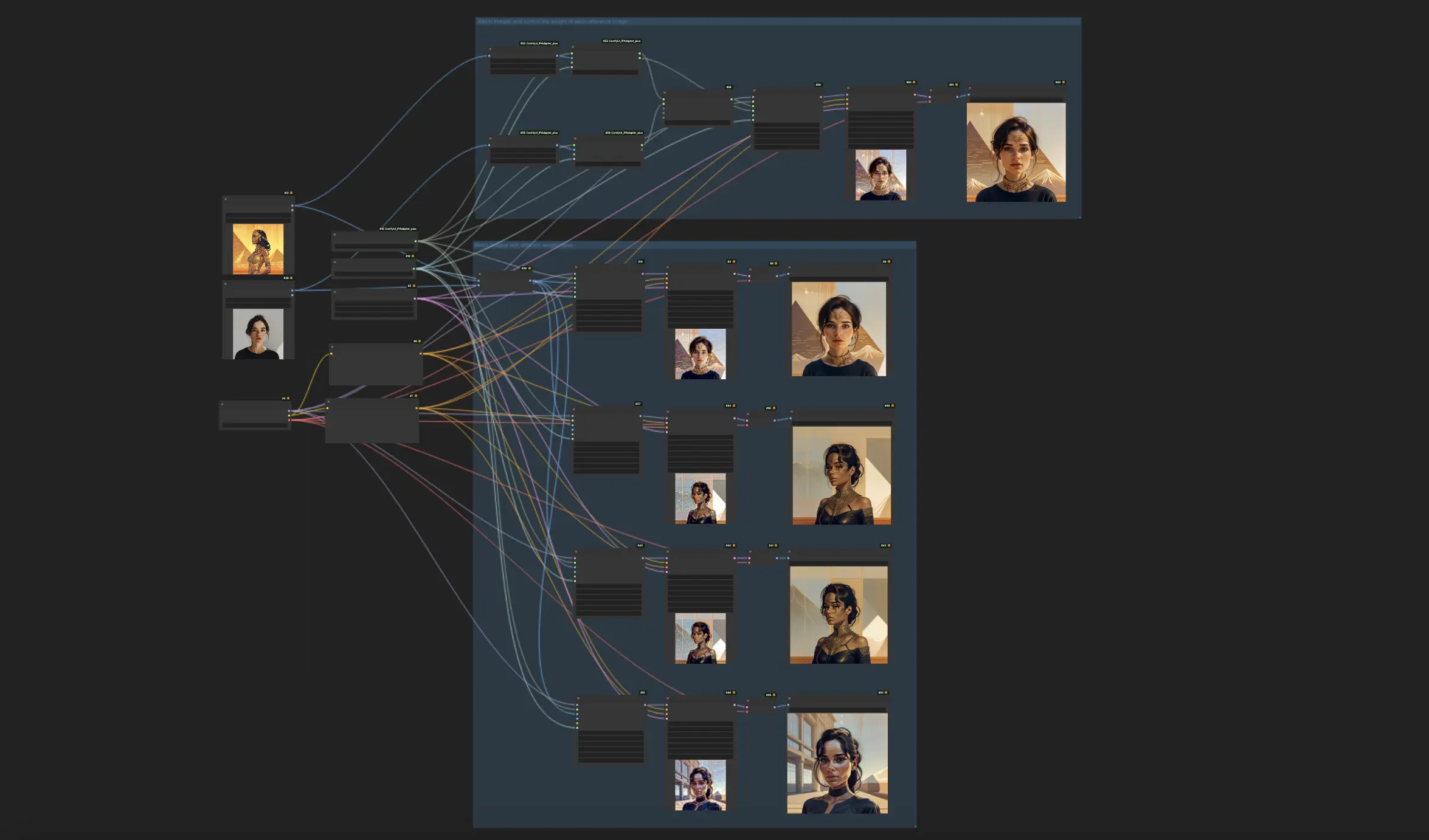

4. ComfyUI IPAdapter Plus - Image Merge-Funktion

Wie verwendet man mehrere Referenzbilder, um ein neues zu erzeugen? Hier sind zwei Methoden, um dies mit ComfyUIs IPAdapter Plus zu erreichen, die Ihnen die nötige Flexibilität und Kontrolle für die kreative Bilderzeugung bieten.

4.1. Methode 1: Nutzung des ComfyUI "Batch Image"-Knotens

Um mit dem "Batch Image"-Knoten zu beginnen, müssen Sie zunächst die Bilder auswählen, die Sie zusammenführen möchten. Diese Bilder werden dann in den Knoten eingegeben und erstellen einen einheitlichen Batch. Dieser Batch wird anschließend in die IPAdapter-Pipeline eingespeist, wobei jedes Bild sequenziell auf den generativen Prozess angewendet wird.

Der Knoten "IPAdapter Advanced" führt die Optionen "Combine Embeds" ein, die Ihnen eine raffinierte Kontrolle darüber geben, wie mehrere Bilder die Generierung beeinflussen. Diese Optionen — Concat, Add, Subtract, Average und Norm Average — bestimmen, wie Einbettungen von verschiedenen Bildern zusammengeführt werden, wobei jede Option zu einzigartigen Ergebnissen führt:

- Concat: Diese Option verknüpft die Einbettungen jedes Bildes und bewahrt und kombiniert so effektiv die Informationen aller Eingangsbilder in einem einzigen, erweiterten Format. Dieser Ansatz ist vorteilhaft für die Einbeziehung eines breiten Spektrums an Merkmalen aus jedem Bild, kann aber aufgrund der erhöhten Menge an verarbeiteten Informationen zu Komplexität führen.

- Add: Durch die Summierung der Einbettungen der Bilder bündelt die "Add"-Methode deren Einflüsse und verstärkt Merkmale, die den Bildern gemeinsam sind. Dies kann besonders nützlich sein, um gemeinsame Merkmale oder Themen hervorzuheben, was potenziell zu einer einheitlicheren und kohärenteren Ausgabe führt.

- Subtract: Im Gegensatz zur Addition differenziert die "Subtract"-Methode die Einbettungen durch Subtraktion und hebt so die einzigartigen Aspekte jedes Bildes hervor. Dieser Ansatz ermöglicht die kreative Erforschung von Kontrasten und kann verwendet werden, um bestimmte Elemente, die in den Referenzbildern vorhanden sind, zu verringern, was neue Wege für den künstlerischen Ausdruck bietet.

- Average: Durch die Mittelwertbildung der Einbettungen erreicht diese Methode eine ausgewogene Verschmelzung der Eigenschaften der Bilder und stellt sicher, dass der Einfluss eines einzelnen Bildes nicht zu dominant ist. Diese Technik ist ideal, um eine harmonische Integration mehrerer Bilder zu erreichen, die eine zusammenhängende Ausgabe liefert, die die Eingangsbilder gleichmäßig repräsentiert.

- Norm Average (Normierter Durchschnitt): Diese Option passt den Einfluss jedes Bildes basierend auf seinem relativen Gewicht innerhalb des Batches an und ermöglicht eine präzise Kontrolle darüber, wie jedes Referenzbild zur endgültigen Komposition beiträgt. Es erlaubt die Feinabstimmung des Erscheinungsbilds des generierten Bildes und gewährleistet, dass das Endergebnis eng mit der Vision des Benutzers übereinstimmt.

Im folgenden Bild erhalten Sie durch die Verwendung verschiedener "Combine Embeds" unterschiedliche Ergebnisse.

4.2. Methode 2: Präzise Kontrolle über Referenzgewichtungen mit dem ComfyUI "IPAdapter Encoder"-Knoten

Für diejenigen, die eine feinere Kontrolle darüber wünschen, wie Referenzbilder im endgültigen Bild gewichtet werden, bietet IPAdapter eine Lösung durch die Verwendung von "IPAdapter Encoder"-Knoten und einem "IPAdapter Combine Embeds"-Knoten.

4.2.1. Nutzung von "IPAdapter Encoder"-Knoten

Jedes Bild im Zusammenführungsprozess wird durch einen IPAdapter-Encoder-Knoten verarbeitet, der die Bilder für die Kompatibilität mit dem IPAdapter kodiert. Innerhalb der "IPAdapter Encoder"-Knoten können Sie jedem Bild spezifische Gewichte zuweisen und so deren Einfluss auf die zusammengeführte Ausgabe festlegen. Durch Anpassen dieser Gewichte können Sie nuanciert kontrollieren, wie dominant oder subtil jedes Bild in der Komposition ist.

4.2.2. Zusammenführung mit dem "IPAdapter Combine Embeds"-Knoten

Nach der Kodierung der Bilder und der Festlegung ihrer Gewichte führt der "IPAdapter Combine Embeds"-Knoten deren kodierte Darstellungen zusammen. Er kombiniert die positiven Einbettungen aus den Encoder-Knoten und spiegelt so den beabsichtigten Einfluss jedes Bildes auf die zusammengeführte Ausgabe wider. Diese ausgewogene Einbettung ist dann für die Synthese bereit.

4.2.3. Verbindung zum "IPAdapter"-Knoten

Die synthetisierte Einbettung wird schließlich vom IP Adapter verarbeitet, um das neue Bild zu erzeugen. Obwohl die Verbindung negativer Einbettungen optional ist, wird sie empfohlen, um Rechenressourcen zu sparen. Durch Auswahl einer der beiden negativen Einbettungen aus den Encoder-Knoten und deren Verbindung mit dem IPAdapter-Knoten wird der Prozess optimiert, unnötige Berechnungen minimiert und der Zusammenführungsprozess gestrafft.

Durch Befolgen dieser Methoden können Sie effektiv mehrere Bilder zusammenführen, um neue, kreative Kompositionen zu erzeugen und die Möglichkeiten von ComfyUI IPAdapter Plus voll auszuschöpfen!

5. ComfyUI IPAdapter Plus - IPAdapter Tile für große Bilder

Bei der Verarbeitung großer Bilder stoßen Sie möglicherweise auf eine besondere Herausforderung: Der CLIP Vision-Encoder, eine zentrale Komponente des IPAdapter-Frameworks, bevorzugt inhärent quadratische Bilder. Diese Präferenz kann zu Beschneidungsproblemen führen, wenn ein großes Bild direkt mit einem IPAdapter-Knoten verbunden wird, was typischerweise dazu führt, dass nur der mittlere Teil des Bildes die Ausgabe beeinflusst. Folglich könnten die oberen und unteren Abschnitte Ihres Bildes ignoriert werden, was die Gesamtqualität des generierten Inhalts beeinträchtigt.

Um dieses Problem zu lösen, bietet der Knoten "IPAdapter Tiled" eine maßgeschneiderte Lösung. Er ermöglicht die direkte Verbindung großer Bilder, indem er das Bild in kleinere, handhabbare Kacheln segmentiert. Diese Methode stellt sicher, dass jeder Teil Ihres Referenzbildes während des Generierungsprozesses berücksichtigt wird und vermeidet so das Problem der partiellen Bildvernachlässigung.

5.1 ComfyUI IPAdapter Tile Workflow

Eine zusätzliche Funktion des "IPAdapter Tiled"-Knotens ist die Ausgabe von Kacheln und Masken, die eine visuelle Darstellung liefert, wie Ihr Bild verarbeitet wird. Diese Funktion zeigt die spezifischen verwendeten Kacheln und ihre entsprechenden Masken und gibt Ihnen Einblick in die innere Funktionsweise des generativen Prozesses. Das Verständnis, wie Ihr Bild segmentiert und verarbeitet wird, kann Ihnen helfen, fundierte Anpassungen vorzunehmen, um Ihre gewünschten Ergebnisse zu erzielen.

Darüber hinaus ermöglicht der "IPAdapter Tiled"-Knoten benutzerdefinierte Maskenanpassungen und bietet so die Flexibilität, bestimmte Bereiche Ihres Bildes hervorzuheben oder zu fokussieren. Durch das Anpassen dieser Masken können Sie mehr Aufmerksamkeit auf spezifische Elemente Ihres großen Bildes lenken und so mehr Kontrolle über das Ergebnis erhalten. Diese Funktion erweist sich als äußerst wertvoll, um bestimmte Aspekte innerhalb Ihres Bildes zu betonen oder zu minimieren und sicherzustellen, dass der generierte Inhalt genau mit Ihrer Vision übereinstimmt.

Daher verbessert die Integration des "IPAdapter Tiled"-Knotens in ComfyUI IPAdapter Plus Ihre Fähigkeit, Image-to-Image-Konditionierungsprojekte mit großen Bildern deutlich zu handhaben.

6. ComfyUI IPAdapter Plus - Stil und Komposition

Wie man den ComfyUI IPAdapter Plus verwendet, um die Stile und Kompositionen von Referenzbildern zu manipulieren und zu kombinieren, um neue, fesselnde Bilder zu erstellen. Der ComfyUI IPAdapter Plus bietet Künstlern und Designern eine leistungsstarke Palette von Werkzeugen zum Experimentieren, einschließlich der Möglichkeit, den Stil eines Bildes zu übertragen, die Komposition eines anderen beizubehalten oder sogar Stil und Komposition von verschiedenen Referenzen in einem einzigen Bild zu verschmelzen.

6.1. ComfyUI IPAdapter Plus für die Stilübertragung

Um den Stil eines Referenzbildes wie bei einem 1-Bild-LoRA auf Ihren Zielinhalt zu übertragen, folgen Sie mithilfe des ComfyUI IPAdapter Advanced-Knotens diesen Schritten:

Einrichten des "IPAdapter Advanced"-Knotens: Beginnen Sie damit, einen "IPAdapter Advanced"-Knoten in Ihren Workflow einzubinden.

Konfigurieren des Knotens: Suchen Sie in den Einstellungen des ComfyUI IPAdapter Advanced-Knotens die Option "Weight Type". Verwenden Sie das Dropdown-Menü, um "Style Transfer (SDXL)" auszuwählen. Diese Konfiguration weist den Adapter an, die Übertragung des visuellen Stils Ihres Referenzbildes auf das Zielbild zu priorisieren.

Anpassen des "Weight" für die Stilübertragung: Die Einstellung "weight" bestimmt die Stärke der Stilübertragung. Eine Erhöhung dieses Wertes verstärkt den Einfluss des Referenzstils auf Ihr Zielbild und macht den Effekt deutlicher.

6.2. ComfyUI IPAdapter Plus zum Beibehalten der Komposition

Um die Komposition eines Referenzbildes beizubehalten, während ein neues generiert wird, verwenden Sie ebenfalls den ComfyUI IPAdapter Advanced-Knoten, jedoch mit einer anderen Einstellung:

Einrichten des "IPAdapter Advanced"-Knotens: Fügen Sie wie zuvor einen IPAdapter Advanced-Knoten zu Ihrem Workflow hinzu.

Konfigurieren des Knotens: Wählen Sie im Dropdown-Menü "Weight Type" die Option "Composition (SDXL)". Dies weist den Adapter an, die Kompositionselemente des Referenzbildes in der neuen Generierung beizubehalten.

Anpassen des "Weight" für die Komposition: Ändern Sie die Einstellung "weight", um zu beeinflussen, wie stark sich das neue Bild an die Komposition des Referenzbildes hält. Ein höheres Gewicht wird die Komposition des Referenzbildes strenger durchsetzen.

6.3. ComfyUI IPAdapter Plus zum Beibehalten von Komposition und Stilübertragung

Für Projekte, die sowohl den Stil eines Bildes als auch die Komposition eines anderen übertragen erfordern, bietet der Knoten "IPAdapter style & composition SDXL" eine optimierte Lösung:

Auswahl des "IPAdapter Style & Composition SDXL"-Knotens: Fügen Sie diesen spezialisierten Knoten zu Ihrem Projekt hinzu, um Stil- und Kompositionsübertragungen gleichzeitig zu handhaben.

Laden von Stil- und Kompositionsreferenzen: Der Knoten "IPAdapter Style & Composition SDXL" ermöglicht zwei Eingaben, eine für das Bild, dessen Stil Sie übertragen möchten, und eine andere für das Bild, dessen Komposition Sie beibehalten möchten. Laden Sie beide Referenzen entsprechend.

Konfigurieren von "Weights" für Stil und Komposition: Der Knoten "IPAdapter Style & Composition SDXL" bietet separate Gewichtseinstellungen für Stil und Komposition. Passen Sie diese Gewichte an, um den Einfluss jeder Referenz auf das finale Bild auszubalancieren. Durch Festlegen eines höheren Gewichts für Stil oder Komposition wird dieser Aspekt im generierten Bild priorisiert.

Durch Befolgen dieser Schritte und Experimentieren mit den Einstellungen können Sie den ComfyUI IPAdapter Plus nutzen, um visuell atemberaubende Bilder zu erstellen, die das Beste aus beiden Welten vereinen: den unverwechselbaren Stil eines Kunstwerks mit der durchdachten Komposition eines anderen.

🌟🌟🌟 ComfyUI Online - Erleben Sie den IPAdapter Plus Workflow jetzt 🌟🌟🌟

Wenn Sie daran interessiert sind, den ComfyUI IPAdapter Plus (IPAdapter V2) Workflow zu erkunden, nutzen Sie das folgende ComfyUI-Web. Es ist vollständig mit allen wichtigen Customer-Knoten und -Modellen ausgestattet und ermöglicht nahtlose Kreativität ohne manuelle Setups. Sammeln Sie sofort praktische Erfahrungen!