AnimateDiff ComfyUI Workflow/Tutorial - Stable Diffusion Animation

Updated: 5/16/2024

Hey, hast du dich schon mal gefragt, wie man Text in Videos verwandeln kann? Das ist zwar nichts brandneues, aber es wird immer spannender. Lass uns heute über eines dieser coolen Tools sprechen, AnimateDiff in der ComfyUI-Umgebung. Egal ob du ein digitaler Künstler bist oder einfach gerne neue Technologien erforschst, AnimateDiff bietet eine aufregende Möglichkeit, deine Textideen in animierte GIFs und Videos zu verwandeln.

Wir werden folgendes behandeln:

- Wie funktioniert AnimateDiff?

- ComfyUI AnimateDiff Workflow - Keine Installation nötig, völlig kostenlos

- AnimateDiff V3 vs. Animatediff SDXL vs. AnimateDiff v2

- AnimateDiff V3: Neues Motion-Modul in Animatediff

- AnimateDiff SDXL

- AnimateDiff V2

- AnimateDiff-Einstellungen: So verwendest du AnimateDiff in ComfyUI

- AnimateDiff-Modelle

- CheckPoint-Modelle für AnimateDiff

- Beta-Zeitplan

- Motion Scale

- Context Batch Size bestimmt die Animationslänge

- Context Length

- Motion LoRA für Kameradynamik (nur AnimateDiff v2)

- AnimateDiff-Prompt

- AnimateDiff Prompt Travel / Prompt Scheduling

- ComfyUI Hires Fix - Verbessere deine Animationen

- Einsatzbereiter ComfyUI AnimateDiff Workflow: Erforschung der Stable Diffusion Animation

1. Wie funktioniert AnimateDiff?

Der Kern von AnimateDiff ist ein Motion-Modeling-Modul. Stell dir das wie das Gehirn der Operation vor, das alles über Bewegung aus verschiedenen Videoclips lernt. Es ist wie ein Tanzlehrer, der jeden Move aus dem Effeff kennt. Dieses Modul integriert sich nahtlos in vortrainierte Text-zu-Bild-Modelle. Du bist also nicht mehr nur auf statische Bilder beschränkt - deine Kreationen können tanzen, springen und sich drehen!

2. ComfyUI AnimateDiff Workflow - Keine Installation nötig, völlig kostenlos

Schau dir das obige Video an, das mit dem ComfyUI AnimateDiff Workflow erstellt wurde. Jetzt kannst du direkt in diesen Animatediff Workflow eintauchen, ohne dass eine Installation nötig ist. Wir haben alles für dich in einem cloudbasierten ComfyUI eingerichtet, komplett mit dem AnimateDiff Workflow und allen wichtigen Modellen und Custom Nodes von Animatediff V3, Animatediff SDXL und Animatediff V2.

Experimentiere und spiele damit herum. Oder lies weiter in diesem Tutorial, wie man AnimateDiff verwendet, und probiere es später aus.

3. AnimateDiff V3 vs. Animatediff SDXL vs. AnimateDiff v2

Lass uns die verschiedenen Versionen von AnimateDiff durchgehen. Jede Version hat ihren eigenen Charme, also schnall dich an für eine kurze Tour!

3.1. AnimateDiff V3: Neues Motion-Modul in Animatediff

AnimateDiff V3 ist nicht nur eine neue Version, es ist eine Evolution in der Motion-Modul-Technologie und sticht mit seinen verfeinerten Funktionen hervor. Das Motion-Modul v3_sd15_mm.ckpt ist das Herzstück dieser Version und für nuancierte und flexible Animationen verantwortlich.

Lass uns die technische Magie dahinter aufschlüsseln. Der Star-Player ist hier das Domain Adapter LoRA-Modul, das im Wesentlichen ein Primer für das Motion-Modul ist. Durch das Training mit statischen Frames aus dem Videodatensatz stattet dieses LoRA-Modul AnimateDiff mit mehr Fähigkeiten zur Handhabung von Bewegung aus. Ziemlich cool, oder?

Bei der Verwendung von AnimateDiff V3 wirst du feststellen, dass es nicht unbedingt Animatediff V2 in allen Aspekten übertrifft. Stattdessen bietet es verschiedene Arten von Bewegungen und erweitert so dein kreatives Arsenal.

Positiver Prompt:masterpiece, best quality, girl with rainbow hair, really wild hair, mane

Negativer Prompt: (low quality, nsfw, worst quality:1.4), (deformed, distorted, disfigured:1.3), easynegative, hands, bad-hands-5, blurry, ugly, text, embedding:easynegative

CheckPoint:

toonyou_beta6

3.2. AnimateDiff SDXL

Wenn du auf hochauflösende Videos stehst, könnte AnimateDiff SDXL eine Option sein. Es läuft auf dem Motion-Modul mm_sdxl_v10_beta.ckpt und ist für die Erstellung von Animationen mit einer Auflösung von 1024x1024 und 16 Frames konzipiert. Beachte jedoch, dass es sich noch in der Beta-Phase befindet, daher könnte es klug sein, noch etwas zu warten, bevor du eintauchst.

Verwende denselben positiven und negativen Prompt wie bei AnimateDiff V3

CheckPoint:

dreamshaperXL10_alpha2Xl10

3.3. AnimateDiff V2

AnimateDiff V2 ist der Klassiker! Mit mm_sd_v15_v2.ckpt bietet diese Version MotionLoRA für acht essentielle Kamerabewegungen: Zoom In/Out, Pan Left/Right, Tilt Up/Down und Rolling Clockwise/Anticlockwise. Animatediff V2 ist perfekt, wenn du dynamische Kamerabewegungen suchst, um deinen Animationen Dramatik zu verleihen.

Verwende denselben positiven und negativen Prompt wie bei AnimateDiff V3

CheckPoint:

toonyou_beta6

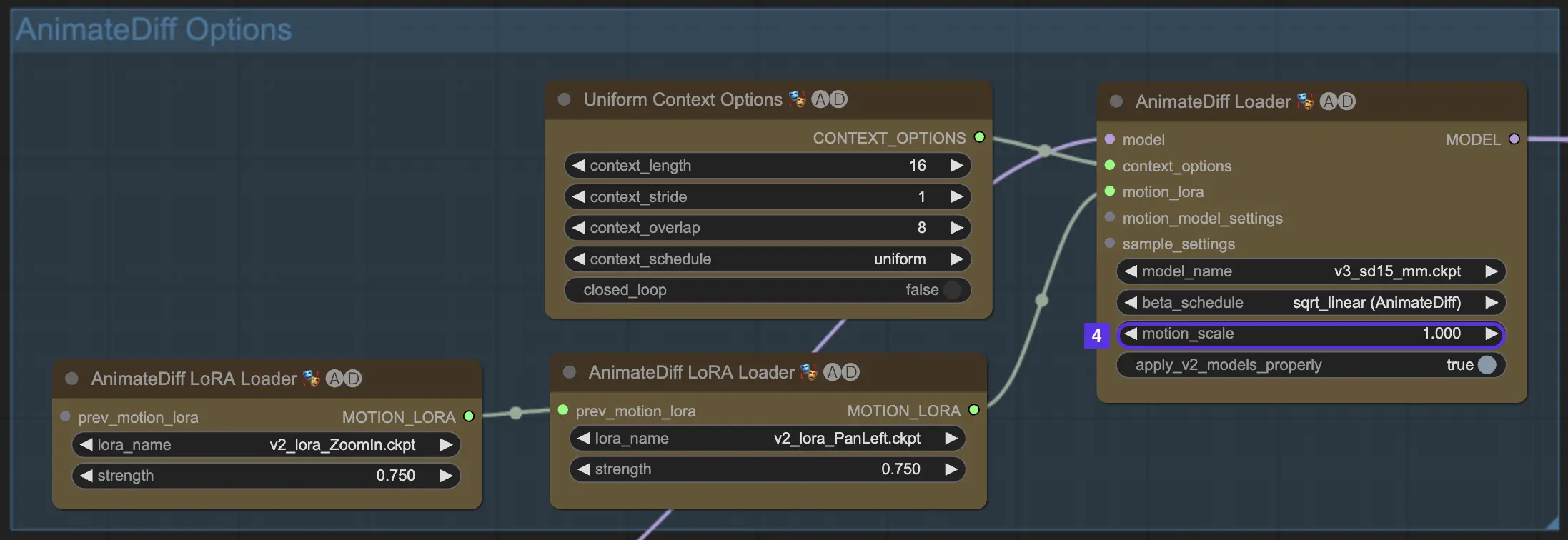

4. AnimateDiff-Einstellungen: So verwendest du AnimateDiff in ComfyUI

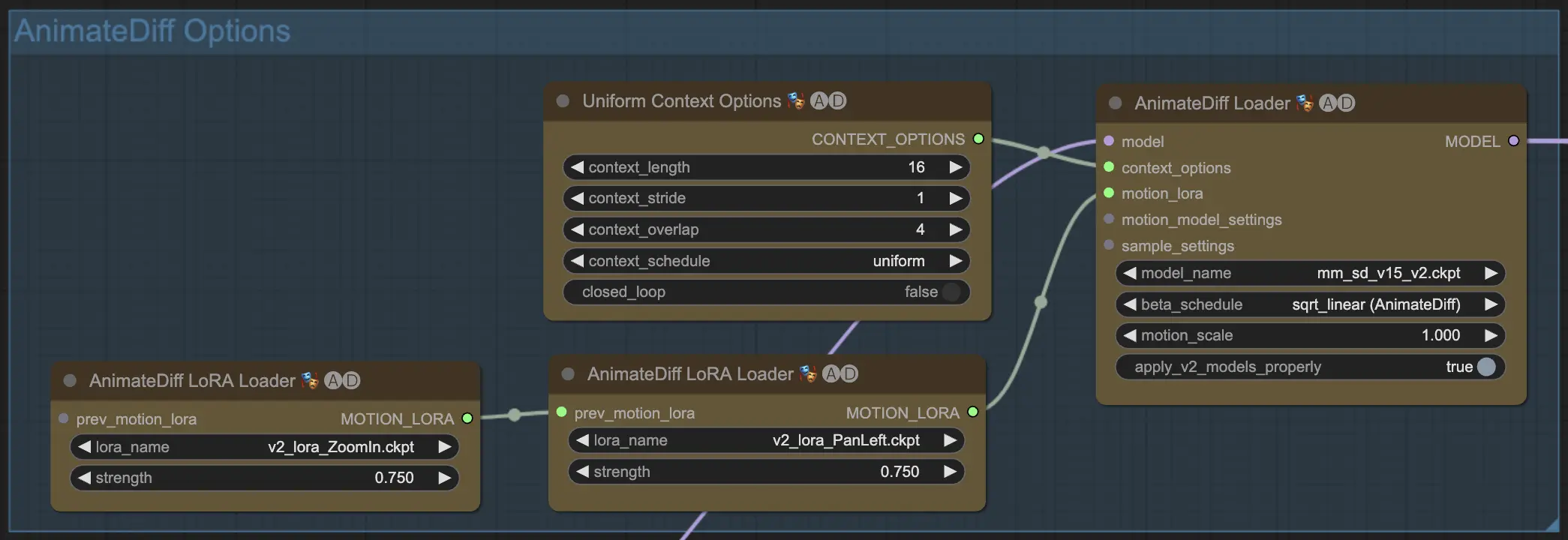

Sobald du den AnimateDiff-Workflow innerhalb von ComfyUI betrittst, stößt du auf eine Gruppe mit der Bezeichnung "AnimateDiff Options", wie unten gezeigt. Dieser Bereich enthält die Einstellungen und Funktionen, die du wahrscheinlich bei der Arbeit mit AnimateDiff verwendest.

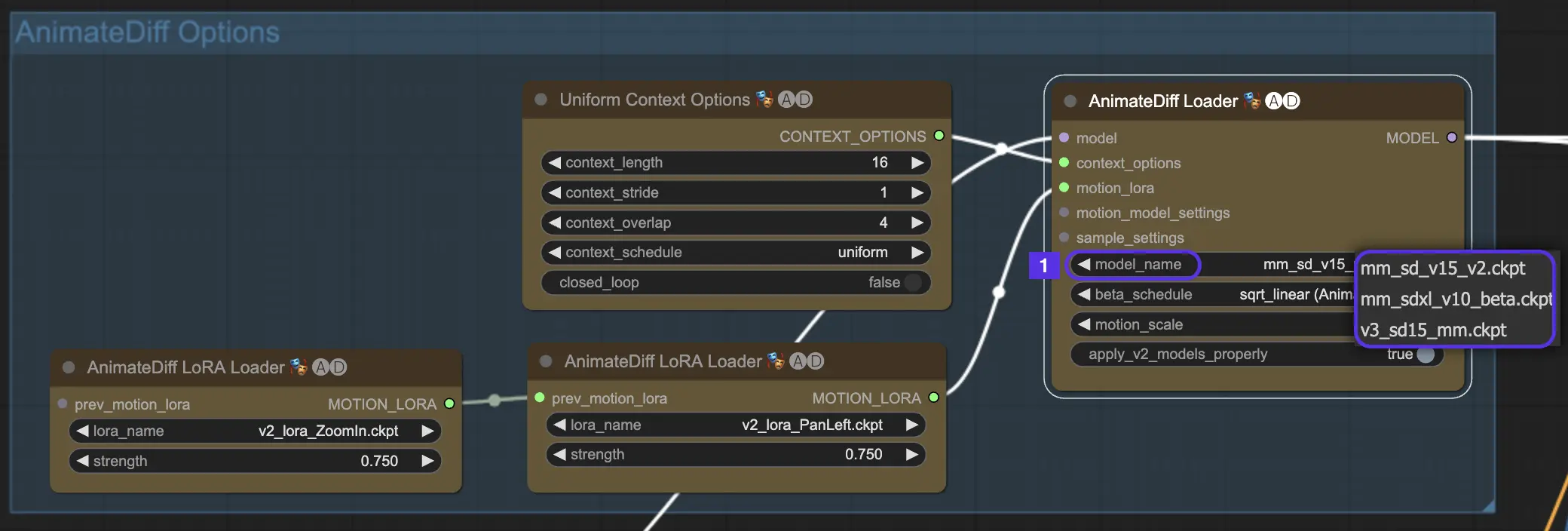

4.1. AnimateDiff-Modelle

Zuerst wählst du das AnimateDiff-Motion-Modul aus, das du im Dropdown-Menü model_name ausprobieren möchtest:

v3_sd15_mm.ckptfür AnimateDiff V3mm_sdxl_v10_beta.ckptfür AnimateDiff SDXLmm_sd_v15_v2.ckptfür AnimateDiff V2

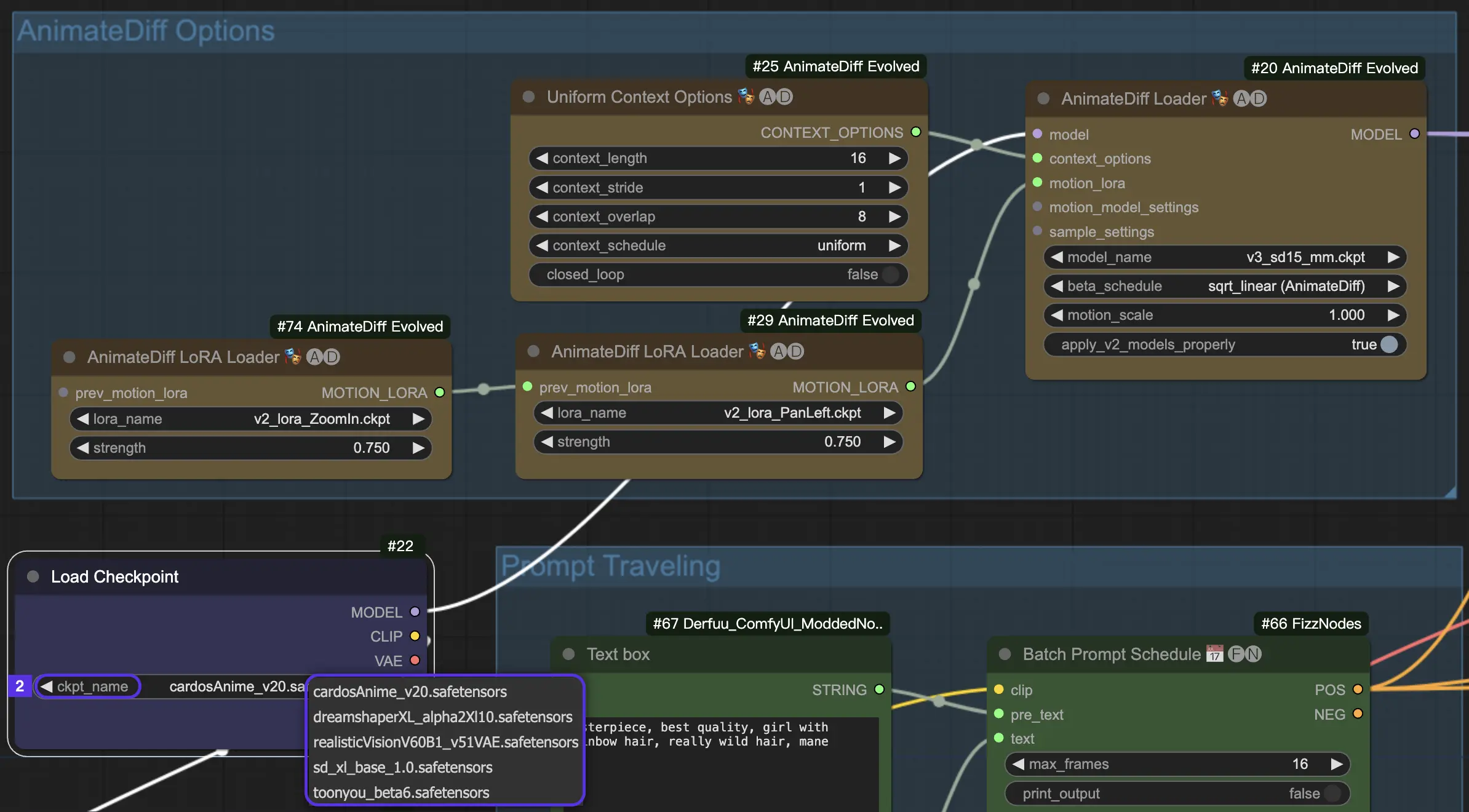

4.2. CheckPoint-Modelle für AnimateDiff

AnimateDiff benötigt ein Stable Diffusion Checkpoint-Modell.

Für AnimateDiff V2 und V3 musst du ein SD v1.5-Modell verwenden. Modelle wie realisticVisionV60B1_V51VAE, toonyou_beta6 und cardos_Animev2.0 sind Top-Favoriten.

Wenn du zu AnimateDiff SDXL tendierst, ziele auf ein SDXL-Modell wie sd_xl_base_1.0 oder dreamshaperXL10_alpha2Xl10.

In der RunComfy Cloud-Umgebung sind alle Motion-Module und Checkpoint-Modelle zu deiner Bequemlichkeit vorinstalliert.

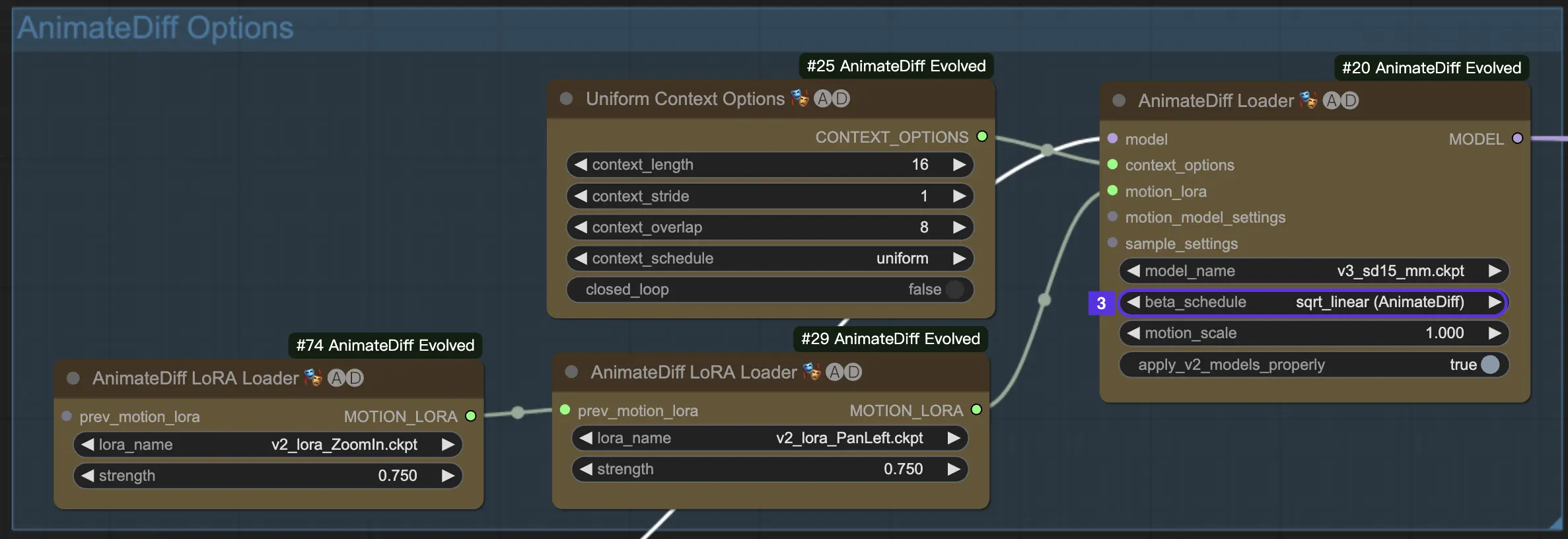

4.3. Beta-Zeitplan

Der Beta-Zeitplan in AnimateDiff bestimmt das Verhalten des Rauschunterdrückungsprozesses während der Animationsgenerierung.

Für AnimateDiff V3 und V2 ist die Einstellung sqrt_linear im Allgemeinen der Weg, aber scheue dich nicht, auch linear für einige interessante Effekte auszuprobieren.

Bei AnimateDiff XL bleibst du bei linear (AnimateDiff-SDXL).

4.4. Motion Scale

Motion Scale in AnimateDiff ermöglicht es dir, die Bewegungsintensität zu steuern. Unter 1 bedeutet subtilere Bewegung; über 1 bedeutet ausgeprägtere Bewegung.

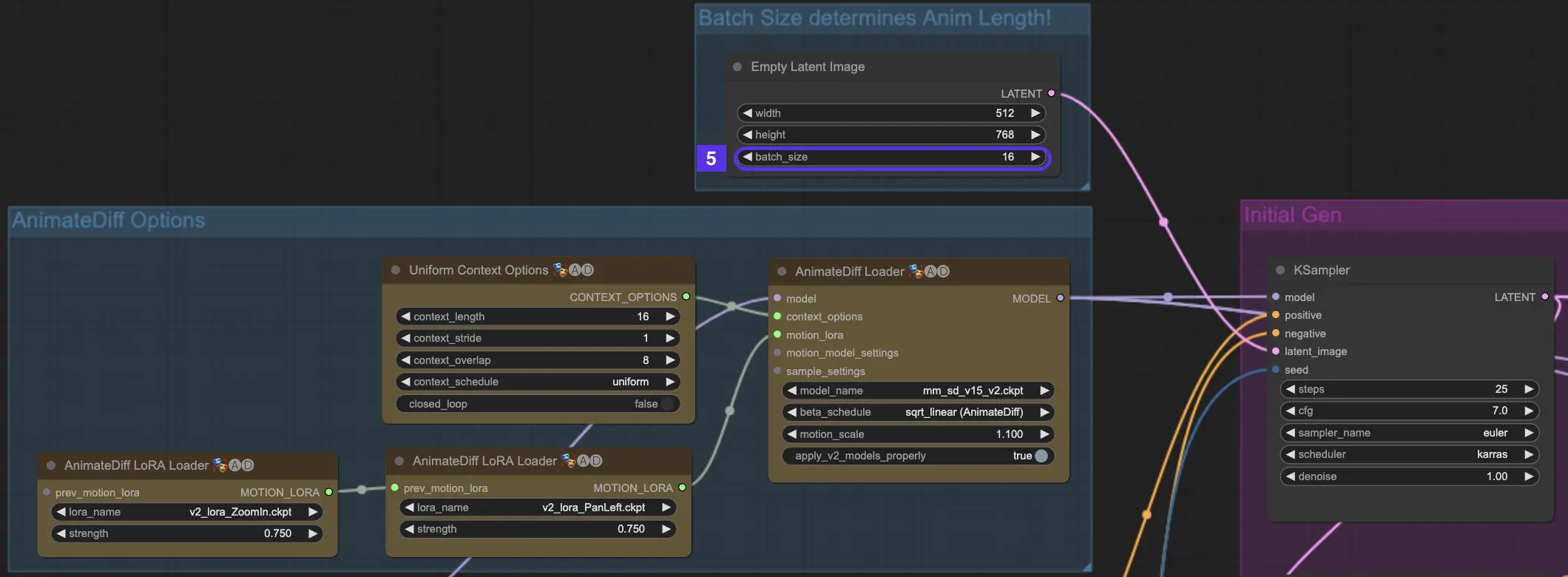

4.5. Context Batch Size bestimmt die Animationslänge

Die Batch Size in AnimateDiff repräsentiert die Bausteine deiner Animation. Sie dient als grundlegender Faktor, der die Länge deiner Animation beeinflusst. Sie bestimmt die Anzahl der "Szenen" oder Segmente, aus denen deine Animation bestehen wird.

Größere Batch Sizes führen zu mehr Szenen in deiner Animation und ermöglichen eine längere und aufwendigere Erzählung. Es gibt keine Obergrenze für die Batch Size, so dass du Animationen so lang oder kurz erstellen kannst, wie du möchtest. Die Standard-Batch Size beträgt 16.

- 16 Batch Size = Ein kurzes, 2-sekündiges Video

- 32 Batch Size = Ein kurzer, 4-sekündiger Clip

- 64 Batch Size = Ein längeres, 8-sekündiges Feature

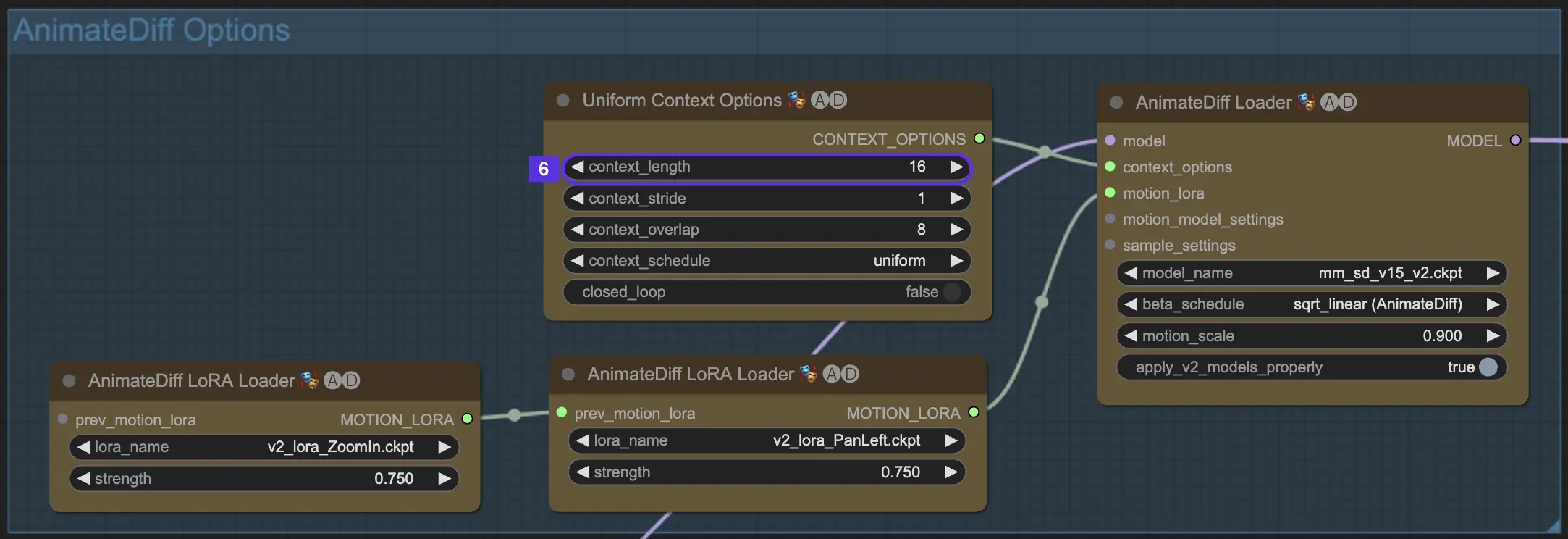

4.6. Context Length

Die Uniform Context Length in AnimateDiff spielt eine entscheidende Rolle bei der Gewährleistung reibungsloser Übergänge zwischen den von deiner Batch Size festgelegten Szenen. Es ist wie ein erfahrener Editor, der genau weiß, wie man Szenen für den natürlichsten Fluss zusammenfügt.

Die von dir festgelegte Länge für den Uniform Context bestimmt die Art der Übergänge zwischen den Szenen. Eine längere Uniform Context Length führt zu sanfteren, allmählicheren Übergängen, die den Wechsel von einer Szene zur anderen fast unmerklich machen. Eine kürzere Länge hingegen erzeugt schnellere, auffälligere Übergänge, die für bestimmte Erzähleffekte ideal sein können. Die Standard-Uniform-Context-Länge beträgt 16.

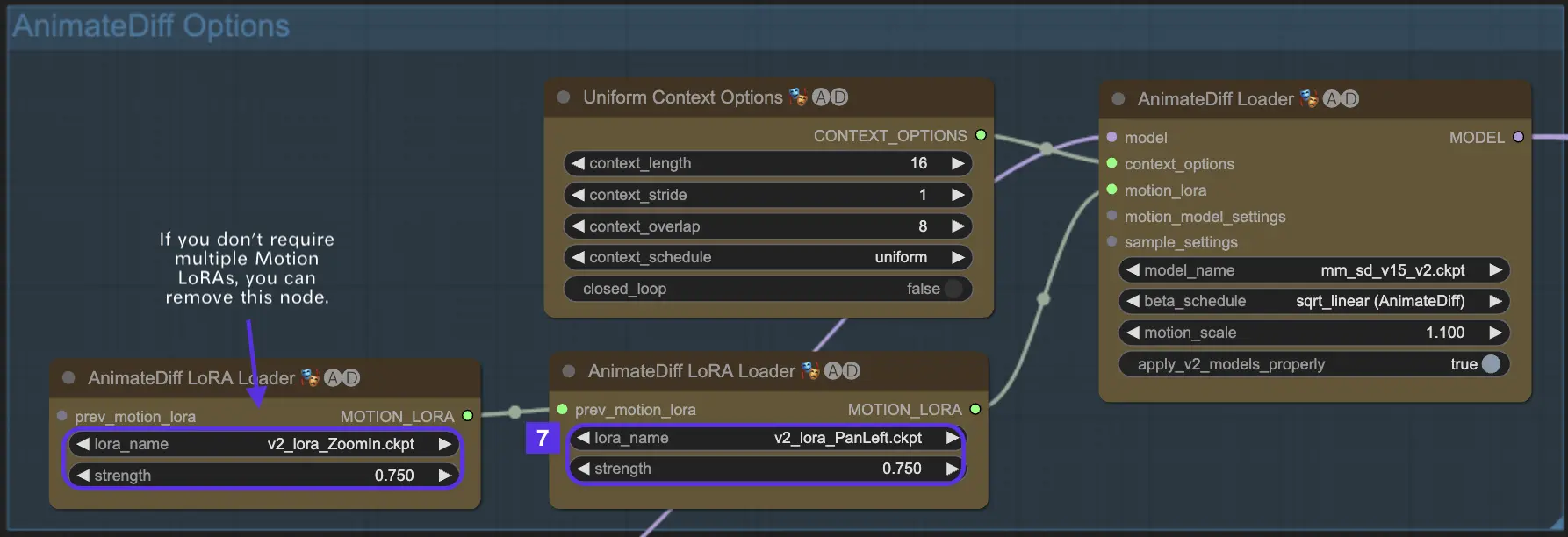

4.7. Motion LoRA für Kameradynamik (nur AnimateDiff v2)

Motion LoRAs sind ausschließlich mit AnimateDiff v2 kompatibel. Diese nützlichen Ergänzungen bringen eine dynamische Ebene der Kamerabewegung in deine Animationen. Bei der Verwendung von Motion LoRAs ist es entscheidend, das richtige Gleichgewicht mit dem LoRA-Gewicht zu finden. Eine Einstellung von etwa 0,75 trifft normalerweise den Sweet Spot und sorgt für flüssige Kamerabewegungen ohne störende Hintergrund-Artefakte.

Darüber hinaus hast du die kreative Freiheit, mehrere Motion LoRAs zu verketten. Durch die strategische Kombination verschiedener Motion-LoRA-Modelle kannst du komplexe Kamerabewegungen orchestrieren, experimentieren und die perfekte Mischung aus Bewegungen für deine einzigartige Animationsvision finden und so deine Animation zu einem cineastischen Meisterwerk erheben.

Hier ist ein Beispiel für die gemeinsame Verwendung der Funktionen "Pan Left" und "Zoom In" von Motion LoRa.

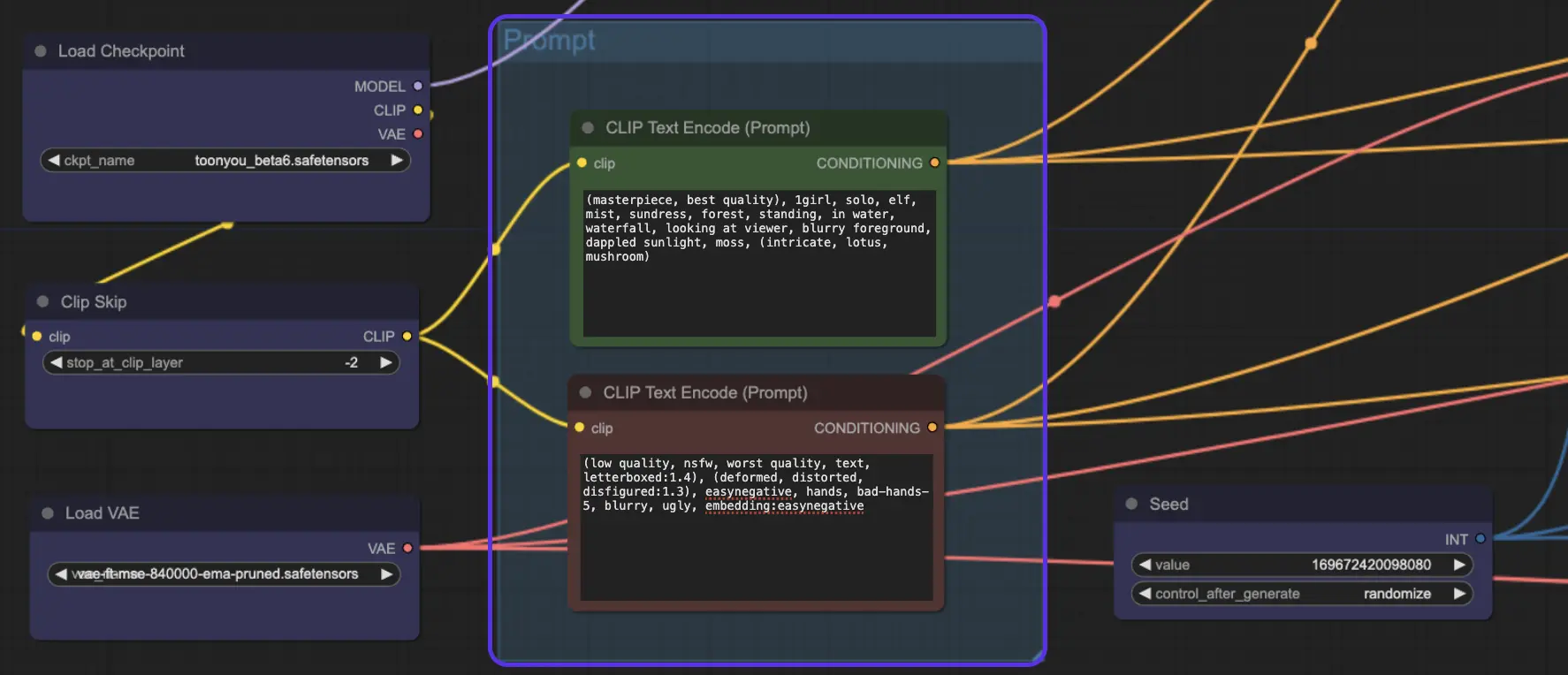

5. AnimateDiff-Prompt

Okay, jetzt hast du dein Modell und die AnimateDiff-Einstellungen eingestellt, es ist Showtime! Hier verwandelst du deinen Text in Videoanimationen.

Hier ist ein Beispiel für einen positiven und einen negativen Prompt:

Positiver Prompt:(masterpiece, best quality), 1girl, solo, elf, mist, sundress, forest, standing, in water, waterfall, looking at viewer, blurry foreground, dappled sunlight, moss, (intricate, lotus, mushroom)

Negativer Prompt: (low quality, nsfw, worst quality, text, letterboxed:1.4), (deformed, distorted, disfigured:1.3), easynegative, hands, bad-hands-5, blurry, ugly, embedding:easynegative

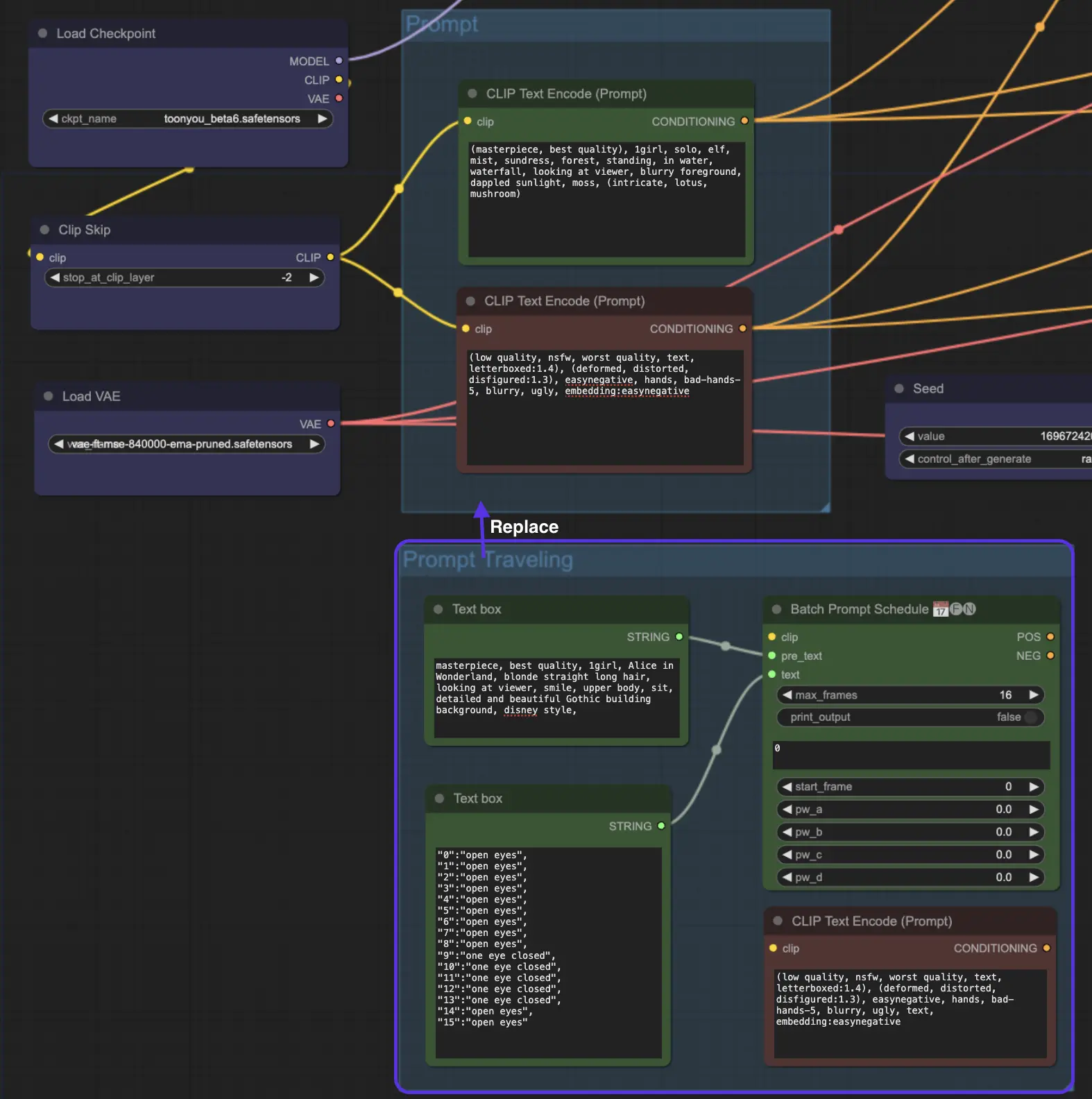

6. AnimateDiff Prompt Travel / Prompt Scheduling

Aber warte, da gibt es noch mehr! Hast du schon Prompt Travel / Prompt Scheduling ausprobiert? Stell es dir vor, als würdest du in die Rolle eines Filmregisseurs schlüpfen. Du hast die Kontrolle und gestaltest deine Geschichte Szene für Szene. Es ist wie ein Puzzle, bei dem jedes Teil ein Moment in deiner Geschichte ist.

Wie funktioniert Prompt Travel?

Stell dir vor, du erstellst einen Mini-Film. Du setzt Prompt 1 bei Frame 1 und Prompt 2 bei Frame 8 und so weiter. AnimateDiff wird diese Prompts nahtlos mischen und einen fließenden Übergang von Frame 1 zu Frame 8 schaffen.

Tipp: Während Prompt Travel faszinierend sein kann, ist es wichtig zu beachten, dass es nicht immer ein Erfolgsgarant ist. Die Effektivität von Prompt Travel hängt auch vom ausgewählten Checkpoint-Modell ab. Zum Beispiel ist das Modell cardos_Animev2.0 mit Prompt Travel kompatibel, aber das gilt nicht für alle Modelle. Außerdem kann das Ergebnis unvorhersehbar sein - manche Prompts lassen sich möglicherweise nicht gut mischen, was zu weniger als idealen Übergängen führt. Daher ist Prompt Travel eher eine experimentelle Funktion als ein garantiertes Werkzeug für nahtlose Animation.

Wir haben den Knoten "Prompt Travel / Prompt Scheduling" am Ende des AnimateDiff ComfyUI-Workflows platziert. Wenn du experimentieren möchtest, musst du "Prompt Travel" anstelle der regulären "Prompt"-Option verwenden.

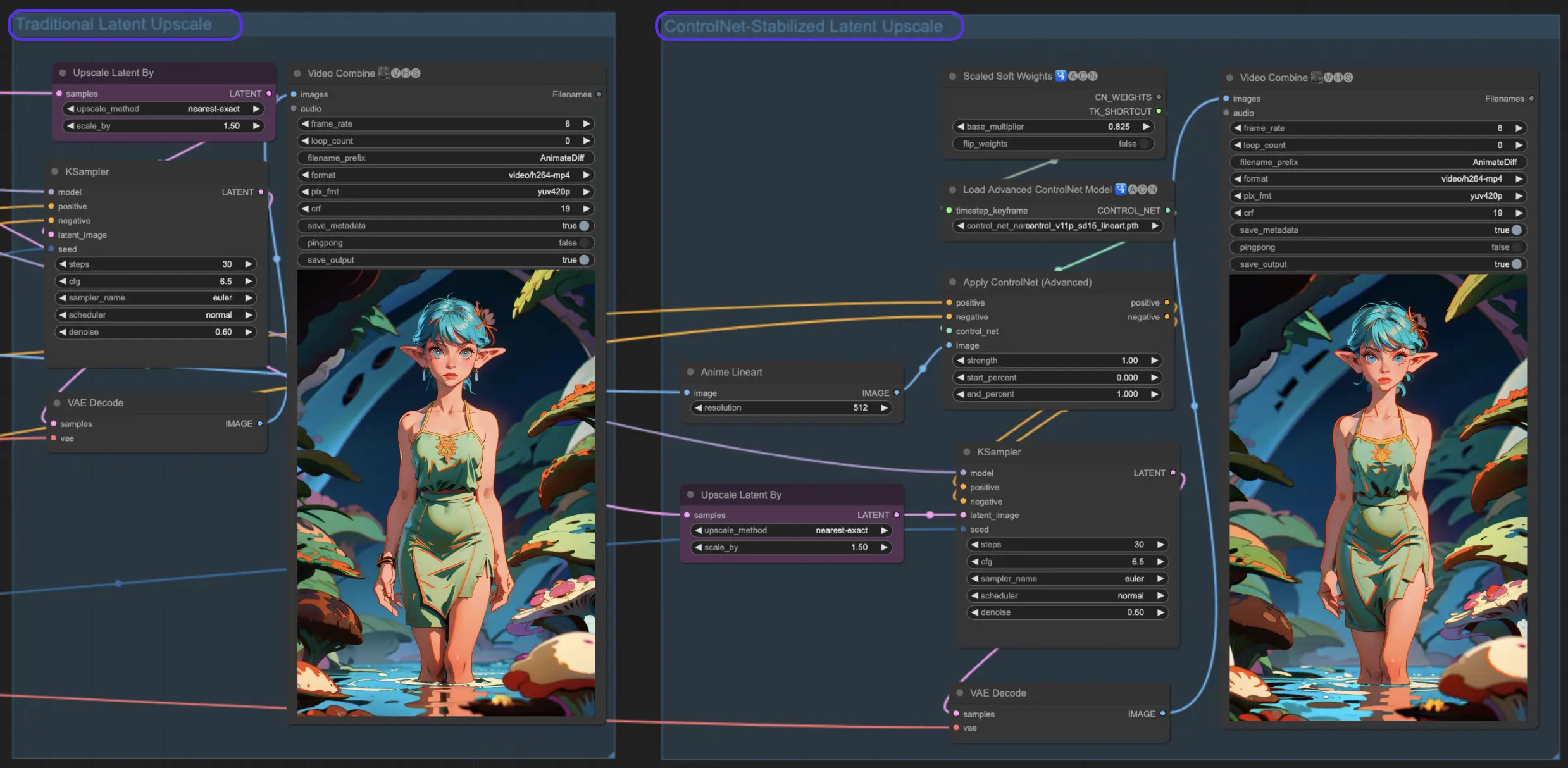

7. ComfyUI Hires Fix - Verbessere deine Animationen

Durch den Einsatz von AnimateDiff zusammen mit dem Hi-Res Fix kannst du die Auflösung deiner Bilder verbessern. Dieser Prozess verwandelt leicht unscharfe Bilder in kristallklare Meisterwerke. In diesem Abschnitt stellen wir zwei Methoden vor.

7.1. Latent Upscale

Traditionelles Latent Upscaling in ComfyUI. Durch die Anwendung von Einstellungen wie 0,6 Denoising Strength und die Wahl eines 1,5-fachen Upscale wirst du sehen, wie sich deine Animationen mit reicheren Details und schärferer Klarheit verwandeln. Es ist, als würdest du eine Brille aufsetzen und plötzlich die Welt in High Definition sehen!

7.2. ControlNet Upscale

Traditionelles Latent Upscaling ist cool, aber lass uns mit Control Net Assisted Latent Upscale auf die nächste Stufe gehen. Es verwendet ControlNets für ein präziseres Upscaling und stellt sicher, dass deine Animation ihre Integrität beibehält. Mit dem Zusatz eines Lineart-Preprocessors und dem richtigen ControlNet-Modell verbesserst du deine Kunst und bewahrst gleichzeitig ihre Seele.

8. Einsatzbereiter ComfyUI AnimateDiff Workflow: Erforschung der Stable Diffusion Animation

Wir haben uns in die aufregende Welt von AnimateDiff in ComfyUI vertieft. Für diejenigen, die gerne mit dem von uns vorgestellten ComfyUI AnimateDiff Workflow experimentieren möchten, sollten unbedingt RunComfy ausprobieren, eine Cloud-Umgebung mit einer leistungsstarken GPU, die voll ausgestattet ist, einschließlich aller wesentlichen Modelle und Custom Nodes. Keine manuelle Einrichtung erforderlich! Einfach ein Spielplatz, um deine Kreativität zu entfesseln. 🌟

Autor: RunComfy Editors

Unser Team von Redakteuren arbeitet seit mehr als 15 Jahren mit KI, angefangen mit NLP/Vision im Zeitalter von RNN/CNN. Wir haben enorme Erfahrungen mit KI-Chatbots/Art/Animation gesammelt, wie z.B. BERT/GAN/Transformer usw. Sprich mit uns, wenn du Hilfe bei KI-Kunst, Animation und Video benötigst.