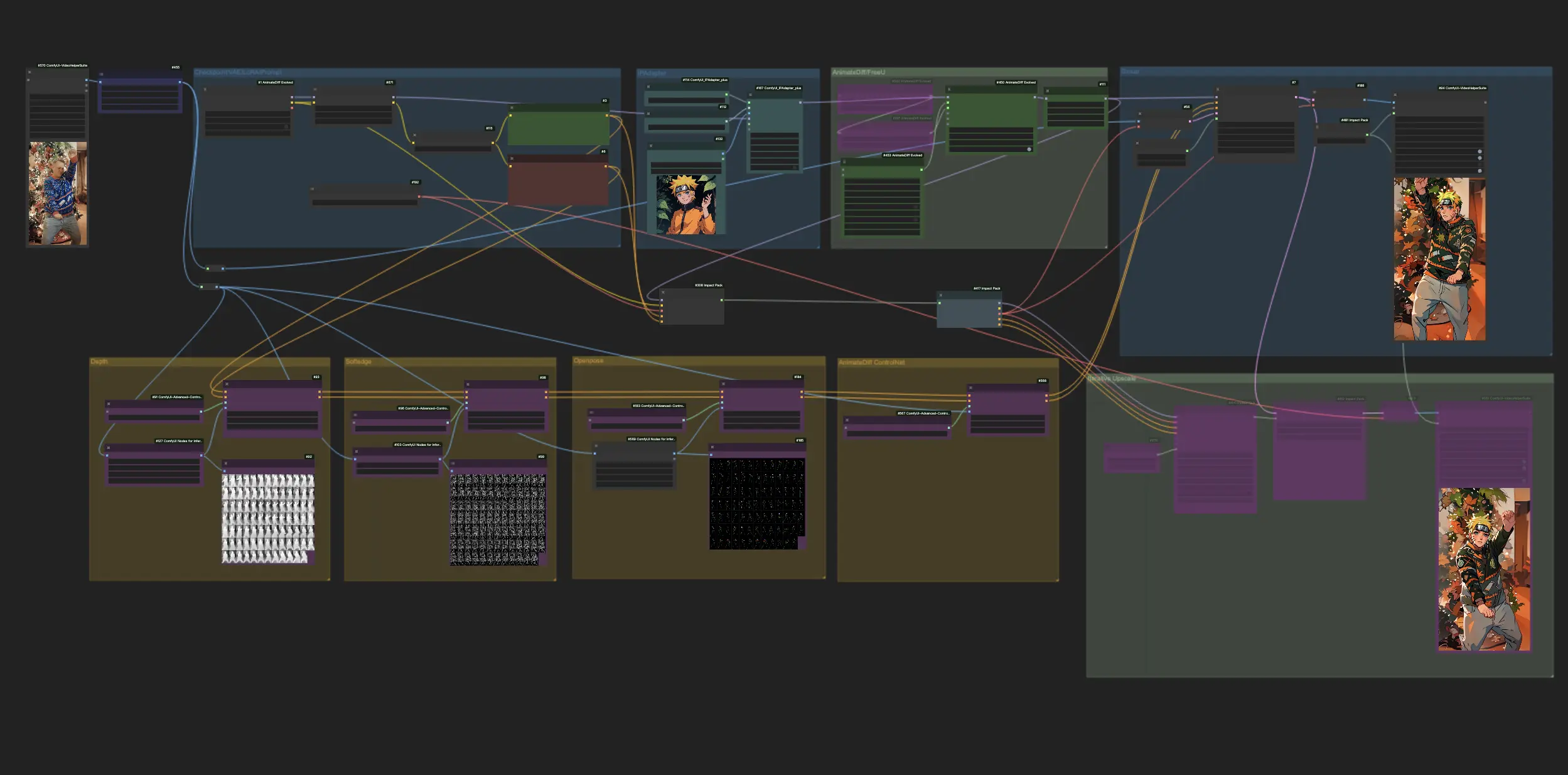

AnimateDiff + ControlNet + IPAdapter V1 | Estilo de Anime Japonés

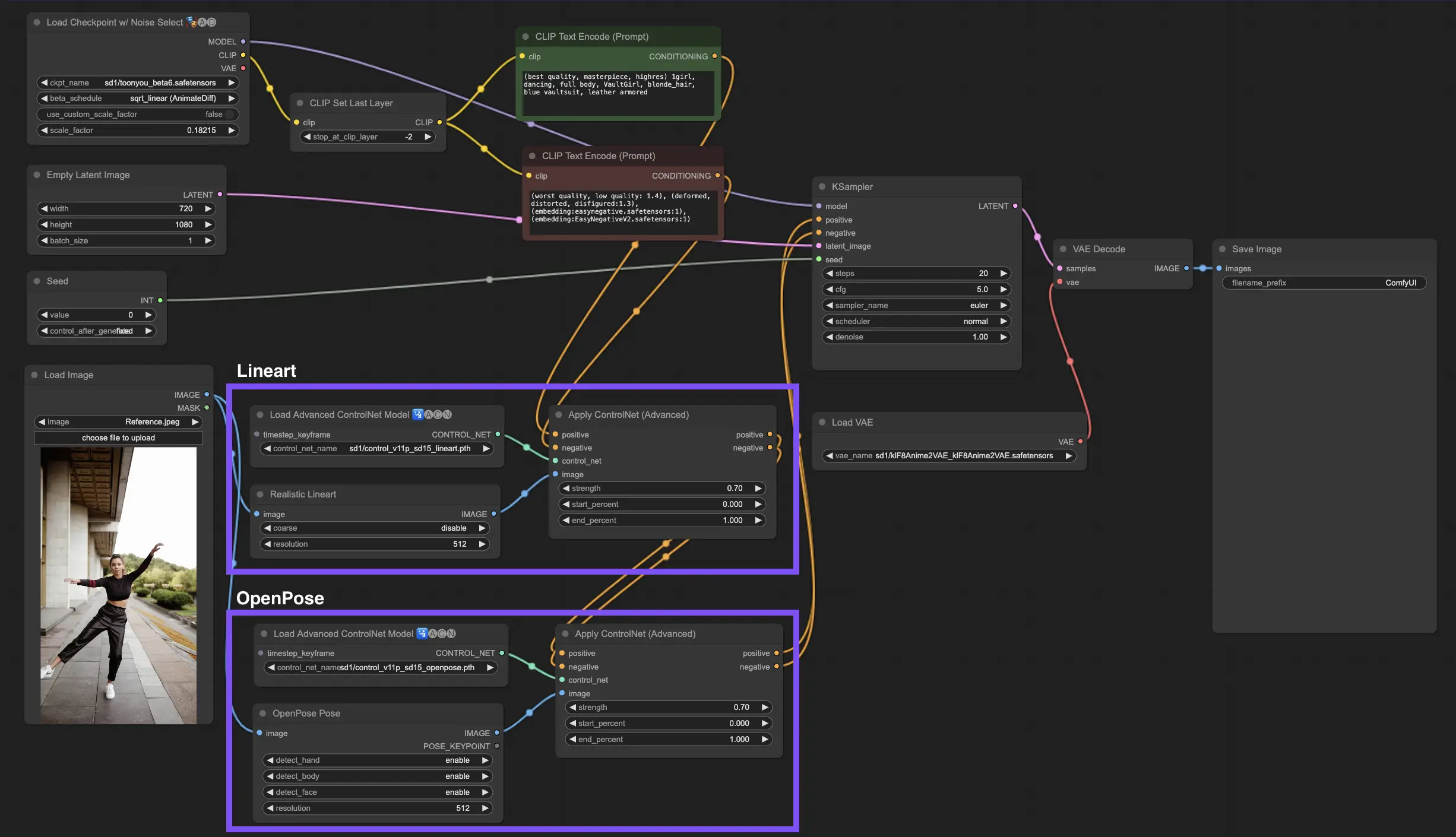

Experimenta la emoción de la transformación al anime mientras ComfyUI aprovecha el poder de AnimateDiff, ControlNet e IPAdapter para convertir videos estándar en cautivadoras versiones de anime japonés. Este flujo de trabajo emplea hábilmente técnicas avanzadas como la percepción de profundidad, el detallado de bordes suaves y la tecnología OpenPose, junto con el toque matizado de Lora, asegurando que cada video se reimagine con una auténtica estética de anime. Sumérgete en el universo del anime con una metamorfosis fluida e infundida de estilo.ComfyUI Vid2Vid (Japanese Anime) Flujo de trabajo

- Flujos de trabajo completamente operativos

- Sin nodos ni modelos faltantes

- No se requiere configuración manual

- Presenta visuales impresionantes

ComfyUI Vid2Vid (Japanese Anime) Ejemplos

ComfyUI Vid2Vid (Japanese Anime) Descripción

Este flujo de trabajo está inspirado en con algunas modificaciones. Para más información, por favor visita su canal de YouTube.

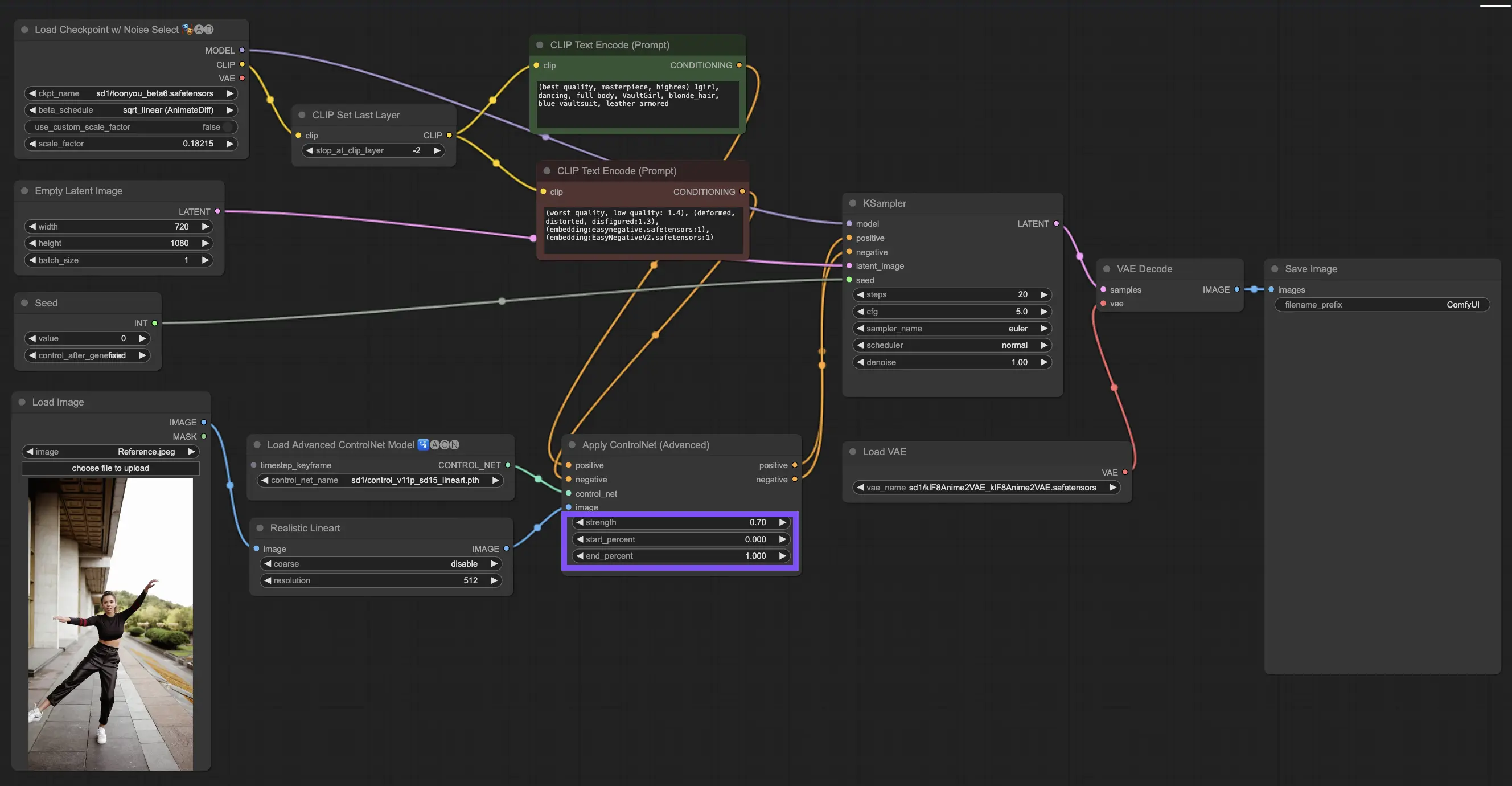

1. Flujo de Trabajo de ComfyUI: AnimateDiff + ControlNet + IPAdapter | Estilo de Anime Japonés

Este flujo de trabajo te permite transformar videos estándar en encantadoras creaciones de anime japonés utilizando AnimateDiff, ControlNet e IPAdapter. Siéntete libre de experimentar con varios puntos de control, ajustes de LoRA e imágenes de referencia para el IPAdapter para crear tu estilo único. ¡Es una forma divertida y creativa de dar vida a tus videos en el mundo del anime!

2. Resumen de AnimateDiff

Por favor, consulta los detalles sobre

3. Cómo Usar ControlNet

3.1. Entendiendo ControlNet

ControlNet revoluciona la forma en que generamos imágenes al traer un nuevo nivel de control espacial a los modelos de difusión de texto a imagen. Esta arquitectura de red neuronal de vanguardia se asocia maravillosamente con gigantes como Stable Diffusion, aprovechando sus vastas bibliotecas, forjadas a partir de miles de millones de imágenes, para tejer matices espaciales directamente en la estructura de la creación de imágenes. Desde esbozar bordes hasta mapear posturas humanas, percepción de profundidad o segmentar imágenes, ControlNet te permite moldear las imágenes de maneras que van mucho más allá del alcance de simples indicaciones de texto.

3.2. La Innovación de ControlNet

En su esencia, ControlNet es ingeniosamente sencillo. Comienza protegiendo la integridad de los parámetros del modelo original, manteniendo intacto el entrenamiento base. Luego, ControlNet introduce un conjunto reflejado de las capas de codificación del modelo, pero con un giro: se entrenan utilizando "convoluciones cero". Estos ceros como punto de partida significan que las capas incorporan suavemente nuevas condiciones espaciales sin causar alboroto, asegurando que los talentos originales del modelo se conserven incluso cuando se embarcan en nuevos caminos de aprendizaje.

3.3. Entender ControlNets y T2I-Adapters

Tanto ControlNets como T2I-Adapters desempeñan roles cruciales en el condicionamiento de la generación de imágenes, y cada uno ofrece ventajas distintas. Los T2I-Adapters son reconocidos por su eficiencia, particularmente en términos de acelerar el proceso de generación de imágenes. A pesar de esto, los ControlNets no tienen igual en su capacidad para guiar intricadamente el proceso de generación, lo que los convierte en una herramienta poderosa para los creadores.

Considerando la superposición de funcionalidades entre muchos modelos de T2I-Adapter y ControlNet, nuestra discusión se centrará principalmente en los ControlNets. Sin embargo, vale la pena señalar que la plataforma RunComfy ha precargado varios modelos de T2I-Adapter para facilitar su uso. Para aquellos interesados en experimentar con T2I-Adapters, puedes cargar sin problemas estos modelos e integrarlos en tus proyectos.

Elegir entre modelos de ControlNet y T2I-Adapter en ComfyUI no afecta el uso de nodos de ControlNet o la consistencia del flujo de trabajo. Esta uniformidad asegura un proceso optimizado, permitiéndote aprovechar los beneficios únicos de cada tipo de modelo de acuerdo con las necesidades de tu proyecto.

3.4. Uso de Nodos de ControlNet

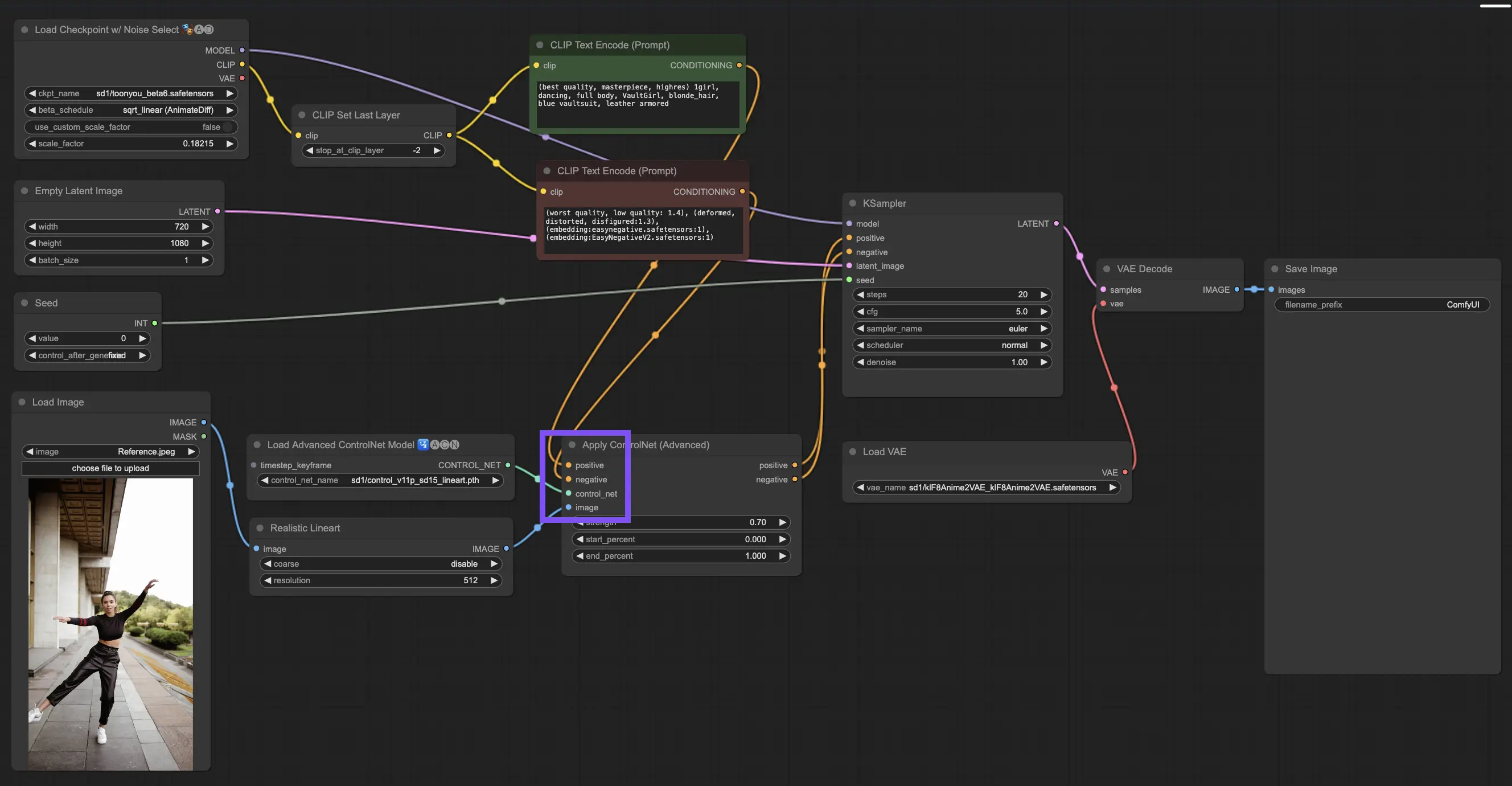

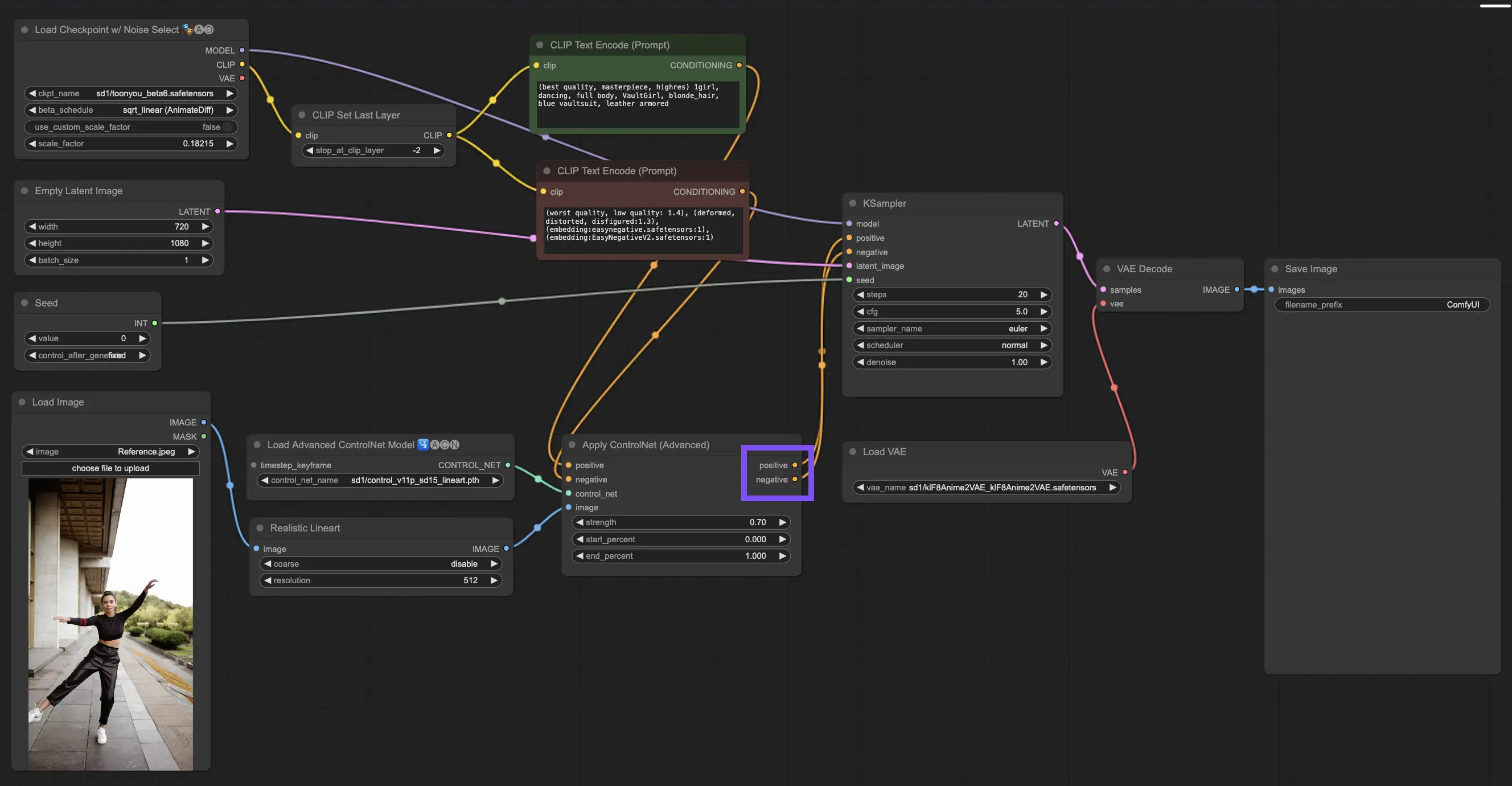

3.4.1. Cargando el Nodo "Apply ControlNet"

Para comenzar, necesitarás cargar el nodo "Apply ControlNet" en tu ComfyUI. Este es tu primer paso hacia un viaje de creación de imágenes con doble condicionamiento, combinando elementos visuales con indicaciones textuales.

3.4.2. Entendiendo las Entradas del Nodo "Apply ControlNet"

Condicionamiento Positivo y Negativo: Estas son tus herramientas para dar forma a la imagen final: lo que debe abarcar y lo que debe evitar. Conéctalas a las ranuras "Positive prompt" y "Negative prompt" para sincronizarlas con la parte basada en texto de tu dirección creativa.

Seleccionando el Modelo ControlNet: Necesitarás vincular esta entrada a la salida del nodo "Load ControlNet Model". Aquí es donde decides si usar un modelo ControlNet o T2IAdaptor basado en los rasgos o estilos específicos que buscas. Si bien nos enfocamos en los modelos ControlNet, vale la pena mencionar algunos codiciados T2IAdaptors para una visión completa.

Preprocesando tu Imagen: Conecta tu imagen a un nodo "ControlNet Preprocessor", que es vital para garantizar que tu imagen esté lista para ControlNet. Es esencial hacer coincidir el preprocesador con tu modelo ControlNet. Este paso ajusta tu imagen original para que se ajuste perfectamente a las necesidades del modelo: redimensionando, recoloreando o aplicando los filtros necesarios, preparándola para su uso por parte de ControlNet.

3.4.3. Entendiendo las Salidas del Nodo "Apply ControlNet"

Después del procesamiento, el nodo "Apply ControlNet" te presenta dos salidas que reflejan la sofisticada interacción de ControlNet y tu entrada creativa: Condicionamiento Positivo y Negativo. Estas salidas guían el modelo de difusión dentro de ComfyUI, lo que conduce a tu siguiente elección: refinar la imagen usando el KSampler o sumergirte más profundamente al apilar más ControlNets para aquellos que buscan un detalle y una personalización sin igual.

3.4.4. Ajustando "Apply ControlNet" para Obtener los Mejores Resultados

Determinando la Fuerza: Esta configuración controla cuánto influye ControlNet en la imagen resultante. Un 1.0 completo significa que la entrada de ControlNet tiene las riendas, mientras que bajar a 0.0 permite que el modelo se ejecute sin la influencia de ControlNet.

Ajustando el Porcentaje de Inicio: Esto te dice cuándo ControlNet comienza a participar durante el proceso de difusión. Por ejemplo, un inicio del 20% significa que desde un quinto del camino, ControlNet comienza a dejar su huella.

Configurando el Porcentaje de Finalización: Este es el lado opuesto del Porcentaje de Inicio, marcando cuándo ControlNet se retira. Si lo configuras al 80%, la influencia de ControlNet se desvanece a medida que la imagen se acerca a sus etapas finales, sin ser afectada por ControlNet en el último tramo.

3.5. Guía para el Modelo ControlNet: Openpose, Depth, SoftEdge, Canny, Lineart, Tile

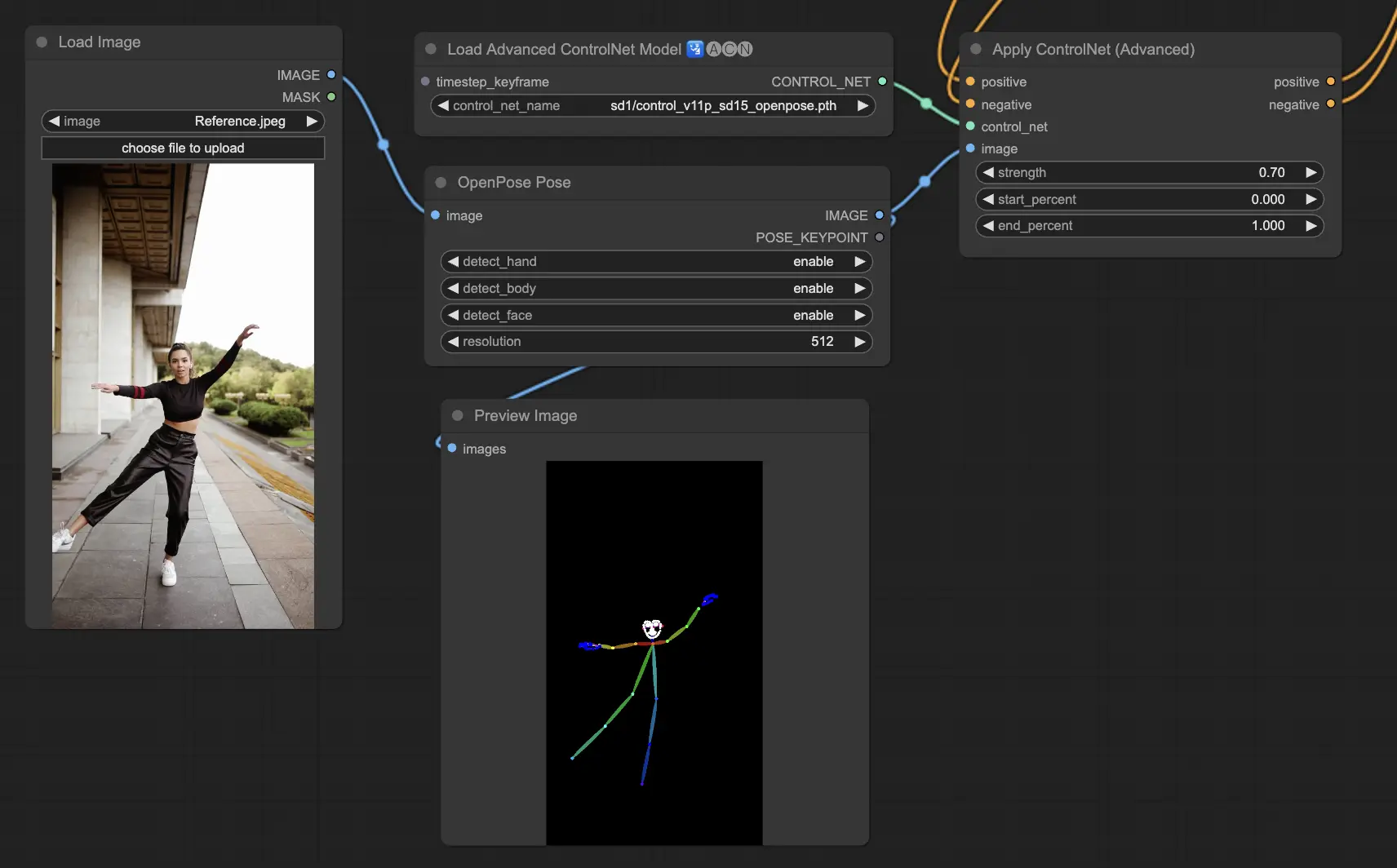

3.5.1. Modelo ControlNet: Openpose

- Openpose (también conocido como Openpose body): Este modelo actúa como la piedra angular de ControlNet para identificar puntos clave en el cuerpo humano, como los ojos, la nariz, el cuello, los hombros, los codos, las muñecas, las rodillas y los tobillos. Es perfecto para replicar poses humanas simples.

- Openpose_face: Esta versión de Openpose va un paso más allá al detectar puntos clave faciales, lo que permite un análisis matizado de las expresiones faciales y la dirección en la que apunta la cara. Si tu proyecto se centra en las expresiones faciales, este modelo es vital.

- Openpose_hand: Esta mejora del modelo Openpose se enfoca en los detalles finos de los movimientos de manos y dedos, lo cual es clave para una comprensión detallada de los gestos y el posicionamiento de las manos. Amplía el alcance de lo que Openpose puede hacer dentro de ControlNet.

- Openpose_faceonly: Adaptado para el análisis detallado del rostro, este modelo se salta los puntos clave del cuerpo para enfocarse exclusivamente en las expresiones faciales y la orientación. Cuando solo importan las características faciales, este es el modelo a elegir.

- Openpose_full: Este modelo todo en uno integra las capacidades de Openpose, Openpose_face y Openpose_hand para la detección de puntos clave de cuerpo completo, rostro y manos, lo que lo convierte en la opción preferida para un análisis integral de la pose humana dentro de ControlNet.

- DW_Openpose_full: Basado en Openpose_full, este modelo introduce mejoras adicionales para una detección de pose superior en detalle y precisión. Es la versión más avanzada disponible en el conjunto de ControlNet.

Las opciones de preprocesador incluyen: Openpose o DWpose

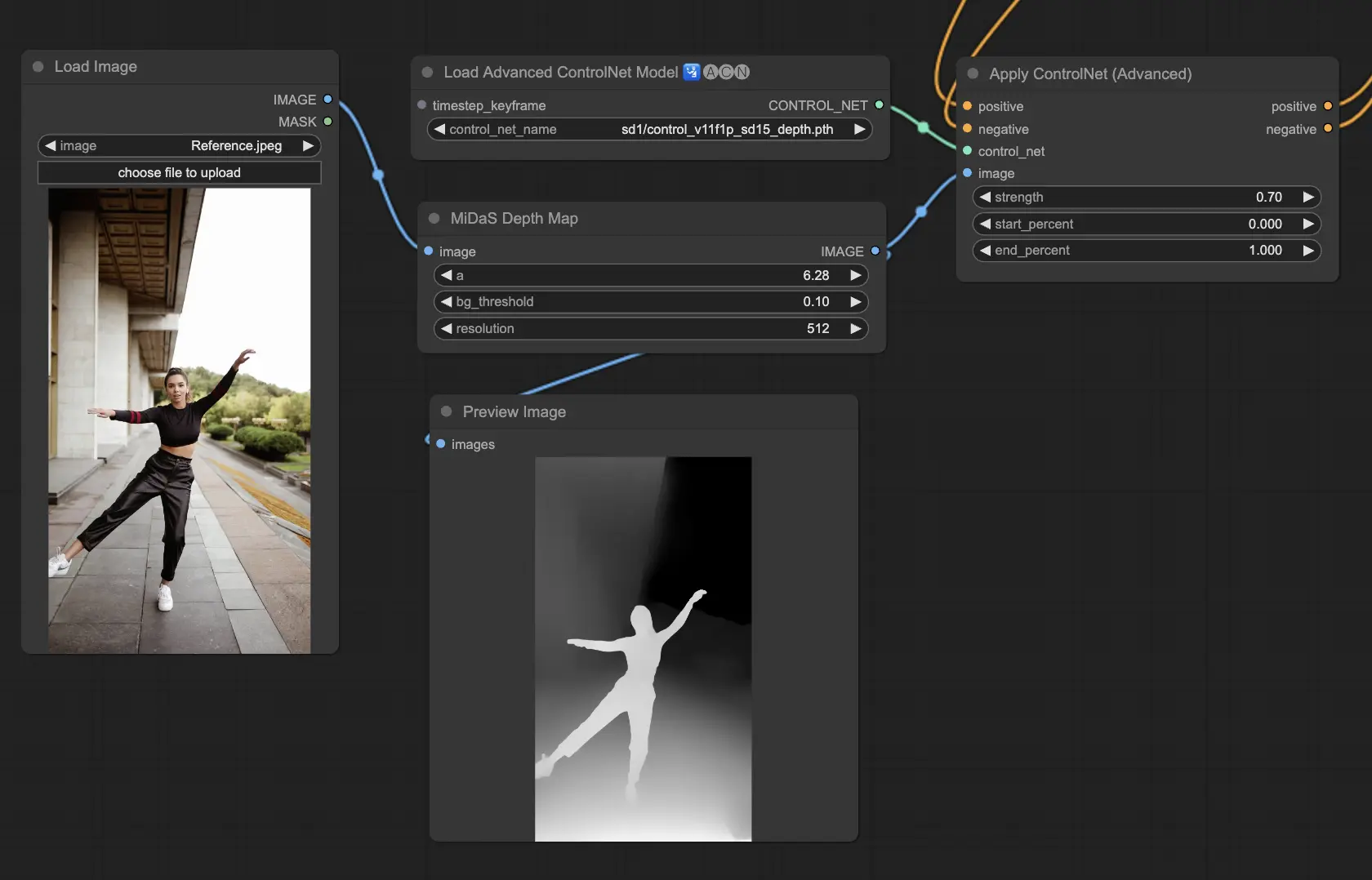

3.5.2. Modelo ControlNet: Depth

Los modelos de profundidad utilizan una imagen 2D para inferir la profundidad, representándola como un mapa en escala de grises. Cada uno tiene sus fortalezas en términos de detalle o enfoque de fondo:

- Depth Midas: Un enfoque equilibrado para la estimación de profundidad, Depth Midas ofrece un punto medio en el detalle y la representación del fondo.

- Depth Leres: Pone énfasis en los detalles mientras sigue capturando elementos de fondo de manera más prominente.

- Depth Leres++: Empuja los límites del detalle en la información de profundidad, lo cual es particularmente útil para escenas complejas.

- Zoe: Encuentra un equilibrio entre los niveles de detalle de los modelos Midas y Leres.

- Depth Anything: Un modelo mejorado para una estimación de profundidad versátil en diversas escenas.

- Depth Hand Refiner: Específicamente ajusta los detalles de las manos en los mapas de profundidad, lo que lo hace invaluable para escenas donde la ubicación precisa de las manos es esencial.

Preprocesadores a considerar: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Este modelo sobresale en robustez y compatibilidad con mapas de profundidad reales de motores de renderizado.

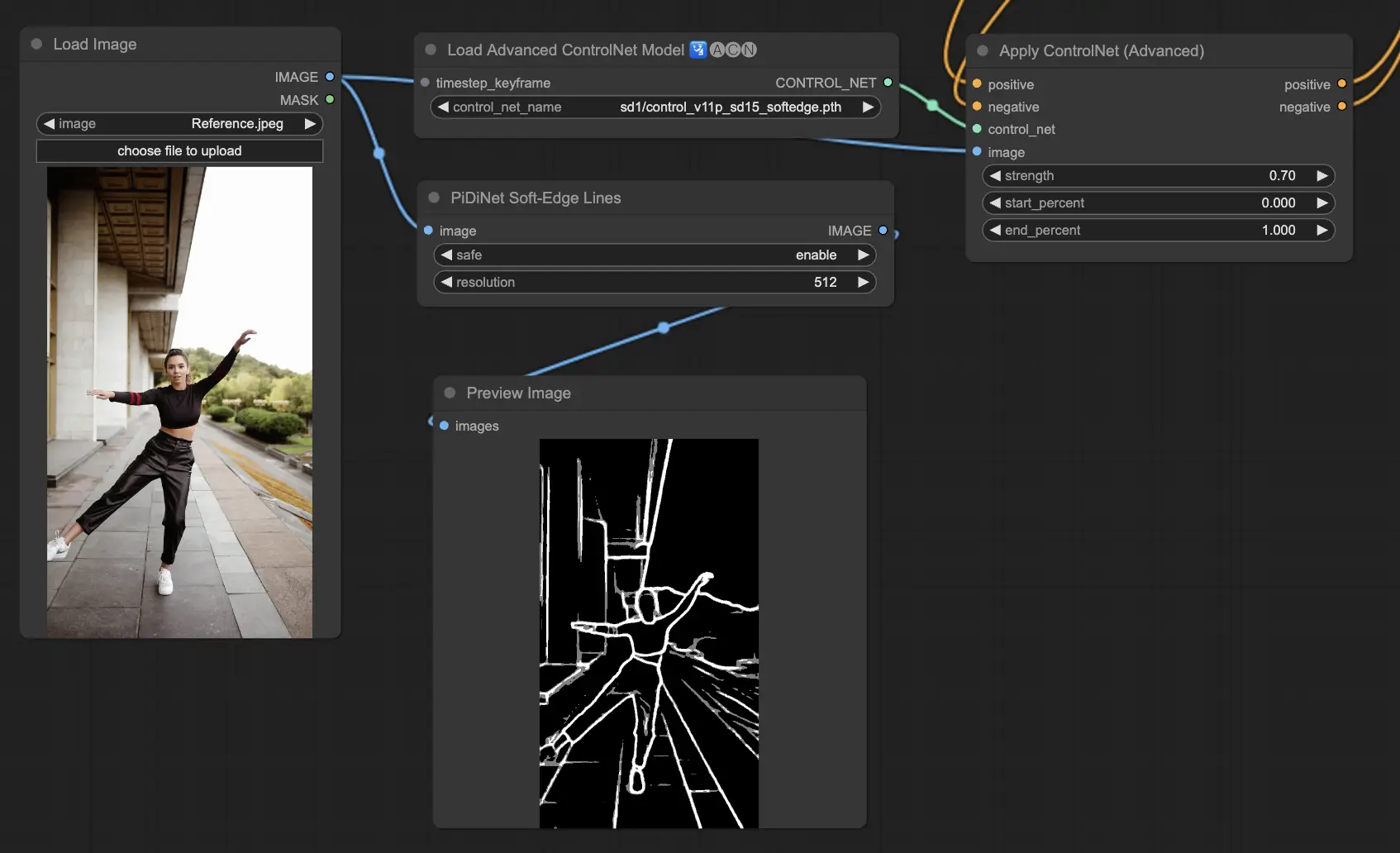

3.5.3. Modelo ControlNet: SoftEdge

ControlNet Soft Edge está diseñado para producir imágenes con bordes más suaves, mejorando los detalles mientras mantiene un aspecto natural. Utiliza redes neuronales de vanguardia para una manipulación refinada de imágenes, ofreciendo un control creativo extenso y una integración impecable.

En términos de robustez: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Para los resultados de más alta calidad: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Como recomendación general, SoftEdge_PIDI es la opción preferida ya que típicamente entrega excelentes resultados.

Los preprocesadores incluyen: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

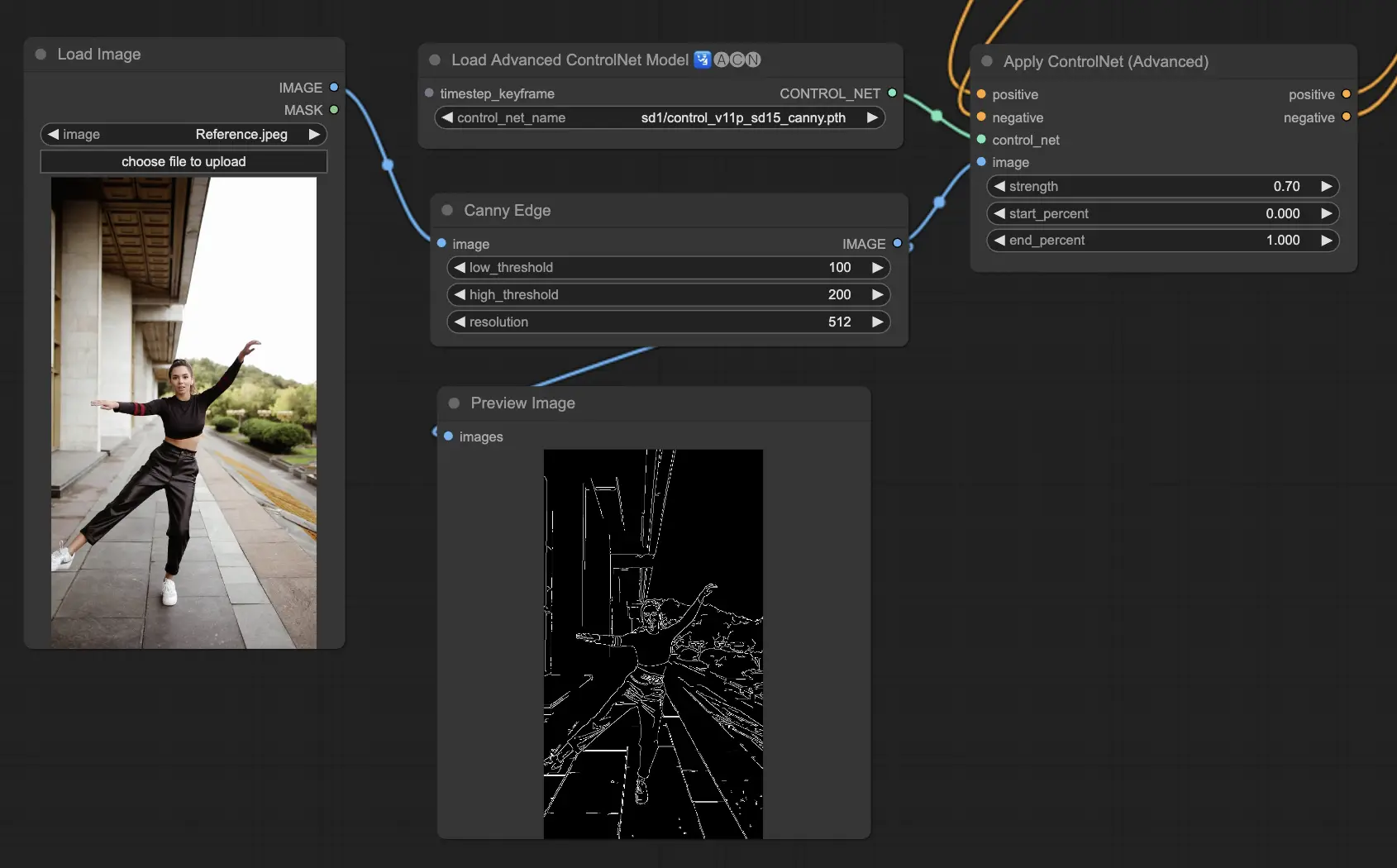

3.5.4. Modelo ControlNet: Canny

El modelo Canny implementa la detección de bordes Canny para resaltar un amplio espectro de bordes dentro de las imágenes. Este modelo es excelente para mantener la integridad de los elementos estructurales mientras simplifica el aspecto general de la imagen, ayudando a crear arte estilizado o preparando imágenes para manipulación adicional.

Preprocesadores disponibles: Canny

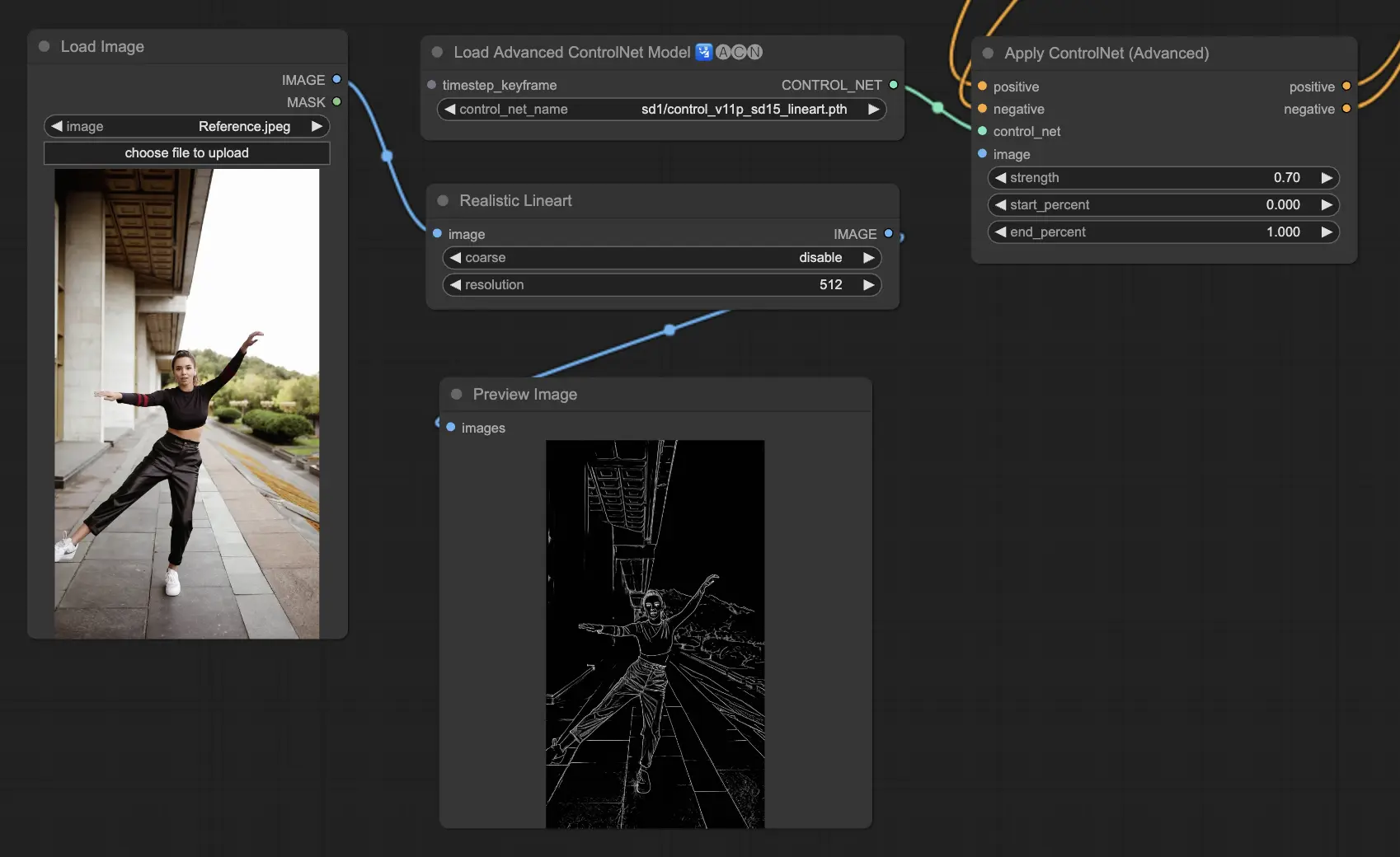

3.5.5. Modelo ControlNet: Lineart

Los modelos Lineart son tus herramientas para transformar imágenes en dibujos lineales estilizados, adecuados para una variedad de aplicaciones artísticas:

- Lineart: La opción estándar para convertir imágenes en dibujos lineales, proporcionando un punto de partida versátil para diferentes esfuerzos artísticos o creativos.

- Lineart anime: Diseñado para crear dibujos lineales de estilo anime limpios y precisos, perfecto para proyectos que apuntan a una apariencia inspirada en el anime.

- Lineart realistic: Busca capturar una representación más realista en los dibujos lineales, ofreciendo más detalles para proyectos que requieren realismo.

- Lineart coarse: Enfatiza líneas más audaces y pronunciadas para un impacto visual llamativo, ideal para declaraciones gráficas audaces.

Los preprocesadores disponibles pueden producir lineart detallado o más pronunciado (Lineart y Lineart_Coarse).

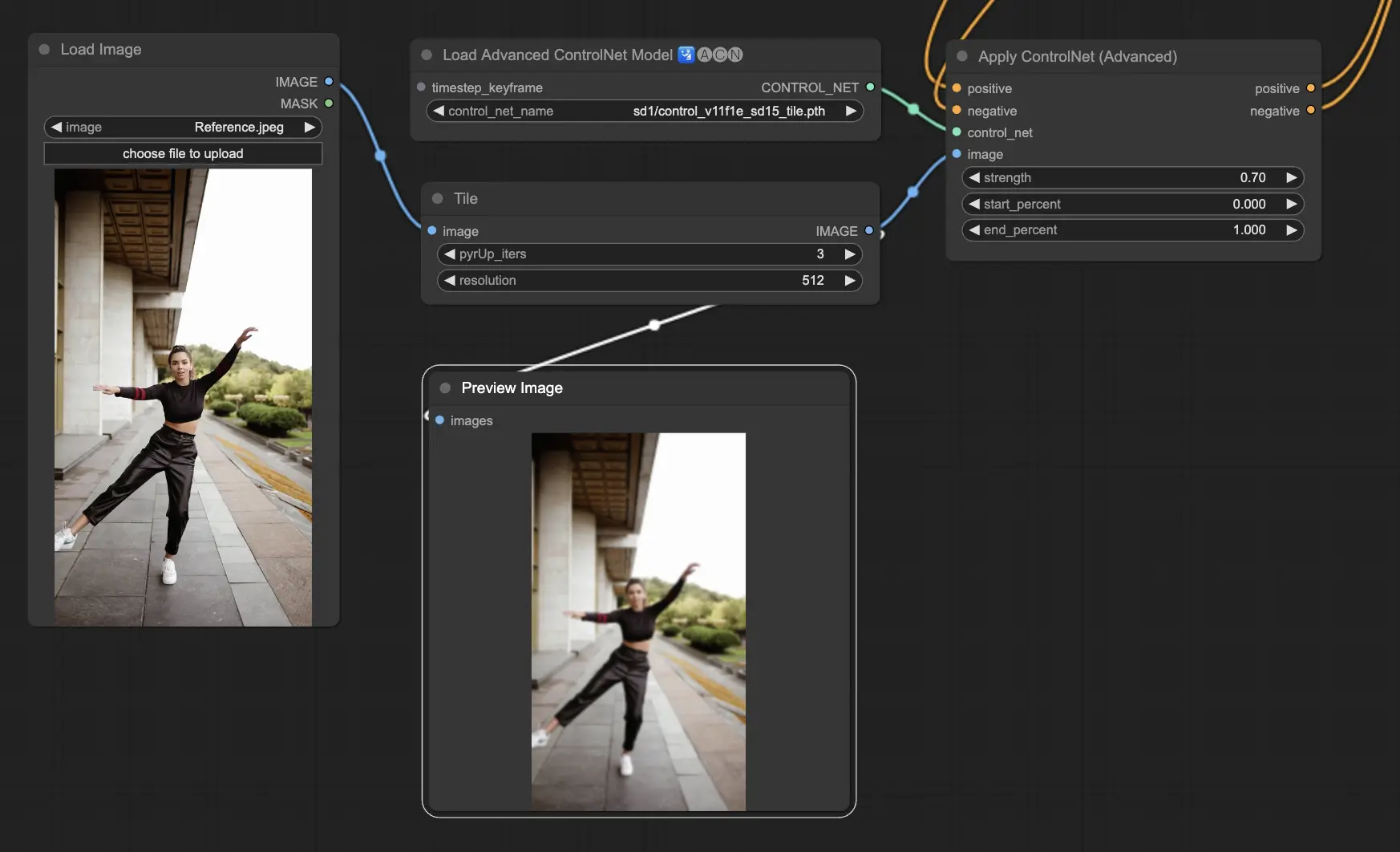

3.5.6. Modelo ControlNet: Tile

El modelo Tile Resample sobresale en resaltar detalles en las imágenes. Es especialmente efectivo cuando se usa junto con un ampliador para mejorar la resolución y el detalle de la imagen, a menudo aplicado para afilar y enriquecer texturas y elementos de la imagen.

Preprocesador recomendado: Tile

3.6. Guía para usar múltiples ControlNet

Incorporar múltiples ControlNets o T2I-Adapters permite la aplicación secuencial de diferentes tipos de condicionamiento a tu proceso de generación de imágenes. Por ejemplo, puedes combinar ControlNets Lineart y OpenPose para un detalle mejorado.

Lineart para la Forma del Objeto: Comienza integrando un ControlNet Lineart para agregar profundidad y detalle a objetos o elementos en tus imágenes. Este proceso implica preparar un mapa lineart o canny para los objetos que deseas incluir.

OpenPose para el Control de la Pose: Después del detallado lineart, utiliza el ControlNet OpenPose para dictar la pose de los individuos dentro de tu imagen. Necesitarás generar u obtener un mapa OpenPose que capture la pose deseada.

Aplicación Secuencial: Para combinar efectivamente estos efectos, vincula la salida del ControlNet Lineart al ControlNet OpenPose. Este método asegura que tanto la pose de los sujetos como las formas de los objetos se guíen simultáneamente durante el proceso de generación, creando un resultado que se alinee armoniosamente con todas las especificaciones de entrada.

4. Resumen de IPAdapter

Por favor, consulta los detalles sobre