ComfyUI FLUX: Guía de Configuración, Flujos de Trabajo como FLUX-ControlNet, FLUX-LoRA y FLUX-IPAdapter... y Acceso en Línea

Updated: 8/26/2024

¡Hola, entusiastas de la IA! 👋 Bienvenidos a nuestra guía introductoria sobre el uso de FLUX dentro de ComfyUI. FLUX es un modelo de última generación desarrollado por Black Forest Labs. 🌟 En este tutorial, profundizaremos en los aspectos esenciales de ComfyUI FLUX, mostrando cómo este poderoso modelo puede mejorar tu proceso creativo y ayudarte a superar los límites del arte generado por IA. 🚀

Cubriremos:

1. Introducción a FLUX

2. Diferentes Versiones de FLUX

3. Requisitos de Hardware de FLUX

- 3.1. Requisitos de Hardware de FLUX.1 [Pro]

- 3.2. Requisitos de Hardware de FLUX.1 [Dev]

- 3.3. Requisitos de Hardware de FLUX.1 [Schnell]

4. Cómo instalar FLUX en ComfyUI

- 4.1. Instalación o Actualización de ComfyUI

- 4.2. Descarga de Codificadores de Texto FLUX de ComfyUI y Modelos CLIP

- 4.3. Descarga del Modelo VAE FLUX.1

- 4.4. Descarga del Modelo UNET FLUX.1

5. Flujo de Trabajo de ComfyUI FLUX | Descarga, Acceso en Línea y Guía

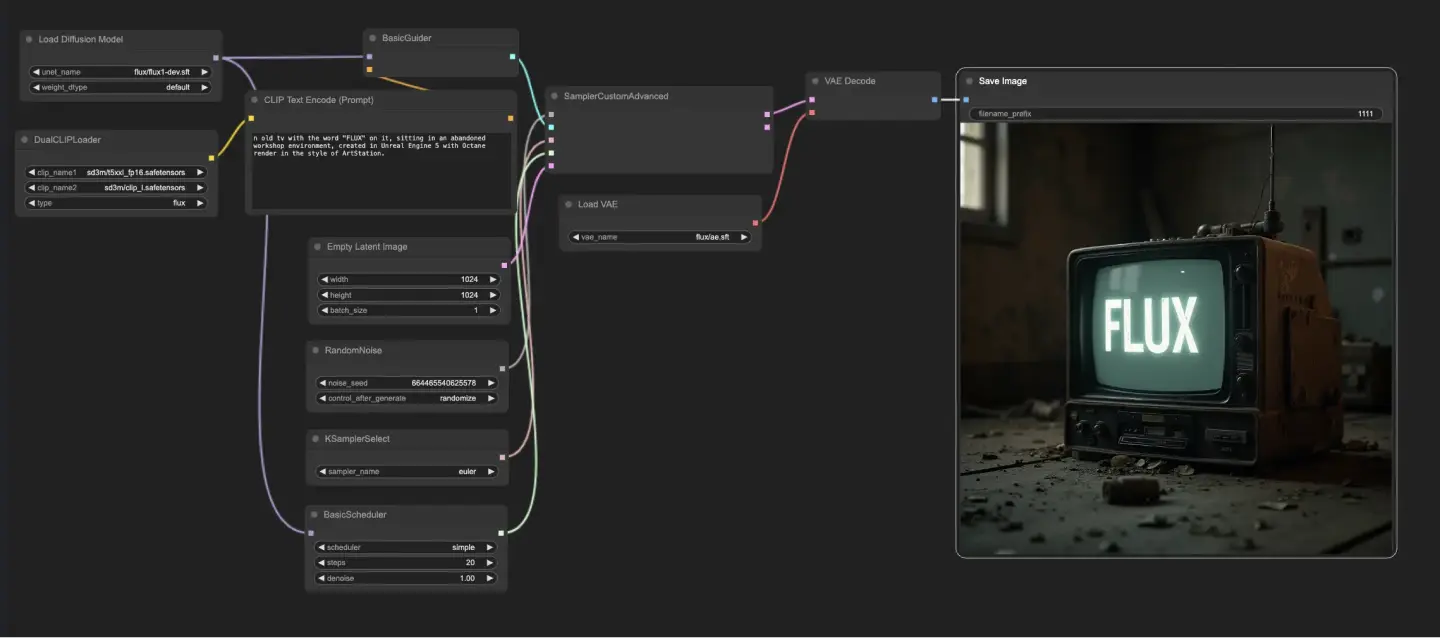

- 5.1. Flujo de Trabajo de ComfyUI: FLUX Txt2Img

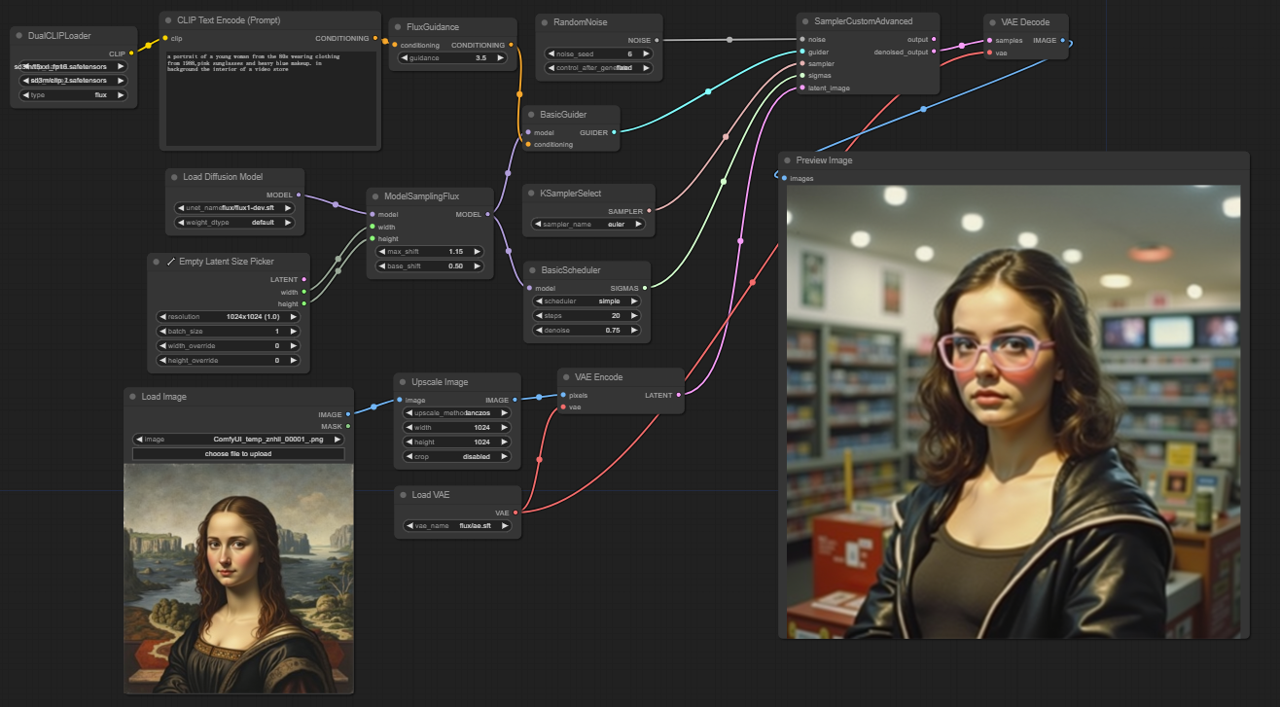

- 5.2. Flujo de Trabajo de ComfyUI: FLUX Img2Img

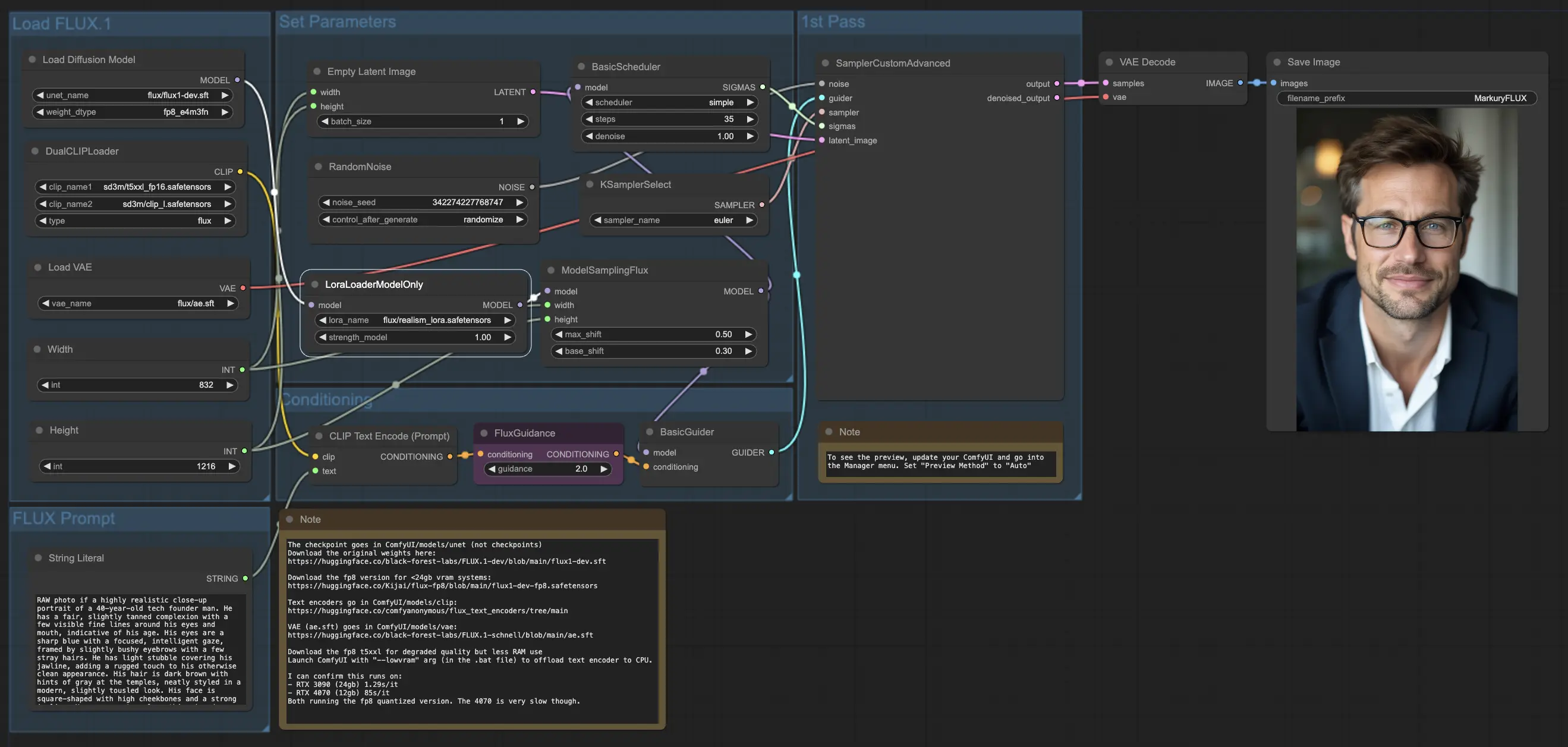

- 5.3. Flujo de Trabajo de ComfyUI: FLUX LoRA

- 5.4. Flujo de Trabajo de ComfyUI: FLUX ControlNet

- 5.5. Flujo de Trabajo de ComfyUI: FLUX Inpainting

- 5.6. Flujo de Trabajo de ComfyUI: FLUX NF4 & Upscale

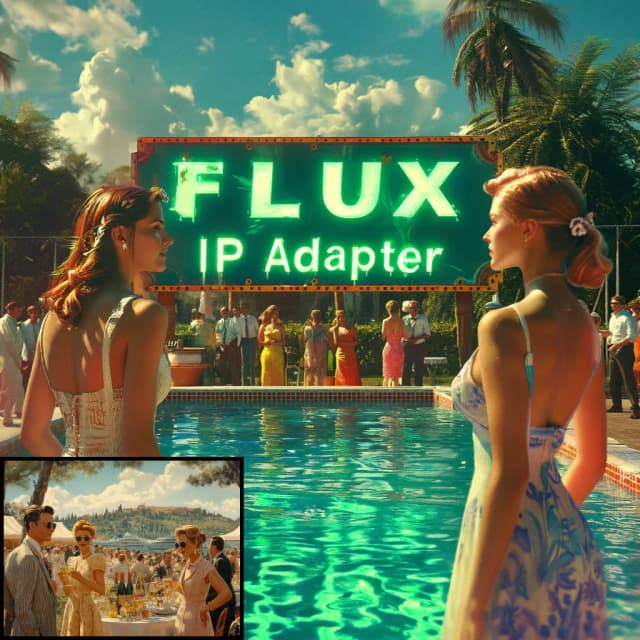

- 5.7. Flujo de Trabajo de ComfyUI: FLUX IPAdapter

- 5.8. Flujo de Trabajo de ComfyUI: Flux LoRA Trainer

- 5.9. Flujo de Trabajo de ComfyUI: Flux Latent Upscale

1. Introducción a FLUX

FLUX.1, el modelo de IA de última generación de Black Forest Labs, está revolucionando la forma en que creamos imágenes a partir de descripciones de texto. Con su capacidad inigualable para generar imágenes asombrosamente detalladas y complejas que se ajustan estrechamente a las indicaciones de entrada, FLUX.1 se destaca de la competencia. El secreto del éxito de FLUX.1 radica en su arquitectura híbrida única, que combina diferentes tipos de bloques transformadores y está impulsada por unos impresionantes 12 mil millones de parámetros. Esto permite a FLUX.1 producir imágenes visualmente cautivadoras que representan con notable precisión las descripciones de texto.

Uno de los aspectos más emocionantes de FLUX.1 es su versatilidad para generar imágenes en diversos estilos, desde fotorrealistas hasta artísticos. FLUX.1 incluso tiene la notable capacidad de incorporar texto de manera fluida dentro de las imágenes generadas, una hazaña que muchos otros modelos luchan por lograr. Además, FLUX.1 es conocido por su excepcional adherencia a las indicaciones, manejando sin esfuerzo tanto descripciones simples como complejas. Esto ha llevado a que FLUX.1 se compare frecuentemente con otros modelos bien conocidos como Stable Diffusion y Midjourney, con FLUX.1 a menudo emergiendo como la opción preferida debido a su naturaleza fácil de usar y resultados de primera calidad.

Las impresionantes capacidades de FLUX.1 lo convierten en una herramienta invaluable para una amplia gama de aplicaciones, desde la creación de contenido visual impresionante e inspirar diseños innovadores hasta facilitar la visualización científica. La capacidad de FLUX.1 para generar imágenes altamente detalladas y precisas a partir de descripciones de texto abre un mundo de posibilidades para profesionales creativos, investigadores y entusiastas por igual. A medida que el campo de la imaginería generada por IA continúa evolucionando, FLUX.1 se encuentra a la vanguardia, estableciendo un nuevo estándar de calidad, versatilidad y facilidad de uso.

Black Forest Labs, la empresa pionera de IA detrás del revolucionario FLUX.1, fue fundada por Robin Rombach, una figura destacada en la industria de la IA que anteriormente formó parte del equipo central de Stability AI. Si estás ansioso por aprender más sobre Black Forest Labs y su trabajo revolucionario con FLUX.1, asegúrate de visitar su sitio web oficial en https://blackforestlabs.ai/.

2. Diferentes Versiones de FLUX

FLUX.1 viene en tres versiones diferentes, cada una diseñada para satisfacer necesidades específicas de los usuarios:

- FLUX.1 [pro]: Esta es la versión de gama alta que ofrece la mejor calidad y rendimiento, perfecta para uso profesional y proyectos de alto nivel.

- FLUX.1 [dev]: Optimizada para uso no comercial, esta versión mantiene una salida de alta calidad mientras es más eficiente, lo que la hace ideal para desarrolladores y entusiastas.

- FLUX.1 [schnell]: Esta versión se centra en la velocidad y la ligereza, lo que la hace perfecta para desarrollo local y proyectos personales. También es de código abierto y está disponible bajo la licencia Apache 2.0, por lo que es accesible para una amplia gama de usuarios.

| Nombre | Repositorio de HuggingFace | Licencia | md5sum |

FLUX.1 [pro] | Solo disponible en nuestra API. | ||

FLUX.1 [dev] | https://huggingface.co/black-forest-labs/FLUX.1-dev | FLUX.1-dev Non-Commercial License | a6bd8c16dfc23db6aee2f63a2eba78c0 |

FLUX.1 [schnell] | https://huggingface.co/black-forest-labs/FLUX.1-schnell | apache-2.0 | a9e1e277b9b16add186f38e3f5a34044 |

3. Requisitos de Hardware de FLUX

3.1. FLUX.1 [Pro] Requisitos de Hardware

- GPU Recomendada: NVIDIA RTX 4090 o equivalente con 24 GB o más de VRAM. El modelo está optimizado para GPUs de alta gama para manejar sus operaciones complejas.

- RAM: 32 GB o más de memoria del sistema.

- Espacio en Disco: Aproximadamente 30 GB.

- Requisitos de Computación: Se requiere alta precisión; usa FP16 (media precisión) para evitar errores de falta de memoria. Para mejores resultados, se sugiere usar la variante del modelo Clip

fp16para máxima calidad. - Otros Requisitos: Se recomienda un SSD rápido para tiempos de carga más rápidos y mejor rendimiento general.

3.2. FLUX.1 [Dev] Requisitos de Hardware

- GPU Recomendada: NVIDIA RTX 3080/3090 o equivalente con al menos 16 GB de VRAM. Esta versión es un poco más tolerante con el hardware en comparación con el modelo Pro, pero aún requiere un poder sustancial de GPU.

- RAM: 16 GB o más de memoria del sistema.

- Espacio en Disco: Aproximadamente 25 GB.

- Requisitos de Computación: Similar al Pro, usa modelos FP16, pero con una ligera tolerancia para cálculos de menor precisión. Puede usar modelos Clip

fp16ofp8según las capacidades de la GPU. - Otros Requisitos: Se recomienda un SSD rápido para un rendimiento óptimo.

3.3. FLUX.1 [Schnell] Requisitos de Hardware

- GPU Recomendada: NVIDIA RTX 3060/4060 o equivalente con 12 GB de VRAM. Esta versión está optimizada para una inferencia más rápida y menores demandas de hardware.

- RAM: 8 GB o más de memoria del sistema.

- Espacio en Disco: Aproximadamente 15 GB.

- Requisitos de Computación: Esta versión es menos exigente y permite cálculos

fp8si se queda sin memoria. Está diseñada para ser rápida y eficiente, con un enfoque en la velocidad en lugar de la calidad ultra alta. - Otros Requisitos: El SSD es útil pero no tan crítico como en las versiones Pro y Dev.

4. Cómo instalar FLUX en ComfyUI

4.1. Instalación o Actualización de ComfyUI

Para usar eficazmente FLUX.1 dentro del entorno ComfyUI, es crucial asegurarse de tener instalada la última versión de ComfyUI. Esta versión soporta las características e integraciones necesarias para los modelos FLUX.1.

4.2. Descarga de Codificadores de Texto FLUX de ComfyUI y Modelos CLIP

Para un rendimiento óptimo y una generación precisa de texto a imagen usando FLUX.1, necesitarás descargar codificadores de texto específicos y modelos CLIP. Los siguientes modelos son esenciales, dependiendo del hardware de tu sistema:

| Nombre del Archivo del Modelo | Tamaño | Nota | Enlace |

t5xxl_fp16.safetensors | 9.79 GB | Para mejores resultados, si tienes alta VRAM y RAM (más de 32 GB de RAM). | Descargar |

t5xxl_fp8_e4m3fn.safetensors | 4.89 GB | Para menor uso de memoria (8-12 GB) | Descargar |

clip_l.safetensors | 246 MB | Descargar |

Pasos para Descargar e Instalar:

- Descarga el modelo

clip_l.safetensors. - Dependiendo de la VRAM y RAM de tu sistema, descarga

t5xxl_fp8_e4m3fn.safetensors(para menor VRAM) ot5xxl_fp16.safetensors(para mayor VRAM y RAM). - Coloca los modelos descargados en el directorio

ComfyUI/models/clip/. Nota: Si has usado previamente SD 3 Medium, es posible que ya tengas estos modelos.

4.3. Descarga del Modelo VAE FLUX.1

El modelo Variational Autoencoder (VAE) es crucial para mejorar la calidad de generación de imágenes en FLUX.1. El siguiente modelo VAE está disponible para su descarga:

| Nombre del Archivo | Tamaño | Enlace |

ae.safetensors | 335 MB | Descargar (se abre en una nueva pestaña) |

Pasos para Descargar e Instalar:

- Descarga el archivo de modelo

ae.safetensors. - Coloca el archivo descargado en el directorio

ComfyUI/models/vae. - Para una fácil identificación, se recomienda renombrar el archivo a

flux_ae.safetensors.

4.4. Descarga del Modelo UNET FLUX.1

El modelo UNET es la columna vertebral para la síntesis de imágenes en FLUX.1. Dependiendo de las especificaciones de tu sistema, puedes elegir entre diferentes variantes:

| Nombre del Archivo | Tamaño | Enlace | Nota |

flux1-dev.safetensors | 23.8GB | Descargar | Si tienes alta VRAM y RAM. |

flux1-schnell.safetensors | 23.8GB | Descargar | Para menor uso de memoria |

Pasos para Descargar e Instalar:

- Descarga el modelo UNET apropiado según la configuración de memoria de tu sistema.

- Coloca el archivo de modelo descargado en el directorio

ComfyUI/models/unet/.

5. Flujo de Trabajo de ComfyUI FLUX | Descarga, Acceso en Línea y Guía

Actualizaremos continuamente el Flujo de Trabajo de ComfyUI FLUX para proporcionarte los flujos de trabajo más recientes y completos para generar imágenes impresionantes usando ComfyUI FLUX.

5.1. Flujo de Trabajo de ComfyUI: FLUX Txt2Img

5.1.1. ComfyUI FLUX Txt2Img : Descargar

5.1.2. ComfyUI FLUX Txt2Img Versión en Línea: ComfyUI FLUX Txt2Img

En la Plataforma RunComfy, nuestra versión en línea precarga todos los modos y nodos necesarios para ti. Además, ofrecemos máquinas GPU de alto rendimiento, asegurando que puedas disfrutar de la experiencia ComfyUI FLUX Txt2Img sin esfuerzo.

5.1.3. Explicación de ComfyUI FLUX Txt2Img:

El flujo de trabajo de ComfyUI FLUX Txt2Img comienza cargando los componentes esenciales, incluidos el FLUX UNET (UNETLoader), FLUX CLIP (DualCLIPLoader) y FLUX VAE (VAELoader). Estos forman la base del proceso de generación de imágenes de ComfyUI FLUX.

- UNETLoader: Carga el modelo UNET para la generación de imágenes.

- Checkpoint: flux/flux1-schnell.sft; flux/flux1-dev.sft

- DualCLIPLoader: Carga el modelo CLIP para la codificación de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupación: La estrategia de agrupación para el modelo CLIP es flux

- VAELoader: Carga el modelo Variational Autoencoder (VAE) para decodificar representaciones latentes.

- Modelo VAE: flux/ae.sft

La indicación de texto, que describe la salida deseada, se codifica usando el CLIPTextEncode. Este nodo toma la indicación de texto como entrada y produce la codificación de texto condicionada, que guía a ComfyUI FLUX durante la generación.

Para iniciar el proceso de generación de ComfyUI FLUX, se crea una representación latente vacía usando el EmptyLatentImage. Esto sirve como punto de partida para que ComfyUI FLUX construya.

El BasicGuider juega un papel crucial en la guía del proceso de generación de ComfyUI FLUX. Toma la codificación de texto condicionada y el UNET cargado de FLUX como entradas, asegurando que la salida generada se alinee con la descripción de texto proporcionada.

El KSamplerSelect te permite elegir el método de muestreo para la generación de ComfyUI FLUX, mientras que el RandomNoise genera ruido aleatorio como entrada para ComfyUI FLUX. El BasicScheduler programa los niveles de ruido (sigmas) para cada paso en el proceso de generación, controlando el nivel de detalle y claridad en la salida final.

El SamplerCustomAdvanced reúne todos los componentes del flujo de trabajo de ComfyUI FLUX Txt2Img. Toma el ruido aleatorio, el guía, el muestreador seleccionado, los sigmas programados y la representación latente vacía como entradas. A través de un proceso de muestreo avanzado, genera una representación latente que representa la indicación de texto.

Finalmente, el VAEDecode decodifica la representación latente generada en la salida final usando el VAE de FLUX cargado. El SaveImage te permite guardar la salida generada en una ubicación especificada, preservando la impresionante creación posible gracias al flujo de trabajo de ComfyUI FLUX Txt2Img.

5.2. Flujo de Trabajo de ComfyUI: FLUX Img2Img

5.2.1. ComfyUI FLUX Img2Img: Descargar

5.2.2. ComfyUI FLUX Img2Img Versión en Línea: ComfyUI FLUX Img2Img

En la Plataforma RunComfy, nuestra versión en línea precarga todos los modos y nodos necesarios para ti. Además, ofrecemos máquinas GPU de alto rendimiento, asegurando que puedas disfrutar de la experiencia ComfyUI FLUX Img2Img sin esfuerzo.

5.2.3. Explicación de ComfyUI FLUX Img2Img:

El flujo de trabajo de ComfyUI FLUX Img2Img se basa en el poder de ComfyUI FLUX para generar salidas basadas tanto en indicaciones de texto como en representaciones de entrada. Comienza cargando los componentes necesarios, incluidos el modelo CLIP (DualCLIPLoader), el modelo UNET (UNETLoader) y el modelo VAE (VAELoader).

- UNETLoader: Carga el modelo UNET para la generación de imágenes.

- Checkpoint: flux/flux1-schnell.sft; flux/flux1-dev.sft

- DualCLIPLoader: Carga el modelo CLIP para la codificación de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupación: La estrategia de agrupación para el modelo CLIP es flux

- VAELoader: Carga el modelo Variational Autoencoder (VAE) para decodificar representaciones latentes.

- Modelo VAE: flux/ae.sft

La representación de entrada, que sirve como punto de partida para el proceso ComfyUI FLUX Img2Img, se carga usando el LoadImage. El ImageScale luego escala la representación de entrada al tamaño deseado, asegurando la compatibilidad con ComfyUI FLUX.

La representación de entrada escalada se codifica usando el VAEEncode, convirtiéndola en una representación latente. Esta representación latente captura las características esenciales y los detalles de la entrada, proporcionando una base para que ComfyUI FLUX trabaje.

La indicación de texto, que describe las modificaciones o mejoras deseadas para la entrada, se codifica usando el CLIPTextEncode. El FluxGuidance luego aplica orientación a la codificación condicionada según la escala de orientación especificada, influyendo en la fuerza de la influencia de la indicación de texto en la salida final.

El ModelSamplingFlux configura los parámetros de muestreo para ComfyUI FLUX, incluidos el reespaciado de tiempos, la relación de padding y las dimensiones de salida. Estos parámetros controlan la granularidad y la resolución de la salida generada.

El KSamplerSelect te permite elegir el método de muestreo para la generación de ComfyUI FLUX, mientras que el BasicGuider guía el proceso de generación basado en la codificación de texto y el UNET de FLUX cargado.

El ruido aleatorio se genera usando el RandomNoise, y el BasicScheduler programa los niveles de ruido (sigmas) para cada paso en el proceso de generación. Estos componentes introducen variaciones controladas y afinan los detalles en la salida final.

El SamplerCustomAdvanced reúne el ruido aleatorio, el guía, el muestreador seleccionado, los sigmas programados y la representación latente de la entrada. A través de un proceso de muestreo avanzado, genera una representación latente que incorpora las modificaciones especificadas por la indicación de texto mientras preserva las características esenciales de la entrada.

Finalmente, el VAEDecode decodifica la representación latente denoised en la salida final usando el VAE de FLUX cargado. El PreviewImage muestra una vista previa de la salida generada, mostrando los impresionantes resultados logrados por el flujo de trabajo de ComfyUI FLUX Img2Img.

5.3. Flujo de Trabajo de ComfyUI: FLUX LoRA

5.3.1. ComfyUI FLUX LoRA: Descargar

5.3.2. ComfyUI FLUX LoRA Versión en Línea: ComfyUI FLUX LoRA

En la Plataforma RunComfy, nuestra versión en línea precarga todos los modos y nodos necesarios para ti. Además, ofrecemos máquinas GPU de alto rendimiento, asegurando que puedas disfrutar de la experiencia ComfyUI FLUX LoRA sin esfuerzo.

5.3.3. Explicación de ComfyUI FLUX LoRA:

El flujo de trabajo de ComfyUI FLUX LoRA aprovecha el poder de la Adaptación de Bajo Rango (LoRA) para mejorar el rendimiento de ComfyUI FLUX. Comienza cargando los componentes necesarios, incluidos el modelo UNET (UNETLoader), el modelo CLIP (DualCLIPLoader), el modelo VAE (VAELoader) y el modelo LoRA (LoraLoaderModelOnly).

- UNETLoader: Carga el modelo UNET para la generación de imágenes.

- Checkpoint: flux/flux1-dev.sft

- DualCLIPLoader: Carga el modelo CLIP para la codificación de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupación: La estrategia de agrupación para el modelo CLIP es flux

- VAELoader: Carga el modelo Variational Autoencoder (VAE) para decodificar representaciones latentes.

- Modelo VAE: flux/ae.sft

- LoraLoaderModelOnly: Carga el modelo LoRA (Adaptación de Bajo Rango) para mejorar el modelo UNET.

- Modelo Cargado: flux/realism_lora.safetensors

La indicación de texto, que describe la salida deseada, se especifica usando el String Literal. Luego, el CLIPTextEncode codifica la indicación de texto, generando la codificación de texto condicionada que guía el proceso de generación de ComfyUI FLUX.

El FluxGuidance aplica orientación a la codificación de texto condicionada, influyendo en la fuerza y dirección de la adherencia de ComfyUI FLUX a la indicación de texto.

Se crea una representación latente vacía, que sirve como punto de partida para la generación, usando el EmptyLatentImage. El ancho y la altura de la salida generada se especifican usando el Int Literal, asegurando las dimensiones deseadas del resultado final.

El ModelSamplingFlux configura los parámetros de muestreo para ComfyUI FLUX, incluidos la relación de padding y el reespaciado de tiempos. Estos parámetros controlan la resolución y granularidad de la salida generada.

El KSamplerSelect te permite elegir el método de muestreo para la generación de ComfyUI FLUX, mientras que el BasicGuider guía el proceso de generación basado en la codificación de texto y el UNET de FLUX cargado mejorado con FLUX LoRA.

El ruido aleatorio se genera usando el RandomNoise, y el BasicScheduler programa los niveles de ruido (sigmas) para cada paso en el proceso de generación. Estos componentes introducen variaciones controladas y afinan los detalles en la salida final.

El SamplerCustomAdvanced reúne el ruido aleatorio, el guía, el muestreador seleccionado, los sigmas programados y la representación latente vacía. A través de un proceso de muestreo avanzado, genera una representación latente que representa la indicación de texto, aprovechando el poder de FLUX y la mejora de FLUX LoRA.

Finalmente, el VAEDecode decodifica la representación latente generada en la salida final usando el VAE de FLUX cargado. El SaveImage te permite guardar la salida generada en una ubicación especificada, preservando la impresionante creación posible gracias al flujo de trabajo de ComfyUI FLUX LoRA.

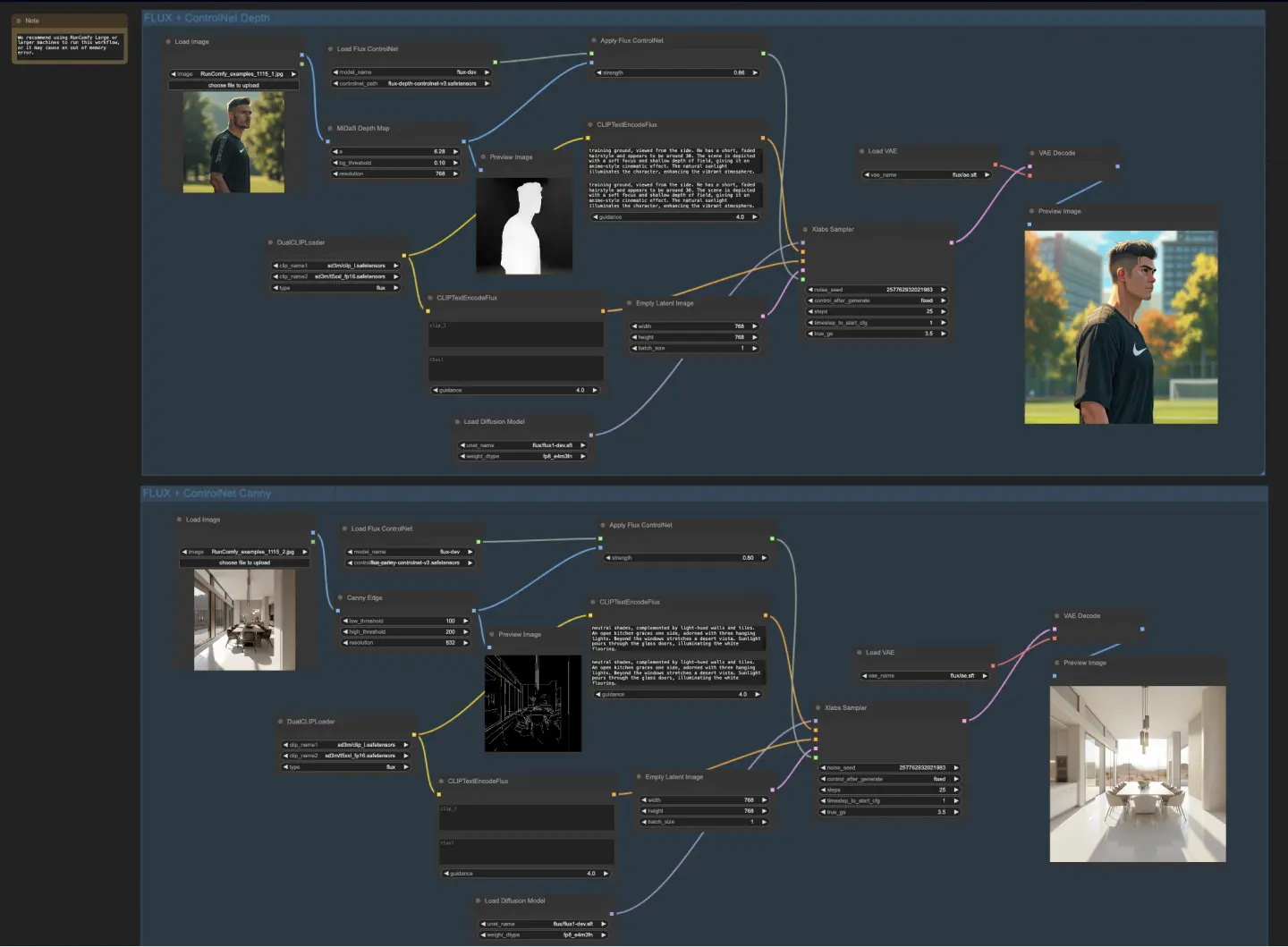

5.4. Flujo de Trabajo de ComfyUI: FLUX ControlNet

5.4.1. ComfyUI FLUX ControlNet: Descargar

5.4.2. ComfyUI FLUX ControlNet Versión en Línea: ComfyUI FLUX ControlNet

En la Plataforma RunComfy, nuestra versión en línea precarga todos los modos y nodos necesarios para ti. Además, ofrecemos máquinas GPU de alto rendimiento, asegurando que puedas disfrutar de la experiencia ComfyUI FLUX ControlNet sin esfuerzo.

5.4.3. Explicación de ComfyUI FLUX ControlNet:

El flujo de trabajo de ComfyUI FLUX ControlNet demuestra la integración de ControlNet con ComfyUI FLUX para una generación de salida mejorada. El flujo de trabajo muestra dos ejemplos: acondicionamiento basado en profundidad y acondicionamiento basado en bordes de Canny.

- UNETLoader: Carga el modelo UNET para la generación de imágenes.

- Checkpoint: flux/flux1-dev.sft

- DualCLIPLoader

: Carga el modelo CLIP para la codificación de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupación: La estrategia de agrupación para el modelo CLIP es flux

- VAELoader: Carga el modelo Variational Autoencoder (VAE) para decodificar representaciones latentes.

- Modelo VAE: flux/ae.sft

En el flujo de trabajo basado en profundidad, la representación de entrada se somete a preprocesamiento usando el MiDaS-DepthMapPreprocessor, generando un mapa de profundidad. El mapa de profundidad se pasa a través del ApplyFluxControlNet (Depth) junto con el FLUX ControlNet cargado para el acondicionamiento de profundidad. La condición resultante del FLUX ControlNet sirve como entrada para el XlabsSampler (Depth), junto con el UNET de FLUX cargado, la codificación de texto, la codificación de texto negativa y la representación latente vacía. El XlabsSampler genera una representación latente basada en estas entradas, que luego se decodifica en la salida final usando el VAEDecode.

- MiDaS-DepthMapPreprocessor (Depth): Preprocesa la imagen de entrada para la estimación de profundidad usando MiDaS.

- LoadFluxControlNet: Carga el modelo ControlNet.

- Ruta: flux-depth-controlnet.safetensors

De manera similar, en el flujo de trabajo basado en bordes de Canny, la representación de entrada se somete a preprocesamiento usando el CannyEdgePreprocessor para generar bordes de Canny. La representación de bordes de Canny se pasa a través del ApplyFluxControlNet (Canny) junto con el FLUX ControlNet cargado para el acondicionamiento de bordes de Canny. La condición resultante del FLUX ControlNet sirve como entrada para el XlabsSampler (Canny), junto con el UNET de FLUX cargado, la codificación de texto, la codificación de texto negativa y la representación latente vacía. El XlabsSampler genera una representación latente basada en estas entradas, que luego se decodifica en la salida final usando el VAEDecode.

- CannyEdgePreprocessor (Canny): Preprocesa la imagen de entrada para la detección de bordes de Canny.

- LoadFluxControlNet: Carga el modelo ControlNet.

- Ruta: flux-canny-controlnet.safetensors

El flujo de trabajo de ComfyUI FLUX ControlNet incorpora nodos para cargar los componentes necesarios (DualCLIPLoader, UNETLoader, VAELoader, LoadFluxControlNet), codificar indicaciones de texto (CLIPTextEncodeFlux), crear representaciones latentes vacías (EmptyLatentImage) y previsualizar las salidas generadas y preprocesadas (PreviewImage).

Al aprovechar el poder de FLUX ControlNet, el flujo de trabajo de ComfyUI FLUX ControlNet permite la generación de salidas que se alinean con el acondicionamiento específico, como mapas de profundidad o bordes de Canny. Este nivel adicional de control y orientación mejora la flexibilidad y precisión del proceso de generación, permitiendo la creación de salidas impresionantes y contextualmente relevantes usando ComfyUI FLUX.

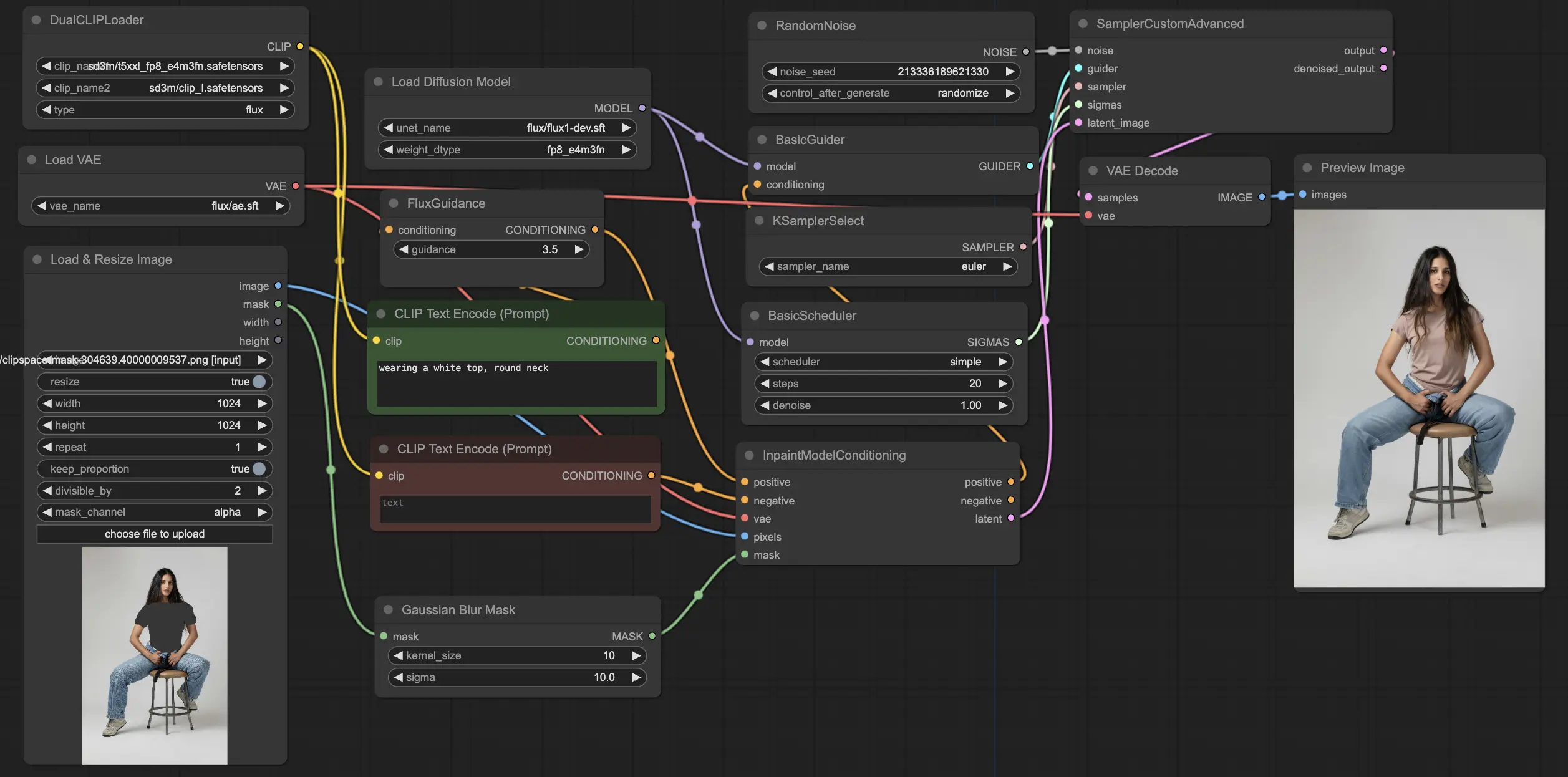

5.5. Flujo de Trabajo de ComfyUI: FLUX Inpainting

5.5.1. ComfyUI FLUX Inpainting: Descargar

5.5.2. ComfyUI FLUX Inpainting Versión en Línea: ComfyUI FLUX Inpainting

En la Plataforma RunComfy, nuestra versión en línea precarga todos los modos y nodos necesarios para ti. Además, ofrecemos máquinas GPU de alto rendimiento, asegurando que puedas disfrutar de la experiencia ComfyUI FLUX Inpainting sin esfuerzo.

5.5.3. Explicación de ComfyUI FLUX Inpainting:

El flujo de trabajo de ComfyUI FLUX Inpainting demuestra la capacidad de ComfyUI FLUX para realizar inpainting, que implica llenar regiones faltantes o enmascaradas de una salida basada en el contexto circundante y las indicaciones de texto proporcionadas. El flujo de trabajo comienza cargando los componentes necesarios, incluidos el modelo UNET (UNETLoader), el modelo VAE (VAELoader) y el modelo CLIP (DualCLIPLoader).

- UNETLoader: Carga el modelo UNET para la generación de imágenes.

- Checkpoint: flux/flux1-schnell.sft; flux/flux1-dev.sft

- DualCLIPLoader: Carga el modelo CLIP para la codificación de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupación: La estrategia de agrupación para el modelo CLIP es flux

- VAELoader: Carga el modelo Variational Autoencoder (VAE) para decodificar representaciones latentes.

- Modelo VAE: flux/ae.sft

Las indicaciones de texto positivas y negativas, que describen el contenido y estilo deseado para la región inpainted, se codifican usando los CLIPTextEncodes. La codificación de texto positiva se guía aún más usando el FluxGuidance para influir en el proceso de inpainting de ComfyUI FLUX.

La representación de entrada y la máscara se cargan y redimensionan usando el LoadAndResizeImage, asegurando la compatibilidad con los requisitos de ComfyUI FLUX. El ImpactGaussianBlurMask aplica desenfoque gaussiano a la máscara, creando una transición más suave entre la región inpainted y la representación original.

El InpaintModelConditioning prepara el acondicionamiento para el inpainting de FLUX combinando la codificación de texto positiva guiada, la codificación de texto negativa codificada, el VAE de FLUX cargado, la representación de entrada cargada y redimensionada, y la máscara desenfocada. Este acondicionamiento sirve como la base para el proceso de inpainting de ComfyUI FLUX.

El ruido aleatorio se genera usando el RandomNoise, y el método de muestreo se selecciona usando el KSamplerSelect. El BasicScheduler programa los niveles de ruido (sigmas) para el proceso de inpainting de ComfyUI FLUX, controlando el nivel de detalle y claridad en la región inpainted.

El BasicGuider guía el proceso de inpainting de ComfyUI FLUX basado en el acondicionamiento preparado y el UNET de FLUX cargado. El SamplerCustomAdvanced realiza el proceso de muestreo avanzado, tomando el ruido aleatorio generado, el guía, el muestreador seleccionado, los sigmas programados y la representación latente de la entrada como entradas. Produce la representación latente inpainted.

Finalmente, el VAEDecode decodifica la representación latente inpainted en la salida final, integrando perfectamente la región inpainted con la representación original. El PreviewImage muestra la salida final, demostrando las impresionantes capacidades de inpainting de FLUX.

Al aprovechar el poder de FLUX y el flujo de trabajo de inpainting cuidadosamente diseñado, FLUX Inpainting permite la creación de salidas inpainted visualmente coherentes y contextualmente relevantes. Ya sea restaurando partes faltantes, eliminando objetos no deseados o modificando regiones específicas, el flujo de trabajo de inpainting de ComfyUI FLUX proporciona una herramienta poderosa para la edición y manipulación.

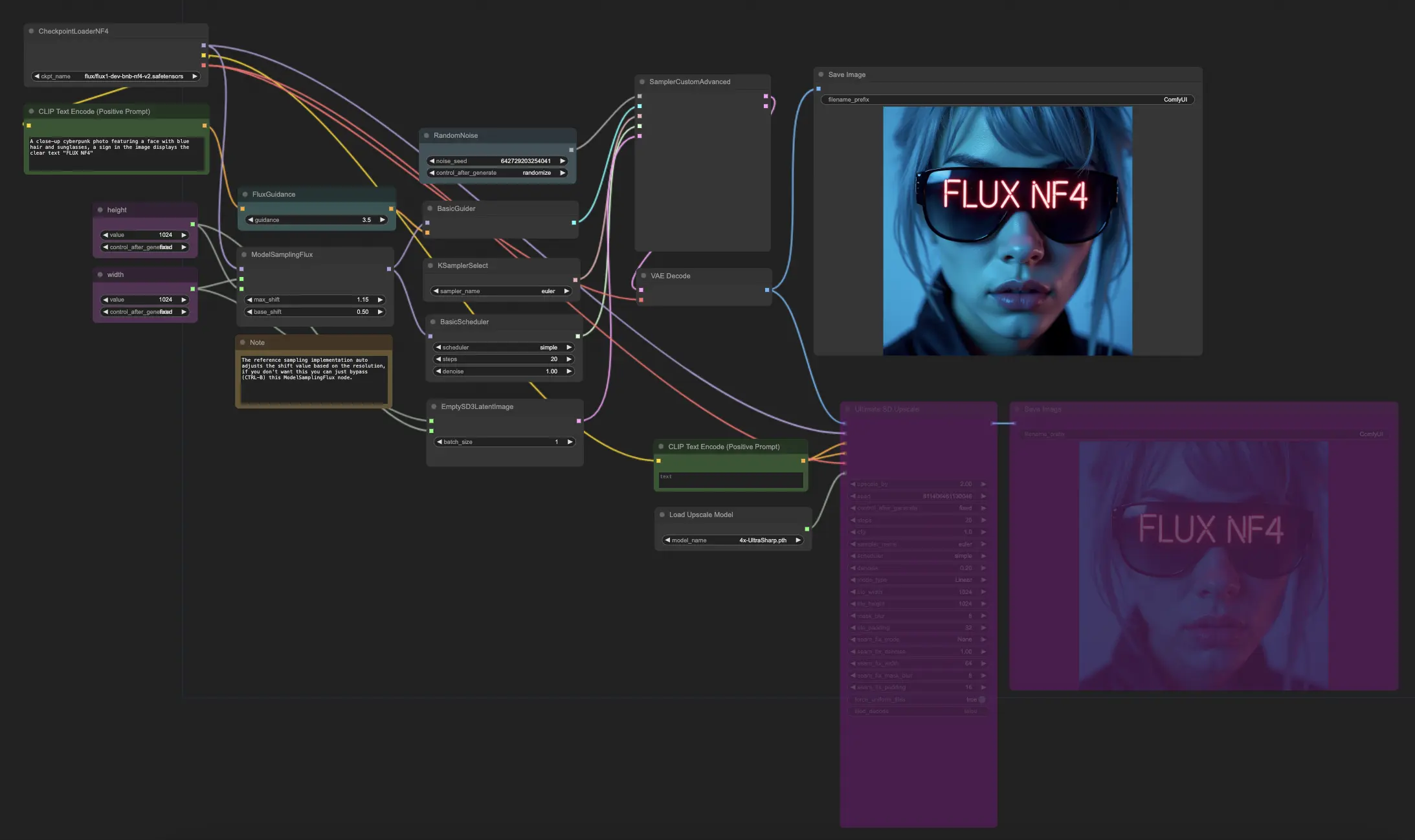

5.6. Flujo de Trabajo de ComfyUI: FLUX NF4

5.6.1. ComfyUI FLUX NF4: Descargar

5.6.2. ComfyUI FLUX NF4 Versión en Línea: ComfyUI FLUX NF4

En la Plataforma RunComfy, nuestra versión en línea precarga todos los modos y nodos necesarios para ti. Además, ofrecemos máquinas GPU de alto rendimiento, asegurando que puedas disfrutar de la experiencia ComfyUI FLUX NF4 sin esfuerzo.

5.6.3. Explicación de ComfyUI FLUX NF4:

El flujo de trabajo de ComfyUI FLUX NF4 muestra la integración de ComfyUI FLUX con la arquitectura NF4 (Normalizing Flow 4) para la generación de salidas de alta calidad. El flujo de trabajo comienza cargando los componentes necesarios usando el CheckpointLoaderNF4, que incluye el FLUX UNET, FLUX CLIP y FLUX VAE.

- UNETLoader: Carga el modelo UNET para la generación de imágenes.

- Checkpoint: TBD

Los nodos PrimitiveNode (height) y PrimitiveNode (width) especifican la altura y el ancho deseados de la salida generada. El nodo ModelSamplingFlux configura los parámetros de muestreo para ComfyUI FLUX basado en el UNET de FLUX cargado y la altura y el ancho especificados.

El nodo EmptySD3LatentImage crea una representación latente vacía como punto de partida para la generación. El nodo BasicScheduler programa los niveles de ruido (sigmas) para el proceso de generación de ComfyUI FLUX.

El nodo RandomNoise genera ruido aleatorio para el proceso de generación de ComfyUI FLUX. El nodo BasicGuider guía el proceso de generación basado en el FLUX condicionada.

El nodo KSamplerSelect selecciona el método de muestreo para la generación de ComfyUI FLUX. El nodo SamplerCustomAdvanced realiza el proceso de muestreo avanzado, tomando el ruido aleatorio generado, el guía, el muestreador seleccionado, los sigmas programados y la representación latente vacía como entradas. Produce la representación latente generada.

El nodo VAEDecode decodifica la representación latente generada en la salida final usando el VAE de FLUX cargado. El nodo SaveImage guarda la salida generada en una ubicación especificada.

Para el escalado, se utiliza el nodo UltimateSDUpscale. Toma la salida generada, el FLUX cargado, el acondicionamiento positivo y negativo para el escalado, el VAE de FLUX cargado y el escalado de FLUX cargado como entradas. El nodo CLIPTextEncode (Upscale Positive Prompt) codifica la indicación de texto positiva para el escalado. El nodo UpscaleModelLoader carga el escalado de FLUX. El nodo UltimateSDUpscale realiza el proceso de escalado y produce la representación escalada. Finalmente, el nodo SaveImage (Upscaled) guarda la salida escalada en una ubicación especificada.

Al aprovechar el poder de ComfyUI FLUX y la arquitectura NF4, el flujo de trabajo de ComfyUI FLUX NF4 permite la generación de salidas de alta calidad con fidelidad y realismo mejorados. La integración perfecta de ComfyUI FLUX con la arquitectura NF4 proporciona una herramienta poderosa para crear salidas impresionantes y cautivadoras.

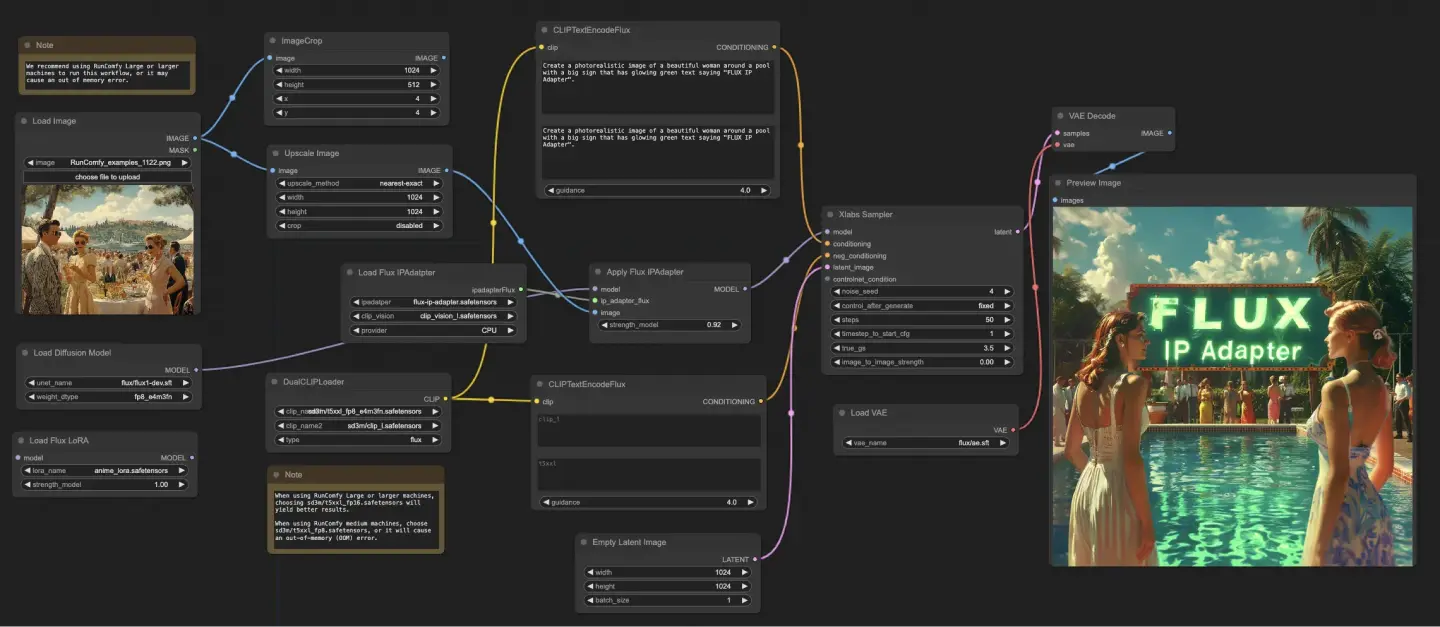

5.7. Flujo de Trabajo de ComfyUI: FLUX IPAdapter

5.7.1. ComfyUI FLUX IPAdapter: Descargar

5.7.2. ComfyUI FLUX IPAdapter Versión en Línea: ComfyUI FLUX IPAdapter

En la Plataforma RunComfy, nuestra versión en línea precarga todos los modos y nodos necesarios para ti. Además, ofrecemos máquinas GPU de alto rendimiento, asegurando que puedas disfrutar de la experiencia ComfyUI FLUX IPAdapter sin esfuerzo.

5.7.3. Explicación de ComfyUI FLUX IPAdapter:

El flujo de trabajo de ComfyUI FLUX IPAdapter comienza cargando los modelos necesarios, incluidos el modelo UNET (UNETLoader), el modelo CLIP (DualCLIPLoader) y el modelo VAE (VAELoader).

Las indicaciones de texto positivas y negativas se codifican usando el CLIPTextEncodeFlux. La codificación de texto positiva se usa para guiar el proceso de generación de ComfyUI FLUX.

La imagen de entrada se carga usando el LoadImage. El LoadFluxIPAdapter carga el IP-Adapter para el modelo FLUX, que luego se aplica al modelo UNET cargado usando el ApplyFluxIPAdapter. El ImageScale escala la imagen de entrada al tamaño deseado antes de aplicar el IP-Adapter.

- LoadFluxIPAdapter: Carga el IP-Adapter para el modelo FLUX.

- Modelo IP Adapter: flux-ip-adapter.safetensors

- Codificador de Visión CLIP: clip_vision_l.safetensors

El EmptyLatentImage crea una representación latente vacía como punto de partida para la generación de ComfyUI FLUX.

El XlabsSampler realiza el proceso de muestreo, tomando el UNET de FLUX con IP-Adapter aplicado, la codificación de texto positiva y negativa, y la representación latente vacía como entradas. Genera una representación latente.

El VAEDecode decodifica la representación latente generada en la salida final usando el VAE de FLUX cargado. El nodo PreviewImage muestra una vista previa de la salida final.

El flujo de trabajo de ComfyUI FLUX IPAdapter aprovecha el poder de ComfyUI FLUX y el IP-Adapter para generar salidas de alta calidad que se alinean con las indicaciones de texto proporcionadas. Al aplicar el IP-Adapter al UNET de FLUX, el flujo de trabajo permite la generación de salidas que capturan las características y el estilo deseados especificados en la codificación de texto.

5.8. Flujo de Trabajo de ComfyUI: Flux LoRA Trainer

5.8.1. ComfyUI FLUX LoRA Trainer: Descargar

5.8.2. Explicación de ComfyUI Flux LoRA Trainer:

El flujo de trabajo de ComfyUI FLUX LoRA Trainer consiste en múltiples etapas para entrenar un LoRA usando la arquitectura FLUX en ComfyUI.

Selección y Configuración de ComfyUI FLUX: El nodo FluxTrainModelSelect se usa para seleccionar los componentes para el entrenamiento, incluidos el UNET, VAE, CLIP y el codificador de texto CLIP. El nodo OptimizerConfig configura los ajustes del optimizador para el entrenamiento de ComfyUI FLUX, como el tipo de optimizador, la tasa de aprendizaje y la decaimiento de peso. Los nodos TrainDatasetGeneralConfig y TrainDatasetAdd se usan para configurar el conjunto de datos de entrenamiento, incluidos la resolución, los ajustes de aumento y los tamaños de lote.

Inicialización del Entrenamiento de ComfyUI FLUX: El nodo InitFluxLoRATraining inicializa el proceso de entrenamiento de LoRA usando los componentes seleccionados, la configuración del conjunto de datos y los ajustes del optimizador. El nodo FluxTrainValidationSettings configura los ajustes de validación para el entrenamiento, como el número de muestras de validación, la resolución y el tamaño de lote.

Bucle de Entrenamiento de ComfyUI FLUX: El nodo FluxTrainLoop realiza el bucle de entrenamiento para el LoRA, iterando durante un número especificado de pasos. Después de cada bucle de entrenamiento, el nodo FluxTrainValidate valida el LoRA entrenado usando los ajustes de validación y genera salidas de validación. El nodo PreviewImage muestra una vista previa de los resultados de validación. El nodo FluxTrainSave guarda el LoRA entrenado en intervalos especificados.

Visualización de Pérdida de ComfyUI FLUX: El nodo VisualizeLoss visualiza la pérdida de entrenamiento durante el curso del entrenamiento. El nodo SaveImage guarda el gráfico de pérdida para un análisis posterior.

Procesamiento de Salida de Validación de ComfyUI FLUX: Los nodos AddLabel y SomethingToString se usan para agregar etiquetas a las salidas de validación, indicando los pasos de entrenamiento. Los nodos ImageBatchMulti y ImageConcatFromBatch combinan y concatenan las salidas de validación en un solo resultado para una visualización más fácil.

Finalización del Entrenamiento de ComfyUI FLUX: El nodo FluxTrainEnd finaliza el proceso de entrenamiento de LoRA y guarda el LoRA entrenado. El nodo UploadToHuggingFace se puede usar para subir el LoRA entrenado a Hugging Face para compartir y usar más con ComfyUI FLUX.

5.9. Flujo de Trabajo de ComfyUI: Flux Latent Upscaler

5.9.1. ComfyUI Flux Latent Upscaler: Descargar

5.9.2. Explicación de ComfyUI Flux Latent Upscaler:

El flujo de trabajo de ComfyUI Flux Latent Upscale comienza cargando los componentes necesarios, incluidos el CLIP (DualCLIPLoader), UNET (UNETLoader) y VAE (VAELoader). La indicación de texto se codifica usando el nodo CLIPTextEncode, y la orientación se aplica usando el nodo FluxGuidance.

El nodo SDXLEmptyLatentSizePicker+ especifica el tamaño de la representación latente vacía, que sirve como punto de partida para el proceso de escalado en FLUX. La representación latente se procesa luego a través de una serie de pasos de escalado y recorte usando los nodos LatentUpscale y LatentCrop.

El proceso de escalado se guía por la codificación de texto y usa el nodo SamplerCustomAdvanced con el método de muestreo seleccionado (KSamplerSelect) y los niveles de ruido programados (BasicScheduler). El nodo ModelSamplingFlux configura los parámetros de muestreo.

La representación latente escalada se compone luego con la representación latente original usando el nodo LatentCompositeMasked y una máscara generada por los nodos SolidMask y FeatherMask. El ruido se inyecta en la representación latente escalada usando el nodo InjectLatentNoise+.

Finalmente, la representación latente escalada se decodifica en la salida final usando el nodo VAEDecode, y se aplica un afilado inteligente usando el nodo ImageSmartSharpen+. El nodo PreviewImage muestra una vista previa de la salida final generada por ComfyUI FLUX.

El flujo de trabajo de ComfyUI FLUX Latent Upscaler también incluye varias operaciones matemáticas usando los nodos SimpleMath+, SimpleMathFloat+, SimpleMathInt+ y SimpleMathPercent+ para calcular dimensiones, proporciones y otros parámetros para el proceso de escalado.

RunComfy es la principal ComfyUI plataforma, ofreciendo ComfyUI en línea entorno y servicios, junto con flujos de trabajo de ComfyUI con impresionantes imágenes. RunComfy también ofrece AI Models, permitiendo a los artistas aprovechar las últimas herramientas de AI para crear arte increíble.