Plongée dans ComfyUI ControlNet : avec Depth, OpenPose, Canny, Lineart, Softedge, Scribble, Seg...

Updated: 5/17/2024

Salut ! Dans ce guide, nous allons plonger dans le monde passionnant de ControlNet dans ComfyUI. Explorons ensemble ce qu'il apporte et comment il peut pimenter vos projets !

Nous aborderons :

1. Qu'est-ce que ControlNet ?

2. Les aspects techniques derrière ControlNet

3. Comment utiliser ComfyUI ControlNet : les étapes de base

- 3.1. Charger le nœud "Apply ControlNet" dans ComfyUI

- 3.2. Entrées du nœud "Apply ControlNet"

- 3.3. Sorties du nœud "Apply ControlNet"

- 3.4. Paramètres pour affiner "Apply ControlNet"

4. Comment utiliser ComfyUI ControlNet : Fonctionnalités avancées - Timestep Keyframes

5. Aperçu détaillé des différents modèles ControlNet/T2IAdaptor

- 5.1. ControlNet Openpose

- 5.2. ControlNet Tile

- 5.3. ControlNet Canny

- 5.4. ControlNet Depth

- 5.5. ControlNet Lineart

- 5.6. ControlNet Scribbles

- 5.7. ControlNet Segmentation

- 5.8. ControlNet Shuffle

- 5.9. ControlNet Inpainting

- 5.10. ControlNet MLSD

- 5.11. ControlNet Normalmaps

- 5.12. ControlNet Soft Edge

- 5.13. ControlNet IP2P (Instruct Pix2Pix)

- 5.14. T2I Adapter

- 5.15. Autres ControlNet populaires : QRCode Monster et IP-Adapter

6. Comment utiliser plusieurs ControlNets

7. Expérimentez ComfyUI ControlNet dès maintenant !

🌟🌟🌟 ComfyUI en ligne - Expérimentez le workflow ControlNet maintenant 🌟🌟🌟

Si vous souhaitez explorer le workflow ControlNet, utilisez le ComfyUI web suivant. Il est entièrement équipé de tous les nœuds et modèles client essentiels, permettant une créativité transparente sans nécessiter de configurations manuelles. Commencez à acquérir une expérience pratique en expérimentant immédiatement les fonctionnalités de ControlNet, ou poursuivez ce tutoriel pour apprendre à utiliser efficacement ControlNet.

Pour des workflows ComfyUI plus avancés et premium, visitez notre 🌟Liste des workflows ComfyUI🌟

1. Qu'est-ce que ControlNet ?

ControlNet est une technologie transformatrice qui améliore considérablement les capacités des modèles de diffusion texte-image, permettant un contrôle spatial sans précédent de la génération d'images. En tant qu'architecture de réseau neuronal, ControlNet s'intègre parfaitement aux modèles pré-entraînés à grande échelle tels que Stable Diffusion. Il exploite la vaste formation de ces modèles, construits sur des milliards d'images, pour introduire des conditions spatiales dans le processus de création d'images. Ces conditions peuvent aller des contours et des poses humaines aux cartes de profondeur et de segmentation, permettant aux utilisateurs de guider la génération d'images d'une manière qui n'était pas possible auparavant avec les prompts textuels seuls.

2. Les aspects techniques derrière ControlNet

Le génie de ControlNet réside dans sa méthodologie distinctive. Initialement, il sécurise les paramètres du modèle original, en s'assurant que la formation de base reste inchangée. Ensuite, ControlNet introduit un clone des couches d'encodage du modèle pour l'entraînement, en utilisant des "convolutions zéro". Ces couches convolutives spécialement conçues commencent avec des poids nuls, intégrant soigneusement de nouvelles conditions spatiales. Cette approche empêche toute perturbation bruyante d'intervenir, préservant la compétence originale du modèle tout en initiant de nouvelles trajectoires d'apprentissage.

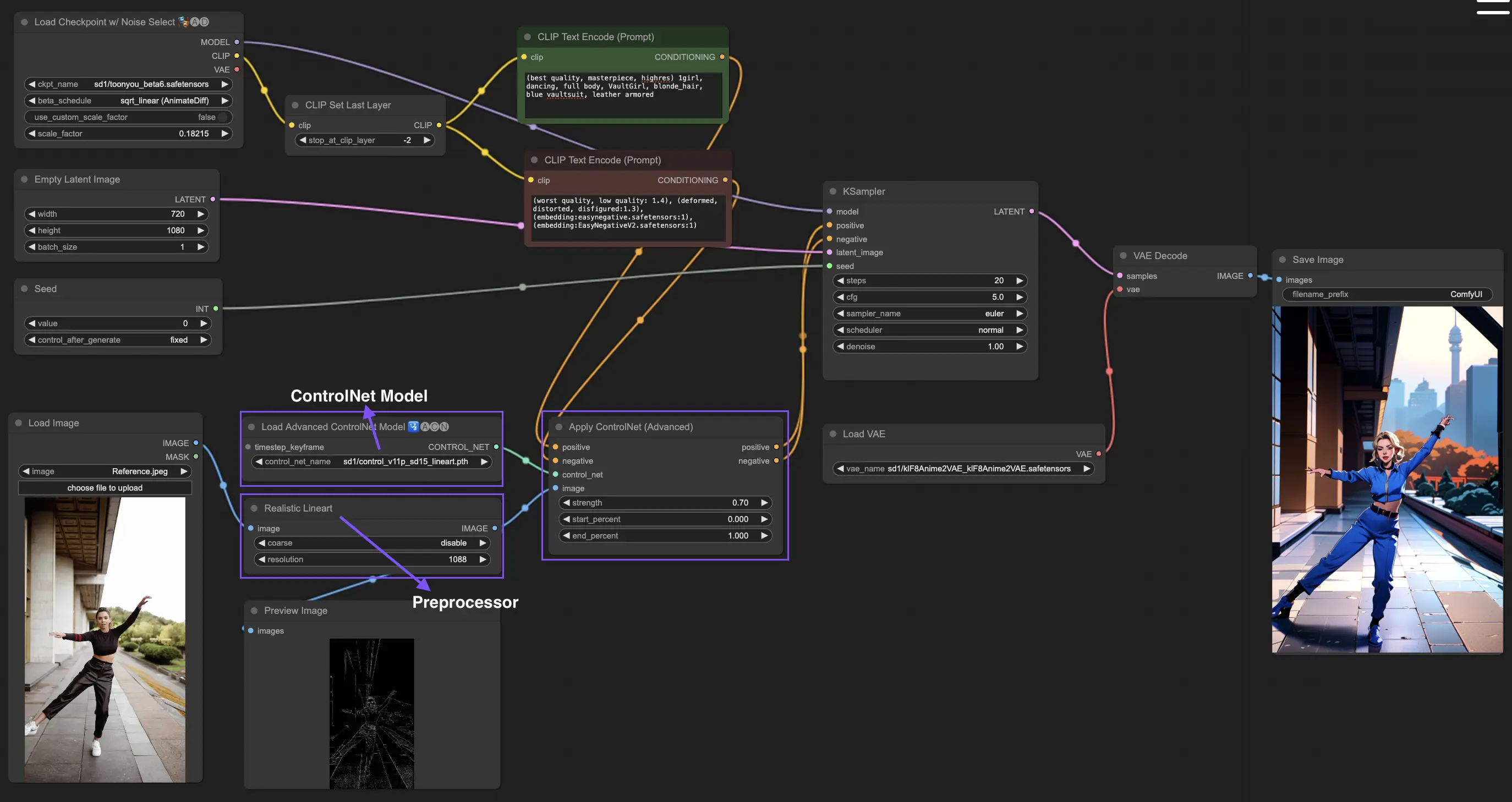

3. Comment utiliser ComfyUI ControlNet : les étapes de base

Traditionnellement, les modèles de diffusion stable utilisent des prompts textuels comme mécanisme de conditionnement pour guider la génération d'images, alignant la sortie avec les spécificités du prompt textuel. ControlNet introduit une forme supplémentaire de conditionnement à ce processus, améliorant la capacité à diriger l'imagerie générée plus précisément en fonction des entrées textuelles et visuelles.

3.1. Charger le nœud "Apply ControlNet" dans ComfyUI

Cette étape intègre ControlNet dans votre workflow ComfyUI, permettant d'appliquer un conditionnement supplémentaire à votre processus de génération d'images. Elle jette les bases de l'application d'un guidage visuel parallèlement aux prompts textuels.

3.2. Entrées du nœud "Apply ControlNet"

Conditionnement positif et négatif : Ces entrées sont cruciales pour définir les résultats souhaités et les aspects à éviter dans l'image générée. Elles doivent être liées respectivement à "Positive prompt" et "Negative prompt", s'alignant sur la partie conditionnement textuel du processus.

Modèle ControlNet : Cette entrée doit être connectée à la sortie du nœud "Load ControlNet Model". Cette étape est essentielle pour sélectionner et incorporer un modèle ControlNet ou T2IAdaptor dans votre workflow, garantissant ainsi que le modèle de diffusion bénéficie du guidage spécifique fourni par votre modèle choisi. Chaque modèle, qu'il s'agisse d'un ControlNet ou d'un T2IAdaptor, est rigoureusement entraîné pour influencer le processus de génération d'images en fonction de certains types de données ou de préférences stylistiques. Étant donné que les fonctionnalités de nombreux modèles T2IAdaptor s'alignent étroitement avec celles des modèles ControlNet, notre attention portera principalement sur les modèles ControlNet dans la suite de notre discussion. Cependant, nous mettrons également en évidence certains des T2IAdaptors les plus populaires par souci d'exhaustivité.

Préprocesseur : L'entrée "image" doit être connectée à un nœud "ControlNet Preprocessor", ce qui est crucial pour adapter votre image afin qu'elle réponde aux exigences spécifiques du modèle ControlNet que vous utilisez. Il est impératif d'utiliser le préprocesseur correct adapté à votre modèle ControlNet sélectionné. Cette étape garantit que l'image d'origine subit les modifications nécessaires, telles que des ajustements de format, de taille, de couleur ou l'application de filtres spécifiques, pour l'optimiser selon les directives de ControlNet. Après cette phase de prétraitement, l'image d'origine est remplacée par la version modifiée, que ControlNet utilise ensuite. Ce processus garantit que vos images d'entrée sont précisément préparées pour le processus ControlNet.

3.3. Sorties du nœud "Apply ControlNet"

Le nœud "Apply ControlNet" génère deux sorties cruciales : Conditionnement positif et négatif. Ces sorties, imprégnées des effets nuancés de ControlNet et du guidage visuel, jouent un rôle central dans le pilotage du comportement du modèle de diffusion dans ComfyUI. Ensuite, vous avez le choix : soit passer au KSampler pour la phase d'échantillonnage afin de peaufiner davantage l'image générée, soit, pour ceux qui recherchent un niveau de détail et de personnalisation encore plus élevé dans leur création, continuer à superposer des ControlNets supplémentaires. Cette technique avancée d'intégration de plusieurs ControlNets permet une manipulation plus granulaire des attributs de l'image, offrant une boîte à outils améliorée aux créateurs visant à atteindre une précision et un contrôle inégalés dans leurs sorties visuelles.

3.4. Paramètres pour affiner "Apply ControlNet"

strength : Ce paramètre détermine l'intensité de l'effet de ControlNet sur l'image générée dans ComfyUI. Une valeur de 1,0 implique une force maximale, ce qui signifie que le guidage de ControlNet aura une influence maximale sur la sortie du modèle de diffusion. Inversement, une valeur de 0,0 indique aucune influence, désactivant essentiellement l'effet de ControlNet sur le processus de génération d'images.

start_percent : Ce paramètre spécifie le point de départ, en pourcentage du processus de diffusion, où ControlNet commence à influencer la génération. Par exemple, définir un pourcentage de départ de 20 % signifie que le guidage de ControlNet commencera à affecter la génération d'images à partir de la marque des 20 % du processus de diffusion.

end_percent : Analogue au "Start Percent", le paramètre "End Percent" définit le point auquel l'influence de ControlNet cesse. Par exemple, un pourcentage de fin de 80 % signifierait que le guidage de ControlNet cesse d'influencer la génération d'images à la marque de 80 % d'achèvement du processus de diffusion, laissant les phases finales non affectées.

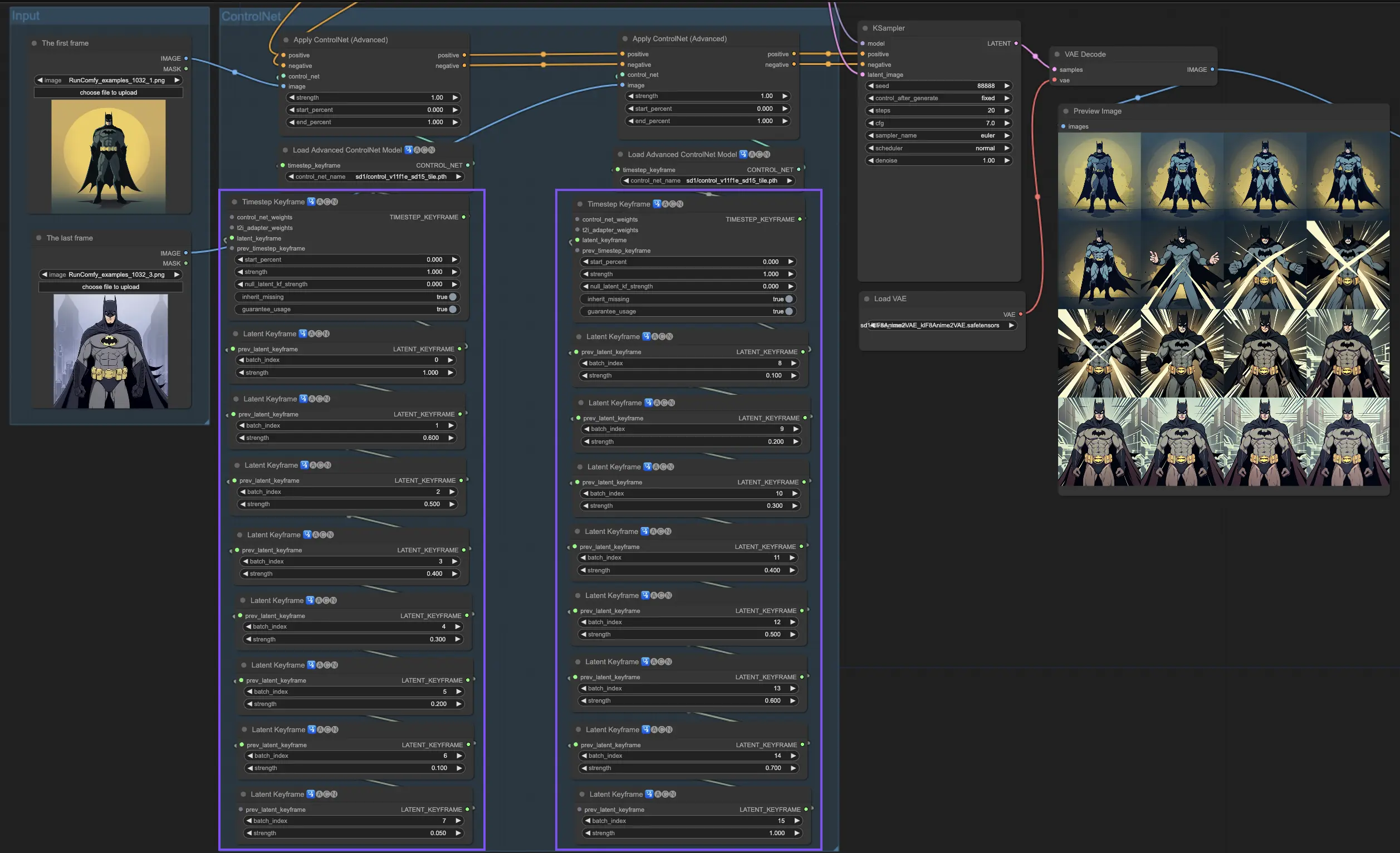

4. Comment utiliser ComfyUI ControlNet : Fonctionnalités avancées - Timestep Keyframes

Les Timestep Keyframes dans ControlNet offrent un contrôle sophistiqué sur le comportement du contenu généré par l'IA, en particulier lorsque le timing et la progression sont cruciaux, comme dans les animations ou les visuels évolutifs. Voici une ventilation détaillée des paramètres clés pour vous aider à les utiliser efficacement et intuitivement :

prev_timestep_kf : Considérez prev_timestep_kf comme un lien entre les keyframes qui se succèdent dans une séquence. En connectant les keyframes, vous créez une transition fluide ou un storyboard qui guide l'IA à travers le processus de génération, étape par étape, en veillant à ce que chaque phase s'enchaîne logiquement avec la suivante.

cn_weights : cn_weights sont utiles pour affiner la sortie en ajustant des caractéristiques spécifiques au sein de ControlNet pendant différentes phases du processus de génération.

latent_keyframe : latent_keyframe vous permet d'ajuster la force avec laquelle chaque partie du modèle d'IA influence le résultat final pendant une phase particulière du processus de génération. Par exemple, si vous générez une image où le premier plan doit devenir plus détaillé à mesure que le processus évolue, vous pouvez augmenter la force des aspects (latents) du modèle responsables des détails du premier plan dans les keyframes ultérieurs. Inversement, si certaines caractéristiques doivent s'estomper à l'arrière-plan au fil du temps, vous pouvez réduire leur force dans les keyframes suivants. Ce niveau de contrôle est particulièrement utile pour créer des visuels dynamiques et évolutifs ou dans des projets où le timing et la progression précis sont cruciaux.

mask_optional : Utilisez des masques d'attention comme des projecteurs, en concentrant l'influence de ControlNet sur des zones spécifiques de votre image. Qu'il s'agisse de mettre en évidence un personnage dans une scène ou d'accentuer un élément d'arrière-plan, ces masques peuvent s'appliquer uniformément ou varier en intensité, en dirigeant précisément l'attention de l'IA là où vous le souhaitez.

start_percent : start_percent marque le moment où votre keyframe entre en jeu, mesuré en pourcentage du processus de génération global. Le définir revient à programmer l'entrée en scène d'un acteur, en s'assurant qu'il apparaisse au bon moment dans la performance.

strength : strength offre un contrôle de haut niveau sur l'influence globale de ControlNet.

null_latent_kf_strength : Pour tous les acteurs (latents) que vous n'avez pas explicitement dirigés dans cette scène (keyframe), null_latent_kf_strength agit comme une instruction par défaut, leur indiquant comment se comporter en arrière-plan. Il garantit qu'aucune partie de la génération n'est laissée sans orientation, maintenant une sortiecohérente même dans les zones que vous n'avez pas spécifiquement abordées.

inherit_missing : L'activation d'inherit_missing permet à votre keyframe actuel d'adopter tous les paramètres non spécifiés de son prédécesseur, comme un jeune frère ou une jeune sœur héritant de vêtements. C'est un raccourci utile qui assure la continuité et la cohérence sans avoir besoin de répéter les instructions.

guarantee_usage : guarantee_usage est votre garantie que, quoi qu'il arrive, le keyframe actuel aura son moment de gloire dans le processus, même si ce n'est que pour un bref instant. Il garantit que chaque keyframe que vous avez mis en place a un impact, honorant votre planification détaillée pour guider le processus créatif de l'IA.

Les Timestep Keyframes offrent la précision nécessaire pour guider méticuleusement le processus créatif de l'IA, vous permettant de façonner le récit ou le voyage visuel exactement comme vous l'imaginez. Ils servent d'outil puissant pour orchestrer l'évolution des visuels, en particulier dans l'animation, de la scène d'ouverture jusqu'à la conclusion. Voici un aperçu plus détaillé de la façon dont les Timestep Keyframes peuvent être appliqués stratégiquement pour gérer la progression d'une animation, en assurant une transition fluide de l'image initiale à l'image finale, en parfaite adéquation avec vos objectifs artistiques.

5. Aperçu détaillé des différents modèles ControlNet/T2IAdaptor

Étant donné que les fonctionnalités de nombreux modèles T2IAdaptor s'alignent étroitement avec celles des modèles ControlNet, notre attention portera principalement sur les modèles ControlNet dans la suite de notre discussion. Cependant, nous mettrons également en évidence certains des T2IAdaptors les plus populaires par souci d'exhaustivité.

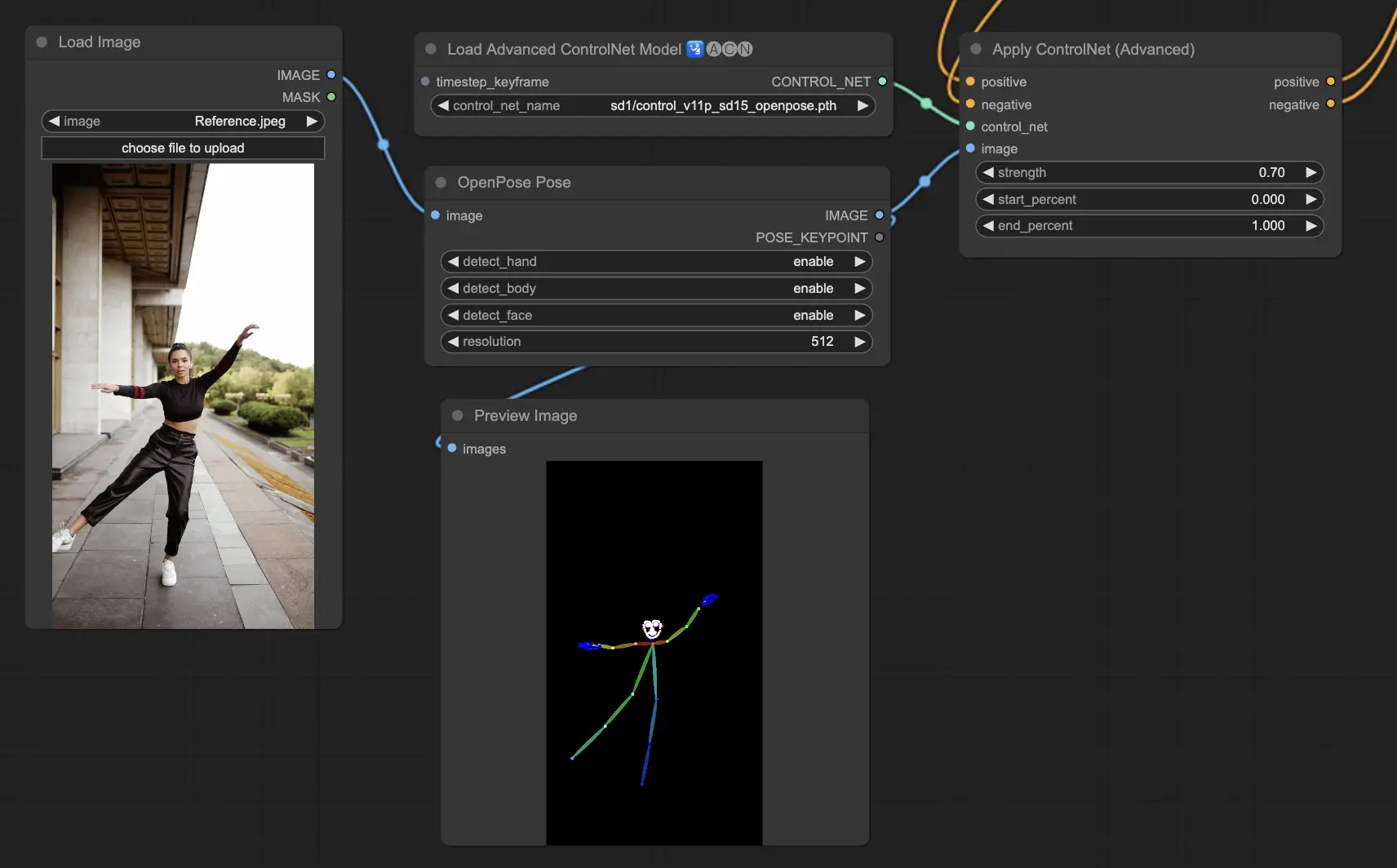

5.1. ComfyUI ControlNet Openpose

- Openpose (=Openpose body) : Le modèle fondamental de ControlNet qui identifie les points-clés de base du corps tels que les yeux, le nez, le cou, les épaules, les coudes, les poignets, les genoux et les chevilles. Il est idéal pour la réplication de base des poses humaines.

- Openpose_face : Étend le modèle OpenPose en ajoutant la détection des points-clés du visage, offrant une analyse plus détaillée des expressions faciales et de l'orientation. Ce modèle ControlNet est essentiel pour les projets axés sur les expressions faciales.

- Openpose_hand : Augmente le modèle OpenPose avec la capacité de capturer les détails complexes des mains et des doigts, en se concentrant sur les gestes et positions détaillés des mains. Cet ajout améliore la polyvalence d'OpenPose dans ControlNet.

- Openpose_faceonly : Un modèle spécialisé uniquement pour les détails du visage, omettant les points-clés du corps pour se concentrer sur la capture des expressions et des orientations faciales. Ce modèle dans ControlNet se concentre exclusivement sur les caractéristiques faciales.

- Openpose_full : Un amalgame complet des modèles OpenPose, OpenPose_face et OpenPose_hand, offrant une détection complète du corps entier, du visage et des mains pour une réplication totale de la pose humaine dans ControlNet.

- DW_Openpose_full : Une version améliorée du modèle OpenPose_full, intégrant des améliorations supplémentaires pour une détection de pose encore plus détaillée et précise. Cette version représente le summum de la précision de détection de pose dans le cadre de ControlNet.

Préprocesseur : Openpose ou DWpose

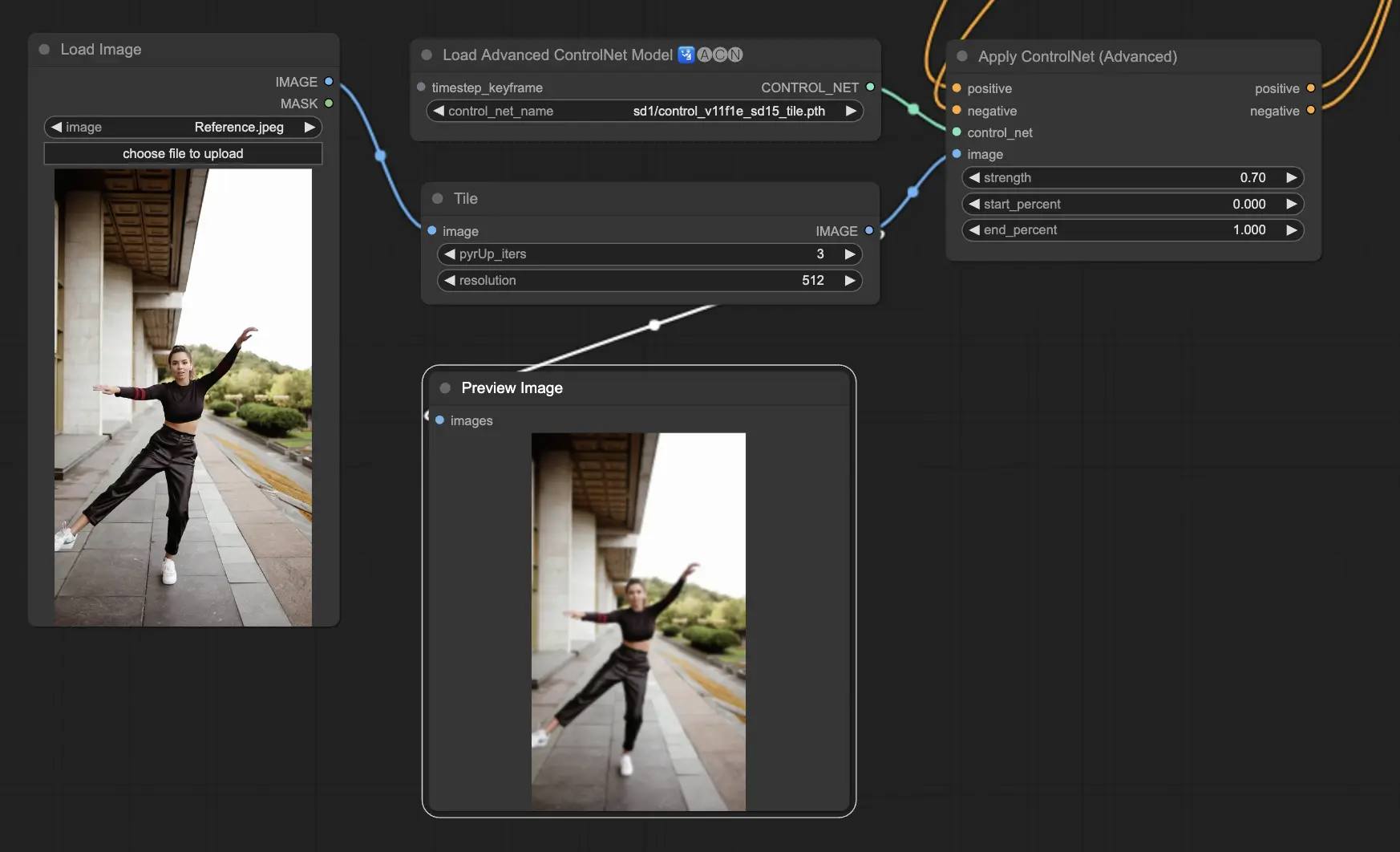

5.2. ComfyUI ControlNet Tile

Le modèle Tile Resample est utilisé pour l'amélioration des détails dans les images. Il est particulièrement utile en conjonction avec un upscaler pour améliorer la résolution de l'image tout en ajoutant des détails plus fins, souvent utilisé pour affiner et enrichir les textures et les éléments dans une image.

Préprocesseur : Tile

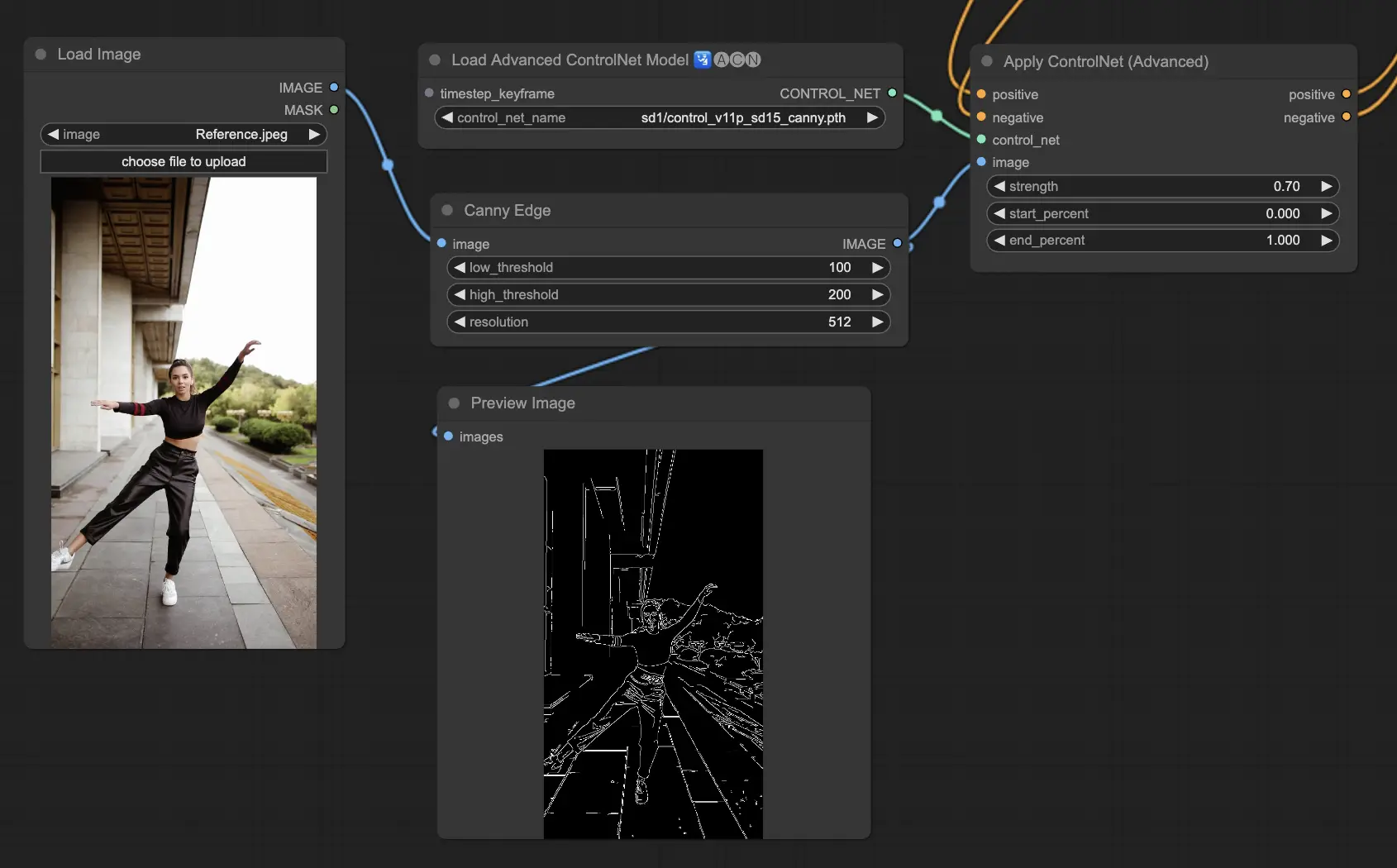

5.3. ComfyUI ControlNet Canny

Le modèle Canny applique l'algorithme de détection de contours de Canny, un processus en plusieurs étapes pour détecter une large gamme de contours dans les images. Ce modèle est bénéfique pour préserver les aspects structurels d'une image tout en simplifiant sa composition visuelle, ce qui le rend utile pour l'art stylisé ou le prétraitement avant une manipulation d'image plus poussée.

Préprocesseurs : Canny

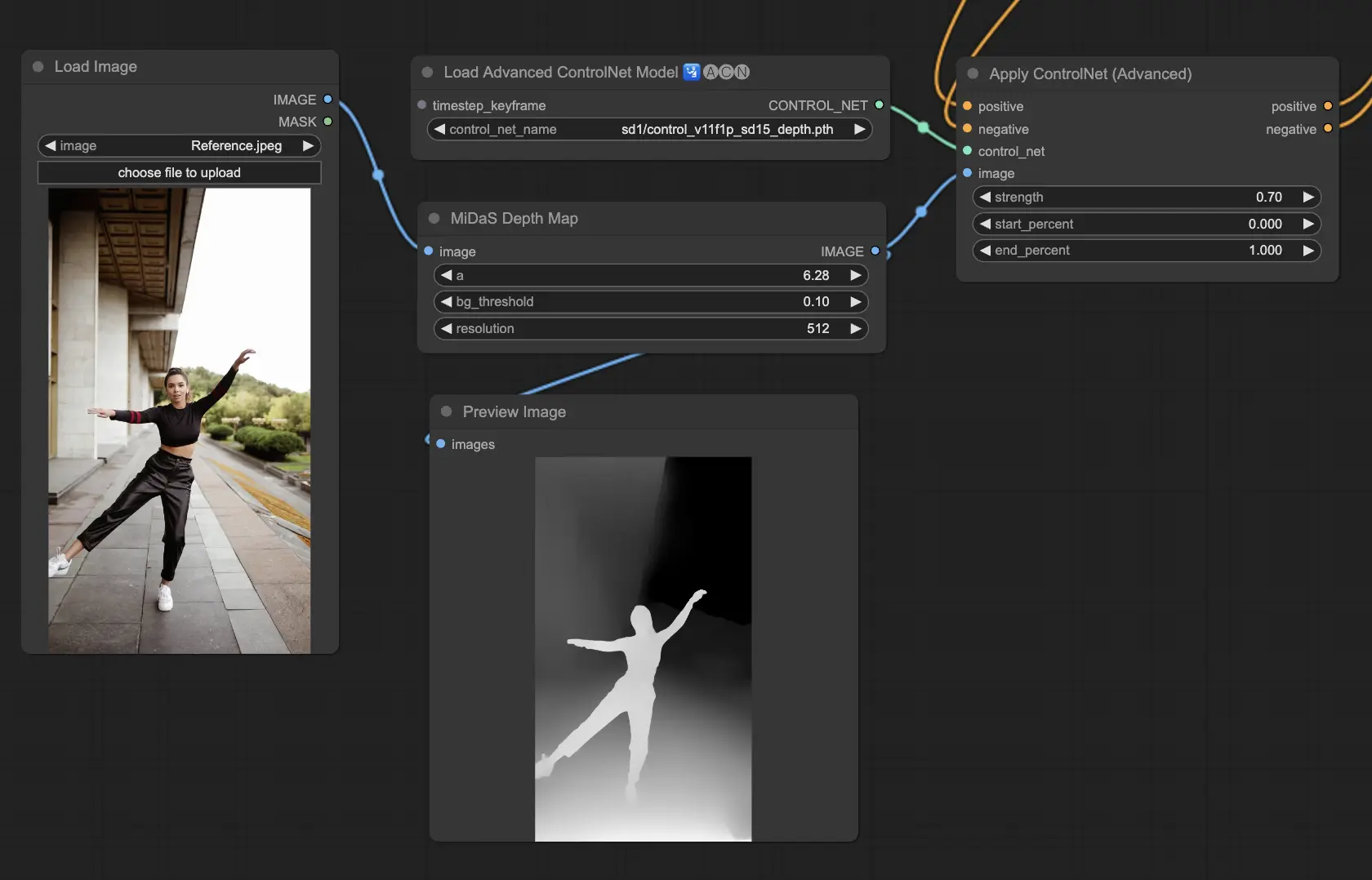

5.4. ComfyUI ControlNet Depth

Les modèles Depth déduisent les informations de profondeur à partir d'une image 2D, traduisant la distance perçue en une carte de profondeur en niveaux de gris. Chaque variante offre un équilibre différent entre la capture des détails et l'accent mis sur l'arrière-plan :

- Depth Midas : Fournit une estimation classique de la profondeur, équilibrant le rendu des détails et de l'arrière-plan.

- Depth Leres : Se concentre sur l'amélioration des détails avec une tendance à inclure plus d'éléments d'arrière-plan.

- Depth Leres++ : Offre un niveau avancé de détail pour les informations de profondeur, idéal pour les scènes complexes.

- Zoe : Établit un équilibre entre les modèles Midas et Leres en termes de niveau de détail.

- Depth Anything : Un modèle plus récent et amélioré pour l'estimation de la profondeur, conçu pour une large gamme de scènes.

- Depth Hand Refiner : Spécialement conçu pour améliorer les détails des mains dans les cartes de profondeur, utile pour les scènes où le positionnement des mains est essentiel.

Préprocesseurs : Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Ce modèle est très robuste et peut fonctionner sur des cartes de profondeur réelles provenant de moteurs de rendu.

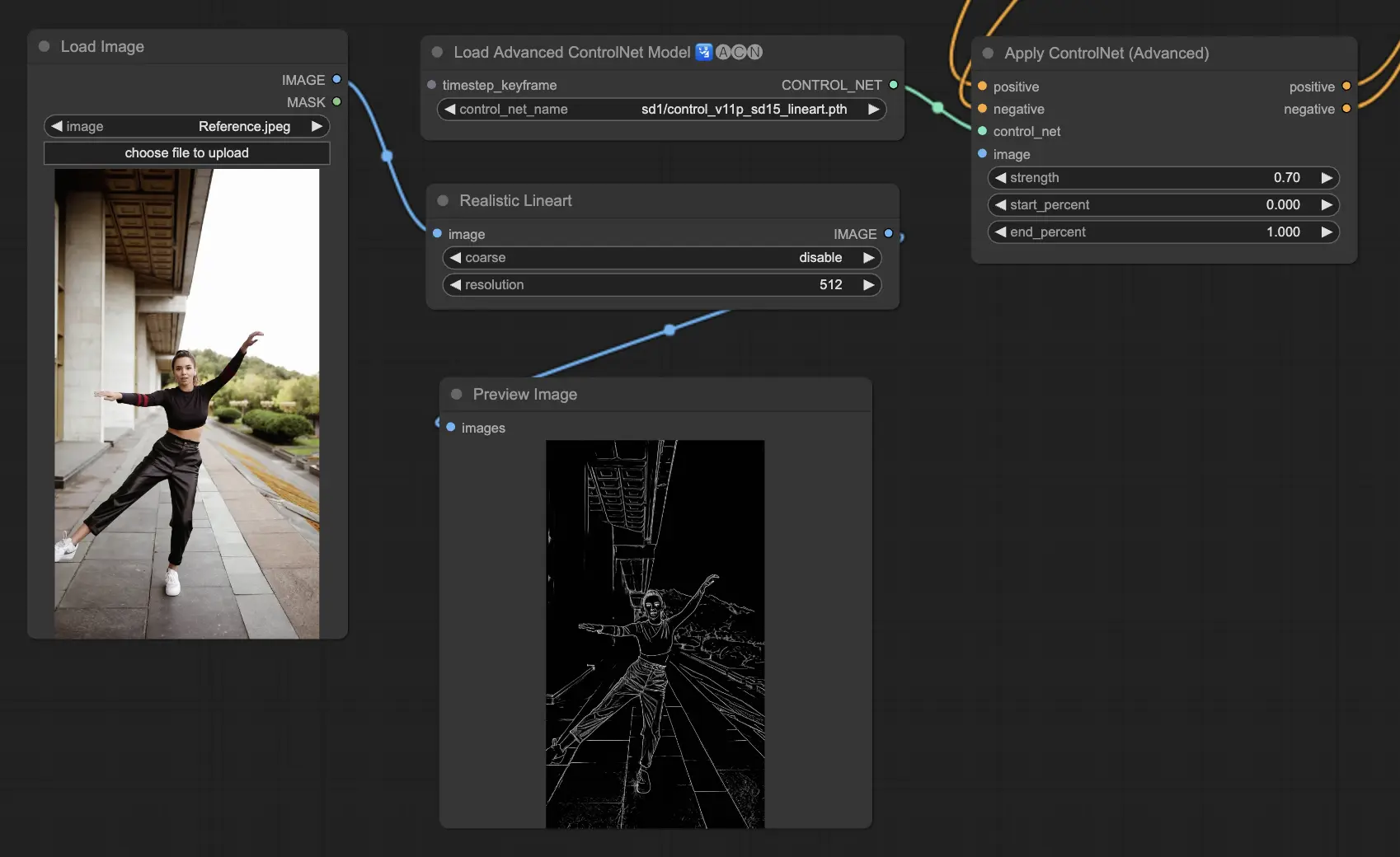

5.5. ComfyUI ControlNet Lineart

Les modèles Lineart convertissent les images en dessins au trait stylisés, utiles pour les rendus artistiques ou comme base pour un travail créatif ultérieur :

- Lineart : Ce modèle standard convertit les images en dessins au trait stylisés, offrant une base polyvalente pour divers projets artistiques ou créatifs.

- Lineart anime : Se concentre sur la génération de dessins au trait de style anime, caractérisés par des traits propres et précis, ce qui le rend adapté aux projets visant une esthétique anime.

- Lineart realistic : Produit des dessins au trait avec une touche plus réaliste, capturant l'essence du sujet avec plus de détails, parfait pour les projets nécessitant une représentation réaliste.

- Lineart coarse : Fournit un dessin au trait plus prononcé avec des traits plus épais et plus audacieux, créant un effet saisissant qui se démarque, particulièrement adapté aux expressions artistiques audacieuses.

Le préprocesseur peut générer des dessins au trait détaillés ou grossiers à partir d'images (Lineart et Lineart_Coarse)

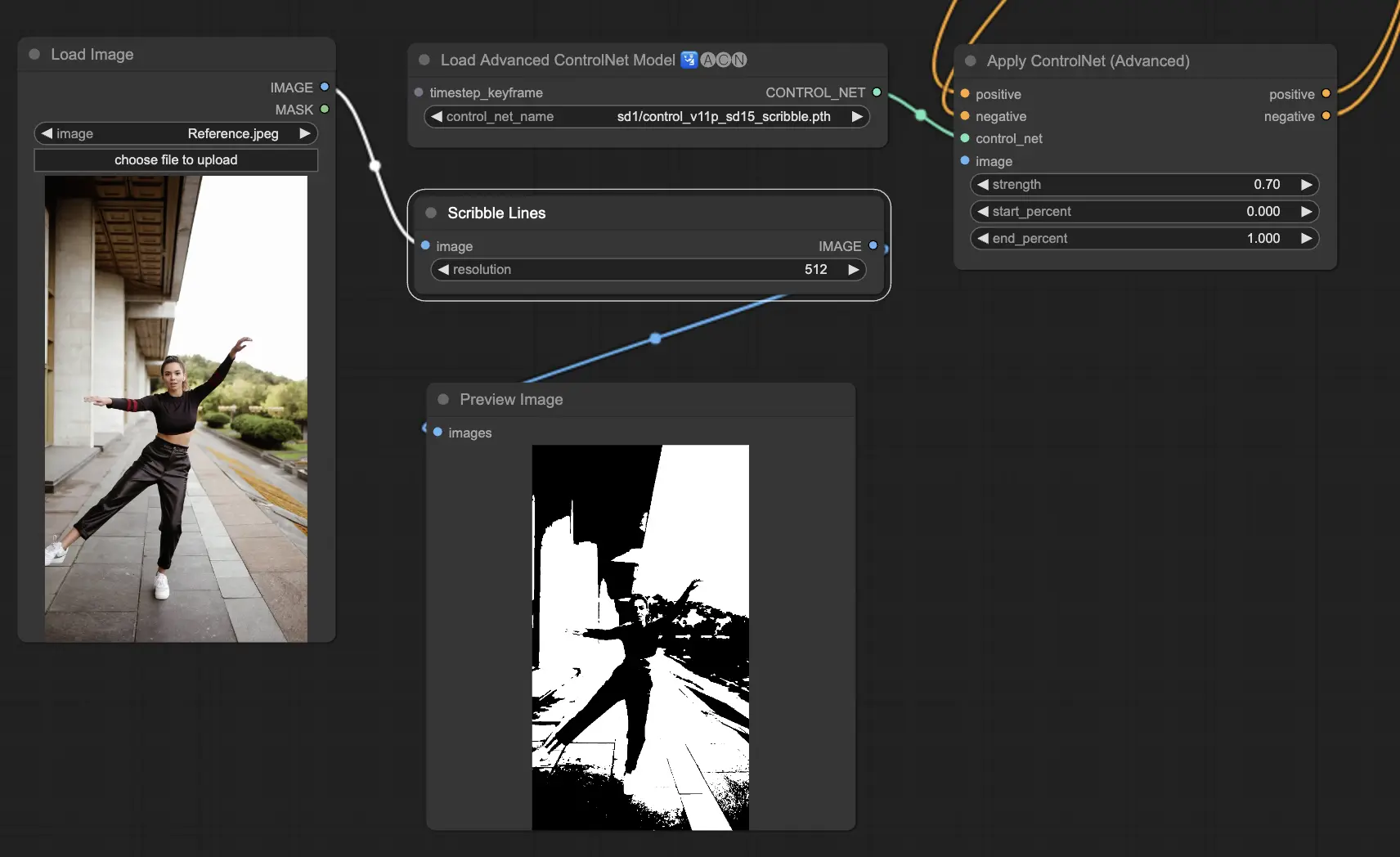

5.6. ComfyUI ControlNet Scribbles

Les modèles Scribble sont conçus pour transformer les images en une apparence de croquis, simulant l'aspect de dessins à la main. Ils sont particulièrement utiles pour le restyling artistique ou comme étape préliminaire dans un flux de travail de conception plus large :

- Scribble : Conçu pour convertir les images en œuvres d'art détaillées qui simulent des croquis ou des esquisses dessinés à la main.

- Scribble HED : Utilise la détection de contours Holistically-Nested Edge Detection (HED) pour créer des contours qui ressemblent à des croquis dessinés à la main. Il est recommandé pour la recoloration et le restyling des images, ajoutant une touche artistique unique à l'œuvre.

- Scribble Pidinet : Se concentre sur la détection des différences de pixels pour produire des lignes plus nettes avec moins de détails, ce qui le rend idéal pour des représentations plus claires et plus abstraites. Scribble Pidinet est parfait pour ceux qui recherchent des courbes nettes et des bords droits, offrant un aspect poli tout en préservant les détails essentiels.

- Scribble xdog : Emploie la méthode Extended Difference of Gaussian (xDoG) pour la détection des contours. Cela permet d'ajuster les paramètres de seuil pour affiner l'effet de croquis, ce qui permet de contrôler le niveau de détail dans votre œuvre. xDoG est polyvalent, permettant aux utilisateurs de trouver l'équilibre parfait dans leurs créations artistiques.

Préprocesseurs : Scribble, Scribble_HED, Scribble_PIDI et Scribble_XDOG

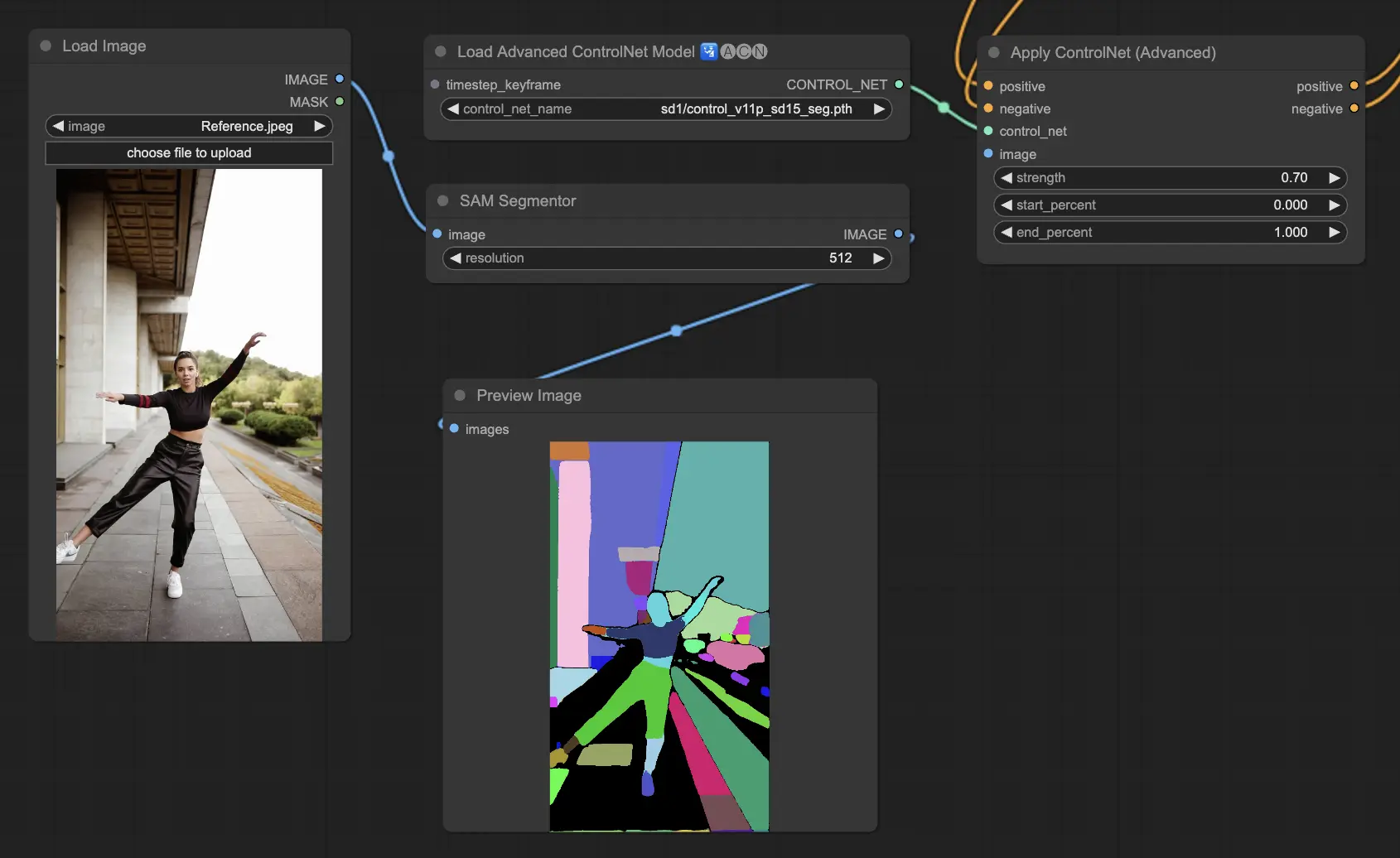

5.7. ComfyUI ControlNet Segmentation

Les modèles de segmentation catégorisent les pixels de l'image en classes d'objets distinctes, chacune représentée par une couleur spécifique. Ceci est inestimable pour identifier et manipuler des éléments individuels dans une image, comme séparer le premier plan de l'arrière-plan ou différencier les objets pour une édition détaillée.

- Seg : Conçu pour différencier les objets dans une image par couleur, traduisant efficacement ces distinctions en éléments distincts dans la sortie. Par exemple, il peut séparer les meubles dans un agencement de pièce, ce qui est particulièrement précieux pour les projets nécessitant un contrôle précis de la composition et de l'édition de l'image.

- ufade20k : Utilise le modèle de segmentation UniFormer entraîné sur l'ensemble de données ADE20K, capable de distinguer un large éventail de types d'objets avec une grande précision.

- ofade20k : Emploie le modèle de segmentation OneFormer, également entraîné sur ADE20K, offrant une approche alternative de la différenciation des objets avec ses capacités de segmentation uniques.

- ofcoco : Tire parti de la segmentation OneFormer entraînée sur l'ensemble de données COCO, adaptée aux images avec des objets catégorisés dans les paramètres de l'ensemble de données COCO, facilitant une identification et une manipulation précises des objets.

Préprocesseurs acceptables : Sam, Seg_OFADE20K (Oneformer ADE20K), Seg_UFADE20K (Uniformer ADE20K), Seg_OFCOCO (Oneformer COCO), ou masques créés manuellement.

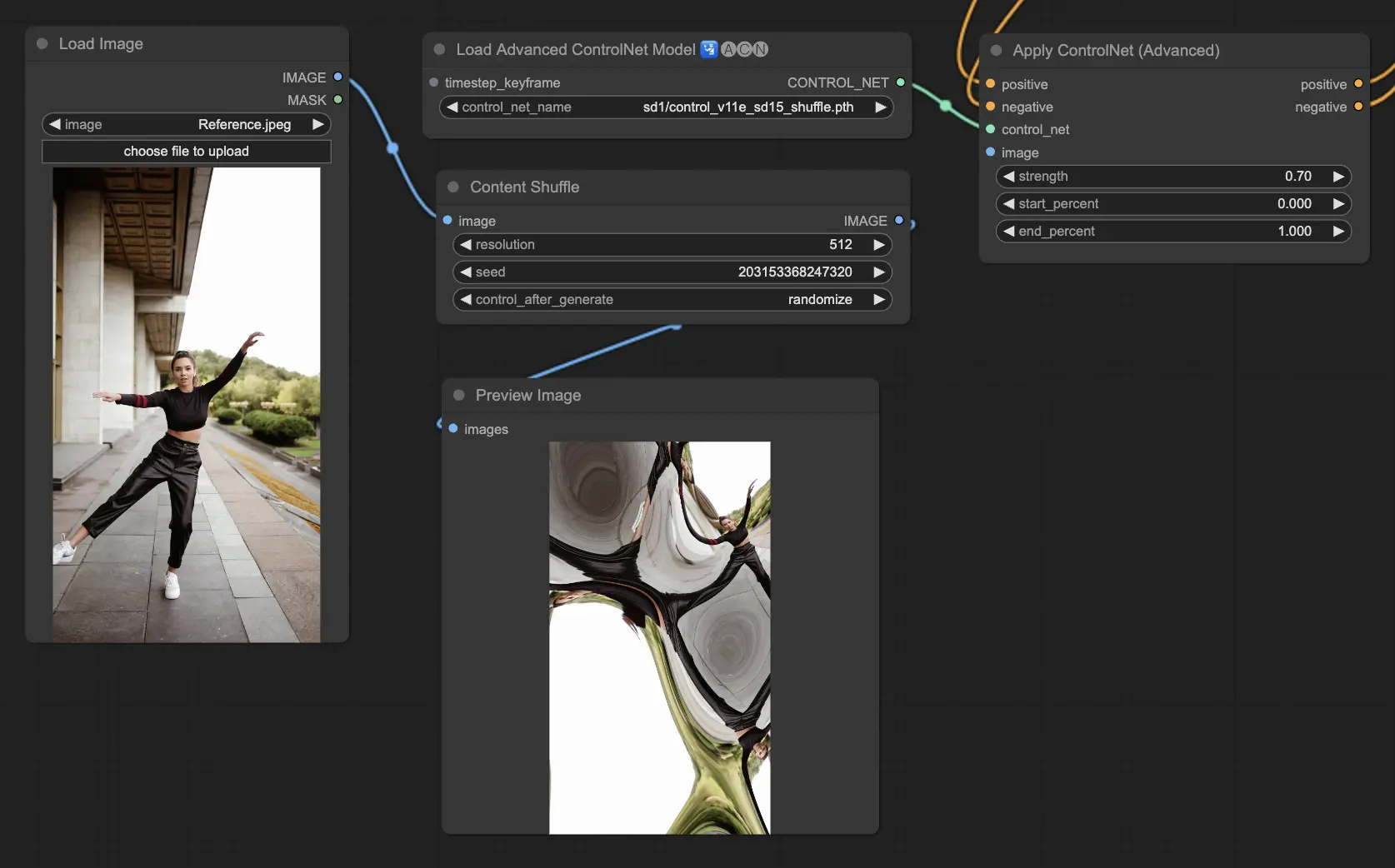

5.8. ComfyUI ControlNet Shuffle

Le modèle Shuffle introduit une nouvelle approche en randomisant les attributs de l'image d'entrée, tels que les schémas de couleurs ou les textures, sans altérer la composition. Ce modèle est particulièrement efficace pour les explorations créatives et la génération de variations d'une image avec une intégrité structurelle conservée mais une esthétique visuelle modifiée. Sa nature aléatoire signifie que chaque sortie est unique, influencée par la valeur de la graine utilisée dans le processus de génération.

Préprocesseurs : Shuffle

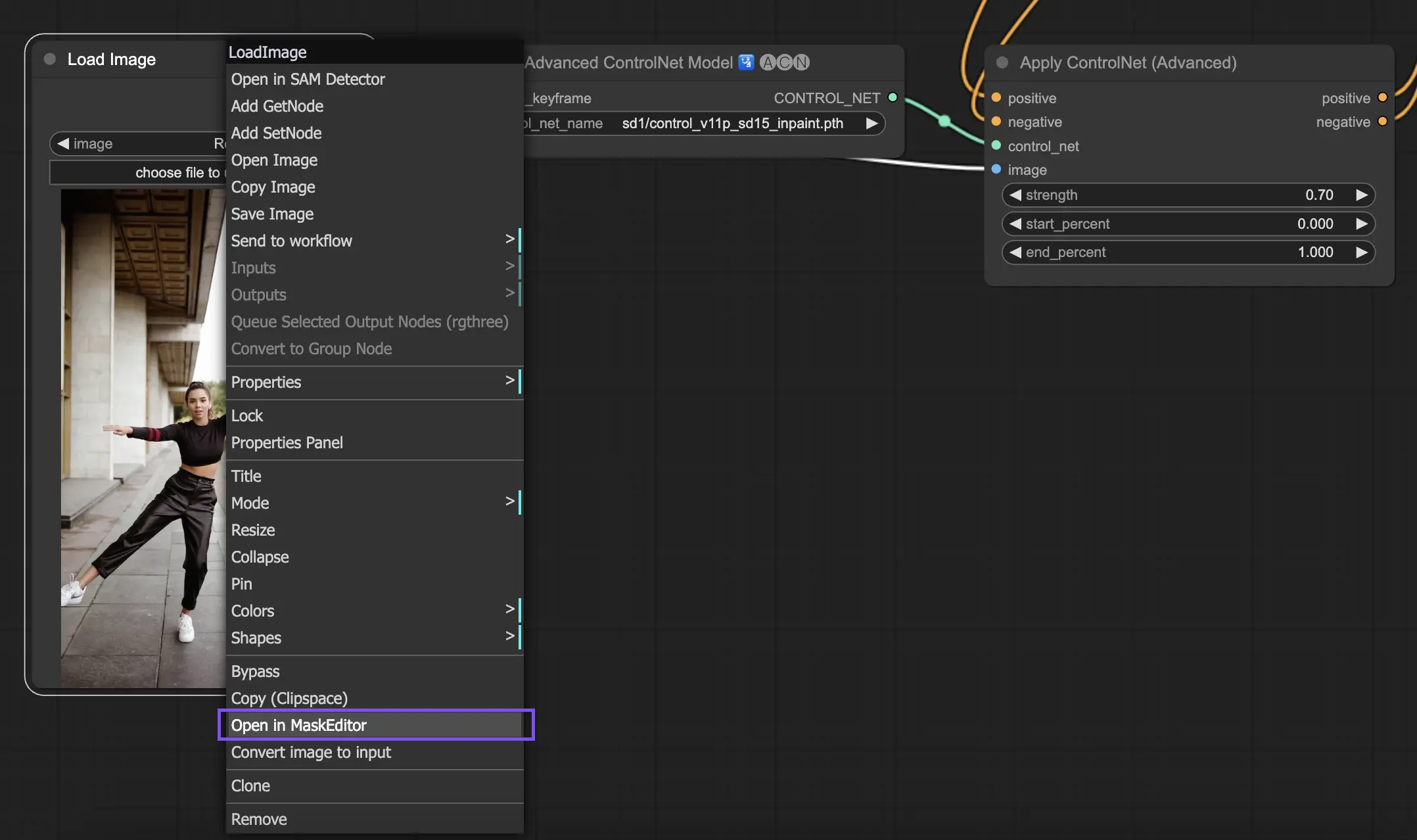

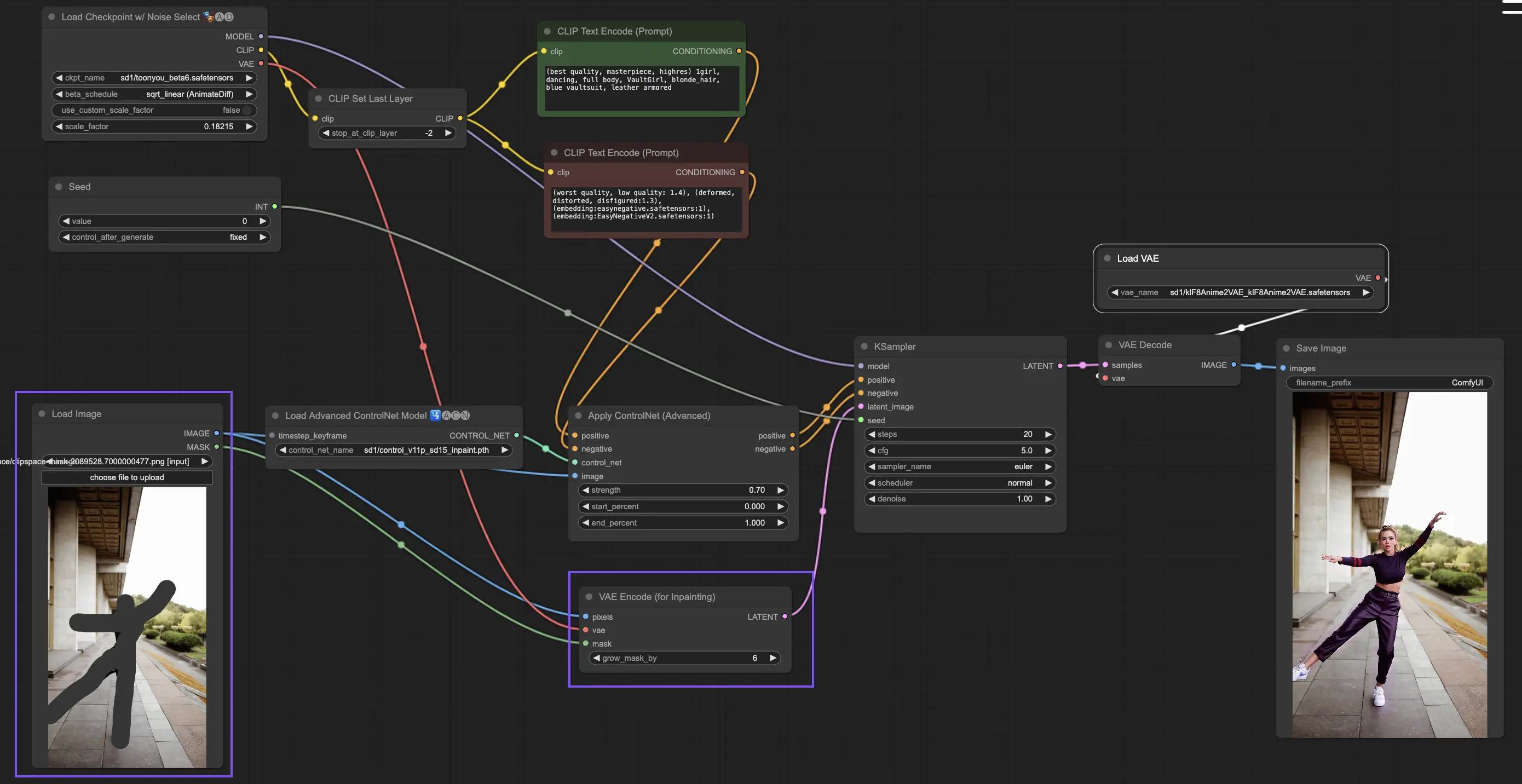

5.9. ComfyUI ControlNet Inpainting

Les modèles Inpainting dans ControlNet permettent une édition affinée dans des zones spécifiques d'une image, maintenant la cohérence globale tout en introduisant des variations ou des corrections significatives.

Pour utiliser ControlNet Inpainting, commencez par isoler la zone que vous souhaitez régénérer par masquage. Cela peut être fait en cliquant avec le bouton droit sur l'image souhaitée et en sélectionnant "Open in MaskEditor" pour les modifications.

Contrairement à d'autres implémentations dans ControlNet, Inpainting contourne le besoin d'un préprocesseur en raison des modifications directes appliquées à l'image. Cependant, il est crucial de transmettre l'image éditée à l'espace latent via le KSampler. Cela garantit que le modèle de diffusion se concentre uniquement sur la régénération de la région masquée, préservant l'intégrité des zones non masquées.

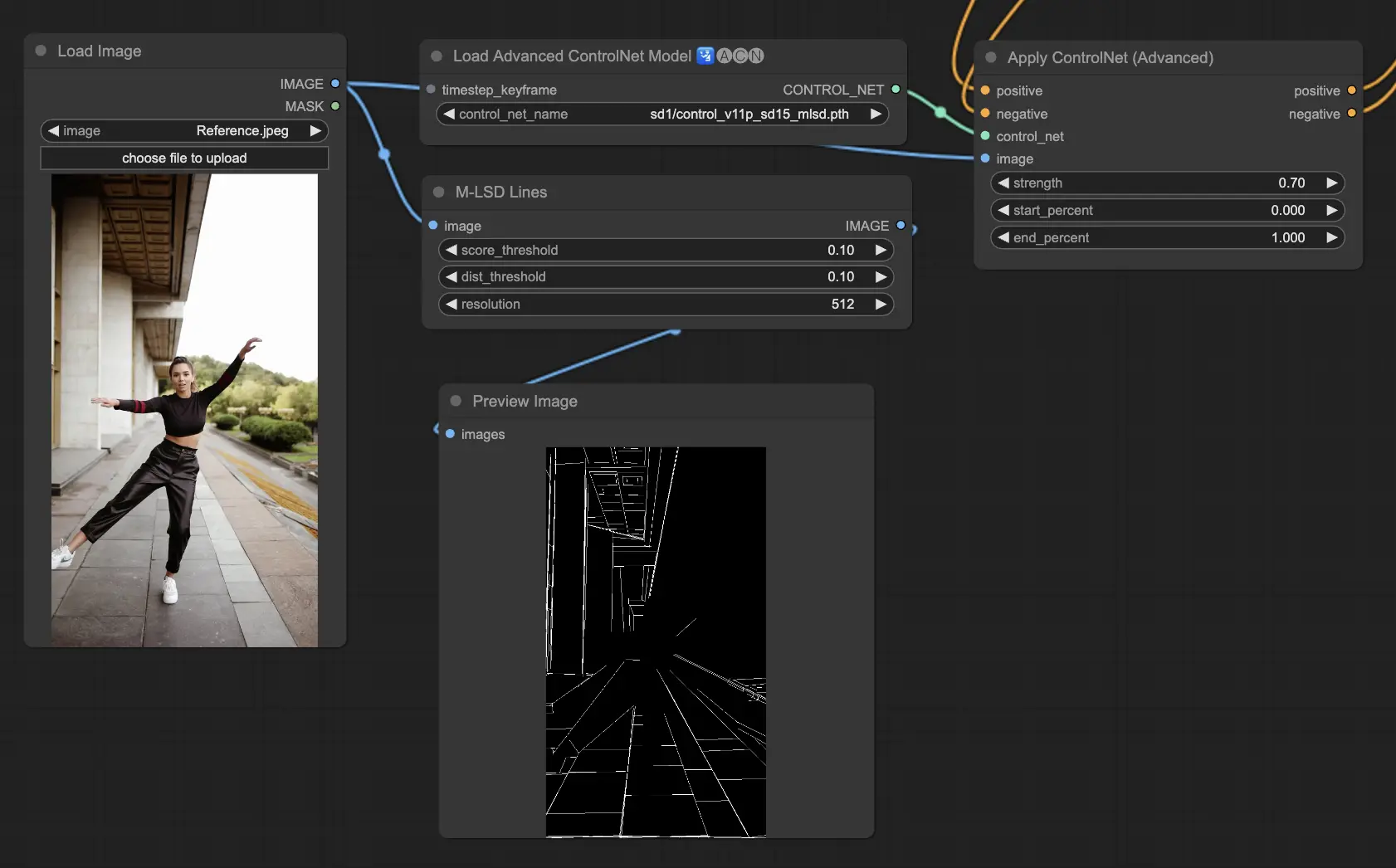

5.10. ComfyUI ControlNet MLSD

M-LSD (Mobile Line Segment Detection) se concentre sur la détection des lignes droites, idéal pour les images avec des éléments architecturaux forts, des intérieurs et des formes géométriques. Il simplifie les scènes à leur essence structurelle, facilitant les projets créatifs impliquant des environnements créés par l'homme.

Préprocesseurs : MLSD.

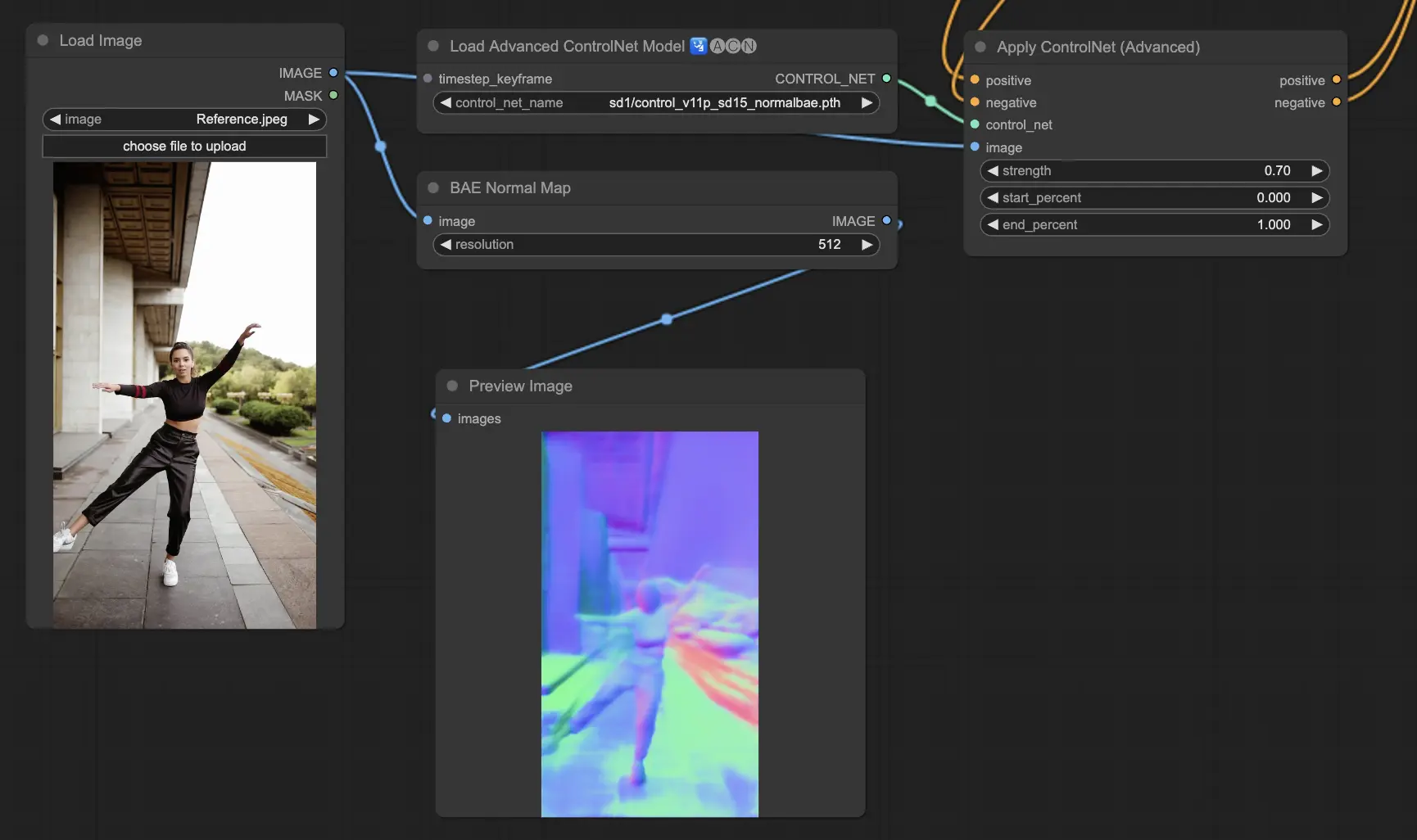

5.11. ComfyUI ControlNet Normalmaps

Normalmaps permet de simuler des effets complexes d'éclairage et de texture en modélisant l'orientation des surfaces dans une scène visuelle, plutôt que de s'appuyer uniquement sur des données de couleur. Ceci est essentiel pour les tâches de modélisation et de simulation 3D.

- Normal Bae : Cette méthode génère des cartes normales en exploitant l'approche d'incertitude normale. Elle fournit une technique innovante pour représenter l'orientation des surfaces, améliorant la simulation des effets d'éclairage en fonction de la géométrie physique de la scène modélisée plutôt que des méthodes conventionnelles basées sur la couleur.

- Normal Midas : En utilisant les cartes de profondeur produites par le modèle Midas, Normal Midas estime avec précision les cartes normales. Cette approche permet une simulation nuancée des textures de surface et de l'éclairage, basée sur les informations de profondeur de la scène, enrichissant ainsi la complexité visuelle des modèles 3D.

Préprocesseurs : Normal BAE, Normal Midas

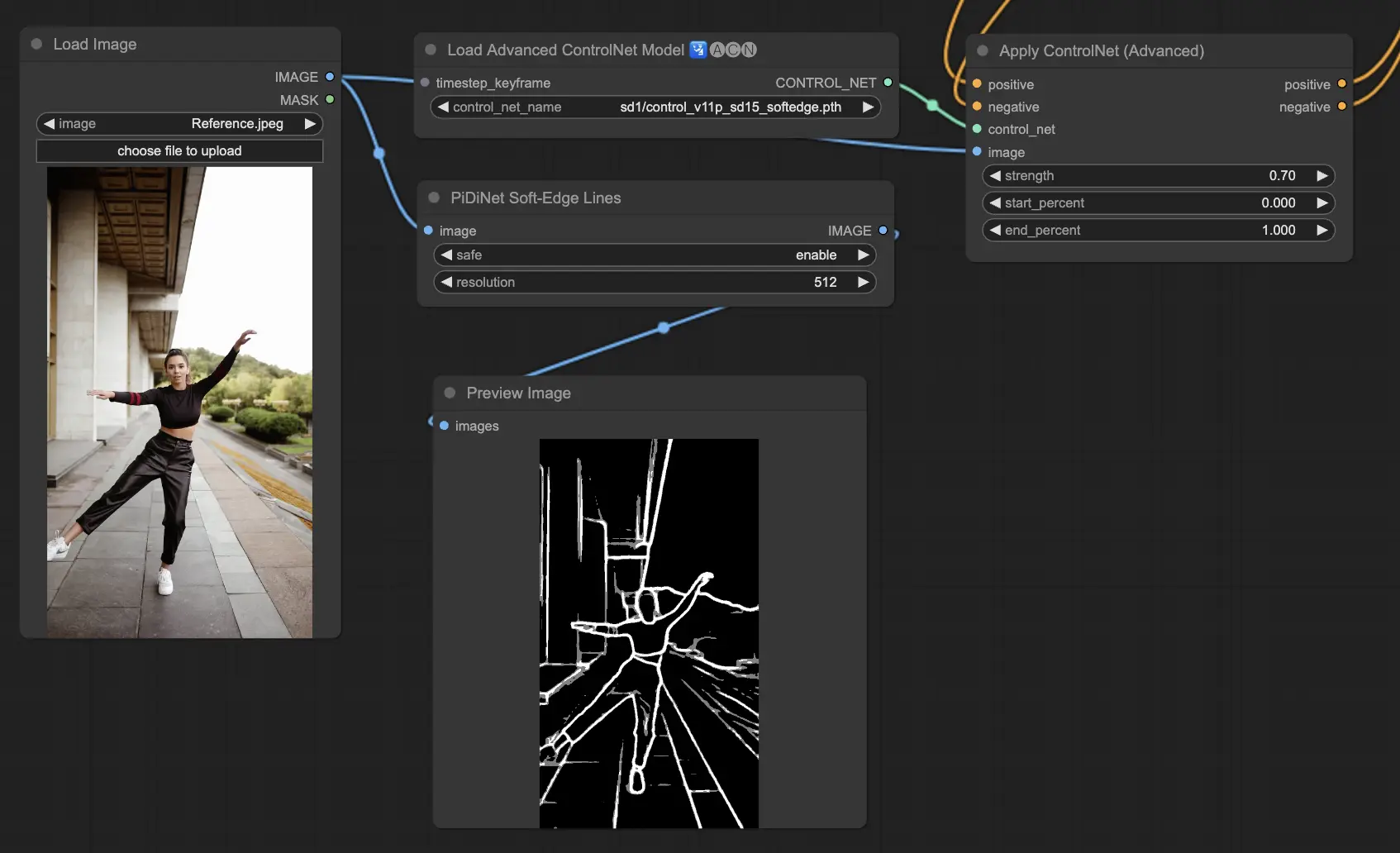

5.12. ComfyUI ControlNet Soft Edge

ControlNet Soft Edge est conçu pour générer des images avec des bords plus doux, en se concentrant sur le contrôle des détails et l'apparence naturelle. Il utilise des techniques avancées de réseau neuronal pour une manipulation précise des images, offrant une plus grande liberté créative et des capacités de fusion transparente.

Robustesse : SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Qualité maximale des résultats : SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Compte tenu du compromis, nous recommandons d'utiliser SoftEdge_PIDI par défaut. Dans la plupart des cas, il fonctionne très bien.

Préprocesseurs : SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

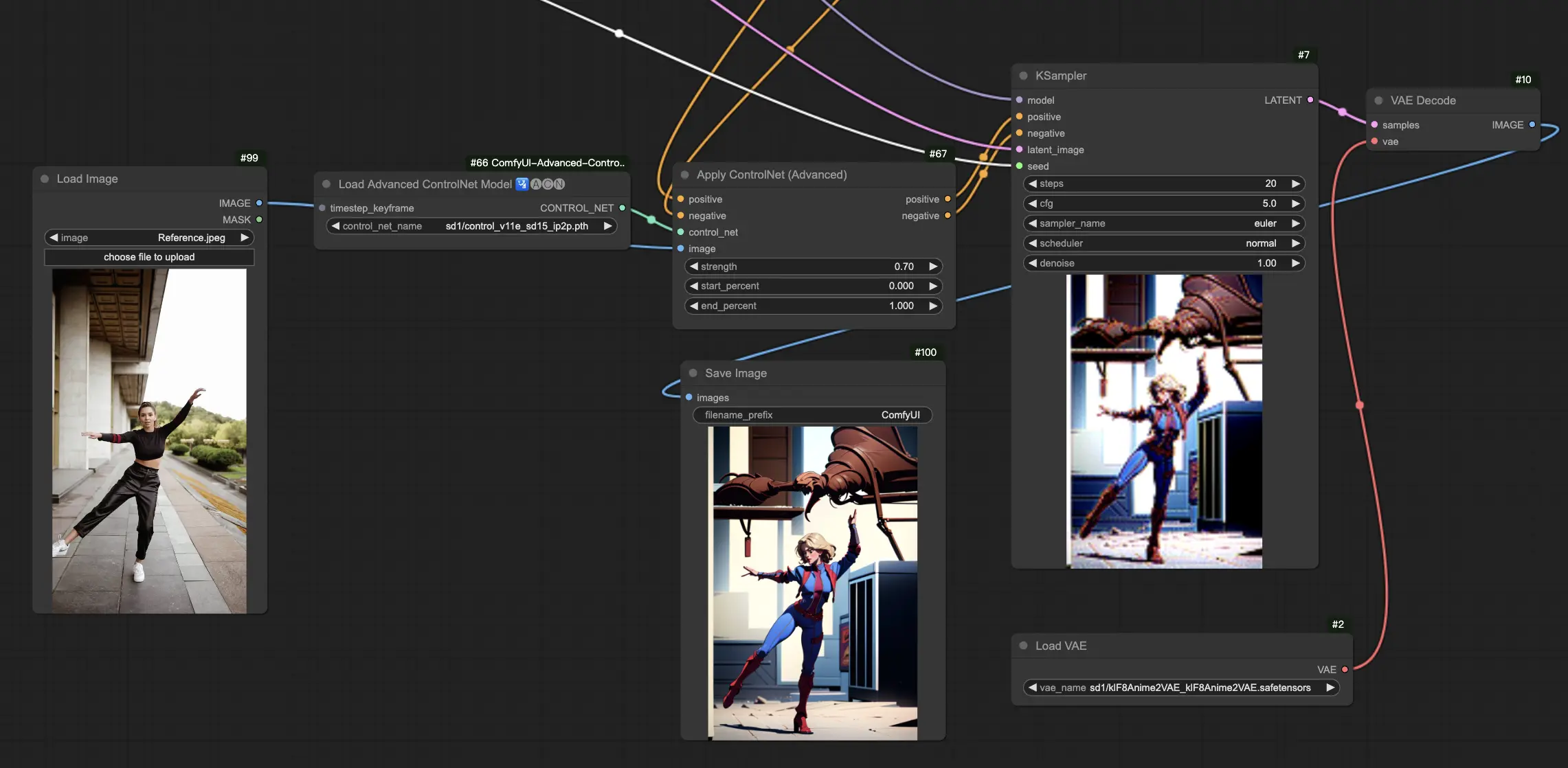

5.13. ComfyUI ControlNet IP2P (Instruct Pix2Pix)

Le modèle ControlNet IP2P (Instruct Pix2Pix) se démarque comme une adaptation unique dans le cadre de ControlNet, conçue pour tirer parti de l'ensemble de données Instruct Pix2Pix pour les transformations d'images. Cette variante de ControlNet se différencie en équilibrant les prompts d'instruction et les prompts de description pendant sa phase d'entraînement. Contrairement à l'approche conventionnelle d'Instruct Pix2Pix officiel, ControlNet IP2P intègre un mélange 50/50 de ces types de prompts, améliorant sa polyvalence et son efficacité dans la génération des résultats souhaités.

5.14. ComfyUI T2I Adapter

t2iadapter color : Le modèle t2iadapter_color est spécialement conçu pour améliorer la représentation des couleurs et la précision dans les images générées lors de l'utilisation de modèles de diffusion texte-image. En se concentrant sur l'adaptation des couleurs, ce modèle permet une palette de couleurs plus précise et vibrante, étroitement alignée avec les descriptions fournies dans les prompts textuels. Il est particulièrement utile pour les projets où la fidélité et la spécificité des couleurs sont cruciales, ajoutant une nouvelle couche de réalisme et de détail à l'imagerie générée.

t2iadapter style : Le modèle t2iadapter_style cible les aspects stylistiques de la génération d'images, permettant la modification et le contrôle du style artistique des images de sortie. Cet adaptateur permet aux utilisateurs de guider le modèle texte-image vers la génération d'images qui adhèrent à des styles ou esthétiques artistiques spécifiques décrits dans les prompts textuels. C'est un outil inestimable pour les projets créatifs où le style de l'image joue un rôle central, offrant un moyen transparent de mélanger les styles d'art traditionnels avec les capacités modernes de l'IA.

5.15. Autres ControlNets populaires de ComfyUI : QRCode Monster et IP-Adapter

Pour ces segments, nous consacrerons des articles séparés pour fournir une introduction approfondie à chacun, étant donné la quantité substantielle d'informations que nous souhaitons partager.

6. Comment utiliser plusieurs ComfyUI ControlNets

L'utilisation de plusieurs ComfyUI ControlNets dans ComfyUI implique un processus de superposition ou d'enchaînement de modèles ControlNet pour affiner la génération d'images avec des contrôles plus précis sur divers aspects comme la pose, la forme, le style et la couleur.

Ainsi, vous pouvez construire votre workflow en appliquant un ControlNet (par ex. OpenPose) puis en transmettant sa sortie à un autre ControlNet (par ex. Canny). Cette application en couches permet une personnalisation détaillée de l'image, où chaque ControlNet applique ses transformations ou contrôles spécifiques. Le processus permet un contrôle affiné de la sortie finale, intégrant de multiples aspects guidés par différents ControlNets.

🌟🌟🌟 ComfyUI en ligne - Expérimentez le workflow ControlNet maintenant 🌟🌟🌟

Si vous souhaitez explorer le workflow ControlNet, utilisez le ComfyUI web suivant. Il est entièrement équipé de tous les nœuds et modèles client essentiels, permettant une créativité transparente sans nécessiter de configurations manuelles. Acquérez une expérience pratique et familiarisez-vous avec les fonctionnalités de ControlNet dès maintenant !

Pour des workflows ComfyUI plus avancés et premium, visitez notre 🌟Liste des workflows ComfyUI🌟

RunComfy est la première ComfyUI plateforme, offrant des ComfyUI en ligne environnement et services, ainsi que des workflows ComfyUI proposant des visuels époustouflants. RunComfy propose également AI Playground, permettant aux artistes d'utiliser les derniers outils d'IA pour créer des œuvres d'art incroyables.