Immersione Profonda in ComfyUI ControlNet: Con Depth, OpenPose, Canny, Lineart, Softedge, Scribble, Seg...

Updated: 5/17/2024

Ciao! In questa guida, ci immergeremo nell'entusiasmante mondo di ControlNet in ComfyUI. Esploriamo insieme cosa porta in tavola e come può ravvivare i tuoi progetti!

Trattaremo:

1. Che cos'è ControlNet?

2. Gli Aspetti Tecnici Dietro ControlNet

3. Come Usare ComfyUI ControlNet: Passi Base

- 3.1. Caricare il Nodo "Apply ControlNet" in ComfyUI

- 3.2. Input del Nodo "Apply ControlNet"

- 3.3. Output del Nodo "Apply ControlNet"

- 3.4. Parametri per ottimizzare "Apply ControlNet"

4. Come Usare ComfyUI ControlNet: Funzionalità Avanzate - Keyframe Timestep

5. Vari Modelli ControlNet/T2IAdaptor: Panoramica Dettagliata

- 5.1. ControlNet Openpose

- 5.2. ControlNet Tile

- 5.3. ControlNet Canny

- 5.4. ControlNet Depth

- 5.5. ControlNet Lineart

- 5.6. ControlNet Scribbles

- 5.7. ControlNet Segmentation

- 5.8. ControlNet Shuffle

- 5.9. ControlNet Inpainting

- 5.10. ControlNet MLSD

- 5.11. ControlNet Normalmaps

- 5.12. ControlNet Soft Edge

- 5.13. ControlNet IP2P (Instruct Pix2Pix)

- 5.14. T2I Adapter

- 5.15. Altri ControlNet Popolari: QRCode Monster e IP-Adapter

6. Come Usare Più ControlNet

7. Prova Subito ComfyUI ControlNet!

🌟🌟🌟 ComfyUI Online - Prova Ora il Workflow di ControlNet 🌟🌟🌟

Se sei interessato a esplorare il workflow di ControlNet, usa il seguente ComfyUI web. È completamente equipaggiato con tutti i nodi e i modelli essenziali, consentendo una creatività fluida senza bisogno di setup manuali. Inizia a ottenere esperienza pratica sperimentando immediatamente le funzionalità di ControlNet, oppure continua con questo tutorial per imparare a usare ControlNet efficacemente.

Per workflow ComfyUI più avanzati e premium, visita la nostra 🌟Lista di Workflow ComfyUI🌟

1. Che cos'è ControlNet?

ControlNet è una tecnologia trasformativa che migliora significativamente le capacità dei modelli di diffusione da testo a immagine, consentendo un controllo spaziale senza precedenti nella generazione di immagini. Come architettura di rete neurale, ControlNet si integra perfettamente con modelli pre-addestrati su larga scala come Stable Diffusion. Sfrutta l'ampio addestramento di questi modelli, basato su miliardi di immagini, per introdurre condizioni spaziali nel processo di creazione delle immagini. Queste condizioni possono variare da bordi e pose umane a mappe di profondità e segmentazione, consentendo agli utenti di guidare la generazione delle immagini in modi prima non possibili con i soli prompt testuali.

2. Gli Aspetti Tecnici Dietro ControlNet

La genialità di ControlNet sta nella sua metodologia distintiva. Inizialmente, fissa i parametri del modello originale, assicurando che l'addestramento di base rimanga inalterato. Successivamente, ControlNet introduce un clone dei livelli di codifica del modello per l'addestramento, utilizzando "convoluzioni zero". Questi speciali livelli convoluzionali iniziano con pesi zero, integrando con attenzione nuove condizioni spaziali. Questo approccio impedisce a qualsiasi rumore dirompente di intervenire, preservando l'originale competenza del modello mentre avvia nuove traiettorie di apprendimento.

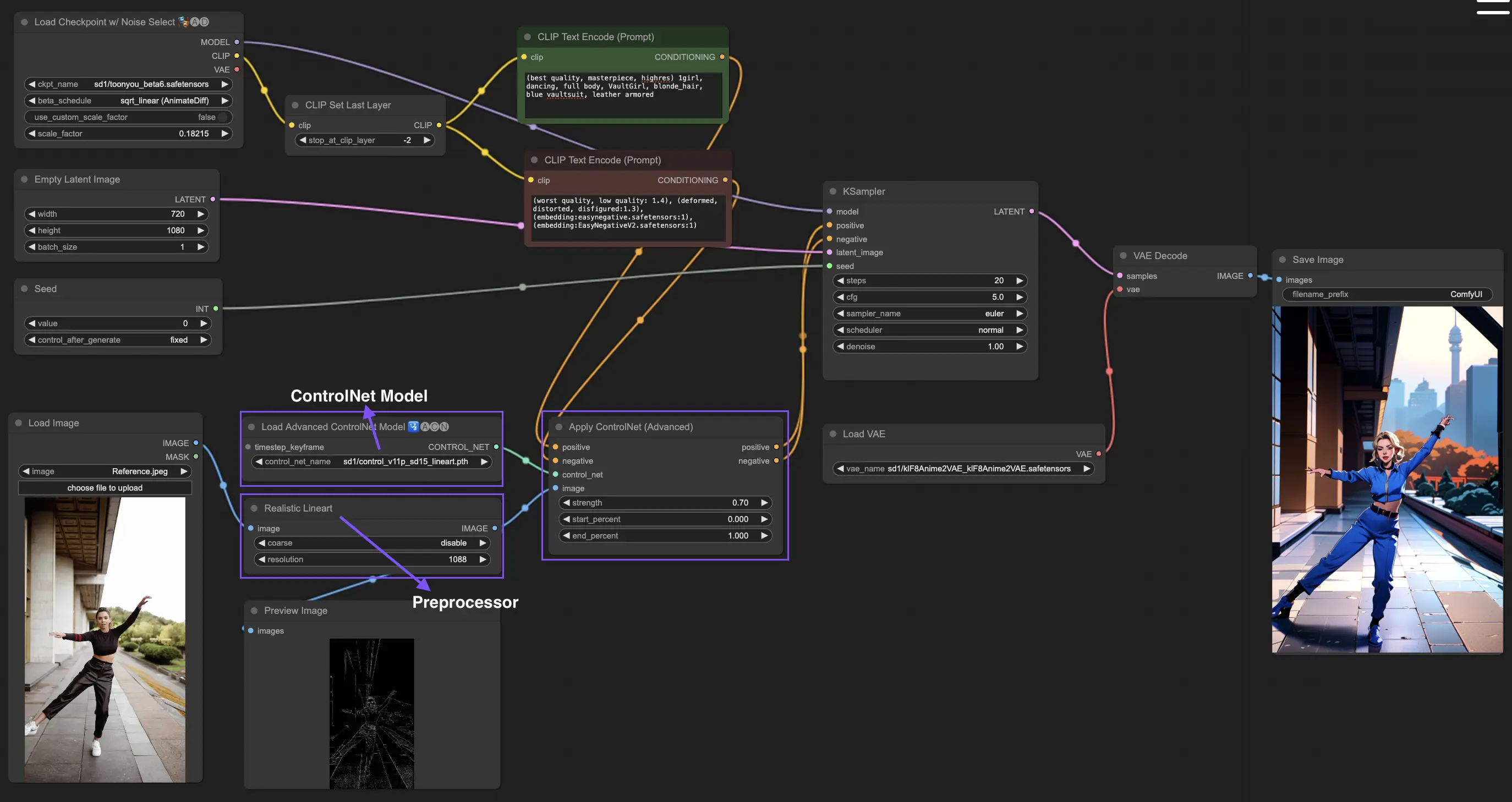

3. Come Usare ComfyUI ControlNet: Passi Base

Tradizionalmente, i modelli di stable diffusion impiegano prompt testuali come meccanismo di condizionamento per guidare la generazione delle immagini, allineando l'output con le specifiche del prompt testuale. ControlNet introduce una forma aggiuntiva di condizionamento in questo processo, migliorando la capacità di dirigere più precisamente le immagini generate in base agli input testuali e visivi.

3.1. Caricare il Nodo "Apply ControlNet" in ComfyUI

Questo passo integra ControlNet nel tuo workflow di ComfyUI, consentendo l'applicazione di un condizionamento aggiuntivo al tuo processo di generazione delle immagini. Pone le basi per applicare una guida visiva insieme ai prompt testuali.

3.2. Input del Nodo "Apply ControlNet"

Condizionamento Positivo e Negativo: Questi input sono cruciali per definire i risultati desiderati e gli aspetti da evitare nell'immagine generata. Dovrebbero essere collegati rispettivamente a "Prompt positivo" e "Prompt negativo", allineandosi con la parte di condizionamento testuale del processo.

Modello ControlNet: Questo input dovrebbe essere collegato all'output del nodo "Load ControlNet Model". Questo passo è essenziale per selezionare e incorporare un modello ControlNet o T2IAdaptor nel tuo workflow, garantendo così che il modello di diffusione benefici della guida specifica fornita dal modello scelto. Ogni modello, sia ControlNet che T2IAdaptor, è rigorosamente addestrato per influenzare il processo di generazione delle immagini in base a determinati tipi di dati o preferenze stilistiche. Dato che le funzionalità di molti modelli T2IAdaptor si allineano strettamente con quelle dei modelli ControlNet, ci concentreremo principalmente sui modelli ControlNet nella nostra discussione successiva. Tuttavia, evidenzieremo anche alcuni dei T2IAdaptor più popolari per completezza.

Preprocessore: L'input "image" deve essere collegato a un nodo "ControlNet Preprocessor", che è cruciale per adattare la tua immagine in modo da soddisfare i requisiti specifici del modello ControlNet che stai utilizzando. È imperativo utilizzare il preprocessore corretto su misura per il modello ControlNet selezionato. Questo passaggio assicura che l'immagine originale subisca le modifiche necessarie, come adattamenti nel formato, dimensione, colore o l'applicazione di filtri specifici, per ottimizzarla secondo le linee guida di ControlNet. Dopo questa fase di pre-elaborazione, l'immagine originale viene sostituita con la versione modificata, che ControlNet poi utilizza. Questo processo garantisce che le tue immagini di input siano preparate precisamente per il processo di ControlNet.

3.3. Output del Nodo "Apply ControlNet"

Il nodo "Apply ControlNet" genera due output cruciali: Condizionamento Positivo e Negativo. Questi output, imbevuti degli effetti sfumati di ControlNet e della guida visiva, giocano un ruolo fondamentale nel guidare il comportamento del modello di diffusione in ComfyUI. Successivamente, ti viene presentata una scelta: procedere al KSampler per la fase di campionamento per perfezionare ulteriormente l'immagine generata, oppure, per coloro che perseguono un livello ancora più alto di dettaglio e personalizzazione nella loro creazione, continuare a stratificare ulteriori ControlNet. Questa tecnica avanzata di integrazione di più ControlNet consente una manipolazione più granulare degli attributi dell'immagine, offrendo un toolkit potenziato per i creatori che mirano a raggiungere una precisione e un controllo ineguagliabili nei loro output visivi.

3.4. Parametri per ottimizzare "Apply ControlNet"

strength: Questo parametro determina l'intensità dell'effetto di ControlNet sull'immagine generata in ComfyUI. Un valore di 1.0 implica piena forza, il che significa che la guida di ControlNet avrà la massima influenza sull'output del modello di diffusione. Al contrario, un valore di 0.0 indica nessuna influenza, disabilitando essenzialmente l'effetto di ControlNet sul processo di generazione dell'immagine.

start_percent: Questo parametro specifica il punto di partenza, come percentuale del processo di diffusione, in cui ControlNet inizia a influenzare la generazione. Ad esempio, impostando una percentuale di inizio del 20% significa che la guida di ControlNet inizierà a influenzare la generazione dell'immagine dal 20% in poi del processo di diffusione.

end_percent: Analogamente alla "Percentuale di Inizio", il parametro "Percentuale di Fine" definisce il punto in cui l'influenza di ControlNet cessa. Ad esempio, una percentuale di fine dell'80% significherebbe che la guida di ControlNet smette di influenzare la generazione dell'immagine al punto di completamento dell'80% del processo di diffusione, lasciando le fasi finali non influenzate.

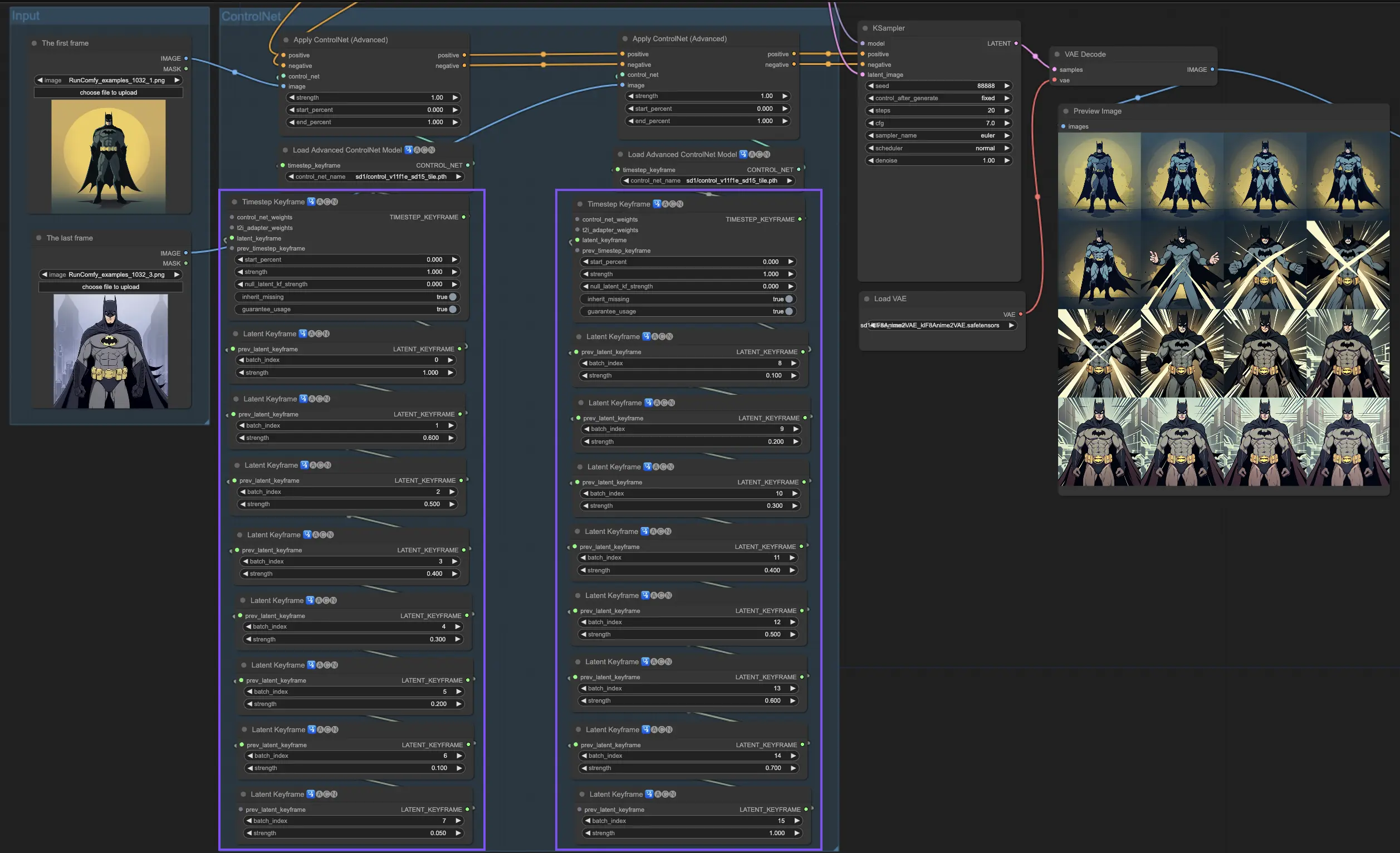

4. Come Usare ComfyUI ControlNet: Funzionalità Avanzate - Keyframe Timestep

I Keyframe Timestep in ControlNet offrono un controllo sofisticato sul comportamento dei contenuti generati dall'AI, specialmente quando il tempismo e la progressione sono cruciali, come nelle animazioni o nelle immagini in evoluzione. Ecco una descrizione dettagliata dei parametri chiave per aiutarti a utilizzarli in modo efficace e intuitivo:

prev_timestep_kf: Pensa a prev_timestep_kf come a collegare le mani con il keyframe precedente in una sequenza. Connettendo i keyframe, crei una transizione fluida o uno storyboard che guida l'AI attraverso il processo di generazione, passo dopo passo, assicurando che ogni fase fluisca logicamente nella successiva.

cn_weights: i cn_weights sono utili per ottimizzare l'output regolando specifiche caratteristiche all'interno di ControlNet durante le diverse fasi del processo di generazione.

latent_keyframe: latent_keyframe ti permette di regolare quanto fortemente ogni parte del modello AI influenza il risultato finale durante una particolare fase del processo di generazione. Ad esempio, se stai generando un'immagine in cui il primo piano dovrebbe diventare più dettagliato man mano che il processo evolve, puoi aumentare la forza per gli aspetti (latenti) del modello responsabili dei dettagli del primo piano nei keyframe successivi. Al contrario, se certe caratteristiche dovrebbero svanire sullo sfondo nel tempo, puoi ridurne la forza nei keyframe successivi. Questo livello di controllo è particolarmente utile nella creazione di immagini dinamiche ed evolutive o in progetti in cui il tempismo e la progressione precisi sono cruciali.

mask_optional: Usa maschere di attenzione come riflettori, concentrando l'influenza di ControlNet su aree specifiche della tua immagine. Che si tratti di evidenziare un personaggio in una scena o di enfatizzare un elemento dello sfondo, queste maschere possono essere applicate uniformemente o variare di intensità, dirigendo l'attenzione dell'AI esattamente dove vuoi.

start_percent: start_percent segna il momento in cui il tuo keyframe entra in gioco, misurato come percentuale del processo di generazione complessivo. Impostarlo è come programmare l'ingresso di un attore sul palco, assicurando che appaia proprio nel momento giusto dello spettacolo.

strength: strength fornisce un controllo di alto livello sull'influenza complessiva di ControlNet.

null_latent_kf_strength: Per qualsiasi attore (latente) che non hai esplicitamente diretto in questa scena (keyframe), null_latent_kf_strength agisce come un'istruzione predefinita, dicendo loro come esibirsi in background. Assicura che nessuna parte della generazione sia lasciata senza guida, mantenendo un output coerente anche nelle aree che non hai specificamente affrontato.

inherit_missing: L'attivazione di inherit_missing consente al tuo keyframe corrente di adottare qualsiasi impostazione non specificata dal suo predecessore, come un fratello minore che eredita i vestiti. È una scorciatoia utile che assicura continuità e coerenza senza dover ripetere le istruzioni.

guarantee_usage: guarantee_usage è la tua garanzia che, in ogni caso, ilkeyframe corrente avrà il suo momento di gloria nel processo, anche se solo per una breve istanza. Assicura che ogni keyframe che hai impostato abbia un impatto, onorando la tua pianificazione dettagliata nel guidare il processo creativo dell'AI.

I Keyframe Timestep offrono la precisione necessaria per guidare meticolosamente il processo creativo dell'AI, permettendoti di creare esattamente come immagini il viaggio narrativo o visivo. Servono come strumento potente per orchestrare l'evoluzione delle immagini, in particolare nell'animazione, dalla scena di apertura fino alla conclusione. Ecco uno sguardo più da vicino a come i Keyframe Timestep possono essere applicati strategicamente per gestire la progressione di un'animazione, assicurando una transizione senza soluzione di continuità dal fotogramma iniziale a quello finale, allineandosi perfettamente con i tuoi obiettivi artistici.

5. Vari Modelli ControlNet/T2IAdaptor: Panoramica Dettagliata

Dato che le funzionalità di molti modelli T2IAdaptor si allineano strettamente con quelle dei modelli ControlNet, ci concentreremo principalmente sui modelli ControlNet nella nostra discussione successiva. Tuttavia, evidenzieremo anche alcuni dei T2IAdaptor più popolari per completezza.

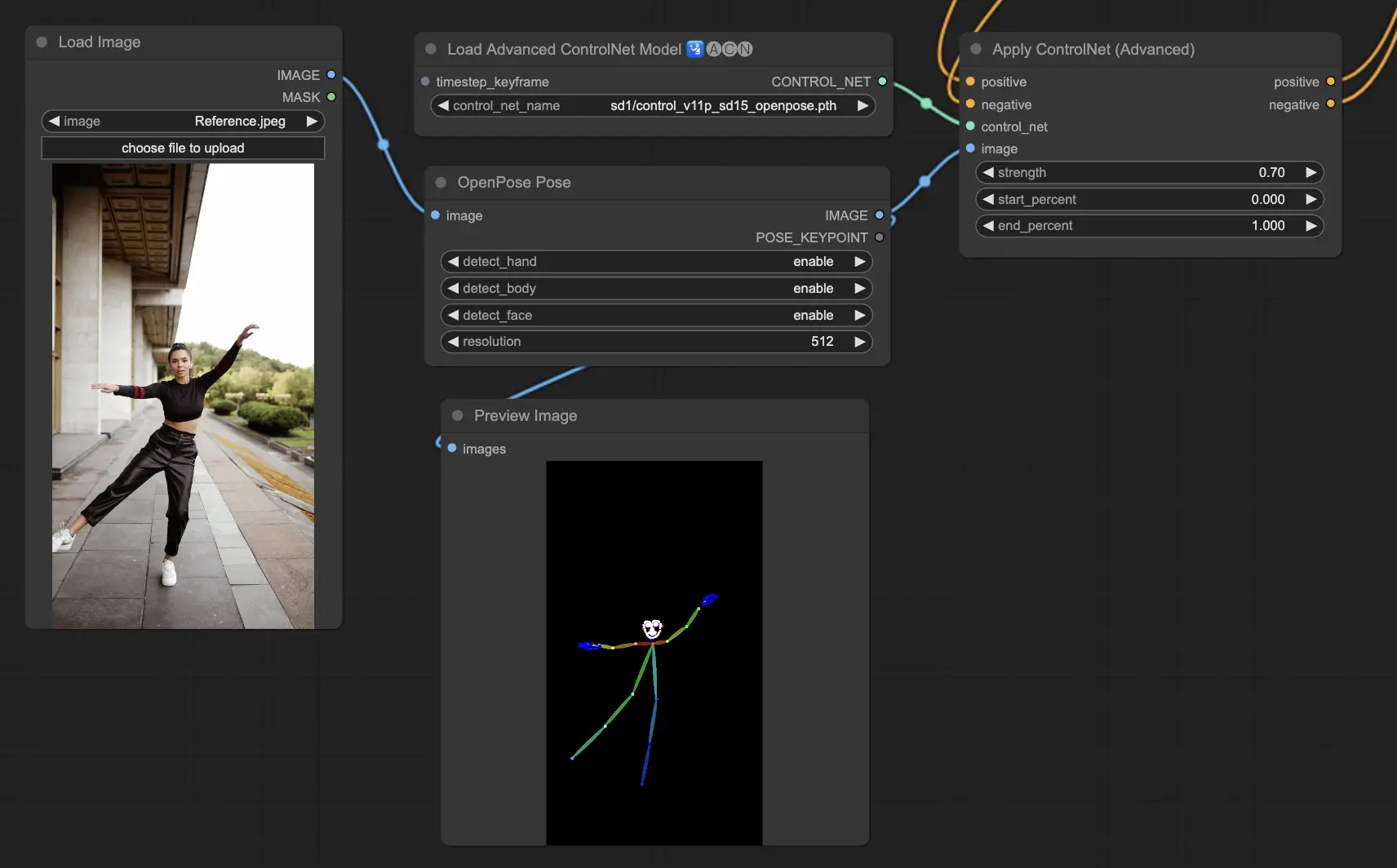

5.1. ComfyUI ControlNet Openpose

- Openpose (=Openpose body): Il modello fondamentale all'interno di ControlNet che identifica i punti chiave del corpo di base come occhi, naso, collo, spalle, gomiti, polsi, ginocchia e caviglie. È ideale per la replica di base della posa umana.

- Openpose_face: Estende il modello OpenPose aggiungendo il rilevamento dei punti chiave del viso, offrendo un'analisi più dettagliata delle espressioni e dell'orientamento del viso. Questo modello ControlNet è essenziale per i progetti che si concentrano sulle espressioni facciali.

- Openpose_hand: Arricchisce il modello OpenPose con la capacità di catturare dettagli intricati di mani e dita, concentrandosi su gesti e posizioni dettagliate delle mani. Questa aggiunta migliora la versatilità di OpenPose all'interno di ControlNet.

- Openpose_faceonly: Un modello specializzato solo per i dettagli del viso, che omette i punti chiave del corpo per concentrarsi sulla cattura di espressioni e orientamenti del viso. Questo modello all'interno di ControlNet si concentra esclusivamente sulle caratteristiche del viso.

- Openpose_full: Una fusione completa dei modelli OpenPose, OpenPose_face e OpenPose_hand, che offre il rilevamento completo di corpo, viso e mani per la replica totale della posa umana all'interno di ControlNet.

- DW_Openpose_full: Una versione migliorata del modello OpenPose_full, che incorpora ulteriori perfezionamenti per un rilevamento della posa ancora più dettagliato e accurato. Questa versione rappresenta il culmine della precisione del rilevamento della posa all'interno del framework ControlNet.

Preprocessore: Openpose o DWpose

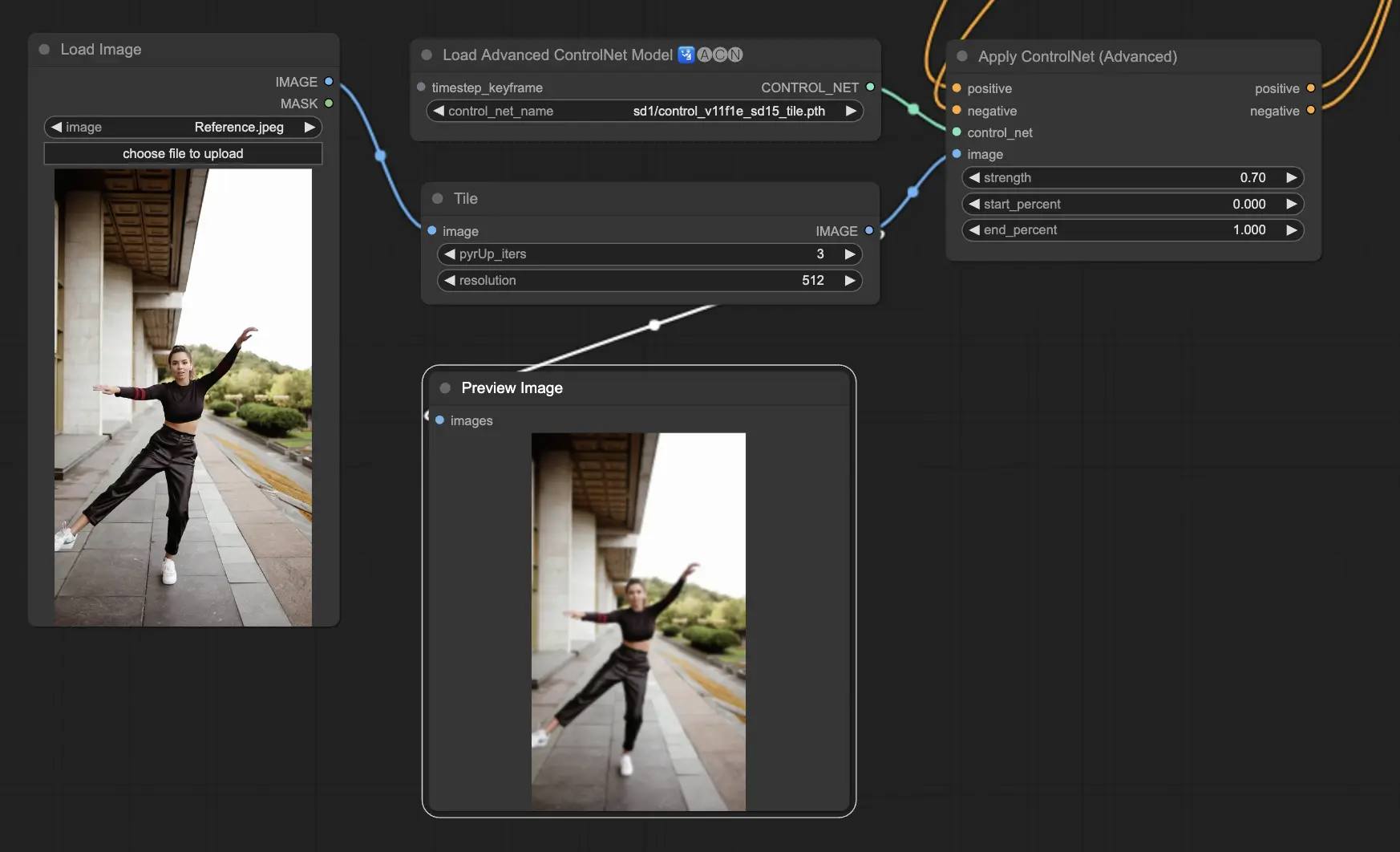

5.2. ComfyUI ControlNet Tile

Il modello Tile Resample viene utilizzato per migliorare i dettagli nelle immagini. È particolarmente utile in combinazione con un upscaler per migliorare la risoluzione dell'immagine aggiungendo dettagli più fini, spesso utilizzato per affinare e arricchire trame ed elementi all'interno di un'immagine.

Preprocessore: Tile

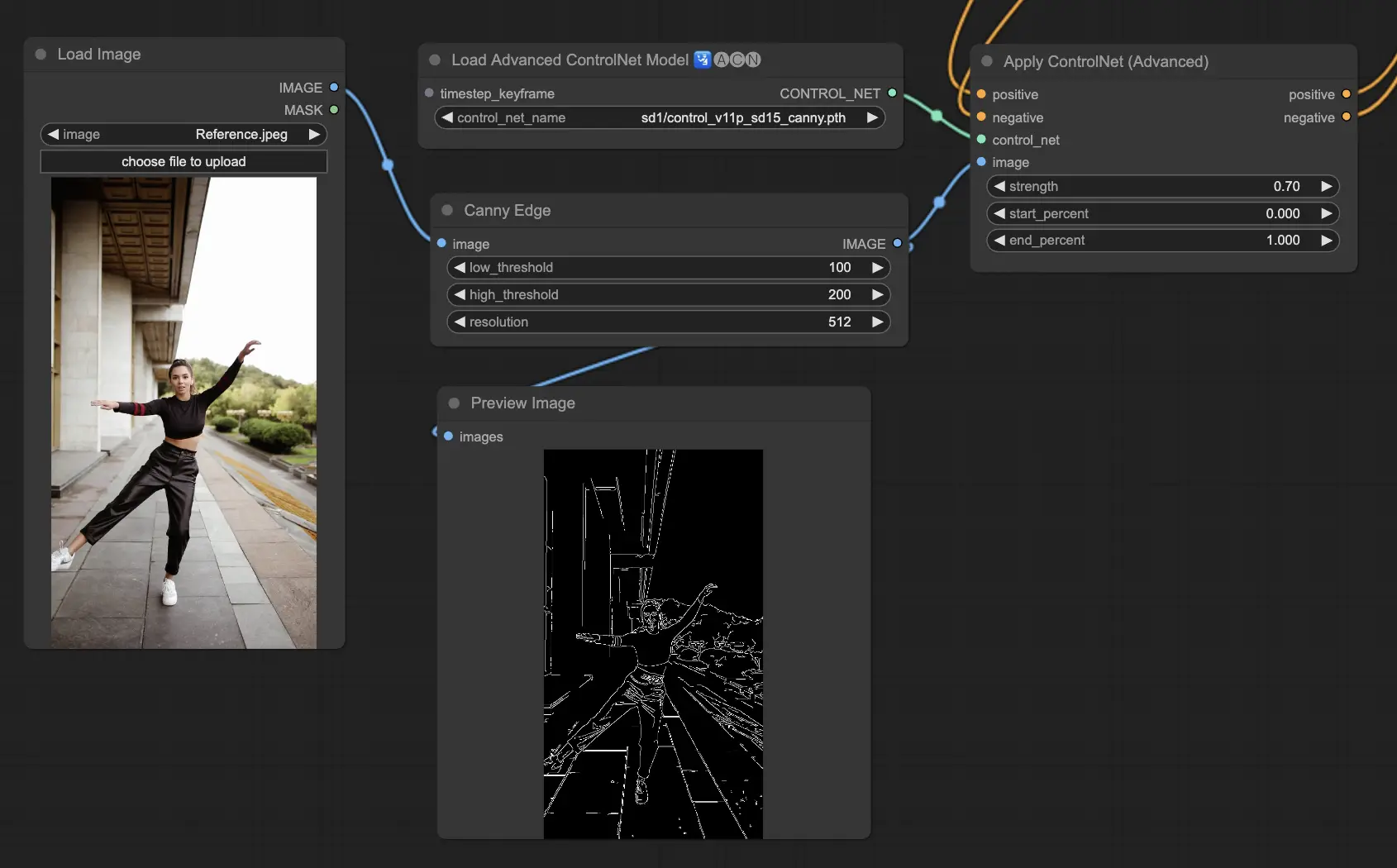

5.3. ComfyUI ControlNet Canny

Il modello Canny applica l'algoritmo di rilevamento dei bordi di Canny, un processo a più fasi per rilevare una vasta gamma di bordi nelle immagini. Questo modello è utile per preservare gli aspetti strutturali di un'immagine semplificandone la composizione visiva, rendendolo utile per l'arte stilizzata o la pre-elaborazione prima di ulteriori manipolazioni dell'immagine.

Preprocessori: Canny

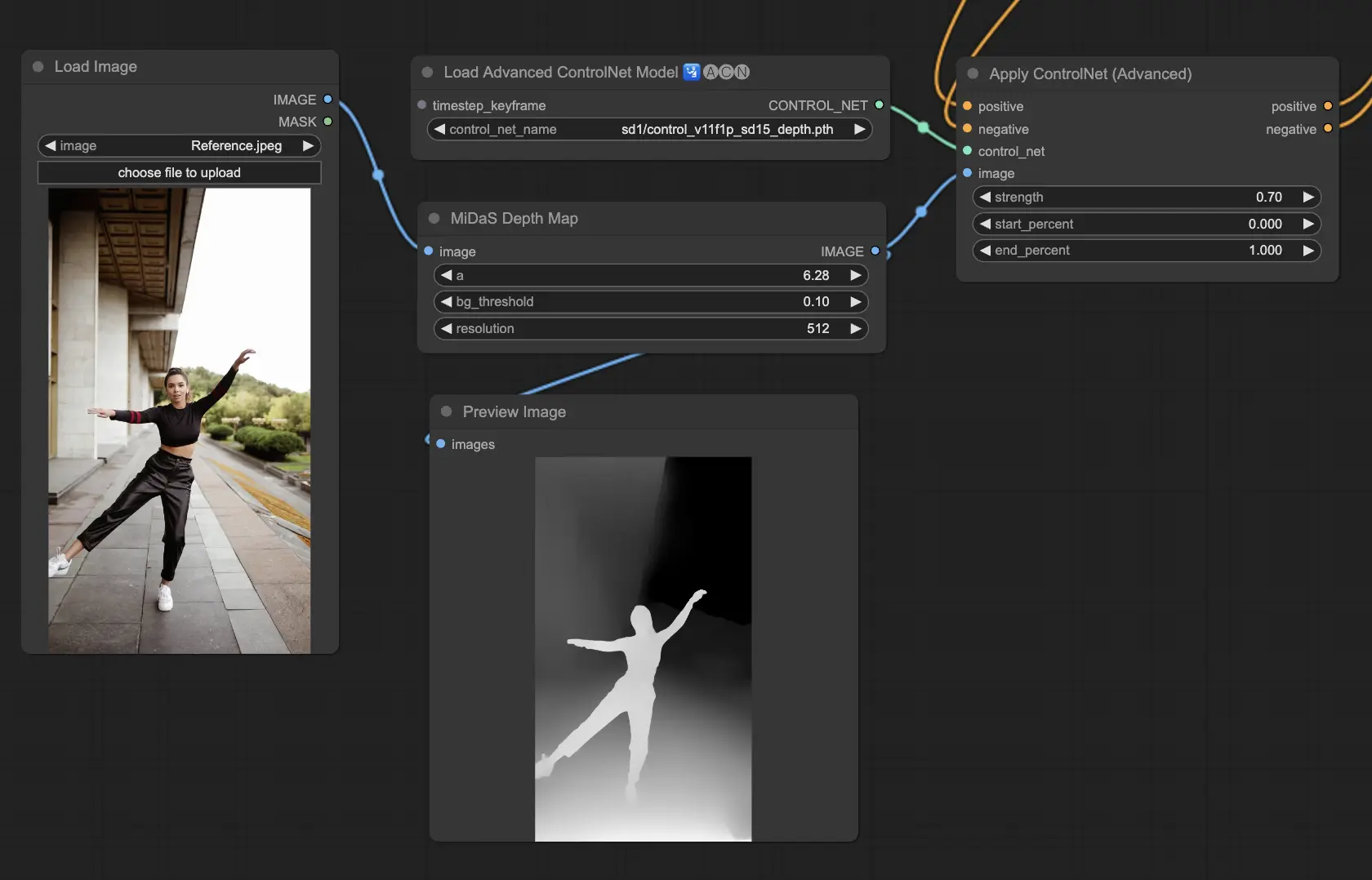

5.4. ComfyUI ControlNet Depth

I modelli Depth deducono informazioni sulla profondità da un'immagine 2D, traducendo la distanza percepita in una mappa di profondità in scala di grigi. Ogni variante offre un diverso equilibrio tra cattura dei dettagli ed enfasi dello sfondo:

- Depth Midas: Fornisce una classica stima della profondità, bilanciando il rendering dei dettagli e dello sfondo.

- Depth Leres: Si concentra sul miglioramento dei dettagli con una tendenza a includere più elementi di sfondo.

- Depth Leres++: Offre un livello avanzato di dettaglio per le informazioni di profondità, ideale per scene complesse.

- Zoe: Trova un equilibrio tra i modelli Midas e Leres in termini di livello di dettaglio.

- Depth Anything: Un modello più recente e migliorato per la stima della profondità, progettato per una vasta gamma di scene.

- Depth Hand Refiner: Specificamente progettato per migliorare i dettagli delle mani nelle mappe di profondità, utile per le scene in cui il posizionamento delle mani è fondamentale.

Preprocessori: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Questo modello è altamente robusto e può funzionare su mappe di profondità reali provenienti da motori di rendering.

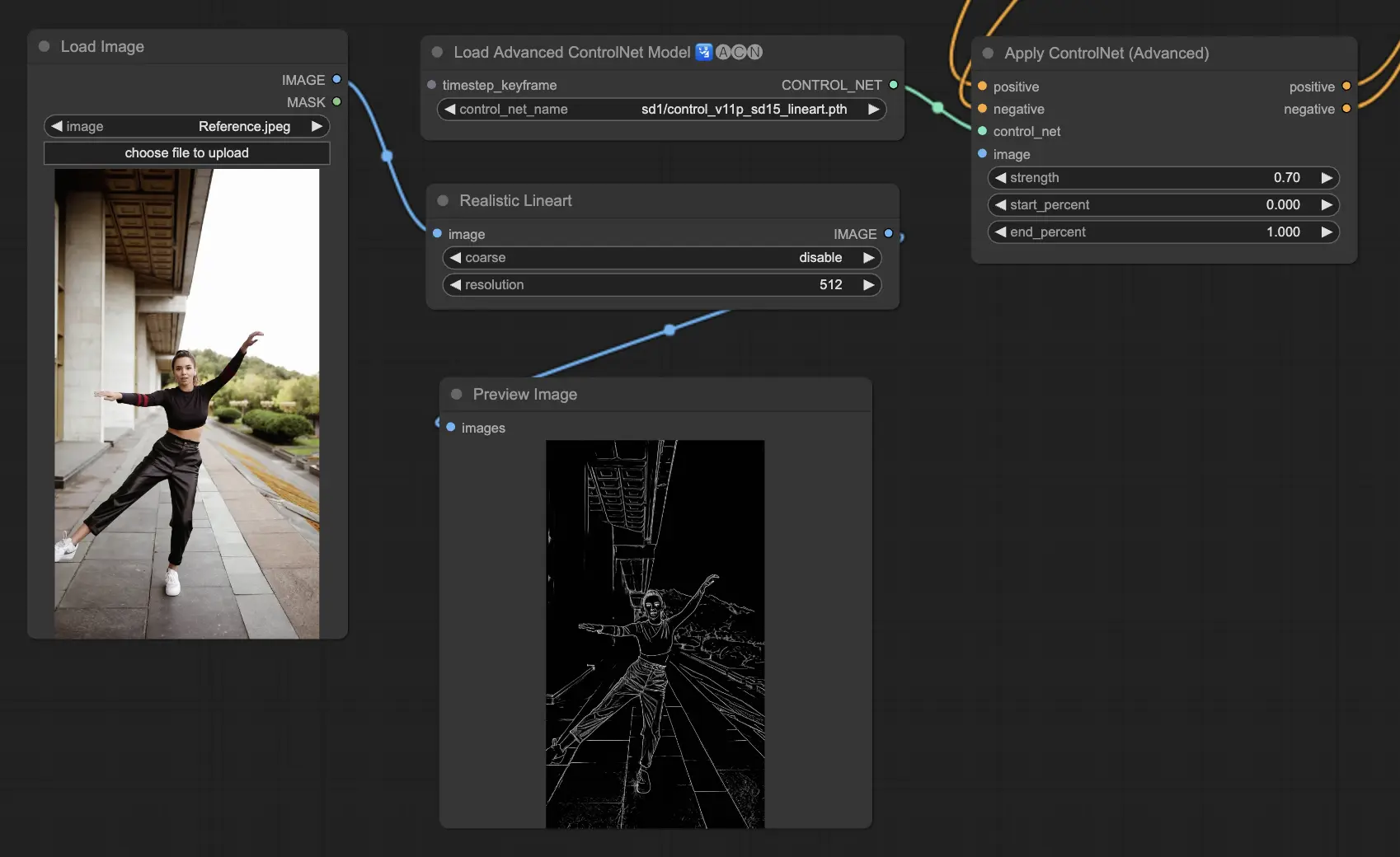

5.5. ComfyUI ControlNet Lineart

I modelli Lineart convertono le immagini in disegni a linea stilizzati, utili per rappresentazioni artistiche o come base per ulteriori lavori creativi:

- Lineart: Questo modello standard converte le immagini in disegni a linea stilizzati, offrendo una base versatile per vari progetti artistici o creativi.

- Lineart anime: Si concentra sulla generazione di disegni a linea in stile anime, caratterizzati da linee pulite e precise, rendendolo adatto a progetti che mirano a un'estetica anime.

- Lineart realistic: Produce disegni a linea con un tocco più realistico, catturando l'essenza del soggetto con maggiori dettagli, perfetto per progetti che richiedono una rappresentazione realistica.

- Lineart coarse: Fornisce un disegno a linea più pronunciato con linee più pesanti e audaci, creando un effetto sorprendente che spicca, specialmente adatto a espressioni artistiche audaci.

Il preprocessore può generare linee dettagliate o grossolane dalle immagini (Lineart e Lineart_Coarse)

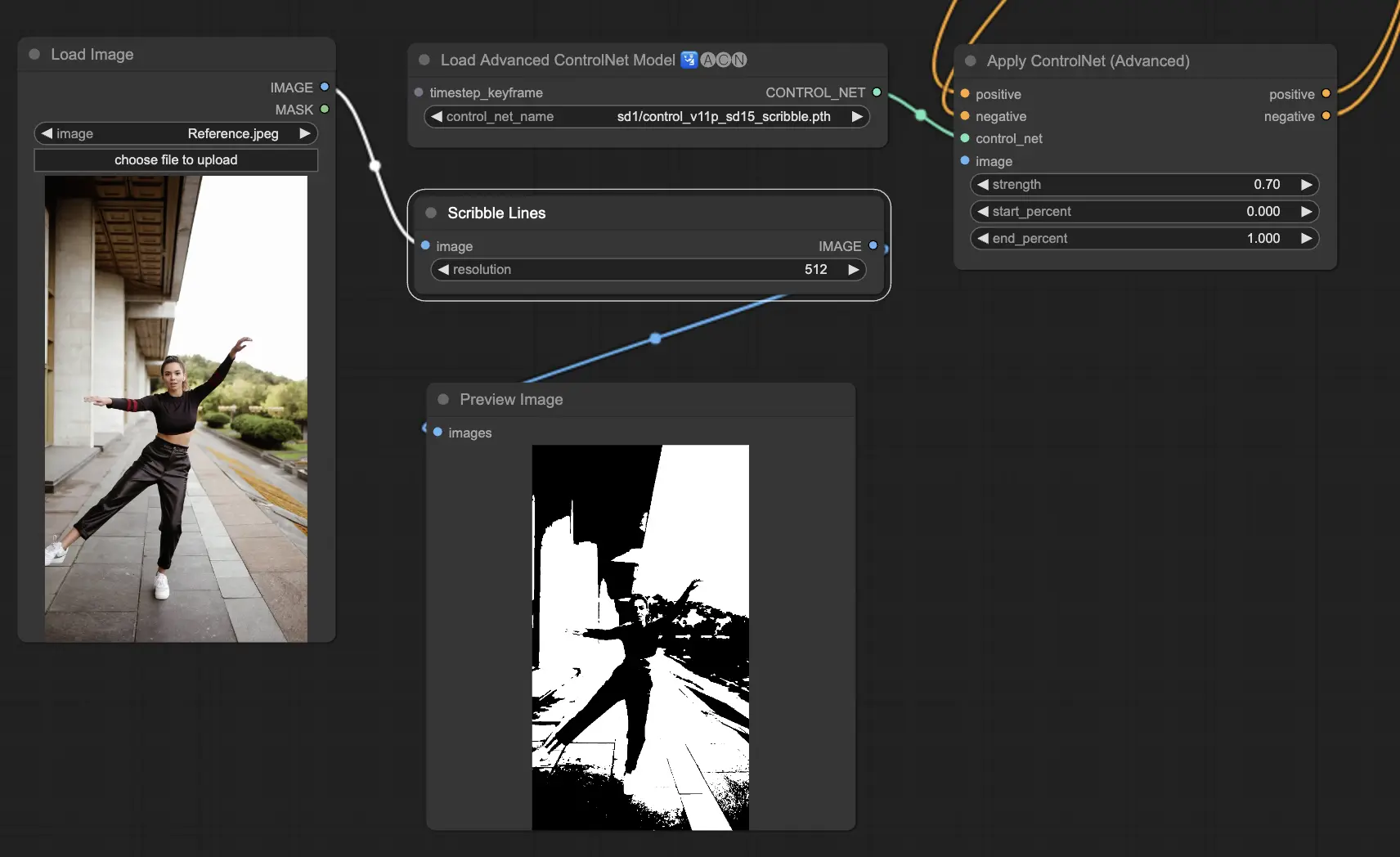

5.6. ComfyUI ControlNet Scribbles

I modelli Scribble sono progettati per trasformare le immagini in un aspetto simile a uno scarabocchio, simulando l'aspetto di schizzi disegnati a mano. Sono particolarmente utili per il restyling artistico o come fase preliminare in un flusso di lavoro di progettazione più ampio:

- Scribble: Progettato per convertire le immagini in opere d'arte dettagliate che simulano scarabocchi o schizzi disegnati a mano.

- Scribble HED: Utilizza il rilevamento dei bordi olisticamente annidato (HED) per creare contorni che assomigliano a schizzi disegnati a mano. È consigliato per ricolorare e ridisegnare le immagini, aggiungendo un tocco artistico unico all'opera d'arte.

- Scribble Pidinet: Si concentra sul rilevamento delle differenze di pixel per produrre linee più pulite con dettagli ridotti, rendendolo ideale per rappresentazioni più chiare e astratte. Scribble Pidinet è perfetto per chi cerca curve nitide e bordi rettilinei, offrendo un aspetto raffinato pur preservando i dettagli essenziali

- Scribble xdog: Impiega il metodo Extended Difference of Gaussian (xDoG) per il rilevamento dei bordi. Questo consente di regolare le impostazioni di soglia per ottimizzare l'effetto scarabocchio, rendendo possibile controllare il livello di dettaglio nelle tue opere d'arte. xDoG è versatile, permettendo agli utenti di trovare il perfetto equilibrio nelle loro creazioni artistiche

Preprocessori: Scribble, Scribble_HED, Scribble_PIDI e Scribble_XDOG

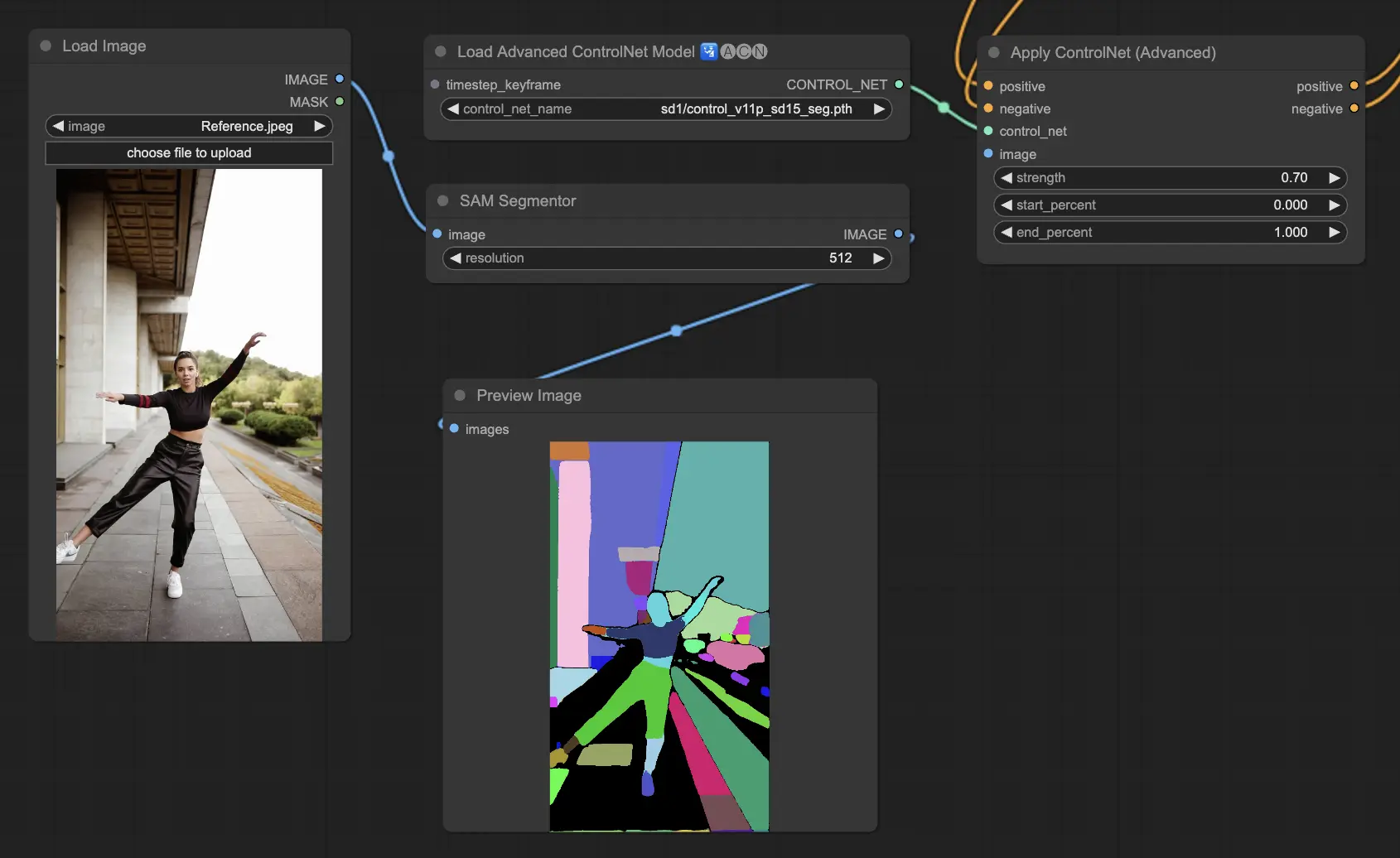

5.7. ComfyUI ControlNet Segmentation

I modelli di segmentazione classificano i pixel delle immagini in classi distinte di oggetti, ciascuna rappresentata da un colore specifico. Questo è prezioso per identificare e manipolare singoli elementi all'interno di un'immagine, come separare il primo piano dallo sfondo o differenziare gli oggetti per una modifica dettagliata.

- Seg: Progettato per differenziare gli oggetti all'interno di un'immagine per colore, traducendo efficacemente queste distinzioni in elementi distinti nell'output. Ad esempio, può separare i mobili in una disposizione di una stanza, rendendolo particolarmente prezioso per progetti che richiedono un controllo preciso sulla composizione e l'editing delle immagini

- ufade20k: Utilizza il modello di segmentazione UniFormer addestrato sul set di dati ADE20K, in grado di distinguere una vasta gamma di tipi di oggetti con elevata precisione.

- ofade20k: Impiega il modello di segmentazione OneFormer, anch'esso addestrato su ADE20K, offrendo un approccio alternativo alla differenziazione degli oggetti con le sue capacità di segmentazione uniche.

- ofcoco: Sfrutta la segmentazione OneFormer addestrata sul set di dati COCO, adattata per immagini con oggetti classificati all'interno dei parametri del set di dati COCO, facilitando l'identificazione e la manipolazione precisa degli oggetti.

Preprocessori accettabili: Sam, Seg_OFADE20K (Oneformer ADE20K), Seg_UFADE20K (Uniformer ADE20K), Seg_OFCOCO (Oneformer COCO) o maschere create manualmente.

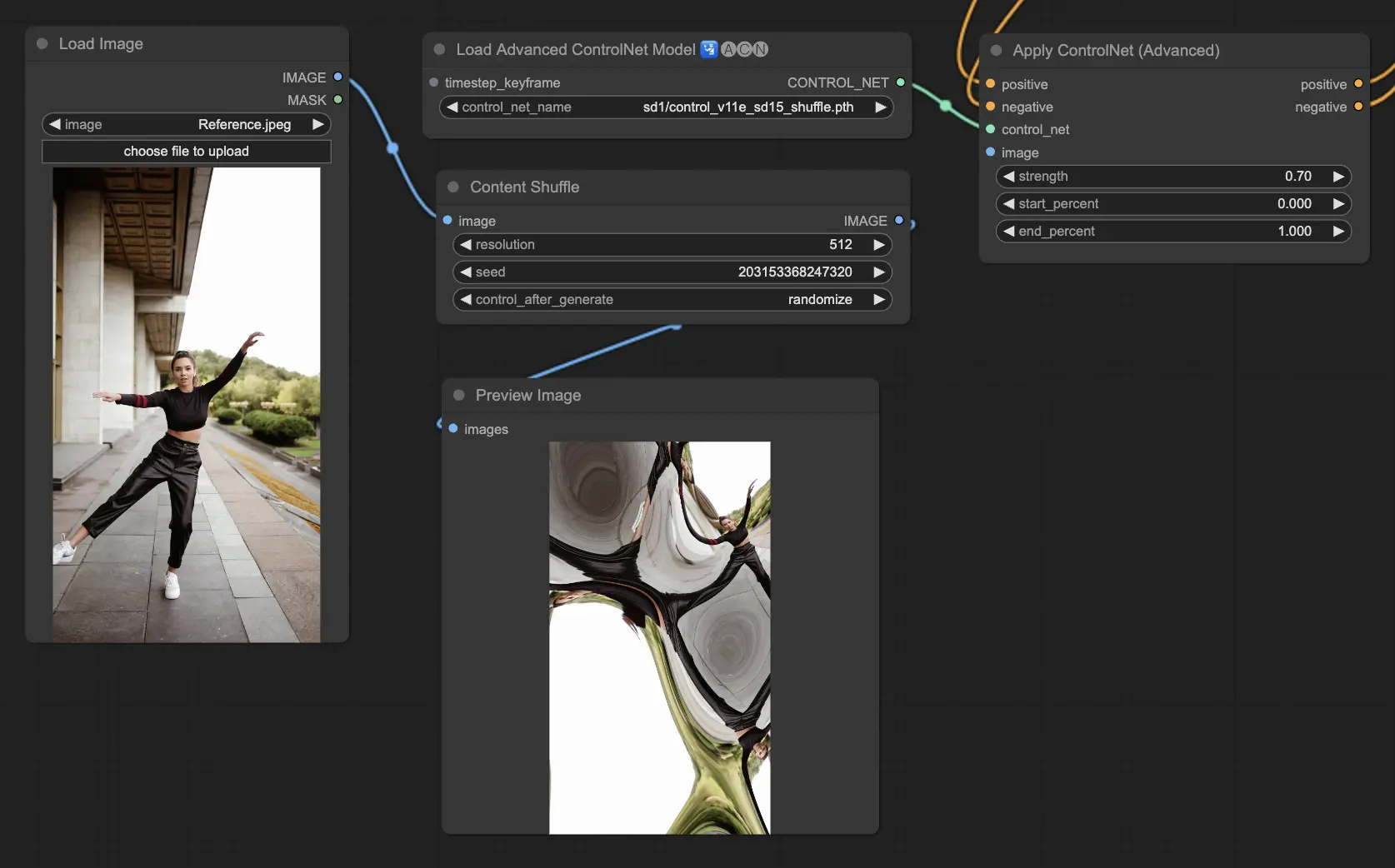

5.8. ComfyUI ControlNet Shuffle

Il modello Shuffle introduce un approccio nuovo randomizzando gli attributi dell'immagine di input, come gli schemi di colore o le trame, senza alterare la composizione. Questo modello è particolarmente efficace per esplorazioni creative e per generare variazioni di un'immagine con integrità strutturale mantenuta ma estetica visiva alterata. La sua natura randomizzata significa che ogni output è unico, influenzato dal valore di seed utilizzato nel processo di generazione.

Preprocessori: Shuffle

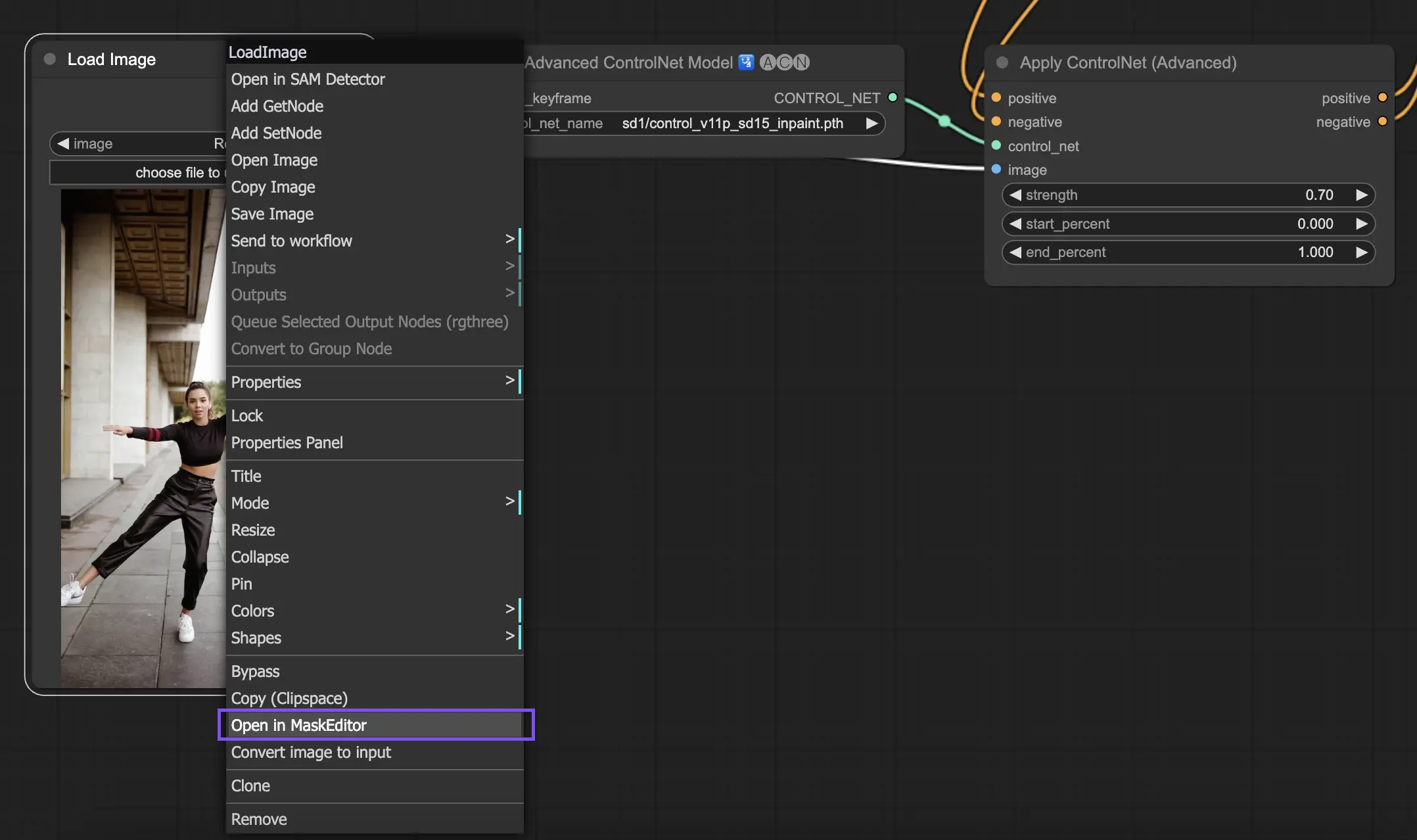

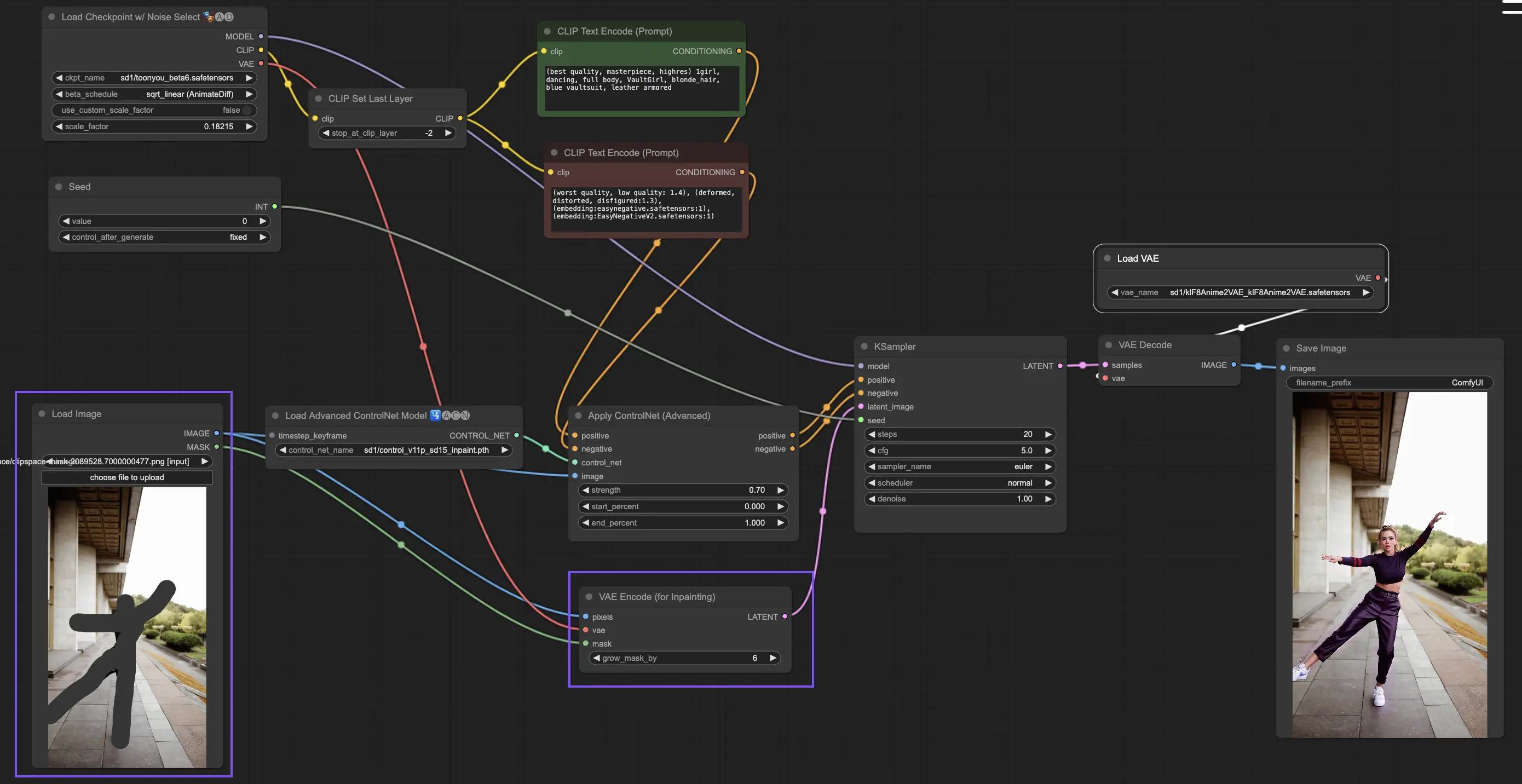

5.9. ComfyUI ControlNet Inpainting

I modelli Inpainting all'interno di ControlNet consentono modifiche raffinate all'interno di aree specifiche di un'immagine, mantenendo la coerenza generale mentre introducono variazioni o correzioni significative.

Per utilizzare ControlNet Inpainting, inizia isolando l'area che desideri rigenerare attraverso la mascheratura. Questo può essere fatto facendo clic con il tasto destro sull'immagine desiderata e selezionando "Apri in MaskEditor" per le modifiche.

A differenza di altre implementazioni all'interno di ControlNet, Inpainting bypassa la necessità di un preprocessore a causa delle modifiche dirette applicate all'immagine. Tuttavia, è fondamentale inoltrare l'immagine modificata allo spazio latente tramite il KSampler. Questo assicura che il modello di diffusione si concentri esclusivamente sulla rigenerazione della regione mascherata, mantenendo l'integrità delle aree non mascherate.

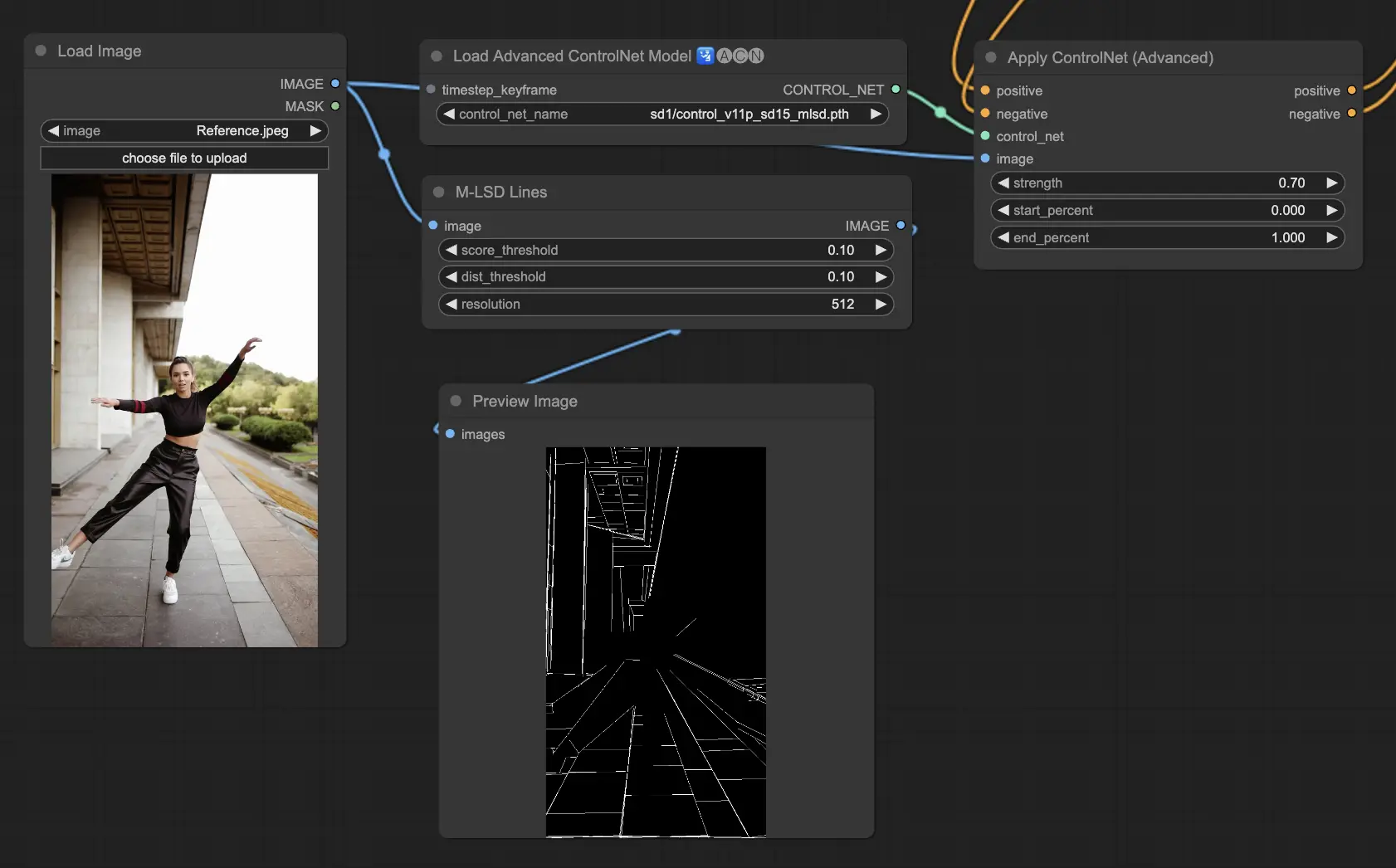

5.10. ComfyUI ControlNet MLSD

M-LSD (Mobile Line Segment Detection) si concentra sul rilevamento di linee rette, ideale per immagini con forti elementi architettonici, interni e forme geometriche. Semplifica le scene alla loro essenza strutturale, facilitando progetti creativi che coinvolgono ambienti artificiali.

Preprocessori: MLSD.

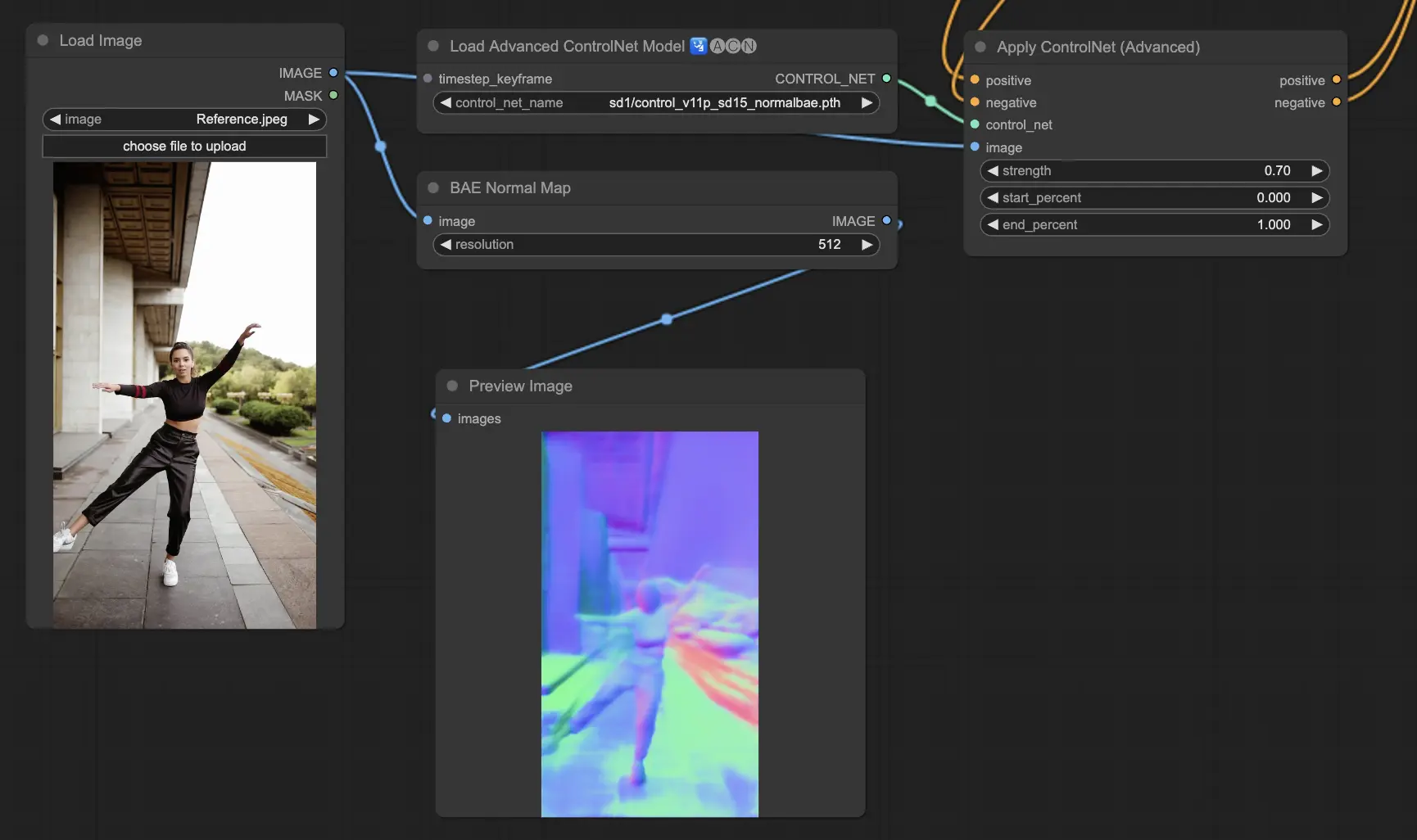

5.11. ComfyUI ControlNet Normalmaps

Normalmaps consente la simulazione di effetti di illuminazione e texture complessi modellando l'orientamento delle superfici in una scena visiva, piuttosto che affidarsi solo ai dati di colore. Questo è fondamentale per le attività di modellazione e simulazione 3D.

- Normal Bae: Questo metodo genera mappe normali sfruttando l'approccio dell'incertezza normale. Fornisce una tecnica innovativa per rappresentare l'orientamento delle superfici, migliorando la simulazione degli effetti di illuminazione basati sulla geometria fisica della scena modellata piuttosto che sui metodi convenzionali basati sul colore.

- Normal Midas: Utilizzando le mappe di profondità prodotte dal modello Midas, Normal Midas stima accuratamente le mappe normali. Questo approccio consente una simulazione sfumata di trame e illuminazione delle superfici, basata sulle informazioni di profondità della scena, arricchendo così la complessità visiva dei modelli 3D.

Preprocessori: Normal BAE, Normal Midas

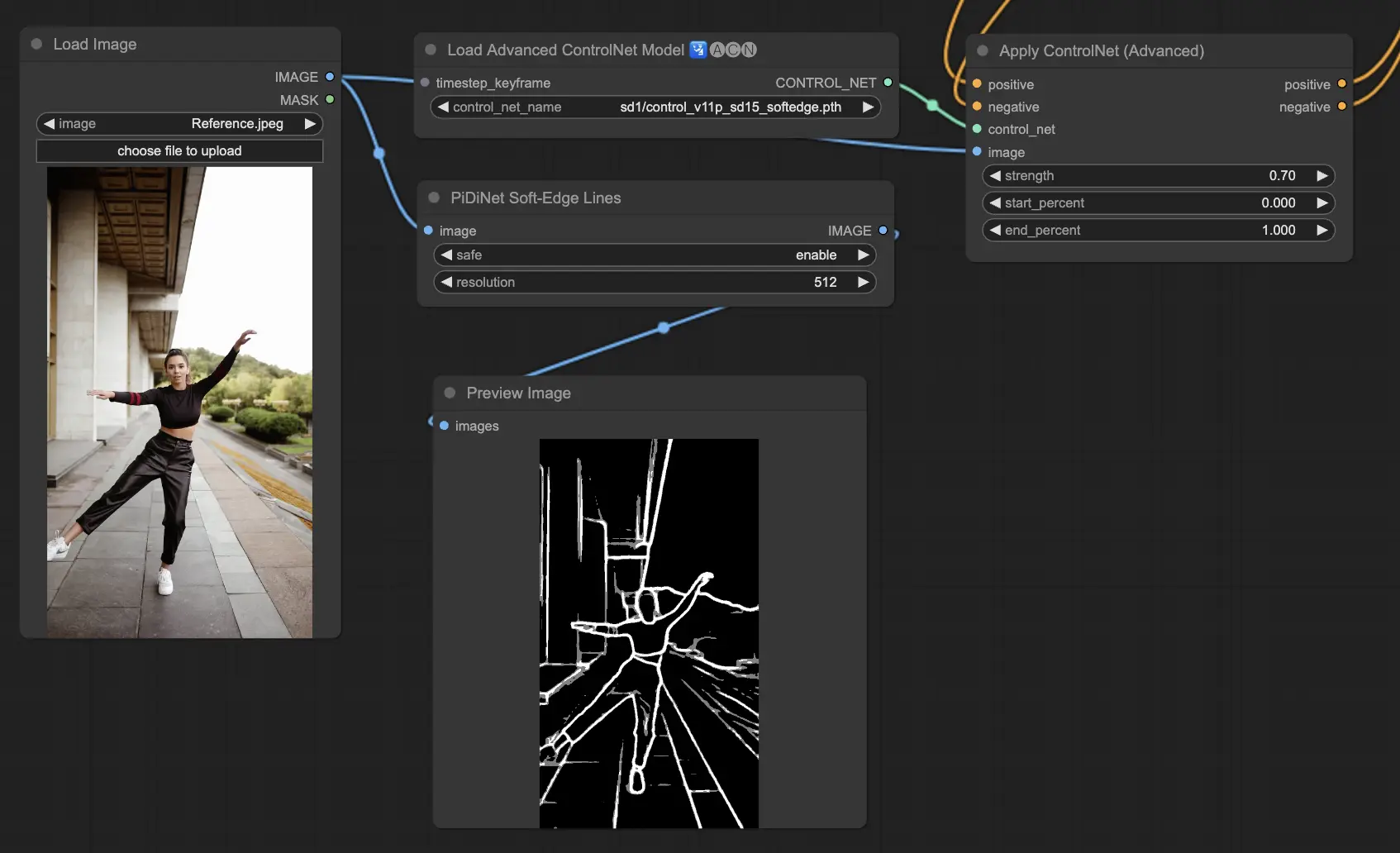

5.12. ComfyUI ControlNet Soft Edge

ControlNet Soft Edge è progettato per generare immagini con bordi più morbidi, concentrandosi sul controllo dei dettagli e sull'aspetto naturale. Utilizza tecniche avanzate di rete neurale per una manipolazione precisa delle immagini, offrendo una maggiore libertà creativa e capacità di fusione senza soluzione di continuità

Robustezza: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Massima qualità del risultato: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Considerando il compromesso, consigliamo di utilizzare SoftEdge_PIDI per impostazione predefinita. Nella maggior parte dei casi funziona molto bene.

Preprocessori: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

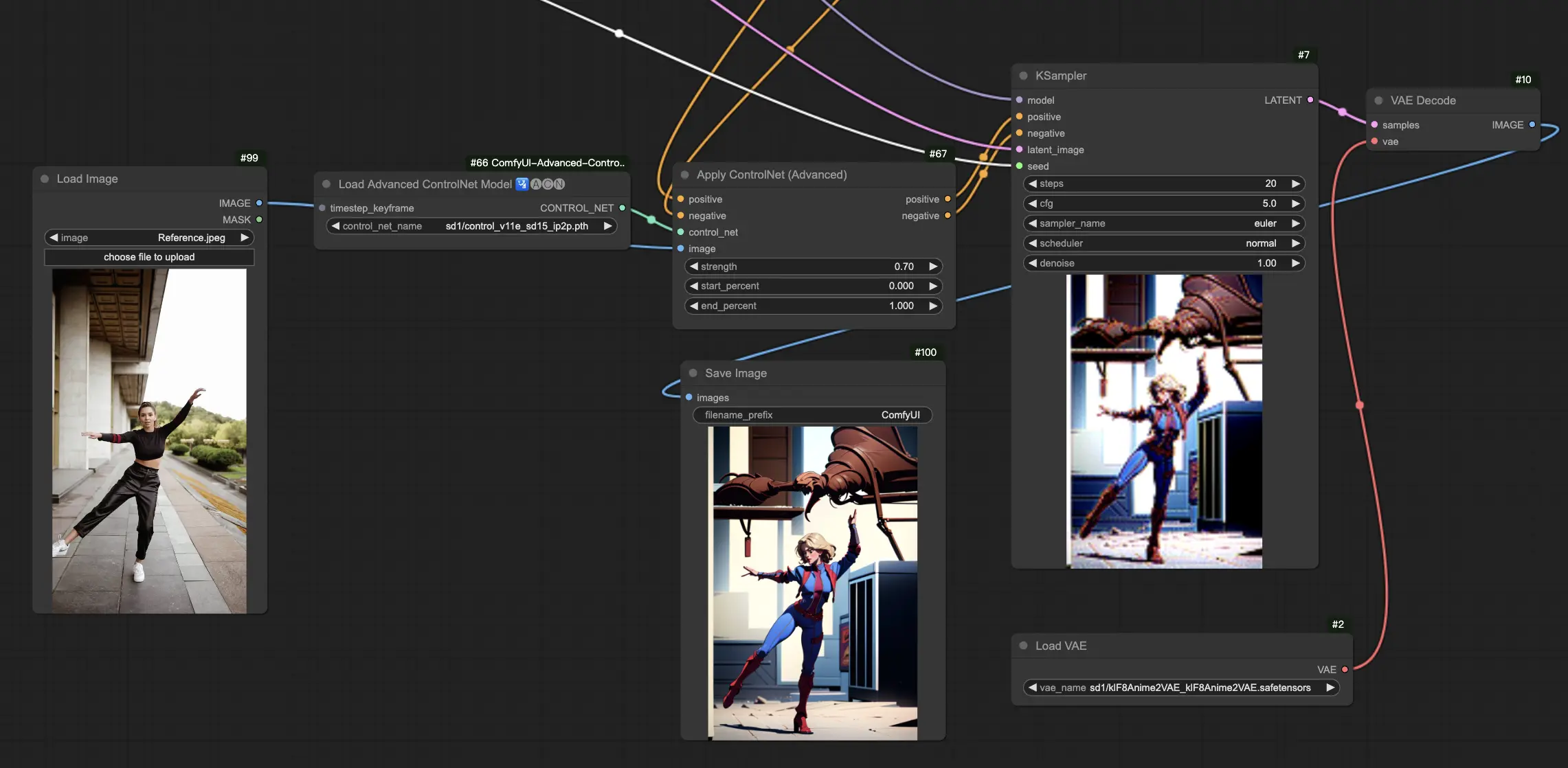

5.13. ComfyUI ControlNet IP2P (Instruct Pix2Pix)

Il modello ControlNet IP2P (Instruct Pix2Pix) si distingue come un adattamento unico all'interno del framework ControlNet, progettato per sfruttare il set di dati Instruct Pix2Pix per le trasformazioni delle immagini. Questa variante di ControlNet si differenzia bilanciando i prompt di istruzione e i prompt di descrizione durante la fase di addestramento. A differenza dell'approccio convenzionale in Instruct Pix2Pix ufficiale, ControlNet IP2P incorpora una miscela 50/50 di questi tipi di prompt, migliorando la sua versatilità ed efficacia nel generare i risultati desiderati.

5.14. ComfyUI T2I Adapter

t2iadapter color: Il modello t2iadapter_color è specificamente progettato per migliorare la rappresentazione e l'accuratezza del colore nelle immagini generate quando si utilizzano modelli di diffusione da testo a immagine. Concentrandosi sull'adattamento del colore, questo modello consente una tavolozza di colori più accurata e vibrante, strettamente allineata con le descrizioni fornite nei prompt testuali. È particolarmente utile per progetti in cui la fedeltà e la specificità del colore sono cruciali, aggiungendo un nuovo livello di realismo e dettaglio alle immagini generate.

t2iadapter style: Il modello t2iadapter_style si concentra sugli aspetti stilistici della generazione delle immagini, consentendo la modifica e il controllo dello stile artistico delle immagini di output. Questo adattatore consente agli utenti di guidare il modello da testo a immagine verso la generazione di immagini che aderiscono a specifici stili artistici o estetiche descritte nei prompt testuali. È uno strumento prezioso per i progetti creativi in cui lo stile dell'immagine gioca un ruolo fondamentale, offrendo un modo senza soluzione di continuità per fondere stili artistici tradizionali con le moderne capacità dell'AI.

5.15. Altri ControlNet Popolari di ComfyUI: QRCode Monster e IP-Adapter

Per questi segmenti, dedicheremo articoli separati per fornire un'introduzione approfondita a ciascuno, data la notevole quantità di informazioni che desideriamo condividere.

6. Come Usare Più ComfyUI ControlNet

Usare più ComfyUI ControlNet in ComfyUI comporta un processo di stratificazione o concatenamento di modelli ControlNet per perfezionare la generazione delle immagini con controlli più precisi su vari aspetti come posa, forma, stile e colore.

Quindi, puoi costruire il tuo flusso di lavoro applicando un ControlNet (ad esempio, OpenPose) e poi alimentando il suo output in un altro ControlNet (ad esempio, Canny). Questa applicazione stratificata consente una personalizzazione dettagliata dell'immagine, in cui ogni ControlNet applica le sue trasformazioni o controlli specifici. Il processo consente un controllo raffinato sull'output finale, integrando molteplici aspetti guidati da diversi ControlNet.

🌟🌟🌟 ComfyUI Online - Prova Ora il Workflow di ControlNet 🌟🌟🌟

Se sei interessato a esplorare il workflow di ControlNet, usa il seguente ComfyUI web. È completamente equipaggiato con tutti i nodi e i modelli essenziali, consentendo una creatività fluida senza bisogno di setup manuali. Acquisisci esperienza pratica e familiarizza con le funzionalità di ControlNet ora!

Per workflow ComfyUI più avanzati e premium, visita la nostra 🌟Lista di Workflow ComfyUI🌟

RunComfy è la piattaforma principale ComfyUI che offre ComfyUI online ambiente e servizi, insieme a workflow di ComfyUI con visuali mozzafiato. RunComfy offre anche AI Playground, consentire agli artisti di sfruttare gli ultimi strumenti di AI per creare arte incredibile.