ComfyUI FLUX: Guia de Configuração, Workflows como FLUX-ControlNet, FLUX-LoRA e FLUX-IPAdapter... e Acesso Online

Updated: 8/26/2024

Olá, entusiastas de IA! 👋 Bem-vindos ao nosso guia introdutório sobre o uso do FLUX no ComfyUI. FLUX é um modelo de ponta desenvolvido pela Black Forest Labs. 🌟 Neste tutorial, mergulharemos nos fundamentos do ComfyUI FLUX, mostrando como este poderoso modelo pode aprimorar seu processo criativo e ajudá-lo a expandir os limites da arte gerada por IA. 🚀

Vamos cobrir:

1. Introdução ao FLUX

2. Diferentes Versões do FLUX

3. Requisitos de Hardware para FLUX

- 3.1. Requisitos de Hardware para FLUX.1 [Pro]

- 3.2. Requisitos de Hardware para FLUX.1 [Dev]

- 3.3. Requisitos de Hardware para FLUX.1 [Schnell]

4. Como instalar o FLUX no ComfyUI

- 4.1. Instalando ou Atualizando o ComfyUI

- 4.2. Baixando Codificadores de Texto ComfyUI FLUX e Modelos CLIP

- 4.3. Baixando o Modelo VAE FLUX.1

- 4.4. Baixando o Modelo UNET FLUX.1

5. Workflow ComfyUI FLUX | Download, Acesso Online e Guia

- 5.1. Workflow ComfyUI: FLUX Txt2Img

- 5.2. Workflow ComfyUI: FLUX Img2Img

- 5.3. Workflow ComfyUI: FLUX LoRA

- 5.4. Workflow ComfyUI: FLUX ControlNet

- 5.5. Workflow ComfyUI: FLUX Inpainting

- 5.6. Workflow ComfyUI: FLUX NF4 & Upscale

- 5.7. Workflow ComfyUI: FLUX IPAdapter

- 5.8. Workflow ComfyUI: Flux LoRA Trainer

- 5.9. Workflow ComfyUI: Flux Latent Upscale

1. Introdução ao FLUX

FLUX.1, o modelo de IA de ponta da Black Forest Labs, está revolucionando a forma como criamos imagens a partir de descrições de texto. Com sua capacidade incomparável de gerar imagens incrivelmente detalhadas e complexas que correspondem de perto aos prompts de entrada, o FLUX.1 se destaca da concorrência. O segredo do sucesso do FLUX.1 reside em sua arquitetura híbrida única, que combina diferentes tipos de blocos de transformadores e é alimentada por impressionantes 12 bilhões de parâmetros. Isso permite que o FLUX.1 produza imagens visualmente cativantes que representam com precisão as descrições de texto com notável precisão.

Um dos aspectos mais emocionantes do FLUX.1 é sua versatilidade em gerar imagens em vários estilos, desde fotorealísticos até artísticos. O FLUX.1 até possui a notável capacidade de incorporar texto perfeitamente dentro das imagens geradas, uma façanha que muitos outros modelos têm dificuldade em alcançar. Além disso, o FLUX.1 é conhecido por sua excepcional aderência ao prompt, lidando facilmente com descrições simples e complexas. Isso levou o FLUX.1 a ser frequentemente comparado a outros modelos bem conhecidos, como Stable Diffusion e Midjourney, com o FLUX.1 frequentemente emergindo como a escolha preferida devido à sua natureza amigável ao usuário e resultados de alta qualidade.

As impressionantes capacidades do FLUX.1 o tornam uma ferramenta inestimável para uma ampla gama de aplicações, desde a criação de conteúdo visual deslumbrante e a inspiração de designs inovadores até a facilitação da visualização científica. A capacidade do FLUX.1 de gerar imagens altamente detalhadas e precisas a partir de descrições de texto abre um mundo de possibilidades para profissionais criativos, pesquisadores e entusiastas. À medida que o campo da imagem gerada por IA continua a evoluir, o FLUX.1 está na vanguarda, estabelecendo um novo padrão de qualidade, versatilidade e facilidade de uso.

A Black Forest Labs, a empresa de IA pioneira por trás do revolucionário FLUX.1, foi fundada por Robin Rombach, uma figura renomada na indústria de IA que anteriormente foi membro central da Stability AI. Se você está ansioso para saber mais sobre a Black Forest Labs e seu trabalho revolucionário com o FLUX.1, não deixe de visitar o site oficial em https://blackforestlabs.ai/.

2. Diferentes Versões do FLUX

FLUX.1 vem em três versões diferentes, cada uma projetada para atender a necessidades específicas dos usuários:

- FLUX.1 [pro]: Esta é a versão topo de linha que oferece a melhor qualidade e desempenho, perfeita para uso profissional e projetos de alto nível.

- FLUX.1 [dev]: Otimizada para uso não comercial, esta versão mantém alta qualidade de saída enquanto é mais eficiente, tornando-a ótima para desenvolvedores e entusiastas.

- FLUX.1 [schnell]: Esta versão é focada em velocidade e leveza, tornando-a perfeita para desenvolvimento local e projetos pessoais. Também é de código aberto e está disponível sob a licença Apache 2.0, sendo acessível para uma ampla gama de usuários.

| Nome | Repositório HuggingFace | Licença | md5sum |

FLUX.1 [pro] | Disponível apenas em nossa API. | ||

FLUX.1 [dev] | https://huggingface.co/black-forest-labs/FLUX.1-dev | FLUX.1-dev Non-Commercial License | a6bd8c16dfc23db6aee2f63a2eba78c0 |

FLUX.1 [schnell] | https://huggingface.co/black-forest-labs/FLUX.1-schnell | apache-2.0 | a9e1e277b9b16add186f38e3f5a34044 |

3. Requisitos de Hardware para FLUX

3.1. FLUX.1 [Pro] Requisitos de Hardware

- GPU Recomendado: NVIDIA RTX 4090 ou equivalente com 24 GB ou mais de VRAM. O modelo é otimizado para GPUs de alto desempenho para lidar com suas operações complexas.

- RAM: 32 GB ou mais de memória do sistema.

- Espaço em Disco: Aproximadamente 30 GB.

- Requisitos de Computação: Alta precisão é necessária; use FP16 (meia precisão) para evitar erros de falta de memória. Para melhores resultados, sugere-se usar a variante do modelo Clip

fp16para máxima qualidade. - Outros Requisitos: Um SSD rápido é recomendado para tempos de carregamento mais rápidos e desempenho geral.

3.2. FLUX.1 [Dev] Requisitos de Hardware

- GPU Recomendado: NVIDIA RTX 3080/3090 ou equivalente com pelo menos 16 GB de VRAM. Esta versão é um pouco mais tolerante em relação ao hardware em comparação com o modelo Pro, mas ainda requer um poder substancial de GPU.

- RAM: 16 GB ou mais de memória do sistema.

- Espaço em Disco: Aproximadamente 25 GB.

- Requisitos de Computação: Semelhante ao Pro, use modelos FP16, mas com uma ligeira tolerância para cálculos de precisão mais baixa. Pode usar modelos Clip

fp16oufp8com base nas capacidades da GPU. - Outros Requisitos: Um SSD rápido é recomendado para desempenho ideal.

3.3. FLUX.1 [Schnell] Requisitos de Hardware

- GPU Recomendado: NVIDIA RTX 3060/4060 ou equivalente com 12 GB de VRAM. Esta versão é otimizada para inferência mais rápida e menores exigências de hardware.

- RAM: 8 GB ou mais de memória do sistema.

- Espaço em Disco: Aproximadamente 15 GB.

- Requisitos de Computação: Esta versão é menos exigente e permite cálculos

fp8se a memória estiver esgotada. Foi projetada para ser rápida e eficiente, com foco na velocidade em vez de qualidade ultra-alta. - Outros Requisitos: SSD é útil, mas não tão crítico quanto nas versões Pro e Dev.

4. Como instalar o FLUX no ComfyUI

4.1. Instalando ou Atualizando o ComfyUI

Para usar efetivamente o FLUX.1 dentro do ambiente ComfyUI, é crucial garantir que você tenha a versão mais recente do ComfyUI instalada. Esta versão suporta os recursos e integrações necessários para os modelos FLUX.1.

4.2. Baixando Codificadores de Texto ComfyUI FLUX e Modelos CLIP

Para desempenho ideal e geração precisa de texto para imagem usando o FLUX.1, você precisará baixar codificadores de texto específicos e modelos CLIP. Os seguintes modelos são essenciais, dependendo do hardware do seu sistema:

| Nome do Arquivo do Modelo | Tamanho | Nota | Link |

t5xxl_fp16.safetensors | 9.79 GB | Para melhores resultados, se você tiver alta VRAM e RAM (mais de 32GB de RAM). | Download |

t5xxl_fp8_e4m3fn.safetensors | 4.89 GB | Para menor uso de memória (8-12GB) | Download |

clip_l.safetensors | 246 MB | Download |

Passos para Baixar e Instalar:

- Baixe o modelo

clip_l.safetensors. - Dependendo da VRAM e RAM do seu sistema, baixe

t5xxl_fp8_e4m3fn.safetensors(para menor VRAM) out5xxl_fp16.safetensors(para maior VRAM e RAM). - Coloque os modelos baixados no diretório

ComfyUI/models/clip/. Nota: Se você já usou SD 3 Medium, pode ser que já tenha esses modelos.

4.3. Baixando o Modelo VAE FLUX.1

O modelo Variational Autoencoder (VAE) é crucial para melhorar a qualidade da geração de imagem no FLUX.1. O seguinte modelo VAE está disponível para download:

| Nome do Arquivo | Tamanho | Link |

ae.safetensors | 335 MB | Download(opens in a new tab) |

Passos para Baixar e Instalar :

- Baixe o arquivo de modelo

ae.safetensors. - Coloque o arquivo baixado no diretório

ComfyUI/models/vae. - Para facilitar a identificação, recomenda-se renomear o arquivo para

flux_ae.safetensors.

4.4. Baixando o Modelo UNET FLUX.1

O modelo UNET é a espinha dorsal para a síntese de imagens no FLUX.1. Dependendo das especificações do seu sistema, você pode escolher entre diferentes variantes:

| Nome do Arquivo | Tamanho | Link | Nota |

flux1-dev.safetensors | 23.8GB | Download | Se você tiver alta VRAM e RAM. |

flux1-schnell.safetensors | 23.8GB | Download | Para menor uso de memória |

Passos para Baixar e Instalar:

- Baixe o modelo UNET apropriado com base na configuração de memória do seu sistema.

- Coloque o arquivo de modelo baixado no diretório

ComfyUI/models/unet/.

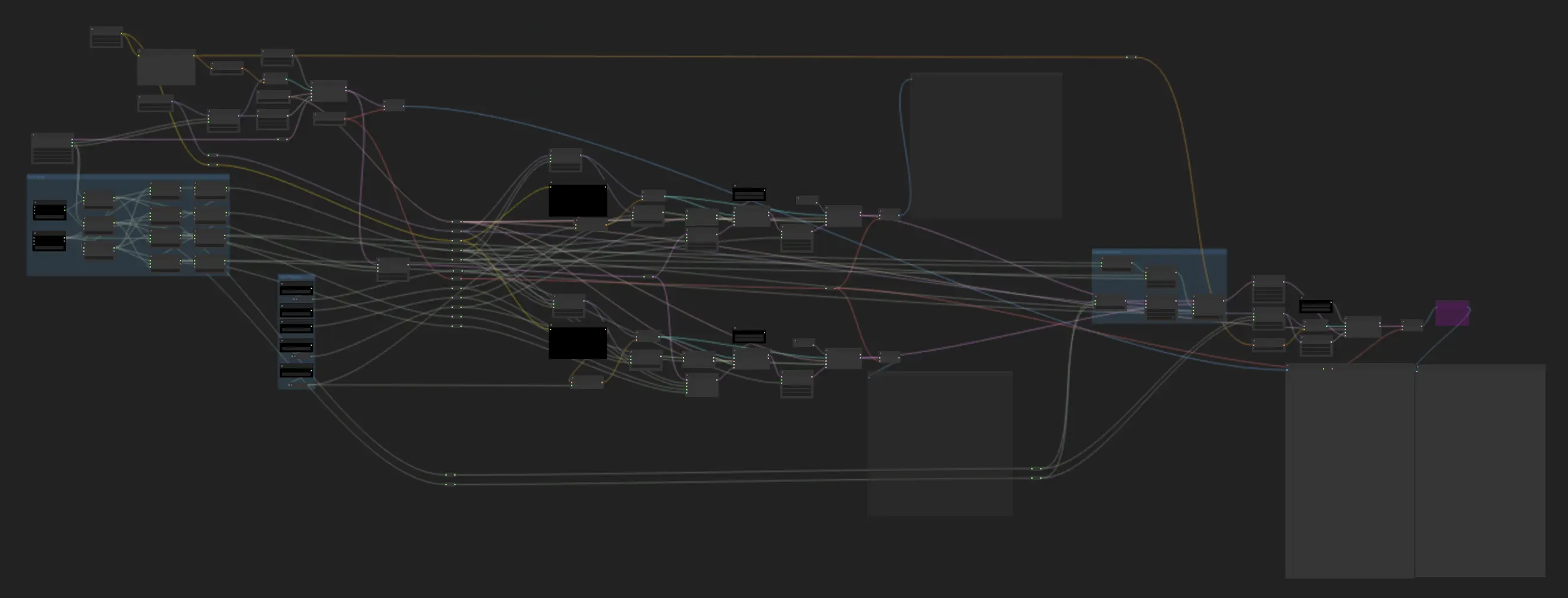

5. Workflow ComfyUI FLUX | Download, Acesso Online e Guia

Continuaremos atualizando o Workflow ComfyUI FLUX para fornecer a você os workflows mais recentes e abrangentes para gerar imagens deslumbrantes usando o ComfyUI FLUX.

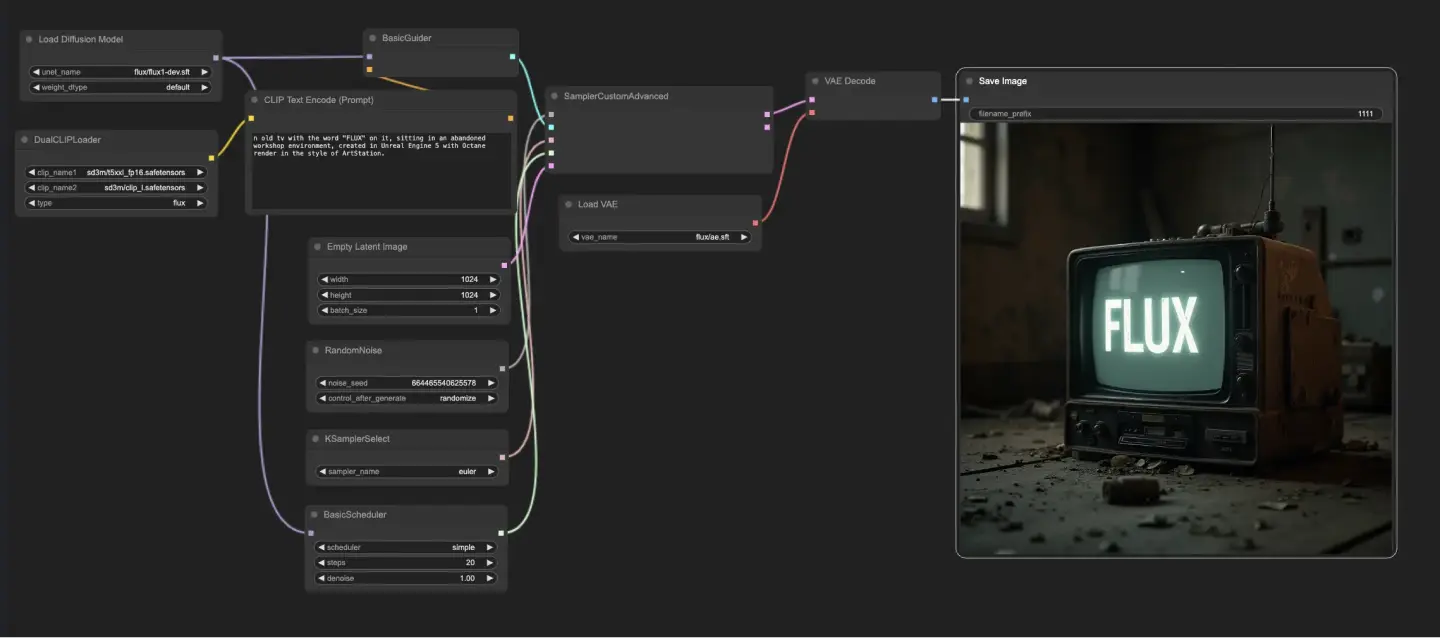

5.1. Workflow ComfyUI: FLUX Txt2Img

5.1.1. ComfyUI FLUX Txt2Img : Download

5.1.2. ComfyUI FLUX Txt2Img Versão Online: ComfyUI FLUX Txt2Img

Na Plataforma RunComfy, nossa versão online pré-carrega todos os modos e nós necessários para você. Além disso, oferecemos máquinas com GPUs de alto desempenho, garantindo que você possa desfrutar da experiência ComfyUI FLUX Txt2Img sem esforço.

5.1.3. Explicação do ComfyUI FLUX Txt2Img:

O workflow ComfyUI FLUX Txt2Img começa carregando os componentes essenciais, incluindo o FLUX UNET (UNETLoader), o FLUX CLIP (DualCLIPLoader) e o FLUX VAE (VAELoader). Esses formam a base do processo de geração de imagens ComfyUI FLUX.

- UNETLoader: Carrega o modelo UNET para a geração de imagens.

- Checkpoint: flux/flux1-schnell.sft; flux/flux1-dev.sft

- DualCLIPLoader: Carrega o modelo CLIP para codificação de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupamento: A estratégia de agrupamento para o modelo CLIP é flux

- VAELoader: Carrega o modelo Variational Autoencoder (VAE) para decodificação de representações latentes.

- Modelo VAE: flux/ae.sft

O prompt de texto, que descreve a saída desejada, é codificado usando o CLIPTextEncode. Este nó pega o prompt de texto como entrada e gera a codificação de texto condicionada, que guia o ComfyUI FLUX durante a geração.

Para iniciar o processo de geração ComfyUI FLUX, é criada uma representação latente vazia usando o EmptyLatentImage. Isso serve como ponto de partida para o ComfyUI FLUX construir.

O BasicGuider desempenha um papel crucial na orientação do processo de geração ComfyUI FLUX. Ele pega a codificação de texto condicionada e o FLUX UNET carregado como entradas, garantindo que a saída gerada esteja alinhada com a descrição fornecida no texto.

O KSamplerSelect permite que você escolha o método de amostragem para a geração ComfyUI FLUX, enquanto o RandomNoise gera ruído aleatório como entrada para o ComfyUI FLUX. O BasicScheduler agenda os níveis de ruído (sigmas) para cada etapa do processo de geração, controlando o nível de detalhe e clareza na saída final.

O SamplerCustomAdvanced reúne todos os componentes do workflow ComfyUI FLUX Txt2Img. Ele pega o ruído aleatório, o guia, o amostrador selecionado, os sigmas agendados e a representação latente vazia como entradas. Através de um processo de amostragem avançado, ele gera uma representação latente que representa o prompt de texto.

Finalmente, o VAEDecode decodifica a representação latente gerada na saída final usando o FLUX VAE carregado. O SaveImage permite que você salve a saída gerada em um local especificado, preservando a criação impressionante possibilitada pelo workflow ComfyUI FLUX Txt2Img.

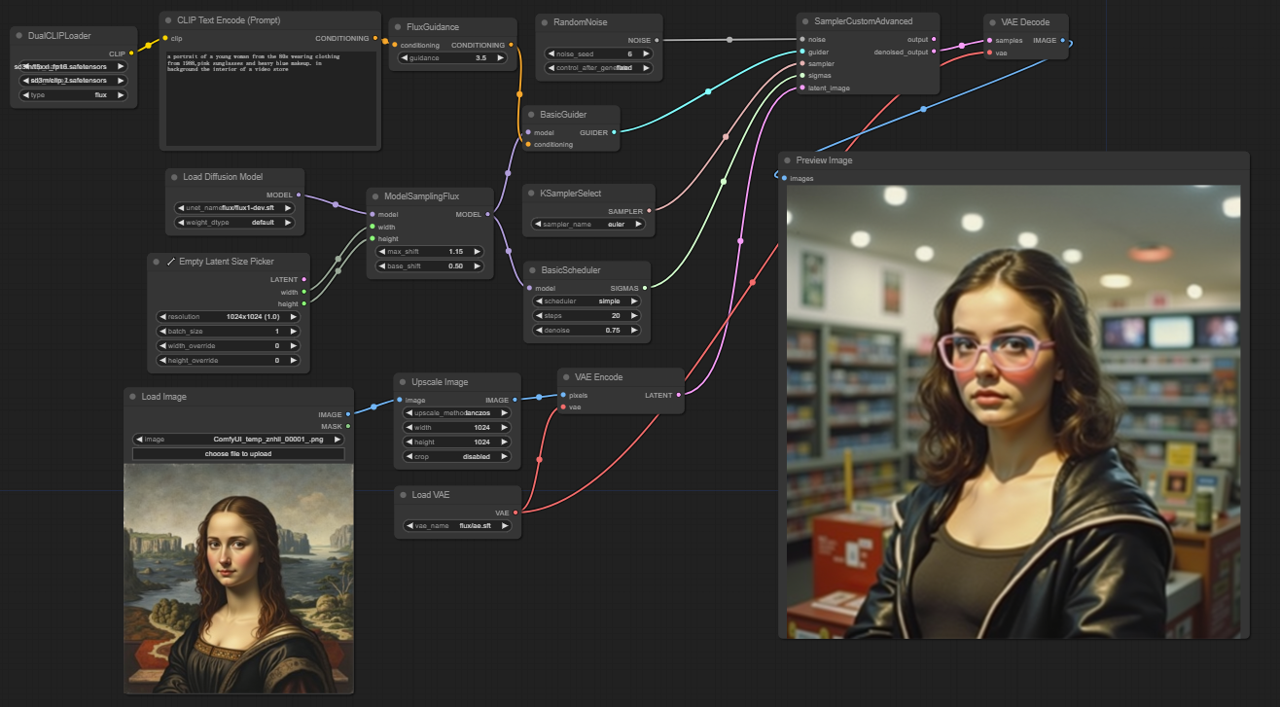

5.2. Workflow ComfyUI: FLUX Img2Img

5.2.1. ComfyUI FLUX Img2Img: Download

5.2.2. ComfyUI FLUX Img2Img Versão Online: ComfyUI FLUX Img2Img

Na Plataforma RunComfy, nossa versão online pré-carrega todos os modos e nós necessários para você. Além disso, oferecemos máquinas com GPUs de alto desempenho, garantindo que você possa desfrutar da experiência ComfyUI FLUX Img2Img sem esforço.

5.2.3. Explicação do ComfyUI FLUX Img2Img:

O workflow ComfyUI FLUX Img2Img baseia-se no poder do ComfyUI FLUX para gerar saídas com base em ambos os prompts de texto e representações de entrada. Ele começa carregando os componentes necessários, incluindo o modelo CLIP (DualCLIPLoader), o modelo UNET (UNETLoader) e o modelo VAE (VAELoader).

- UNETLoader: Carrega o modelo UNET para a geração de imagens.

- Checkpoint: flux/flux1-schnell.sft; flux/flux1-dev.sft

- DualCLIPLoader: Carrega o modelo CLIP para codificação de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupamento: A estratégia de agrupamento para o modelo CLIP é flux

- VAELoader: Carrega o modelo Variational Autoencoder (VAE) para decodificação de representações latentes.

- Modelo VAE: flux/ae.sft

A representação de entrada, que serve como ponto de partida para o processo ComfyUI FLUX Img2Img, é carregada usando o LoadImage. O ImageScale então escala a representação de entrada para o tamanho desejado, garantindo a compatibilidade com o ComfyUI FLUX.

A representação de entrada escalada passa por codificação usando o VAEEncode, convertendo-a em uma representação latente. Esta representação latente captura os recursos e detalhes essenciais da entrada, fornecendo uma base para o ComfyUI FLUX trabalhar.

O prompt de texto, descrevendo as modificações ou melhorias desejadas na entrada, é codificado usando o CLIPTextEncode. O FluxGuidance então aplica orientação ao condicionamento com base na escala de orientação especificada, influenciando a força da influência do prompt de texto na saída final.

O ModelSamplingFlux define os parâmetros de amostragem para o ComfyUI FLUX, incluindo a reamostragem do passo de tempo, a proporção de padding e as dimensões da saída. Esses parâmetros controlam a granularidade e a resolução da saída gerada.

O KSamplerSelect permite que você escolha o método de amostragem para a geração ComfyUI FLUX, enquanto o BasicGuider orienta o processo de geração com base no condicionamento de texto codificado e no FLUX UNET carregado.

Ruído aleatório é gerado usando o RandomNoise, e o BasicScheduler agenda os níveis de ruído (sigmas) para cada etapa do processo de geração. Esses componentes introduzem variações controladas e ajustam os detalhes na saída final.

O SamplerCustomAdvanced reúne o ruído aleatório, o guia, o amostrador selecionado, os sigmas agendados e a representação latente da entrada. Através de um processo de amostragem avançado, ele gera uma representação latente que incorpora as modificações especificadas pelo prompt de texto, preservando os recursos essenciais da entrada.

Finalmente, o VAEDecode decodifica a representação latente denoised na saída final usando o FLUX VAE carregado. O PreviewImage exibe uma pré-visualização da saída gerada, mostrando os resultados impressionantes alcançados pelo workflow ComfyUI FLUX Img2Img.

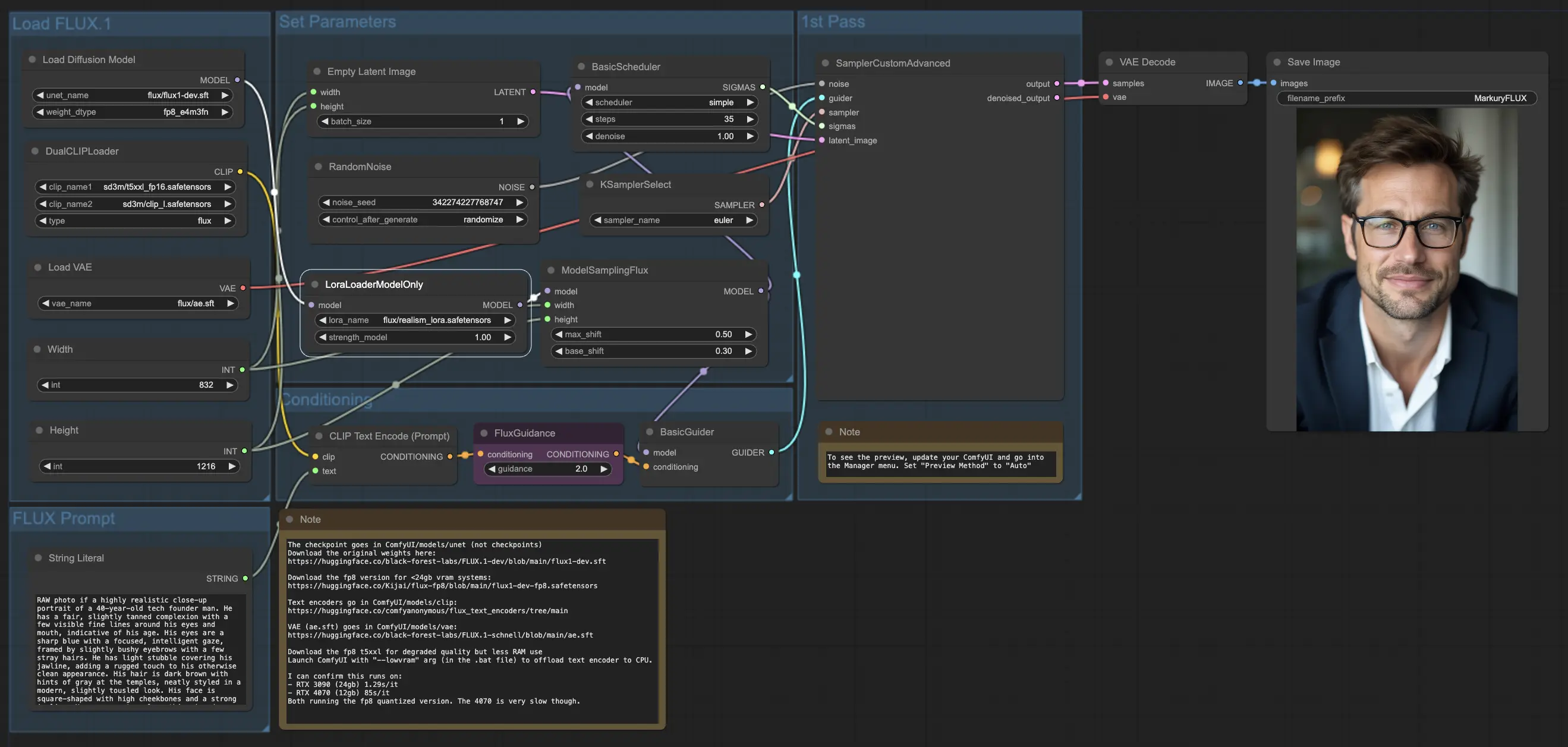

5.3. Workflow ComfyUI: FLUX LoRA

5.3.1. ComfyUI FLUX LoRA: Download

5.3.2. ComfyUI FLUX LoRA Versão Online: ComfyUI FLUX LoRA

Na Plataforma RunComfy, nossa versão online pré-carrega todos os modos e nós necessários para você. Além disso, oferecemos máquinas com GPUs de alto desempenho, garantindo que você possa desfrutar da experiência ComfyUI FLUX LoRA sem esforço.

5.3.3. Explicação do ComfyUI FLUX LoRA:

O workflow ComfyUI FLUX LoRA aproveita o poder da Adaptação de Baixa Classificação (LoRA) para aprimorar o desempenho do ComfyUI FLUX. Ele começa carregando os componentes necessários, incluindo o modelo UNET (UNETLoader), o modelo CLIP (DualCLIPLoader), o modelo VAE (VAELoader) e o modelo LoRA (LoraLoaderModelOnly).

- UNETLoader: Carrega o modelo UNET para a geração de imagens.

- Checkpoint: flux/flux1-dev.sft

- DualCLIPLoader: Carrega o modelo CLIP para codificação de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupamento: A estratégia de agrupamento para o modelo CLIP é flux

- VAELoader: Carrega o modelo Variational Autoencoder (VAE) para decodificação de representações latentes.

- Modelo VAE: flux/ae.sft

- LoraLoaderModelOnly: Carrega o modelo LoRA (Adaptação de Baixa Classificação) para aprimorar o modelo UNET.

- ModeloLoader: flux/realism_lora.safetensors

O prompt de texto, que descreve a saída desejada, é especificado usando o String Literal. O CLIPTextEncode então codifica o prompt de texto, gerando o condicionamento de texto codificado que guia o processo de geração ComfyUI FLUX.

O FluxGuidance aplica orientação ao condicionamento de texto codificado, influenciando a força e a direção da aderência do ComfyUI FLUX ao prompt de texto.

Uma representação latente vazia, servindo como ponto de partida para a geração, é criada usando o EmptyLatentImage. A largura e a altura da saída gerada são especificadas usando o Int Literal, garantindo as dimensões desejadas do resultado final.

O ModelSamplingFlux define os parâmetros de amostragem para o ComfyUI FLUX, incluindo a proporção de padding e a reamostragem do passo de tempo. Esses parâmetros controlam a resolução e a granularidade da saída gerada.

O KSamplerSelect permite que você escolha o método de amostragem para a geração ComfyUI FLUX, enquanto o BasicGuider orienta o processo de geração com base no condicionamento de texto codificado e no FLUX UNET carregado aprimorado com o FLUX LoRA.

Ruído aleatório é gerado usando o RandomNoise, e o BasicScheduler agenda os níveis de ruído (sigmas) para cada etapa do processo de geração. Esses componentes introduzem variações controladas e ajustam os detalhes na saída final.

O SamplerCustomAdvanced reúne o ruído aleatório, o guia, o amostrador selecionado, os sigmas agendados e a representação latente vazia. Através de um processo de amostragem avançado, ele gera uma representação latente que representa o prompt de texto, aproveitando o poder do FLUX e do aprimoramento FLUX LoRA.

Finalmente, o VAEDecode decodifica a representação latente gerada na saída final usando o FLUX VAE carregado. O SaveImage permite que você salve a saída gerada em um local especificado, preservando a criação impressionante possibilitada pelo workflow ComfyUI FLUX LoRA.

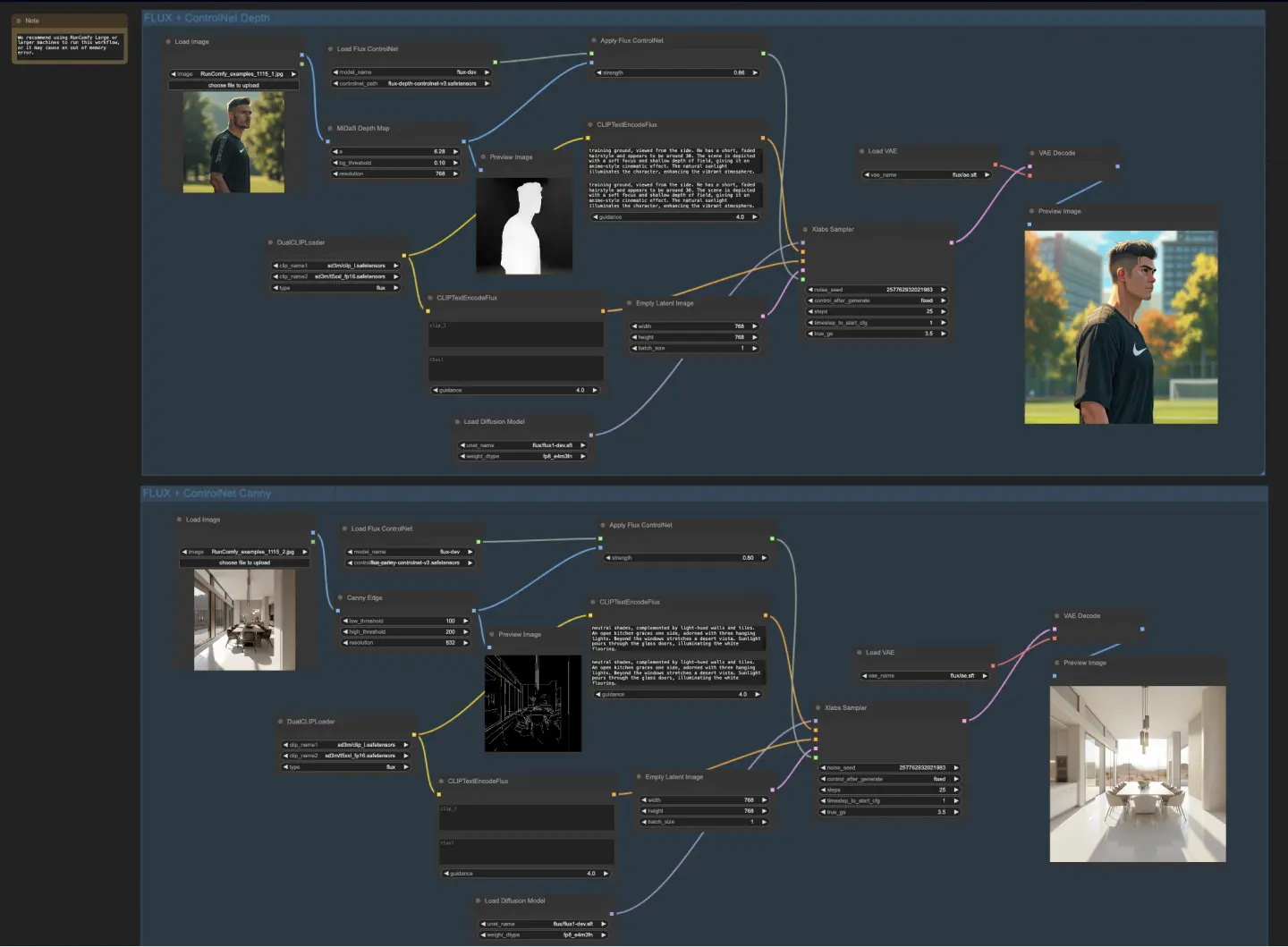

5.4. Workflow ComfyUI: FLUX ControlNet

5.4.1. ComfyUI FLUX ControlNet: Download

5.4.2. ComfyUI FLUX ControlNet Versão Online: ComfyUI FLUX ControlNet

Na Plataforma RunComfy, nossa versão online pré-carrega todos os modos e nós necessários para você. Além disso, oferecemos máquinas com GPUs de alto desempenho, garantindo que você possa desfrutar da experiência ComfyUI FLUX ControlNet sem esforço.

5.4.3. Explicação do ComfyUI FLUX ControlNet:

O workflow ComfyUI FLUX ControlNet demonstra a integração do ControlNet com o ComfyUI FLUX para geração de saída aprimorada. O workflow mostra dois exemplos: condicionamento baseado em profundidade e condicionamento baseado em borda de Canny.

- UNETLoader: Carrega o modelo UNET para a geração de imagens.

- Checkpoint: flux/flux1-dev.sft

- DualCLIPLoader: Carrega o modelo CLIP para codificação de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupamento: A estratégia de agrupamento para o modelo CLIP é flux

- VAELoader: Carrega o modelo Variational Autoencoder (V

AE) para decodificação de representações latentes.

- Modelo VAE: flux/ae.sft

No workflow baseado em profundidade, a representação de entrada passa por pré-processamento usando o MiDaS-DepthMapPreprocessor, gerando um mapa de profundidade. O mapa de profundidade é então passado pelo ApplyFluxControlNet (Depth) juntamente com o FLUX ControlNet carregado para condicionamento de profundidade. A condição resultante do FLUX ControlNet serve como entrada para o XlabsSampler (Depth), juntamente com o FLUX UNET carregado, condicionamento de texto codificado, condicionamento de texto negativo e representação latente vazia. O XlabsSampler gera uma representação latente com base nessas entradas, que é subsequentemente decodificada na saída final usando o VAEDecode.

- MiDaS-DepthMapPreprocessor (Depth): Pré-processa a imagem de entrada para estimativa de profundidade usando MiDaS.

- LoadFluxControlNet: Carrega o modelo ControlNet.

- Caminho: flux-depth-controlnet.safetensors

Da mesma forma, no workflow baseado em borda de Canny, a representação de entrada passa por pré-processamento usando o CannyEdgePreprocessor para gerar bordas de Canny. A representação de borda de Canny é passada pelo ApplyFluxControlNet (Canny) juntamente com o FLUX ControlNet carregado para condicionamento de borda de Canny. A condição resultante do FLUX ControlNet serve como entrada para o XlabsSampler (Canny), juntamente com o FLUX UNET carregado, condicionamento de texto codificado, condicionamento de texto negativo e representação latente vazia. O XlabsSampler gera uma representação latente com base nessas entradas, que é então decodificada na saída final usando o VAEDecode.

- CannyEdgePreprocessor (Canny): Pré-processa a imagem de entrada para detecção de borda de Canny.

- LoadFluxControlNet: Carrega o modelo ControlNet.

- Caminho: flux-canny-controlnet.safetensors

O workflow ComfyUI FLUX ControlNet incorpora nós para carregar os componentes necessários (DualCLIPLoader, UNETLoader, VAELoader, LoadFluxControlNet), codificar prompts de texto (CLIPTextEncodeFlux), criar representações latentes vazias (EmptyLatentImage) e visualizar as saídas geradas e pré-processadas (PreviewImage).

Ao aproveitar o poder do FLUX ControlNet, o workflow ComfyUI FLUX ControlNet permite a geração de saídas que se alinham com condicionamentos específicos, como mapas de profundidade ou bordas de Canny. Esse nível adicional de controle e orientação aprimora a flexibilidade e precisão do processo de geração, permitindo a criação de saídas deslumbrantes e contextualmente relevantes usando o ComfyUI FLUX.

5.5. Workflow ComfyUI: FLUX Inpainting

5.5.1. ComfyUI FLUX Inpainting: Download

5.5.2. ComfyUI FLUX Inpainting Versão Online: ComfyUI FLUX Inpainting

Na Plataforma RunComfy, nossa versão online pré-carrega todos os modos e nós necessários para você. Além disso, oferecemos máquinas com GPUs de alto desempenho, garantindo que você possa desfrutar da experiência ComfyUI FLUX Inpainting sem esforço.

5.5.3. Explicação do ComfyUI FLUX Inpainting:

O workflow ComfyUI FLUX Inpainting demonstra a capacidade do ComfyUI FLUX de realizar inpainting, que envolve preencher regiões ausentes ou mascaradas de uma saída com base no contexto circundante e nos prompts de texto fornecidos. O workflow começa carregando os componentes necessários, incluindo o modelo UNET (UNETLoader), o modelo VAE (VAELoader) e o modelo CLIP (DualCLIPLoader).

- UNETLoader: Carrega o modelo UNET para a geração de imagens.

- Checkpoint: flux/flux1-schnell.sft; flux/flux1-dev.sft

- DualCLIPLoader: Carrega o modelo CLIP para codificação de texto.

- Modelo de Embedding 1: sd3m/t5xxl_fp8_e4m3fn.safetensors; sd3m/t5xxl_fp16.safetensors

- Modelo de Embedding 2: sd3m/clip_g.safetensors; sd3m/clip_l.safetensors

- Agrupamento: A estratégia de agrupamento para o modelo CLIP é flux

- VAELoader: Carrega o modelo Variational Autoencoder (VAE) para decodificação de representações latentes.

- Modelo VAE: flux/ae.sft

Os prompts de texto positivos e negativos, que descrevem o conteúdo e estilo desejados para a região preenchida, são codificados usando os CLIPTextEncodes. O condicionamento de texto positivo é ainda orientado usando o FluxGuidance para influenciar o processo de inpainting do ComfyUI FLUX.

A representação de entrada e a máscara são carregadas e redimensionadas usando o LoadAndResizeImage, garantindo a compatibilidade com os requisitos do ComfyUI FLUX. O ImpactGaussianBlurMask aplica desfoque gaussiano à máscara, criando uma transição mais suave entre a região preenchida e a representação original.

O InpaintModelConditioning prepara o condicionamento para o inpainting FLUX combinando o condicionamento de texto positivo orientado, condicionamento de texto negativo codificado, VAE FLUX carregado, representação de entrada carregada e redimensionada e máscara desfocada. Esse condicionamento serve como base para o processo de inpainting do ComfyUI FLUX.

Ruído aleatório é gerado usando o RandomNoise, e o método de amostragem é selecionado usando o KSamplerSelect. O BasicScheduler agenda os níveis de ruído (sigmas) para o processo de inpainting do ComfyUI FLUX, controlando o nível de detalhe e clareza na região preenchida.

O BasicGuider orienta o processo de inpainting do ComfyUI FLUX com base no condicionamento preparado e no FLUX UNET carregado. O SamplerCustomAdvanced realiza o processo de amostragem avançado, pegando o ruído gerado, o guia, o amostrador selecionado, os sigmas agendados e a representação latente da entrada como entradas. Ele gera a representação latente preenchida.

Finalmente, o VAEDecode decodifica a representação latente preenchida na saída final, mesclando perfeitamente a região preenchida com a representação original. O PreviewImage exibe a saída final, mostrando as impressionantes capacidades de inpainting do FLUX.

Ao aproveitar o poder do FLUX e o workflow de inpainting cuidadosamente projetado, o FLUX Inpainting permite a criação de saídas visualmente coerentes e contextualmente relevantes. Seja restaurando partes ausentes, removendo objetos indesejados ou modificando regiões específicas, o workflow de inpainting do ComfyUI FLUX oferece uma ferramenta poderosa para edição e manipulação.

5.6. Workflow ComfyUI: FLUX NF4

5.6.1. ComfyUI FLUX NF4: Download

5.6.2. ComfyUI FLUX NF4 Versão Online: ComfyUI FLUX NF4

Na Plataforma RunComfy, nossa versão online pré-carrega todos os modos e nós necessários para você. Além disso, oferecemos máquinas com GPUs de alto desempenho, garantindo que você possa desfrutar da experiência ComfyUI FLUX NF4 sem esforço.

5.6.3. Explicação do ComfyUI FLUX NF4:

O workflow ComfyUI FLUX NF4 mostra a integração do ComfyUI FLUX com a arquitetura NF4 (Normalizing Flow 4) para geração de saída de alta qualidade. O workflow começa carregando os componentes necessários usando o CheckpointLoaderNF4, que inclui o FLUX UNET, o FLUX CLIP e o FLUX VAE.

- UNETLoader: Carrega o modelo UNET para a geração de imagens.

- Checkpoint: TBD

Os nós PrimitiveNode (height) e PrimitiveNode (width) especificam a altura e a largura desejadas da saída gerada. O nó ModelSamplingFlux define os parâmetros de amostragem para o ComfyUI FLUX com base no FLUX UNET carregado e na altura e largura especificadas.

O nó EmptySD3LatentImage cria uma representação latente vazia como ponto de partida para a geração. O nó BasicScheduler agenda os níveis de ruído (sigmas) para o processo de geração do ComfyUI FLUX.

O nó RandomNoise gera ruído aleatório para o processo de geração do ComfyUI FLUX. O nó BasicGuider orienta o processo de geração com base no ComfyUI FLUX condicionado.

O nó KSamplerSelect seleciona o método de amostragem para a geração do ComfyUI FLUX. O nó SamplerCustomAdvanced realiza o processo de amostragem avançado, pegando o ruído gerado, o guia, o amostrador selecionado, os sigmas agendados e a representação latente vazia como entradas. Ele gera a representação latente gerada.

O nó VAEDecode decodifica a representação latente gerada na saída final usando o FLUX VAE carregado. O nó SaveImage salva a saída gerada em um local especificado.

Para upscaling, o nó UltimateSDUpscale é usado. Ele pega a saída gerada, o FLUX carregado, o condicionamento positivo e negativo para upscaling, o FLUX VAE carregado e o upscaling FLUX carregado como entradas. O nó CLIPTextEncode (Upscale Positive Prompt) codifica o prompt de texto positivo para upscaling. O nó UpscaleModelLoader carrega o upscaling FLUX. O nó UltimateSDUpscale realiza o processo de upscaling e gera a representação upscalada. Finalmente, o nó SaveImage (Upscaled) salva a saída upscalada em um local especificado.

Ao aproveitar o poder do ComfyUI FLUX e a arquitetura NF4, o workflow ComfyUI FLUX NF4 permite a geração de saídas de alta qualidade com fidelidade e realismo aprimorados. A integração perfeita do ComfyUI FLUX com a arquitetura NF4 fornece uma ferramenta poderosa para criar saídas deslumbrantes e cativantes.

5.7. Workflow ComfyUI: FLUX IPAdapter

5.7.1. ComfyUI FLUX IPAdapter: Download

5.7.2. ComfyUI FLUX IPAdapter Versão Online: ComfyUI FLUX IPAdapter

Na Plataforma RunComfy, nossa versão online pré-carrega todos os modos e nós necessários para você. Além disso, oferecemos máquinas com GPUs de alto desempenho, garantindo que você possa desfrutar da experiência ComfyUI FLUX IPAdapter sem esforço.

5.7.3. Explicação do ComfyUI FLUX IPAdapter:

O workflow ComfyUI FLUX IPAdapter começa carregando os modelos necessários, incluindo o modelo UNET (UNETLoader), o modelo CLIP (DualCLIPLoader) e o modelo VAE (VAELoader).

Os prompts de texto positivos e negativos são codificados usando o CLIPTextEncodeFlux. O condicionamento de texto positivo é usado para guiar o processo de geração do ComfyUI FLUX.

A imagem de entrada é carregada usando o LoadImage. O LoadFluxIPAdapter carrega o IP-Adapter para o modelo FLUX, que é então aplicado ao modelo UNET carregado usando o ApplyFluxIPAdapter. O ImageScale redimensiona a imagem de entrada para o tamanho desejado antes de aplicar o IP-Adapter.

- LoadFluxIPAdapter: Carrega o IP-Adapter para o modelo FLUX.

- Modelo IP Adapter: flux-ip-adapter.safetensors

- Codificador de Visão CLIP: clip_vision_l.safetensors

O EmptyLatentImage cria uma representação latente vazia como ponto de partida para a geração do ComfyUI FLUX.

O XlabsSampler realiza o processo de amostragem, pegando o FLUX UNET com o IP-Adapter aplicado, condicionamento de texto positivo e negativo codificado e representação latente vazia como entradas. Ele gera uma representação latente.

O VAEDecode decodifica a representação latente gerada na saída final usando o FLUX VAE carregado. O nó PreviewImage exibe uma pré-visualização da saída final.

O workflow ComfyUI FLUX IPAdapter aproveita o poder do ComfyUI FLUX e do IP-Adapter para gerar saídas de alta qualidade que se alinham com os prompts de texto fornecidos. Ao aplicar o IP-Adapter ao FLUX UNET, o workflow permite a geração de saídas que capturam as características e o estilo desejados especificados no condicionamento de texto.

5.8. Workflow ComfyUI: Flux LoRA Trainer

5.8.1. ComfyUI FLUX LoRA Trainer: Download

5.8.2. Explicação do ComfyUI Flux LoRA Trainer:

O workflow ComfyUI FLUX LoRA Trainer consiste em múltiplos estágios para treinar um LoRA usando a arquitetura FLUX no ComfyUI.

Seleção e Configuração do ComfyUI FLUX: O nó FluxTrainModelSelect é usado para selecionar os componentes para treinamento, incluindo o UNET, VAE, CLIP e codificador de texto CLIP. O nó OptimizerConfig configura as configurações do otimizador para o treinamento do ComfyUI FLUX, como o tipo de otimizador, taxa de aprendizado e decaimento de peso. Os nós TrainDatasetGeneralConfig e TrainDatasetAdd são usados para configurar o conjunto de dados de treinamento, incluindo a resolução, configurações de aumento e tamanhos de lote.

Inicialização do Treinamento ComfyUI FLUX: O nó InitFluxLoRATraining inicializa o processo de treinamento do LoRA usando os componentes selecionados, configuração do conjunto de dados e configurações do otimizador. O nó FluxTrainValidationSettings configura as configurações de validação para o treinamento, como o número de amostras de validação, resolução e tamanho do lote.

Loop de Treinamento ComfyUI FLUX: O nó FluxTrainLoop realiza o loop de treinamento para o LoRA, iterando por um número especificado de etapas. Após cada loop de treinamento, o nó FluxTrainValidate valida o LoRA treinado usando as configurações de validação e gera saídas de validação. O nó PreviewImage exibe uma pré-visualização dos resultados da validação. O nó FluxTrainSave salva o LoRA treinado em intervalos especificados.

Visualização da Perda do ComfyUI FLUX: O nó VisualizeLoss visualiza a perda de treinamento ao longo do curso do treinamento. O nó SaveImage salva o gráfico de perda para análise posterior.

Processamento das Saídas de Validação do ComfyUI FLUX: Os nós AddLabel e SomethingToString são usados para adicionar rótulos às saídas de validação, indicando as etapas de treinamento. Os nós ImageBatchMulti e ImageConcatFromBatch combinam e concatenam as saídas de validação em um único resultado para visualização mais fácil.

Finalização do Treinamento ComfyUI FLUX: O nó FluxTrainEnd finaliza o processo de treinamento do LoRA e salva o LoRA treinado. O nó UploadToHuggingFace pode ser usado para fazer upload do LoRA treinado para o Hugging Face para compartilhamento e uso posterior com o ComfyUI FLUX.

5.9. Workflow ComfyUI: Flux Latent Upscaler

5.9.1. ComfyUI Flux Latent Upscaler: Download

5.9.2. Explicação do ComfyUI Flux Latent Upscaler:

O workflow ComfyUI Flux Latent Upscale começa carregando os componentes necessários, incluindo o CLIP (DualCLIPLoader), o UNET (UNETLoader) e o VAE (VAELoader). O prompt de texto é codificado usando o nó CLIPTextEncode, e a orientação é aplicada usando o nó FluxGuidance.

O nó SDXLEmptyLatentSizePicker+ especifica o tamanho da representação latente vazia, que serve como ponto de partida para o processo de upscaling no FLUX. A representação latente é então processada através de uma série de etapas de upscaling e recorte usando os nós LatentUpscale e LatentCrop.

O processo de upscaling é guiado pelo condicionamento de texto codificado e usa o nó SamplerCustomAdvanced com o método de amostragem selecionado (KSamplerSelect) e os níveis de ruído agendados (BasicScheduler). O nó ModelSamplingFlux define os parâmetros de amostragem.

A representação latente upscalada é então composta com a representação latente original usando o nó LatentCompositeMasked e uma máscara gerada pelos nós SolidMask e FeatherMask. Ruído é injetado na representação latente upscalada usando o nó InjectLatentNoise+.

Finalmente, a representação latente upscalada é decodificada na saída final usando o nó VAEDecode, e o sharpening inteligente é aplicado usando o nó ImageSmartSharpen+. O nó PreviewImage exibe uma pré-visualização da saída final gerada pelo ComfyUI FLUX.

O workflow ComfyUI FLUX Latent Upscaler também inclui várias operações matemáticas usando os nós SimpleMath+, SimpleMathFloat+, SimpleMathInt+ e SimpleMathPercent+ para calcular dimensões, proporções e outros parâmetros para o processo de upscaling.