Esta guía proporciona una introducción completa a la creación de contenido 3D con el modelo "Wonder3D", utilizando las capacidades avanzadas de los nodos "ComfyUI 3D Pack" para agilizar los flujos de trabajo y mejorar la calidad del resultado.

Parte 1: ComfyUI 3D Pack

1.1. Introducción a ComfyUI 3D Pack

ComfyUI 3D Pack es un conjunto extenso de nodos que permite a ComfyUI procesar entradas 3D como Mesh y UV Texture usando algoritmos y modelos de vanguardia. Integra algoritmos avanzados de procesamiento 3D como 3DGS (Gaussian Splatting) y NeRF (Neural Radiance Fields), junto con modelos de última generación incluyendo Hunyuan3D, StableFast3D, InstantMesh, CRM, TripoSR y otros.

Con el ComfyUI 3D Pack, los usuarios pueden importar, manipular y generar contenido 3D de alta calidad dentro de la interfaz intuitiva de ComfyUI. Soporta una amplia gama de formatos de archivo 3D como OBJ, PLY, GLB, permitiendo la fácil integración de modelos 3D existentes. El paquete también incluye potentes utilidades de procesamiento de mallas para editar, limpiar y optimizar la geometría 3D.

Uno de los aspectos más destacados es la integración de la tecnología NeRF que permite la reconstrucción 3D fotorrealista a partir de imágenes 2D. Los nodos 3DGS permiten la representación y estilización de nubes de puntos. Los modelos InstantMesh y TripoSR permiten la escalabilidad de alta resolución y superresolución de mallas 3D. CRM (Convolutional Reconstruction Model) permite recuperar la forma 3D a partir de imágenes de múltiples vistas y CCM (Color Correction Map).

ComfyUI 3D Pack fue desarrollado por MrForExample, con todo el crédito para MrForExample. Para información detallada, por favor vea ComfyUI 3D Pack.

1.2. ComfyUI 3D Pack: Listo para Ejecutar en RunComfy

Ahora ComfyUI 3D Pack está completamente configurado y listo para usar en el sitio web de RunComfy. Los usuarios no necesitan instalar ningún software o dependencia adicional. Todos los modelos, algoritmos y herramientas requeridos están preconfigurados y optimizados para funcionar eficientemente en el entorno web de ComfyUI.

Parte 2: Usando el modelo Wonder3D con los Nodos ComfyUI 3D Pack

2.1. ¿Qué es Wonder3D?

Wonder3D es un método de vanguardia para generar eficientemente mallas texturizadas de alta calidad a partir de imágenes de vista única. Aprovecha el poder de los modelos de difusión entre dominios para generar mapas normales de múltiples vistas y sus correspondientes imágenes en color. Wonder3D busca abordar los desafíos de fidelidad, consistencia, generalización y eficiencia en tareas de reconstrucción 3D de vista única.

Wonder3D fue desarrollado por un equipo de investigadores de The University of Hong Kong, Tsinghua University, VAST, University of Pennsylvania, Shanghai Tech University, MPI Informatik, y Texas A&M University, con Xiaoxiao Long y Yuan-Chen Guo como autores principales de contribución igual. Todo el crédito va a su contribución; para más información, por favor vea su página de proyecto en aquí.

2.2. Técnicas detrás de Wonder3D

El núcleo de Wonder3D reside en su innovador modelo de difusión entre dominios. Este modelo está diseñado para capturar la distribución conjunta de mapas normales e imágenes en color a través de múltiples vistas. Para lograr esto, Wonder3D introduce un conmutador de dominio y un esquema de atención entre dominios. El conmutador de dominio permite la generación sin problemas de mapas normales o imágenes en color, mientras que el mecanismo de atención entre dominios facilita el intercambio de información entre los dos dominios, mejorando la consistencia y calidad.

Otro componente clave de Wonder3D es su algoritmo de fusión de normales consciente de la geometría. Este algoritmo extrae de manera robusta superficies de alta calidad de las representaciones 2D de múltiples vistas generadas, incluso en presencia de inexactitudes. Al aprovechar los ricos detalles de la superficie codificados en los mapas normales y las imágenes en color, Wonder3D reconstruye geometrías limpias y detalladas.

2.3. Ventajas/Limitaciones Potenciales de Wonder3D

Wonder3D ofrece varias ventajas sobre los métodos de reconstrucción de vista única existentes. Logra un alto nivel de detalle geométrico mientras mantiene una buena eficiencia, haciéndolo adecuado para varias aplicaciones. El modelo de difusión entre dominios permite a Wonder3D generalizar bien a diferentes categorías de objetos y estilos. La consistencia de múltiples vistas impuesta por el mecanismo de atención entre dominios resulta en reconstrucciones 3D coherentes y plausibles.

Sin embargo, como cualquier método, Wonder3D puede tener algunas limitaciones. La calidad de las mallas generadas depende de los datos de entrenamiento y la capacidad del modelo de difusión para capturar la estructura 3D subyacente. Formas altamente complejas o ambiguas podrían plantear desafíos. Además, la implementación actual de Wonder3D se centra en objetos individuales, y extenderlo para manejar múltiples objetos o escenas completas podría ser un área para futuras investigaciones.

2.4. Cómo usar el Flujo de Trabajo de Wonder3D

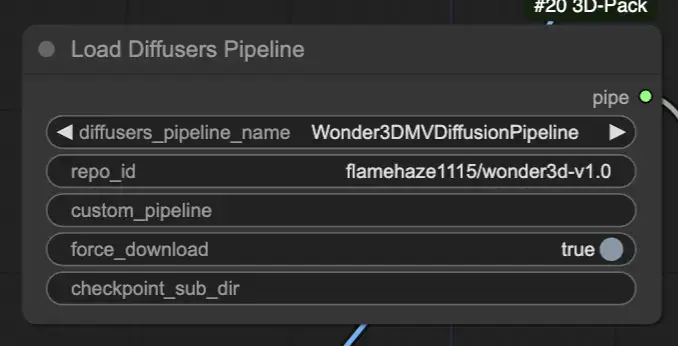

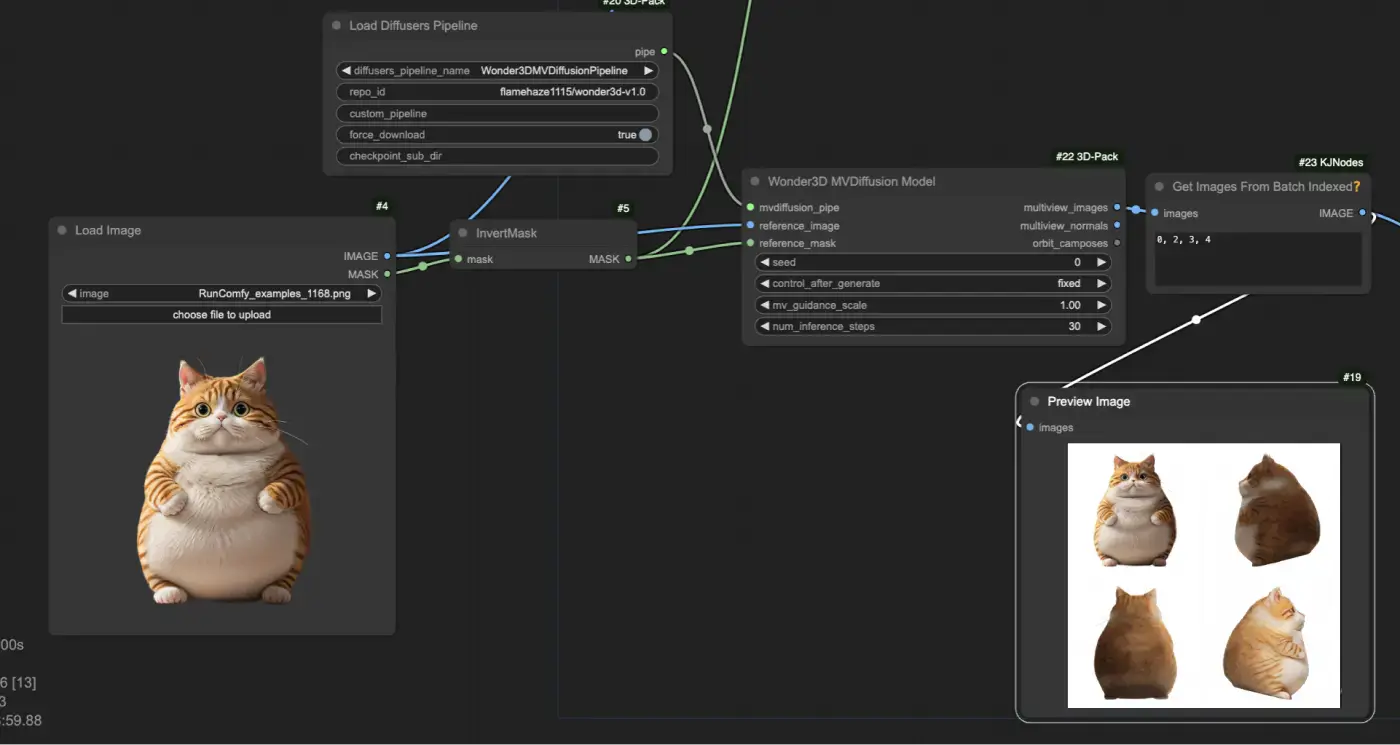

Carga la tubería de difusión preentrenada de Wonder3D usando el nodo "[Comfy3D] Load Diffusers Pipeline", que importa los puntos de control del modelo y configuraciones necesarias.

Proporcione una imagen de entrada y su máscara correspondiente usando los nodos "LoadImage" y "InvertMask". Luego, alimente la imagen de entrada y la máscara en el nodo "[Comfy3D] Wonder3D MVDiffusion Model", que genera mapas normales de múltiples vistas e imágenes en color.

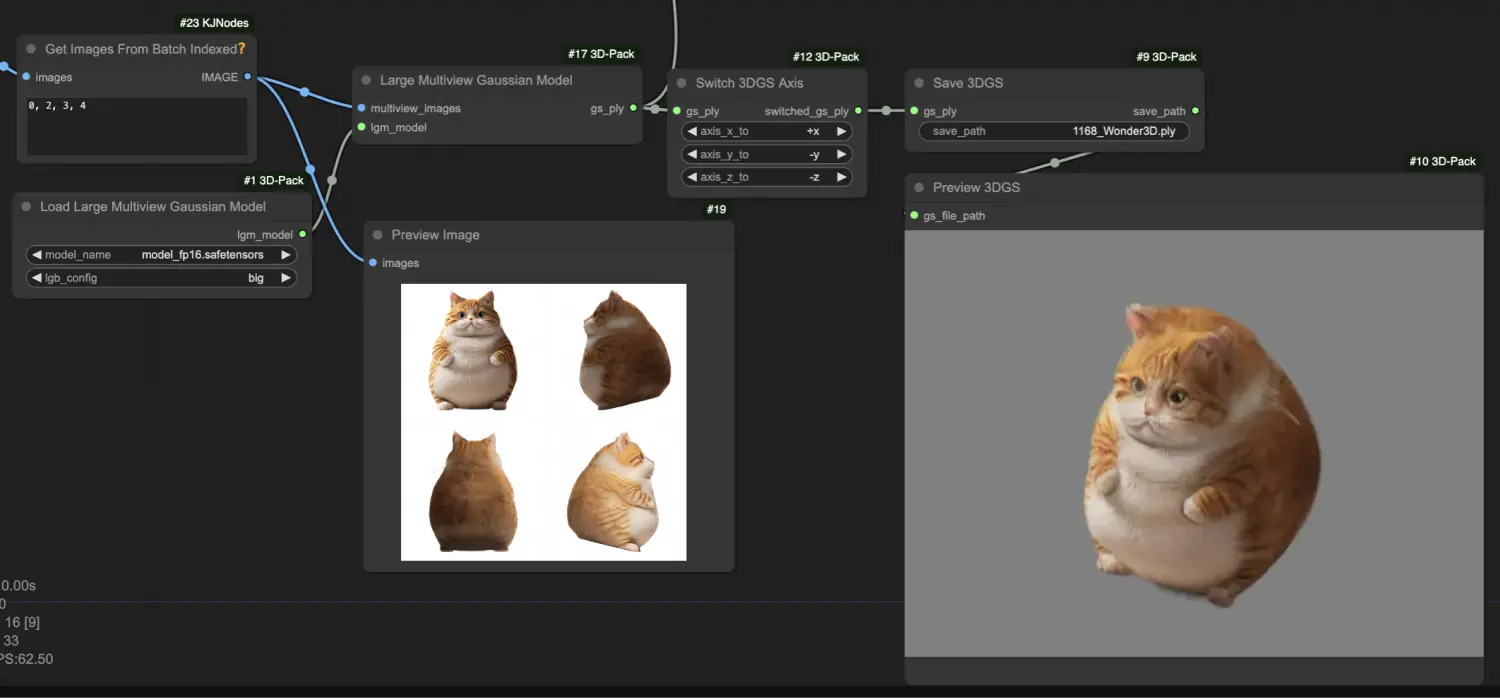

Procese las imágenes generadas de múltiples vistas usando el nodo "[Comfy3D] Large Multiview Gaussian Model", que las convierte en una representación de Gaussian Splatting 3D (3DGS), capturando los detalles geométricos del objeto en un formato de nube de puntos.

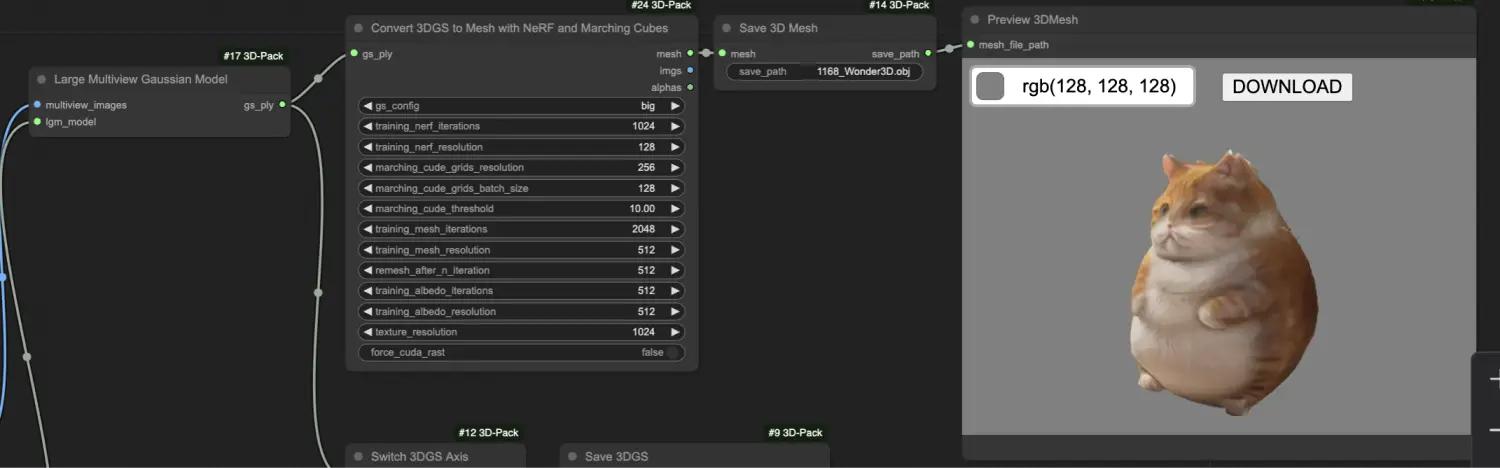

Transforme la representación 3DGS en una malla texturizada usando el nodo "[Comfy3D] Convert 3DGS to Mesh with NeRF and Marching Cubes", que emplea campos de radiancia neural (NeRF) y algoritmos de marching cubes para extraer una malla de alta calidad.