AnimateLCM | Accélérer le texte en vidéo

Ce flux de travail s'appuie sur le flux de travail AnimateDiff-Evolved en incorporant AnimateLCM via les nodes "Load AnimateLCM LoRA" et "Apply AnimateLCM Motion Model in AnimateDiff". Il rend la création d'effets d'animation personnalisés à la fois plus rapide et plus efficace.Flux de travail ComfyUI AnimateLCM

- Workflows entièrement opérationnels

- Aucun nœud ou modèle manquant

- Aucune configuration manuelle requise

- Propose des visuels époustouflants

Exemples ComfyUI AnimateLCM

Description ComfyUI AnimateLCM

1. Flux de travail ComfyUI AnimateLCM

Le flux de travail ComfyUI AnimateLCM est conçu pour améliorer les vitesses d'animation IA. S'appuyant sur les bases de ComfyUI-AnimateDiff-Evolved, ce flux de travail intègre AnimateLCM pour accélérer spécifiquement la création d'animations texte-vidéo (t2v). Vous pouvez expérimenter avec différentes invites et étapes pour obtenir les résultats souhaités.

2. Aperçu d'AnimateLCM

L'avènement de technologies comme SDXL, LCM et SDXL Turbo a considérablement accéléré le rythme de la génération d'images. AnimateLCM propulse encore plus le progrès de l'animation IA. Il prend en charge la génération rapide d'images en vidéo et vise à améliorer la vitesse et l'efficacité de la production de vidéos animées à partir d'images statiques ou de descriptions textuelles, ce qui le rend particulièrement utile pour créer rapidement des effets d'animation personnalisés.

2.1. Présentation d'AnimateLCM

AnimateLCM est conçu pour accélérer l'animation de modèles de diffusion et d'adaptateurs personnalisés grâce à l'apprentissage découplé de la cohérence. Il s'inspire du Consistency Model (CM), qui distille les modèles de diffusion d'images pré-entraînés pour accélérer le processus d'échantillonnage, et de son extension, le Latent Consistency Model (LCM), qui se concentre sur la génération d'images conditionnelles. AnimateLCM s'appuie sur ces fondements pour permettre la création de vidéos de haute fidélité en quelques étapes, en s'appuyant sur le succès des techniques de diffusion et de génération d'images pour étendre leurs capacités au domaine de la vidéo.

2.2. Comment utiliser AnimateLCM dans votre flux de travail ComfyUI

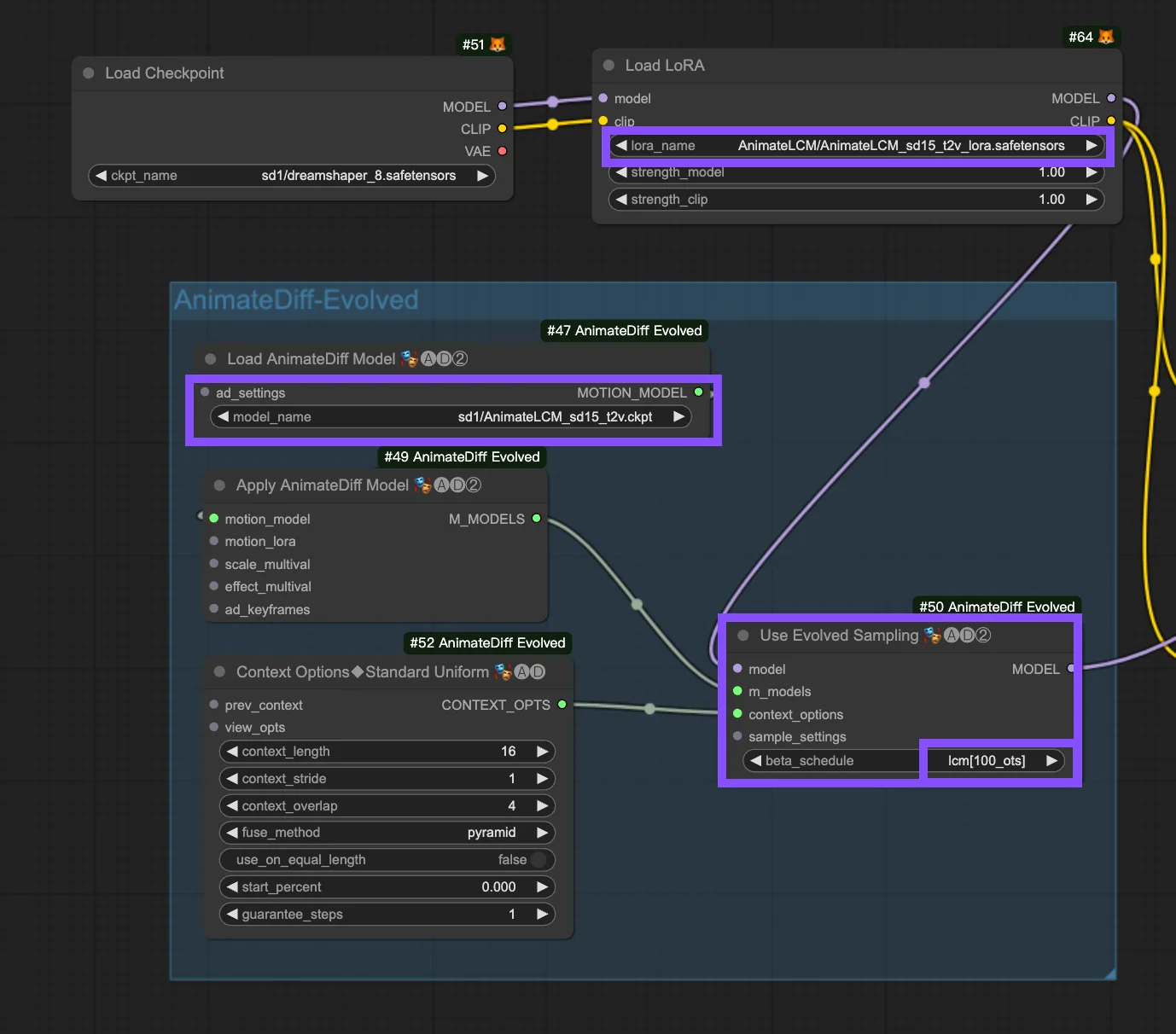

Ce flux de travail s'appuie sur le flux de travail . Voici les paramètres de configuration du nœud "Use Evolved Sampling".

Models : Définissez le modèle de point de contrôle et le modèle LoRA.

- Checkpoint : Il s'agit des entrées de modèle StableDiffusion (SD) utilisées pour la création d'animations. Selon les modèles de mouvement choisis, la compatibilité peut varier entre les versions SD, comme SD1.5 ou SDXL.

- LoRA : Intégrez le modèle AnimateLCM LoRA pour intégrer de manière transparente les adaptateurs existants pour une variété de fonctions, améliorant l'efficacité et la qualité de sortie avec un accent sur l'apprentissage de la cohérence sans sacrifier la vitesse d'échantillonnage.

Motion Models (M Models) : Ce sont les sorties du processus Apply AnimateDiff Model, permettant l'utilisation du modèle de mouvement AnimateLCM.

Context Options : Ces paramètres ajustent le fonctionnement d'AnimateDiff pendant la production d'animations, permettant des animations de n'importe quelle longueur via des fenêtres contextuelles glissantes sur l'ensemble de l'Unet ou spécifiquement dans le module de mouvement. Ils permettent également des ajustements de synchronisation pour les séquences d'animation complexes. Consultez ce pour plus d'informations.

Beta Schedule dans les paramètres d'échantillonnage : Optez pour LCM. Dans les paramètres d'échantillonnage d'AnimateDiff dans ComfyUI, la sélection "beta schedule", qui comprend des options comme "lcm", "lineart", etc., ajuste les valeurs bêta qui régulent les niveaux de bruit tout au long du processus de diffusion. Cette personnalisation affecte le style visuel et la fluidité de l'animation. Chaque paramètre répond à des besoins spécifiques d'animation ou de modèle de mouvement.

- LCM (Latent Consistency Module) : Le paramètre "lcm" est adapté aux LoRA LCM, améliorant l'uniformité de l'animation et réduisant le temps de création. Il permet une convergence plus rapide avec moins d'étapes, nécessitant une réduction des étapes (à un minimum d'environ 4 étapes) et d'autres ajustements de paramètres pour une rétention optimale des détails.

- Linear (AnimateDiff-SDXL) : Recommandé pour AnimateDiff avec les modules de mouvement SDXL, cette option offre un équilibre entre la préservation des détails et la fluidité du mouvement, indiquant une compatibilité avec des versions spécifiques de modèles de mouvement.

- Sqrt_lineart (AnimateDiff) : Similaire à "lineart", cette variante est conçue pour les processus AnimateDiff, en particulier avec les modules de mouvement V2, modifiant les niveaux de bruit pour compléter la sortie du modèle de mouvement pour des transitions ou des mouvements plus fluides.