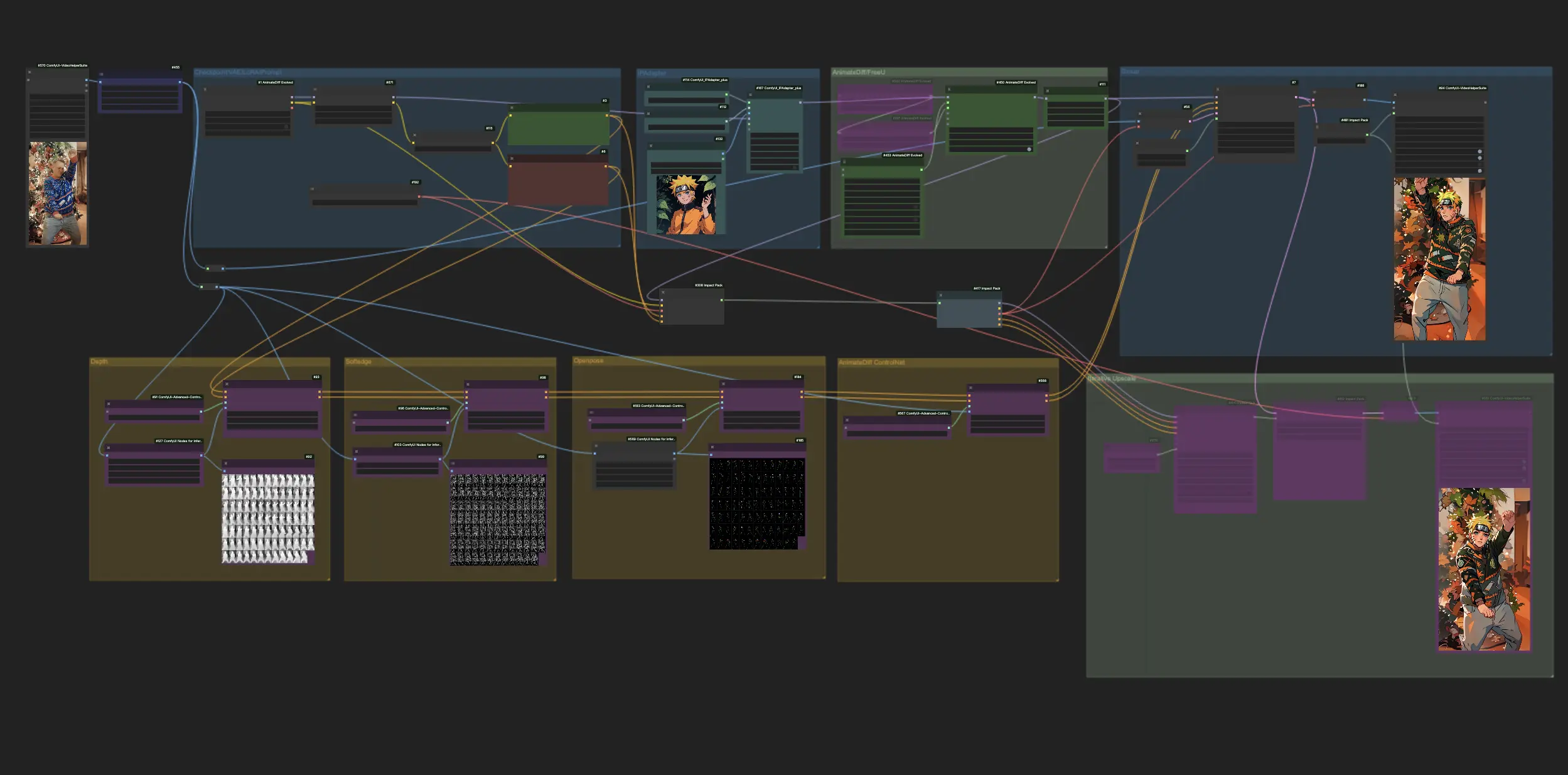

AnimateDiff + ControlNet + IPAdapter V1 | Style Anime Japonais

Vivez le frisson de la transformation en anime alors que ComfyUI exploite la puissance d'AnimateDiff, ControlNet et IPAdapter pour convertir des vidéos standard en des interprétations captivantes d'anime japonais. Ce workflow emploie habilement des techniques avancées telles que la perception de la profondeur, les détails à bords doux et la technologie OpenPose, ainsi que la touche nuancée de Lora, garantissant que chaque vidéo est réimaginée avec une esthétique anime authentique. Immergez-vous dans l'univers de l'anime avec une métamorphose fluide et infusée de style.Flux de travail ComfyUI Vid2Vid (Japanese Anime)

- Workflows entièrement opérationnels

- Aucun nœud ou modèle manquant

- Aucune configuration manuelle requise

- Propose des visuels époustouflants

Exemples ComfyUI Vid2Vid (Japanese Anime)

Description ComfyUI Vid2Vid (Japanese Anime)

Ce workflow est inspiré par avec quelques modifications. Pour plus d'informations, veuillez visiter sa chaîne YouTube.

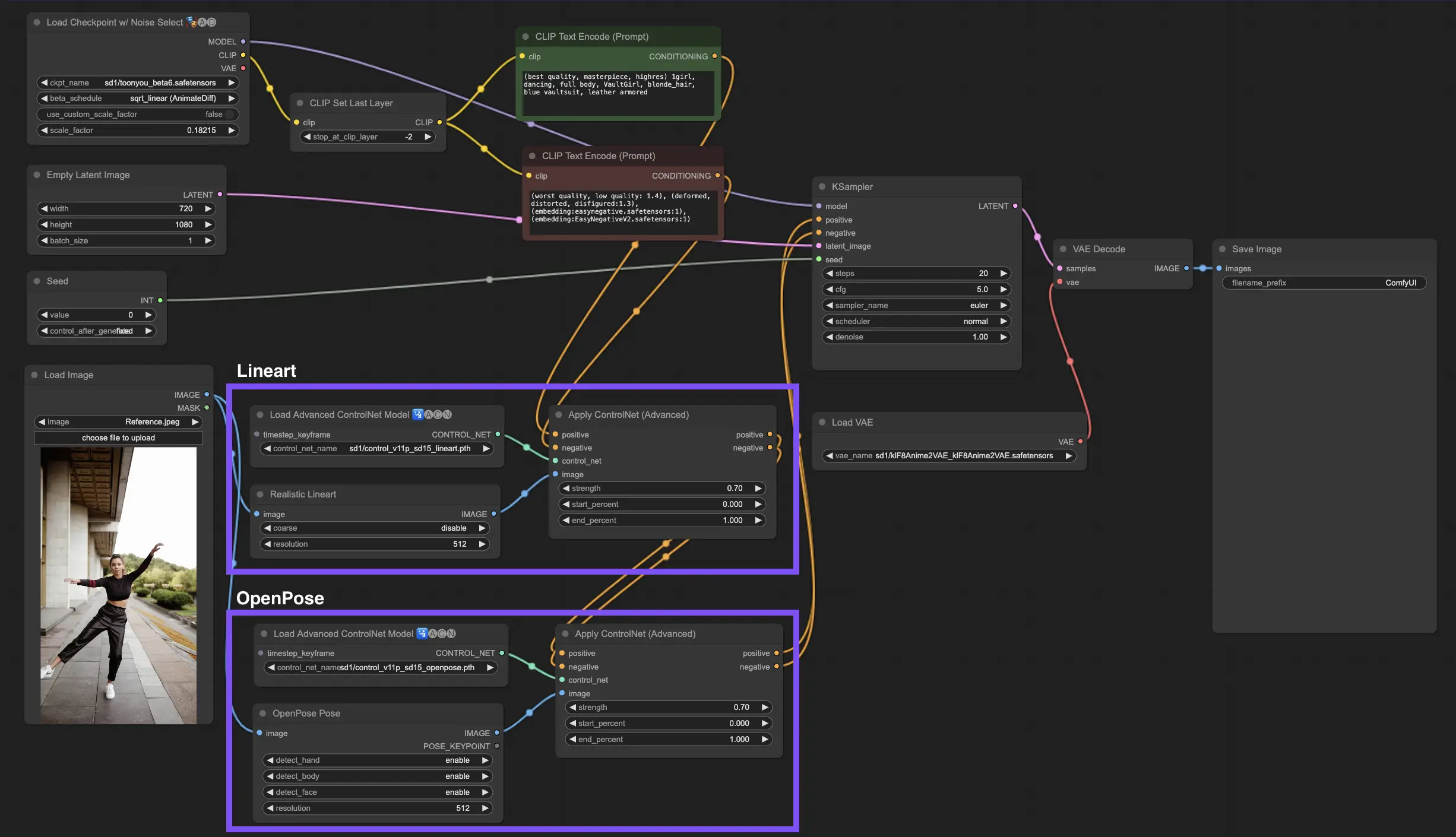

1. Workflow ComfyUI : AnimateDiff + ControlNet + IPAdapter | Style Anime Japonais

Ce workflow vous permet de transformer des vidéos standard en des créations d'anime japonais enchanteresses en utilisant AnimateDiff, ControlNet et IPAdapter. N'hésitez pas à expérimenter avec différents points de contrôle, paramètres LoRA et images de référence pour l'IPAdapter afin de créer votre style unique. C'est un moyen amusant et créatif de donner vie à vos vidéos dans l'univers de l'anime !

2. Aperçu d'AnimateDiff

Veuillez consulter les détails sur

3. Comment utiliser ControlNet

3.1. Comprendre ControlNet

ControlNet révolutionne la façon dont nous générons des images en apportant un nouveau niveau de contrôle spatial aux modèles de diffusion de texte vers image. Cette architecture de réseau neuronal de pointe s'associe magnifiquement à des géants comme Stable Diffusion, exploitant leurs vastes bibliothèques, forgées à partir de milliards d'images, pour tisser des nuances spatiales directement dans la création d'images. Qu'il s'agisse d'esquisser des bords, de cartographier des postures humaines, d'obtenir une perception de la profondeur ou de segmenter des éléments visuels, ControlNet vous permet de façonner les images d'une manière qui va bien au-delà de simples invites textuelles.

3.2. L'innovation de ControlNet

Fondamentalement, ControlNet est ingénieusement simple. Il commence par préserver l'intégrité des paramètres du modèle original, en gardant l'entraînement de base intact. Ensuite, ControlNet introduit un ensemble miroir des couches d'encodage du modèle, mais avec une particularité : elles sont entraînées en utilisant des "convolutions nulles". Ces zéros comme point de départ signifient que les couches intègrent doucement de nouvelles conditions spatiales sans faire de remous, garantissant que les talents originaux du modèle sont préservés même lorsqu'il s'embarque sur de nouveaux chemins d'apprentissage.

3.3. Comprendre ControlNets et T2I-Adapters

Les ControlNets et les T2I-Adapters jouent tous deux un rôle crucial dans le conditionnement de la génération d'images, chacun offrant des avantages distincts. Les T2I-Adapters sont reconnus pour leur efficacité, en particulier pour accélérer le processus de génération d'images. Malgré cela, les ControlNets sont inégalés dans leur capacité à guider de manière détaillée le processus de génération, ce qui en fait un outil puissant pour les créateurs.

Compte tenu du chevauchement des fonctionnalités entre de nombreux modèles T2I-Adapter et ControlNet, notre discussion se concentrera principalement sur ControlNets. Cependant, il convient de noter que la plateforme RunComfy a préchargé plusieurs modèles T2I-Adapter pour faciliter leur utilisation. Pour ceux qui souhaitent expérimenter avec T2I-Adapters, vous pouvez charger facilement ces modèles et les intégrer dans vos projets.

Choisir entre les modèles ControlNet et T2I-Adapter dans ComfyUI n'affecte pas l'utilisation des noeuds ControlNet ou la cohérence du workflow. Cette uniformité garantit un processus rationalisé, vous permettant de tirer parti des avantages uniques de chaque type de modèle en fonction des besoins de votre projet.

3.4. Utilisation des noeuds ControlNet

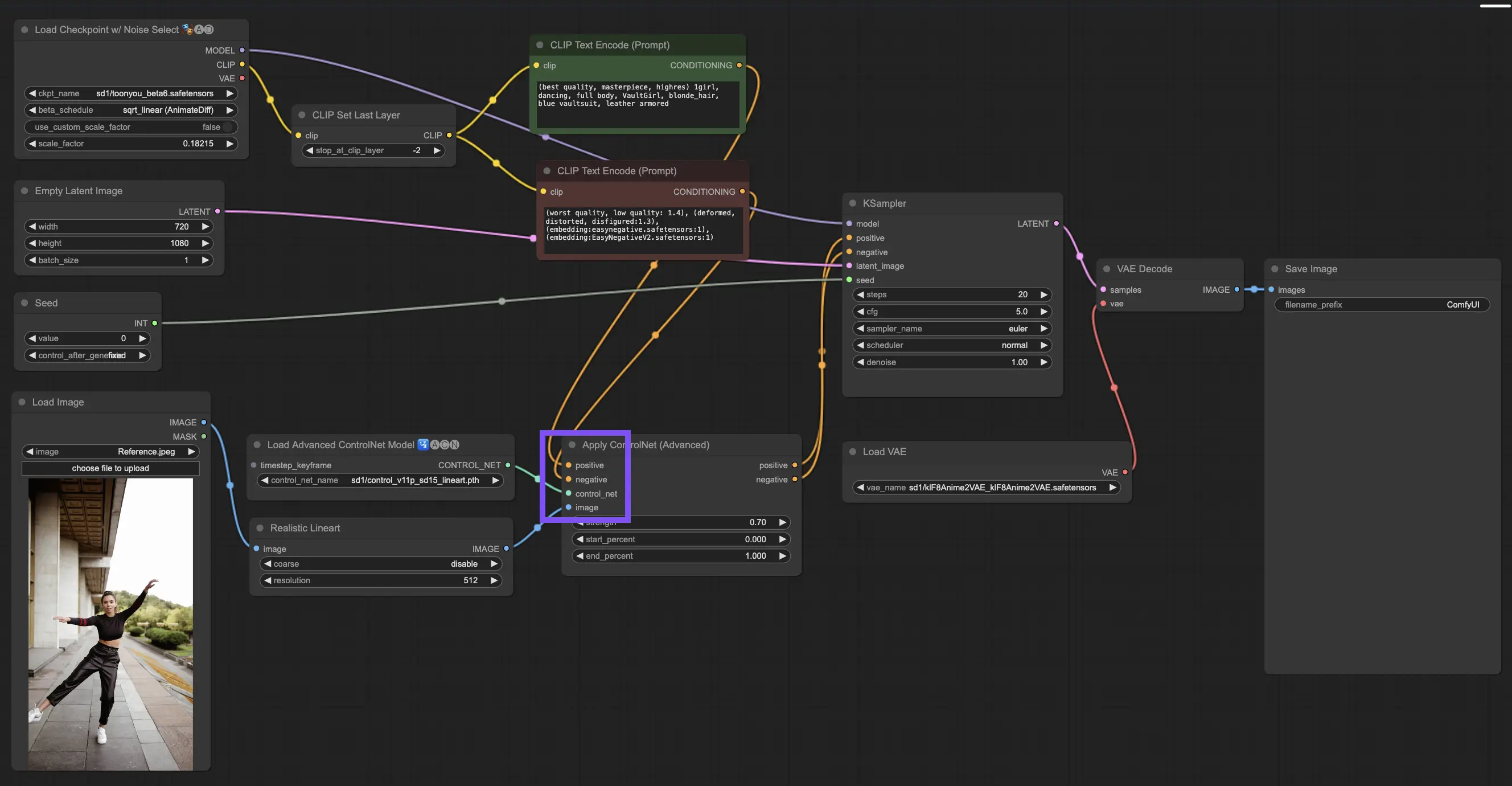

3.4.1. Charger le noeud "Apply ControlNet"

Pour commencer, vous devrez charger le noeud "Apply ControlNet" dans votre ComfyUI. C'est votre première étape vers un processus de création d'images à double conditionnement, mélangeant des éléments visuels avec des invites textuelles.

3.4.2. Comprendre les entrées du noeud "Apply ControlNet"

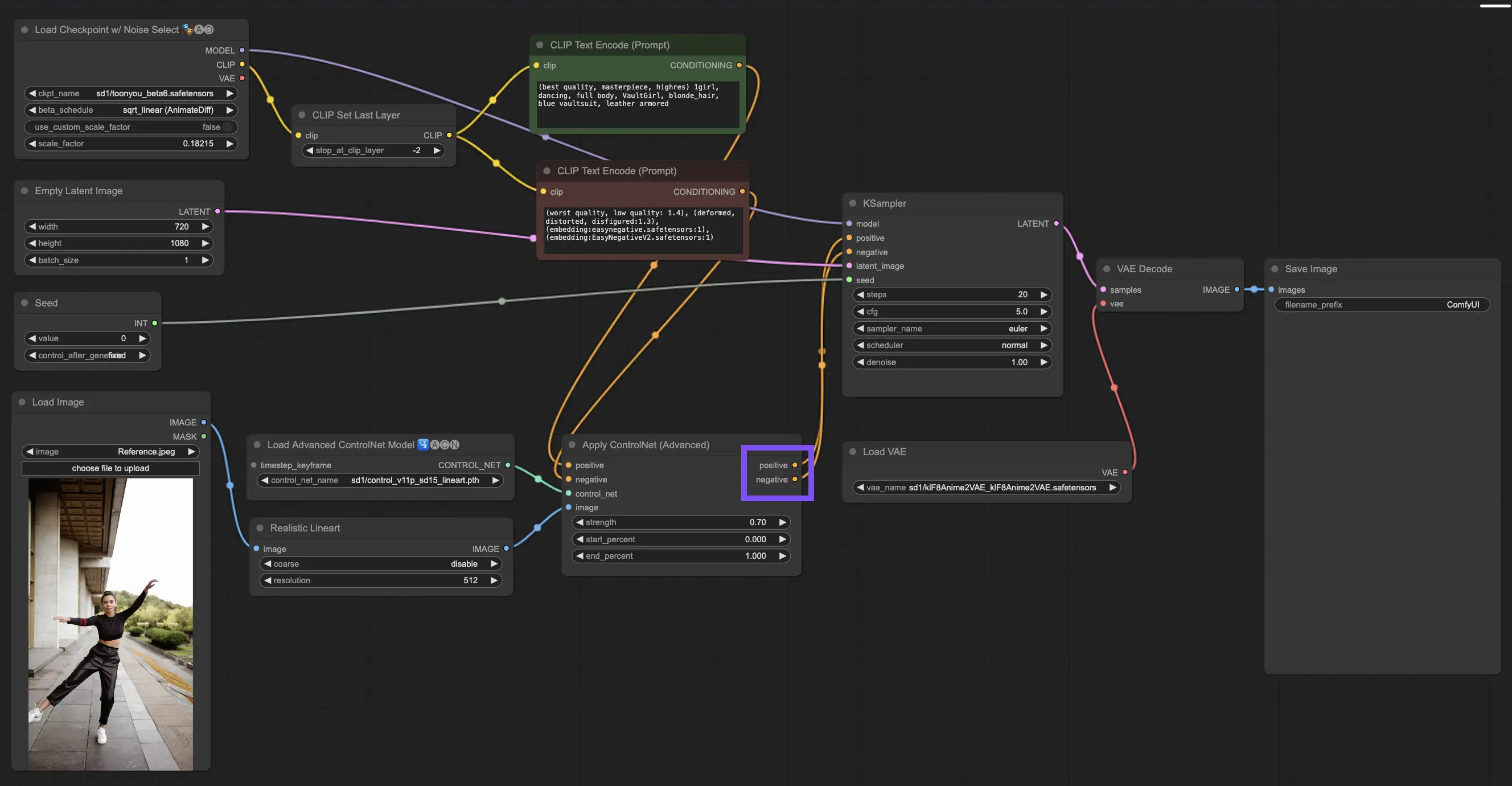

Conditionnement positif et négatif : Ce sont vos outils pour façonner l'image finale, ce qu'elle doit inclure et ce qu'elle doit éviter. Connectez-les aux emplacements "Positive prompt" et "Negative prompt" pour les synchroniser avec la partie textuelle de votre direction créative.

Sélection du modèle ControlNet : Vous devrez relier cette entrée à la sortie du noeud "Load ControlNet Model". C'est là que vous décidez d'utiliser un modèle ControlNet ou T2IAdaptor en fonction des traits ou styles spécifiques que vous visez. Bien que nous nous concentrions sur les modèles ControlNet, il est intéressant de mentionner certains T2IAdaptors recherchés pour une vue d'ensemble complète.

Prétraitement de votre image : Connectez votre image à un noeud "ControlNet Preprocessor", qui est vital pour garantir que votre image est prête pour ControlNet. Il est essentiel de faire correspondre le préprocesseur à votre modèle ControlNet. Cette étape ajuste votre image d'origine pour qu'elle réponde parfaitement aux besoins du modèle, en la redimensionnant, en la recolorant ou en appliquant les filtres nécessaires, la préparant ainsi à être utilisée par ControlNet.

3.4.3. Comprendre les sorties du noeud "Apply ControlNet"

Après le traitement, le noeud "Apply ControlNet" vous présente deux sorties reflétant l'interaction sophistiquée de ControlNet et de votre apport créatif : Conditionnement positif et négatif. Ces sorties guident le modèle de diffusion dans ComfyUI, menant à votre prochain choix : affiner l'image en utilisant le KSampler ou plonger plus profondément en empilant plus de ControlNets pour ceux qui recherchent des détails et une personnalisation inégalés.

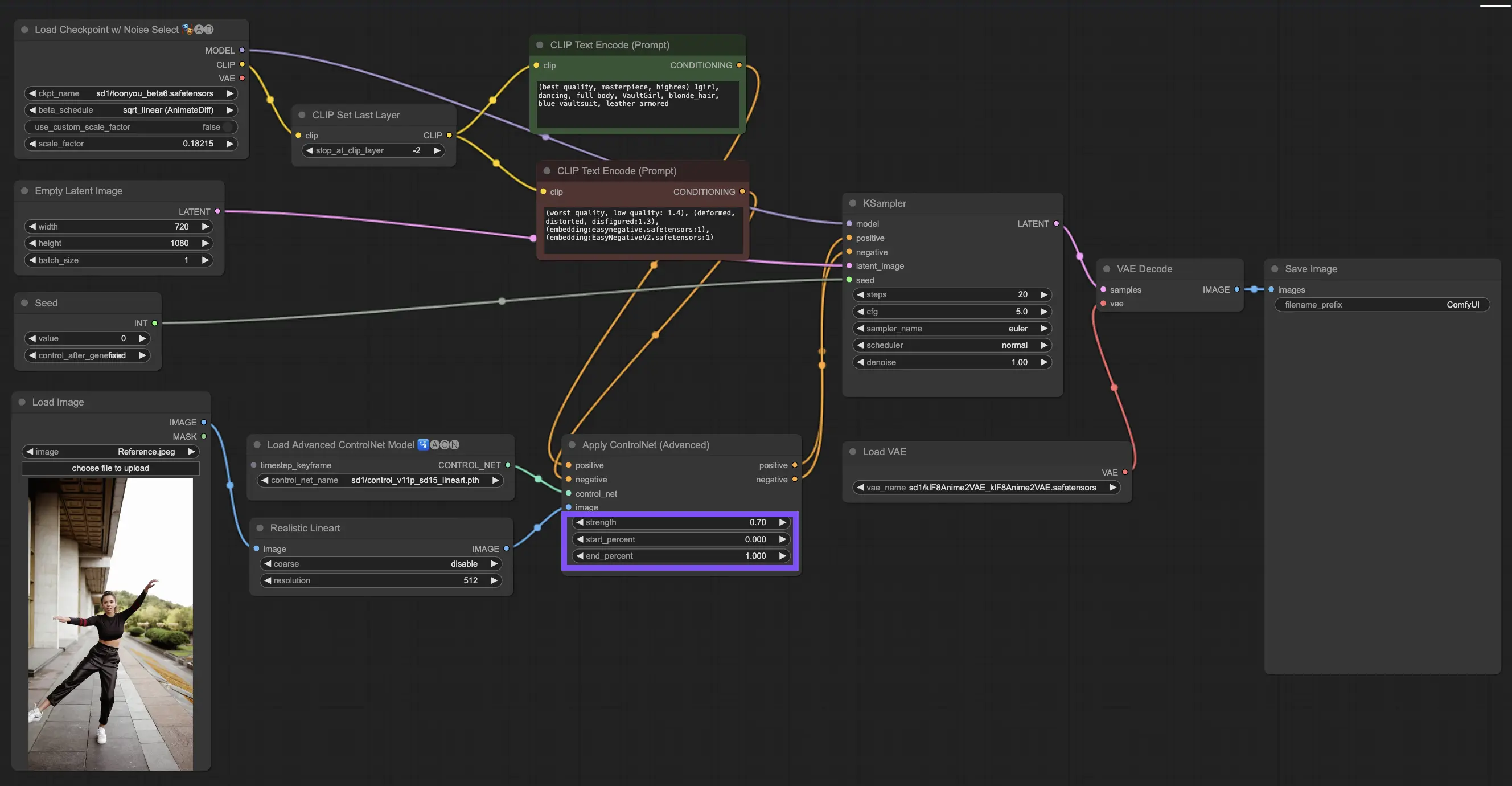

3.4.4. Régler "Apply ControlNet" pour de meilleurs résultats

Déterminer la force : Ce paramètre contrôle à quel point ControlNet influence l'image résultante. Un 1.0 complet signifie que l'entrée de ControlNet a les rênes, tandis que descendre à 0.0 permet au modèle de fonctionner sans l'influence de ControlNet.

Ajuster le pourcentage de départ : Cela vous indique quand ControlNet commence à intervenir pendant le processus de diffusion. Par exemple, un démarrage à 20% signifie qu'à partir d'un cinquième du chemin, ControlNet commence à laisser sa marque.

Définir le pourcentage de fin : C'est l'inverse du pourcentage de départ, marquant le moment où ControlNet se retire. Si vous le réglez à 80%, l'influence de ControlNet s'estompe à mesure que l'image approche de ses étapes finales, sans être touchée par ControlNet dans la dernière ligne droite.

3.5. Guide des modèles ControlNet : Openpose, Depth, SoftEdge, Canny, Lineart, Tile

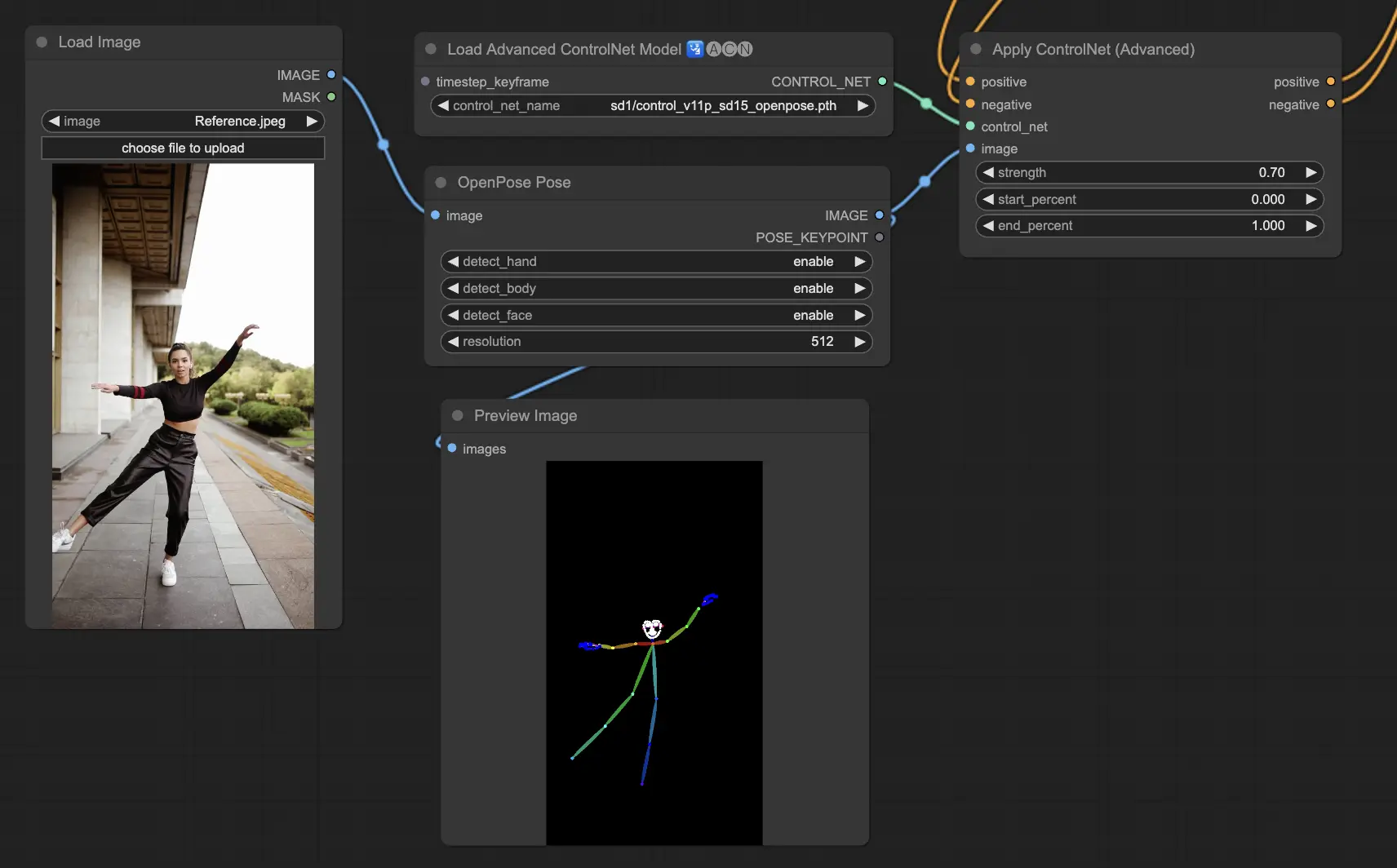

3.5.1. Modèle ControlNet : Openpose

- Openpose (également appelé Openpose body) : Ce modèle agit comme la pierre angulaire de ControlNet pour identifier les points clés du corps humain, tels que les yeux, le nez, le cou, les épaules, les coudes, les poignets, les genoux et les chevilles. Il est parfait pour reproduire des poses humaines simples.

- Openpose_face : Cette version d'Openpose va plus loin en détectant les points clés du visage, ce qui permet une analyse nuancée des expressions faciales et de la direction dans laquelle pointe le visage. Si votre projet est centré sur les expressions faciales, ce modèle est vital.

- Openpose_hand : Cette amélioration du modèle Openpose se concentre sur les détails fins des mouvements des mains et des doigts, ce qui est essentiel pour une compréhension détaillée des gestes et du positionnement des mains. Il élargit le champ d'action d'Openpose au sein de ControlNet.

- Openpose_faceonly : Conçu pour l'analyse détaillée des visages, ce modèle saute les points clés du corps pour se concentrer exclusivement sur les expressions faciales et l'orientation. Lorsque seules les caractéristiques faciales comptent, c'est le modèle à choisir.

- Openpose_full : Ce modèle tout-en-un intègre les capacités d'Openpose, Openpose_face et Openpose_hand pour la détection des points clés du corps entier, du visage et des mains, ce qui en fait le choix par défaut pour une analyse complète de la pose humaine dans ControlNet.

- DW_Openpose_full : En s'appuyant sur Openpose_full, ce modèle introduit d'autres améliorations pour une meilleure précision et des détails de détection de pose. C'est la version la plus avancée disponible dans la suite ControlNet.

Les options de préprocesseur incluent : Openpose ou DWpose

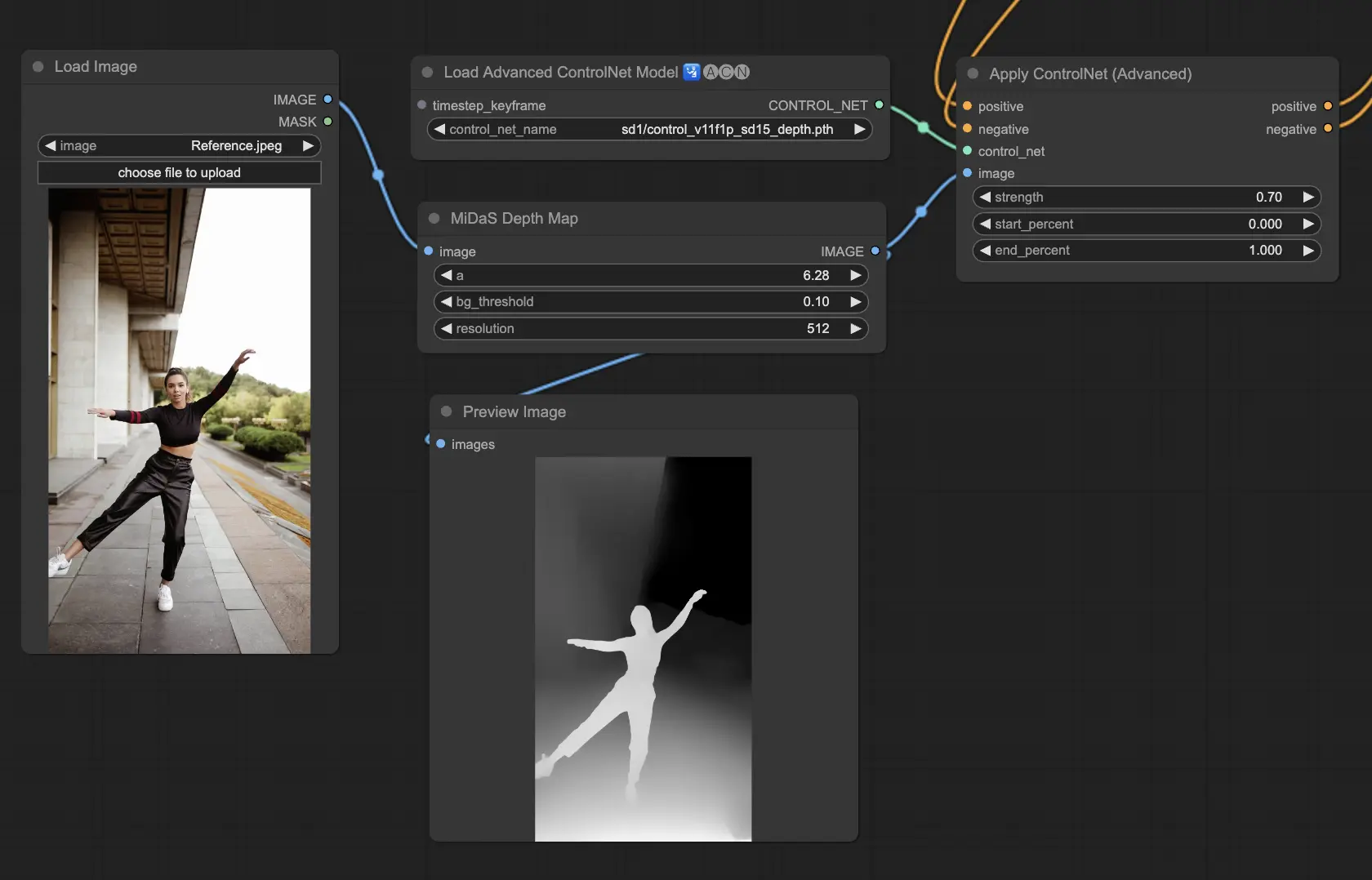

3.5.2. Modèle ControlNet : Depth

Les modèles Depth utilisent une image 2D pour déduire la profondeur, la représentant sous forme de carte en niveaux de gris. Chacun a ses points forts en termes de détail ou de concentration sur l'arrière-plan :

- Depth Midas : Une approche équilibrée de l'estimation de la profondeur, Depth Midas offre un compromis dans la représentation des détails et de l'arrière-plan.

- Depth Leres : Met l'accent sur les détails tout en capturant les éléments d'arrière-plan de manière plus proéminente.

- Depth Leres++ : Repousse les limites des détails d'information de profondeur, ce qui est particulièrement utile pour les scènes complexes.

- Zoe : Trouve un équilibre entre les niveaux de détail des modèles Midas et Leres.

- Depth Anything : Un modèle amélioré pour une estimation polyvalente de la profondeur dans diverses scènes.

- Depth Hand Refiner : Affine spécifiquement les détails des mains dans les cartes de profondeur, ce qui le rend inestimable pour les scènes où le placement précis des mains est essentiel.

Les préprocesseurs à considérer : Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Ce modèle excelle en robustesse et en compatibilité avec les cartes de profondeur réelles des moteurs de rendu.

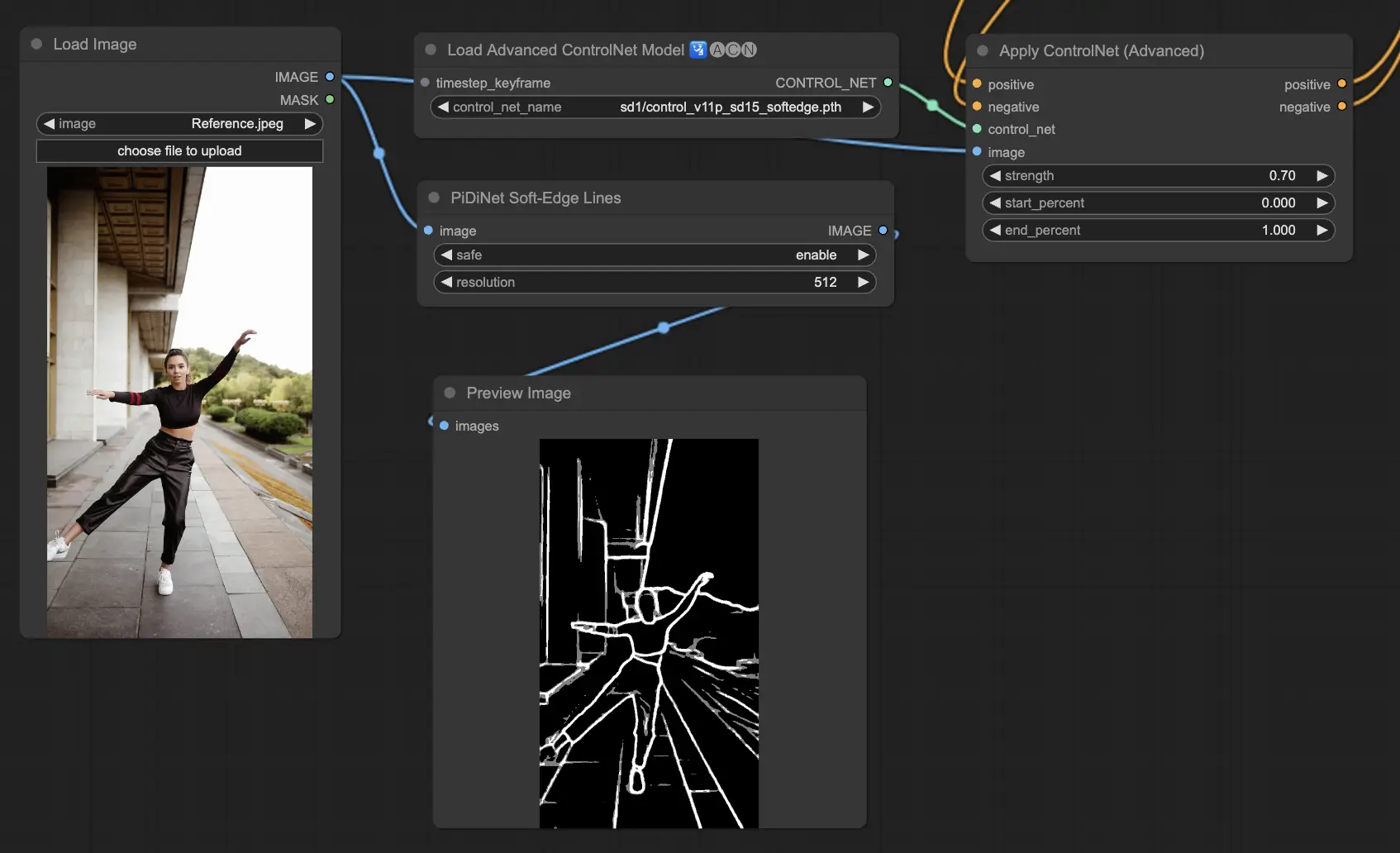

3.5.3. Modèle ControlNet : SoftEdge

ControlNet Soft Edge est conçu pour produire des images avec des bords plus doux, améliorant les détails tout en conservant un aspect naturel. Il utilise des réseaux de neurones de pointe pour une manipulation d'image raffinée, offrant un contrôle créatif étendu et une intégration parfaite.

En termes de robustesse : SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Pour les résultats de la plus haute qualité : SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

En règle générale, SoftEdge_PIDI est l'option par défaut car elle offre généralement d'excellents résultats.

Les préprocesseurs incluent : SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

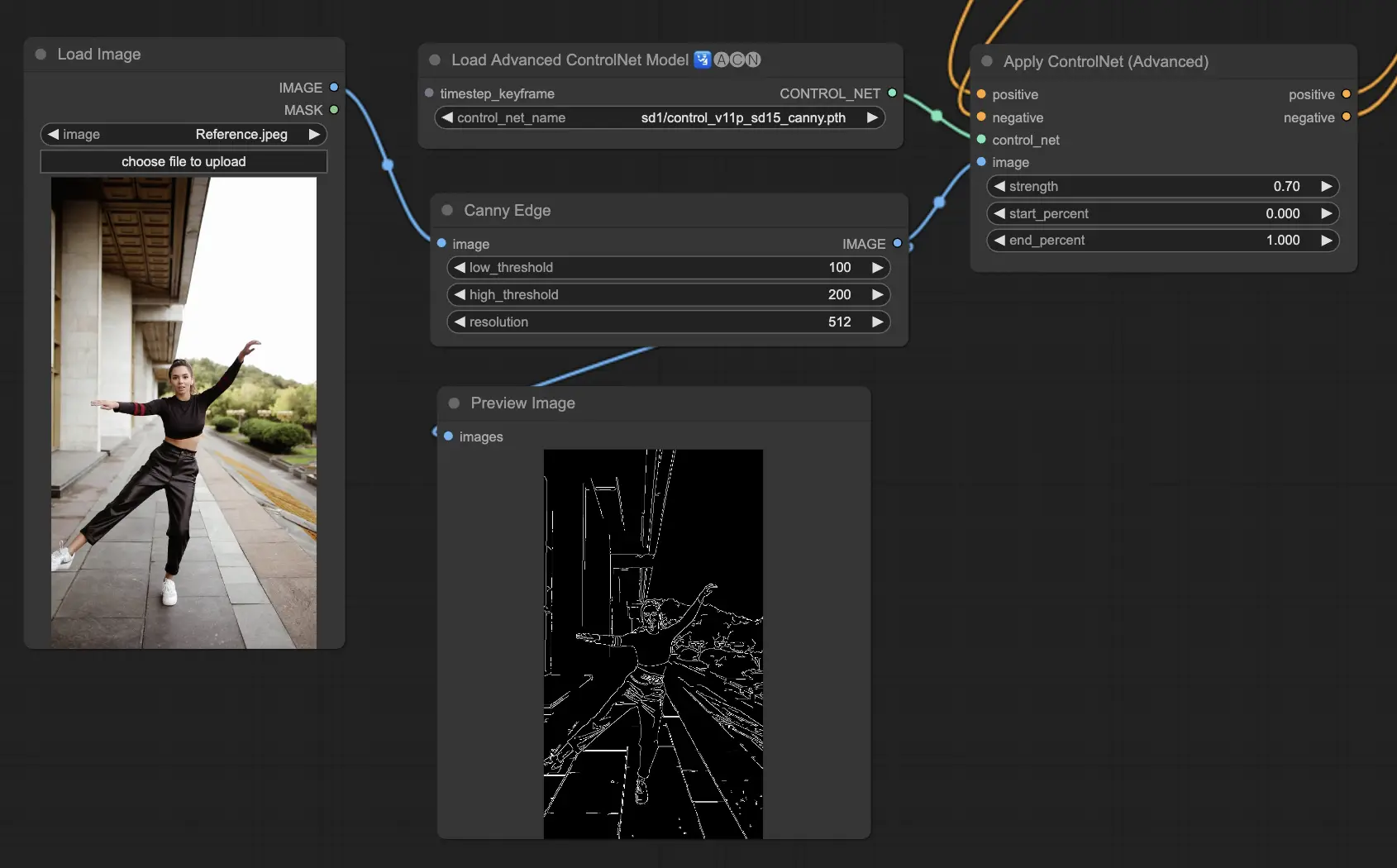

3.5.4. Modèle ControlNet : Canny

Le modèle Canny implémente la détection de contours de Canny pour mettre en évidence un large éventail de contours dans les images. Ce modèle est excellent pour maintenir l'intégrité des éléments structurels tout en simplifiant l'apparence générale de l'image, aidant à créer des illustrations stylisées ou à préparer des images pour une manipulation supplémentaire.

Préprocesseurs disponibles : Canny

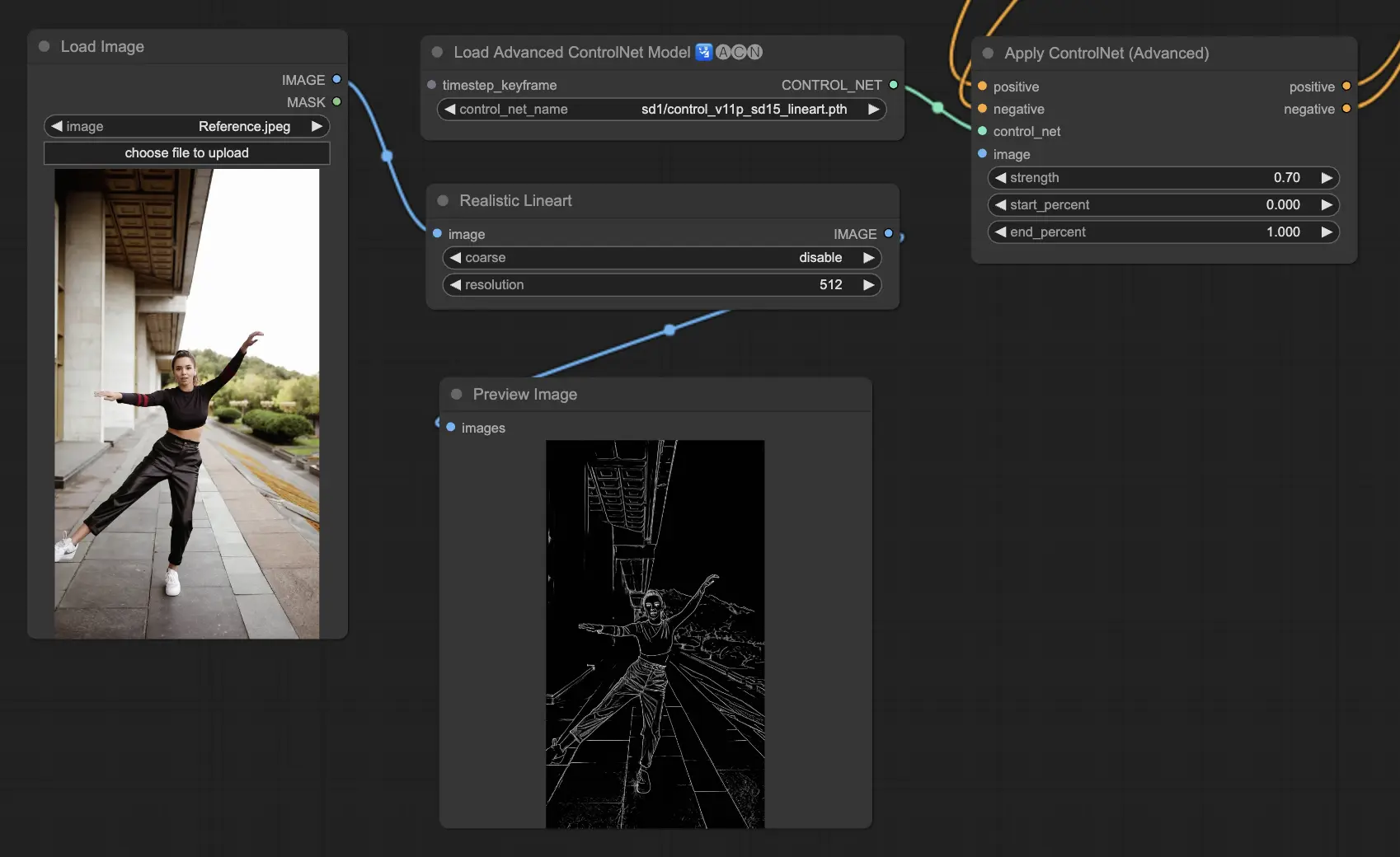

3.5.5. Modèle ControlNet : Lineart

Les modèles Lineart sont vos outils pour transformer des images en dessins au trait stylisés, adaptés à une variété d'applications artistiques :

- Lineart : Le choix standard pour transformer des images en dessins au trait, offrant un point de départ polyvalent pour différents projets artistiques ou créatifs.

- Lineart anime : Conçu pour créer des dessins au trait de style anime nets et précis, parfaits pour les projets visant un look inspiré de l'anime.

- Lineart realistic : Vise à capturer une représentation plus réaliste dans les dessins au trait, offrant plus de détails pour les projets nécessitant du réalisme.

- Lineart coarse : Met l'accent sur des lignes plus audacieuses et plus prononcées pour un impact visuel saisissant, idéal pour des déclarations graphiques audacieuses.

Les préprocesseurs disponibles peuvent produire des dessins au trait détaillés ou plus prononcés (Lineart et Lineart_Coarse).

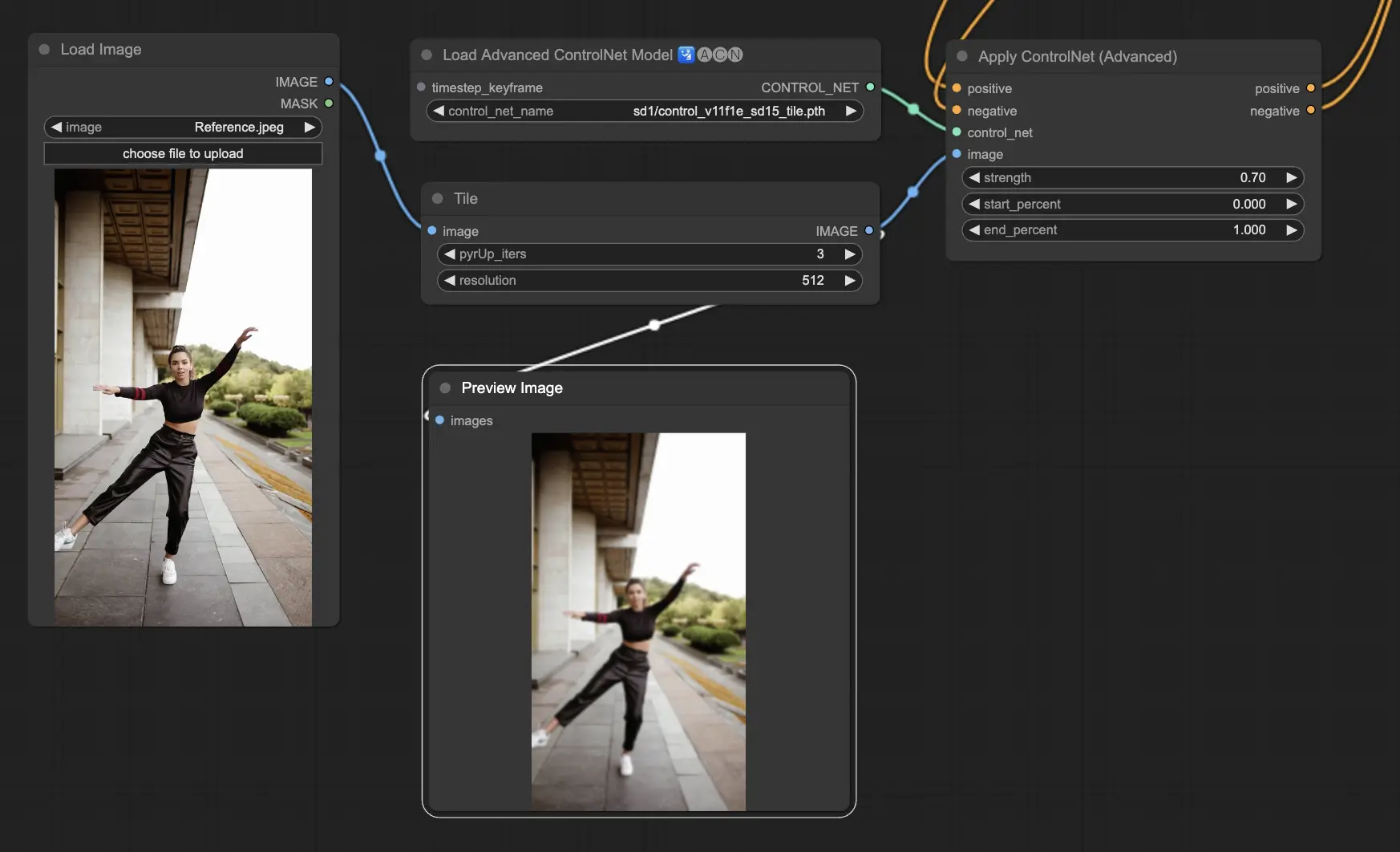

3.5.6. Modèle ControlNet : Tile

Le modèle Tile Resample excelle dans la mise en valeur des détails des images. Il est particulièrement efficace lorsqu'il est utilisé en tandem avec un outil d'upscaling pour améliorer la résolution et les détails de l'image, souvent appliqué pour affiner et enrichir les textures et les éléments de l'image.

Préprocesseur recommandé : Tile

3.6. Guide pour utiliser plusieurs ControlNet

L'intégration de plusieurs ControlNets ou T2I-Adapters permet l'application séquentielle de différents types de conditionnement à votre processus de génération d'images. Par exemple, vous pouvez combiner les ControlNets Lineart et OpenPose pour des détails améliorés.

Lineart pour la forme des objets : Commencez par intégrer un ControlNet Lineart pour ajouter de la profondeur et des détails aux objets ou éléments de vos images. Ce processus implique la préparation d'une carte de trait ou de contour pour les objets que vous souhaitez inclure.

OpenPose pour le contrôle de la pose : Après les détails du trait, utilisez le ControlNet OpenPose pour dicter la pose des individus dans votre image. Vous devrez générer ou acquérir une carte OpenPose qui capture la pose souhaitée.

Application séquentielle : Pour combiner efficacement ces effets, liez la sortie du ControlNet Lineart au ControlNet OpenPose. Cette méthode garantit que la pose des sujets et les formes des objets sont simultanément guidées pendant le processus de génération, créant un résultat qui s'aligne harmonieusement avec toutes les spécifications d'entrée.

4. Aperçu d'IPAdapter

Veuillez consulter les détails sur