AnimateDiff + ControlNet | Style d'art céramique

Ce workflow dans ComfyUI utilise AnimateDiff et ControlNet se concentrant sur la profondeur, entre autres comme Lora, pour transformer habilement des vidéos en style d'art céramique. Il permet au contenu original d'adopter un style artistique distinct, l'élevant efficacement au rang de chefs-d'œuvre d'art céramique.Flux de travail ComfyUI Vid2Vid (Art)

- Workflows entièrement opérationnels

- Aucun nœud ou modèle manquant

- Aucune configuration manuelle requise

- Propose des visuels époustouflants

Exemples ComfyUI Vid2Vid (Art)

Description ComfyUI Vid2Vid (Art)

1. Workflow ComfyUI : AnimateDiff + ControlNet | Style d'art céramique

Ce workflow utilise AnimateDiff, ControlNet se concentrant sur la profondeur, et des Lora spécifiques pour transformer habilement des vidéos en style d'art céramique. Vous êtes encouragé à utiliser différents prompts pour obtenir divers styles artistiques, transformant vos idées en réalité.

2. Comment utiliser AnimateDiff

AnimateDiff est conçu pour animer des images statiques et des prompts textuels en vidéos dynamiques, en s'appuyant sur des modèles Stable Diffusion et un module de mouvement spécialisé. Il automatise le processus d'animation en prédisant des transitions fluides entre les images, le rendant accessible aux utilisateurs sans compétences en programmation.

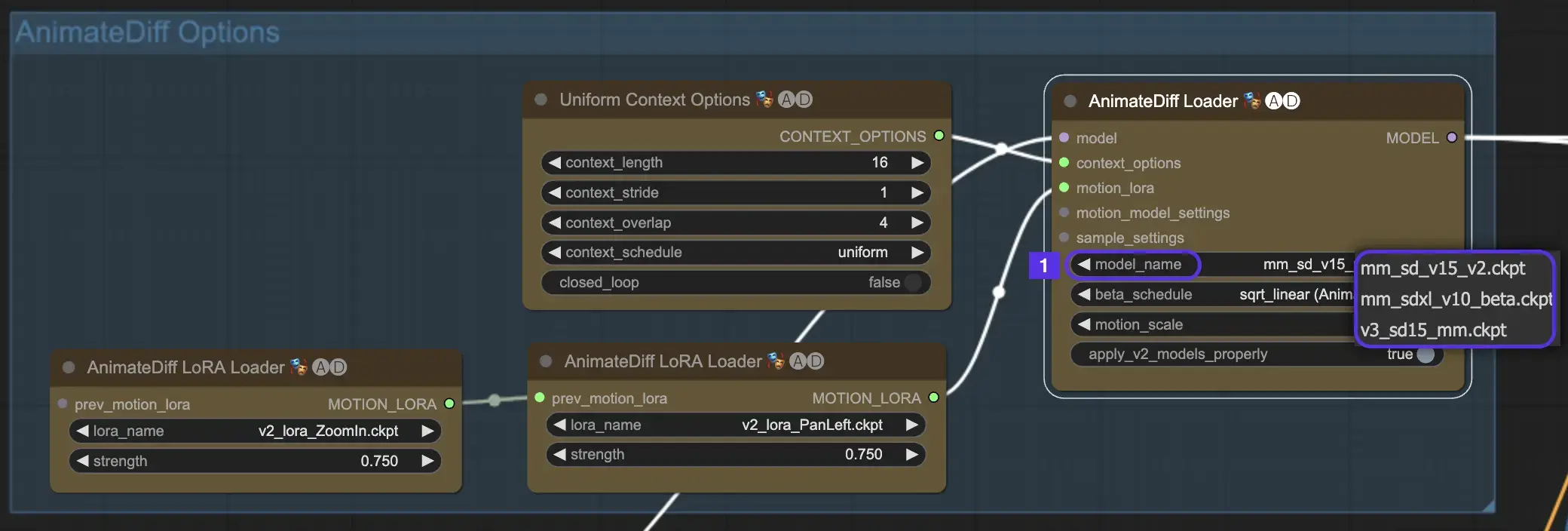

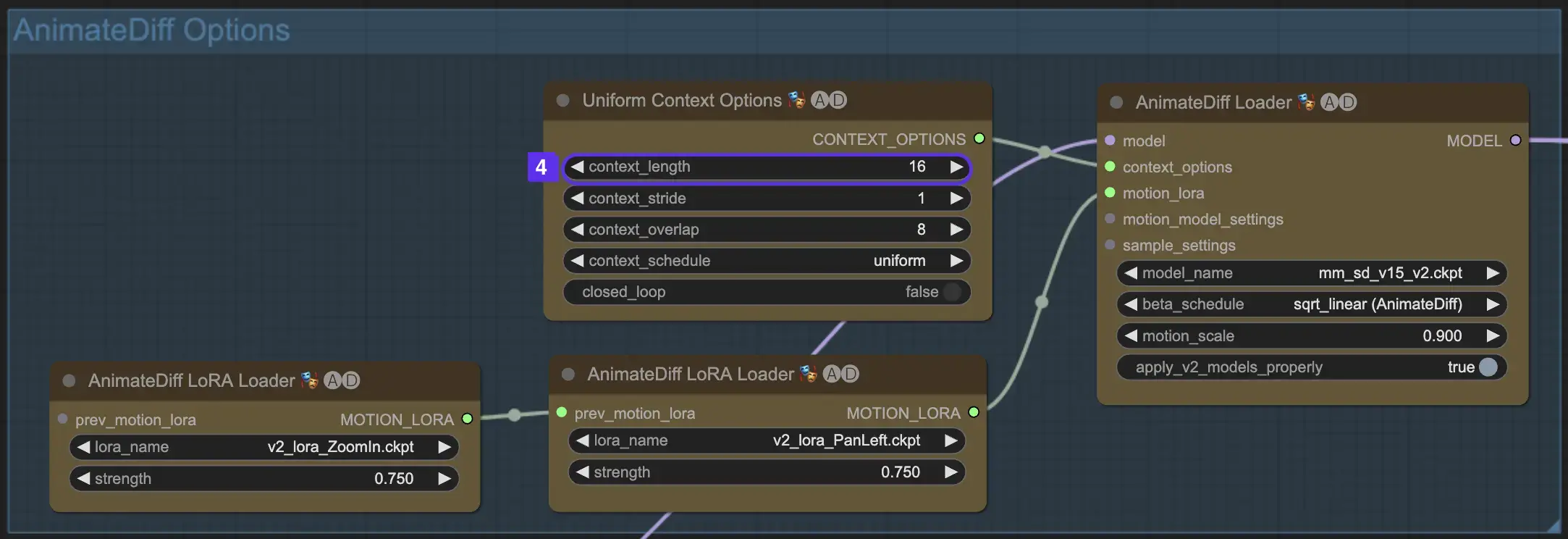

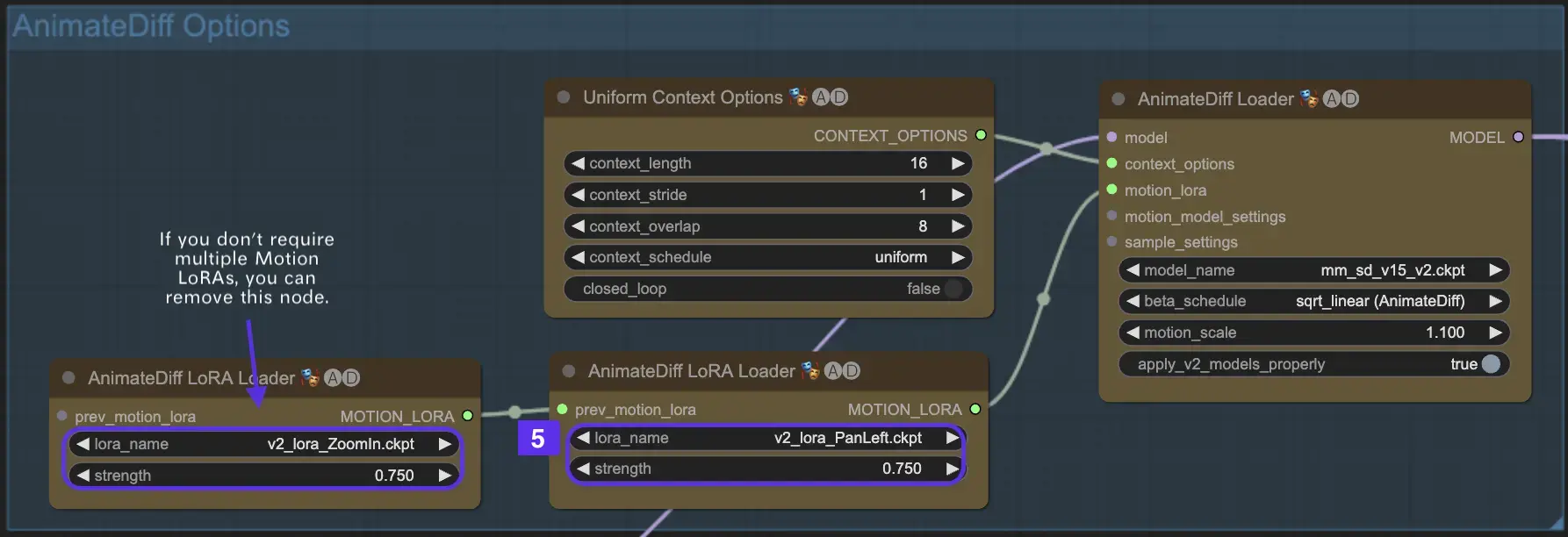

2.1 Modules de mouvement AnimateDiff

Pour commencer, sélectionnez le module de mouvement AnimateDiff souhaité dans le menu déroulant model_name :

- Utilisez v3_sd15_mm.ckpt pour AnimateDiff V3

- Utilisez mm_sd_v15_v2.ckpt pour AnimateDiff V2

- Utilisez mm_sdxl_v10_beta.ckpt pour AnimateDiff SDXL

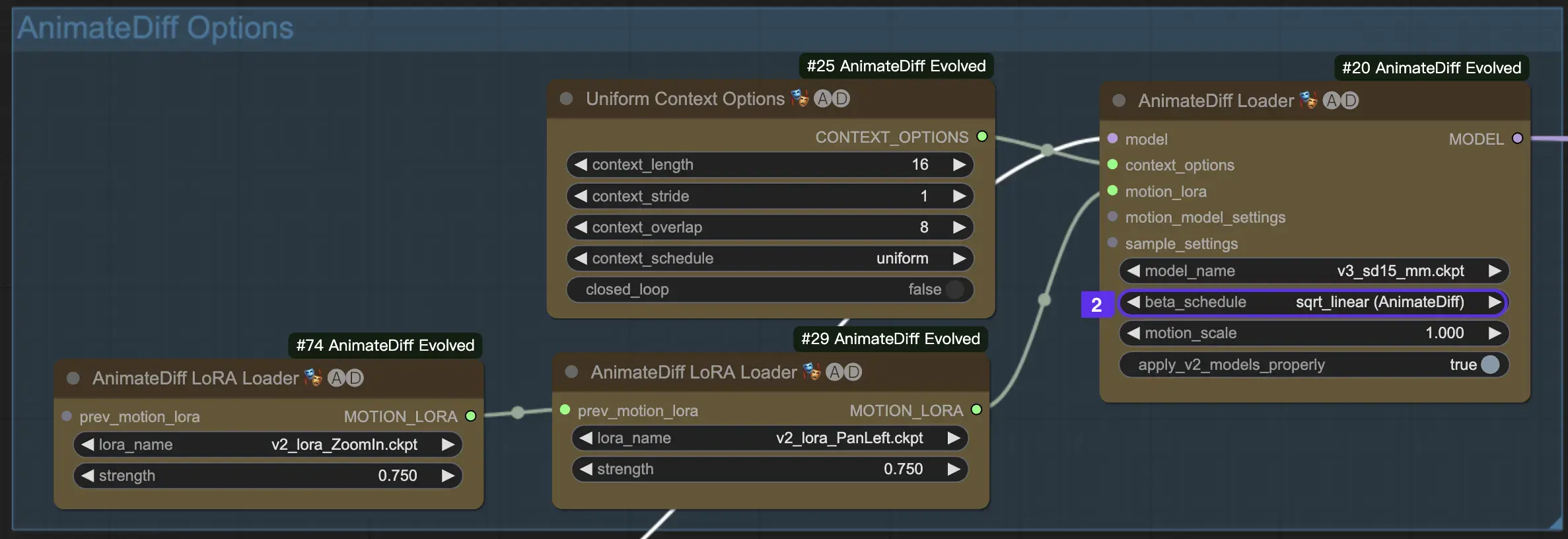

2.2 Beta Schedule

Le Beta Schedule dans AnimateDiff est crucial pour ajuster le processus de réduction du bruit tout au long de la création de l'animation.

Pour les versions V3 et V2 d'AnimateDiff, le réglage sqrt_linear est recommandé, bien que l'expérimentation avec le réglage linear puisse donner des effets uniques.

Pour AnimateDiff SDXL, le réglage linear (AnimateDiff-SDXL) est conseillé.

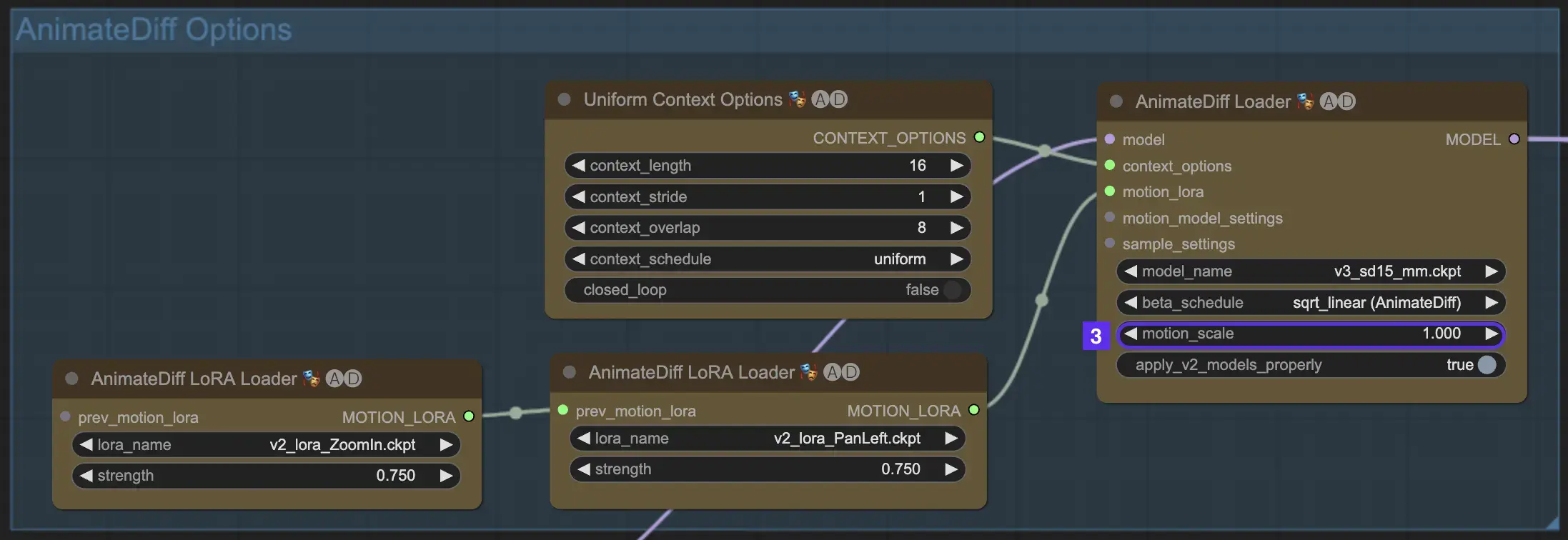

2.3 Échelle de mouvement

La fonctionnalité Motion Scale dans AnimateDiff permet d'ajuster l'intensité du mouvement dans vos animations. Une Motion Scale inférieure à 1 donne un mouvement plus subtil, tandis qu'une échelle supérieure à 1 amplifie le mouvement.

2.4 Longueur de contexte

La longueur de contexte uniforme dans AnimateDiff est essentielle pour assurer des transitions fluides entre les scènes définies par votre taille de lot. Elle agit comme un éditeur expert, connectant de manière transparente les scènes pour une narration fluide. Une longueur de contexte uniforme plus longue assure des transitions plus fluides, tandis qu'une longueur plus courte offre des changements de scène plus rapides et plus distincts, bénéfiques pour certains effets. La longueur de contexte uniforme standard est fixée à 16.

2.5 Utilisation de Motion LoRA pour une dynamique de caméra améliorée (spécifique à AnimateDiff v2)

Les LoRAs de mouvement, compatibles uniquement avec AnimateDiff v2, introduisent une couche supplémentaire de mouvement de caméra dynamique. Trouver l'équilibre optimal avec le poids LoRA, généralement autour de 0.75, assure un mouvement de caméra fluide sans distorsions de l'arrière-plan.

De plus, enchaîner différents modèles Motion LoRA permet une dynamique de caméra complexe. Cela permet aux créateurs d'expérimenter et de découvrir la combinaison idéale pour leur animation, l'élevant à un niveau cinématographique.

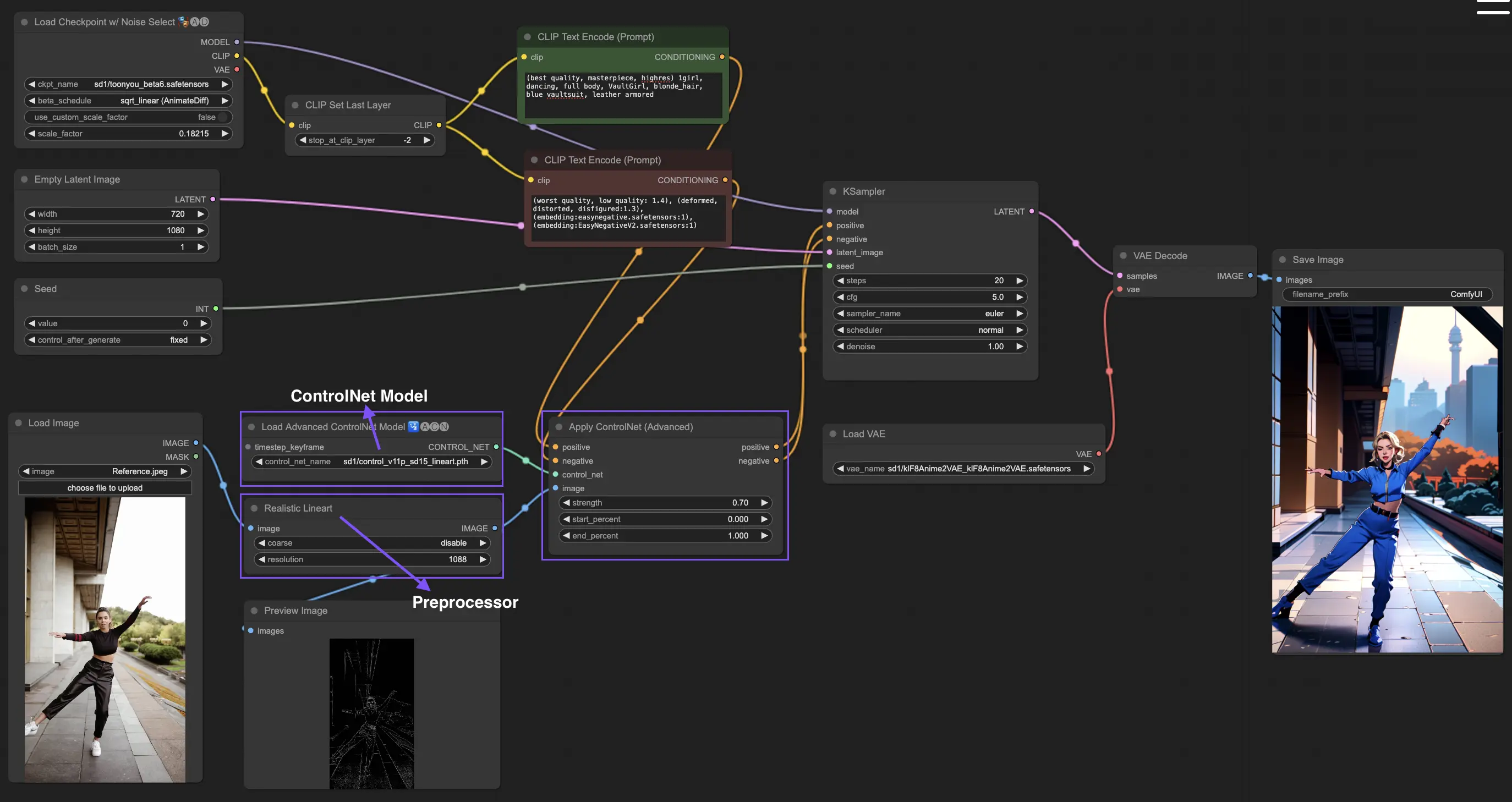

3. Comment utiliser ControlNet

ControlNet améliore la génération d'images en introduisant un contrôle spatial précis aux modèles de texte-à-image, permettant aux utilisateurs de manipuler les images de manière sophistiquée au-delà des simples prompts textuels, en utilisant de vastes bibliothèques de modèles comme Stable Diffusion pour des tâches complexes telles que le croquis, la cartographie et la segmentation visuelle.

Voici le workflow le plus simple utilisant ControlNet.

3.1 Charger le nœud "Apply ControlNet"

Commencez votre création d'image en chargeant le nœud "Apply ControlNet" dans ComfyUI, préparant la combinaison d'éléments visuels et textuels dans votre design.

3.2 Entrées du nœud "Apply ControlNet"

Utilisez le conditionnement positif et négatif pour façonner votre image, sélectionnez un modèle ControlNet pour définir les traits de style, et prétraitez votre image pour vous assurer qu'elle correspond aux exigences du modèle ControlNet, la rendant ainsi prête pour la transformation.

3.3 Sorties du nœud "Apply ControlNet"

Les sorties du nœud guident le modèle de diffusion, offrant le choix entre affiner davantage l'image ou ajouter plus de ControlNets pour des détails et une personnalisation améliorés en fonction de l'interaction de ControlNet avec vos entrées créatives.

3.4 Réglage de "Apply ControlNet" pour de meilleurs résultats

Contrôlez l'influence de ControlNet sur votre image via des paramètres tels que la détermination de la force, l'ajustement du pourcentage de début et la définition du pourcentage de fin pour régler finement le processus créatif et le résultat de l'image.

Pour plus d'informations détaillées, veuillez consulter

Ce workflow est inspiré par avec quelques modifications. Pour plus d'informations, veuillez visiter sa chaîne YouTube.