Hunyuan Video | Testo a Video

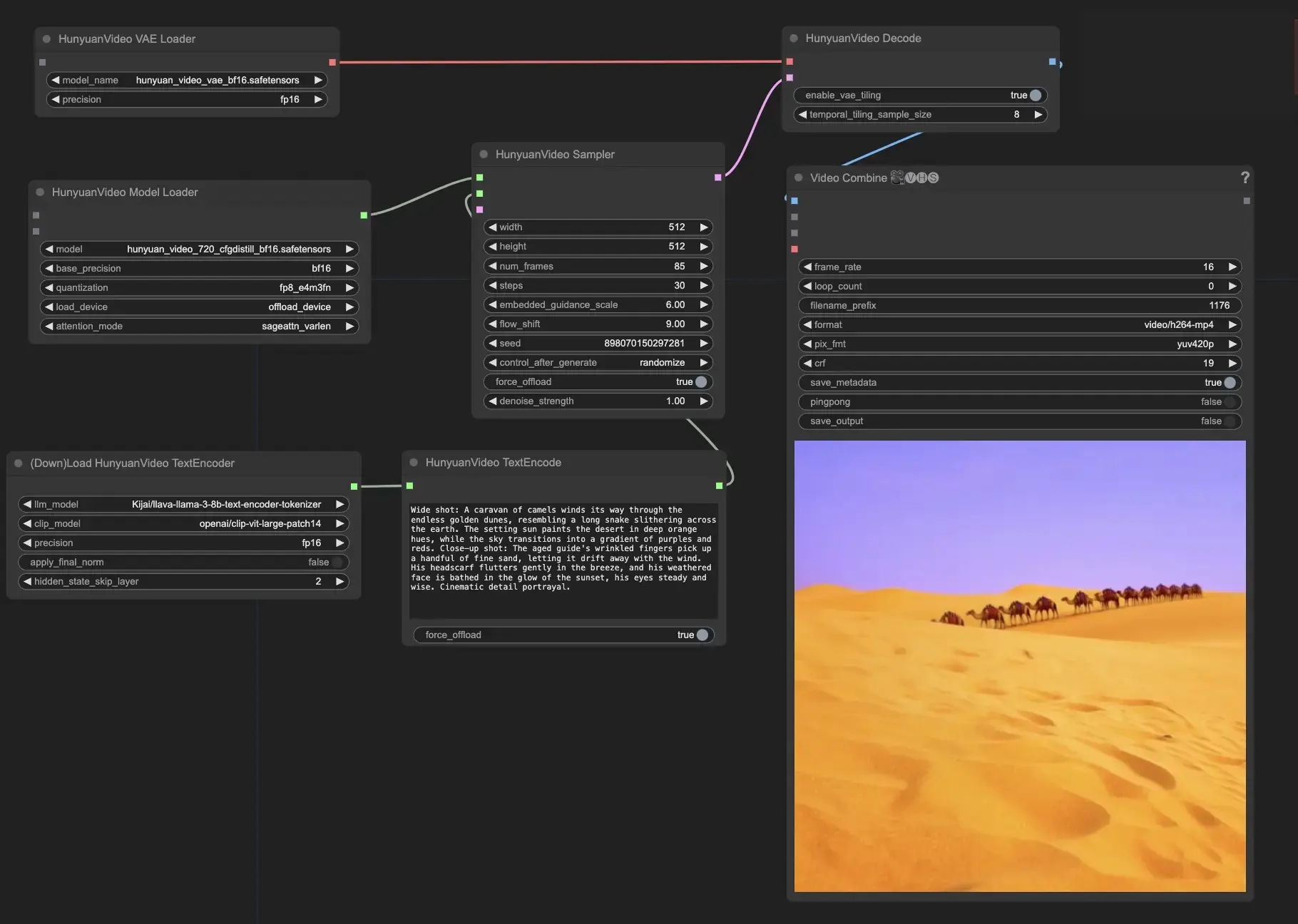

Hunyuan Video è un modello di base video open-source sviluppato da Tencent. Offre prestazioni di generazione video paragonabili, se non superiori, ai principali modelli closed-source. Sfruttando tecniche avanzate come la curazione dei dati, l'addestramento congiunto immagine-video e un'infrastruttura ottimizzata, Hunyuan Video consente la generazione di video di alta qualità su larga scala.ComfyUI Hunyuan Video Flusso di lavoro

- Workflow completamente operativi

- Nessun nodo o modello mancante

- Nessuna configurazione manuale richiesta

- Presenta visuali mozzafiato

ComfyUI Hunyuan Video Esempi

ComfyUI Hunyuan Video Descrizione

è un innovativo modello di base video open-source che offre prestazioni nella generazione video paragonabili, se non migliori, ai migliori modelli closed-source, sviluppato da Tencent, una società tecnologica leader. Hunyuan Video impiega tecnologie all'avanguardia per l'apprendimento del modello, come la curazione dei dati, l'addestramento congiunto immagine-video e un'infrastruttura efficiente per l'addestramento e l'inferenza del modello su larga scala. Hunyuan Video vanta il più grande modello generativo video open-source con oltre 13 miliardi di parametri.

Le caratteristiche principali di Hunyuan Video includono

- Hunyuan Video offre un'architettura unificata per generare sia immagini che video. Utilizza un design speciale del modello Transformer chiamato "Dual-stream to Single-stream." Questo significa che il modello elabora prima le informazioni video e testuali separatamente, per poi combinarle insieme per creare l'output finale. Questo aiuta il modello a comprendere meglio la relazione tra i contenuti visivi e la descrizione testuale.

- Il text encoder in Hunyuan Video si basa su un Modello di Linguaggio Multimodale di Grandi Dimensioni (MLLM). Rispetto ad altri text encoder popolari come CLIP e T5-XXL, MLLM è migliore nell'allineare il testo con le immagini. Può anche fornire descrizioni più dettagliate e ragionamenti sul contenuto. Questo aiuta Hunyuan Video a generare video che corrispondono più accuratamente al testo di input.

- Per gestire efficacemente video ad alta risoluzione e alto frame rate, Hunyuan Video utilizza un Variazionale Autoencoder 3D (VAE) con CausalConv3D. Questo componente comprime i video e le immagini in una rappresentazione più piccola chiamata lo spazio latente. Lavorando in questo spazio compresso, Hunyuan Video può addestrarsi e generare video alla loro risoluzione e frame rate originali senza utilizzare troppe risorse computazionali.

- Hunyuan Video include un modello di riscrittura dei prompt che può adattare automaticamente il testo di input dell'utente per adattarsi meglio alle preferenze del modello. Sono disponibili due modalità: Normale e Master. La modalità Normale si concentra sul miglioramento della comprensione delle istruzioni dell'utente da parte del modello, mentre la modalità Master enfatizza la creazione di video con una qualità visiva superiore. Tuttavia, la modalità Master potrebbe a volte trascurare alcuni dettagli nel testo a favore di un aspetto migliore del video.

Usa Hunyuan Video in ComfyUI

Questi nodi e flussi di lavoro di sono stati sviluppati da Kijai. Diamo tutto il dovuto credito a Kijai per questo lavoro innovativo. Sulla piattaforma RunComfy, stiamo semplicemente presentando i suoi contributi alla comunità.

- Fornisci il tuo prompt testuale: nel nodo HunyuanVideoTextEncode, inserisci il prompt testuale desiderato nel campo "prompt". ci sono alcuni esempi di prompt per il tuo riferimento.

- Configura le impostazioni del video in uscita nel nodo HunyuanVideoSampler:

- Imposta "width" e "height" alla risoluzione preferita

- Imposta "num_frames" alla lunghezza desiderata del video in frame

- "steps" controlla il numero di passaggi di denoising/sampling (predefinito: 30)

- "embedded_guidance_scale" determina la forza della guida del prompt (predefinito: 6.0)

- "flow_shift" influisce sulla lunghezza del video (valori maggiori risultano in video più corti, predefinito: 9.0)