AnimateDiff + ControlNet + IPAdapter V1 | Stile Cartoon

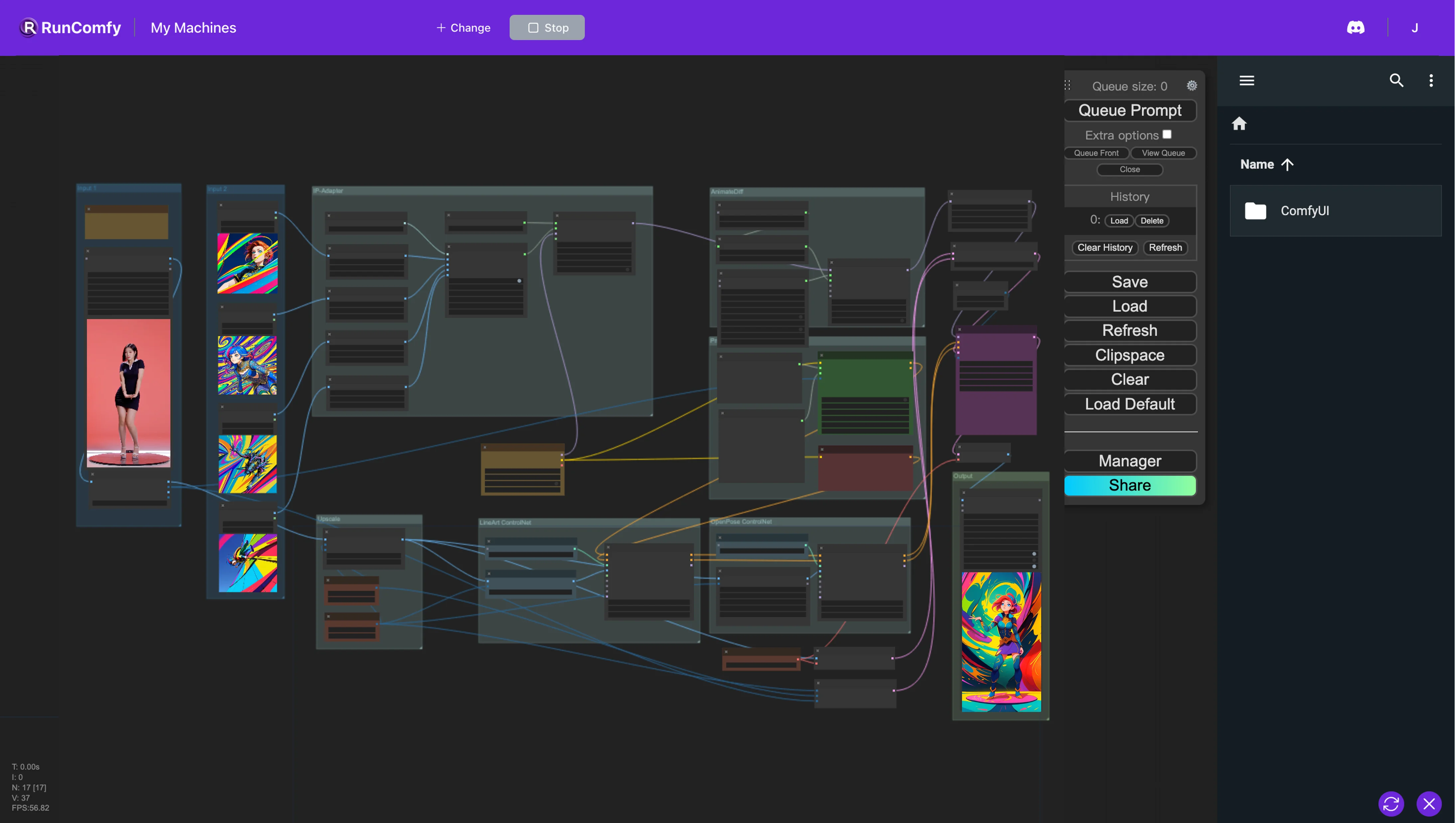

Nel Workflow ComfyUI, integriamo più nodi, tra cui Animatediff, ControlNet (con LineArt e OpenPose), IP-Adapter e FreeU. Questa integrazione facilita la conversione del video originale nell'animazione desiderata utilizzando solo poche immagini per definire lo stile preferito. Tuttavia, anche i modelli di checkpoint influenzano lo stile. Ti incoraggiamo a sperimentare con una varietà di immagini e modelli di checkpoint per ottenere i migliori risultati!ComfyUI Vid2Vid (Cartoon Style) Flusso di lavoro

- Workflow completamente operativi

- Nessun nodo o modello mancante

- Nessuna configurazione manuale richiesta

- Presenta visuali mozzafiato

ComfyUI Vid2Vid (Cartoon Style) Esempi

ComfyUI Vid2Vid (Cartoon Style) Descrizione

1. Workflow ComfyUI AnimateDiff, ControlNet, IP-Adapter e FreeU

Il workflow ComfyUI implementa una metodologia per il restyling video che integra diversi componenti—AnimateDiff, ControlNet, IP-Adapter e FreeU—per migliorare le capacità di editing video.

AnimateDiff: Questo componente utilizza modelli di differenza temporale per creare animazioni fluide da immagini statiche nel tempo. Funziona identificando le differenze tra fotogrammi consecutivi e applicando progressivamente queste variazioni per ridurre i cambiamenti bruschi, preservando così la coerenza del movimento.

ControlNet: ControlNet sfrutta i segnali di controllo, come quelli derivati da strumenti di stima della posa come OpenPose, per guidare il movimento e il flusso dell'animazione. Questi segnali di controllo sono stratificati ed elaborati da modelli simili a reti di controllo, che a loro volta plasmano l'output animato finale.

IP-Adapter: L'IP-Adapter è progettato per adattare le immagini di input in modo che si allineino più strettamente con gli stili o le caratteristiche di output desiderate. Intraprende processi come la colorazione e il trasferimento di stile, alterando gli attributi dell'immagine in modo non supervisionato.

FreeU: Come strumento di miglioramento economico, FreeU affina i modelli di diffusione ottimizzando le architetture U-Net esistenti. Ciò si traduce in un aumento sostanziale della qualità della generazione di immagini e video, richiedendo solo modifiche minime.

Insieme, questi componenti si sinergizzano all'interno di questo workflow ComfyUI per trasformare gli input in animazioni stilizzate attraverso un sofisticato processo di diffusione multi-fase.

2. Panoramica di AnimateDiff

Per favore, controlla i dettagli su

3. Panoramica di ControlNet

Per favore, controlla i dettagli su

4. Panoramica di IP-Adapter

Per favore, controlla i dettagli nell

5. Panoramica di FreeU

5.1. Introduzione a FreeU

FreeU è un miglioramento all'avanguardia per i modelli di diffusione che migliora la qualità del campione senza costi aggiuntivi. Funziona all'interno del sistema esistente, non richiede ulteriore addestramento, nessun parametro extra e mantiene la memoria e il tempo di elaborazione attuali. FreeU utilizza i meccanismi esistenti dell'architettura U-Net di diffusione per migliorare istantaneamente la qualità della generazione.

L'innovazione di FreeU risiede nella sua capacità di sfruttare più efficacemente l'architettura U-Net di diffusione. Affina l'equilibrio tra il backbone di denoising della U-Net e le sue connessioni skip che aggiungono caratteristiche ad alta frequenza, ottimizzando la qualità delle immagini e dei video generati senza compromettere l'integrità semantica.

FreeU è progettato per una facile integrazione con i modelli di diffusione più diffusi, richiedendo adattamenti minimi e la messa a punto di soli due fattori di scala durante l'inferenza per fornire notevoli miglioramenti nella qualità dell'output. Ciò rende FreeU un'opzione attraente per coloro che cercano di migliorare i loro flussi di lavoro generativi in modo efficiente.

Parametri per prestazioni FreeU ottimali

Sentiti libero di regolare questi parametri in base ai tuoi modelli, allo stile dell'immagine/video o alle attività. I seguenti parametri sono solo di riferimento.

SD1.4: (verrà aggiornato presto)

b1: 1.3, b2: 1.4, s1: 0.9, s2: 0.2

SD1.5: (verrà aggiornato presto)

b1: 1.5, b2: 1.6, s1: 0.9, s2: 0.2

SD2.1

b1: 1.4, b2: 1.6, s1: 0.9, s2: 0.2

SDXL

b1: 1.3, b2: 1.4, s1: 0.9, s2: 0.2

Range per altri parametri

Quando si provano parametri aggiuntivi, considera i seguenti intervalli:

- b1: 1 ≤ b1 ≤ 1.2

- b2: 1.2 ≤ b2 ≤ 1.6

- s1: s1 ≤ 1

- s2: s2 ≤ 1

Per ulteriori informazioni, controlla su