Questa guida fornisce un'introduzione completa alla creazione di contenuti 3D con il modello "Wonder3D", utilizzando le capacità avanzate dei nodi "ComfyUI 3D Pack" per ottimizzare i flussi di lavoro e migliorare la qualità dell'output.

Parte 1: ComfyUI 3D Pack

1.1. Introduzione a ComfyUI 3D Pack

ComfyUI 3D Pack è una suite estesa di nodi che consente a ComfyUI di elaborare input 3D come Mesh & UV Texture utilizzando algoritmi e modelli all'avanguardia. Integra algoritmi avanzati di elaborazione 3D come 3DGS (Gaussian Splatting) e NeRF (Neural Radiance Fields), insieme a modelli di ultima generazione tra cui Hunyuan3D, StableFast3D, InstantMesh, CRM, TripoSR e altri.

Con il ComfyUI 3D Pack, gli utenti possono importare, manipolare e generare contenuti 3D di alta qualità all'interno dell'interfaccia intuitiva di ComfyUI. Supporta un'ampia gamma di formati di file 3D come OBJ, PLY, GLB, consentendo una facile integrazione di modelli 3D esistenti. Il pacchetto include anche potenti utility di elaborazione mesh per modificare, pulire e ottimizzare la geometria 3D.

Uno dei punti salienti è l'integrazione della tecnologia NeRF che consente una ricostruzione 3D fotorealistica da immagini 2D. I nodi 3DGS abilitano il rendering e la stilizzazione del cloud di punti. I modelli InstantMesh e TripoSR consentono l'upscaling ad alta risoluzione e la super-risoluzione delle mesh 3D. CRM (Convolutional Reconstruction Model) consente di recuperare la forma 3D da immagini multi-vista e CCM (Color Correction Map).

ComfyUI 3D Pack è stato sviluppato da MrForExample, con tutto il merito a MrForExample. Per informazioni dettagliate, consulta ComfyUI 3D Pack.

1.2. ComfyUI 3D Pack: Pronto per l'Uso su RunComfy

Ora ComfyUI 3D Pack è completamente configurato e pronto per l'uso sul sito web RunComfy. Gli utenti non devono installare alcun software aggiuntivo o dipendenze. Tutti i modelli, algoritmi e strumenti richiesti sono pre-configurati e ottimizzati per funzionare efficacemente nell'ambiente web-based di ComfyUI.

Parte 2: Utilizzo del modello Wonder3D con i Nodi ComfyUI 3D Pack

2.1. Cos'è Wonder3D?

Wonder3D è un metodo all'avanguardia per generare efficientemente mesh con texture di alta qualità da immagini a vista singola. Sfrutta la potenza dei modelli di diffusione cross-domain per generare mappe normali multi-vista e le corrispondenti immagini a colori. Wonder3D mira ad affrontare le sfide di fedeltà, coerenza, generalizzabilità ed efficienza nei compiti di ricostruzione 3D da vista singola.

Wonder3D è stato sviluppato da un team di ricercatori dell'Università di Hong Kong, Università di Tsinghua, VAST, Università della Pennsylvania, Shanghai Tech University, MPI Informatik e Texas A&M University, con Xiaoxiao Long e Yuan-Chen Guo come primi autori a pari merito. Tutto il merito va al loro contributo; per ulteriori informazioni, consulta la loro pagina del progetto qui.

2.2. Tecniche dietro Wonder3D

Il cuore di Wonder3D risiede nel suo innovativo modello di diffusione cross-domain. Questo modello è progettato per catturare la distribuzione congiunta delle mappe normali e delle immagini a colori su più viste. Per ottenere ciò, Wonder3D introduce uno switcher di dominio e uno schema di attenzione cross-domain. Lo switcher di dominio consente la generazione senza soluzione di continuità di mappe normali o immagini a colori, mentre il meccanismo di attenzione cross-domain facilita lo scambio di informazioni tra i due domini, migliorando la coerenza e la qualità.

Un altro componente chiave di Wonder3D è il suo algoritmo di fusione normale consapevole della geometria. Questo algoritmo estrae in modo robusto superfici di alta qualità dalle rappresentazioni 2D multi-vista generate, anche in presenza di imprecisioni. Sfruttando i ricchi dettagli superficiali codificati nelle mappe normali e nelle immagini a colori, Wonder3D ricostruisce geometrie pulite e dettagliate.

2.3. Vantaggi/Potenziali Limitazioni di Wonder3D

Wonder3D offre diversi vantaggi rispetto ai metodi di ricostruzione da vista singola esistenti. Raggiunge un elevato livello di dettaglio geometrico mantenendo una buona efficienza, rendendolo adatto a varie applicazioni. Il modello di diffusione cross-domain consente a Wonder3D di generalizzare bene a diverse categorie di oggetti e stili. La coerenza multi-vista imposta dal meccanismo di attenzione cross-domain risulta in ricostruzioni 3D coerenti e plausibili.

Tuttavia, come qualsiasi metodo, Wonder3D può presentare alcune limitazioni. La qualità delle mesh generate dipende dai dati di addestramento e dalla capacità del modello di diffusione di catturare la struttura 3D sottostante. Forme altamente complesse o ambigue potrebbero rappresentare sfide. Inoltre, l'attuale implementazione di Wonder3D si concentra su oggetti singoli, ed estenderla per gestire più oggetti o intere scene potrebbe essere un'area per future ricerche.

2.4. Come utilizzare il flusso di lavoro Wonder3D

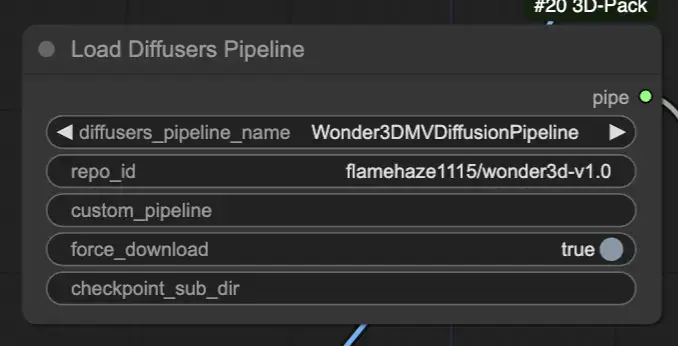

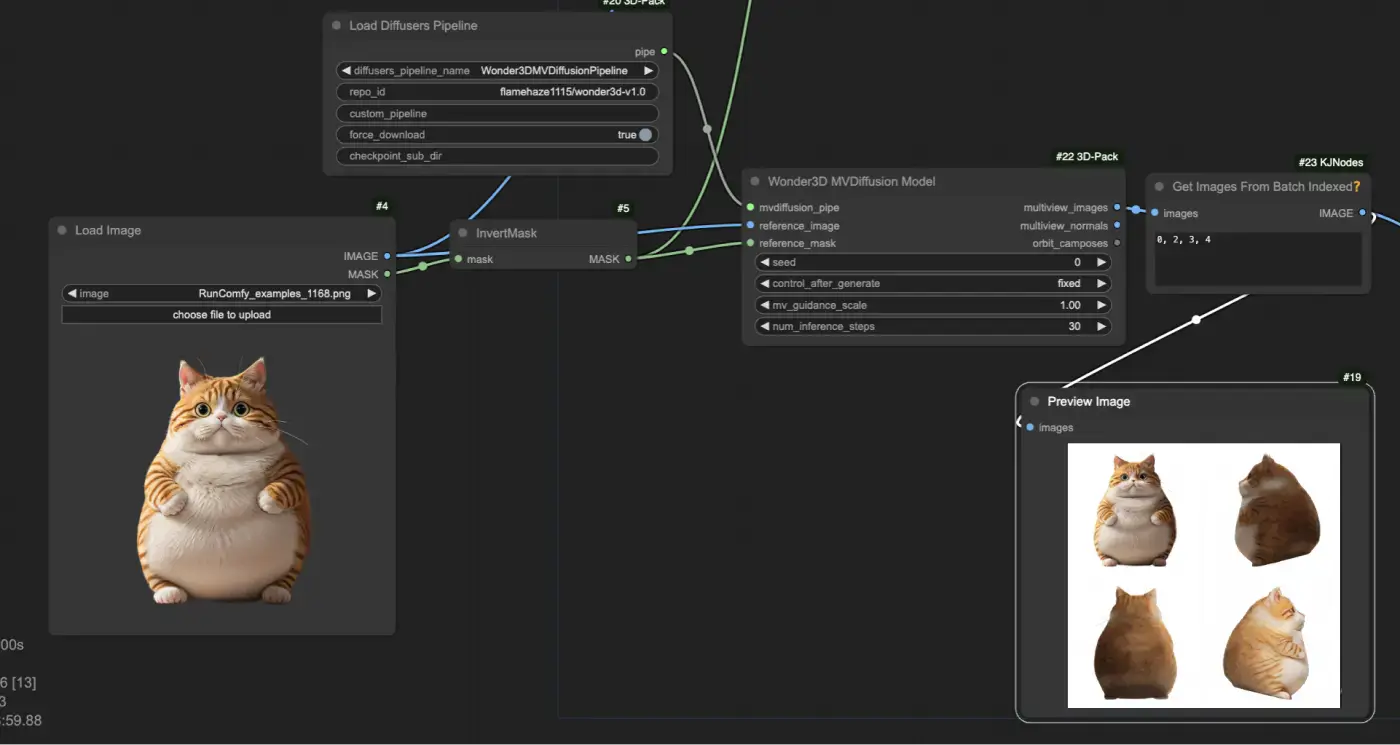

Carica la pipeline di diffusione pre-addestrata Wonder3D utilizzando il nodo "[Comfy3D] Load Diffusers Pipeline", che importa i checkpoint e le configurazioni del modello necessari.

Fornisci un'immagine di input e la sua maschera corrispondente utilizzando i nodi "LoadImage" e "InvertMask". Quindi, inserisci l'immagine di input e la maschera nel nodo "[Comfy3D] Wonder3D MVDiffusion Model", che genera mappe normali multi-vista e immagini a colori.

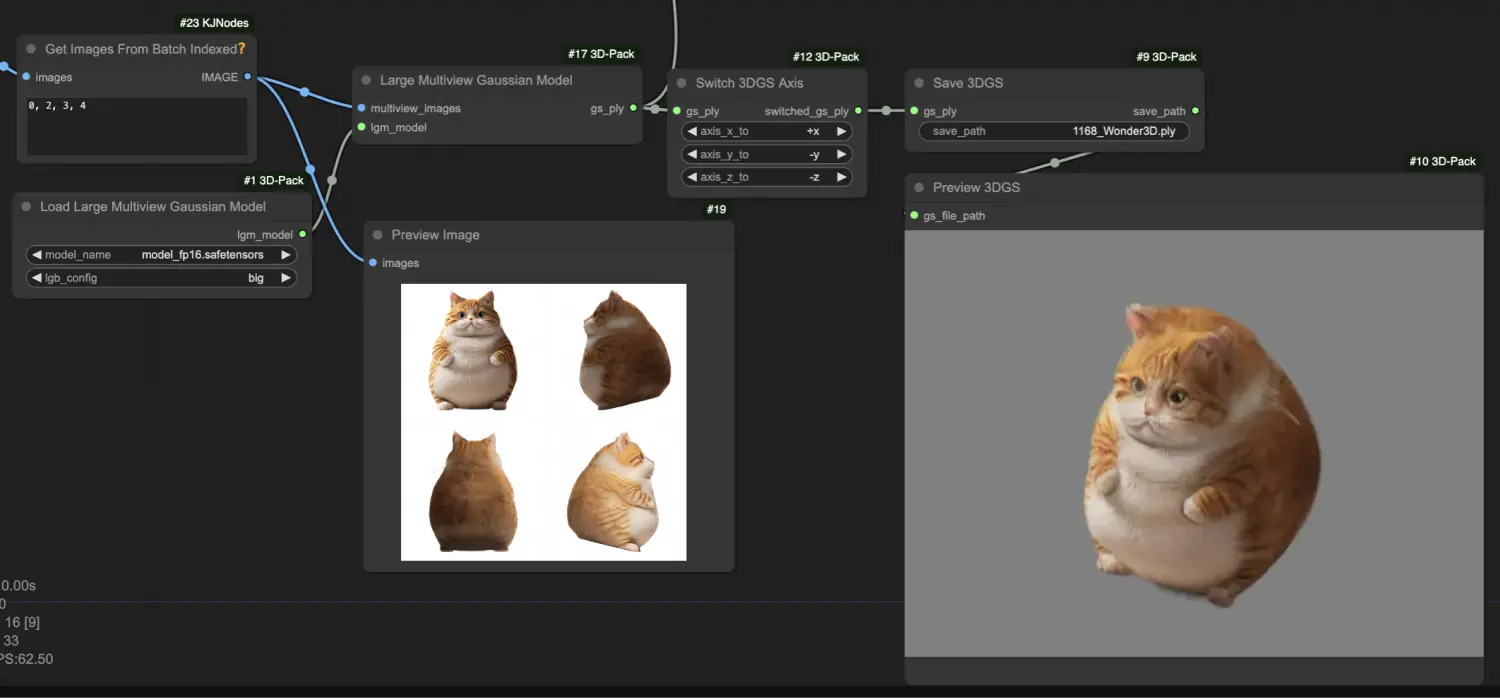

Elabora le immagini multi-vista generate utilizzando il nodo "[Comfy3D] Large Multiview Gaussian Model", che le converte in una rappresentazione di Splatting Gaussiano 3D (3DGS), catturando i dettagli geometrici dell'oggetto in un formato di cloud di punti.

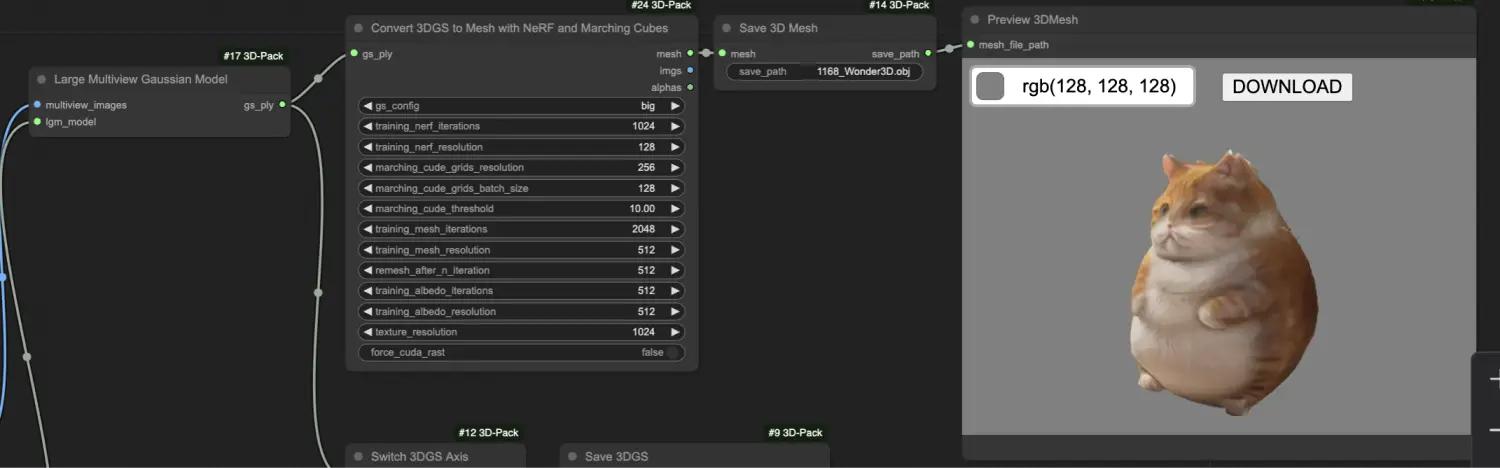

Trasforma la rappresentazione 3DGS in una mesh con texture utilizzando il nodo "[Comfy3D] Convert 3DGS to Mesh with NeRF and Marching Cubes", che impiega campi di radianza neurale (NeRF) e algoritmi di marching cubes per estrarre una mesh di alta qualità.