Questa guida fornisce un'introduzione completa alla creazione di contenuti 3D con il modello 'Hunyuan3D', utilizzando le capacità avanzate dei nodi "ComfyUI 3D Pack" per semplificare i flussi di lavoro e migliorare la qualità dei risultati.

Parte 1: ComfyUI 3D Pack

1.1. Introduzione al ComfyUI 3D Pack

ComfyUI 3D Pack è una suite di nodi estensiva che consente a ComfyUI di elaborare input 3D come Mesh & UV Texture utilizzando algoritmi e modelli all'avanguardia. Integra algoritmi avanzati di elaborazione 3D come 3DGS (Gaussian Splatting) e NeRF (Neural Radiance Fields), insieme a modelli di ultima generazione tra cui Hunyuan3D, StableFast3D, InstantMesh, CRM, TripoSR e altri.

Con il ComfyUI 3D Pack, gli utenti possono importare, manipolare e generare contenuti 3D di alta qualità all'interno dell'interfaccia intuitiva di ComfyUI. Supporta una vasta gamma di formati di file 3D come OBJ, PLY, GLB, consentendo una facile integrazione di modelli 3D esistenti. Il pacchetto include anche potenti utility di elaborazione mesh per modificare, pulire e ottimizzare la geometria 3D.

Uno dei punti salienti è l'integrazione della tecnologia NeRF che consente la ricostruzione 3D fotorealistica da immagini 2D. I nodi 3DGS consentono il rendering e la stilizzazione di nuvole di punti. I modelli InstantMesh e TripoSR permettono l'upscaling ad alta risoluzione e la super-risoluzione delle mesh 3D. CRM (Convolutional Reconstruction Model) consente di recuperare la forma 3D da immagini multi-vista e CCM (Color Correction Map).

ComfyUI 3D Pack è stato sviluppato da MrForExample, con tutti i crediti a MrForExample. Per informazioni dettagliate, si prega di consultare ComfyUI 3D Pack.

1.2. ComfyUI 3D Pack: Pronto per l'Uso su RunComfy

Ora ComfyUI 3D Pack è completamente configurato e pronto per l'uso sul sito RunComfy. Gli utenti non hanno bisogno di installare alcun software o dipendenza aggiuntiva. Tutti i modelli, algoritmi e strumenti richiesti sono preconfigurati e ottimizzati per funzionare efficacemente nell'ambiente web-based di ComfyUI.

Parte 2: Utilizzo del modello Hunyuan3D con i Nodi del ComfyUI 3D Pack

2.1. Cos'è Hunyuan3D?

Hunyuan3D è un innovativo framework di generazione 3D sviluppato da Tencent che combina la potenza dei modelli di diffusione multi-vista e dei modelli di ricostruzione a vista sparsa per creare asset 3D di alta qualità da immagini singole o descrizioni testuali. Il framework Hunyuan3D 1.0 è disponibile in due versioni: una versione lite e una versione standard, entrambe supportano la generazione condizionata da testo e immagine. Per informazioni dettagliate, si prega di consultare Hunyuan3D-1.

2.2. Tecniche Dietro Hunyuan3D

Hunyuan3D introduce diverse innovazioni tecniche per migliorare la velocità e la qualità della generazione 3D:

a. Pipeline a due fasi:

Nella prima fase, un modello di diffusione multi-vista genera efficientemente immagini RGB multi-vista. Queste immagini catturano dettagli ricchi dell'asset 3D da vari punti di vista.

La seconda fase impiega un modello di ricostruzione feed-forward che ricostruisce rapidamente l'asset 3D dalle immagini multi-vista generate.

b. Distribuzione della posa a 0-elevazione

La generazione multi-vista di Hunyuan3D utilizza un'orbita della telecamera a 0-elevazione, massimizzando l'area visibile tra le viste generate e migliorando la qualità della ricostruzione.

c. Guida adattativa senza classificatore

Questa tecnica bilancia controllabilità e diversità per la diffusione multi-vista, garantendo risultati coerenti e di alta qualità.

d. Input ibridi

Il modello di ricostruzione a vista sparsa incorpora l'immagine condizionata non calibrata come vista ausiliaria per compensare le parti non viste nelle immagini generate, migliorando l'accuratezza della ricostruzione.

2.3. Vantaggi e Potenziali Limitazioni di Hunyuan3D

Vantaggi:

- Generazione 3D rapida: Hunyuan3D può creare asset 3D di alta qualità in soli 10 secondi, riducendo significativamente i tempi di generazione rispetto ai metodi basati sull'ottimizzazione.

- Migliore generalizzazione: Separando i compiti di generazione a vista singola in generazione di immagini multi-vista e ricostruzione a vista sparsa, Hunyuan3D ottiene una migliore generalizzazione a oggetti non visti.

- Framework unificato: Hunyuan3D supporta sia la generazione 3D condizionata da testo che da immagine, rendendolo uno strumento versatile per varie applicazioni.

Potenziali Limitazioni:

- Requisiti di memoria: La versione standard di Hunyuan3D ha 3 volte più parametri rispetto alla versione lite, il che può richiedere più memoria per prestazioni ottimali.

- Generazione di strutture sottili: Come altri metodi feed-forward, Hunyuan3D potrebbe avere difficoltà a generare strutture sottili e simili a carta.

2.4. Come Usare il Workflow Hunyuan3D in ComfyUI

Ecco una guida passo-passo per utilizzare il workflow Hunyuan3D per generare mesh 3D di alta qualità da immagini singole

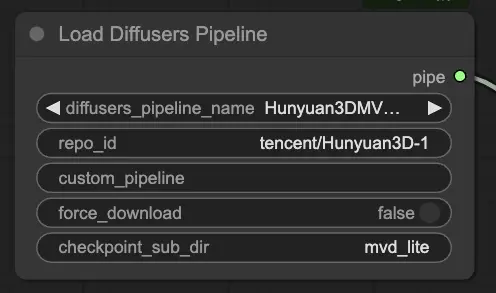

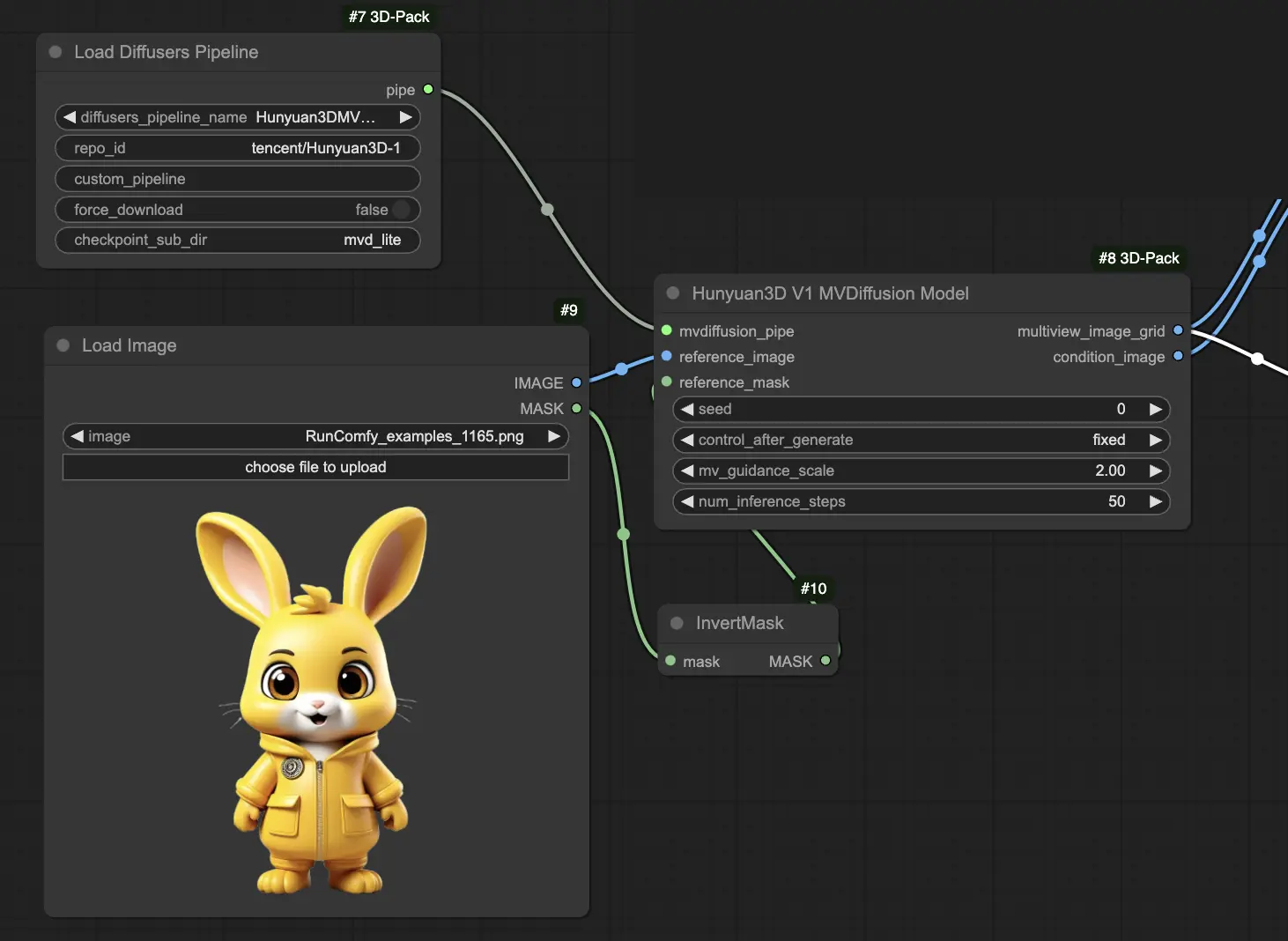

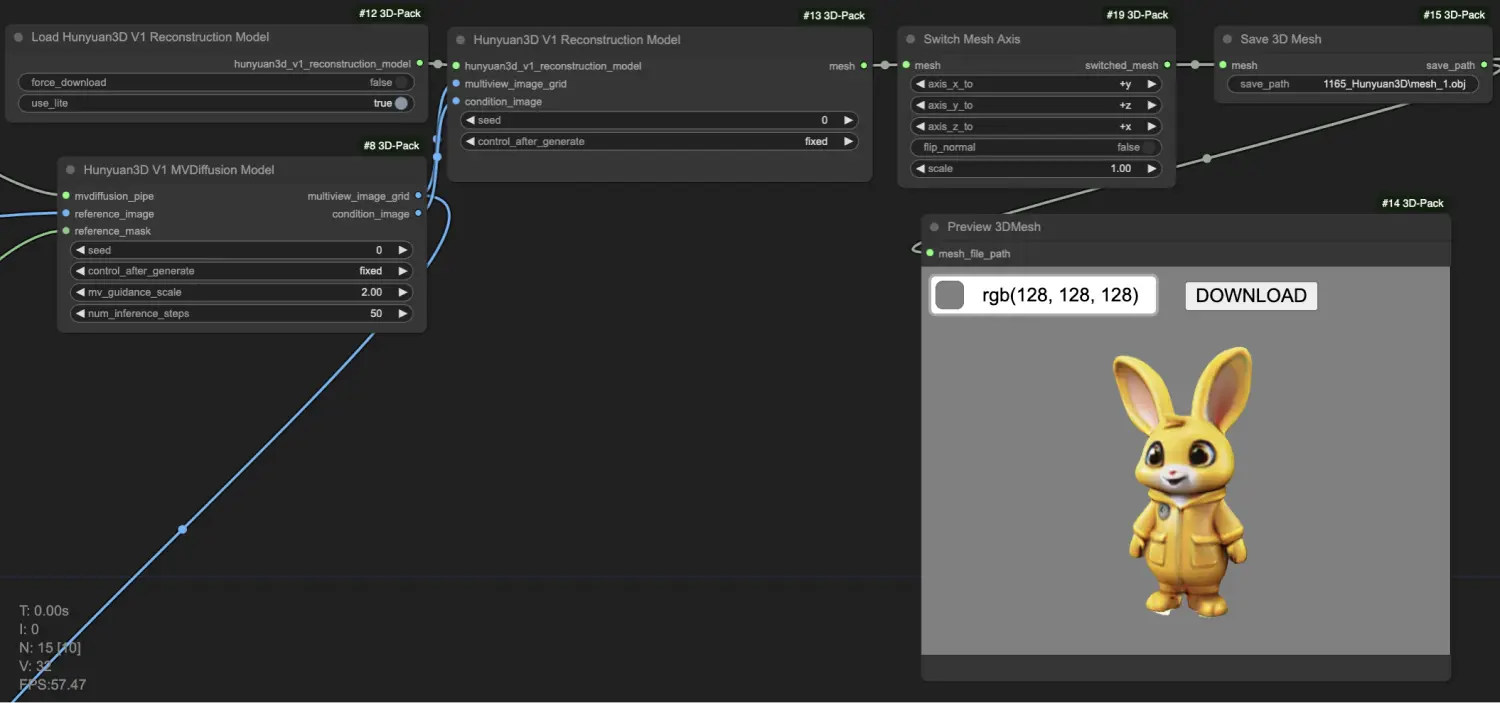

Carica il modello di diffusione multi-vista di Hunyuan3D usando il nodo "[Comfy3D] Load Diffusers Pipeline". Scegli tra la versione lite o standard in base alla memoria della tua GPU.

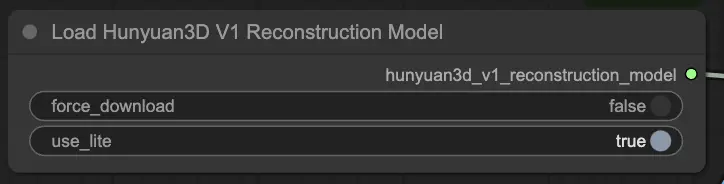

Carica il modello di ricostruzione Hunyuan3D usando il nodo "[Comfy3D] Load Hunyuan3D V1 Reconstruction Model".

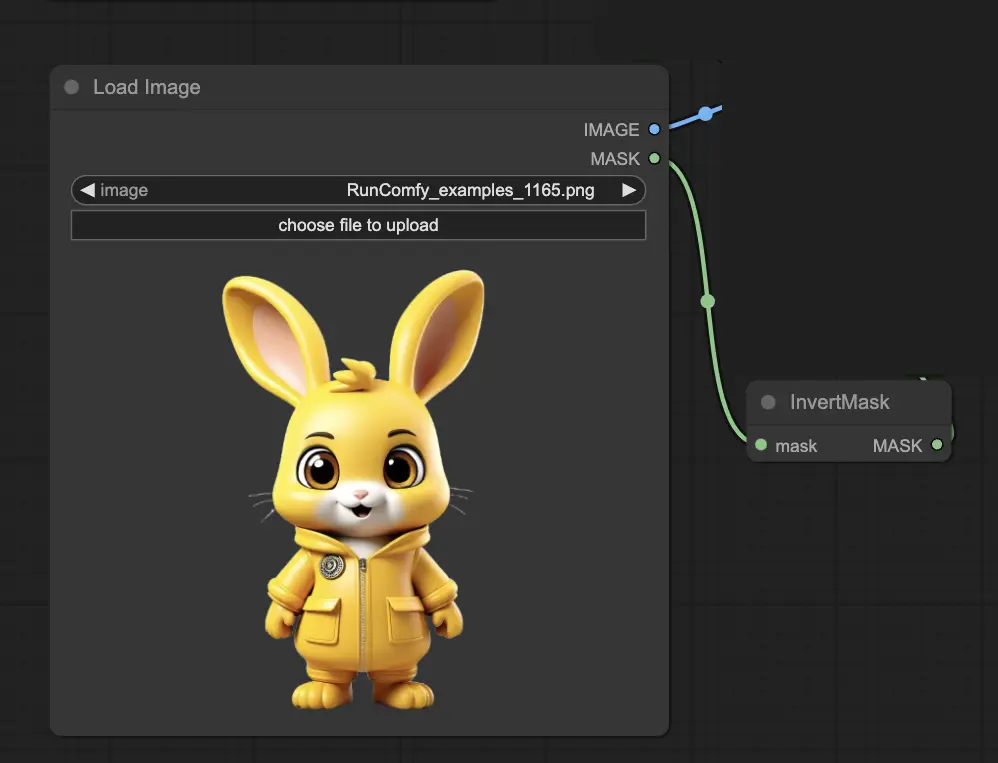

Prepara l'immagine di input e la maschera usando i nodi "LoadImage" e "InvertMask".

Alimenta la pipeline di diffusione caricata, l'immagine di input e la maschera nel nodo "[Comfy3D] Hunyuan3D V1 MVDiffusion Model" per generare immagini multi-vista e un'immagine condizionata.

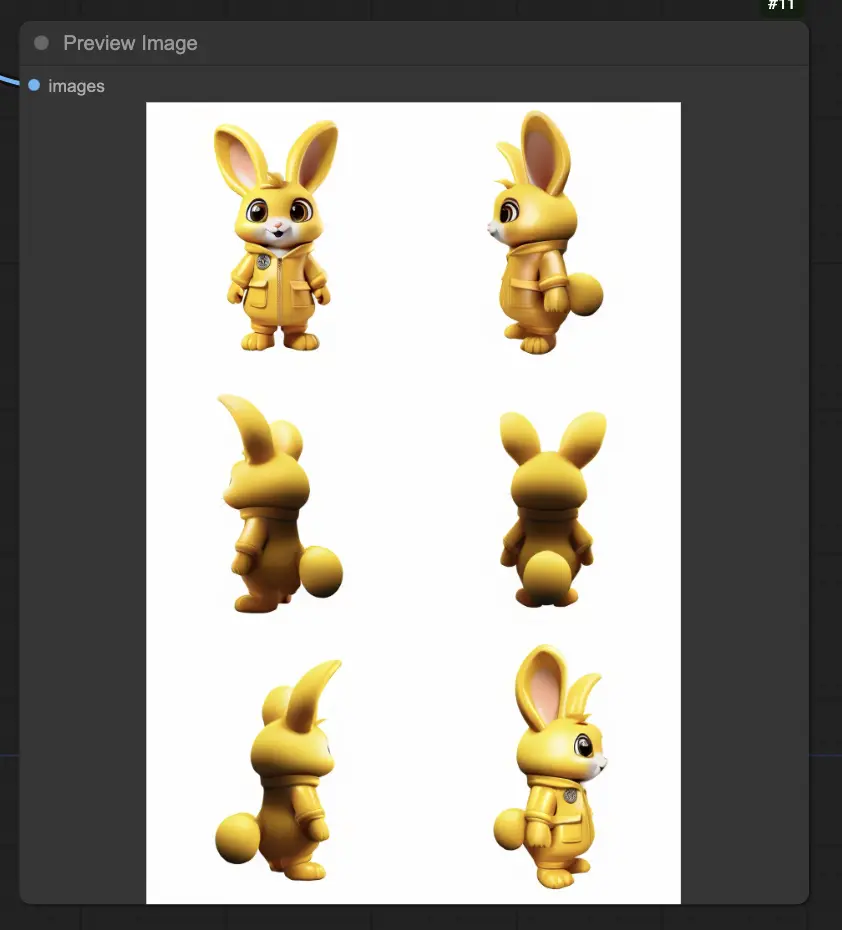

Visualizza in anteprima le immagini multi-vista generate usando il nodo "PreviewImage".

Inserisci il modello di ricostruzione caricato, le immagini multi-vista generate e l'immagine condizionata nel nodo "[Comfy3D] Hunyuan3D V1 Reconstruction Model" per creare la mesh 3D. Inoltre, puoi regolare l'asse e la scala della mesh usando il nodo "[Comfy3D] Switch Mesh Axis" se necessario.

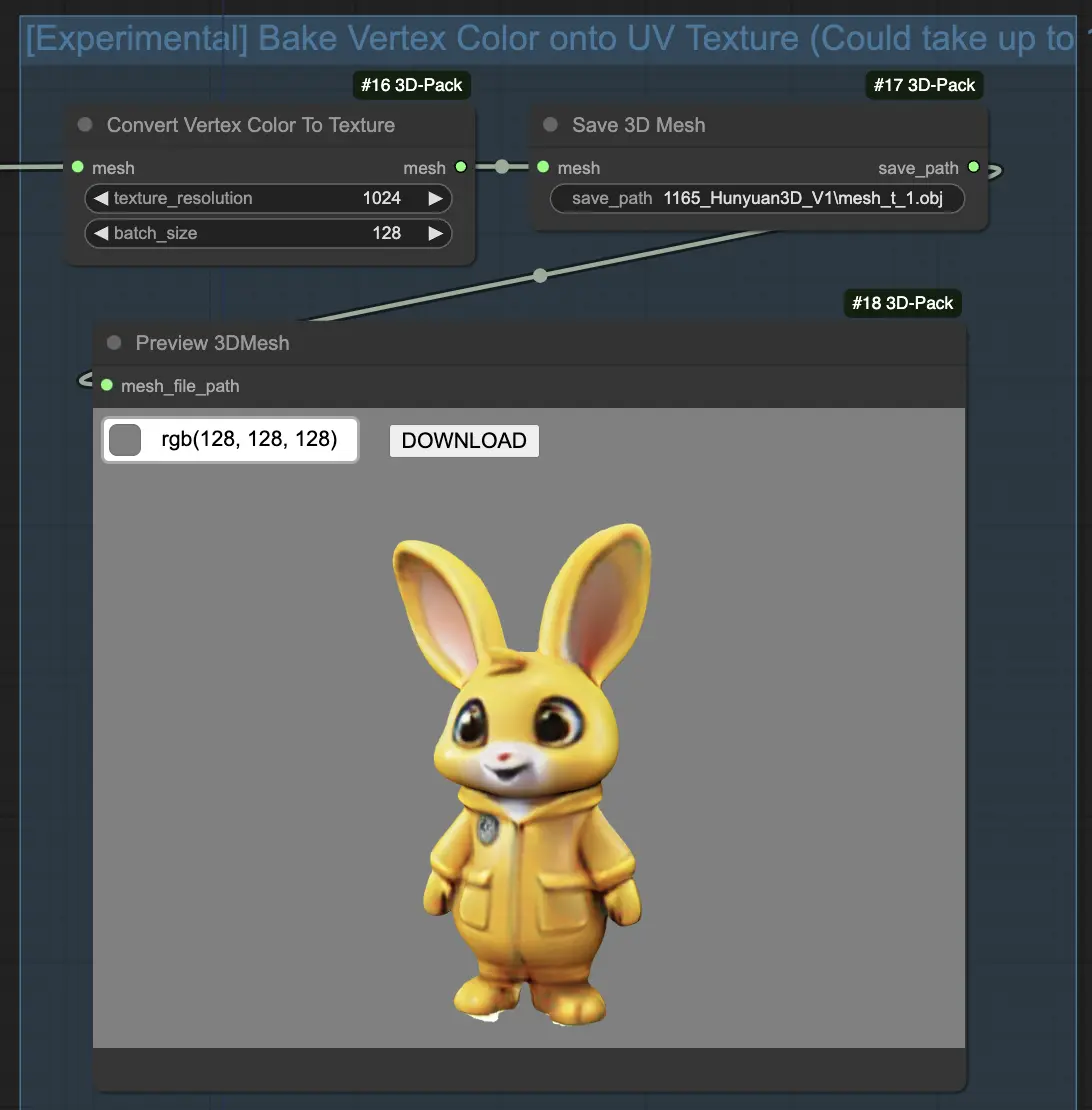

(Opzionale) Converti i colori dei vertici in texture usando il nodo "[Comfy3D] Convert Vertex Color To Texture" per migliorare la qualità della texture.

Ora puoi sbloccare il pieno potenziale di Hunyuan3D per creare straordinari asset 3D da un'immagine singola. Il modello Hunyuan3D rende la generazione 3D avanzata più accessibile che mai!