このアンサンプリングガイドは、Inner-Reflectionsによって書かれたもので、劇的に一貫したビデオスタイル転送を達成するためのアンサンプリング方法の探求に大いに貢献しています。

1. はじめに:アンサンプリングによる潜在ノイズの制御

潜在ノイズは、安定拡散におけるすべての基礎です。これは、私たちが何を達成できるかを考えると驚くべきことです。ただし、一般的に言えば、ノイズを生成するために乱数を使用することを強いられます。これを制御できるとしたらどうでしょうか?

私はアンサンプリングを最初に使用したわけではありません。それは非常に長い間存在しており、いくつかの異なる方法で使用されてきました。しかし、これまでのところ、私は結果に満足していませんでした。私は数か月を費やして最適な設定を見つけ、このガイドを楽しんでいただけることを願っています。

AnimateDiff/Hotshotを使用してサンプリングプロセスを行うことで、元のビデオを表すノイズを見つけることができ、あらゆる種類のスタイル転送が容易になります。特にHotshotの8フレームコンテキストウィンドウを考慮すると、一貫性を保つのに非常に役立ちます。

このアンサンプリングプロセスは、本質的に入力ビデオを元の動きと構成を維持する潜在ノイズに変換します。その後、この表現ノイズを拡散プロセスの開始点として使用し、ランダムノイズの代わりにします。これにより、AIはターゲットスタイルを適用しながら時間的一貫性を保つことができます。

このガイドは、AnimateDiffおよび/またはHotshotをインストールしていることを前提としています。まだインストールしていない場合は、以下のガイドをご覧ください:

AnimateDiff: https://civitai.com/articles/2379

Hotshot XL guide: https://civitai.com/articles/2601/

リソースへのリンク - このワークフローを使用してCivitaiにビデオを投稿したい場合。 https://civitai.com/models/544534

2. このワークフローのシステム要件

NVIDIAグラフィックスカードを搭載したWindowsコンピュータで、少なくとも12GBのVRAMが推奨されます。RunComfyプラットフォームでは、Medium(16GBのVRAM)以上のマシンを使用してください。このプロセスは、標準のAnimateDiffまたはHotshotワークフローよりも多くのVRAMを必要としませんが、拡散プロセスを2回実行するため、ほぼ2倍の時間がかかります。1回目はアップサンプリング、2回目はターゲットスタイルでのリサンプリングです。

3. ノードの説明と設定ガイド

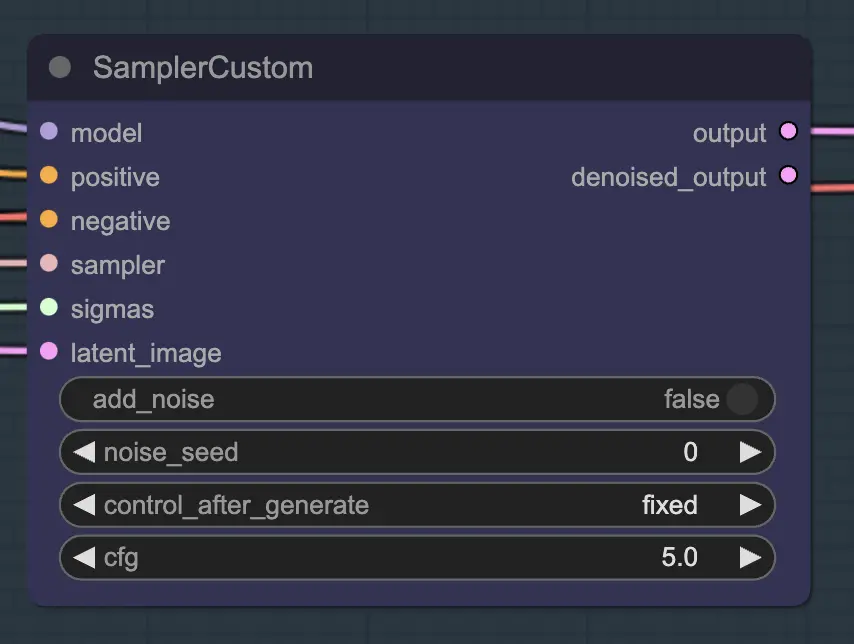

ノード:カスタムサンプラー

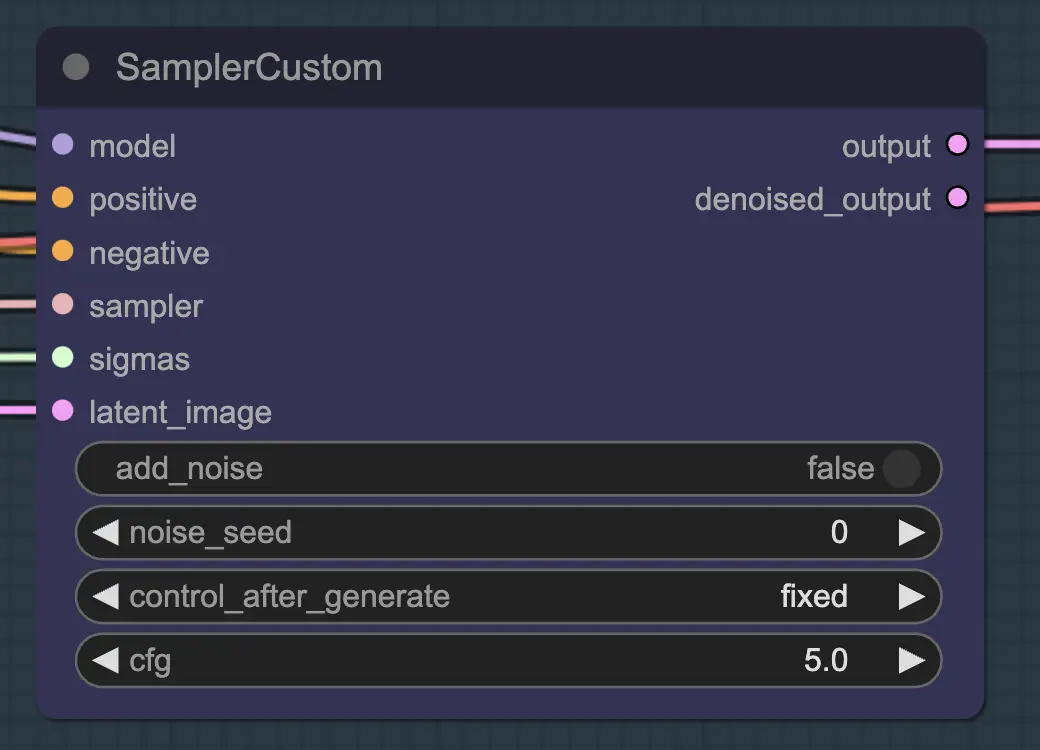

メイン部分は、通常のKSamplerで見られるすべての設定を分割するカスタムサンプラーを使用することです:

これはメインのKSamplerノードです - アンサンプリングのためにノイズ/シードを追加しても(私が知る限り)効果はありません。CFGは重要です - 一般的に言って、このステップでCFGが高いほど、ビデオは元のビデオに近づきます。CFGが高いほど、アンサンプラーは入力により近づきます。

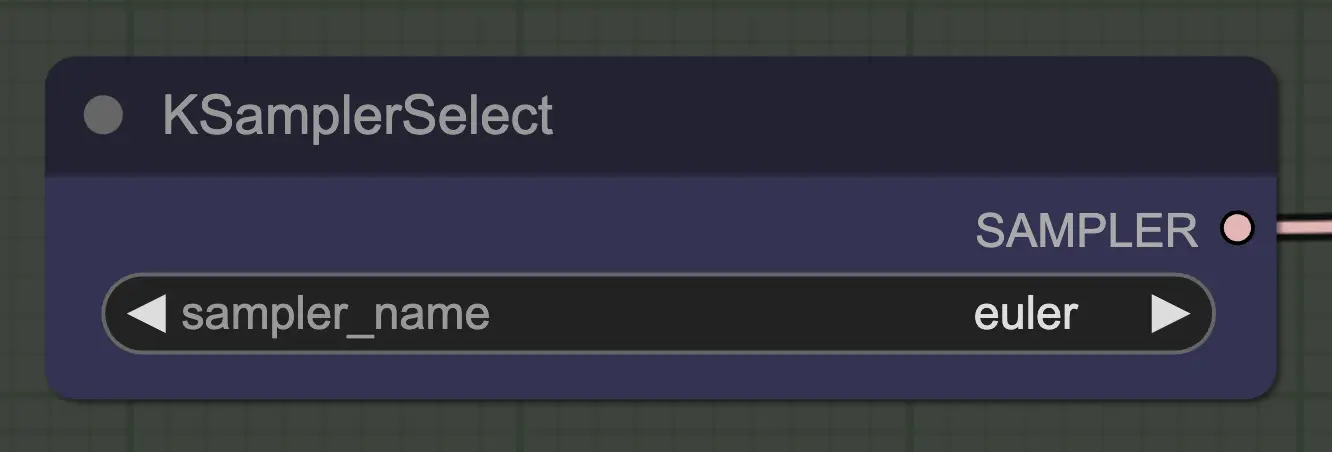

ノード:KSamplerセレクト

最も重要なことは、収束するサンプラーを使用することです!これは、eulerを使用する理由であり、euler aはランダム性/不安定性が高いためです。 各ステップでノイズを追加する祖先サンプラーは、アンサンプリングがきれいに収束するのを妨げます。これについてもっと読みたい場合は、この記事 が役立ちます。redditの@spacepxlは、使用ケースに応じてDPM++ 2M Karrasがより正確なサンプラーである可能性があると示唆しています。

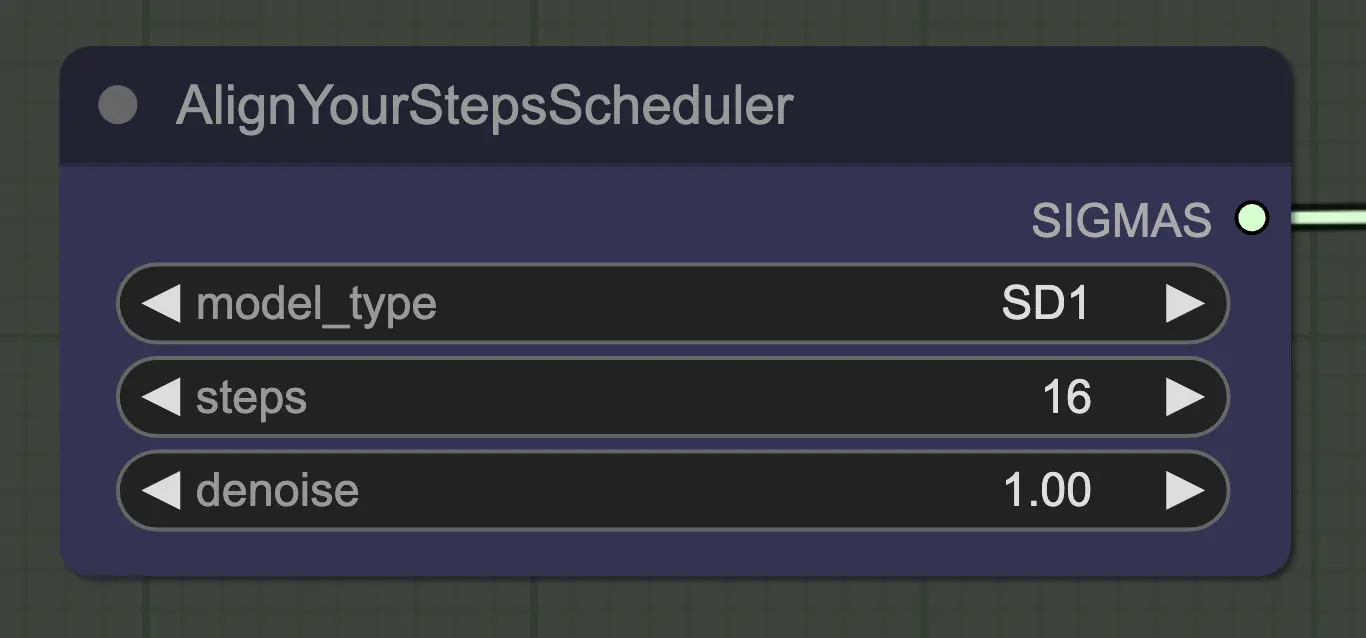

ノード:ステップスケジューラの整列

ここでは任意のスケジューラが問題なく機能しますが、Align Your Steps(AYS)は16ステップで良好な結果を得るため、計算時間を短縮するためにこれを使用しています。より多くのステップはより完全に収束しますが、効果は減少します。

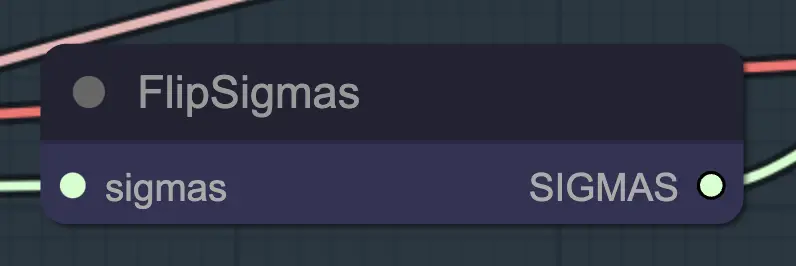

ノード:フリップシグマ

フリップシグマはアンサンプリングを発生させる魔法のノードです!シグマスケジュールを反転させることで、クリーンな入力画像から代表的なノイズに拡散プロセスを逆転させます。

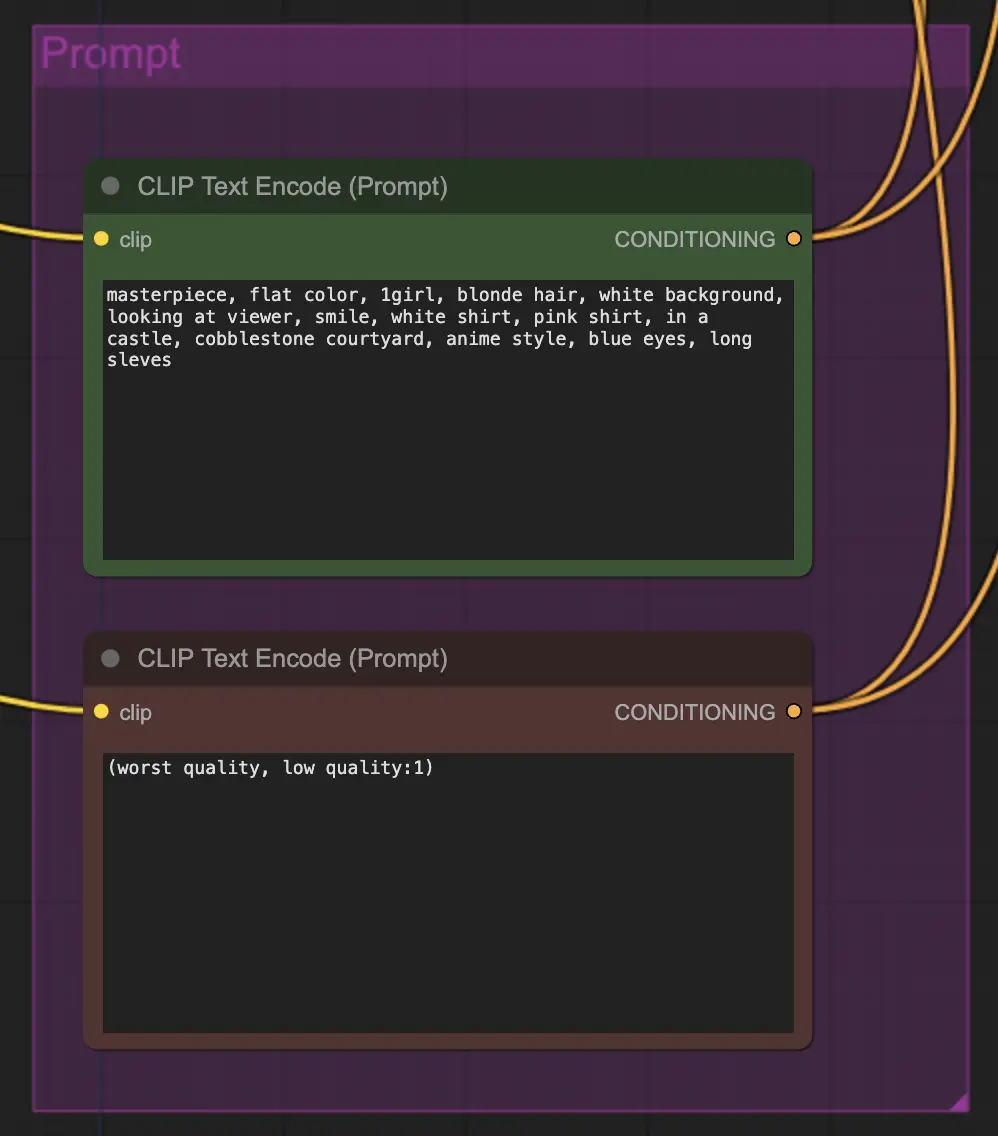

ノード:プロンプト

この方法ではプロンプトが非常に重要です。良いプロンプトは、特に変換を強く押し進めたい場合、ビデオの一貫性を大いに向上させることができます。この例では、同じ条件をアンサンプラーとリサンプラーの両方に供給しました。一般的にはうまく機能しますが、アンサンプラーに空の条件を置くことを妨げるものはありません - スタイル転送を改善するのに役立つことがあり、一貫性が少し失われることがあります。

ノード:リサンプリング

リサンプリングでは、ノイズを追加しないことが重要です (ただし、AnimateDiffサンプル設定で空のノイズを持つことは同じ効果があります - 私のワークフローでは両方を行っています)。リサンプリング中にノイズを追加すると、少なくともデフォルト設定では一貫性のないノイズの多い結果が得られます。その他には、低いCFGと弱いControlNet設定を組み合わせることをお勧めします。これにより、プロンプトがスタイルに影響を与えつつも、一貫性のある結果が得られます。

その他の設定

残りの設定は個人的な好みです。このワークフローを可能な限り簡略化しながら、重要なコンポーネントと設定を含めています。

4. ワークフロー情報

デフォルトのワークフローはSD1.5モデルを使用しています。ただし、チェックポイント、VAE、AnimateDiffモデル、ControlNetモデル、およびステップスケジュールモデルをSDXLに変更することで、SDXLに切り替えることができます。

5. 重要な注意点/問題

- フラッシング - 私のワークフローでアンサンプリングによって作成されたデコードおよびプレビューされた潜在変数を見ると、明らかな色の異常を持つものがいくつかあります。正確な原因は不明ですが、一般的には最終結果には影響しません。これらの異常は特にSDXLで顕著です。ただし、ビデオにフラッシングを引き起こすことがあります。主な原因はControlNetsに関連しているようで、その強度を減らすことで助けになります。プロンプトを変更するか、スケジューラをわずかに変更することも違いを生むことがあります。この問題に直面することがありますので、解決策があれば教えてください!

- DPM++ 2Mはフラッシングを改善することがあります。

6. 次に進むべき道は?

これはビデオの一貫性を制御する全く新しい方法のように感じますので、探求することがたくさんあります。私の提案が必要な場合:

- 複数のソースビデオからのノイズを組み合わせる/マスキングしてみてください。

- 一貫したキャラクター変換のためにIPAdapterを追加してください。

著者について

Inner-Reflections

- https://x.com/InnerRefle11312

- https://civitai.com/user/Inner_Reflections_AI