Este guia fornece uma introdução abrangente à criação de conteúdo 3D com o modelo "Wonder3D", utilizando as capacidades avançadas dos nós do "ComfyUI 3D Pack" para otimizar fluxos de trabalho e melhorar a qualidade do resultado.

Parte 1: ComfyUI 3D Pack

1.1. Introdução ao ComfyUI 3D Pack

ComfyUI 3D Pack é um conjunto extenso de nós que permite ao ComfyUI processar entradas 3D como Mesh & UV Texture usando algoritmos e modelos de ponta. Ele integra algoritmos avançados de processamento 3D como 3DGS (Gaussian Splatting) e NeRF (Neural Radiance Fields), juntamente com modelos de ponta incluindo Hunyuan3D, StableFast3D, InstantMesh, CRM, TripoSR e outros.

Com o ComfyUI 3D Pack, os usuários podem importar, manipular e gerar conteúdo 3D de alta qualidade dentro da interface intuitiva do ComfyUI. Ele suporta uma ampla gama de formatos de arquivo 3D como OBJ, PLY, GLB, permitindo fácil integração de modelos 3D existentes. O pacote também inclui utilitários poderosos de processamento de malha para editar, limpar e otimizar geometria 3D.

Um dos destaques é a integração da tecnologia NeRF, que permite reconstrução 3D fotorrealista a partir de imagens 2D. Os nós 3DGS permitem renderização e estilização de nuvem de pontos. Os modelos InstantMesh e TripoSR permitem aumento de resolução e super-resolução de malhas 3D. CRM (Convolutional Reconstruction Model) permite recuperar a forma 3D a partir de imagens de múltiplas vistas e CCM (Color Correction Map).

ComfyUI 3D Pack foi desenvolvido por MrForExample, com todos os créditos indo para MrForExample. Para informações detalhadas, consulte ComfyUI 3D Pack.

1.2. ComfyUI 3D Pack: Pronto para Rodar no RunComfy

Agora o ComfyUI 3D Pack está totalmente configurado e pronto para uso no site RunComfy. Os usuários não precisam instalar nenhum software ou dependências adicionais. Todos os modelos, algoritmos e ferramentas necessários estão pré-configurados e otimizados para rodar eficientemente no ambiente web do ComfyUI.

Parte 2: Usando o modelo Wonder3D com Nós do ComfyUI 3D Pack

2.1. O que é Wonder3D?

Wonder3D é um método de ponta para gerar malhas texturizadas de alta qualidade de forma eficiente a partir de imagens de visão única. Ele aproveita o poder dos modelos de difusão entre domínios para gerar mapas normais de múltiplas vistas e suas imagens coloridas correspondentes. Wonder3D visa abordar os desafios de fidelidade, consistência, generalização e eficiência em tarefas de reconstrução 3D de visão única.

Wonder3D foi desenvolvido por uma equipe de pesquisadores da Universidade de Hong Kong, Universidade Tsinghua, VAST, Universidade da Pensilvânia, Shanghai Tech University, MPI Informatik e Texas A&M University, com Xiaoxiao Long e Yuan-Chen Guo como autores principais de contribuição igual. Todos os créditos vão para a contribuição deles; para mais informações, consulte a página do projeto em aqui.

2.2. Técnicas por trás do Wonder3D

O núcleo do Wonder3D reside em seu inovador modelo de difusão entre domínios. Este modelo é projetado para capturar a distribuição conjunta de mapas normais e imagens coloridas em múltiplas vistas. Para conseguir isso, Wonder3D introduz um comutador de domínio e um esquema de atenção entre domínios. O comutador de domínio permite a geração contínua de mapas normais ou imagens coloridas, enquanto o mecanismo de atenção entre domínios facilita a troca de informações entre os dois domínios, melhorando a consistência e a qualidade.

Outro componente chave do Wonder3D é seu algoritmo de fusão normal consciente de geometria. Este algoritmo extrai robustamente superfícies de alta qualidade das representações 2D de múltiplas vistas geradas, mesmo na presença de imprecisões. Aproveitando os ricos detalhes de superfície codificados nos mapas normais e nas imagens coloridas, o Wonder3D reconstrói geometrias limpas e detalhadas.

2.3. Vantagens/Possíveis Limitações do Wonder3D

Wonder3D oferece várias vantagens sobre os métodos de reconstrução de visão única existentes. Ele alcança um alto nível de detalhe geométrico enquanto mantém boa eficiência, tornando-o adequado para várias aplicações. O modelo de difusão entre domínios permite que o Wonder3D se generalize bem para diferentes categorias de objetos e estilos. A consistência de múltiplas vistas imposta pelo mecanismo de atenção entre domínios resulta em reconstruções 3D coerentes e plausíveis.

No entanto, como qualquer método, o Wonder3D pode ter algumas limitações. A qualidade das malhas geradas depende dos dados de treinamento e da capacidade do modelo de difusão de capturar a estrutura 3D subjacente. Formas altamente complexas ou ambíguas podem representar desafios. Além disso, a implementação atual do Wonder3D foca em objetos únicos, e estender para lidar com múltiplos objetos ou cenas inteiras pode ser uma área para pesquisas futuras.

2.4. Como usar o Fluxo de Trabalho do Wonder3D

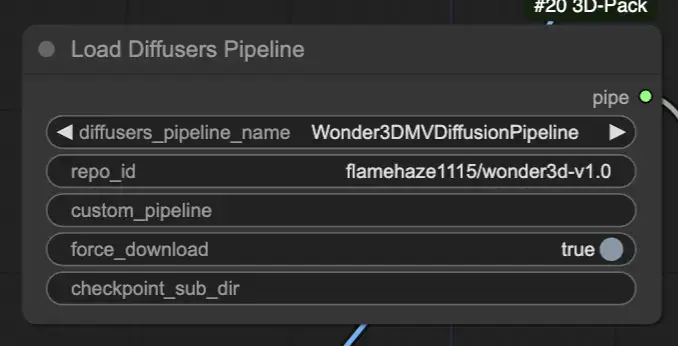

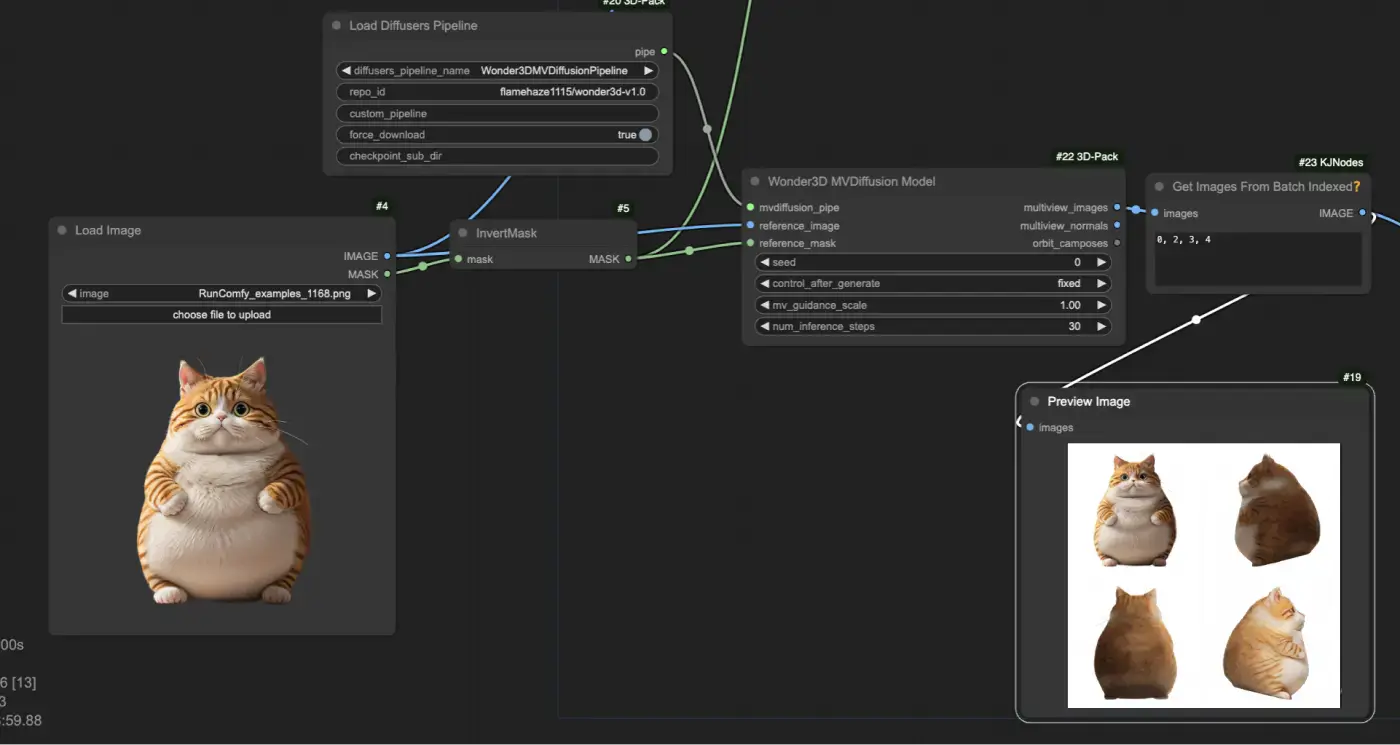

Carregue o pipeline de difusão pré-treinado do Wonder3D usando o nó "[Comfy3D] Load Diffusers Pipeline", que importa os pontos de verificação e configurações do modelo necessários.

Forneça uma imagem de entrada e sua máscara correspondente usando os nós "LoadImage" e "InvertMask". Em seguida, alimente a imagem de entrada e a máscara no nó "[Comfy3D] Wonder3D MVDiffusion Model", que gera mapas normais de múltiplas vistas e imagens coloridas.

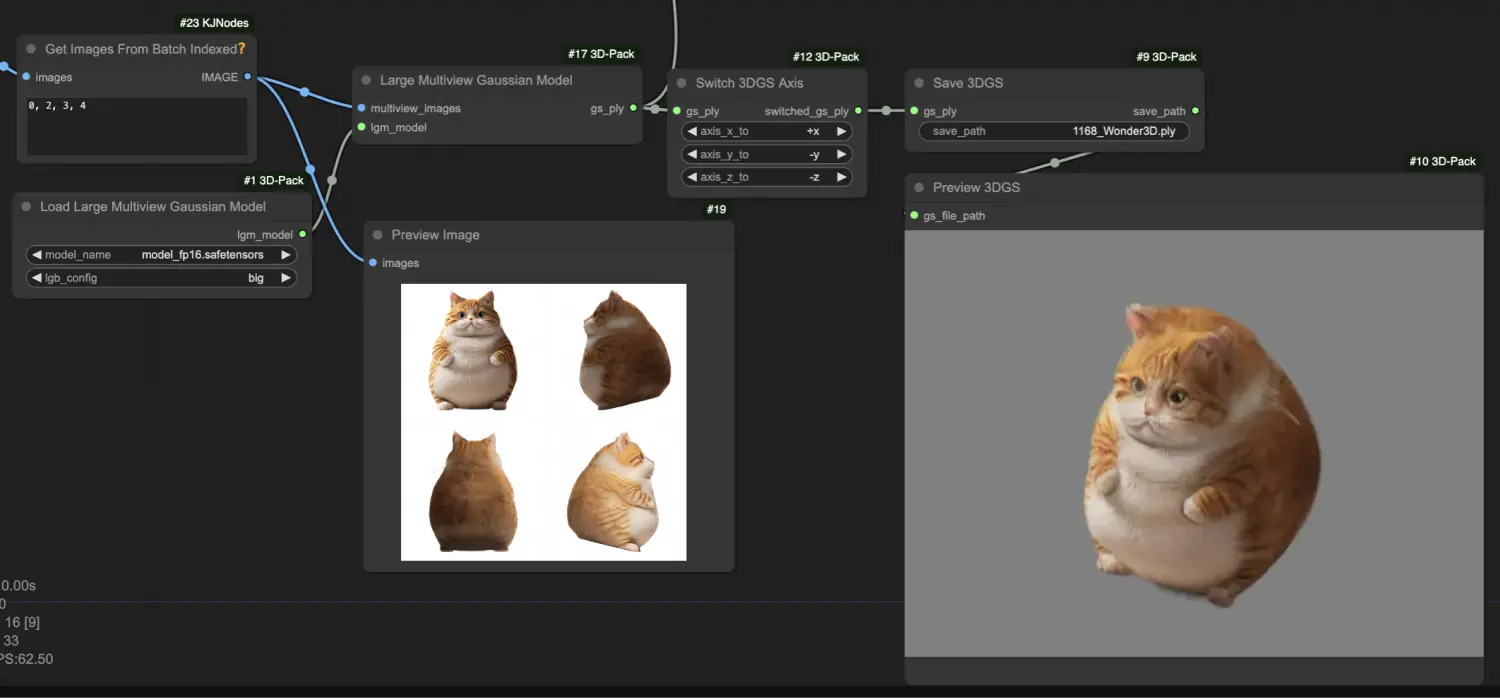

Processe as imagens de múltiplas vistas geradas usando o nó "[Comfy3D] Large Multiview Gaussian Model", que as converte em uma representação de Splatting Gaussiano 3D (3DGS), capturando os detalhes geométricos do objeto em um formato de nuvem de pontos.

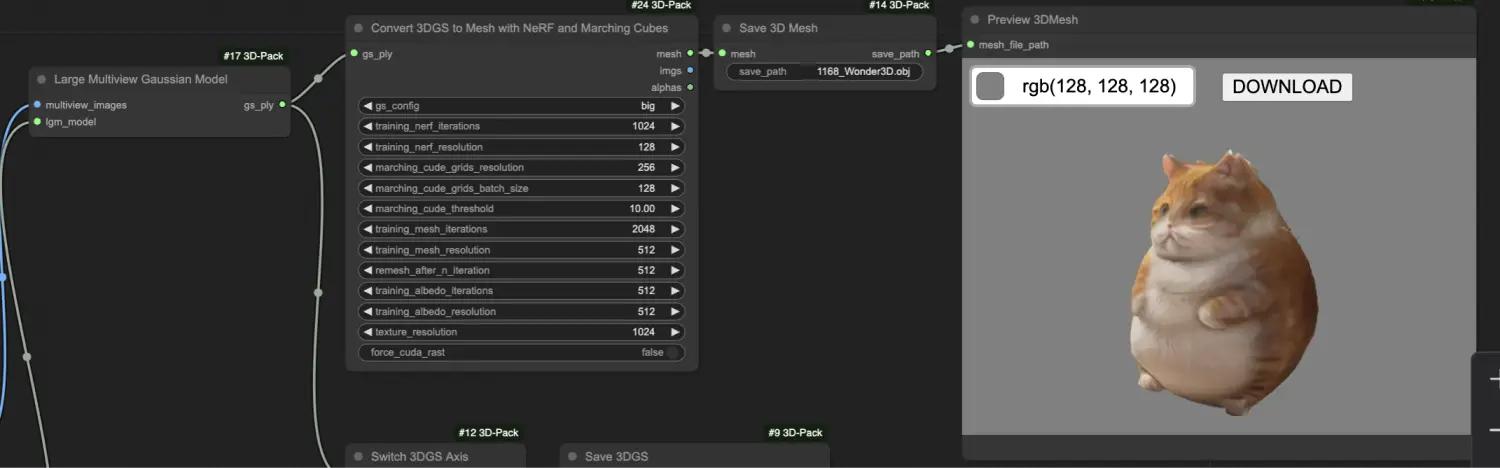

Transforme a representação 3DGS em uma malha texturizada usando o nó "[Comfy3D] Convert 3DGS to Mesh with NeRF and Marching Cubes", que emprega campos de radiância neural (NeRF) e algoritmos de marching cubes para extrair uma malha de alta qualidade.