Olá! Neste guia, vamos mergulhar no mundo fascinante do ControlNet no ComfyUI. Vamos explorar juntos o que ele traz de novidade e como pode apimentar seus projetos!

Nós abordaremos:

1. O que é o ControlNet?

2. Os Aspectos Técnicos por trás do ControlNet

3. Como Usar o ComfyUI ControlNet: Etapas Básicas

- 3.1. Carregando o Nó "Apply ControlNet" no ComfyUI

- 3.2. Entradas do Nó "Apply ControlNet"

- 3.3. Saídas do Nó "Apply ControlNet"

- 3.4. Parâmetros para ajuste fino do "Apply ControlNet"

4. Como Usar o ComfyUI ControlNet: Recursos Avançados - Keyframes de Timestep

5. Vários Modelos ControlNet/T2IAdaptor: Visão Geral Detalhada

- 5.1. ControlNet Openpose

- 5.2. ControlNet Tile

- 5.3. ControlNet Canny

- 5.4. ControlNet Depth

- 5.5. ControlNet Lineart

- 5.6. ControlNet Scribbles

- 5.7. ControlNet Segmentation

- 5.8. ControlNet Shuffle

- 5.9. ControlNet Inpainting

- 5.10. ControlNet MLSD

- 5.11. ControlNet Normalmaps

- 5.12. ControlNet Soft Edge

- 5.13. ControlNet IP2P (Instruct Pix2Pix)

- 5.14. T2I Adapter

- 5.15. Outros ControlNets Populares: QRCode Monster e IP-Adapter

6. Como Usar Múltiplos ControlNets

7. Experimente o ComfyUI ControlNet Agora!

🌟🌟🌟 ComfyUI Online - Experimente o Fluxo de Trabalho do ControlNet Agora 🌟🌟🌟

Se você está interessado em explorar o fluxo de trabalho do ControlNet, use o seguinte ComfyUI web. Ele vem totalmente equipado com todos os nós e modelos essenciais do cliente, permitindo uma criatividade perfeita sem a necessidade de configurações manuais. Comece a ganhar experiência prática experimentando os recursos do ControlNet imediatamente ou continue com este tutorial para aprender a usar o ControlNet efetivamente.

Para fluxos de trabalho ComfyUI mais avançados e premium, visite nossa 🌟Lista de Fluxos de Trabalho ComfyUI🌟

1. O que é o ControlNet?

O ControlNet é uma tecnologia transformadora que aprimora significativamente os recursos dos modelos de difusão de texto para imagem, permitindo um controle espacial sem precedentes na geração de imagens. Como uma arquitetura de rede neural, o ControlNet integra-se perfeitamente com modelos pré-treinados de grande escala, como o Stable Diffusion. Ele aproveita o extenso treinamento desses modelos—construídos em bilhões de imagens para introduzir condições espaciais no processo de criação de imagens. Essas condições podem variar de bordas e poses humanas a mapas de profundidade e segmentação, permitindo que os usuários guiem a geração de imagens de maneiras que antes não eram possíveis apenas com prompts de texto.

2. Os Aspectos Técnicos por trás do ControlNet

A genialidade do ControlNet está em sua metodologia distinta. Inicialmente, ele garante os parâmetros do modelo original, assegurando que o treinamento fundamental permaneça inalterado. Subsequentemente, o ControlNet introduz um clone das camadas de codificação do modelo para treinamento, utilizando "convoluções zero". Essas camadas convolucionais especialmente projetadas começam com pesos zero, integrando cuidadosamente novas condições espaciais. Essa abordagem impede que qualquer ruído disruptivo intervenha, preservando a proficiência original do modelo ao iniciar novas trajetórias de aprendizado.

3. Como Usar o ComfyUI ControlNet: Etapas Básicas

Tradicionalmente, os modelos de difusão estável empregam prompts de texto como mecanismo de condicionamento para guiar a geração de imagens, alinhando a saída com as especificidades do prompt de texto. O ControlNet introduz uma forma adicional de condicionamento a esse processo, aprimorando a capacidade de direcionar a imagem gerada com mais precisão de acordo com as entradas textuais e visuais.

3.1. Carregando o Nó "Apply ControlNet" no ComfyUI

Esta etapa integra o ControlNet ao seu fluxo de trabalho do ComfyUI, permitindo a aplicação de um condicionamento adicional ao seu processo de geração de imagem. Ela estabelece a base para aplicar a orientação visual juntamente com os prompts de texto.

3.2. Entradas do Nó "Apply ControlNet"

Condicionamento Positivo e Negativo: Essas entradas são cruciais para definir os resultados desejados e os aspectos a serem evitados na imagem gerada. Elas devem ser vinculadas a "Prompt Positivo" e "Prompt Negativo", respectivamente, alinhando-se à parte de condicionamento textual do processo.

Modelo ControlNet: Essa entrada deve ser conectada à saída do nó "Load ControlNet Model". Esta etapa é essencial para selecionar e incorporar um modelo ControlNet ou T2IAdaptor ao seu fluxo de trabalho, garantindo que o modelo de difusão se beneficie da orientação específica fornecida pelo modelo escolhido. Cada modelo, seja ControlNet ou T2IAdaptor, é rigorosamente treinado para influenciar o processo de geração de imagem de acordo com certos tipos de dados ou preferências estilísticas. Dado que as funcionalidades de muitos modelos T2IAdaptor se alinham estreitamente com as dos modelos ControlNet, nosso foco será predominantemente nos modelos ControlNet em nossa discussão subsequente. No entanto, também destacaremos alguns dos T2IAdaptors mais populares para completude.

Preprocessor: A entrada "image" deve ser conectada a um nó "ControlNet Preprocessor", que é crucial para adaptar sua imagem para atender aos requisitos específicos do modelo ControlNet que você está utilizando. É imperativo usar o pré-processador correto adaptado ao seu modelo ControlNet selecionado. Esta etapa garante que a imagem original passe por modificações necessárias — como ajustes no formato, tamanho, cor ou aplicação de filtros específicos — para otimizá-la para as diretrizes do ControlNet. Após essa fase de pré-processamento, a imagem original é substituída pela versão modificada, que o ControlNet então utiliza. Esse processo garante que suas imagens de entrada sejam precisamente preparadas para o processo do ControlNet.

3.3. Saídas do Nó "Apply ControlNet"

O nó "Apply ControlNet" gera duas saídas cruciais: Condicionamento Positivo e Negativo. Essas saídas, imbuídas dos efeitos matizados do ControlNet e da orientação visual, desempenham um papel fundamental na orientação do comportamento do modelo de difusão no ComfyUI. Em seguida, você tem uma escolha: prosseguir para o KSampler para a fase de amostragem para refinar ainda mais a imagem gerada ou, para aqueles que buscam um nível ainda mais alto de detalhe e personalização em sua criação, continuar a adicionar camadas de ControlNets adicionais. Essa técnica avançada de integração de mais ControlNets permite uma manipulação mais granular dos atributos da imagem, oferecendo um conjunto de ferramentas aprimorado para criadores que buscam alcançar uma precisão e controle inigualáveis em suas saídas visuais.

3.4. Parâmetros para ajuste fino do "Apply ControlNet"

strength: Este parâmetro determina a intensidade do efeito do ControlNet na imagem gerada no ComfyUI. Um valor de 1.0 implica força total, ou seja, a orientação do ControlNet terá influência máxima na saída do modelo de difusão. Por outro lado, um valor de 0.0 indica nenhuma influência, essencialmente desabilitando o efeito do ControlNet no processo de geração de imagem.

start_percent: Este parâmetro especifica o ponto de partida, como uma porcentagem do processo de difusão, onde o ControlNet começa a influenciar a geração. Por exemplo, definir um start percent de 20% significa que a orientação do ControlNet começará a afetar a geração de imagem a partir da marca de 20% do processo de difusão em diante.

end_percent: Analogamente ao "Start Percent", o parâmetro "End Percent" define o ponto em que a influência do ControlNet cessa. Por exemplo, um end percent de 80% significaria que a orientação do ControlNet para de influenciar a geração de imagem na marca de conclusão de 80% do processo de difusão, deixando as fases finais não afetadas.

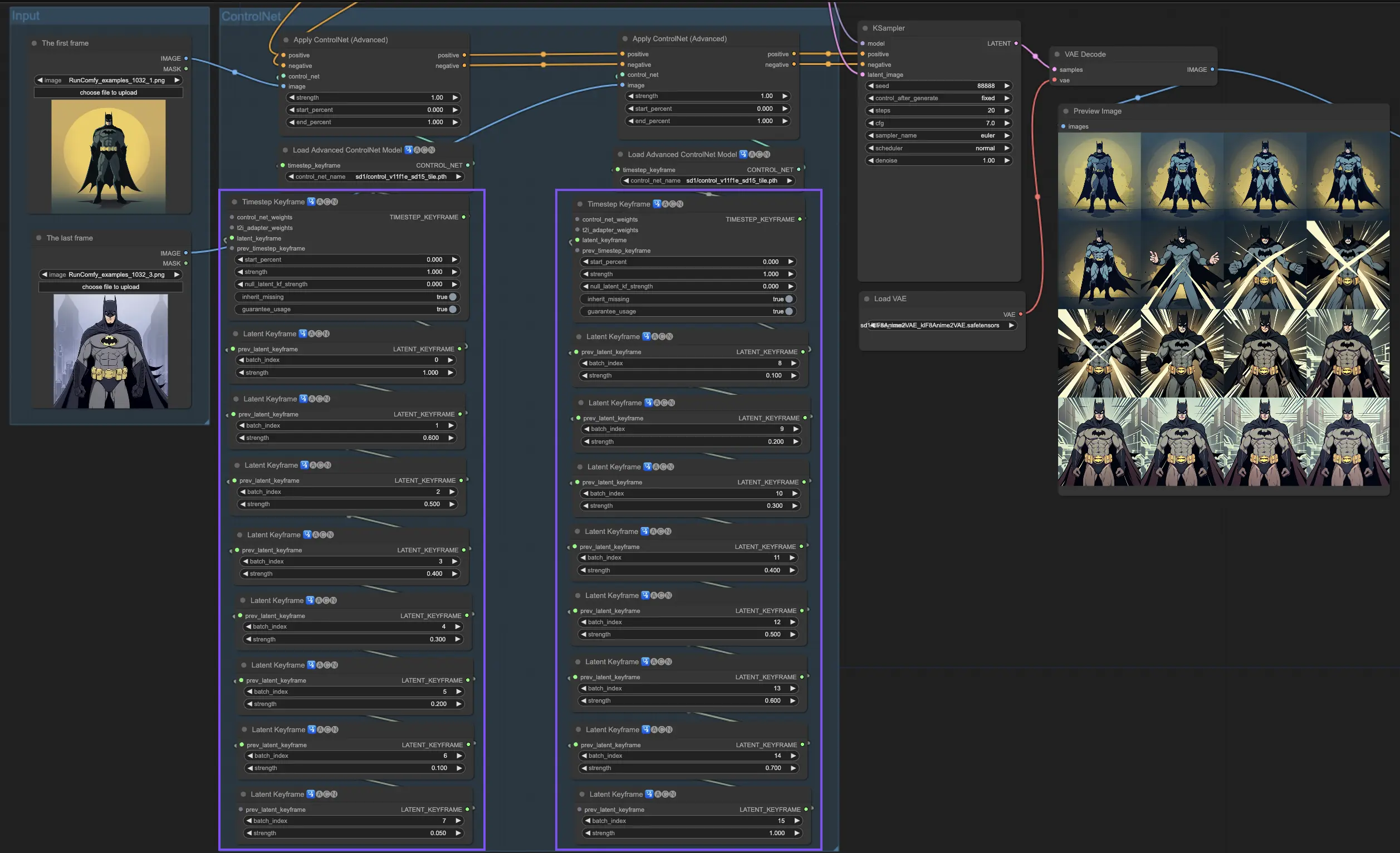

4. Como Usar o ComfyUI ControlNet: Recursos Avançados - Keyframes de Timestep

Keyframes de Timestep no ControlNet oferecem controle sofisticado sobre o comportamento do conteúdo gerado por IA, especialmente quando o tempo e a progressão são cruciais, como em animações ou visuais em evolução. Aqui está uma análise detalhada dos principais parâmetros para ajudá-lo a utilizá-los de maneira eficaz e intuitiva:

prev_timestep_kf: Pense no prev_timestep_kf como unindo as mãos com o keyframe anterior em uma sequência. Ao conectar keyframes, você cria uma transição suave ou um storyboard que guia a IA pelo processo de geração, passo a passo, garantindo que cada fase flua logicamente para a próxima.

cn_weights: Os cn_weights são úteis para ajustar a saída ajustando recursos específicos dentro do ControlNet durante diferentes fases do processo de geração.

latent_keyframe: O latent_keyframe permite ajustar quão fortemente cada parte do modelo de IA influencia o resultado final durante uma fase específica do processo de geração. Por exemplo, se você está gerando uma imagem onde o primeiro plano deve se tornar mais detalhado à medida que o processo evolui, você pode aumentar a força para os aspectos (latentes) do modelo responsáveis pelos detalhes do primeiro plano em keyframes posteriores. Por outro lado, se certos recursos devem desaparecer no plano de fundo ao longo do tempo, você pode reduzir sua força nos keyframes subsequentes. Esse nível de controle é particularmente útil na criação de visuais dinâmicos e em evolução ou em projetos onde o tempo preciso e a progressão são cruciais.

mask_optional: Use máscaras de atenção como holofotes, focando a influência do ControlNet em áreas específicas de sua imagem. Seja destacando um personagem em uma cena ou enfatizando um elemento de fundo, essas máscaras podem ser aplicadas uniformemente ou variar em intensidade, direcionando a atenção da IA precisamente para onde você deseja.

start_percent: O start_percent marca o momento em que seu keyframe entra em ação, medido como uma porcentagem do processo geral de geração. Definir isso é como agendar a entrada de um ator no palco, garantindo que ele apareça no momento certo da performance.

strength: A strength fornece um controle de alto nível sobre a influência geral do ControlNet.

null_latent_kf_strength: Para qualquer ator (latente) que você não tenha direcionado explicitamente nesta cena (keyframe), o null_latent_kf_strength atua como uma instrução padrão, dizendo a eles como se comportar no plano de fundo. Isso garante que nenhuma parte da geração seja deixada sem orientação, mantendo uma saída coerente mesmo em áreas que você não abordou especificamente.

inherit_missing: Ativar o inherit_missing permite que seu keyframe atual adote quaisquer configurações não especificadas de seu antecessor, como um irmão mais novo herdando roupas. É um atalho útil que garante continuidade e coerência sem a necessidade de repetir instruções.

guarantee_usage: O guarantee_usage é sua garantia de que, aconteça o que acontecer, o keyframe atual terá seu momento de brilhar no processo, mesmo que seja apenas por um breve instante. Ele garanteque cada keyframe que você configurou tenha um impacto, honrando seu planejamento detalhado ao guiar o processo criativo da IA.

Keyframes de Timestep oferecem a precisão necessária para guiar meticulosamente o processo criativo da IA, permitindo que você crie a narrativa ou a jornada visual exatamente como você a imagina. Eles servem como uma ferramenta poderosa para orquestrar a evolução dos visuais, particularmente em animações, desde a cena de abertura até a conclusão. Aqui está uma análise mais detalhada de como os Keyframes de Timestep podem ser aplicados estrategicamente para gerenciar a progressão de uma animação, garantindo uma transição perfeita do quadro inicial ao final, alinhando-se perfeitamente com seus objetivos artísticos.

5. Vários Modelos ControlNet/T2IAdaptor: Visão Geral Detalhada

Dado que as funcionalidades de muitos modelos T2IAdaptor se alinham estreitamente com as dos modelos ControlNet, nosso foco será predominantemente nos modelos ControlNet em nossa discussão subsequente. No entanto, também destacaremos alguns dos T2IAdaptors mais populares para completude.

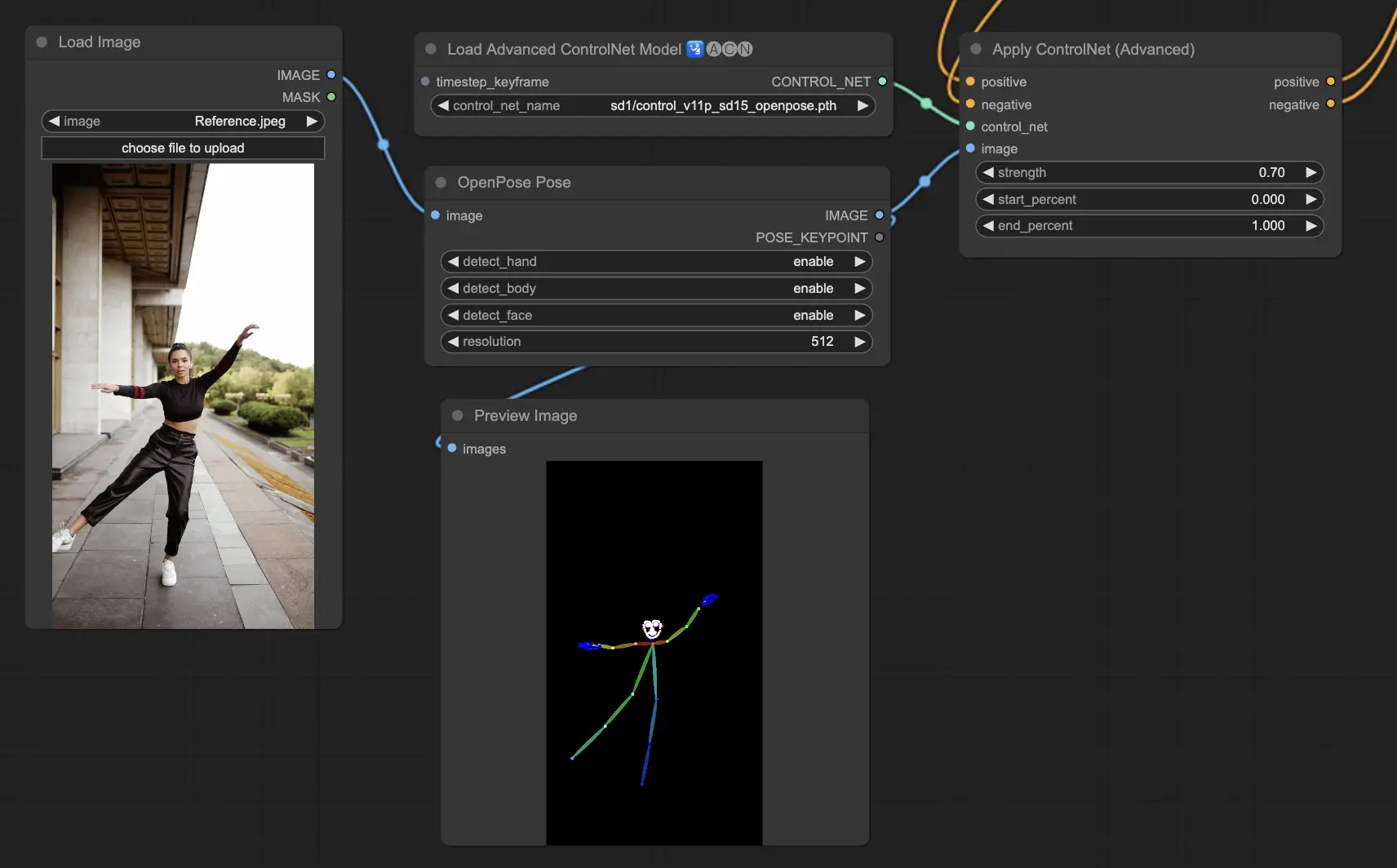

5.1. ComfyUI ControlNet Openpose

- Openpose (= Openpose body): O modelo fundamental dentro do ControlNet que identifica pontos-chave básicos do corpo, como olhos, nariz, pescoço, ombros, cotovelos, pulsos, joelhos e tornozelos. É ideal para a replicação básica de poses humanas.

- Openpose_face: Estende o modelo OpenPose adicionando detecção de pontos-chave faciais, oferecendo uma análise mais detalhada das expressões faciais e orientação. Este modelo ControlNet é essencial para projetos com foco em expressões faciais.

- Openpose_hand: Aumenta o modelo OpenPose com a capacidade de capturar detalhes intrincados das mãos e dedos, concentrando-se em gestos e posições detalhadas das mãos. Esta adição aprimora a versatilidade do OpenPose dentro do ControlNet.

- Openpose_faceonly: Um modelo especializado apenas para detalhes faciais, omitindo pontos-chave do corpo para se concentrar na captura de expressões e orientações faciais. Este modelo dentro do ControlNet se concentra exclusivamente em características faciais.

- Openpose_full: Uma amálgama abrangente dos modelos OpenPose, OpenPose_face e OpenPose_hand, oferecendo detecção completa do corpo, rosto e mãos para replicação total da pose humana dentro do ControlNet.

- DW_Openpose_full: Uma versão aprimorada do modelo OpenPose_full, incorporando refinamentos adicionais para detecção de pose ainda mais detalhada e precisa. Esta versão representa o ápice da precisão de detecção de pose dentro da estrutura do ControlNet.

Pré-processador: Openpose ou DWpose

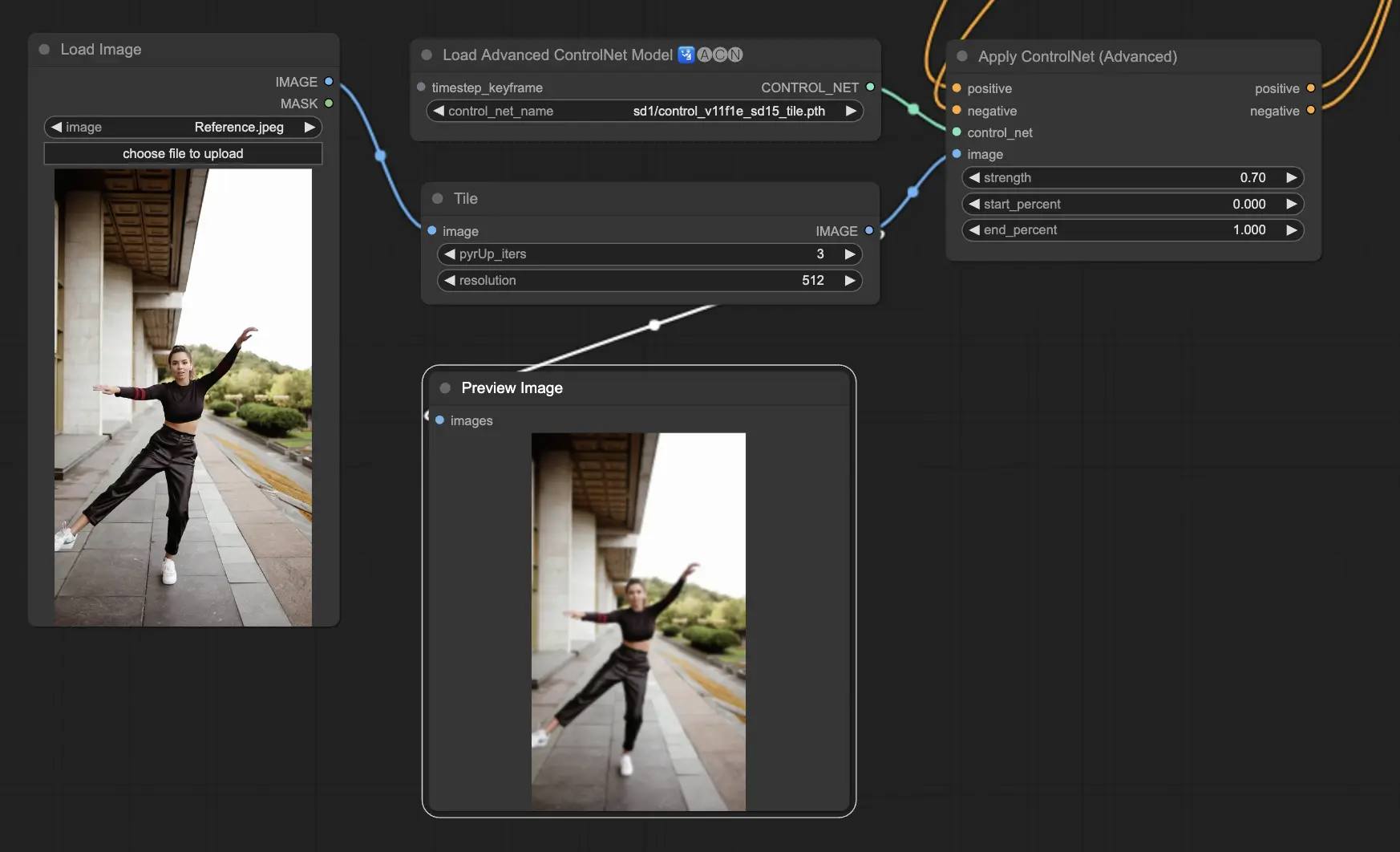

5.2. ComfyUI ControlNet Tile

O modelo Tile Resample é usado para aprimoramento de detalhes em imagens. É particularmente útil em conjunto com um upscaler para melhorar a resolução da imagem enquanto adiciona detalhes mais finos, frequentemente utilizado para aguçar e enriquecer texturas e elementos dentro de uma imagem.

Pré-processador: Tile

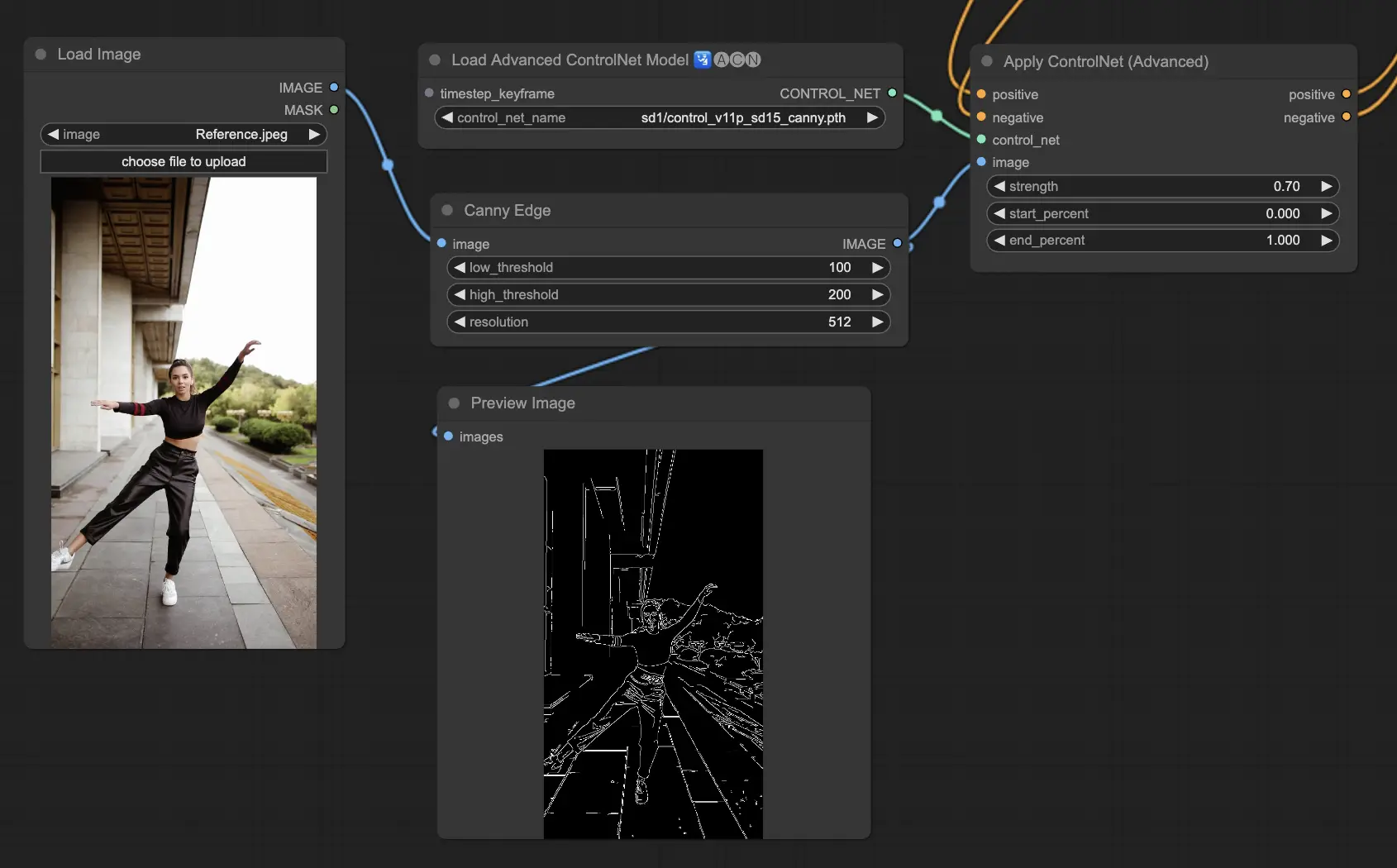

5.3. ComfyUI ControlNet Canny

O modelo Canny aplica o algoritmo de detecção de borda Canny, um processo de várias etapas para detectar uma ampla gama de bordas em imagens. Este modelo é benéfico para preservar os aspectos estruturais de uma imagem enquanto simplifica sua composição visual, tornando-o útil para arte estilizada ou pré-processamento antes de uma manipulação adicional da imagem.

Pré-processadores: Canny

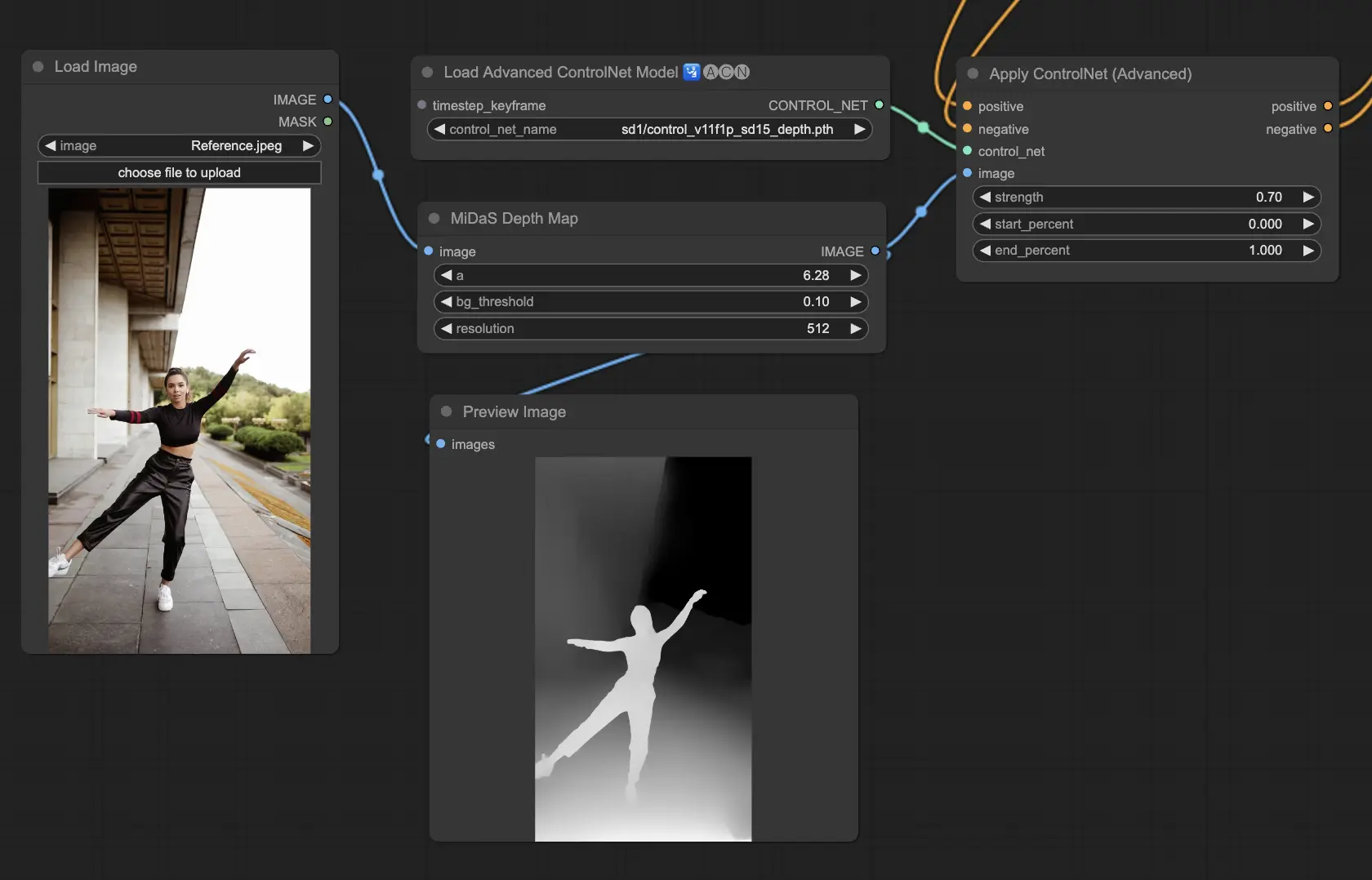

5.4. ComfyUI ControlNet Depth

Modelos de profundidade inferem informações de profundidade a partir de uma imagem 2D, traduzindo a distância percebida em um mapa de profundidade em tons de cinza. Cada variante oferece um equilíbrio diferente entre captura de detalhes e ênfase no plano de fundo:

- Depth Midas: Fornece uma estimativa de profundidade clássica, equilibrando detalhes e renderização de fundo.

- Depth Leres: Concentra-se no aprimoramento de detalhes com uma tendência a incluir mais elementos de fundo.

- Depth Leres++: Oferece um nível avançado de detalhes para informações de profundidade, ideal para cenas complexas.

- Zoe: Oferece um equilíbrio entre os modelos Midas e Leres em termos de nível de detalhe.

- Depth Anything: Um modelo mais recente e aprimorado para estimativa de profundidade, projetado para uma ampla gama de cenas.

- Depth Hand Refiner: Especificamente projetado para melhorar detalhes das mãos em mapas de profundidade, útil para cenas onde o posicionamento das mãos é crítico.

Pré-processadores: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Este modelo é altamente robusto e pode funcionar em mapas de profundidade reais de motores de renderização.

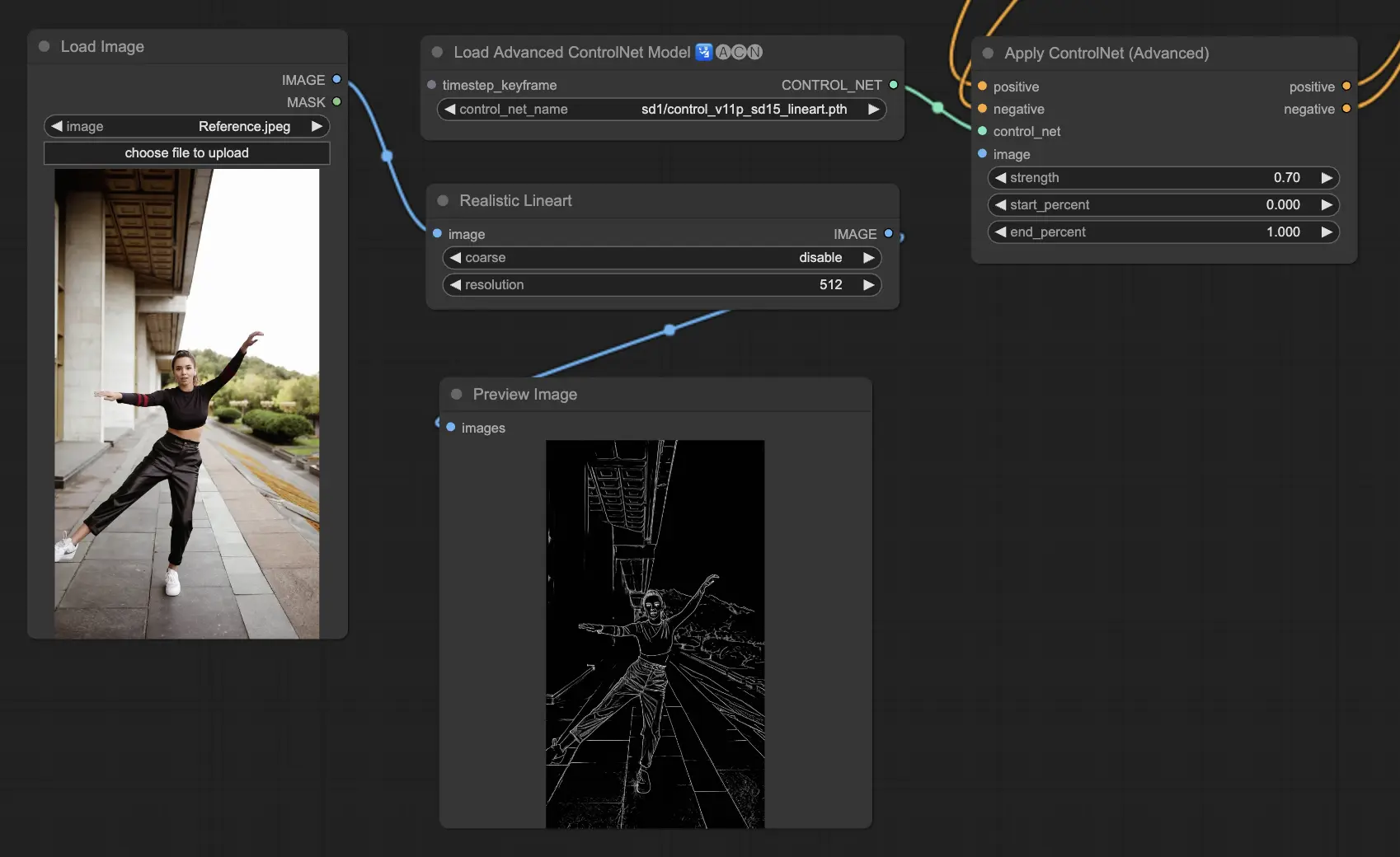

5.5. ComfyUI ControlNet Lineart

Modelos Lineart convertem imagens em desenhos de linhas estilizados, úteis para representações artísticas ou como base para trabalhos criativos adicionais:

- Lineart: Este modelo padrão converte imagens em desenhos de linhas estilizados, oferecendo uma base versátil para vários projetos artísticos ou criativos.

- Lineart anime: Concentra-se na geração de desenhos de linhas no estilo anime, caracterizados por linhas limpas e precisas, tornando-o adequado para projetos que buscam uma estética anime.

- Lineart realistic: Produz desenhos de linhas com um toque mais realista, capturando a essência do assunto com maior detalhe, perfeito para projetos que exigem uma representação realista.

- Lineart coarse: Oferece um desenho de linha mais pronunciado com linhas mais pesadas e ousadas, criando um efeito marcante que se destaca, especialmente adequado para expressões artísticas ousadas.

O pré-processador pode gerar linhas detalhadas ou grosseiras a partir de imagens (Lineart e Lineart_Coarse)

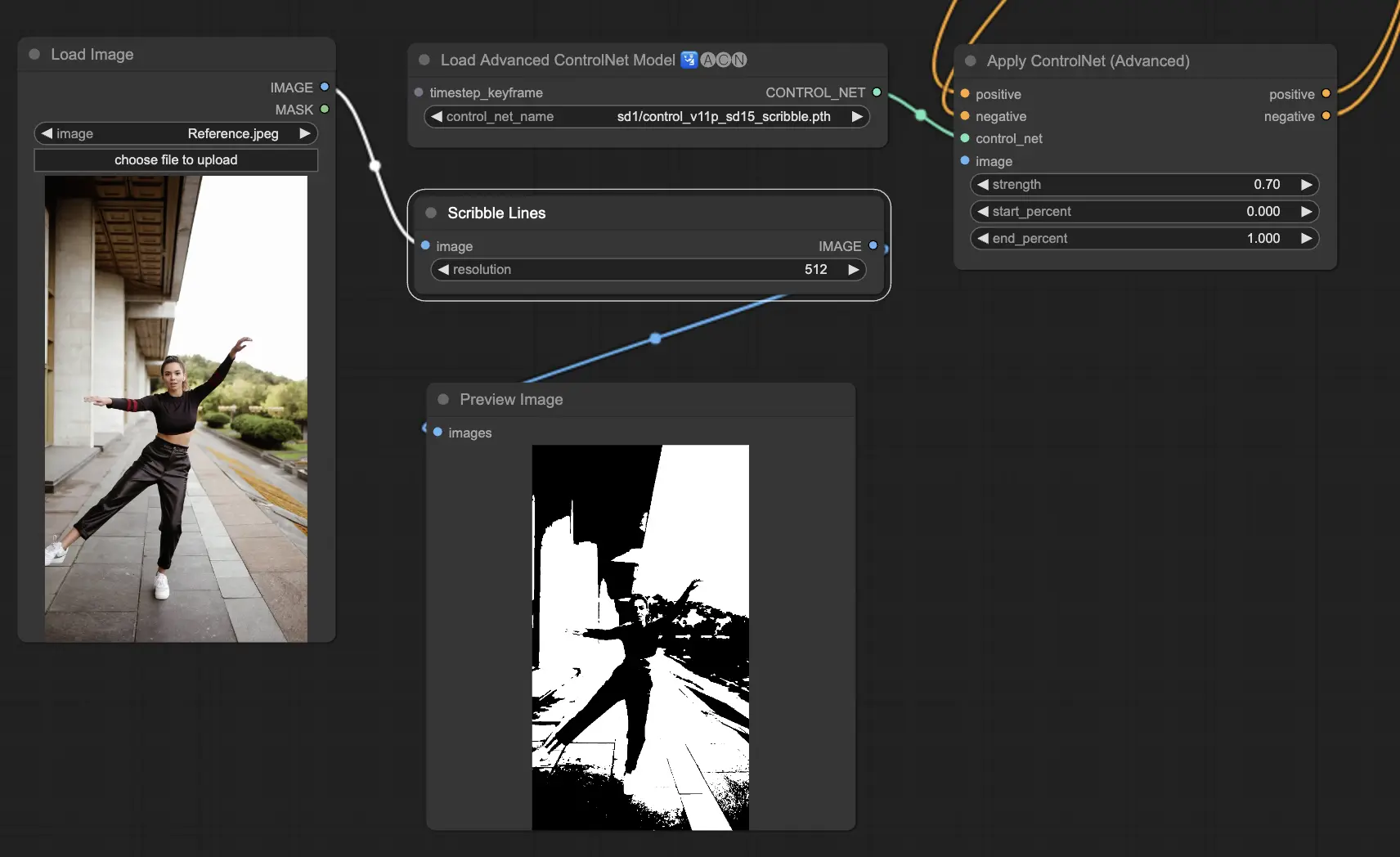

5.6. ComfyUI ControlNet Scribbles

Modelos Scribble são projetados para transformar imagens em uma aparência semelhante a rabiscos, simulando o aspecto de esboços desenhados à mão. Eles são particularmente úteis para reestilização artística ou como uma etapa preliminar em um fluxo de trabalho de design maior:

- Scribble: Projetado para converter imagens em obras de arte detalhadas que simulam rabiscos ou esboços desenhados à mão.

- Scribble HED: Utiliza a Detecção de Borda Holisticamente Aninhada (HED) para criar contornos que se assemelham a esboços desenhados à mão. É recomendado para recolorir e reestilizar imagens, adicionando um toque artístico único à arte.

- Scribble Pidinet: Concentra-se na detecção de diferenças de pixels para produzir linhas mais limpas com detalhes reduzidos, tornando-o ideal para representações mais claras e abstratas. O Scribble Pidinet é perfeito para aqueles que buscam curvas nítidas e bordas retas, oferecendo um visual polido enquanto preserva detalhes essenciais.

- Scribble xdog: Emprega o método Extended Difference of Gaussian (xDoG) para detecção de bordas. Isso permite configurações de limite ajustáveis para ajustar o efeito de rabisco, tornando possível controlar o nível de detalhe em suas obras de arte. O xDoG é versátil, permitindo que os usuários alcancem o equilíbrio perfeito em suas criações artísticas.

Pré-processadores: Scribble, Scribble_HED, Scribble_PIDI e Scribble_XDOG

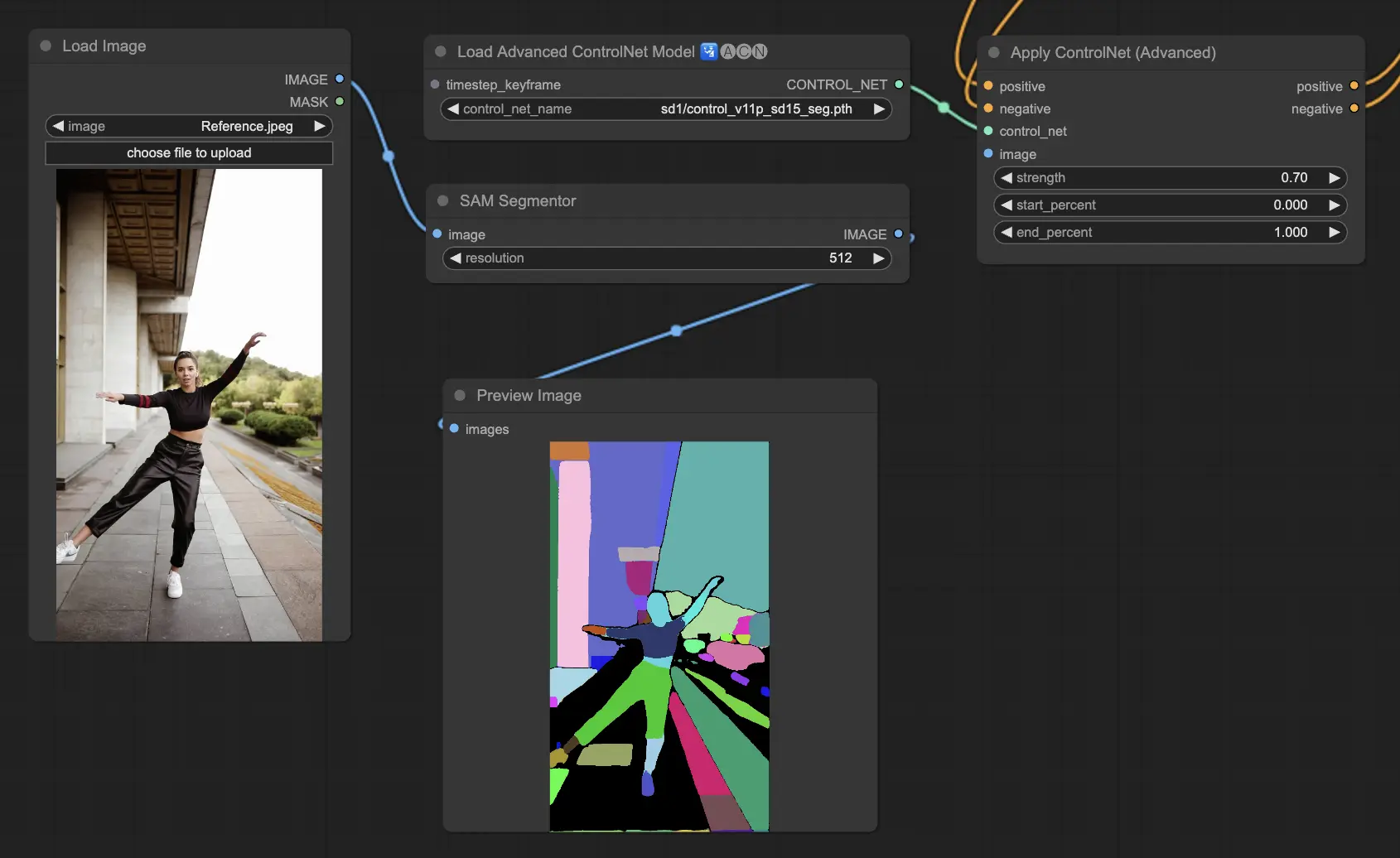

5.7. ComfyUI ControlNet Segmentation

Modelos de segmentação categorizam pixels de imagem em classes de objetos distintas, cada uma representada por uma cor específica. Isso é inestimável para identificar e manipular elementos individuais dentro de uma imagem, como separar o primeiro plano do plano de fundo ou diferenciar objetos para edição detalhada.

- Seg: Projetado para diferenciar objetos dentro de uma imagem por cor, traduzindo efetivamente essas distinções em elementos distintos na saída. Por exemplo, pode separar móveis em um layout de sala, tornando-o particularmente valioso para projetos que requerem controle preciso sobre a composição e edição de imagens.

- ufade20k: Utiliza o modelo de segmentação UniFormer treinado no conjunto de dados ADE20K, capaz de distinguir uma ampla gama de tipos de objetos com alta precisão.

- ofade20k: Emprega o modelo de segmentação OneFormer, também treinado no ADE20K, oferecendo uma abordagem alternativa para diferenciação de objetos com seus recursos exclusivos de segmentação.

- ofcoco: Aproveita a segmentação OneFormer treinada no conjunto de dados COCO, adaptada para imagens com objetos categorizados dentro dos parâmetros do conjunto de dados COCO, facilitando a identificação e manipulação precisas de objetos.

Pré-processadores aceitáveis: Sam, Seg_OFADE20K (Oneformer ADE20K), Seg_UFADE20K (Uniformer ADE20K), Seg_OFCOCO (Oneformer COCO) ou máscaras criadas manualmente.

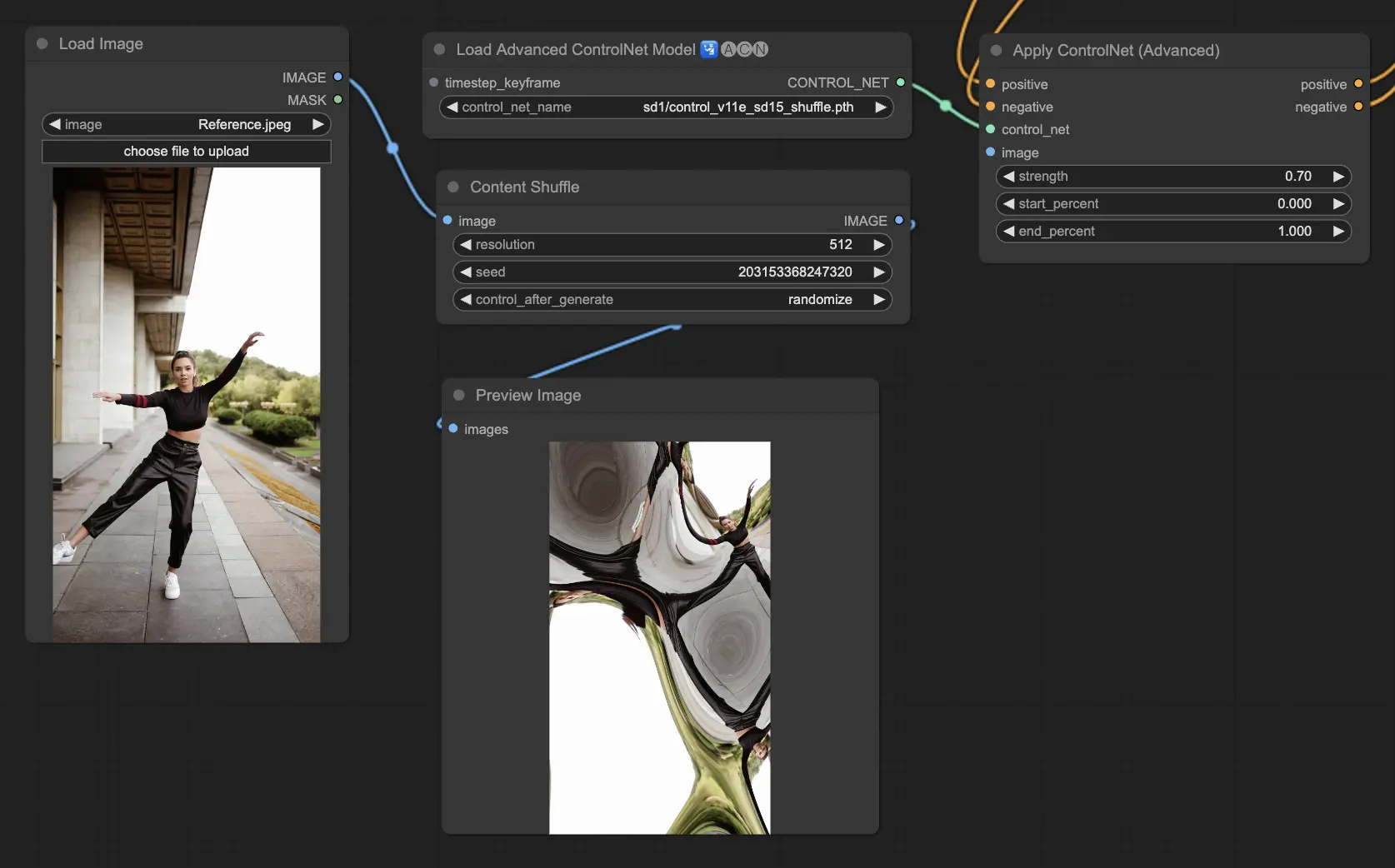

5.8. ComfyUI ControlNet Shuffle

O modelo Shuffle introduz uma abordagem inovadora randomizando os atributos da imagem de entrada, como esquemas de cores ou texturas, sem alterar a composição. Este modelo é particularmente eficaz para explorações criativas e geração de variações de uma imagem com integridade estrutural retida, mas estética visual alterada. Sua natureza randomizada significa que cada saída é única, influenciada pelo valor de semente usado no processo de geração.

Pré-processadores: Shuffle

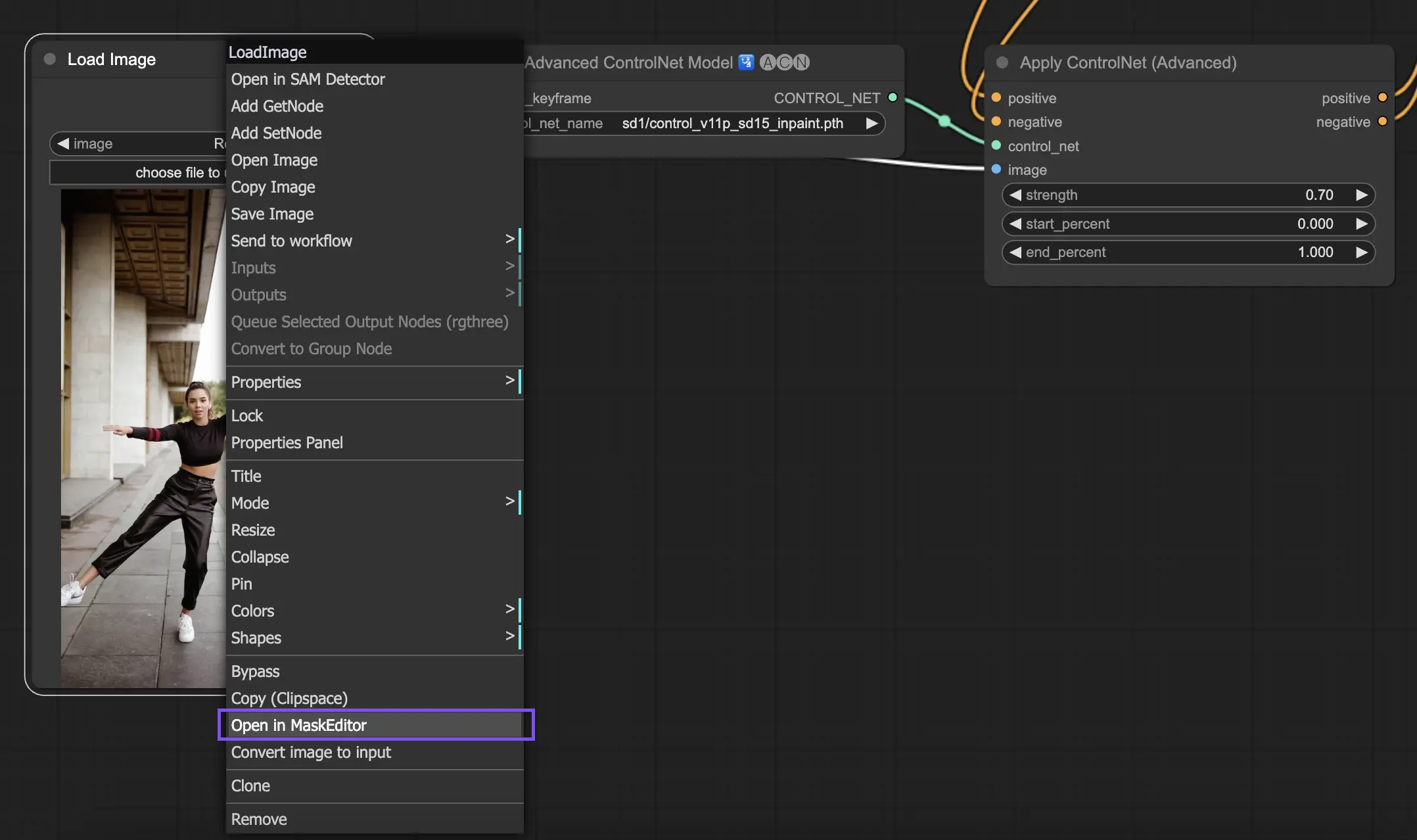

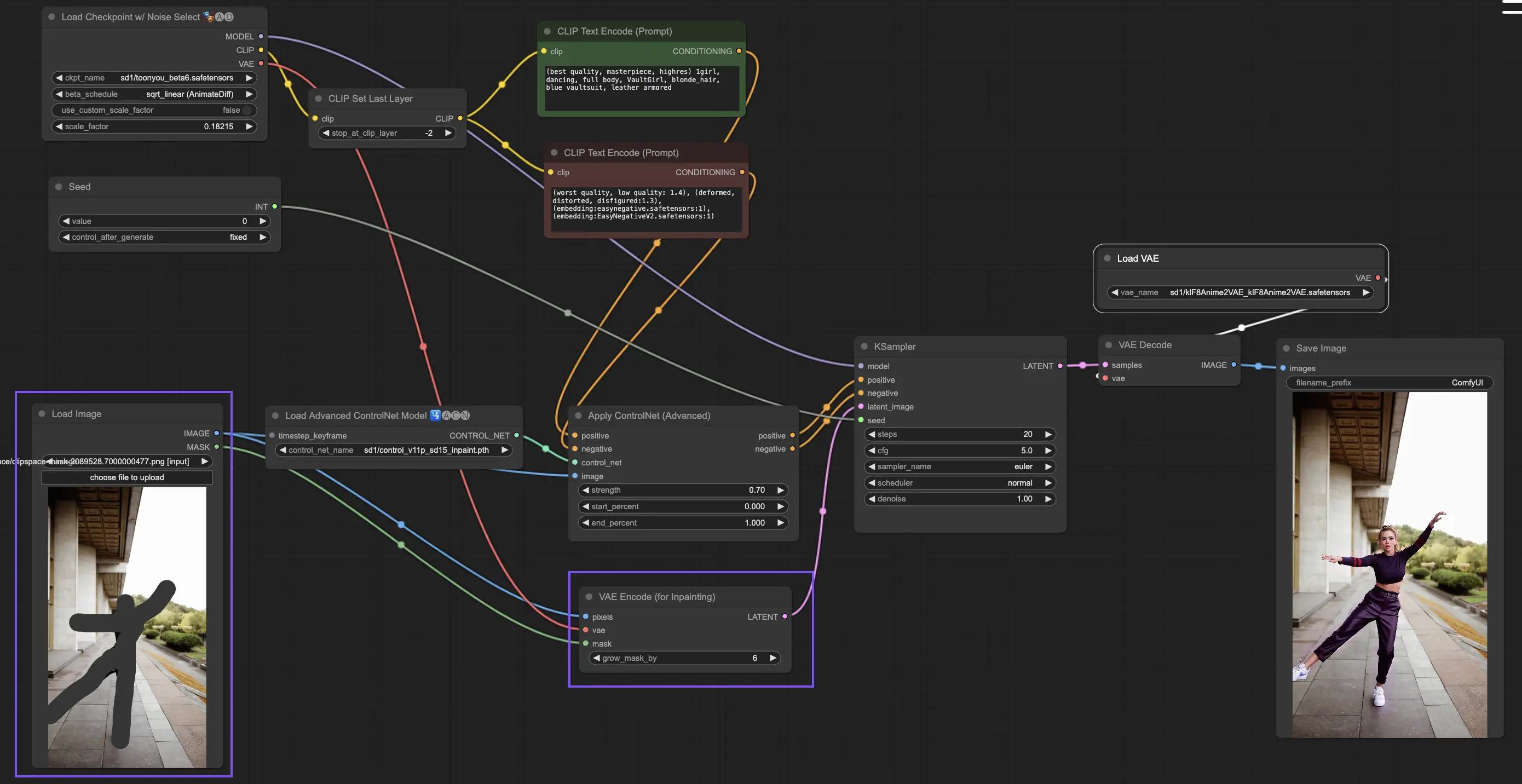

5.9. ComfyUI ControlNet Inpainting

Modelos de Inpainting dentro do ControlNet permitem edição refinada dentro de áreas específicas de uma imagem, mantendo a coerência geral enquanto introduzem variações ou correções significativas.

Para utilizar o ControlNet Inpainting, comece isolando a área que deseja regenerar através de mascaramento. Isso pode ser feito clicando com o botão direito na imagem desejada e selecionando "Open in MaskEditor" para modificações.

Diferente de outras implementações dentro do ControlNet, o Inpainting ignora a necessidade de um pré-processador devido às modificações diretas aplicadas à imagem. No entanto, é crucial encaminhar a imagem editada para o espaço latente através do KSampler. Isso garante que o modelo de difusão se concentre exclusivamente na regeneração da região mascarada, mantendo a integridade das áreas não mascaradas.

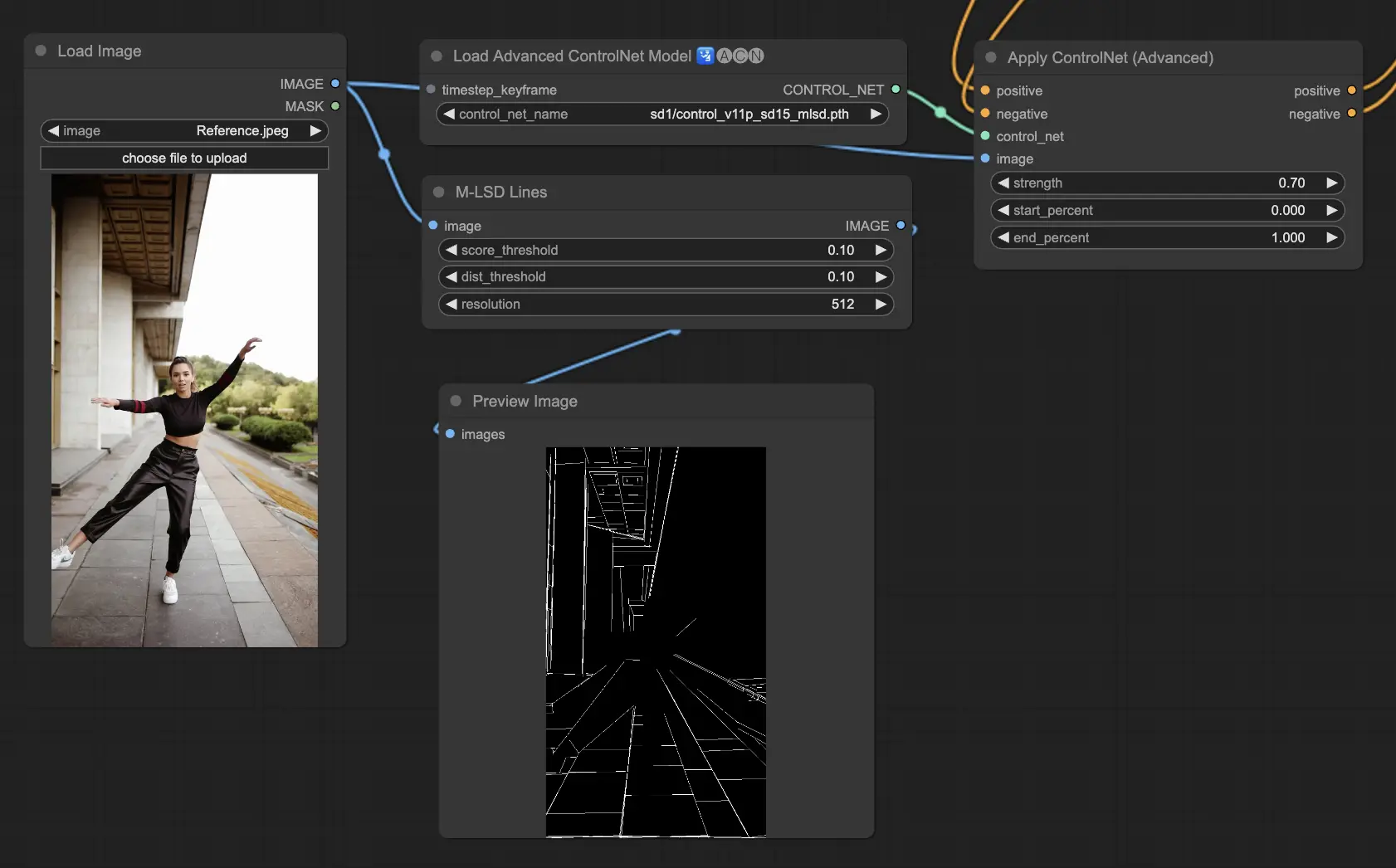

5.10. ComfyUI ControlNet MLSD

M-LSD (Detecção de Segmento de Linha Móvel) se concentra na detecção de linhas retas, ideal para imagens com fortes elementos arquitetônicos, interiores e formas geométricas. Ele simplifica cenas à sua essência estrutural, facilitando projetos criativos envolvendo ambientes construídos pelo homem.

Pré-processadores: MLSD.

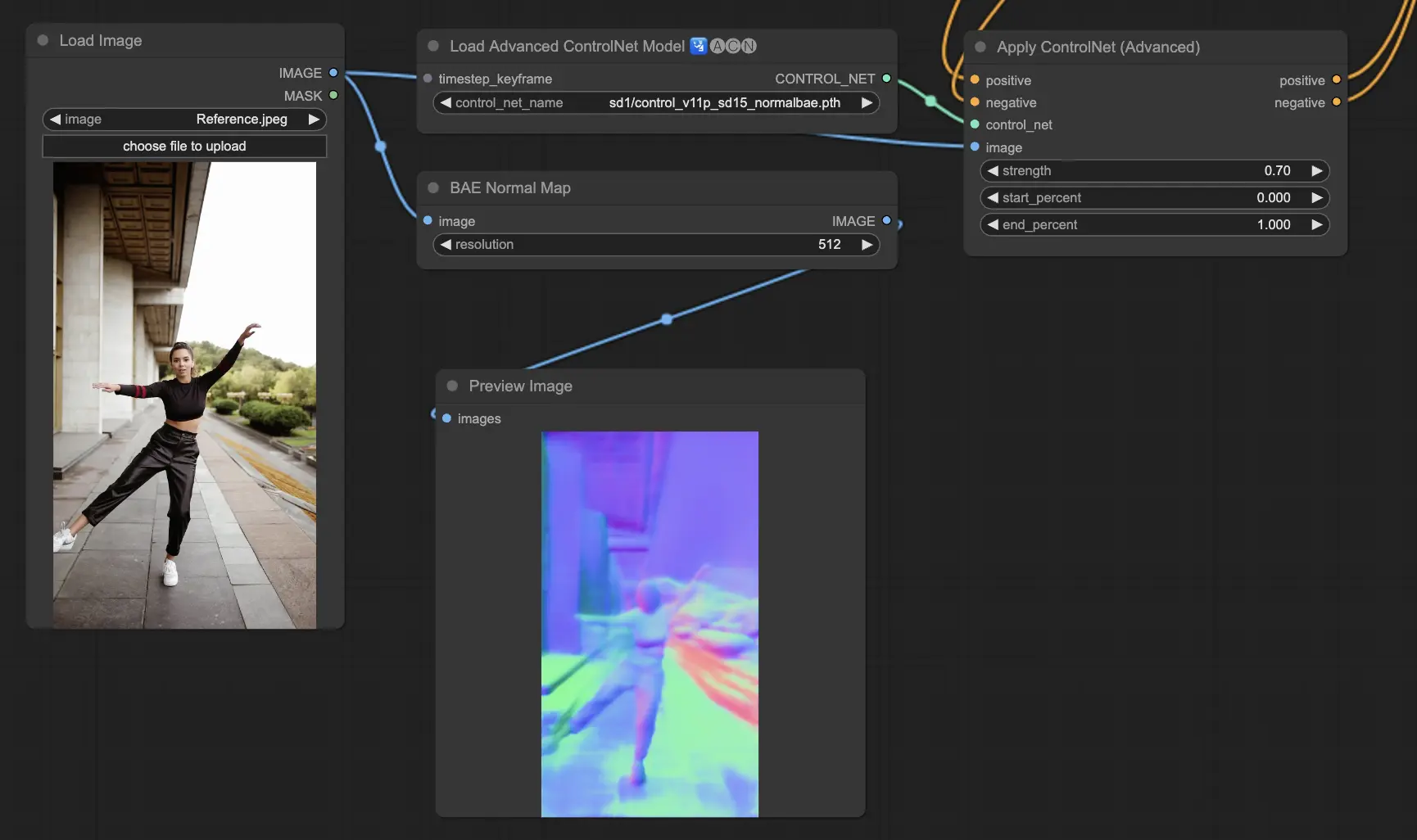

5.11. ComfyUI ControlNet Normalmaps

Normalmaps permite a simulação de efeitos complexos de iluminação e textura modelando a orientação das superfícies em uma cena visual, em vez de confiar apenas em dados de cor. Isso é fundamental para tarefas de modelagem e simulação 3D.

- Normal Bae: Este método gera normal maps aproveitando a abordagem de incerteza normal. Ele fornece uma técnica inovadora para retratar a orientação das superfícies, aprimorando a simulação de efeitos de iluminação com base na geometria física da cena modelada, em vez de métodos convencionais baseados em cores.

- Normal Midas: Utilizando mapas de profundidade produzidos pelo modelo Midas, o Normal Midas estima com precisão normal maps. Essa abordagem permite uma simulação matizada de texturas e iluminação de superfície, com base nasinformações de profundidade da cena, enriquecendo assim a complexidade visual de modelos 3D.

Pré-processadores: Normal BAE, Normal Midas

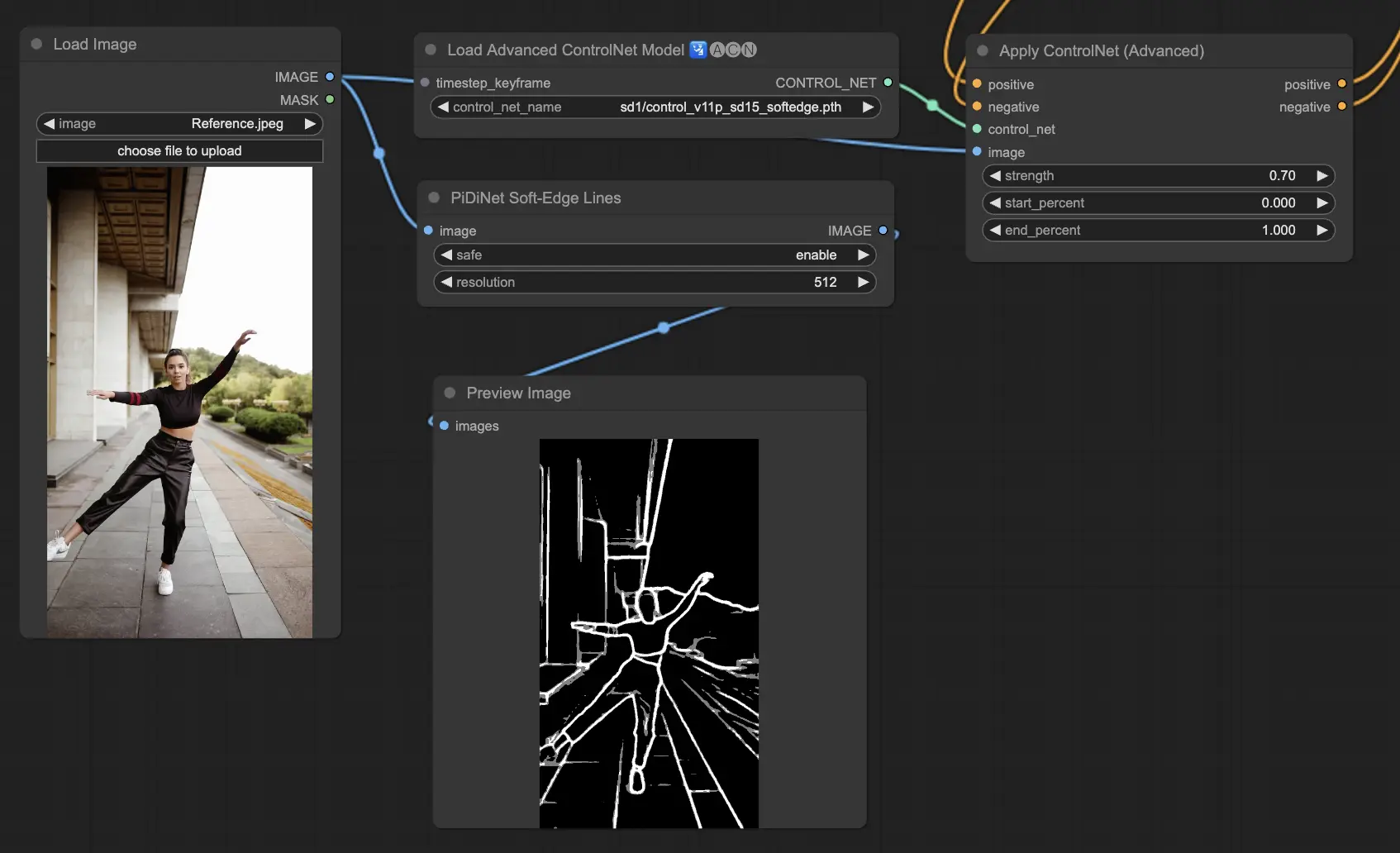

5.12. ComfyUI ControlNet Soft Edge

O ControlNet Soft Edge é projetado para gerar imagens com bordas mais suaves, com foco no controle de detalhes e na aparência natural. Ele usa técnicas avançadas de rede neural para manipulação precisa de imagens, oferecendo maior liberdade criativa e recursos de mesclagem perfeitos.

Robustez: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Qualidade máxima de resultado: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Considerando a compensação, recomendamos usar o SoftEdge_PIDI por padrão. Na maioria dos casos, ele funciona muito bem.

Pré-processadores: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

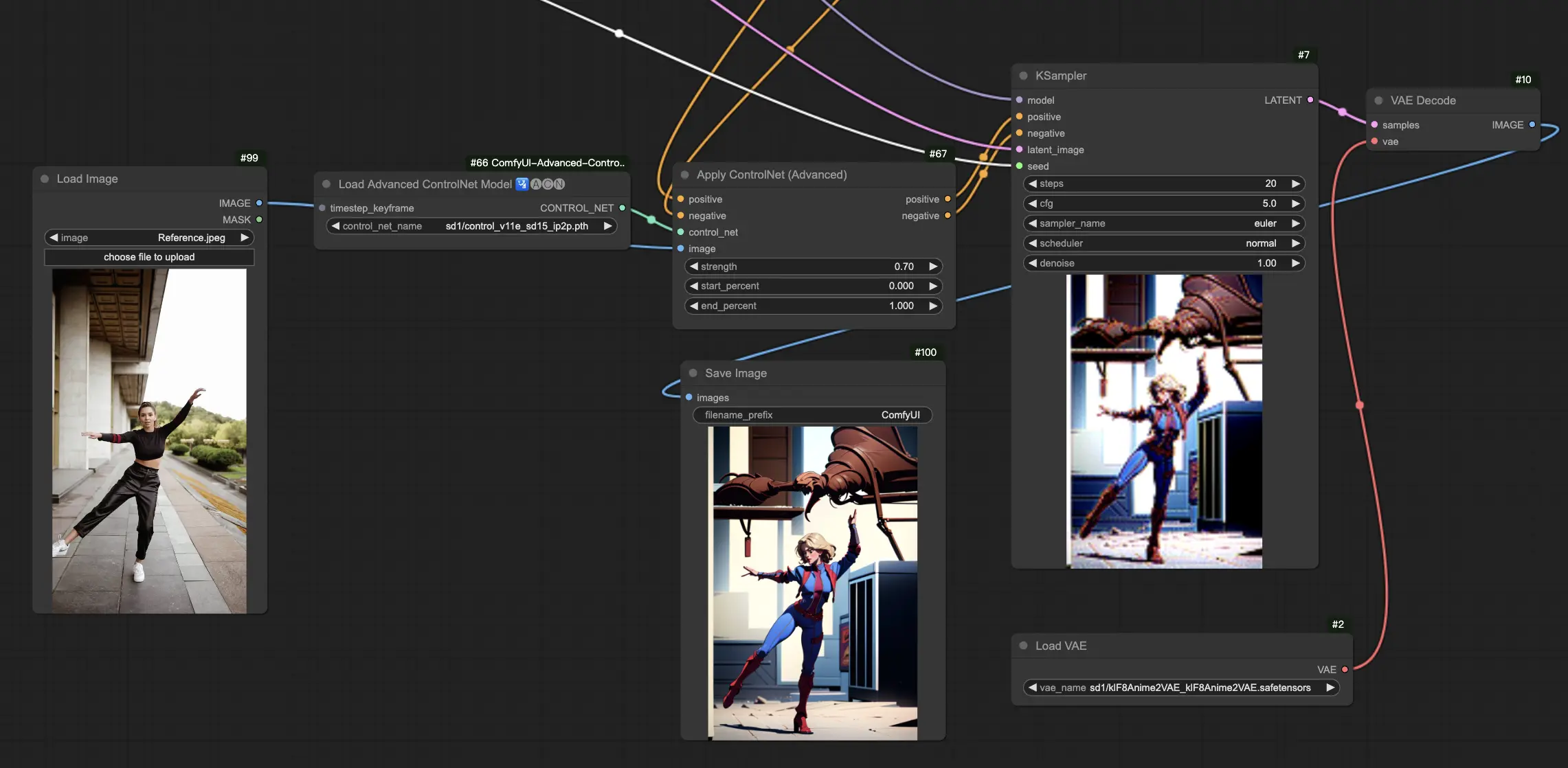

5.13. ComfyUI ControlNet IP2P (Instruct Pix2Pix)

O modelo ControlNet IP2P (Instruct Pix2Pix) se destaca como uma adaptação única dentro da estrutura do ControlNet, adaptada para aproveitar o conjunto de dados Instruct Pix2Pix para transformações de imagem. Esta variante do ControlNet se diferencia por equilibrar prompts de instrução e prompts de descrição durante sua fase de treinamento. Ao contrário da abordagem convencional no Instruct Pix2Pix oficial, o ControlNet IP2P incorpora uma mistura 50/50 desses tipos de prompt, aprimorando sua versatilidade e eficácia na geração de resultados desejados.

5.14. ComfyUI T2I Adapter

t2iadapter color: O modelo t2iadapter_color é especificamente projetado para aprimorar a representação e precisão das cores em imagens geradas ao usar modelos de difusão de texto para imagem. Ao focar na adaptação de cores, este modelo permite uma paleta de cores mais precisa e vibrante, alinhada de perto com as descrições fornecidas nos prompts de texto. É particularmente útil para projetos onde a fidelidade e a especificidade das cores são cruciais, adicionando uma nova camada de realismo e detalhe às imagens geradas.

t2iadapter style: O modelo t2iadapter_style visa os aspectos estilísticos da geração de imagens, permitindo a modificação e o controle do estilo artístico das imagens de saída. Este adaptador permite que os usuários guiem o modelo de texto para imagem na direção de gerar imagens que aderem a estilos artísticos ou estéticas específicas descritas nos prompts de texto. É uma ferramenta inestimável para projetos criativos onde o estilo da imagem desempenha um papel fundamental, oferecendo uma maneira perfeita de misturar estilos de arte tradicionais com recursos modernos de IA.

5.15. Outros ComfyUI ControlNets Populares: QRCode Monster e IP-Adapter

Para esses segmentos, dedicaremos artigos separados para fornecer uma introdução completa a cada um, dado o volume substancial de informações que desejamos compartilhar.

6. Como Usar Múltiplos ComfyUI ControlNets

Usar múltiplos ComfyUI ControlNets no ComfyUI envolve um processo de camadas ou encadeamento de modelos ControlNet para refinar a geração de imagens com controles mais precisos sobre vários aspectos, como pose, forma, estilo e cor.

Assim, você pode construir seu fluxo de trabalho aplicando um ControlNet (por exemplo, OpenPose) e, em seguida, alimentando sua saída para outro ControlNet (por exemplo, Canny). Essa aplicação em camadas permite a personalização detalhada da imagem, onde cada ControlNet aplica suas transformações ou controles específicos. O processo permite um controle refinado sobre a saída final, integrando múltiplos aspectos guiados por diferentes ControlNets.

🌟🌟🌟 ComfyUI Online - Experimente o Fluxo de Trabalho do ControlNet Agora 🌟🌟🌟

Se você está interessado em explorar o fluxo de trabalho do ControlNet, use o seguinte ComfyUI web. Ele vem totalmente equipado com todos os nós e modelos essenciais do cliente, permitindo uma criatividade perfeita sem a necessidade de configurações manuais. Ganhe experiência prática e familiarize-se com os recursos do ControlNet agora!