Este fluxo de trabalho é inspirado por enigmatic_e com algumas modificações. Para mais informações, por favor visite seu canal no YouTube.

Este fluxo de trabalho permite transformar vídeos comuns em encantadoras criações de anime japonês usando AnimateDiff, ControlNet e IPAdapter. Sinta-se à vontade para experimentar vários pontos de verificação, configurações de LoRA e imagens de referência para o IPAdapter para criar seu estilo único. É uma maneira divertida e criativa de dar vida aos seus vídeos no mundo do anime!

Por favor, confira os detalhes sobre Como usar AnimateDiff no ComfyUI

O ControlNet revoluciona a maneira como geramos imagens, trazendo um novo nível de controle espacial para modelos de difusão de texto para imagem. Essa arquitetura de rede neural de ponta faz uma bela parceria com gigantes como o Stable Diffusion, aproveitando suas vastas bibliotecas—forjadas a partir de bilhões de imagens—para tecer nuances espaciais diretamente no tecido da criação de imagens. Desde esboçar bordas até mapear posturas humanas, percepção de profundidade ou segmentar visuais, o ControlNet capacita você a moldar as imagens de maneiras que vão muito além do escopo de meros prompts de texto.

Em seu núcleo, o ControlNet é engenhosamente direto. Ele começa protegendo a integridade dos parâmetros do modelo original—mantendo o treinamento base intacto. Então, o ControlNet introduz um conjunto espelhado das camadas de codificação do modelo, mas com uma reviravolta: elas são treinadas usando "convoluções zero". Esses zeros como ponto de partida significam que as camadas introduzem suavemente novas condições espaciais sem causar confusão, garantindo que os talentos originais do modelo sejam preservados, mesmo quando ele embarca em novos caminhos de aprendizado.

Tanto ControlNets quanto T2I-Adapters desempenham papéis cruciais no condicionamento da geração de imagens, cada um oferecendo vantagens distintas. Os T2I-Adapters são reconhecidos por sua eficiência, particularmente em termos de acelerar o processo de geração de imagens. Apesar disso, os ControlNets são inigualáveis em sua capacidade de guiar intrincadamente o processo de geração, tornando-os uma ferramenta poderosa para os criadores.

Considerando a sobreposição de funcionalidades entre muitos modelos de T2I-Adapter e ControlNet, nossa discussão se concentrará principalmente em ControlNets. No entanto, vale ressaltar que a plataforma RunComfy tem vários modelos de T2I-Adapter pré-carregados para facilitar o uso. Para aqueles interessados em experimentar T2I-Adapters, você pode carregar esses modelos perfeitamente e integrá-los aos seus projetos.

A escolha entre modelos de ControlNet e T2I-Adapter no ComfyUI não afeta o uso de nós de ControlNet ou a consistência do fluxo de trabalho. Essa uniformidade garante um processo simplificado, permitindo que você aproveite os benefícios únicos de cada tipo de modelo de acordo com as necessidades do seu projeto.

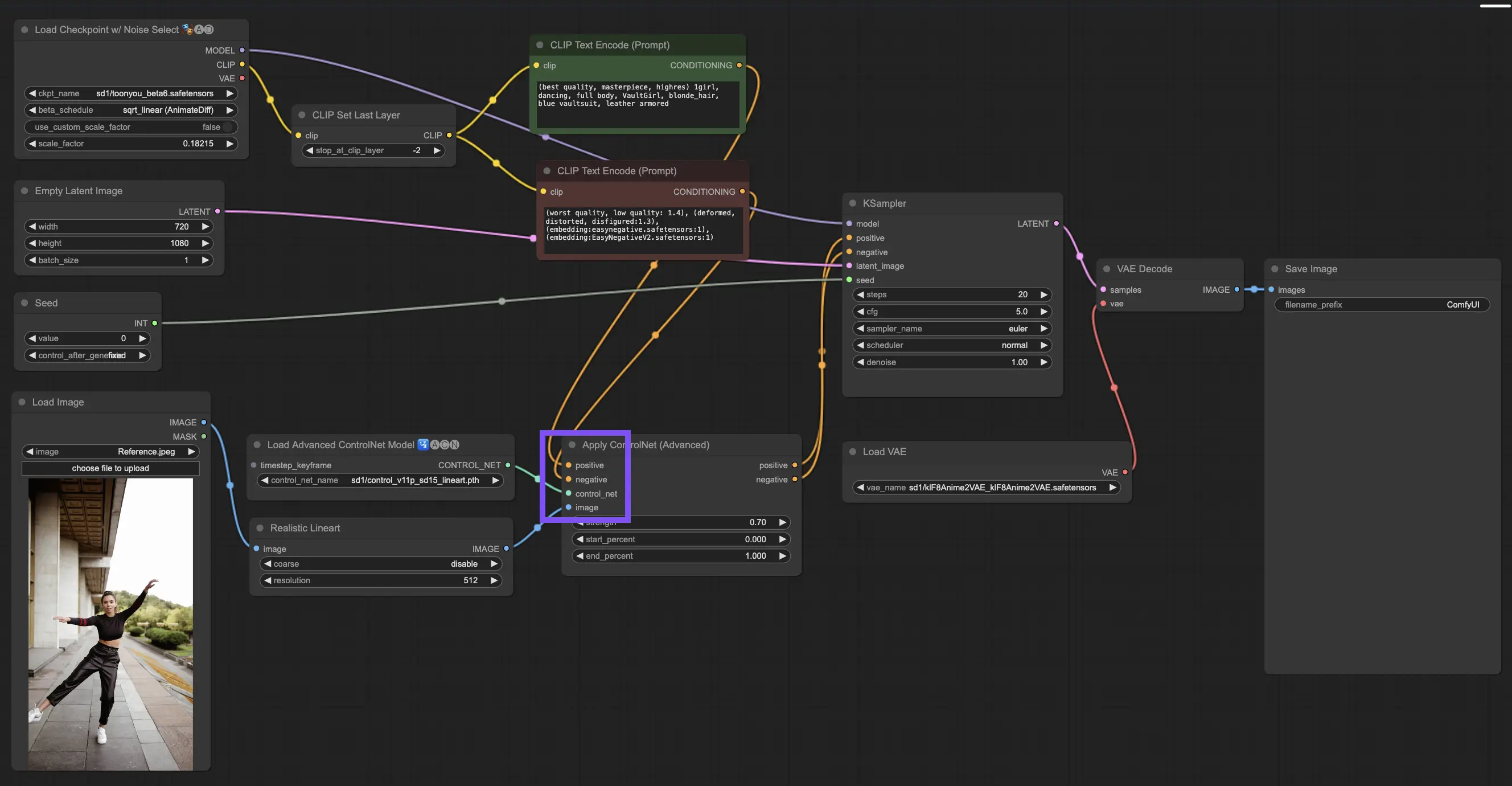

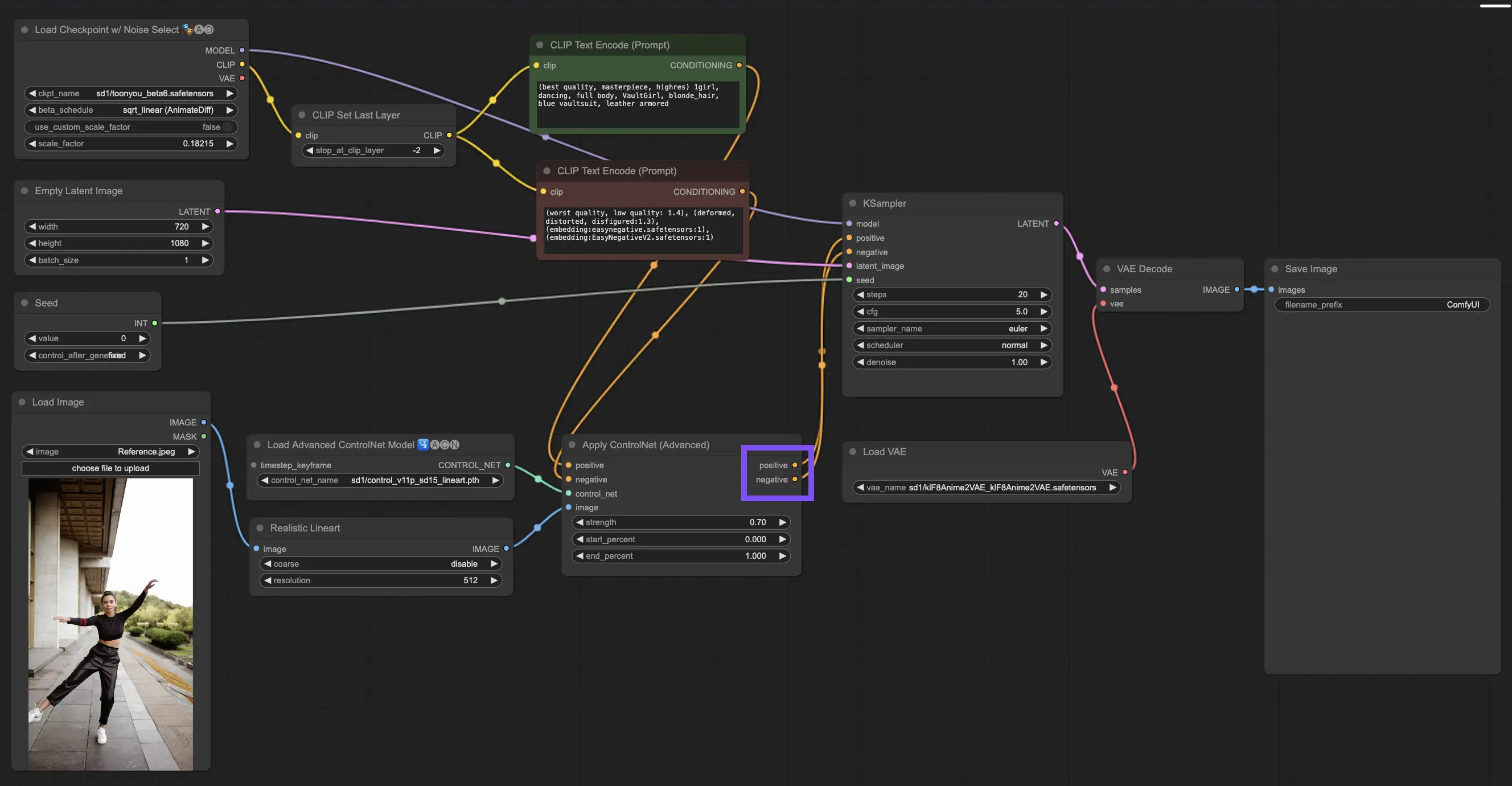

3.4.1. Carregando o Nó "Apply ControlNet"

Para começar, você precisará carregar o nó "Apply ControlNet" no seu ComfyUI. Esse é o primeiro passo em direção a uma jornada de criação de imagens com condicionamento duplo, mesclando elementos visuais com prompts textuais.

3.4.2. Entendendo as Entradas do Nó "Apply ControlNet"

Condicionamento Positivo e Negativo: Essas são suas ferramentas para moldar a imagem final—o que ela deve abraçar e o que deve evitar. Conecte-os aos slots "Prompt positivo" e "Prompt negativo" para sincronizá-los com a parte baseada em texto de sua direção criativa.

Selecionando o Modelo ControlNet: Você precisará vincular esta entrada à saída do nó "Load ControlNet Model". É aqui que você decide se deve usar um modelo ControlNet ou T2IAdaptor com base nos traços ou estilos específicos que você deseja. Embora estejamos nos concentrando nos modelos ControlNet, vale a pena mencionar alguns T2IAdaptors populares para uma visão abrangente.

Pré-processando sua Imagem: Conecte sua imagem a um nó "ControlNet Preprocessor", que é vital para garantir que sua imagem esteja pronta para o ControlNet. É essencial combinar o pré-processador ao seu modelo ControlNet. Essa etapa ajusta sua imagem original para atender perfeitamente às necessidades do modelo—redimensionando, recolorindo ou aplicando os filtros necessários—preparando-a para uso pelo ControlNet.

3.4.3. Entendendo as Saídas do Nó "Apply ControlNet"

Após o processamento, o nó "Apply ControlNet" apresenta duas saídas que refletem a interação sofisticada do ControlNet e sua entrada criativa: Condicionamento Positivo e Negativo. Essas saídas orientam o modelo de difusão dentro do ComfyUI, levando à sua próxima escolha: refinar a imagem usando o KSampler ou se aprofundar empilhando mais ControlNets para aqueles que buscam detalhes e personalização inigualáveis.

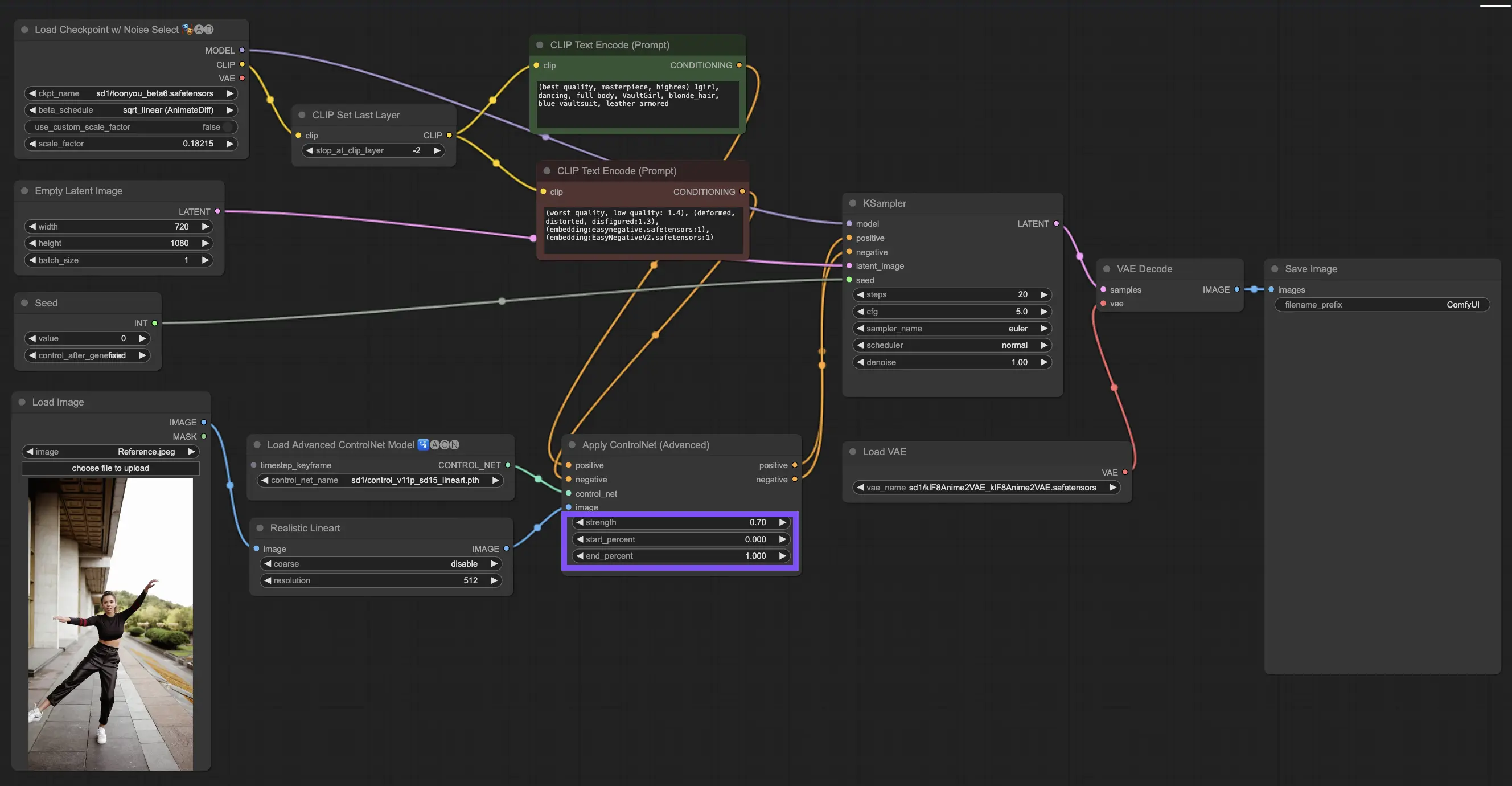

3.4.4. Ajustando "Apply ControlNet" para Melhores Resultados

Determinando a Força: Essa configuração controla o quanto o ControlNet influencia a imagem resultante. Um valor máximo de 1.0 significa que a entrada do ControlNet está no controle, enquanto reduzir para 0.0 permite que o modelo seja executado sem a influência do ControlNet.

Ajustando o Percentual Inicial: Isso informa quando o ControlNet começa a contribuir durante o processo de difusão. Por exemplo, um início de 20% significa que a partir de um quinto do caminho, o ControlNet começa a deixar sua marca.

Definindo o Percentual Final: Esse é o lado oposto do Percentual Inicial, marcando quando o ControlNet se retira. Se você definir como 80%, a influência do ControlNet desaparece à medida que a imagem se aproxima de seus estágios finais, intocada pelo ControlNet no trecho final.

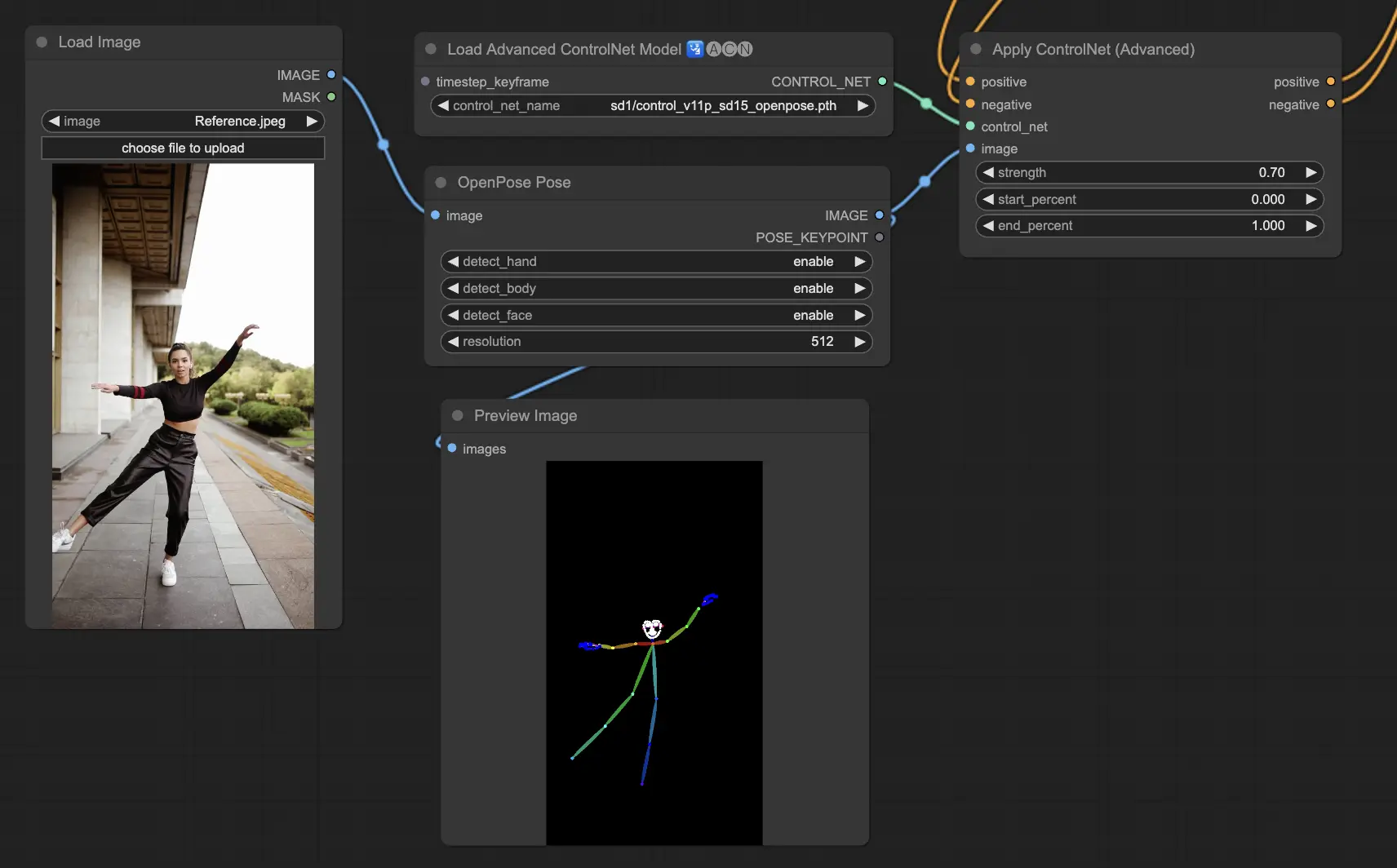

3.5.1. Modelo ControlNet: Openpose

As opções de pré-processador incluem: Openpose ou DWpose

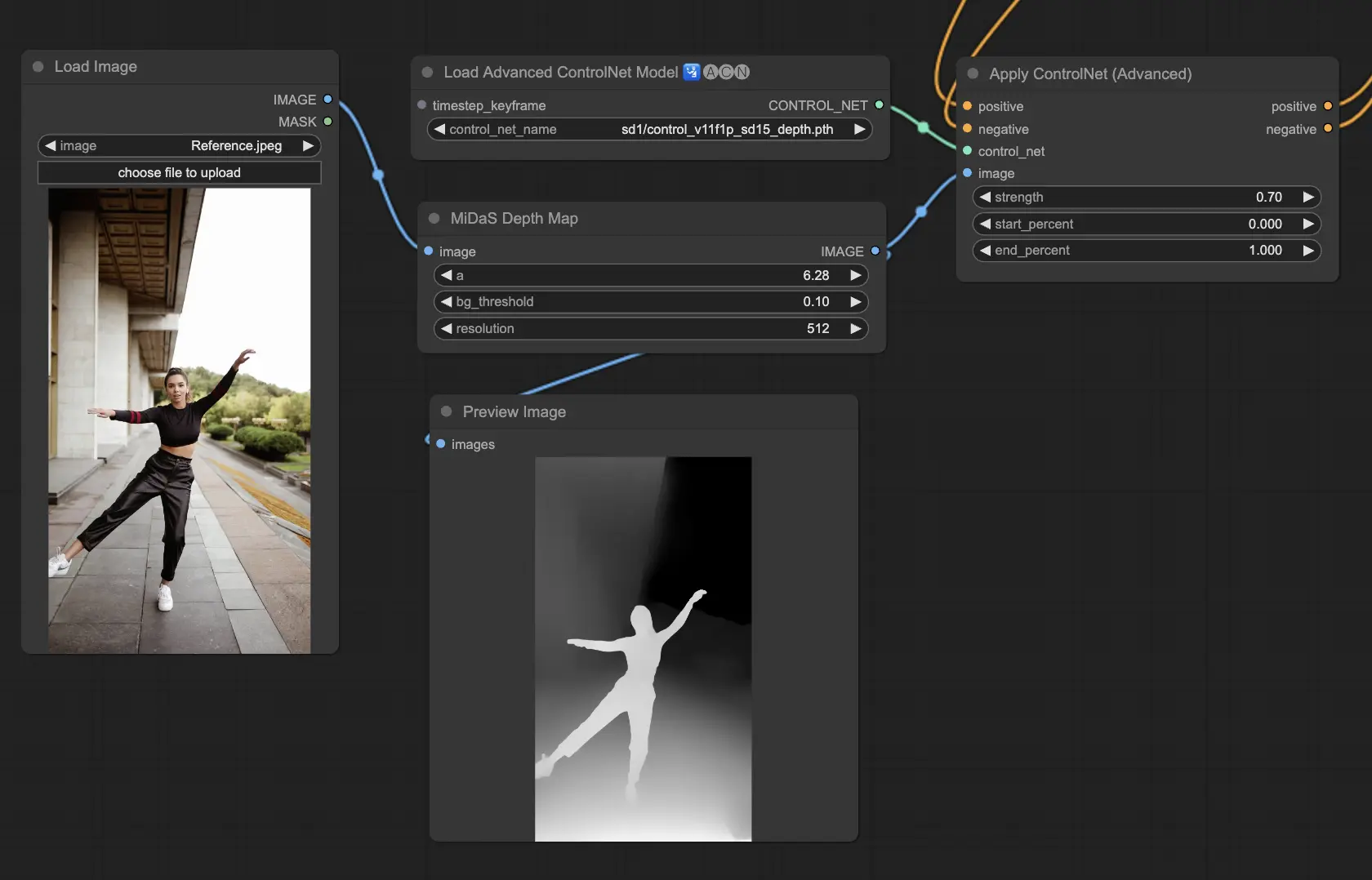

3.5.2. Modelo ControlNet: Depth

Os modelos de profundidade usam uma imagem 2D para inferir a profundidade, representando-a como um mapa em escala de cinza. Cada um tem seus pontos fortes em termos de detalhes ou foco no plano de fundo:

Pré-processadores a considerar: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Este modelo se destaca em robustez e compatibilidade com mapas de profundidade reais de motores de renderização.

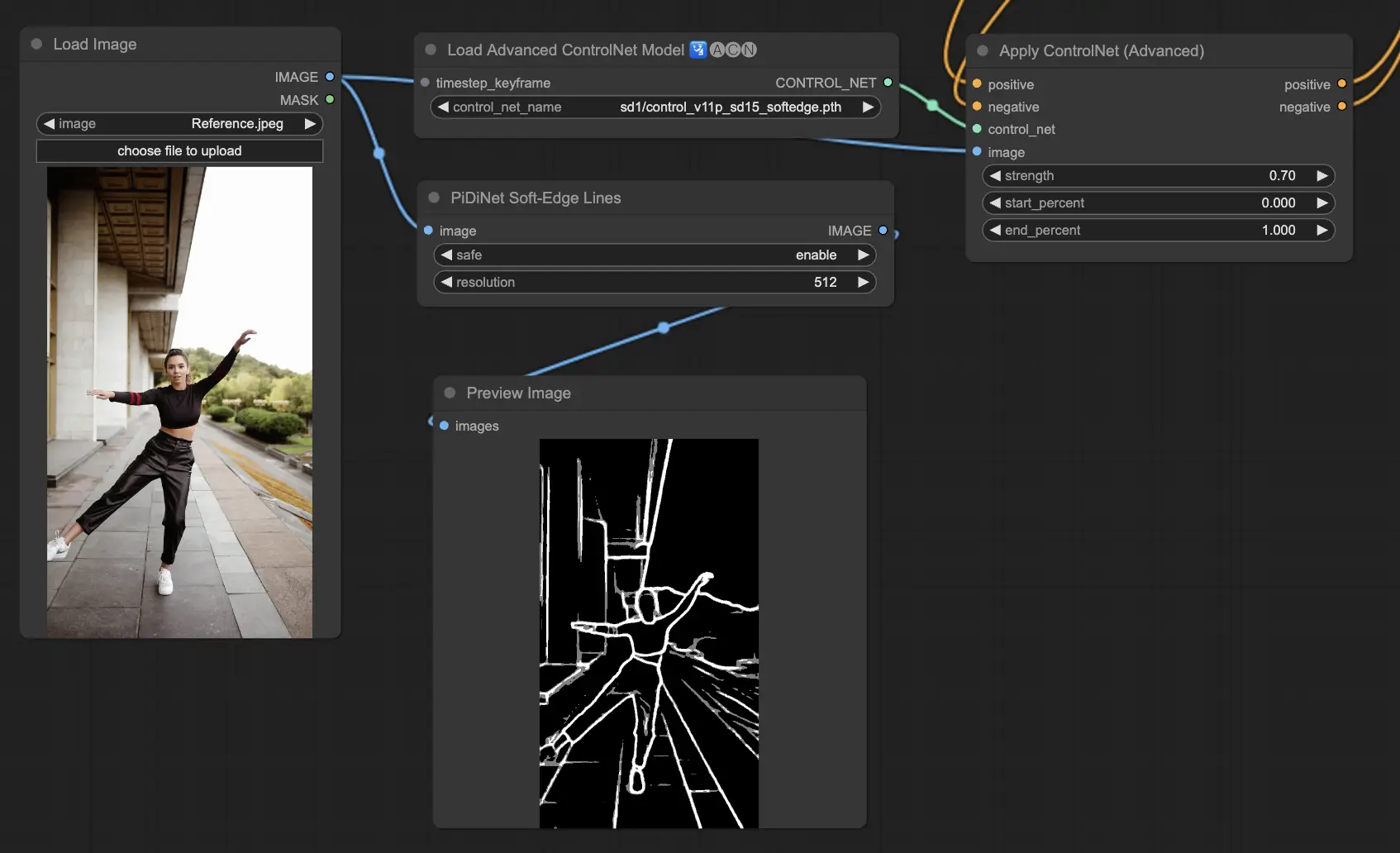

3.5.3. Modelo ControlNet: SoftEdge

O ControlNet Soft Edge é projetado para produzir imagens com bordas mais suaves, aprimorando os detalhes e mantendo uma aparência natural. Ele utiliza redes neurais de ponta para uma manipulação refinada de imagens, oferecendo amplo controle criativo e integração perfeita.

Em termos de robustez: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Para os melhores resultados de qualidade: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Como uma recomendação geral, o SoftEdge_PIDI é a opção preferida, pois geralmente fornece excelentes resultados.

Pré-processadores incluem: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

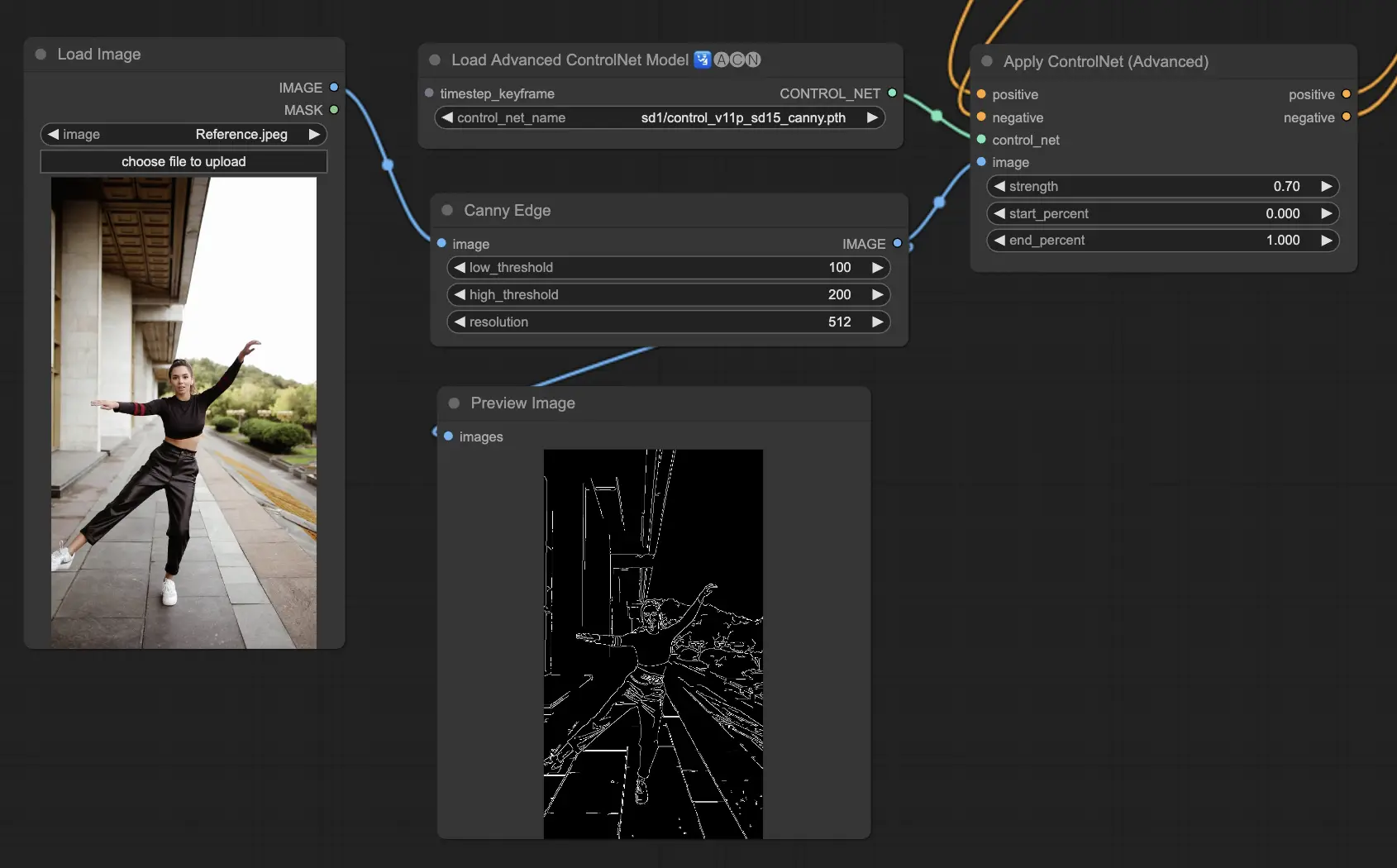

3.5.4. Modelo ControlNet: Canny

O modelo Canny implementa a detecção de bordas Canny para destacar um amplo espectro de bordas dentro das imagens. Este modelo é excelente para manter a integridade dos elementos estruturais enquanto simplifica a aparência geral da imagem, auxiliando na criação de arte estilizada ou preparando imagens para manipulação adicional.

Pré-processadores disponíveis: Canny

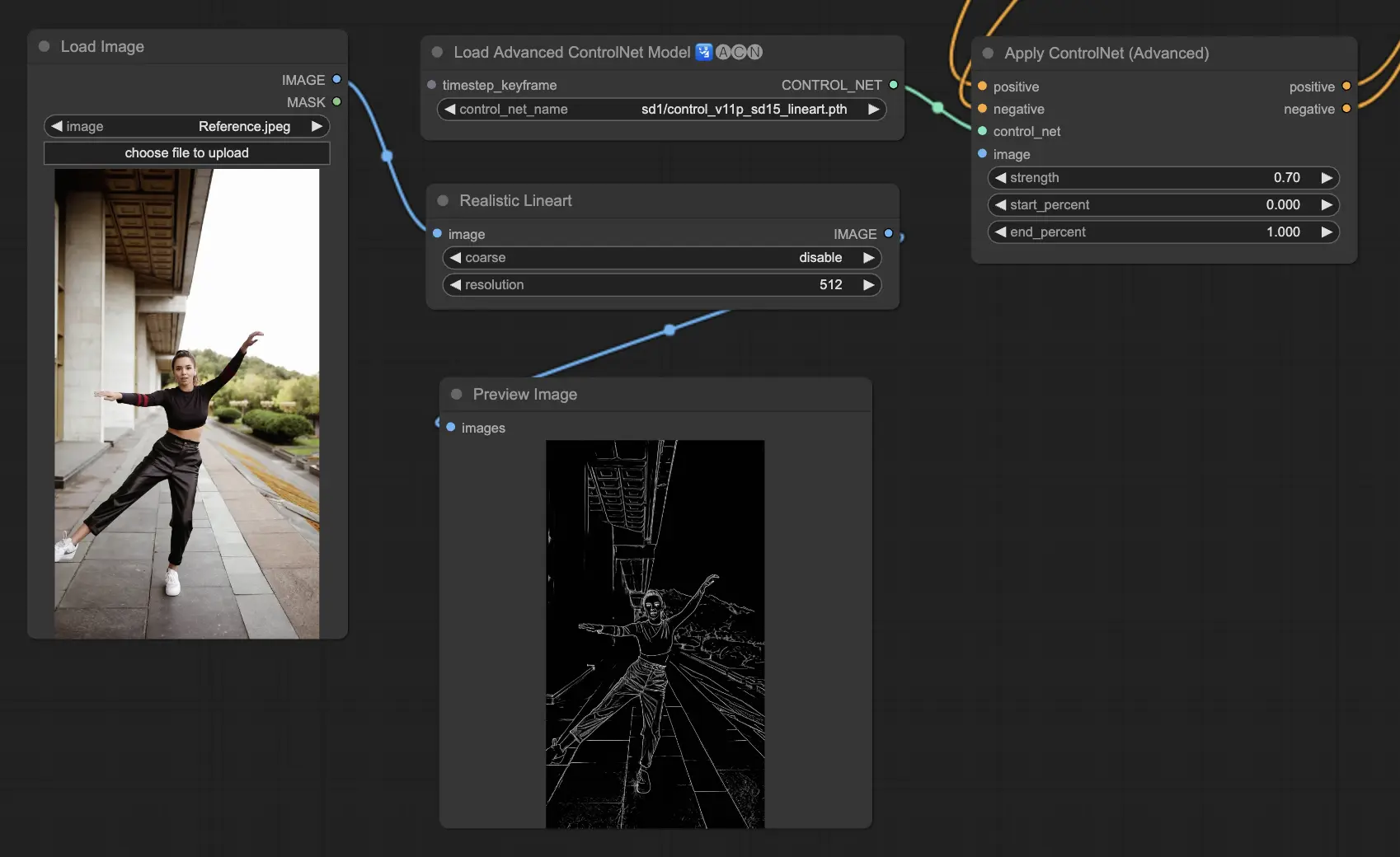

3.5.5. Modelo ControlNet: Lineart

Os modelos Lineart são suas ferramentas para transformar imagens em desenhos de linha estilizados, adequados para uma variedade de aplicações artísticas:

Pré-processadores disponíveis podem produzir lineart detalhado ou mais pronunciado (Lineart e Lineart_Coarse).

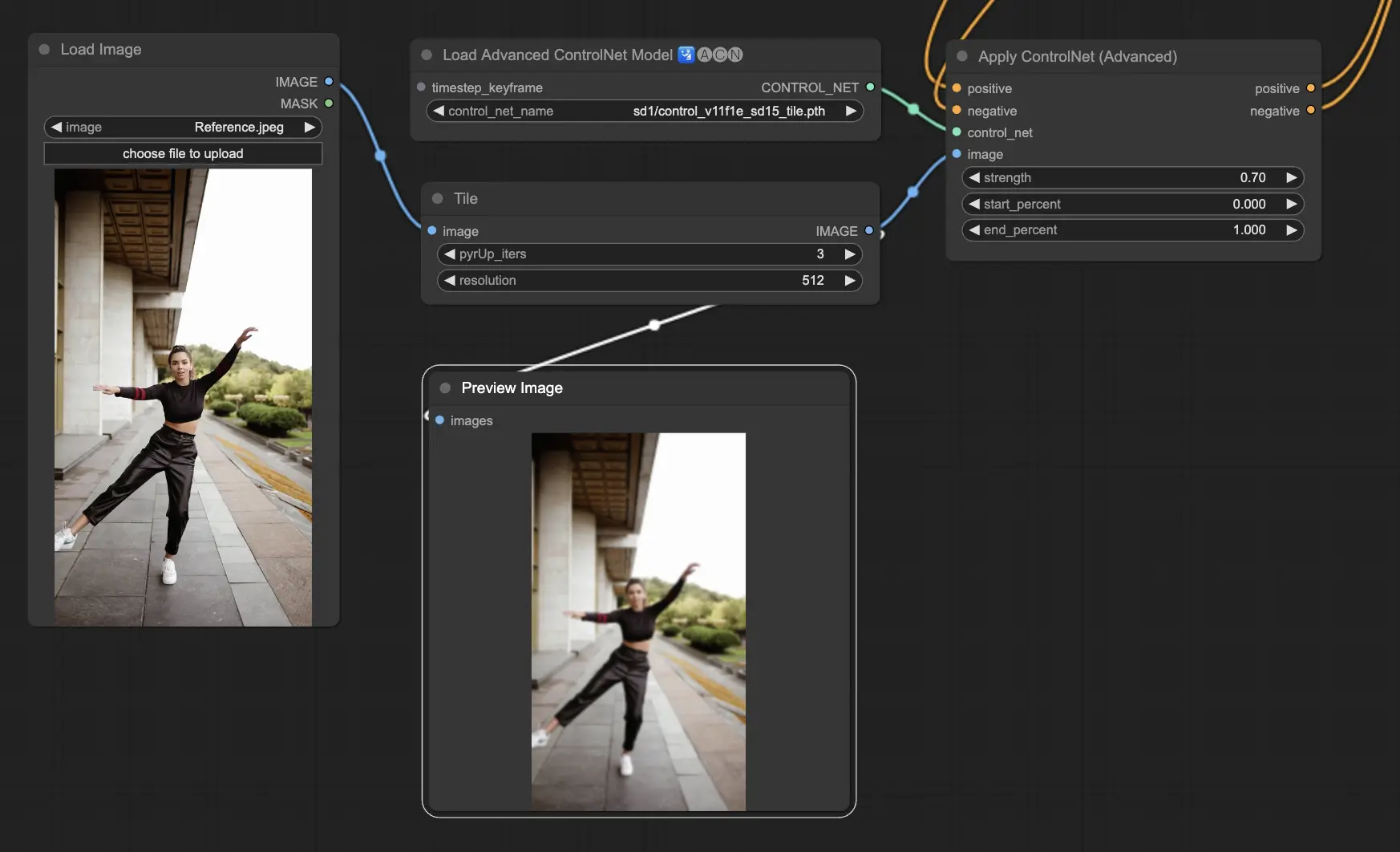

3.5.6. Modelo ControlNet: Tile

O modelo Tile Resample se destaca em realçar detalhes em imagens. É especialmente eficaz quando usado em conjunto com um upscaler para aprimorar a resolução e os detalhes da imagem, frequentemente aplicado para aguçar e enriquecer texturas e elementos da imagem.

Pré-processador recomendado: Tile

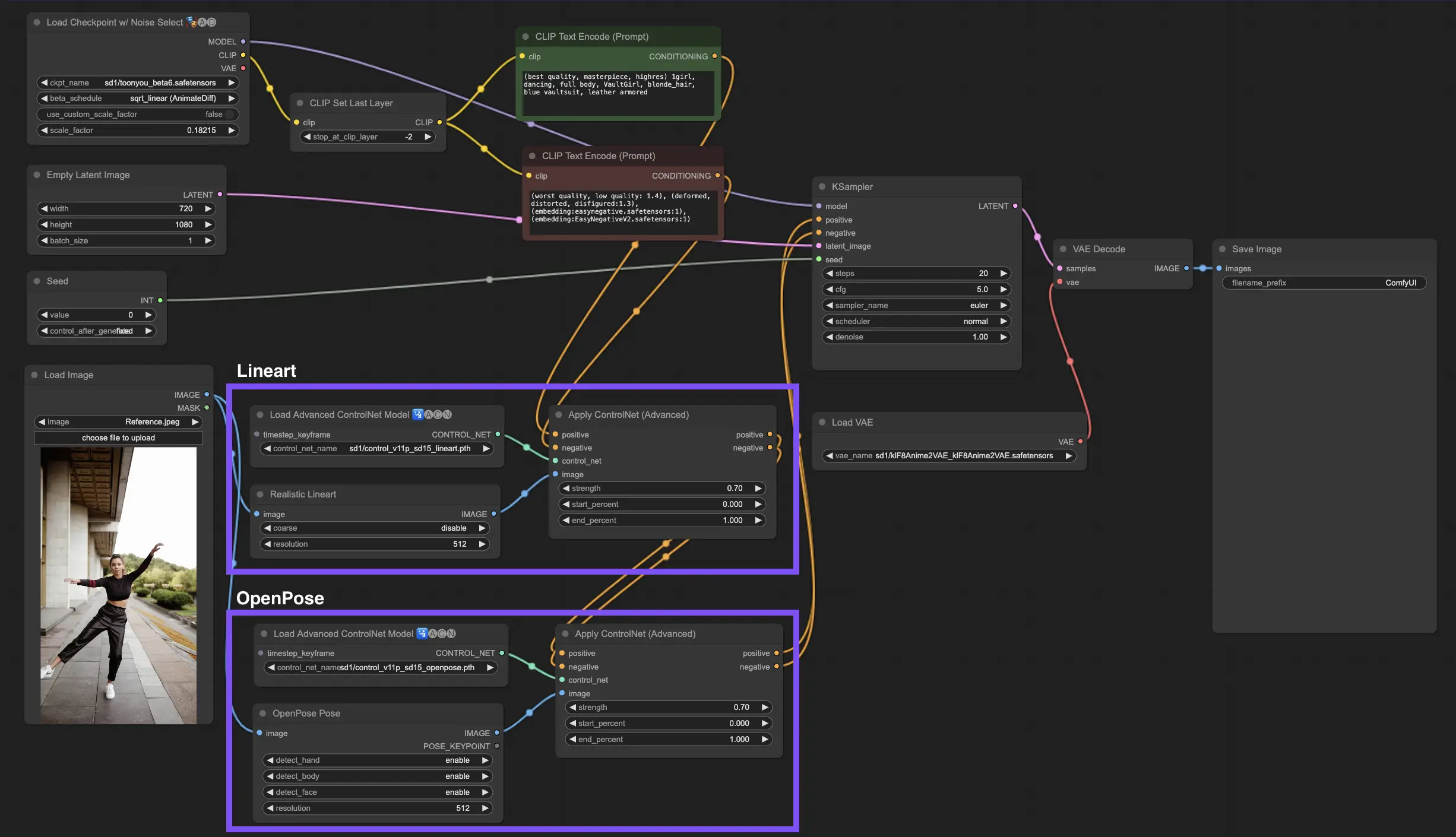

Incorporar vários ControlNets ou T2I-Adapters permite a aplicação sequencial de diferentes tipos de condicionamento ao seu processo de geração de imagem. Por exemplo, você pode combinar ControlNets de Lineart e OpenPose para detalhamento aprimorado.

Lineart para Forma de Objetos: Comece integrando um ControlNet de Lineart para adicionar profundidade e detalhes a objetos ou elementos em suas imagens. Esse processo envolve a preparação de um mapa de lineart ou canny para os objetos que você deseja incluir.

OpenPose para Controle de Pose: Após o detalhamento do lineart, utilize o ControlNet OpenPose para ditar a pose dos indivíduos dentro da sua imagem. Você precisará gerar ou adquirir um mapa OpenPose que capture a pose desejada.

Aplicação Sequencial: Para combinar efetivamente esses efeitos, conecte a saída do ControlNet de Lineart ao ControlNet OpenPose. Esse método garante que tanto a pose dos sujeitos quanto as formas dos objetos sejam guiadas simultaneamente durante o processo de geração, criando um resultado que se alinha harmoniosamente com todas as especificações de entrada.

Por favor, confira os detalhes sobre Como usar o IPAdapter no ComfyUI

RunComfy é a principal ComfyUI plataforma, oferecendo ComfyUI online ambiente e serviços, juntamente com fluxos de trabalho do ComfyUI apresentando visuais impressionantes. RunComfy também oferece AI Playground, permitindo que artistas utilizem as mais recentes ferramentas de AI para criar arte incrível.