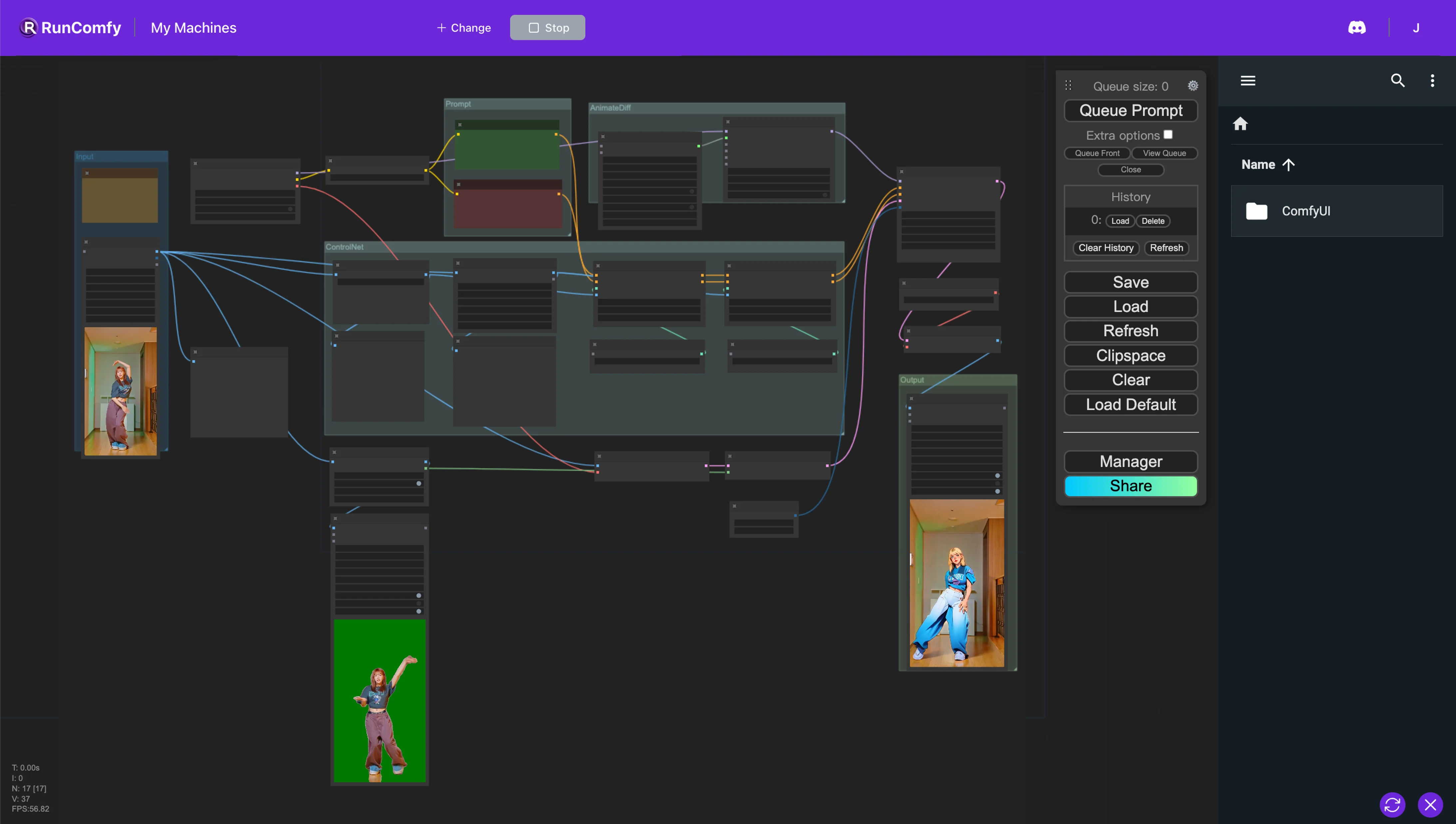

AnimateDiff + ControlNet + AutoMask | Comic Style

В этом рабочем процессе ComfyUI мы используем пользовательские узлы, такие как Animatediff, ControlNet (с Depth и OpenPose) и Auto Mask, чтобы бесшовно изменять стиль видео. Этот процесс преобразует реалистичных персонажей в аниме, тщательно сохраняя оригинальные фоны.ComfyUI Vid2Vid Рабочий процесс

- Полностью функциональные рабочие процессы

- Нет недостающих узлов или моделей

- Не требуется ручная настройка

- Отличается потрясающей визуализацией

ComfyUI Vid2Vid Примеры

ComfyUI Vid2Vid Описание

1. ComfyUI AnimateDiff, ControlNet и Auto Mask Workflow

Этот рабочий процесс ComfyUI представляет мощный подход к изменению стиля видео, специально нацеленный на преобразование персонажей в аниме-стиль при сохранении оригинальных фонов. Эта трансформация поддерживается несколькими ключевыми компонентами, включая AnimateDiff, ControlNet и Auto Mask.

AnimateDiff разработан для дифференциальных анимационных техник, что позволяет сохранять постоянный контекст в анимациях. Этот компонент фокусируется на сглаживании переходов и повышении плавности движения в видео с измененным стилем.

ControlNet играет критическую роль в точном воспроизведении и манипуляции позами человека. Он использует передовые методы оценки поз для точного захвата и управления нюансами движения человека, способствуя преобразованию персонажей в аниме-формы, сохраняя их оригинальные позы.

Auto Mask участвует в автоматической сегментации, умело изолируя персонажей от их фона. Эта технология позволяет избирательно изменять стиль элементов видео, обеспечивая преобразование персонажей без изменения окружающей среды, сохраняя целостность оригинальных фонов.

Этот рабочий процесс ComfyUI реализует преобразование стандартного видео-контента в стилизованные анимации, фокусируясь на эффективности и качестве генерации персонажей в аниме-стиле.

2. Обзор AnimateDiff

2.1. Введение в AnimateDiff

AnimateDiff появляется как AI-инструмент, предназначенный для анимирования статических изображений и текстовых подсказок в динамические видео, используя модели Stable Diffusion и специализированный модуль движения. Эта технология автоматизирует процесс анимации, предсказывая бесшовные переходы между кадрами, делая его доступным для пользователей без навыков программирования или вычислительных ресурсов через бесплатную онлайн-платформу.

2.2. Ключевые особенности AnimateDiff

2.2.1. Поддержка различных моделей: AnimateDiff совместим с различными версиями, включая AnimateDiff v1, v2, v3 для Stable Diffusion V1.5 и AnimateDiff sdxl для Stable Diffusion SDXL. Он позволяет использовать несколько моделей движения одновременно, что способствует созданию сложных и многослойных анимаций.

2.2.2. Размер контекста определяет длину анимации: AnimateDiff позволяет создавать анимации бесконечной длины путем настройки размера контекста. Эта функция позволяет пользователям настраивать длину и переходы анимаций в соответствии с их конкретными требованиями, обеспечивая высоко адаптируемый процесс анимации.

2.2.3. Длина контекста для плавных переходов: Цель Uniform Context Length в AnimateDiff заключается в обеспечении бесшовных переходов между различными сегментами анимации. Настройка Uniform Context Length позволяет пользователям управлять динамикой переходов между сценами — более длинные длины для более плавных, бесшовных переходов, и более короткие длины для более быстрых, выраженных изменений.

2.2.4. Динамика движения: В AnimateDiff v2 доступны специализированные motion LoRAs для добавления кинематографических движений камеры к анимациям. Эта функция вводит динамический слой в анимации, значительно повышая их визуальную привлекательность.

2.2.5. Расширенные функции поддержки: AnimateDiff разработан для работы с различными инструментами, включая ControlNet, SparseCtrl и IPAdapter, предлагая значительные преимущества для пользователей, стремящихся расширить творческие возможности своих проектов.

3. Обзор ControlNet

3.1. Введение в ControlNet

ControlNet представляет собой структуру для дополнения моделей диффузии изображений условными входными данными, направленную на уточнение и управление процессом синтеза изображений. Он достигает этого путем дублирования блоков нейронной сети в данной модели диффузии на два набора: один остается "заблокированным" для сохранения оригинальной функциональности, а другой становится "обучаемым", адаптируясь к предоставленным условиям. Эта двойная структура позволяет разработчикам включать различные условные входные данные, используя модели, такие как OpenPose, Tile, IP-Adapter, Canny, Depth, LineArt, MLSD, Normal Map, Scribbles, Segmentation, Shuffle и T2I Adapter, тем самым непосредственно влияя на сгенерированный результат. Через этот механизм ControlNet предлагает разработчикам мощный инструмент для управления и манипуляции процессом генерации изображений, расширяя гибкость модели диффузии и её применимость к разнообразным творческим задачам.

Предобработка и интеграция моделей

3.1.1. Конфигурация предобработки: Начало работы с ControlNet включает выбор подходящего предобработчика. Рекомендуется активировать опцию предварительного просмотра для визуального понимания влияния предобработки. После предобработки рабочий процесс переходит к использованию предобработанного изображения для дальнейших шагов обработки.

3.1.2. Соответствие моделей: Упрощая процесс выбора моделей, ControlNet обеспечивает совместимость путем сопоставления моделей с их соответствующими предобработчиками на основе общих ключевых слов, облегчая процесс интеграции.

3.2. Ключевые особенности ControlNet

Глубокое изучение моделей ControlNet

3.2.1. Набор OpenPose: Разработан для точного определения поз человека, набор OpenPose включает модели для обнаружения поз тела, выражений лица и движений рук с исключительной точностью. Различные предобработчики OpenPose адаптированы к конкретным требованиям обнаружения, от базового анализа поз до детального захвата нюансов лица и рук.

3.2.2. Модель Tile Resample: Повышая разрешение и детализацию изображений, модель Tile Resample оптимально используется вместе с инструментом масштабирования, стремясь улучшить качество изображения без ущерба для визуальной целостности.

3.2.3. Модель IP-Adapter: Облегчая инновационное использование изображений в качестве подсказок, IP-Adapter интегрирует визуальные элементы из изображений-референсов в сгенерированные результаты, объединяя возможности диффузии текста в изображение для обогащенного визуального контента.

3.2.4. Детектор краев Canny: Известный своими возможностями обнаружения краев, модель Canny подчеркивает структурную сущность изображений, позволяя творческие визуальные интерпретации, сохраняя при этом основные композиции.

3.2.5. Модели восприятия глубины: С помощью различных предобработчиков глубины ControlNet способен извлекать и применять подсказки глубины из изображений, предлагая многослойную глубинную перспективу в сгенерированных визуальных материалах.

3.2.6. Модели LineArt: Преобразуют изображения в художественные линейные рисунки с предобработчиками LineArt, удовлетворяя разнообразные художественные предпочтения от аниме до реалистичных эскизов, ControlNet охватывает спектр стилистических желаний.

3.2.7. Обработка каракулей: С предобработчиками, такими как Scribble HED, Pidinet и xDoG, ControlNet преобразует изображения в уникальное искусство каракулей, предлагая разнообразные стили для обнаружения краев и художественной интерпретации.

3.2.8. Техники сегментации: Возможности сегментации ControlNet точно классифицируют элементы изображения, позволяя точное манипулирование на основе категоризации объектов, идеально подходя для сложных построений сцен.

3.2.9. Модель Shuffle: Вводя метод инновации цветовых схем, модель Shuffle случайным образом перемешивает входные изображения для создания новых цветовых узоров, творчески изменяя оригинал, сохраняя его сущность.

3.2.10. Инновации T2I Adapter: Модели T2I Adapter, включая Color Grid и CLIP Vision Style, продвигают ControlNet в новые творческие области, смешивая и адаптируя цвета и стили для создания визуально привлекательных результатов, которые уважают цветовую схему или стилистические атрибуты оригинала.

3.2.11. MLSD (Mobile Line Segment Detection): Специализируясь на обнаружении прямых линий, MLSD незаменим для проектов, ориентированных на архитектуру и дизайн интерьеров, приоритизируя структурную ясность и точность.

3.2.12. Обработка нормальных карт: Используя данные ориентации поверхности, предобработчики Normal Map воспроизводят 3D-структуру референсных изображений, повышая реализм сгенерированного контента через детальный анализ поверхности.