Глубокое Погружение в ComfyUI ControlNet: Включая Depth, OpenPose, Canny, Lineart, Softedge, Scribble, Seg...

Updated: 5/24/2024

Привет! В этом руководстве мы погрузимся в захватывающий мир ControlNet в ComfyUI. Давайте вместе исследуем, что он может предложить и как он может оживить ваши проекты!

Мы рассмотрим:

1. Что такое ControlNet?

2. Технические Аспекты ControlNet

3. Как использовать ComfyUI ControlNet: Основные Шаги

- 3.1. Загрузка узла "Apply ControlNet" в ComfyUI

- 3.2. Входные данные узла "Apply ControlNet"

- 3.3. Выходные данные узла "Apply ControlNet"

- 3.4. Параметры для тонкой настройки "Apply ControlNet"

4. Как использовать ComfyUI ControlNet: Расширенные Функции - Ключевые кадры по временным шагам

5. Различные модели ControlNet/T2IAdaptor: Подробный Обзор

- 5.1. ControlNet Openpose

- 5.2. ControlNet Tile

- 5.3. ControlNet Canny

- 5.4. ControlNet Depth

- 5.5. ControlNet Lineart

- 5.6. ControlNet Scribbles

- 5.7. ControlNet Segmentation

- 5.8. ControlNet Shuffle

- 5.9. ControlNet Inpainting

- 5.10. ControlNet MLSD

- 5.11. ControlNet Normalmaps

- 5.12. ControlNet Soft Edge

- 5.13. ControlNet IP2P (Instruct Pix2Pix)

- 5.14. T2I Adapter

- 5.15. Другие популярные ControlNet: QRCode Monster и IP-Adapter

6. Как использовать несколько ControlNet

7. Опробуйте ComfyUI ControlNet сейчас!

🌟🌟🌟 ComfyUI Online - Испытайте Workflow ControlNet Сейчас 🌟🌟🌟

Если вы хотите исследовать workflow ControlNet, используйте следующий веб-сайт ComfyUI. Он полностью оснащен всеми необходимыми узлами и моделями, что позволяет легко творить без необходимости в ручных настройках. Начните получать практический опыт, экспериментируя с функциями ControlNet немедленно, или продолжайте с этим руководством, чтобы узнать, как эффективно использовать ControlNet.

Для более продвинутых и премиальных workflow ComfyUI посетите наш 🌟Список Workflow ComfyUI🌟

1. Что такое ControlNet?

ControlNet — это трансформирующая технология, которая значительно расширяет возможности моделей текст-к-изображению, позволяя беспрецедентный пространственный контроль в генерации изображений. Как архитектура нейронной сети, ControlNet бесшовно интегрируется с крупномасштабными предобученными моделями, такими как Stable Diffusion. Он использует обширное обучение этих моделей — построенное на миллиардах изображений — для введения пространственных условий в процесс создания изображений. Эти условия могут варьироваться от краёв и человеческих поз до карт глубины и сегментации, позволяя пользователям направлять генерацию изображений способами, ранее недоступными с помощью одних только текстовых подсказок.

2. Технические Аспекты ControlNet

Гениальность ControlNet заключается в его уникальной методологии. Сначала он фиксирует параметры оригинальной модели, гарантируя, что основное обучение остаётся неизменным. Затем ControlNet вводит клон слоёв кодирования модели для обучения, используя "нулевые свёртки". Эти специально спроектированные свёрточные слои начинают с нулевыми весами, аккуратно интегрируя новые пространственные условия. Этот подход предотвращает вмешательство какого-либо разрушительного шума, сохраняя оригинальное мастерство модели, при этом инициируя новые траектории обучения.

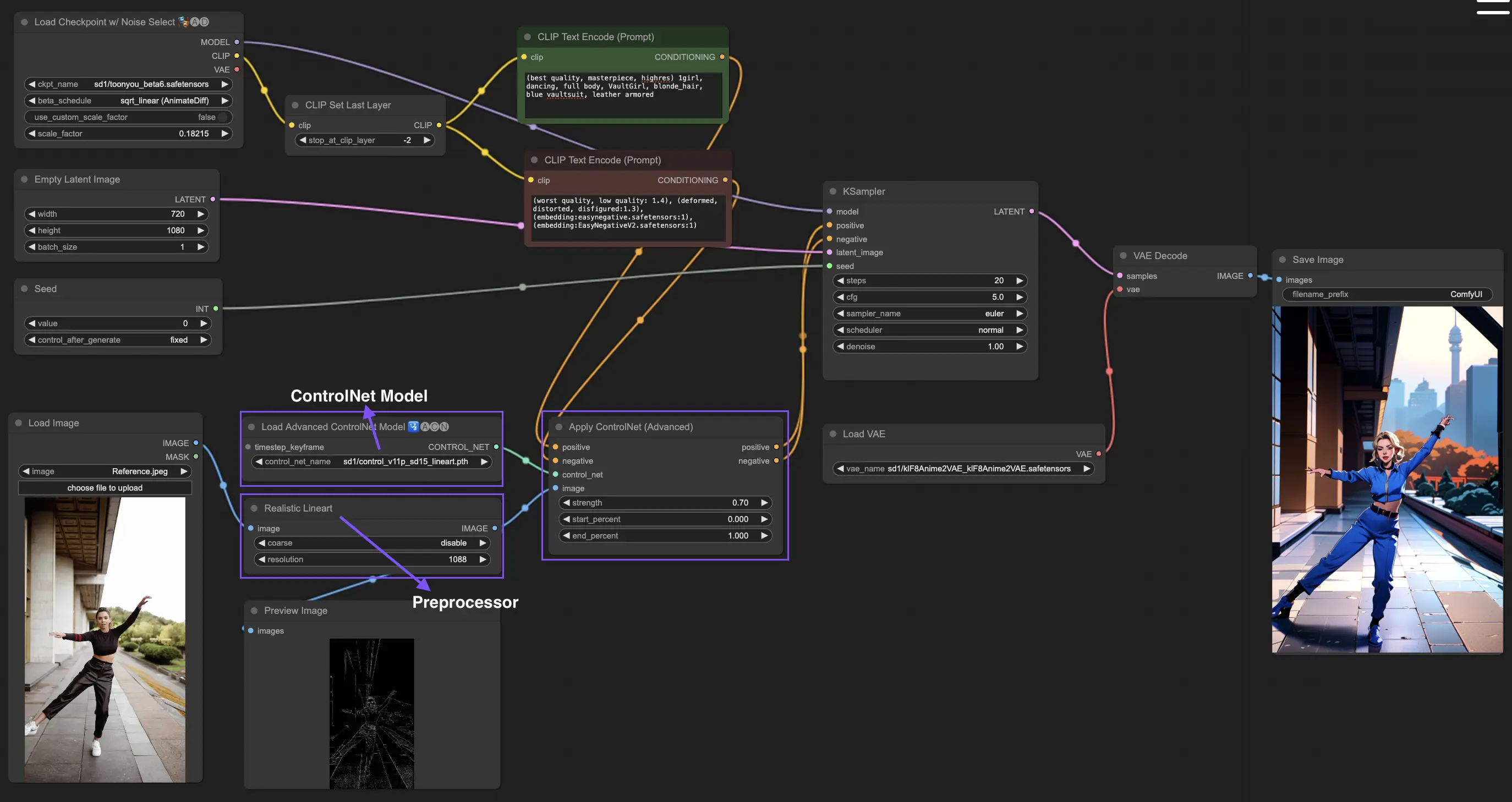

3. Как использовать ComfyUI ControlNet: Основные Шаги

Традиционно модели стабильной диффузии используют текстовые подсказки в качестве механизма кондиционирования для направления генерации изображений, выравнивая выходные данные с конкретикой текстовой подсказки. ControlNet вводит дополнительную форму кондиционирования в этот процесс, увеличивая способность точнее управлять сгенерированными изображениями согласно как текстовым, так и визуальным вводам.

3.1. Загрузка узла "Apply ControlNet" в ComfyUI

Этот шаг интегрирует ControlNet в ваш workflow ComfyUI, позволяя применять дополнительное кондиционирование к процессу генерации изображений. Он закладывает основу для применения визуальных подсказок наряду с текстовыми.

3.2. Входные данные узла "Apply ControlNet"

Положительное и Отрицательное Кондиционирование: Эти входные данные важны для определения желаемых результатов и аспектов, которых следует избегать в сгенерированном изображении. Они должны быть связаны с "Положительной подсказкой" и "Отрицательной подсказкой" соответственно, выравниваясь с текстовой частью процесса кондиционирования.

Модель ControlNet: Этот вход должен быть подключен к выходу узла "Load ControlNet Model". Этот шаг важен для выбора и включения либо модели ControlNet, либо модели T2IAdaptor в ваш workflow, тем самым гарантируя, что модель диффузии получает пользу от конкретных указаний, предоставленных вашей выбранной моделью. Каждая модель, будь то ControlNet или T2IAdaptor, тщательно обучена влиять на процесс генерации изображений в соответствии с определёнными типами данных или стилистическими предпочтениями. Учитывая, что функциональность многих моделей T2IAdaptor тесно связана с моделями ControlNet, наше внимание будет в основном сосредоточено на моделях ControlNet в нашем последующем обсуждении. Однако для полноты картины мы также выделим некоторые из более популярных моделей T2IAdaptor.

Предобработчик: Вход "image" должен быть подключен к узлу "ControlNet Preprocessor", который важен для адаптации вашего изображения к конкретным требованиям модели ControlNet, которую вы используете. Крайне важно использовать правильный предобработчик подходящий для вашей выбранной модели ControlNet. Этот шаг гарантирует, что исходное изображение претерпевает необходимые модификации — такие как корректировки формата, размера, цвета или применение специфических фильтров — чтобы оптимизировать его для указаний ControlNet. После этапа предобработки исходное изображение заменяется модифицированной версией, которую затем использует ControlNet. Этот процесс гарантирует, что ваши входные изображения точно подготовлены для процесса ControlNet.

3.3. Выходные данные узла "Apply ControlNet"

Узел "Apply ControlNet" генерирует два важных выхода: Положительное и Отрицательное Кондиционирование. Эти выходные данные, наполненные нюансами эффектов ControlNet и визуальных указаний, играют ключевую роль в направлении поведения модели диффузии в ComfyUI. После этого вам предоставляется выбор: перейти к KSampler для этапа семплирования, чтобы дополнительно улучшить сгенерированное изображение, или, для тех, кто стремится к ещё более высокому уровню детализации и настройки в своём творении, продолжить накладывать дополнительные ControlNet. Эта продвинутая техника интеграции большего количества ControlNet позволяет более детально манипулировать атрибутами изображения, предлагая расширенный набор инструментов для творцов, стремящихся достичь непревзойдённой точности и контроля в своих визуальных результатах.

3.4. Параметры для тонкой настройки "Apply ControlNet"

strength: Этот параметр определяет интенсивность воздействия ControlNet на сгенерированное изображение в ComfyUI. Значение 1.0 означает полную силу, что означает, что указания ControlNet будут иметь максимальное влияние на выход модели диффузии. Напротив, значение 0.0 указывает на отсутствие влияния, фактически отключая эффект ControlNet на процесс генерации изображения.

start_percent: Этот параметр указывает начальную точку, в процентах от процесса диффузии, с которой ControlNet начинает влиять на генерацию. Например, установка start percent на 20% означает, что указания ControlNet начнут влиять на генерацию изображения с 20% отметки процесса диффузии.

end_percent: Аналогично "Start Percent", параметр "End Percent" определяет точку, в которой влияние ControlNet прекращается. Например, end percent на 80% будет означать, что указания ControlNet прекращают влиять на генерацию изображения на 80% завершения процесса диффузии, оставляя финальные фазы без воздействия.

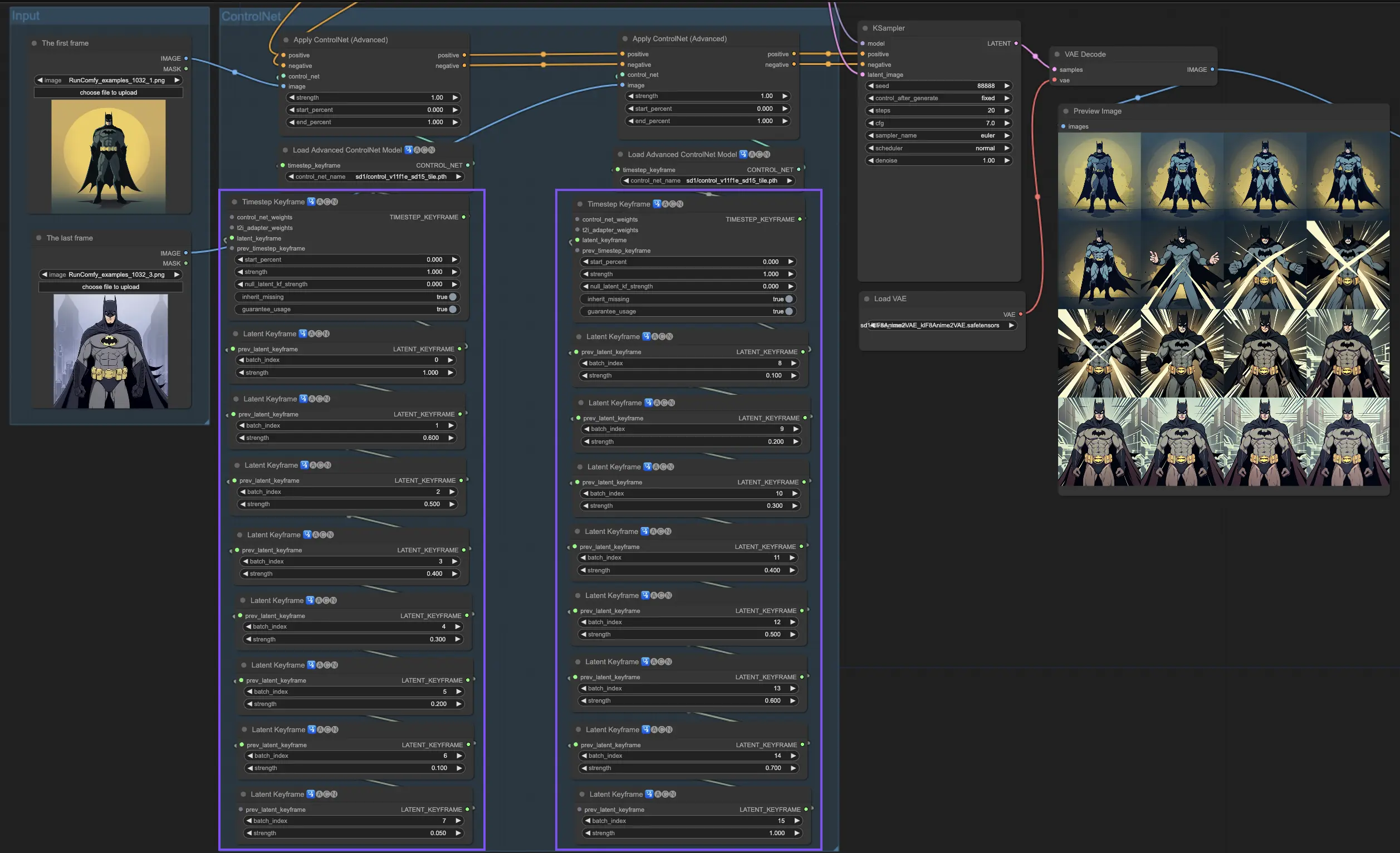

4. Как использовать ComfyUI ControlNet: Расширенные Функции - Ключевые кадры по временным шагам

Ключевые кадры по временным шагам в ControlNet предлагают изысканный контроль над поведением AI-сгенерированного контента, особенно когда важны временные и прогрессивные аспекты, такие как в анимациях или развивающихся визуализациях. Вот подробный разбор ключевых параметров, чтобы помочь вам эффективно и интуитивно их использовать:

prev_timestep_kf: Подумайте о prev_timestep_kf как о соединении с ключевым кадром, который идёт перед ним в последовательности. Соединяя ключевые кадры, вы создаёте плавный переход или раскадровку, направляющую AI через процесс генерации шаг за шагом, гарантируя, что каждая фаза логически перетекает в следующую.

cn_weights: cn_weights полезны для тонкой настройки выходного результата, регулируя конкретные характеристики внутри ControlNet на различных этапах процесса генерации.

latent_keyframe: latent_keyframe позволяет вам регулировать, насколько сильно каждая часть AI-модели влияет на окончательный результат во время определённой фазы процесса генерации. Например, если вы генерируете изображение, где передний план должен становиться более детализированным по мере развития процесса, вы можете увеличить силу для аспектов (латентов) модели, ответственных за детали переднего плана, в более поздних ключевых кадрах. Напротив, если определённые особенности должны со временем уйти на задний план, вы можете уменьшить их силу в последующих ключевых кадрах. Этот уровень контроля особенно полезен при создании динамичных, развивающихся визуализаций или в проектах, где важна точная синхронизация и прогрессия.

mask_optional: Используйте маски внимания как прожекторы, сосредотачивая влияние ControlNet на конкретные области вашего изображения. Будь то выделение персонажа в сцене или акцентирование элемента фона, эти маски могут применяться равномерно или варьироваться по интенсивности, направляя внимание AI точно туда, куда вы хотите.

start_percent: start_percent отмечает сигнал для начала действия вашего ключевого кадра, измеряемого в процентах от общего процесса генерации. Установка этого параметра подобна расписанию выхода актёра на сцену, гарантируя, что он появится в нужный момент представления.

strength: strength предоставляет высокоуровневый контроль над общим влиянием ControlNet.

null_latent_kf_strength: Для любых актёров (латентов), которых вы не указали явно в этой сцене (ключевом кадре), null_latent_kf_strength действует как инструкция по умолчанию, указывая им, как действовать на заднем плане. Это гарантирует, что ни одна часть генерации не остаётся без руководства, поддерживая целостный выход даже в областях, которые вы не адресовали специально.

inherit_missing: Активация inherit_missing позволяет вашему текущему ключевому кадру перенимать любые неуказанные настройки от своего предшественника, как младший брат, наследующий одежду. Это полезный ярлык, обеспечивающий непрерывность и согласованность без необходимости повторять инструкции.

guarantee_usage: guarantee_usage — это ваша гарантия, что, независимо от всего, текущий ключевой кадр будет иметь своё место в процессе, даже если это будет краткий момент. Это гарантирует, что каждый ключевой кадр, который вы настроили, имеет влияние, уважая ваше детальное планирование в руководстве творческим процессом AI.

Ключевые кадры по временным шагам предлагают точность, необходимую для тщательного руководства творческим процессом AI, позволяя вам создавать нарратив или визуальное путешествие именно так, как вы его себе представляете. Они служат мощным инструментом для оркестровки эволюции визуализаций, особенно в анимации, от начальной сцены до заключительной, полностью соответствуя вашим художественным целям.

5. Различные модели ControlNet/T2IAdaptor: Подробный Обзор

Учитывая, что функциональность многих моделей T2IAdaptor тесно связана с моделями ControlNet, наше внимание будет в основном сосредоточено на моделях ControlNet в нашем последующем обсуждении. Однако для полноты картины мы также выделим некоторые из более популярных моделей T2IAdaptor.

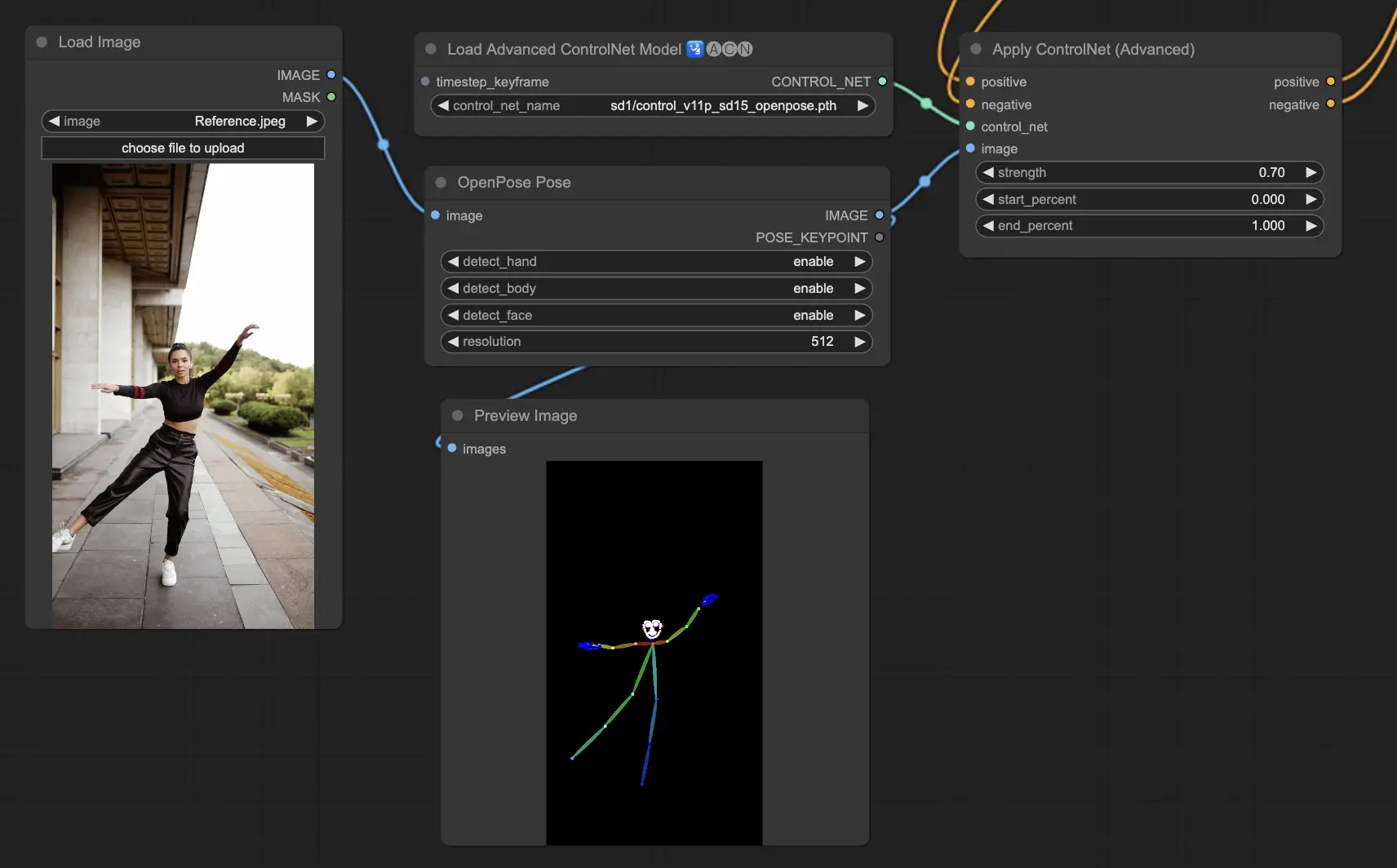

5.1. ComfyUI ControlNet Openpose

- Openpose (=Openpose body): Основная модель в ControlNet, которая определяет основные ключевые точки тела, такие как глаза, нос, шея, плечи, локти, запястья, колени и лодыжки. Идеально подходит для базового воспроизведения поз человека.

- Openpose_face: Расширяет модель OpenPose, добавляя обнаружение ключевых точек лица, предлагая более детализированный анализ выражений лиц и ориентации. Эта модель ControlNet необходима для проектов, сосредоточенных на выражениях лиц.

- Openpose_hand: Дополняет модель OpenPose возможностью захвата сложных деталей рук и пальцев, фокусируясь на детализированных жестах и положениях рук. Это дополнение увеличивает универсальность OpenPose в рамках ControlNet.

- Openpose_faceonly: Специализированная модель только для лицевых деталей, исключая ключевые точки тела, чтобы сосредоточиться на захвате выражений и ориентации лица. Эта модель в ControlNet сосредоточена исключительно на лицевых характеристиках.

- Openpose_full: Комплексное объединение моделей OpenPose, OpenPose_face и OpenPose_hand, предлагающее полное обнаружение всего тела, лица и рук для полного воспроизведения поз человека в рамках ControlNet.

- DW_Openpose_full: Улучшенная версия модели OpenPose_full, включающая дополнительные усовершенствования для ещё более детализированного и точного обнаружения поз. Эта версия представляет вершину точности обнаружения поз в рамках ControlNet.

Предобработчик: Openpose или DWpose

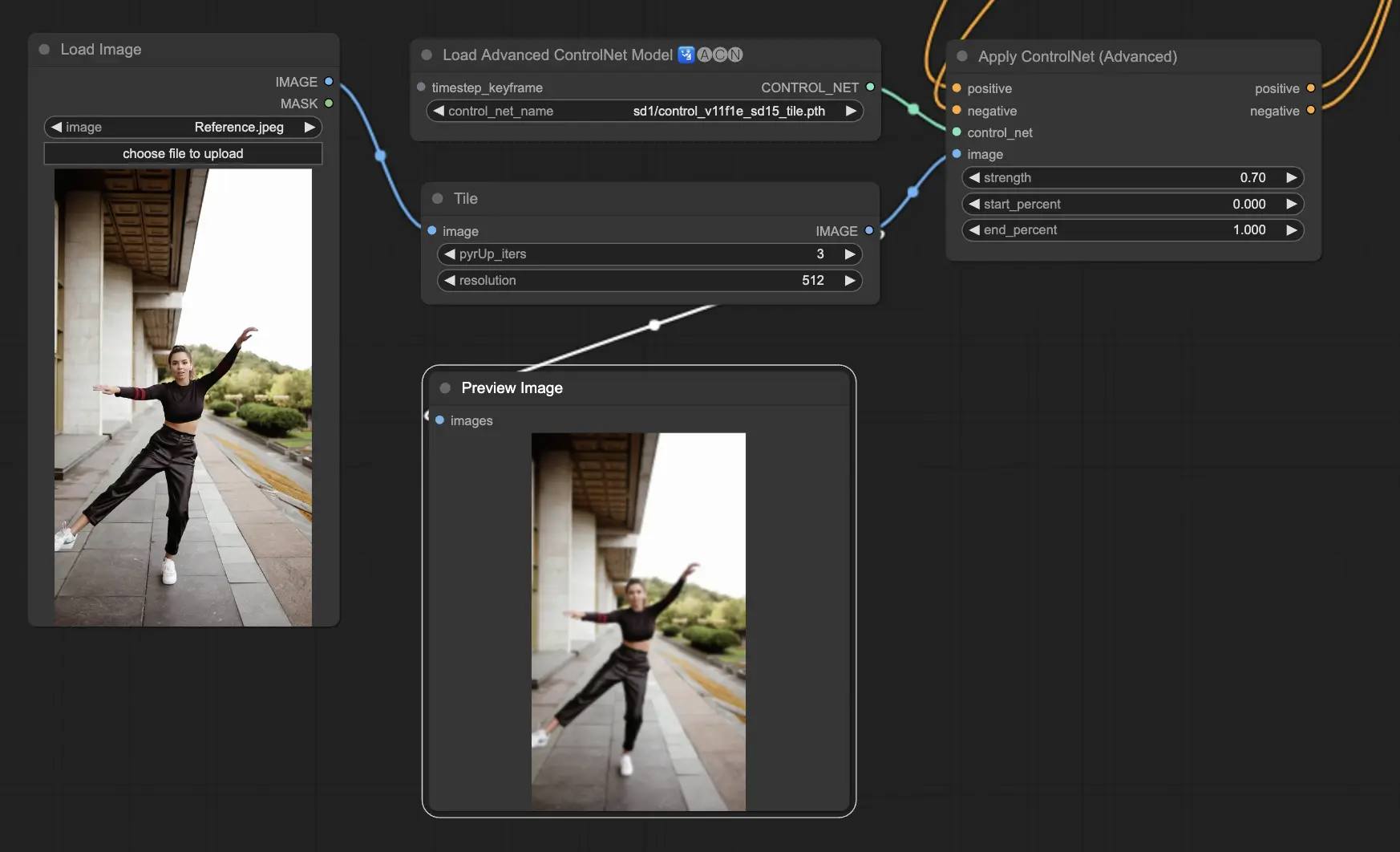

5.2. ComfyUI ControlNet Tile

Модель Tile Resample используется для улучшения деталей в изображениях. Она особенно полезна в сочетании с увеличителем для улучшения разрешения изображения при добавлении более тонких деталей, часто используется для уточнения и обогащения текстур и элементов в изображении.

Предобработчик: Tile

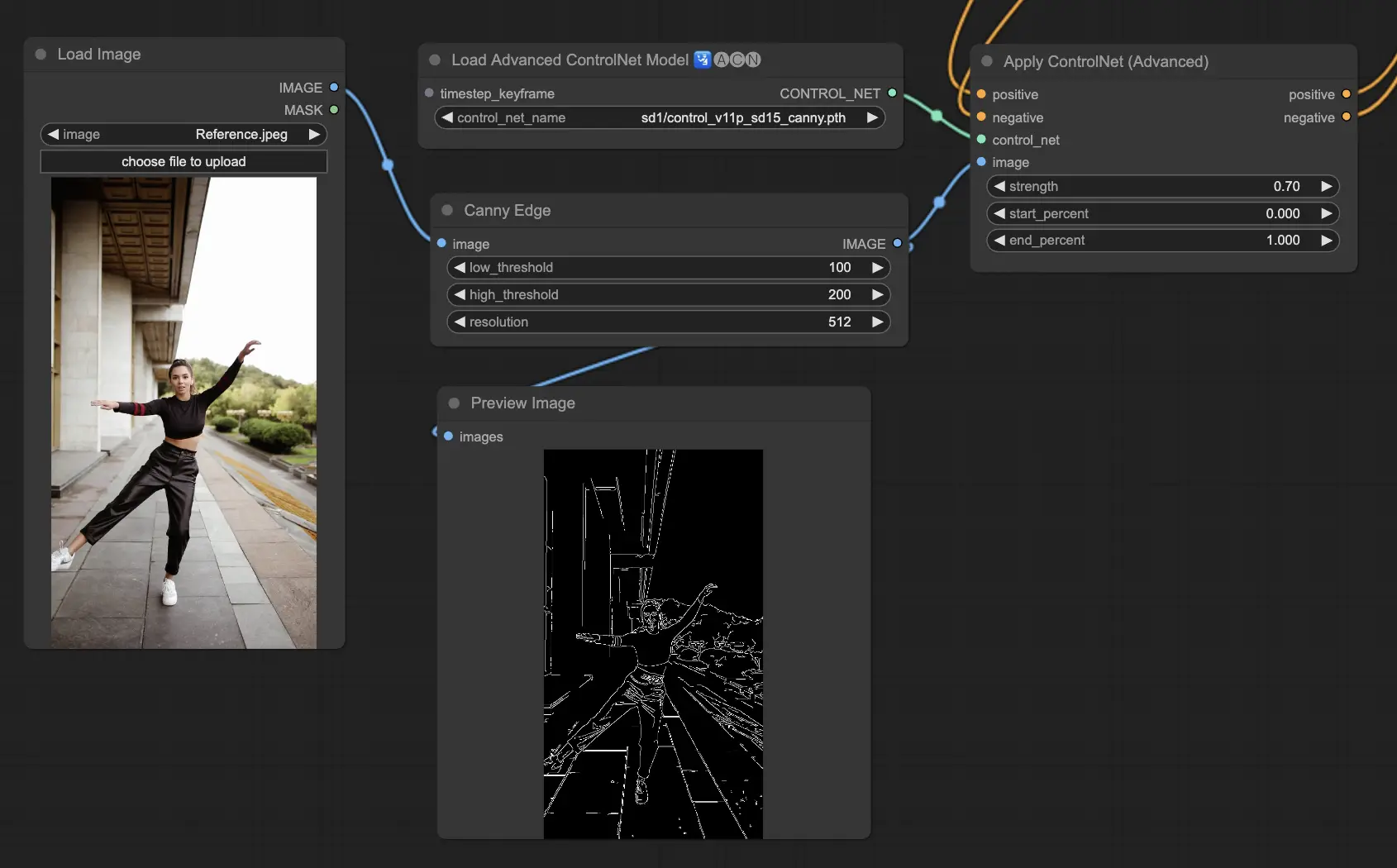

5.3. ComfyUI ControlNet Canny

Модель Canny применяет алгоритм обнаружения краев Canny, многоэтапный процесс для обнаружения широкого спектра краев в изображениях. Эта модель полезна для сохранения структурных аспектов изображения при упрощении его визуального состава, что делает полезной для стилизованного искусства или предварительной обработки перед дальнейшей манипуляцией изображением.

Предобработчики: Canny

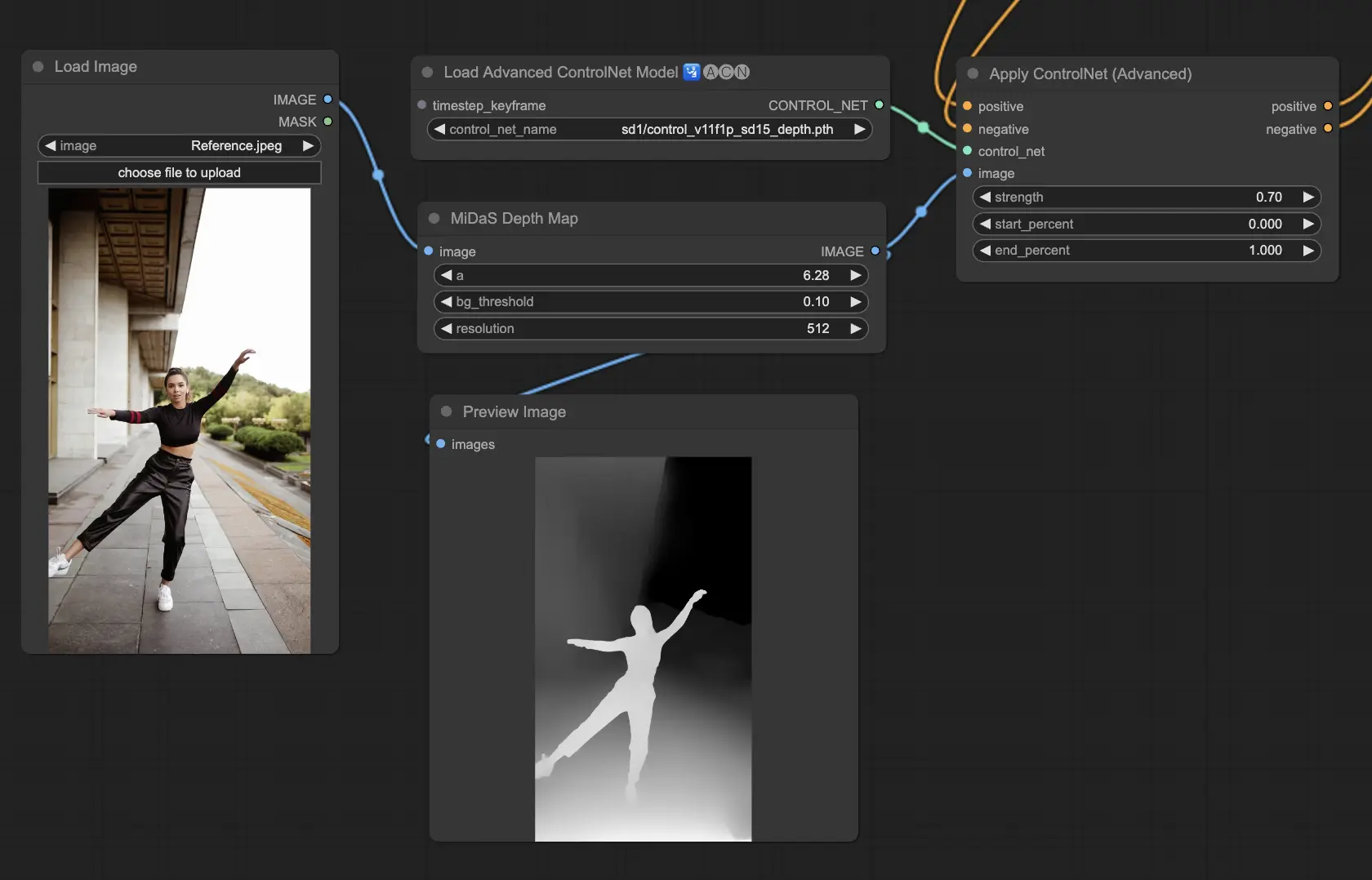

5.4. ComfyUI ControlNet Depth

Модели глубины интерпретируют информацию о глубине из 2D изображения, переводя воспринимаемое расстояние в градации серого на карте глубины. Каждая версия предлагает разный баланс между захватом деталей и акцентом на фоне:

- Depth Midas: Предоставляет классическую оценку глубины, балансируя между деталями и фоном.

- Depth Leres: Сосредотачивается на улучшении деталей с тенденцией включать больше элементов фона.

- Depth Leres++: Предлагает продвинутый уровень детализации для информации о глубине, идеально подходит для сложных сцен.

- Zoe: Находит баланс между моделями Midas и Leres по уровню детализации.

- Depth Anything: Новая, улучшенная модель для оценки глубины, разработанная для широкого спектра сцен.

- Depth Hand Refiner: Специально разработана для улучшения деталей рук на картах глубины, полезна для сцен, где критично позиционирование рук.

Предобработчики: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Эта модель очень устойчива и может работать с реальными картами глубины из рендер-движков.

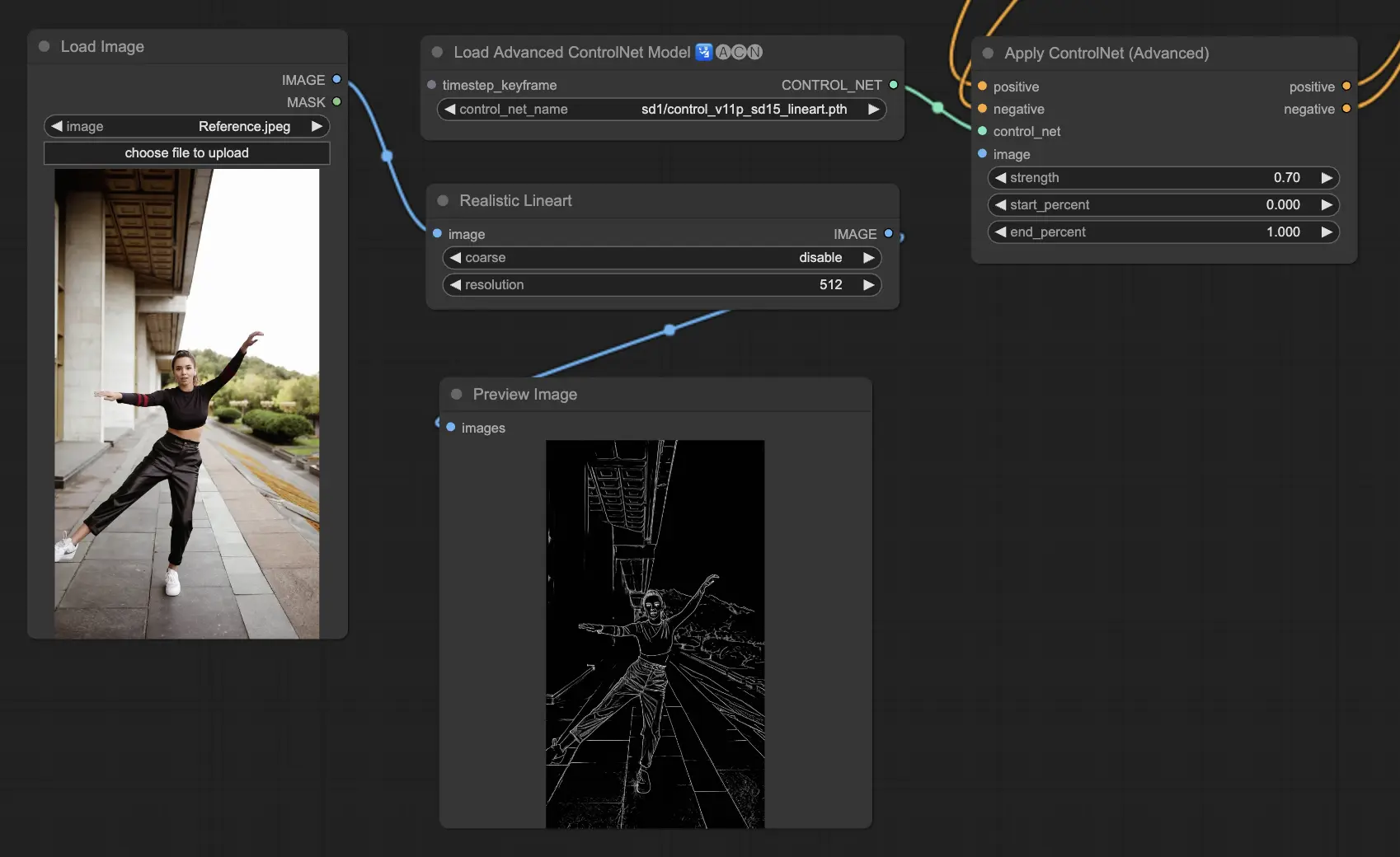

5.5. ComfyUI ControlNet Lineart

Модели Lineart преобразуют изображения в стилизованные линейные рисунки, полезные для художественных интерпретаций или как основа для дальнейшей творческой работы:

- Lineart: Стандартная модель, преобразующая изображения в стилизованные линейные рисунки, предлагая универсальную основу для различных художественных или творческих проектов.

- Lineart anime: Сосредоточена на создании линейных рисунков в стиле аниме, характеризующихся чистыми и точными линиями, что делает её подходящей для проектов, стремящихся к аниме-эстетике.

- Lineart realistic: Создаёт линейные рисунки с более реалистичным оттенком, захватывая суть объекта с большей детализацией, идеально подходит для проектов, требующих жизненного представления.

- Lineart coarse: Предоставляет более выраженный линейный рисунок с более тяжёлыми, смелыми линиями, создавая яркий эффект, который выделяется, особенно подходящий для смелых художественных выражений.

Предобработчик может генерировать детализированные или грубые линейные рисунки из изображений (Lineart и Lineart_Coarse)

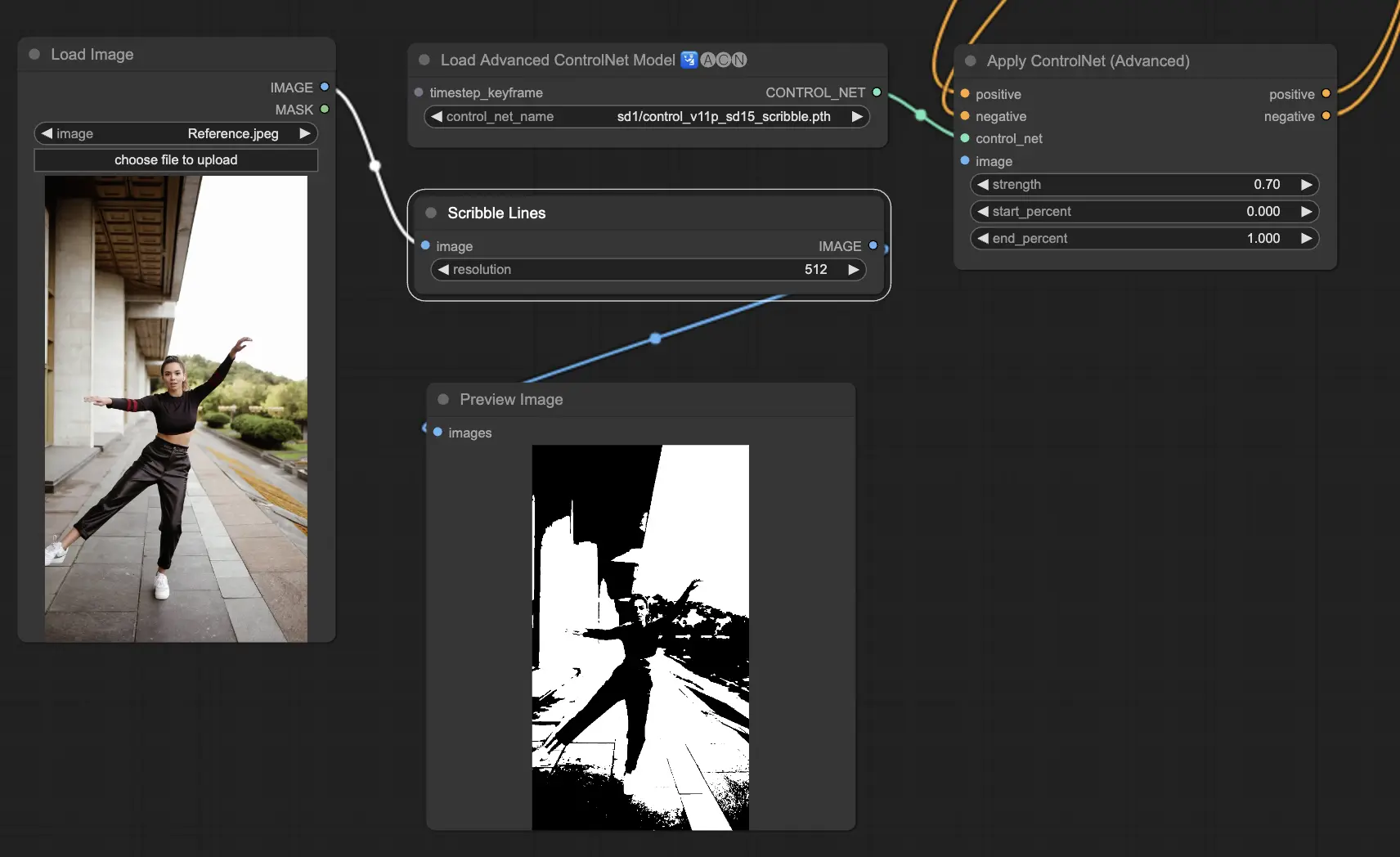

5.6. ComfyUI ControlNet Scribbles

Модели Scribble предназначены для преобразования изображений в вид, напоминающий каракули, имитируя вид нарисованных от руки эскизов. Они особенно полезны для художественного рестайлинга или как предварительный шаг в большем рабочем процессе дизайна:

- Scribble: Разработана для преобразования изображений в детализированные произведения искусства, имитирующие нарисованные от руки каракули или эскизы.

- Scribble HED: Использует Holistically-Nested Edge Detection (HED) для создания контуров, напоминающих нарисованные от руки эскизы. Рекомендуется для перекрашивания и рестайлинга изображений, добавляя уникальный художественный акцент к произведению.

- Scribble Pidinet: Сосредотачивается на обнаружении пиксельных различий для создания более чистых линий с уменьшенной детализацией, что делает её идеальной для более чётких, более абстрактных представлений. Scribble Pidinet идеально подходит для тех, кто ищет чёткие кривые и прямые линии, предлагая полированный вид при сохранении основных деталей

- Scribble xdog: Применяет метод Extended Difference of Gaussian (xDoG) для обнаружения краёв. Это позволяет настраивать пороговые значения для тонкой настройки эффекта каракулей, делая возможным контроль уровня детализации в вашем произведении. xDoG универсален, позволяя пользователям достичь идеального баланса в своих художественных творениях

Предобработчики: Scribble, Scribble_HED, Scribble_PIDI, и Scribble_XDOG

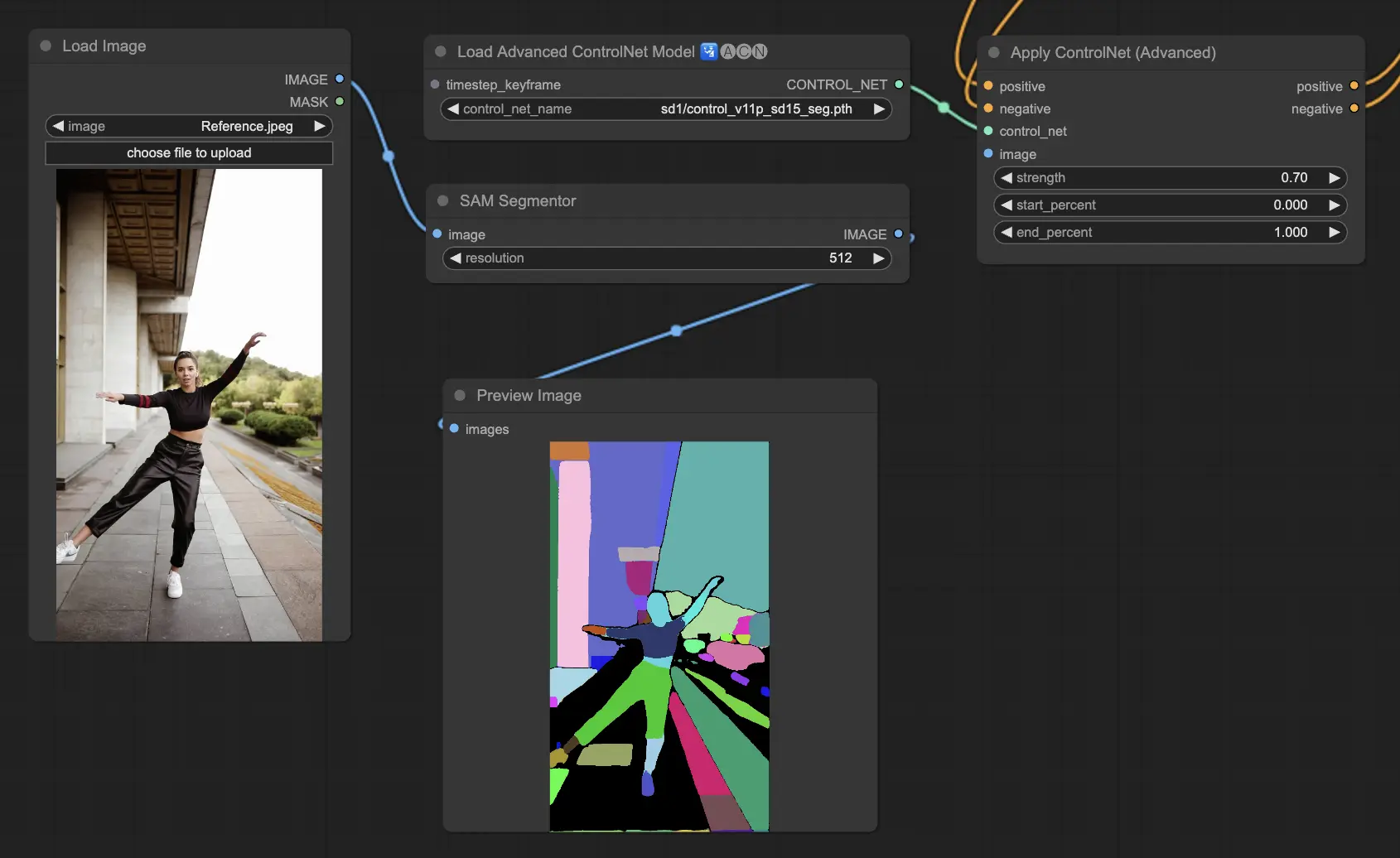

5.7. ComfyUI ControlNet Segmentation

Модели сегментации разделяют пиксели изображения на отдельные классы объектов, каждый из которых представлен определённым цветом. Это незаменимо для идентификации и манипулирования отдельными элементами изображения, такими как разделение переднего плана от фона или различение объектов для детального редактирования.

- Seg: Разработана для различения объектов в изображении по цвету, эффективно переводя эти различия в отдельные элементы на выходе. Например, она может разделять мебель в планировке комнаты, что особенно ценно для проектов, требующих точного контроля над композицией и редактированием изображения

- ufade20k: Использует модель сегментации UniFormer, обученную на наборе данных ADE20K, способную различать широкий спектр типов объектов с высокой точностью.

- ofade20k: Применяет модель сегментации OneFormer, также обученную на ADE20K, предлагая альтернативный подход к различению объектов с её уникальными возможностями сегментации.

- ofcoco: Использует модель сегментации OneFormer, обученную на наборе данных COCO, адаптированную для изображений с объектами, классифицированными в рамках параметров набора данных COCO, что облегчает точную идентификацию и манипуляцию объектами.

Допустимые предобработчики: Sam, Seg_OFADE20K (Oneformer ADE20K), Seg_UFADE20K (Uniformer ADE20K), Seg_OFCOCO (Oneformer COCO), или вручную созданные маски.

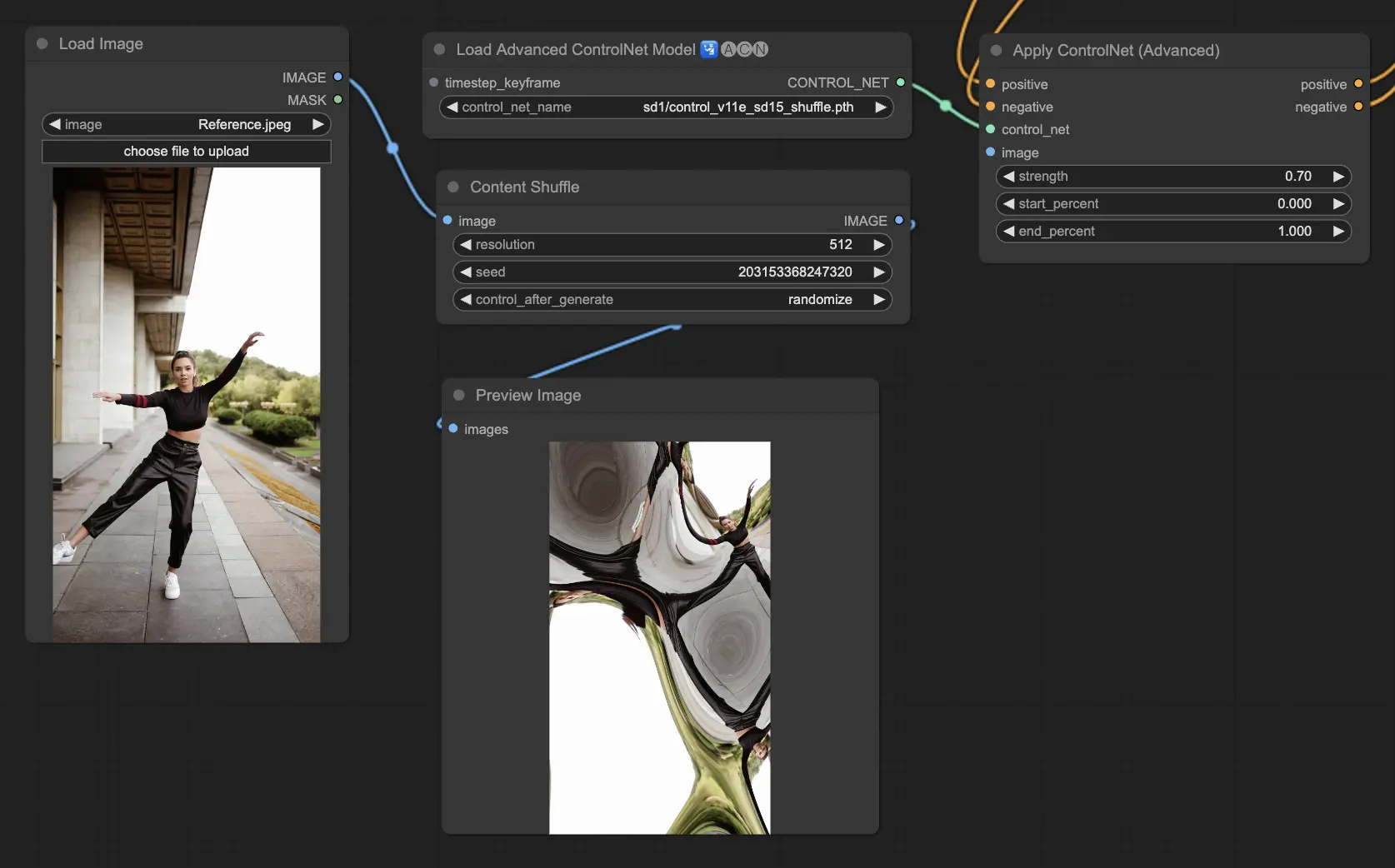

5.8. ComfyUI ControlNet Shuffle

Модель Shuffle вводит новый подход путём рандомизации атрибутов входного изображения, таких как цветовые схемы или текстуры, не изменяя композицию. Эта модель особенно эффективна для творческих исследований и генерации вариаций изображения с сохранённой структурной целостностью, но изменённой визуальной эстетикой. Её рандомизированная природа означает, что каждый выход уникален, на который влияет значение seed, использованное в процессе генерации.

Предобработчики: Shuffle

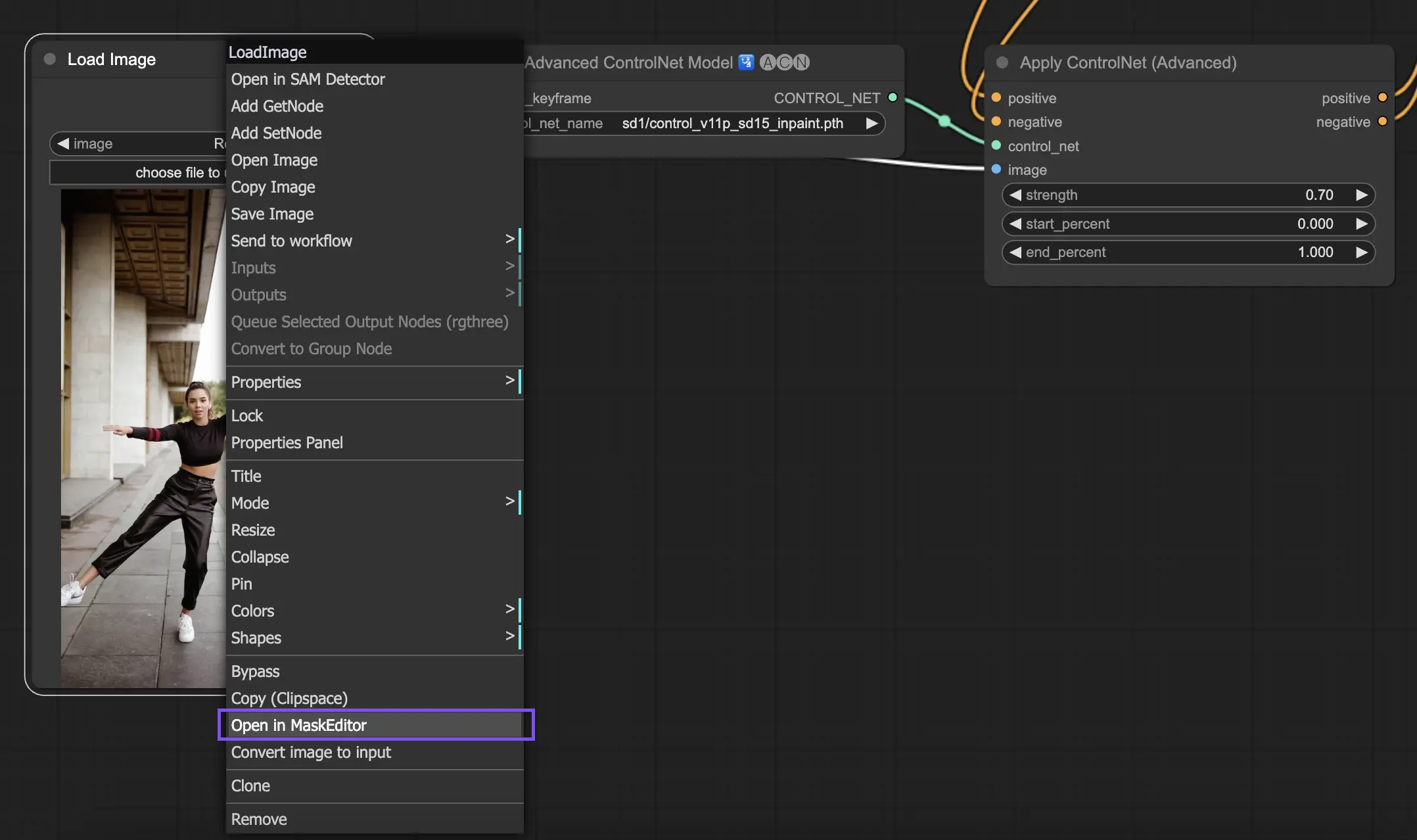

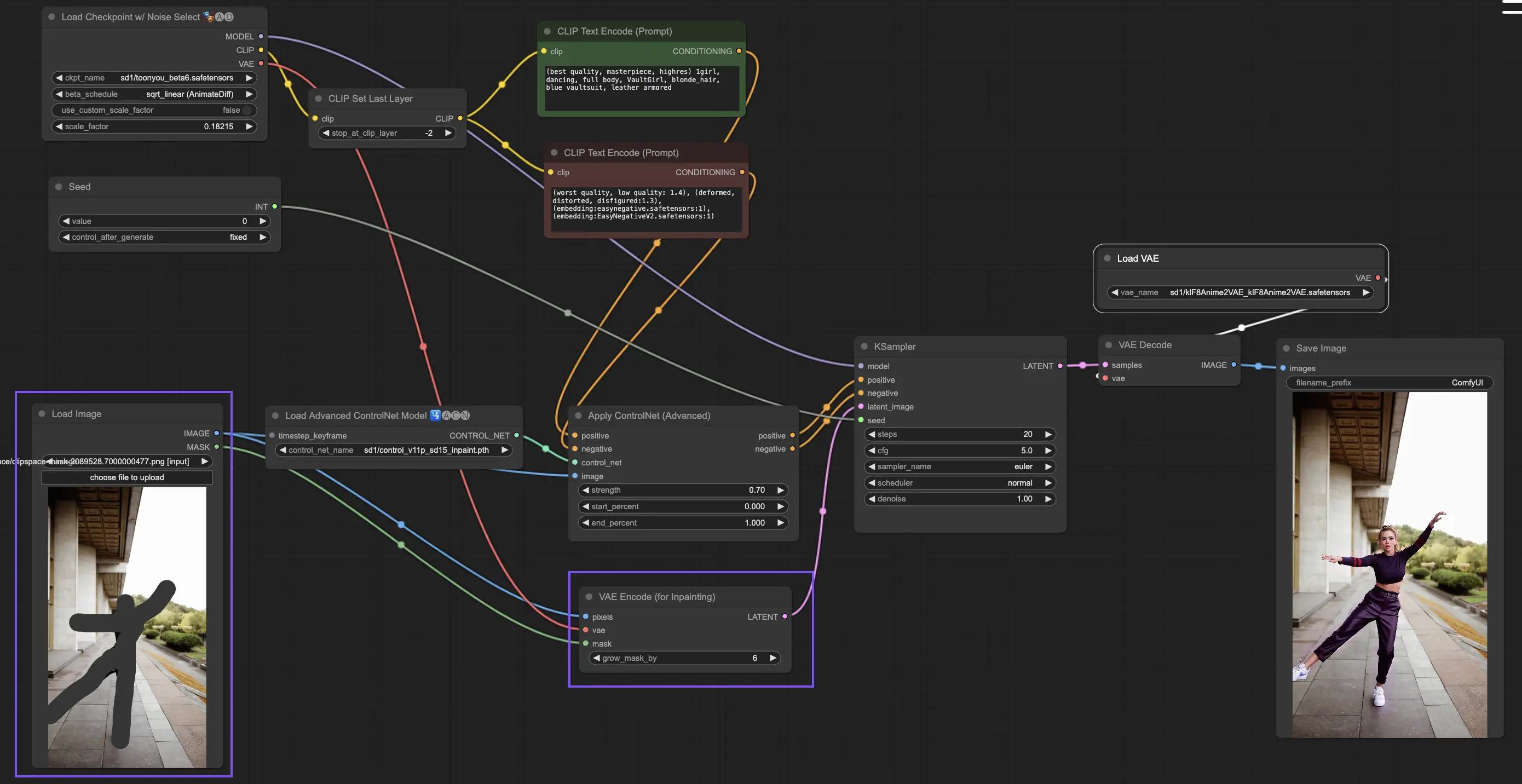

5.9. ComfyUI ControlNet Inpainting

Модели Inpainting в рамках ControlNet позволяют для точного редактирования в конкретных областях изображения, поддерживая общую согласованность при введении значительных вариаций или исправлений.

Чтобы использовать ControlNet Inpainting, начните с изоляции области, которую вы хотите регенерировать, с помощью маскирования. Это можно сделать, щёлкнув правой кнопкой мыши по нужному изображению и выбрав "Open in MaskEditor" для модификаций.

В отличие от других реализаций в рамках ControlNet, Inpainting обходит необходимость в предобработчике из-за прямых модификаций, применяемых к изображению. Однако важно переслать отредактированное изображение в латентное пространство через KSampler. Это гарантирует, что модель диффузии сосредоточится исключительно на регенерации маскированной области, сохраняя целостность немаскированных областей.

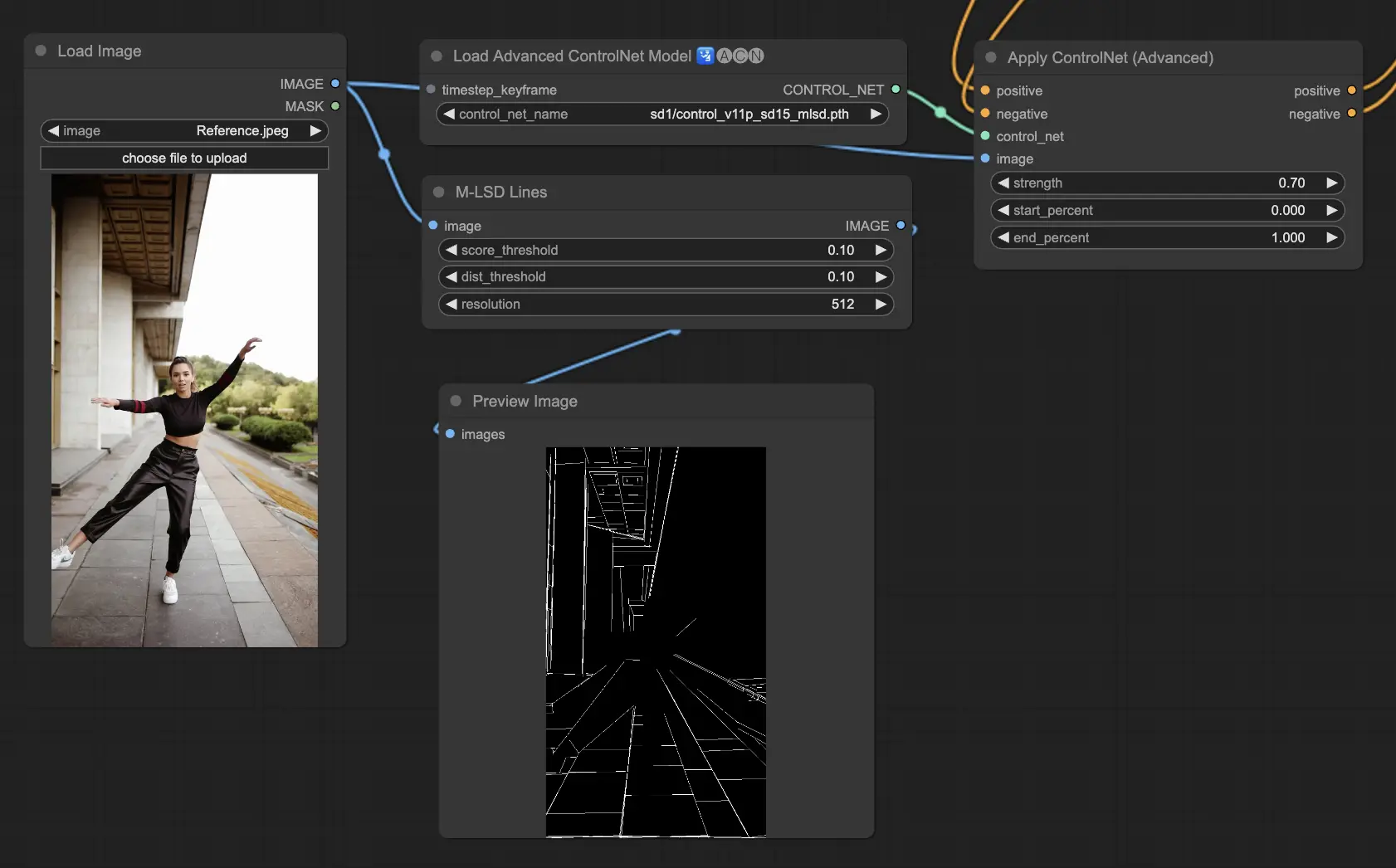

5.10. ComfyUI ControlNet MLSD

M-LSD (Mobile Line Segment Detection) сосредоточен на обнаружении прямых линий, идеально подходит для изображений с ярко выраженными архитектурными элементами, интерьерами и геометрическими формами. Он упрощает сцены до их структурной сути, облегчая творческие проекты, включающие искусственные окружения.

Предобработчики: MLSD.

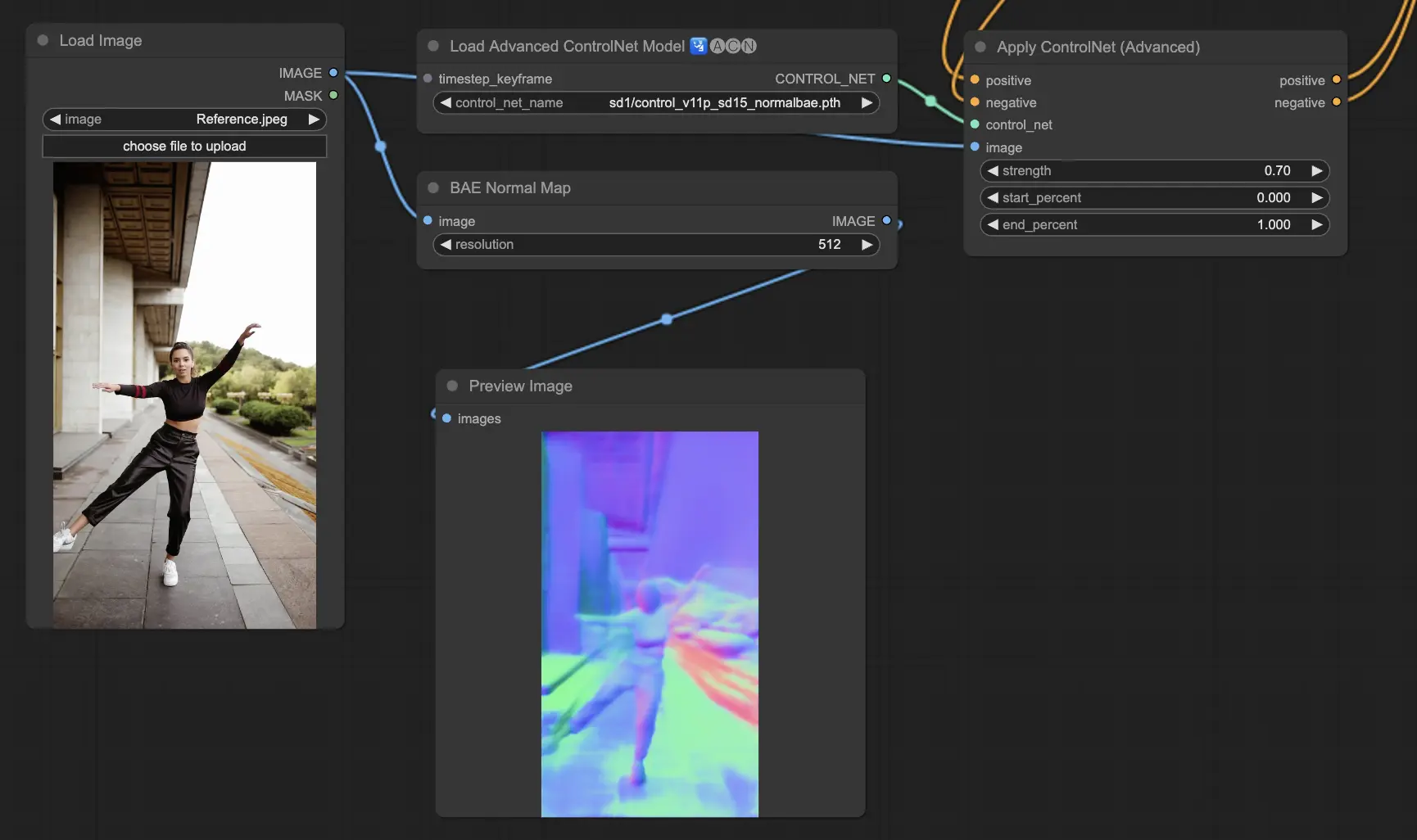

5.11. ComfyUI ControlNet Normalmaps

Normalmaps позволяет симулировать сложные эффекты освещения и текстуры путём моделирования ориентации поверхностей в визуальной сцене, а не полагаясь только на цветовые данные. Это критично для задач 3D моделирования и симуляции.

- Normal Bae: Этот метод генерирует карты нормалей, используя подход неопределённости нормалей. Он предоставляет инновационную технику для отображения ориентации поверхностей, улучшая симуляцию эффектов освещения, основанных на физической геометрии моделированной сцены, а не на традиционных методах, основанных на цвете.

- Normal Midas: Используя карты глубины, созданные моделью Midas, Normal Midas точно оценивает карты нормалей. Этот подход позволяет для нюансированной симуляции текстур поверхностей и освещения, основанных на информации о глубине сцены, тем самым обогащая визуальную сложность 3D моделей.

Предобработчики: Normal BAE, Normal Midas

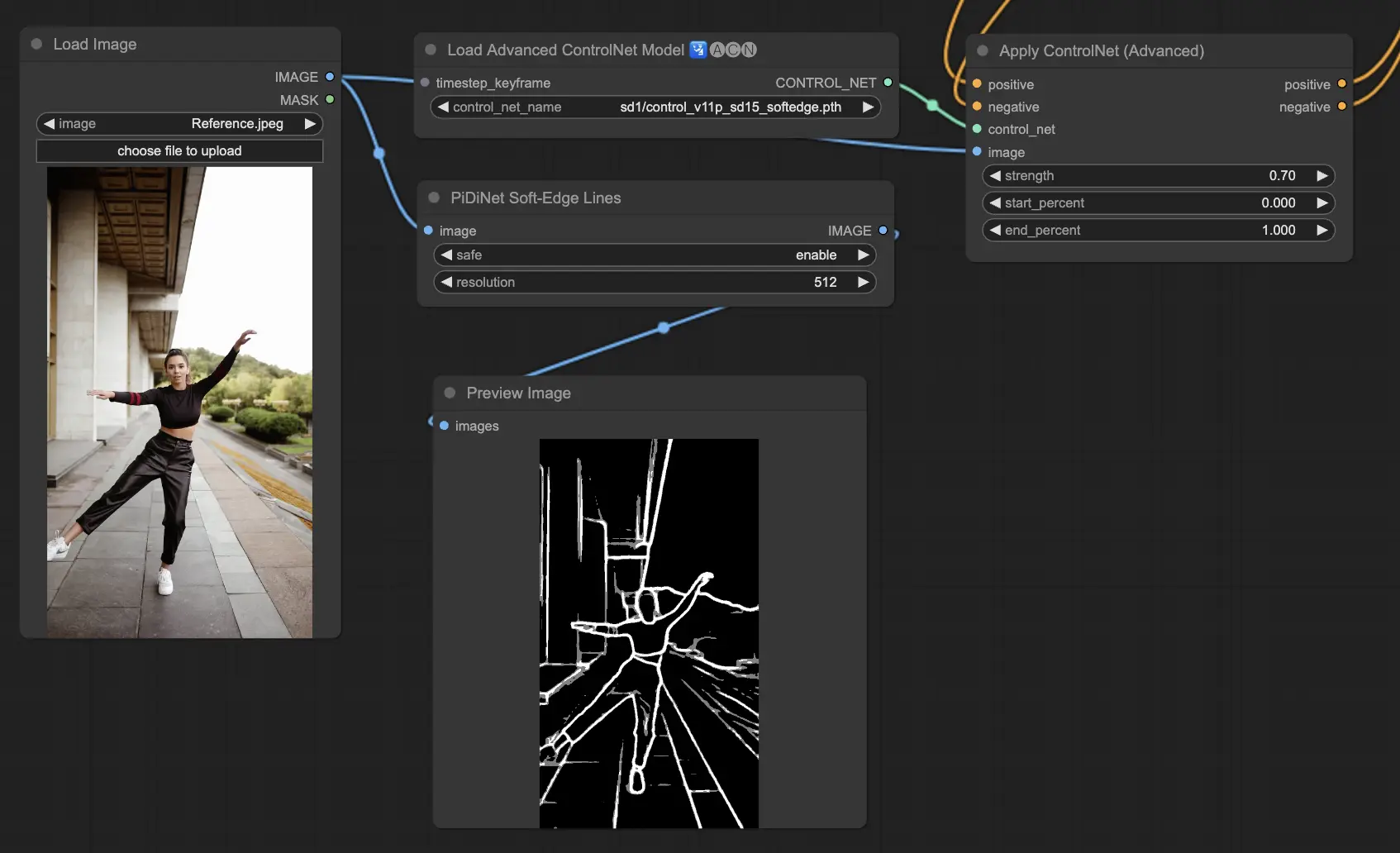

5.12. ComfyUI ControlNet Soft Edge

ControlNet Soft Edge разработан для создания изображений с более мягкими краями, фокусируясь на контроле деталей и естественном внешнем виде. Он использует передовые техники нейронных сетей для точной манипуляции изображениями, предлагая большую творческую свободу и возможности бесшовного смешивания

Устойчивость: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Максимальное качество результата: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Учитывая компромисс, мы рекомендуем использовать SoftEdge_PIDI по умолчанию. В большинстве случаев он работает очень хорошо.

Предобработчики: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

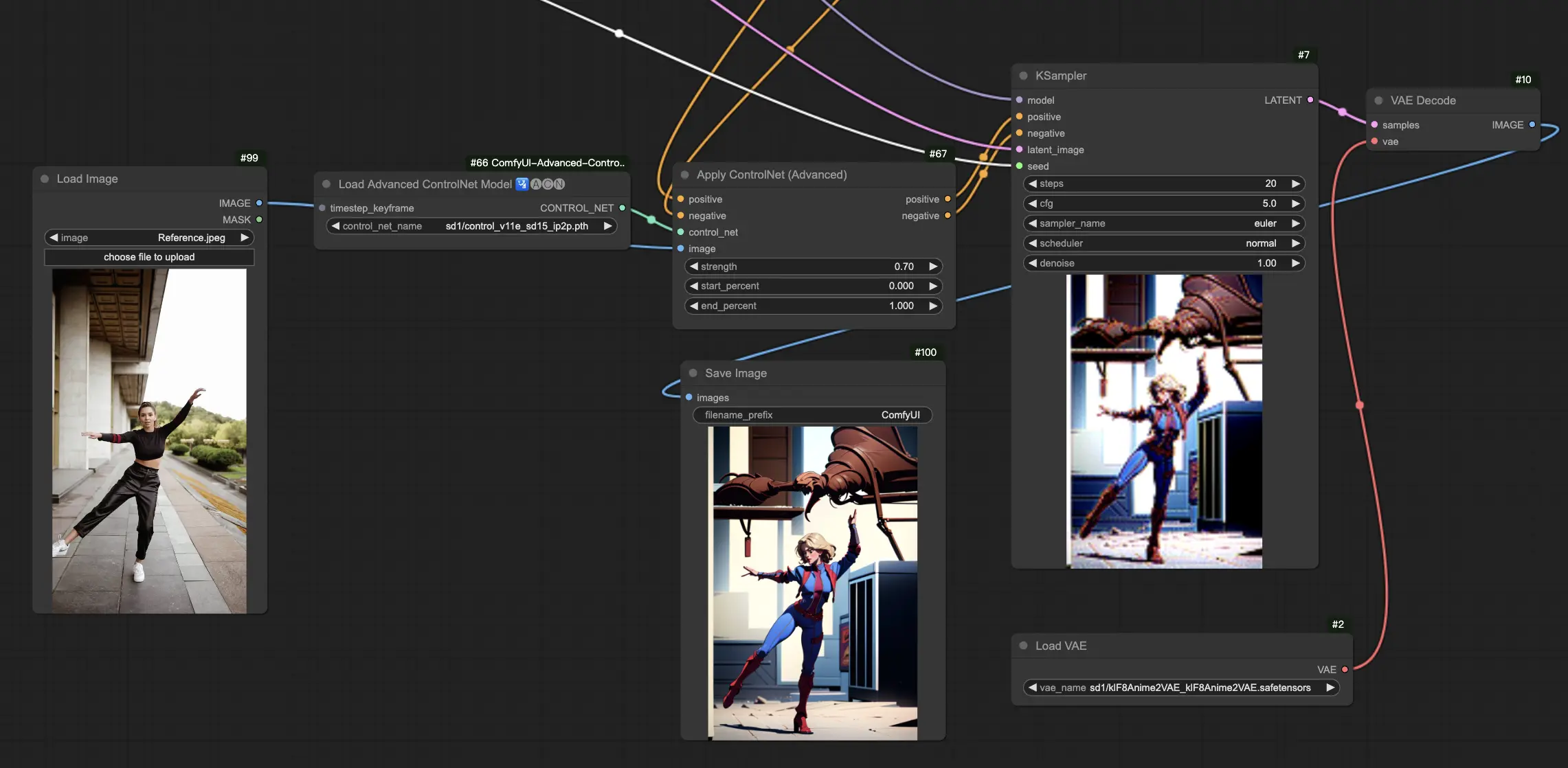

5.13. ComfyUI ControlNet IP2P (Instruct Pix2Pix)

Модель ControlNet IP2P (Instruct Pix2Pix) выделяется как уникальная адаптация в рамках ControlNet, адаптированная для использования набора данных Instruct Pix2Pix для трансформации изображений. Этот вариант ControlNet отличается балансом между инструкционными и описательными подсказками во время его обучения. В отличие от традиционного подхода в официальном Instruct Pix2Pix, ControlNet IP2P включает 50/50 смесь этих типов подсказок, увеличивая его универсальность и эффективность в достижении желаемых результатов.

5.14. ComfyUI T2I Adapter

t2iadapter color: Модель t2iadapter_color специально разработана для улучшения цветопередачи и точности в сгенерированных изображениях при использовании моделей диффузии текст-к-изображению. Сосредотачиваясь на адаптации цвета, эта модель позволяет более точно и ярко передавать цветовую палитру, близко соответствующую описаниям, представленным в текстовых подсказках. Она особенно полезна для проектов, где важны цветовая точность и специфика, добавляя новый уровень реализма и детализации в сгенерированные изображения.

t2iadapter style: Модель t2iadapter_style нацелена на стилистические аспекты генерации изображений, позволяя модифицировать и контролировать художественный стиль выходных изображений. Этот адаптер позволяет пользователям направлять модель текст-к-изображению на генерацию изображений, соответствующих определённым художественным стилям или эстетике, описанным в текстовых подсказках. Это неоценимый инструмент для творческих проектов, где стиль изображения играет ключевую роль, предлагая бесшовный способ сочетать традиционные художественные стили с современными возможностями AI.

5.15. Другие популярные ComfyUI ControlNet: QRCode Monster и IP-Adapter

Для этих сегментов мы посвятим отдельные статьи, чтобы предоставить подробное введение в каждый, учитывая значительное количество информации, которую мы хотим поделиться.

6. Как использовать несколько ComfyUI ControlNet

Использование нескольких ComfyUI ControlNet в ComfyUI включает процесс наслаивания или цепочки моделей ControlNet для уточнения генерации изображения с более точным контролем над различными аспектами, такими как поза, форма, стиль и цвет.

Таким образом, вы можете построить свой workflow, применяя ControlNet (например, OpenPose), а затем передавая его выход на другой ControlNet (например, Canny). Это наслаивание позволяет для детальной настройки изображения, где каждый ControlNet применяет свои специфические трансформации или контролирует. Этот процесс позволяет для более точного контроля над конечным результатом, интегрируя несколько аспектов, управляемых различными ControlNet.

🌟🌟🌟 ComfyUI Online - Испытайте Workflow ControlNet Сейчас 🌟🌟🌟

Если вы хотите исследовать workflow ControlNet, используйте следующий веб-сайт ComfyUI. Он полностью оснащен всеми необходимыми узлами и моделями, что позволяет легко творить без необходимости в ручных настройках. Получите практический опыт и ознакомьтесь с функциями ControlNet сейчас!