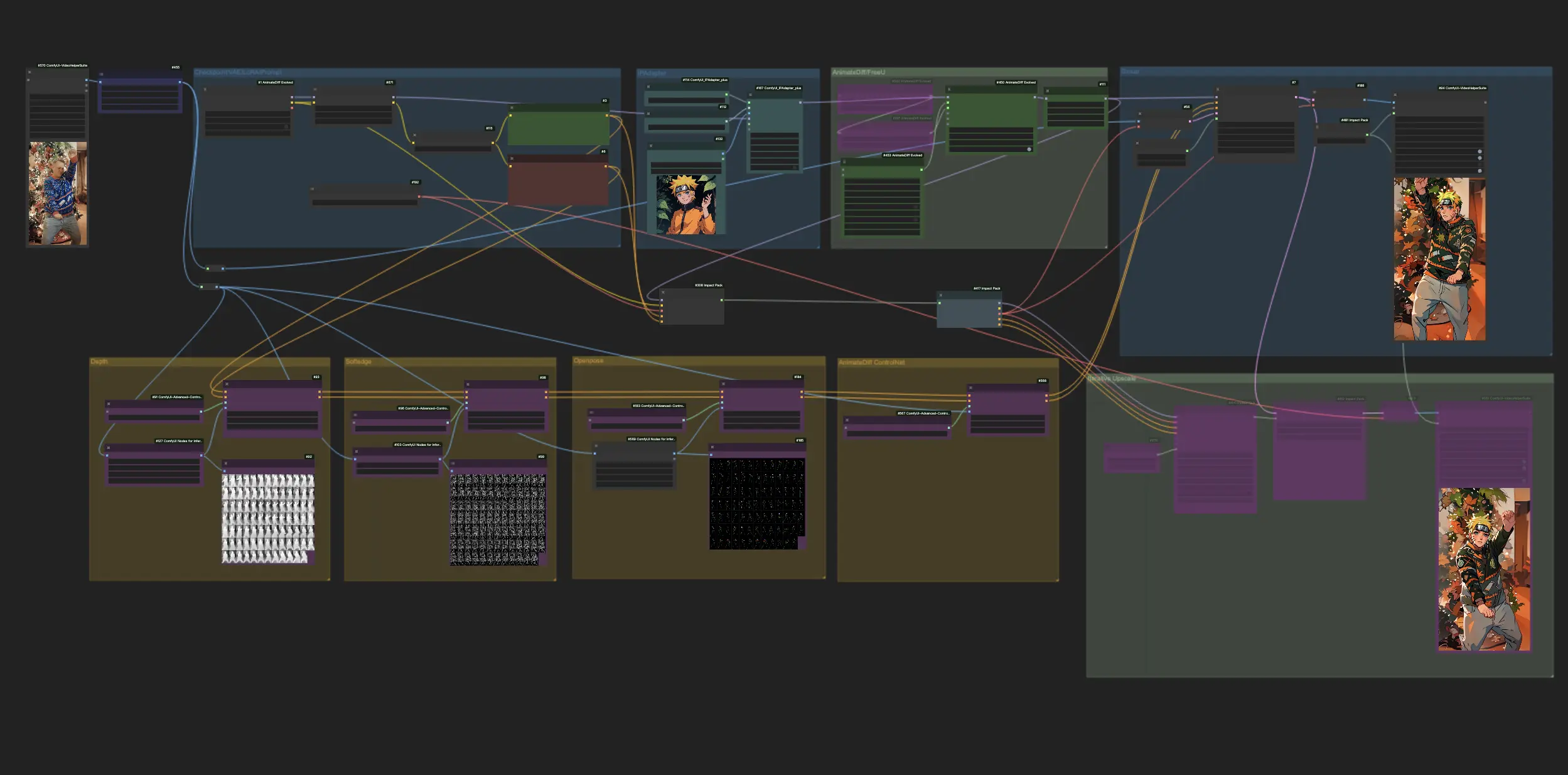

AnimateDiff + ControlNet + IPAdapter V1 | Японский аниме-стиль

Испытайте восторг от превращения видео в аниме, когда ComfyUI использует мощь AnimateDiff, ControlNet и IPAdapter для превращения стандартных видео в захватывающие японские аниме-версии. Этот рабочий процесс искусно использует передовые техники, такие как восприятие глубины, мягкие края и технология OpenPose, вместе с нюансами Lora, обеспечивая аутентичные аниме-эстетики для каждого видео. Погрузитесь в мир аниме с бесшовной, стильной метаморфозой.ComfyUI Vid2Vid (Japanese Anime) Рабочий процесс

- Полностью функциональные рабочие процессы

- Нет недостающих узлов или моделей

- Не требуется ручная настройка

- Отличается потрясающей визуализацией

ComfyUI Vid2Vid (Japanese Anime) Примеры

ComfyUI Vid2Vid (Japanese Anime) Описание

Этот рабочий процесс вдохновлён с некоторыми модификациями. Для получения дополнительной информации, пожалуйста, посетите его YouTube канал.

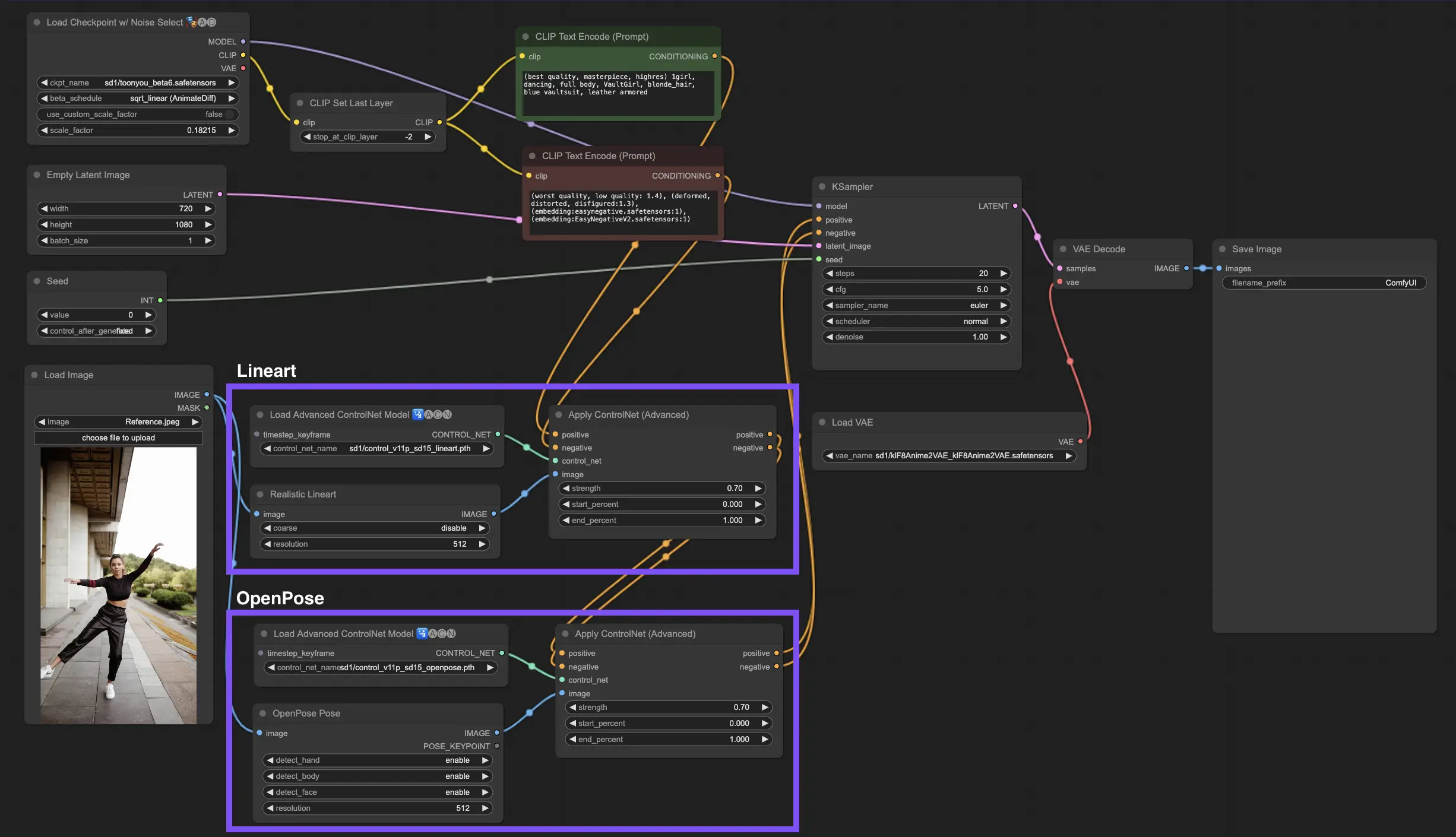

1. ComfyUI Workflow: AnimateDiff + ControlNet + IPAdapter | Японский аниме-стиль

Этот рабочий процесс позволяет преобразовывать стандартные видео в очаровательные японские аниме-создания с использованием AnimateDiff, ControlNet и IPAdapter. Экспериментируйте с различными контрольными точками, настройками LoRA и референсными изображениями для IPAdapter, чтобы создать свой уникальный стиль. Это весёлый и креативный способ оживить ваши видео в мире аниме!

2. Обзор AnimateDiff

Пожалуйста, ознакомьтесь с подробностями на

3. Как использовать ControlNet

3.1. Понимание ControlNet

ControlNet революционизирует способ генерации изображений, предоставляя новый уровень пространственного контроля моделям диффузии текст-изображение. Эта передовая архитектура нейронной сети прекрасно сочетается с гигантами, такими как Stable Diffusion, используя их обширные библиотеки, созданные из миллиардов изображений, чтобы вплетать пространственные нюансы прямо в ткань создания изображений. От набросков краёв до картирования человеческих поз, восприятия глубины или сегментирования визуалов, ControlNet позволяет вам формировать изображения способами, которые выходят далеко за рамки простых текстовых подсказок.

3.2. Инновации ControlNet

В основе ControlNet лежит гениальная простота. Он начинает с сохранения целостности параметров оригинальной модели, сохраняя базовую тренировку в неприкосновенности. Затем ControlNet вводит зеркальный набор слоёв кодирования модели, но с изюминкой: они обучаются с использованием "нулевых свёрток". Эти нули в качестве начальной точки означают, что слои мягко внедряют новые пространственные условия, не вызывая шума, обеспечивая сохранение оригинальных талантов модели даже по мере того, как она вступает на новые пути обучения.

3.3. Понимание ControlNets и T2I-Adapters

И ControlNets, и T2I-Adapters играют важную роль в кондиционировании генерации изображений, каждый предлагая свои преимущества. T2I-Adapters известны своей эффективностью, особенно в плане ускорения процесса генерации изображений. Несмотря на это, ControlNets непревзойдённы в своей способности детально направлять процесс генерации, делая их мощным инструментом для создателей.

Учитывая перекресток функциональностей между многими моделями T2I-Adapter и ControlNet, наше обсуждение будет в основном сосредоточено на ControlNets. Однако стоит отметить, что платформа RunComfy предварительно загрузила несколько моделей T2I-Adapter для удобства использования. Для тех, кто заинтересован в экспериментах с T2I-Adapters, вы можете легко загрузить эти модели и интегрировать их в свои проекты.

Выбор между моделями ControlNet и T2I-Adapter в ComfyUI не влияет на использование узлов ControlNet или на консистентность рабочего процесса. Это единство обеспечивает упрощённый процесс, позволяя вам использовать уникальные преимущества каждого типа модели в зависимости от потребностей вашего проекта.

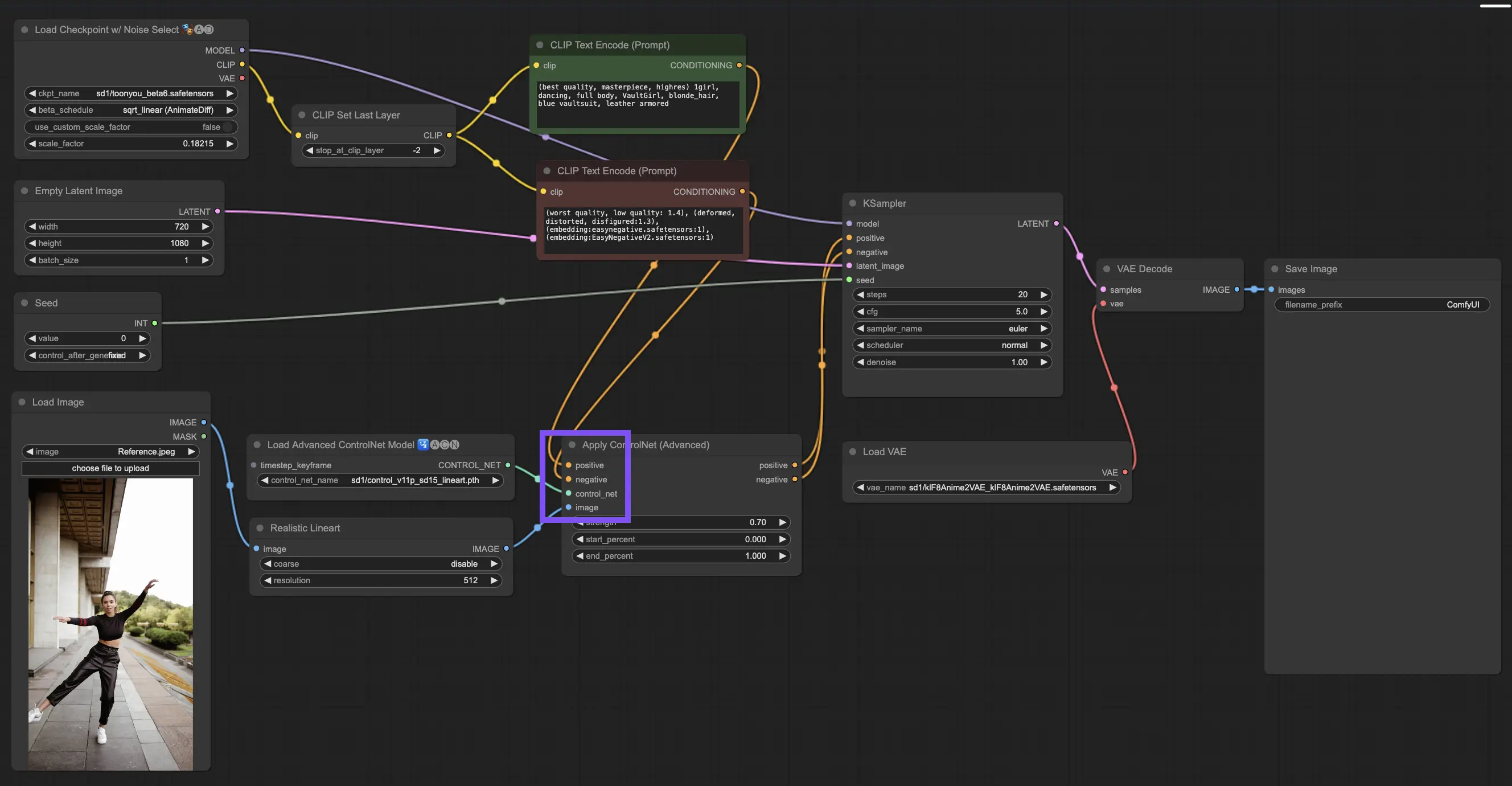

3.4. Использование узлов ControlNet

3.4.1. Загрузка узла "Apply ControlNet"

Для начала вам нужно загрузить узел "Apply ControlNet" в ваш ComfyUI. Это ваш первый шаг к созданию изображений с двойным кондиционированием, объединяющим визуальные элементы с текстовыми подсказками.

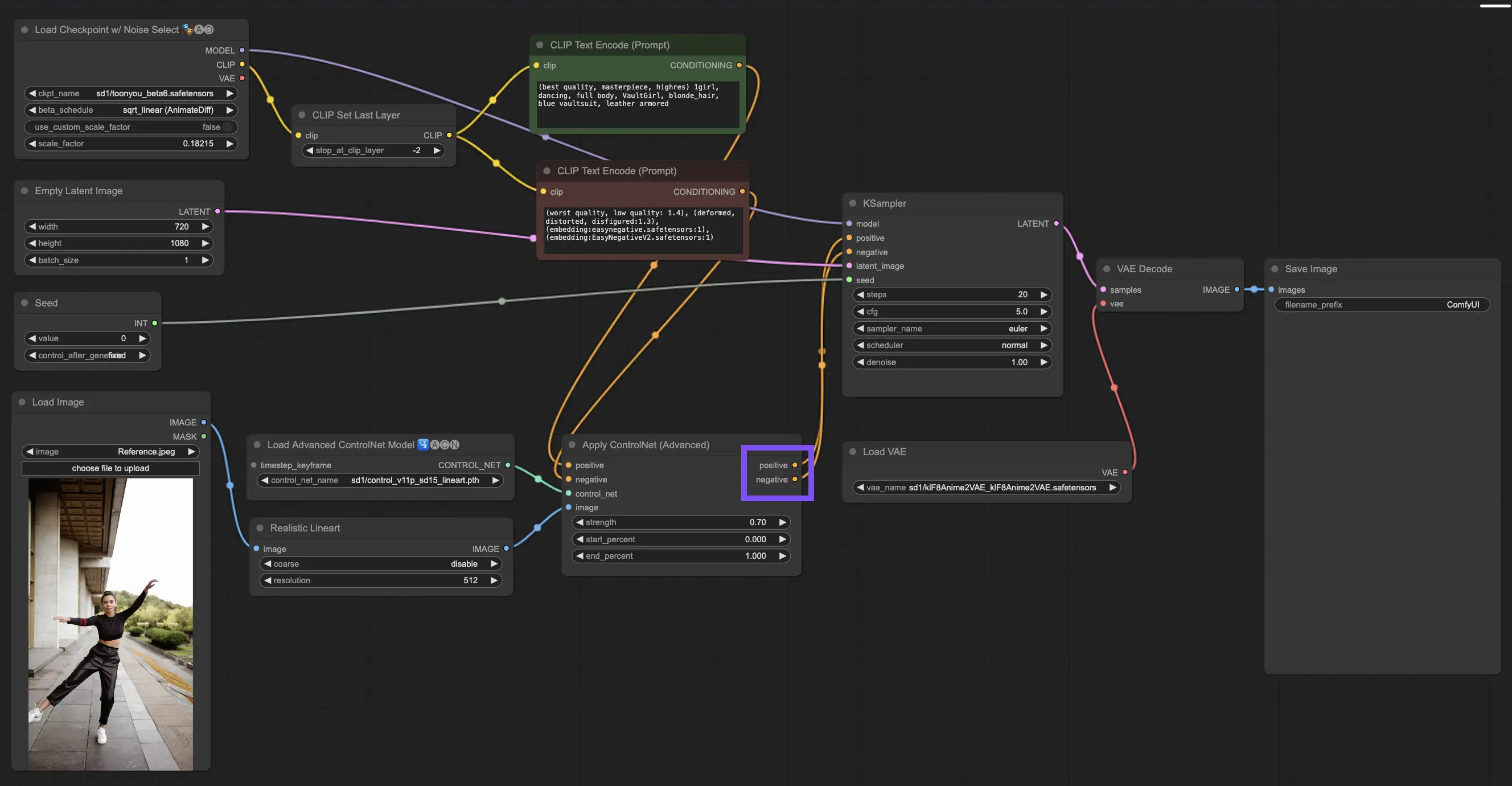

3.4.2. Понимание входов узла "Apply ControlNet"

Позитивное и негативное кондиционирование: Это ваши инструменты для формирования финального изображения: что оно должно включать и что оно должно избегать. Подключите их к слотам "Positive prompt" и "Negative prompt", чтобы синхронизировать их с текстовой частью вашего творческого направления.

Выбор модели ControlNet: Вам нужно будет связать этот вход с выходом узла "Load ControlNet Model". Здесь вы решаете, использовать ли модель ControlNet или T2IAdaptor в зависимости от конкретных черт или стилей, которые вы хотите достичь. Хотя мы сосредотачиваемся на моделях ControlNet, стоит упомянуть некоторые популярные T2IAdaptors для полноты картины.

Предобработка вашего изображения: Подключите ваше изображение к узлу "ControlNet Preprocessor", что жизненно важно для обеспечения готовности вашего изображения к ControlNet. Важно подобрать предобработчик к вашей модели ControlNet. Этот шаг корректирует ваше исходное изображение под нужды модели: изменение размера, перекраска или применение необходимых фильтров, готовя его к использованию ControlNet.

3.4.3. Понимание выходов узла "Apply ControlNet"

После обработки узел "Apply ControlNet" предоставляет вам два выхода, отражающих сложное взаимодействие ControlNet и вашего творческого вклада: Позитивное и Негативное Кондиционирование. Эти выходы направляют модель диффузии в ComfyUI, приводя к вашему следующему выбору: уточнить изображение с помощью KSampler или углубиться дальше, добавляя больше ControlNets для тех, кто стремится к непревзойденной детализации и кастомизации.

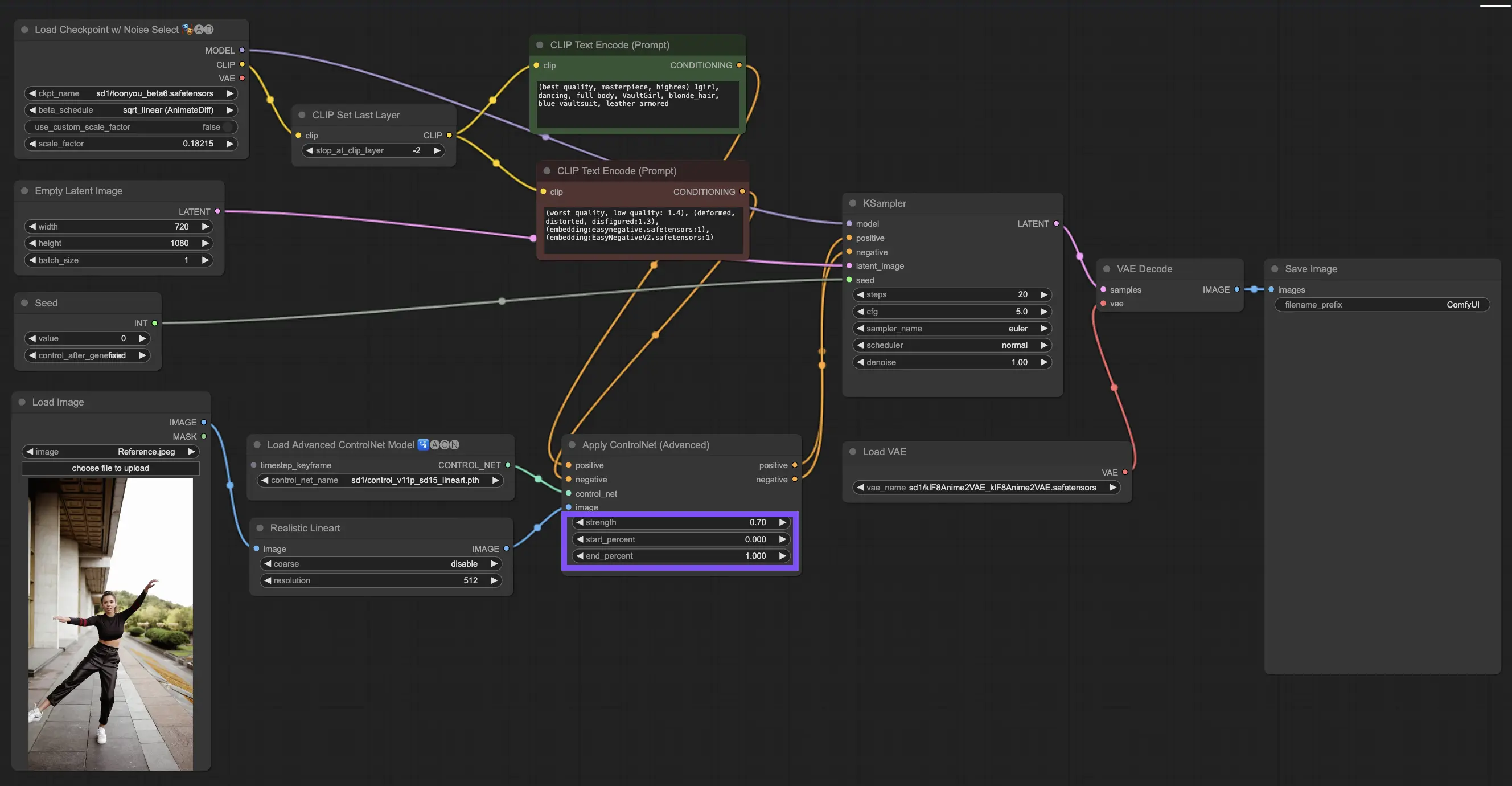

3.4.4. Настройка "Apply ControlNet" для лучших результатов

Определение силы: Этот параметр контролирует, насколько сильно ControlNet влияет на итоговое изображение. Полное значение 1.0 означает, что вход ControlNet имеет полный контроль, в то время как снижение до 0.0 позволяет модели работать без влияния ControlNet.

Настройка начального процента: Это указывает, когда ControlNet начинает вносить свой вклад в процесс диффузии. Например, начало с 20% означает, что с одной пятой пути ControlNet начинает оказывать влияние.

Настройка конечного процента: Это обратная сторона начального процента, указывающая, когда ControlNet прекращает своё влияние. Если вы установите его на 80%, влияние ControlNet исчезнет, когда изображение приближается к финальной стадии, оставаясь нетронутым ControlNet на последнем этапе.

3.5. Руководство по моделям ControlNet: Openpose, Depth, SoftEdge, Canny, Lineart, Tile

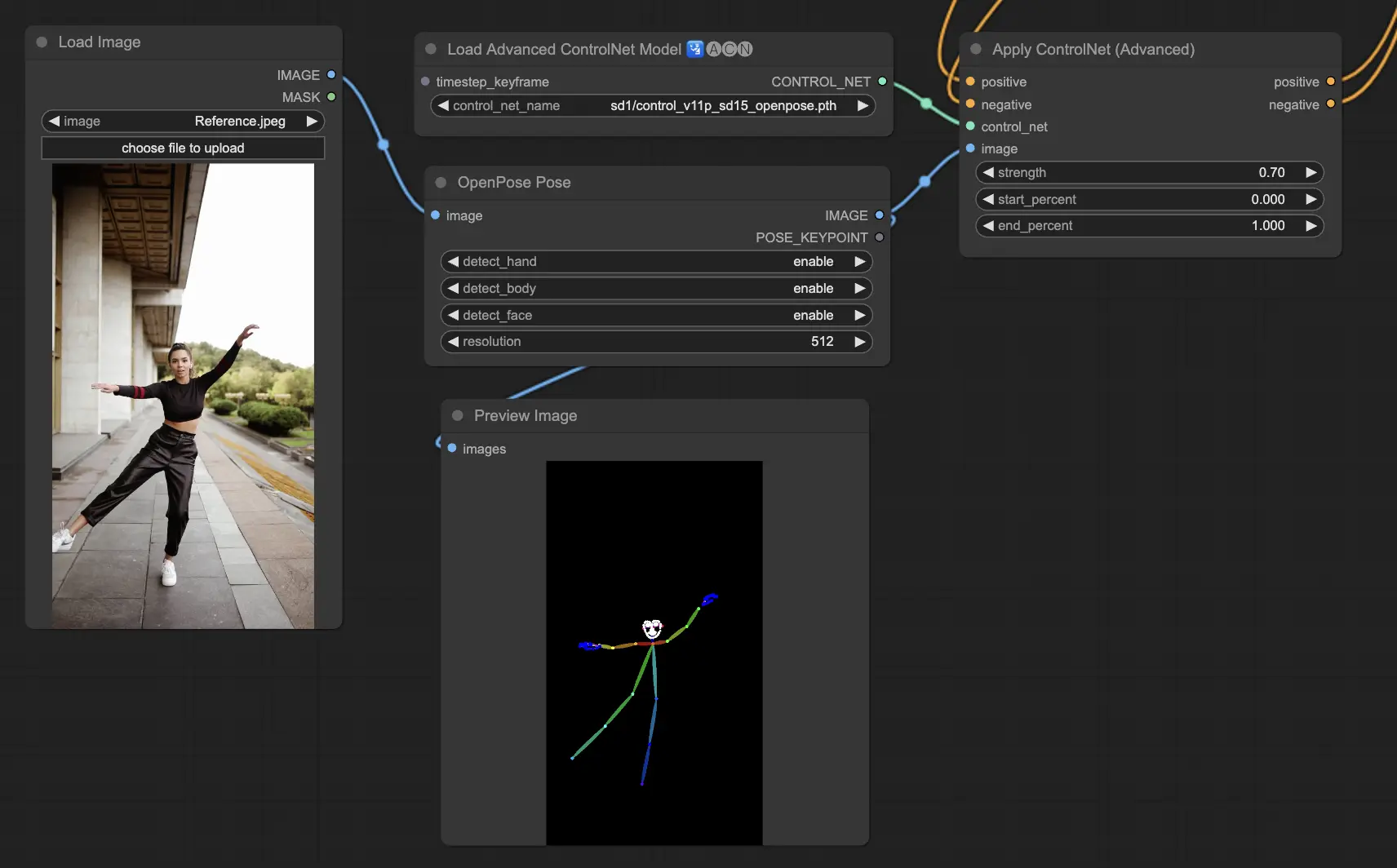

3.5.1. Модель ControlNet: Openpose

- Openpose (также называется Openpose body): Эта модель является основой для ControlNet для идентификации ключевых точек на человеческом теле, таких как глаза, нос, шея, плечи, локти, запястья, колени и лодыжки. Идеально подходит для воспроизведения простых человеческих поз.

- Openpose_face: Эта версия Openpose идёт дальше, обнаруживая ключевые точки лица, что позволяет детализировать выражения лица и направление взгляда. Если ваш проект сосредоточен на выражениях лица, эта модель необходима.

- Openpose_hand: Это улучшение модели Openpose фокусируется на тонких деталях движений рук и пальцев, что важно для детального понимания жестов рук и их положения. Расширяет возможности Openpose в ControlNet.

- Openpose_faceonly: Предназначена для анализа деталей лица, эта модель пропускает ключевые точки тела, чтобы сосредоточиться исключительно на выражениях лица и ориентации. Когда важны только черты лица, выберите эту модель.

- Openpose_full: Эта модель объединяет возможности Openpose, Openpose_face и Openpose_hand для обнаружения ключевых точек всего тела, лица и рук, делая её идеальной для комплексного анализа поз человека в ControlNet.

- DW_Openpose_full: На основе Openpose_full, эта модель вводит дополнительные улучшения для более детального и точного обнаружения поз. Это самая продвинутая версия в наборе ControlNet.

Варианты предобработчика включают: Openpose или DWpose

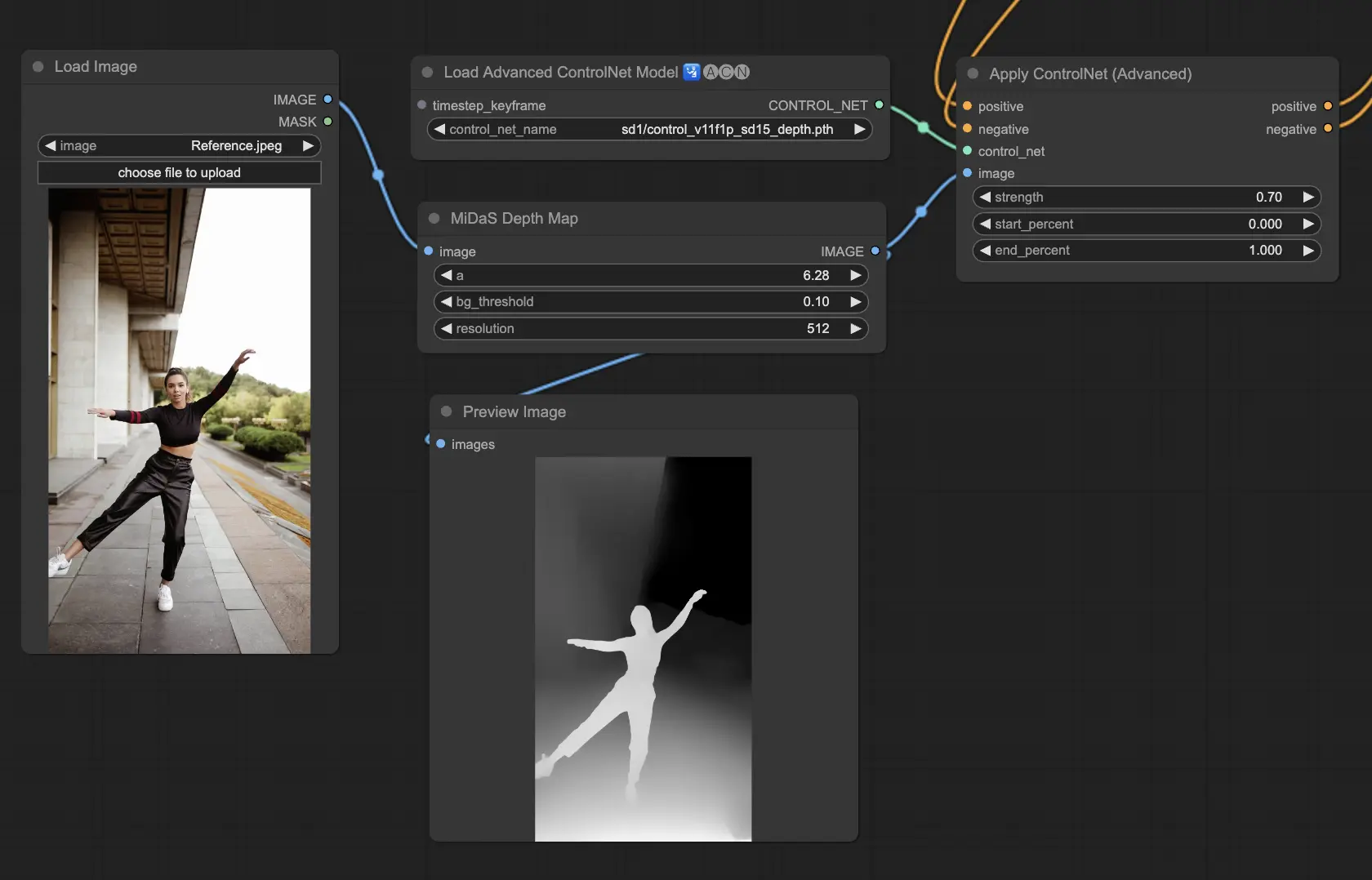

3.5.2. Модель ControlNet: Depth

Модели глубины используют 2D-изображение для оценки глубины, представляя её в виде градационной карты. Каждая из них имеет свои сильные стороны в плане детализации или фокусировки на фоне:

- Depth Midas: Сбалансированный подход к оценке глубины, Depth Midas предлагает средний уровень детализации и отображения фона.

- Depth Leres: Делает акцент на деталях, продолжая при этом захватывать элементы фона более выражено.

- Depth Leres++: Продвигает детализацию информации о глубине, что особенно полезно для сложных сцен.

- Zoe: Находит баланс между уровнями детализации моделей Midas и Leres.

- Depth Anything: Улучшенная модель для универсальной оценки глубины в различных сценах.

- Depth Hand Refiner: Специально тонко настраивает детали рук в картах глубины, делая её незаменимой для сцен, где важна точная позиция рук.

Рекомендуемые предобработчики: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Эта модель отличается надёжностью и совместимостью с реальными картами глубины от рендеринг-движков.

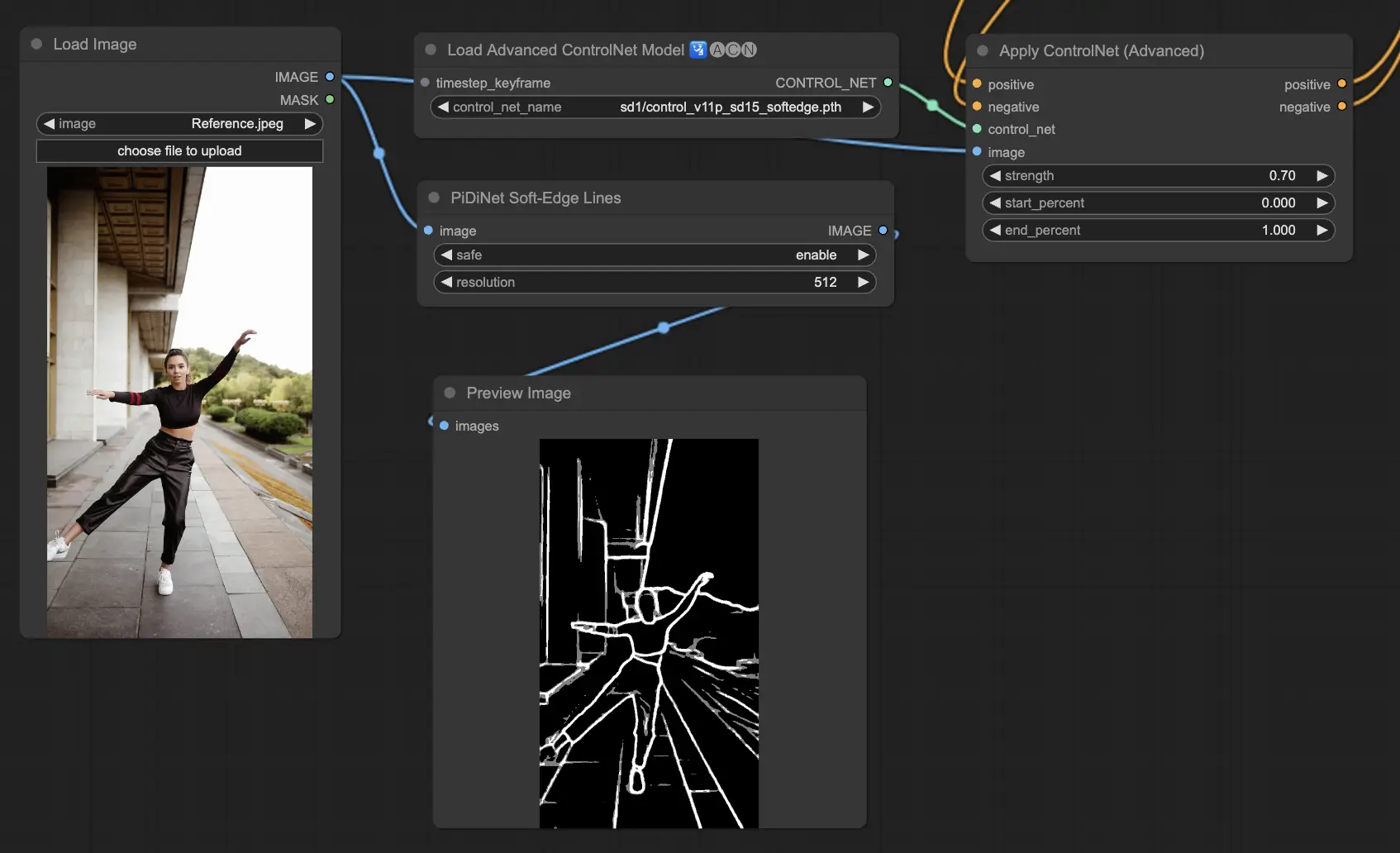

3.5.3. Модель ControlNet: SoftEdge

ControlNet Soft Edge разработан для создания изображений с мягкими краями, улучшая детали при сохранении естественного вида. Он использует передовые нейронные сети для тонкой манипуляции изображениями, предлагая широкий творческий контроль и безупречную интеграцию.

По надёжности: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Для наивысшего качества результатов: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

В общем, рекомендуется использовать SoftEdge_PIDI, так как он обычно даёт отличные результаты.

Предобработчики включают: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

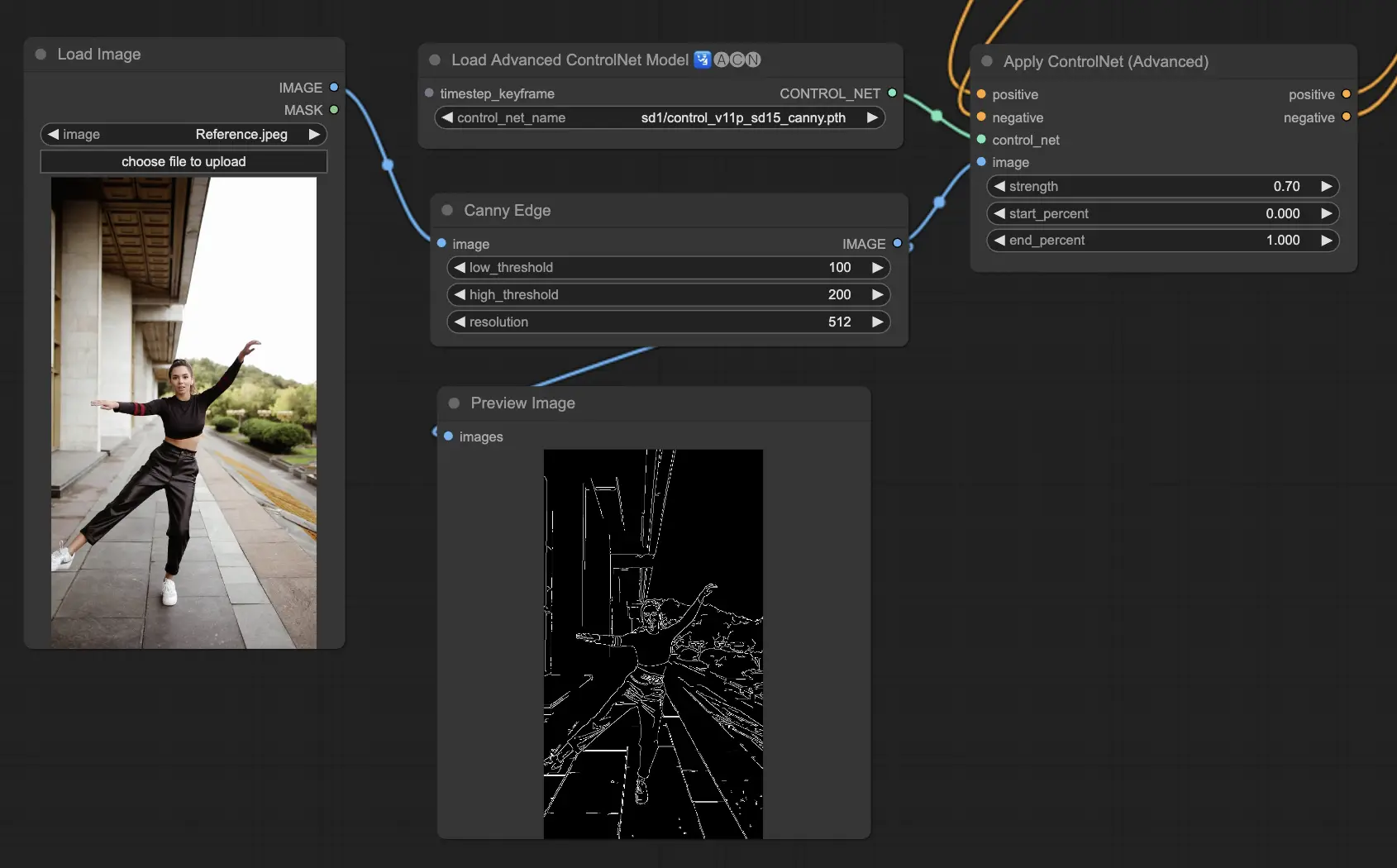

3.5.4. Модель ControlNet: Canny

Модель Canny реализует обнаружение краёв по алгоритму Canny, чтобы выделить широкий спектр краёв в изображениях. Эта модель отлично подходит для сохранения целостности структурных элементов, упрощая общий вид изображения, помогая создавать стилизованное искусство или подготавливать изображения для дальнейшей обработки.

Доступные предобработчики: Canny

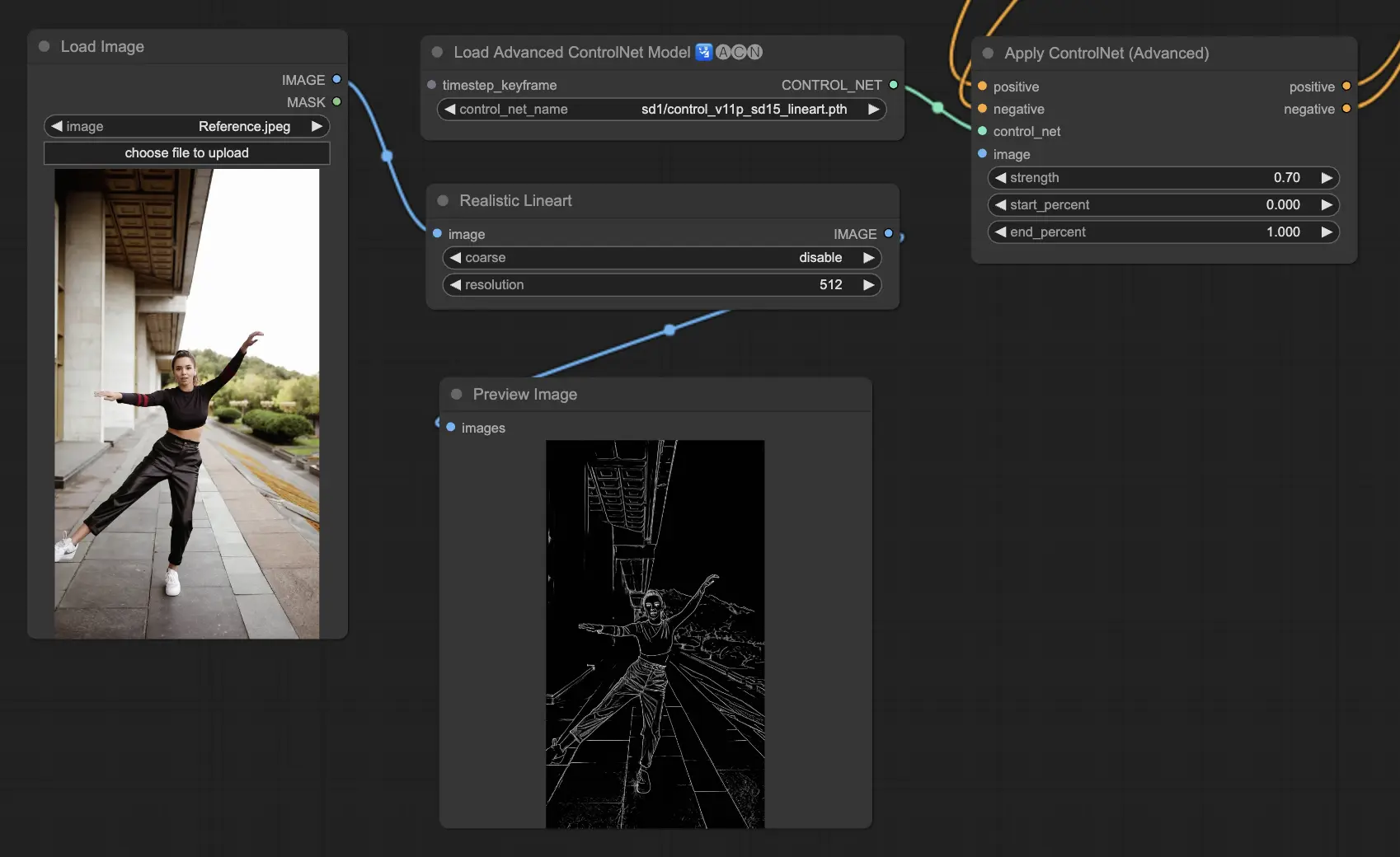

3.5.5. Модель ControlNet: Lineart

Модели Lineart предназначены для преобразования изображений в стилизованные линейные рисунки, подходящие для различных художественных приложений:

- Lineart: Стандартный выбор для превращения изображений в линейные рисунки, предоставляющий универсальную отправную точку для различных художественных или творческих начинаний.

- Lineart anime: Предназначен для создания чистых, точных линейных рисунков в стиле аниме, идеально подходящих для проектов, стремящихся к вдохновлённому аниме виду.

- Lineart realistic: Стремится к более реалистичному представлению в линейных рисунках, предлагая больше деталей для проектов, требующих реализма.

- Lineart coarse: Подчёркивает более жирные, выразительные линии для создания яркого визуального эффекта, идеально подходящего для смелых графических заявлений.

Доступные предобработчики могут создавать как детализированные, так и более выраженные линейные рисунки (Lineart и Lineart_Coarse).

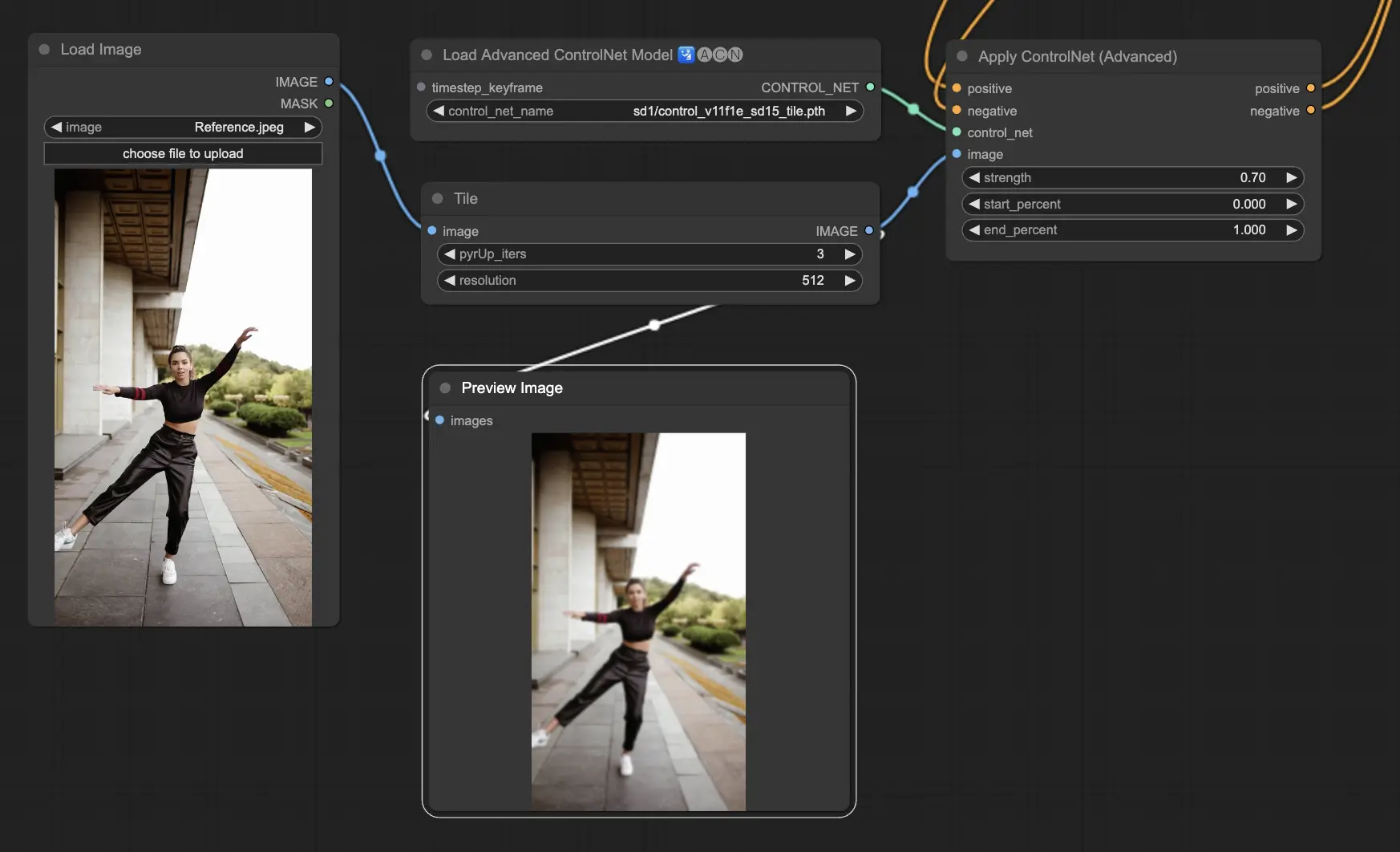

3.5.6. Модель ControlNet: Tile

Модель Tile Resample превосходно выделяет детали в изображениях. Она особенно эффективна при использовании вместе с увеличителем для повышения разрешения и детализации изображения, часто применяется для улучшения текстур и элементов изображения.

Рекомендуемый предобработчик: Tile

3.6. Руководство по использованию нескольких ControlNet

Интеграция нескольких ControlNet или T2I-Adapters позволяет последовательно применять различные типы кондиционирования к процессу генерации изображений. Например, вы можете комбинировать Lineart и OpenPose ControlNets для улучшенной детализации.

Lineart для формы объекта: Начните с интеграции Lineart ControlNet, чтобы добавить глубину и детали объектам или элементам на ваших изображениях. Этот процесс включает подготовку линейного или канни-карты для объектов, которые вы хотите включить.

OpenPose для управления позами: После детализации с использованием Lineart, используйте OpenPose ControlNet для задания позы людей на вашем изображении. Вам нужно будет создать или получить карту OpenPose, которая захватывает желаемую позу.

Последовательное применение: Для эффективного комбинирования этих эффектов, свяжите выход из Lineart ControlNet с OpenPose ControlNet. Этот метод обеспечивает, что как поза субъектов, так и формы объектов одновременно направляются во время процесса генерации, создавая результат, который гармонично соответствует всем входным спецификациям.

4. Обзор IPAdapter

Пожалуйста, ознакомьтесь с подробностями на