AnimateLCM | 加速文本到视频转换

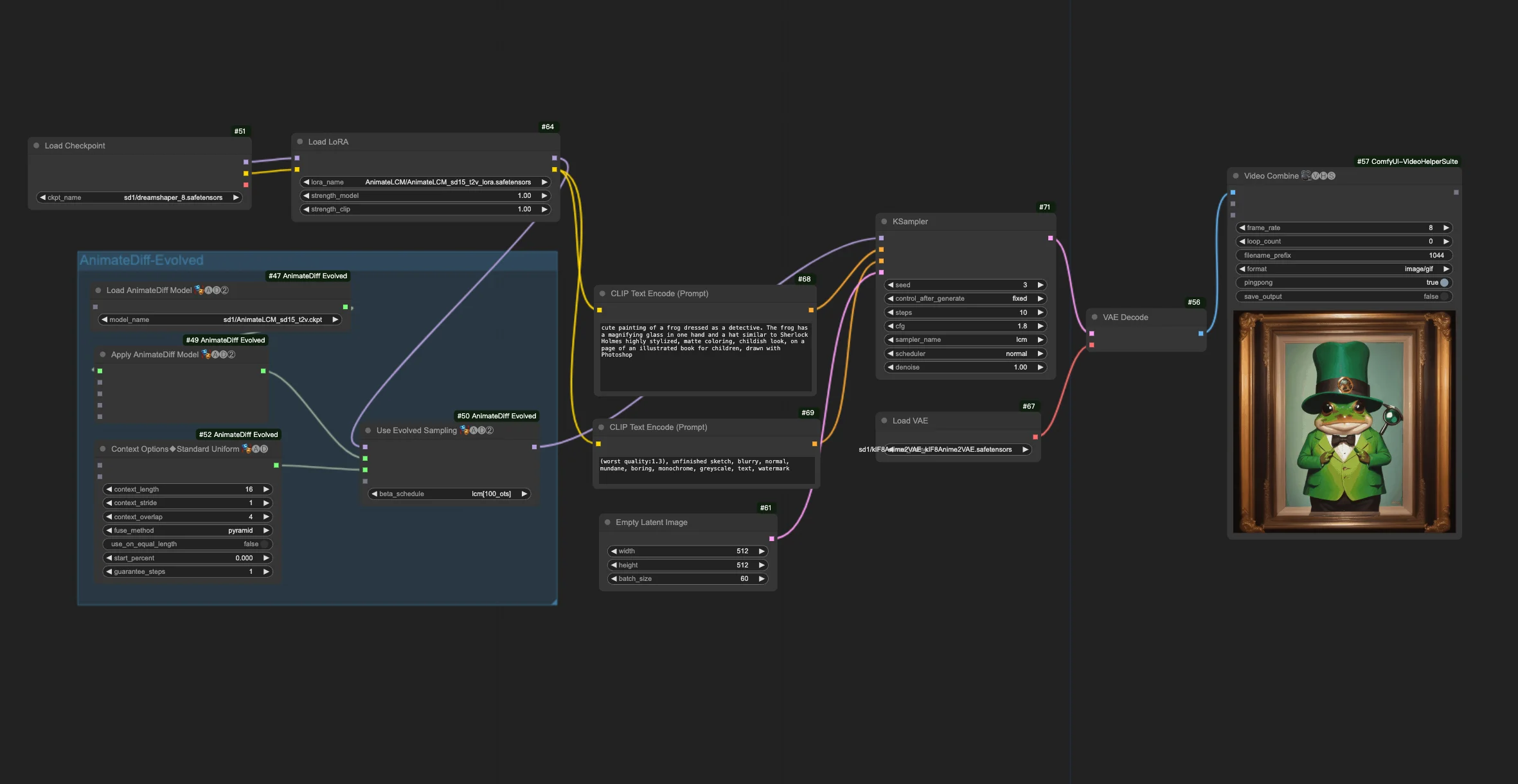

这个工作流程通过引入 "加载 AnimateLCM LoRA" 和 "在 AnimateDiff 中应用 AnimateLCM 运动模型",在 AnimateDiff-Evolved 工作流程的基础上进行了改进。它使个性化动画效果的创建更加快速和高效。ComfyUI AnimateLCM 工作流程

ComfyUI AnimateLCM 示例

ComfyUI AnimateLCM 描述

1. ComfyUI AnimateLCM 工作流程

ComfyUI AnimateLCM 工作流程旨在提高 AI 动画制作速度。在 ComfyUI-AnimateDiff-Evolved 的基础上,该工作流程引入了 AnimateLCM,以特别加速文本到视频 (t2v) 动画的创建。您可以尝试各种提示和步骤来实现预期效果。

2. AnimateLCM 概述

SDXL、LCM 和 SDXL Turbo 等技术的出现极大地提高了图像生成的速度。AnimateLCM 进一步推动了 AI 动画的进步。它支持快速的图像到视频生成,旨在提高从静态图像或文本描述生成动画视频的速度和效率,特别适用于快速创建个性化动画效果。

2.1. AnimateLCM 简介

AnimateLCM 旨在通过解耦一致性学习来加速个性化扩散模型和适配器的动画制作。它受到一致性模型 (CM) 的启发,CM 通过蒸馏预训练的图像扩散模型来加速采样过程,以及其扩展版本潜在一致性模型 (LCM),后者专注于条件图像生成。AnimateLCM 利用这些基础,在图像扩散和生成技术的成功基础上,将其能力扩展到视频领域,实现在几个步骤内创建高保真视频。

2.2. 如何在 ComfyUI 工作流程中使用 AnimateLCM

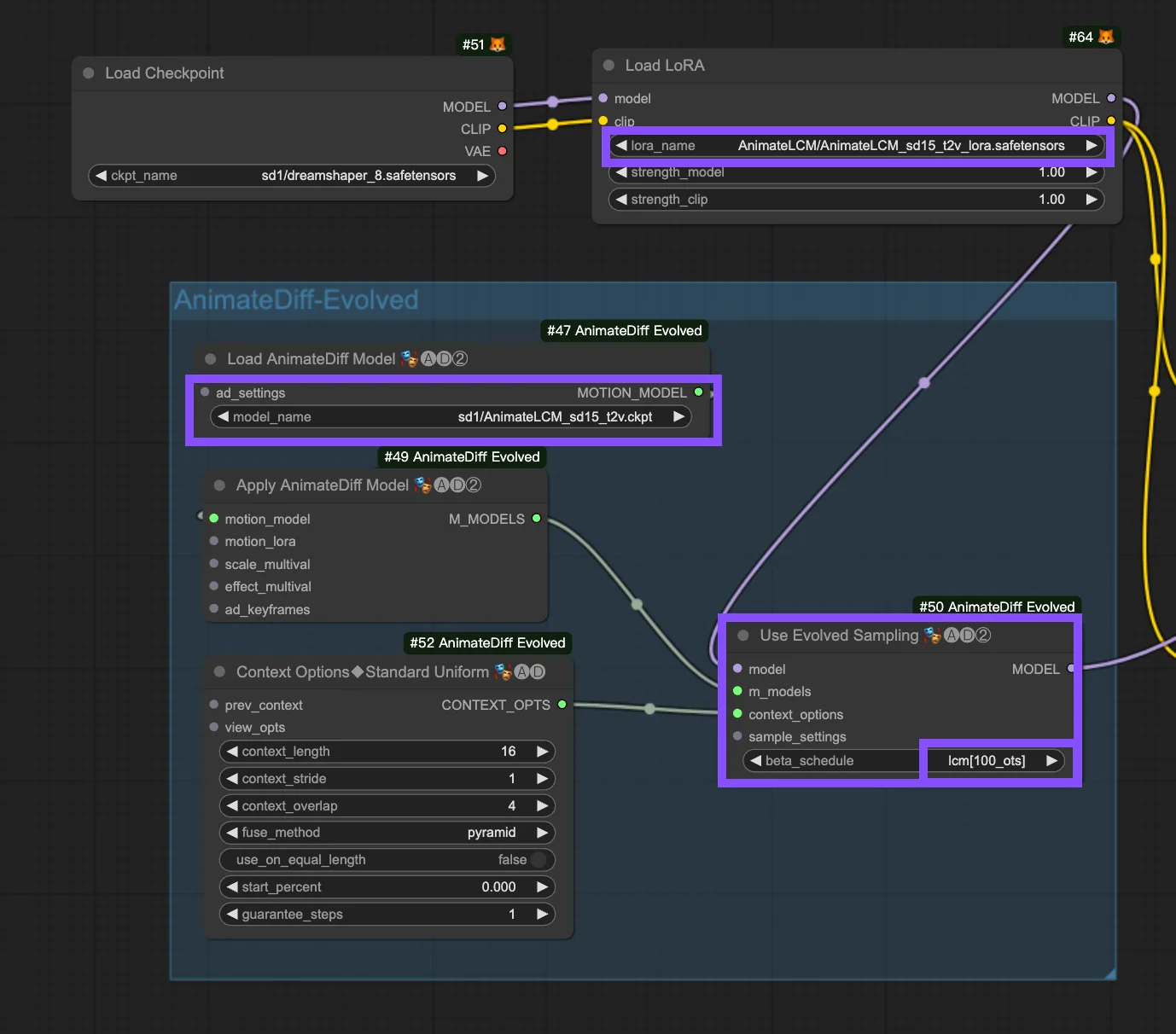

这个工作流程建立在 工作流程之上。以下是 "使用 Evolved 采样" 节点中的配置参数。

Models: 设置检查点模型和 LoRA 模型。

- Checkpoint: 这涉及用于动画创建的 StableDiffusion (SD) 模型输入。根据所选的运动模型,兼容性可能因 SD 版本而异,例如 SD1.5 或 SDXL。

- LoRA: 引入 AnimateLCM LoRA 模型,以无缝集成现有适配器,用于各种功能,通过专注于一致性学习来提高效率和输出质量,同时不牺牲采样速度。

Motion Models (M Models): 这些是 Apply AnimateDiff Model 过程的输出,支持使用 AnimateLCM Motion Model。

Context Options: 这些设置可在动画制作过程中调整 AnimateDiff 的操作,允许通过在整个 Unet 或特定运动模块内滑动上下文窗口来创建任意长度的动画。它们还支持对复杂动画序列进行时间调整。请参考

Beta Schedule in Sample Settings: 选择 LCM。在 ComfyUI 的 AnimateDiff 采样设置中,"beta schedule" 选项,包括 "lcm"、"lineart" 等选项,可微调整个扩散过程中控制噪声水平的 beta 值。这种自定义会影响动画的视觉风格和流畅度。每个设置都针对特定的动画或运动模型需求。

- LCM (潜在一致性模块): "lcm" 设置专为 LCM LoRA 量身定制,可提高动画的一致性并减少创建时间。它通过更少的步骤实现更快的收敛,需要减少步骤(至少 ~4 步)和调整其他参数以实现最佳的细节保留。

- Linear (AnimateDiff-SDXL): 推荐与 SDXL 运动模块一起使用 AnimateDiff,该选项在细节保留和平滑运动之间取得平衡,表明与特定运动模型版本的兼容性。

- Sqrt_lineart (AnimateDiff): 与 "lineart" 类似,该变体专为 AnimateDiff 过程设计,特别是与 V2 运动模块一起使用,通过修改噪声水平来补充运动模型的输出,以实现更流畅的过渡或运动。