AnimateDiff + ControlNet + AutoMask | Comic-Stil

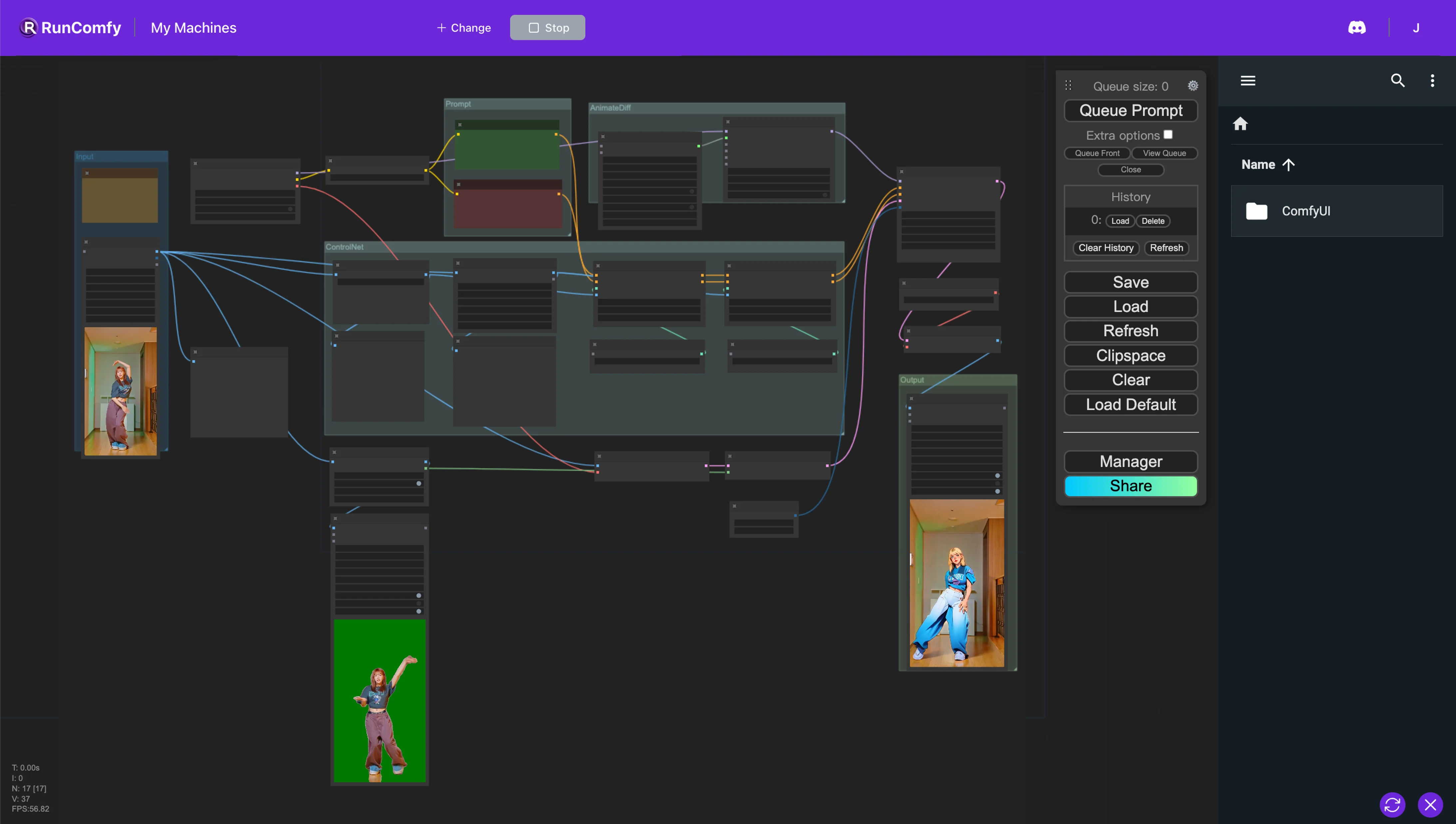

In diesem ComfyUI-Workflow verwenden wir benutzerdefinierte Nodes wie Animatediff, ControlNet (mit Depth und OpenPose) und Auto Mask, um Videos nahtlos umzugestalten. Dieser Prozess verwandelt realistische Charaktere in Anime, während die ursprünglichen Hintergründe sorgfältig erhalten bleiben.ComfyUI Vid2Vid Arbeitsablauf

- Voll funktionsfähige Workflows

- Keine fehlenden Nodes oder Modelle

- Keine manuelle Einrichtung erforderlich

- Beeindruckende Visualisierungen

ComfyUI Vid2Vid Beispiele

ComfyUI Vid2Vid Beschreibung

1. ComfyUI AnimateDiff, ControlNet und Auto Mask Workflow

Dieser ComfyUI-Workflow stellt einen leistungsstarken Ansatz für das Video-Restyling vor, der speziell darauf abzielt, Charaktere in einen Anime-Stil zu verwandeln und gleichzeitig die ursprünglichen Hintergründe beizubehalten. Diese Transformation wird durch mehrere Schlüsselkomponenten unterstützt, darunter AnimateDiff, ControlNet und Auto Mask.

AnimateDiff ist für differentielle Animationstechniken konzipiert und ermöglicht die Beibehaltung eines konsistenten Kontexts innerhalb von Animationen. Diese Komponente konzentriert sich auf die Glättung von Übergängen und die Verbesserung der Flüssigkeit der Bewegung in umgestalteten Videoinhalten.

ControlNet spielt eine entscheidende Rolle bei der präzisen Nachbildung und Manipulation der menschlichen Pose. Es nutzt fortschrittliche Posenschätzung, um die Nuancen der menschlichen Bewegung genau zu erfassen und zu steuern, wodurch die Transformation von Charakteren in Anime-Formen erleichtert wird, während ihre ursprünglichen Posen erhalten bleiben.

Auto Mask ist an der automatischen Segmentierung beteiligt und kann Charaktere geschickt von ihren Hintergründen isolieren. Diese Technologie ermöglicht ein selektives Umstyling von Videoelementen und stellt sicher, dass Charaktertransformationen ausgeführt werden, ohne die Umgebung zu verändern, wodurch die Integrität der ursprünglichen Hintergründe gewahrt bleibt.

Dieser ComfyUI-Workflow realisiert die Umwandlung von Standard-Videoinhalten in stilisierte Animationen und konzentriert sich dabei auf Effizienz und Qualität der Generierung von Charakteren im Anime-Stil.

2. Übersicht über AnimateDiff

2.1. Einführung in AnimateDiff

AnimateDiff tritt als KI-Tool auf, das entwickelt wurde, um statische Bilder und Textprompts in dynamische Videos zu animieren, wobei Stable Diffusion-Modelle und ein spezielles Bewegungsmodul verwendet werden. Diese Technologie automatisiert den Animationsprozess, indem sie nahtlose Übergänge zwischen Frames vorhersagt, und macht ihn über eine kostenlose Online-Plattform für Benutzer ohne Programmierkenntnisse oder Computerressourcen zugänglich.

2.2. Hauptmerkmale von AnimateDiff

2.2.1. Umfassende Modellunterstützung: AnimateDiff ist mit verschiedenen Versionen kompatibel, darunter AnimateDiff v1, v2, v3 für Stable Diffusion V1.5 und AnimateDiff sdxl für Stable Diffusion SDXL. Es ermöglicht die gleichzeitige Verwendung mehrerer Bewegungsmodelle und erleichtert so die Erstellung komplexer und geschichteter Animationen.

2.2.2. Kontext-Batch-Größe bestimmt die Animationslänge: AnimateDiff ermöglicht die Erstellung von Animationen mit unendlicher Länge durch die Anpassung der Kontext-Batch-Größe. Diese Funktion ermöglicht es Benutzern, die Länge und den Übergang von Animationen an ihre spezifischen Anforderungen anzupassen, was einen hochgradig anpassbaren Animationsprozess bietet.

2.2.3. Kontextlänge für sanfte Übergänge: Der Zweck der einheitlichen Kontextlänge in AnimateDiff besteht darin, nahtlose Übergänge zwischen verschiedenen Segmenten einer Animation zu gewährleisten. Durch die Anpassung der einheitlichen Kontextlänge können Benutzer die Übergangsdynamik zwischen Szenen steuern - längere Längen für weichere, nahtlosere Übergänge und kürzere Längen für schnellere, ausgeprägtere Änderungen.

2.2.4. Bewegungsdynamik: In AnimateDiff v2 sind spezielle Bewegungs-LoRAs verfügbar, um Animationen kinematografische Kamerabewegungen hinzuzufügen. Diese Funktion führt eine dynamische Ebene in Animationen ein und verbessert deren visuelle Attraktivität erheblich.

2.2.5. Erweiterte Unterstützungsfunktionen: AnimateDiff wurde entwickelt, um mit einer Vielzahl von Tools wie ControlNet, SparseCtrl und IPAdapter zu arbeiten, was Benutzern, die die kreativen Möglichkeiten ihrer Projekte erweitern möchten, erhebliche Vorteile bietet.

3. Übersicht über ControlNet

3.1. Einführung in ControlNet

ControlNet stellt ein Framework für die Erweiterung von Bilddiffusionsmodellen mit bedingten Eingaben vor, mit dem Ziel, den Bildsyntheseprozess zu verfeinern und zu steuern. Es erreicht dies, indem es die neuronalen Netzwerkblöcke innerhalb eines bestimmten Diffusionsmodells in zwei Sätze dupliziert: Einer bleibt "gesperrt", um die ursprüngliche Funktionalität zu erhalten, und der andere wird "trainierbar" und passt sich an die bereitgestellten spezifischen Bedingungen an. Diese duale Struktur ermöglicht es Entwicklern, eine Vielzahl von bedingten Eingaben einzubinden, indem sie Modelle wie OpenPose, Tile, IP-Adapter, Canny, Depth, LineArt, MLSD, Normal Map, Scribbles, Segmentation, Shuffle und T2I Adapter verwenden, wodurch die generierte Ausgabe direkt beeinflusst wird. Durch diesen Mechanismus bietet ControlNet Entwicklern ein leistungsstarkes Werkzeug zur Steuerung und Manipulation des Bildgenerierungsprozesses, wodurch die Flexibilität des Diffusionsmodells und dessen Anwendbarkeit auf vielfältige kreative Aufgaben verbessert wird.

Präprozessoren und Modellintegration

3.1.1. Konfiguration der Vorverarbeitung: Die Initiierung mit ControlNet beinhaltet die Auswahl eines geeigneten Präprozessors. Die Aktivierung der Vorschauoption wird für ein visuelles Verständnis der Auswirkungen der Vorverarbeitung empfohlen. Nach der Vorverarbeitung geht der Workflow zur Verwendung des vorverarbeiteten Bildes für weitere Verarbeitungsschritte über.

3.1.2. Modellabgleich: ControlNet vereinfacht den Modellauswahlprozess, indem es die Kompatibilität durch die Ausrichtung von Modellen mit ihren entsprechenden Präprozessoren auf der Grundlage gemeinsamer Schlüsselwörter gewährleistet, was einen nahtlosen Integrationsprozess ermöglicht.

3.2. Hauptmerkmale von ControlNet

Eingehende Untersuchung der ControlNet-Modelle

3.2.1. OpenPose-Suite: Die OpenPose-Suite ist für die präzise Erkennung der menschlichen Pose konzipiert und umfasst Modelle zur Erkennung von Körperhaltungen, Gesichtsausdrücken und Handbewegungen mit außergewöhnlicher Genauigkeit. Verschiedene OpenPose-Präprozessoren sind auf spezifische Erkennungsanforderungen zugeschnitten, von der grundlegenden Posenanalyse bis hin zur detaillierten Erfassung von Gesichts- und Handnuancen.

3.2.2. Tile Resample Model: Das Tile Resample Model verbessert die Bildauflösung und -details und wird optimal zusammen mit einem Upscaling-Tool verwendet, um die Bildqualität zu verbessern, ohne die visuelle Integrität zu beeinträchtigen.

3.2.3. IP-Adapter-Modell: Der IP-Adapter erleichtert die innovative Verwendung von Bildern als Prompts und integriert visuelle Elemente aus Referenzbildern in die generierten Ausgaben, wobei die Möglichkeiten der Text-zu-Bild-Diffusion für angereicherte visuelle Inhalte kombiniert werden.

3.2.4. Canny-Kantendetektor: Das Canny-Modell ist für seine Kantenerkennungsfähigkeiten bekannt und betont die strukturelle Essenz von Bildern, was kreative visuelle Neuinterpretationen ermöglicht, während die Kernkompositionen erhalten bleiben.

3.2.5. Tiefenwahrnehmungsmodelle: Durch eine Vielzahl von Tiefenpräprozessoren ist ControlNet in der Lage, Tiefenhinweise aus Bildern abzuleiten und anzuwenden, was eine geschichtete Tiefenperspektive in generierten Bildern bietet.

3.2.6. LineArt-Modelle: Mit LineArt-Präprozessoren können Bilder in künstlerische Strichzeichnungen umgewandelt werden, die verschiedene künstlerische Vorlieben von Anime bis hin zu realistischen Skizzen berücksichtigen. ControlNet passt sich an ein Spektrum stilistischer Wünsche an.

3.2.7. Scribbles-Verarbeitung: Mit Präprozessoren wie Scribble HED, Pidinet und xDoG verwandelt ControlNet Bilder in einzigartige Scribble-Kunst und bietet verschiedene Stile für die Kantenerkennung und künstlerische Neuinterpretation.

3.2.8. Segmentierungstechniken: Die Segmentierungsfähigkeiten von ControlNet klassifizieren Bildelemente genau und ermöglichen eine präzise Manipulation basierend auf der Objektkategorisierung, ideal für komplexe Szenenkonstruktionen.

3.2.9. Shuffle-Modell: Das Shuffle-Modell führt eine Methode für Farbschema-Innovationen ein, indem Eingabebilder randomisiert werden, um neue Farbmuster zu erzeugen, wodurch das Original kreativ verändert wird, während seine Essenz erhalten bleibt.

3.2.10. T2I-Adapter-Innovationen: Die T2I-Adapter-Modelle, einschließlich Color Grid und CLIP Vision Style, bringen ControlNet in neue kreative Bereiche, indem sie Farben und Stile mischen und anpassen, um visuell überzeugende Ergebnisse zu erzielen, die das Farbschema oder die stilistischen Attribute des Originals respektieren.

3.2.11. MLSD (Mobile Line Segment Detection): MLSD ist auf die Erkennung von geraden Linien spezialisiert und für Projekte, die sich auf architektonische und Innenraumentwürfe konzentrieren, unverzichtbar, wobei strukturelle Klarheit und Präzision im Vordergrund stehen.

3.2.12. Normal Map-Verarbeitung: Unter Verwendung von Oberflächenorientierungsdaten replizieren Normal Map-Präprozessoren die 3D-Struktur von Referenzbildern und verbessern den Realismus der generierten Inhalte durch detaillierte Oberflächenanalyse.