ComfyUI Vid2Vid Dance Transfer

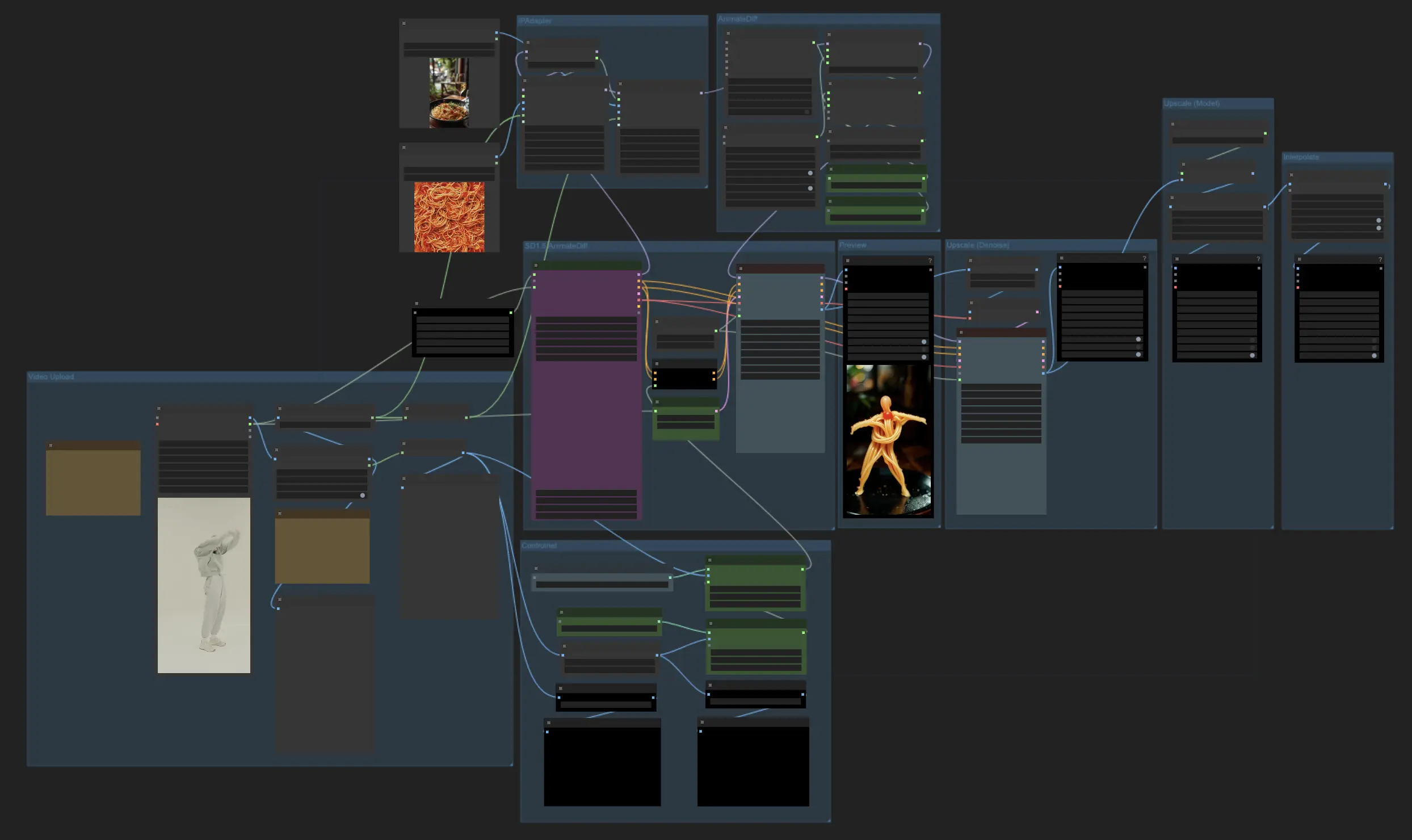

Mit diesem ComfyUI Vid2Vid Dance Transfer Workflow können Sie echte Videos einfach stilisieren und in fesselnde Animationen verwandeln. Dieser Workflow überträgt die Bewegung und den Stil von einem Quellvideo auf ein Zielbild oder Objekt und erzeugt beeindruckende Ergebnisse. Das Tutorial behandelt wesentliche Aspekte wie Video- und Maskenvorbereitung, Zielbildkonfiguration, Bewegungstransfer mit AnimateDiff, ControlNet-Anleitung und Generierung von Ausgabeframes.ComfyUI Vid2Vid Arbeitsablauf

- Voll funktionsfähige Workflows

- Keine fehlenden Nodes oder Modelle

- Keine manuelle Einrichtung erforderlich

- Beeindruckende Visualisierungen

ComfyUI Vid2Vid Beispiele

ComfyUI Vid2Vid Beschreibung

ComfyUI Vid2Vid Dance Transfer ist ein leistungsstarker ComfyUI Vid2Vid Workflow, der es Benutzern ermöglicht, echte Videos in verschiedene Objekte oder Elemente zu stilisieren und zu transformieren. Mit diesem Workflow können Sie beeindruckende Videoanimationen erstellen, indem Sie die Bewegung und den Stil eines Quellvideos auf ein Zielbild oder Objekt übertragen. Dieses Tutorial führt Sie durch die wichtigsten Komponenten und Einstellungen, die erforderlich sind, um die besten Ergebnisse zu erzielen.

Credit

Danke an MDMZ und DP für ihre unglaublichen Beiträge bei der Erstellung dieses Workflows! MDMZ teilte seinen ComfyUI Vid2Vid Dance Transfer Workflow durch sein YouTube-Tutorial , das auf DPs ursprünglichem Workflow aufbaut.

1. Was macht der ComfyUI Vid2Vid Dance Transfer Workflow?

Der ComfyUI Vid2Vid Dance Transfer Workflow ermöglicht es Ihnen, ein echtes Video in eine stilisierte Animation zu verwandeln. Er überträgt die Bewegung und die Tanzschritte vom Quellvideo auf ein Zielbild oder Objekt Ihrer Wahl.

2. Wichtige Komponenten des ComfyUI Vid2Vid Workflows

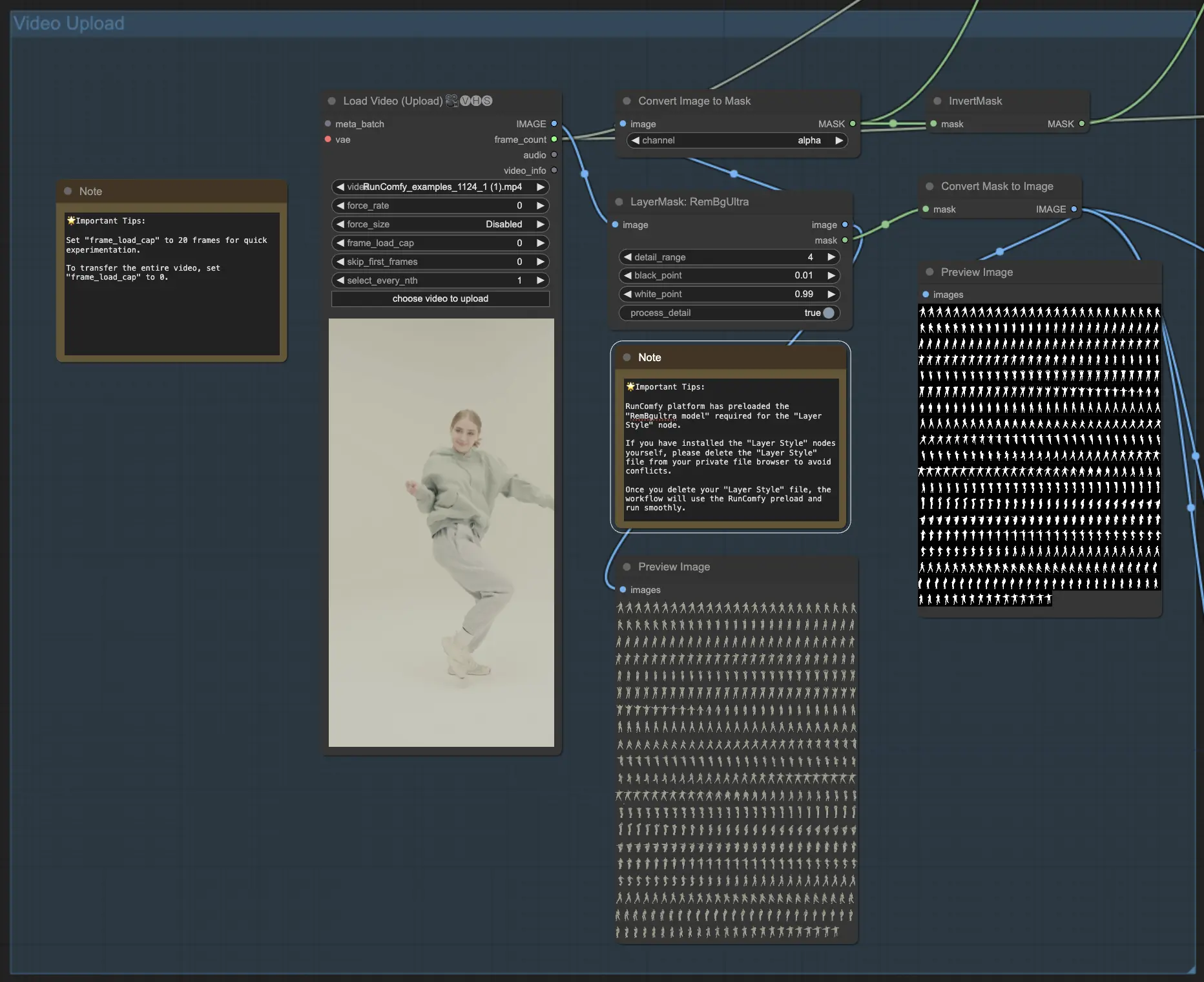

2.1 Video hochladen und Maske erstellen

- Der ComfyUI Vid2Vid Workflow beginnt mit der VHS_LoadVideo-Komponente, in der Sie das Quellvideo hochladen, das die zu übertragenden Tanzbewegungen enthält.

- Die LayerMask: RemBgUltra-Komponente wird verwendet, um den Hintergrund aus den Videoframes zu entfernen und eine Schwarz-Weiß-Maske des Subjekts zu erstellen. Diese Maske ist entscheidend, um die Bewegung richtig zu identifizieren und zu übertragen.

- Die ImageToMask- und MaskToImage-Komponenten konvertieren bei Bedarf zwischen Bild- und Maskenformaten im ComfyUI Vid2Vid Workflow.

- 🌟 Wichtige Tipps: Die RunComfy-Plattform hat das erforderliche "RemBgultra-Modell" für den "Layer Style"-Knoten vorinstalliert. Wenn Sie die "Layer Style"-Knoten selbst installiert haben, löschen Sie bitte die "Layer Style"-Datei aus Ihrem privaten Dateibrowser, um Konflikte zu vermeiden. Sobald Sie Ihre "Layer Style"-Datei gelöscht haben, verwendet der Workflow das RunComfy-Preload und läuft reibungslos.

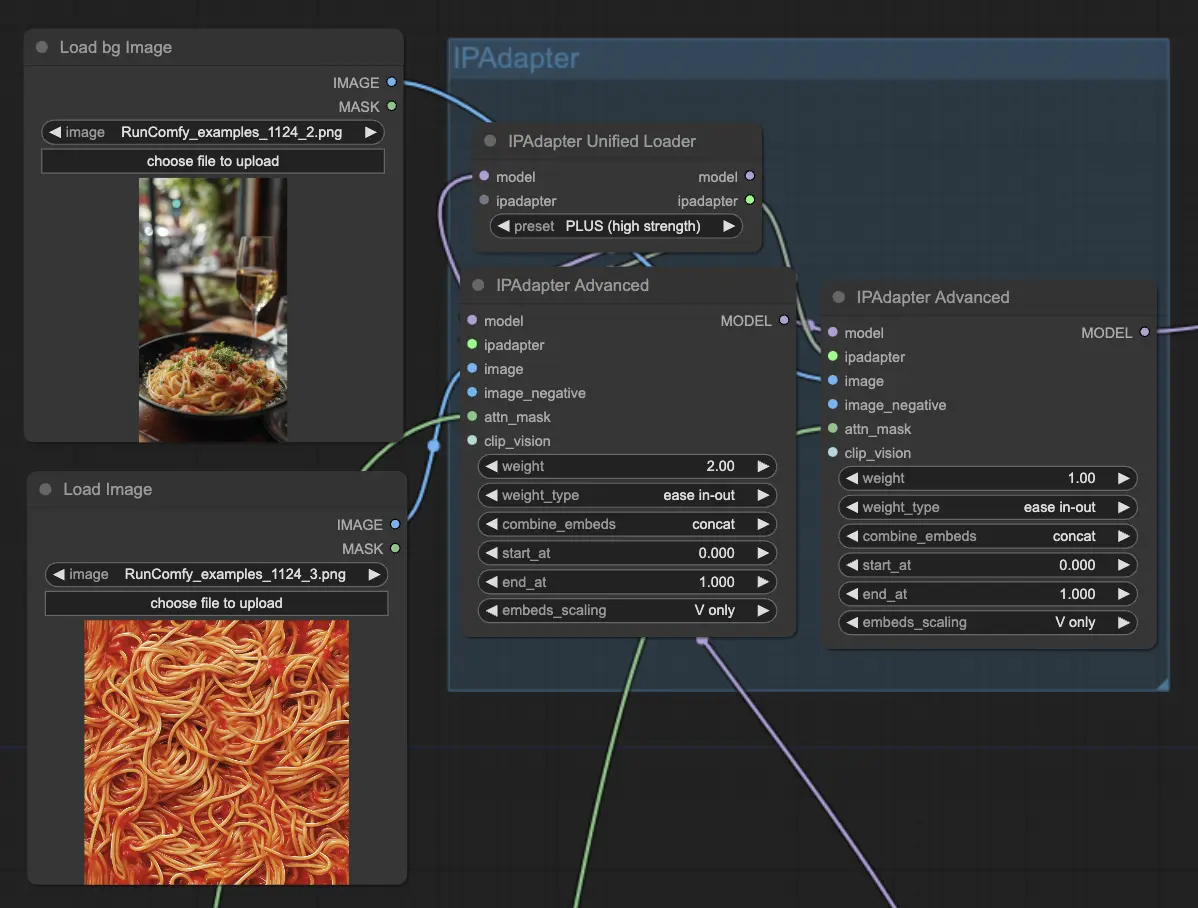

2.2 Zielbild mit IPAdapter einrichten

- Die IPAdapterAdvanced-Komponenten werden verwendet, um das Zielbild oder Objekt zu laden und zu konfigurieren, das den ComfyUI Vid2Vid Dance Transfer erhalten soll. Sie können das Zielbild mit dem LoadImage-Knoten hochladen und das Zielhintergrundbild mit dem LoadBgImage-Knoten hochladen.

- Der IPAdapterUnifiedLoader wird verwendet, um den IPAdapter zu laden, der die Stärke des Einflusses des Zielbildes auf die Ausgabe bestimmt.

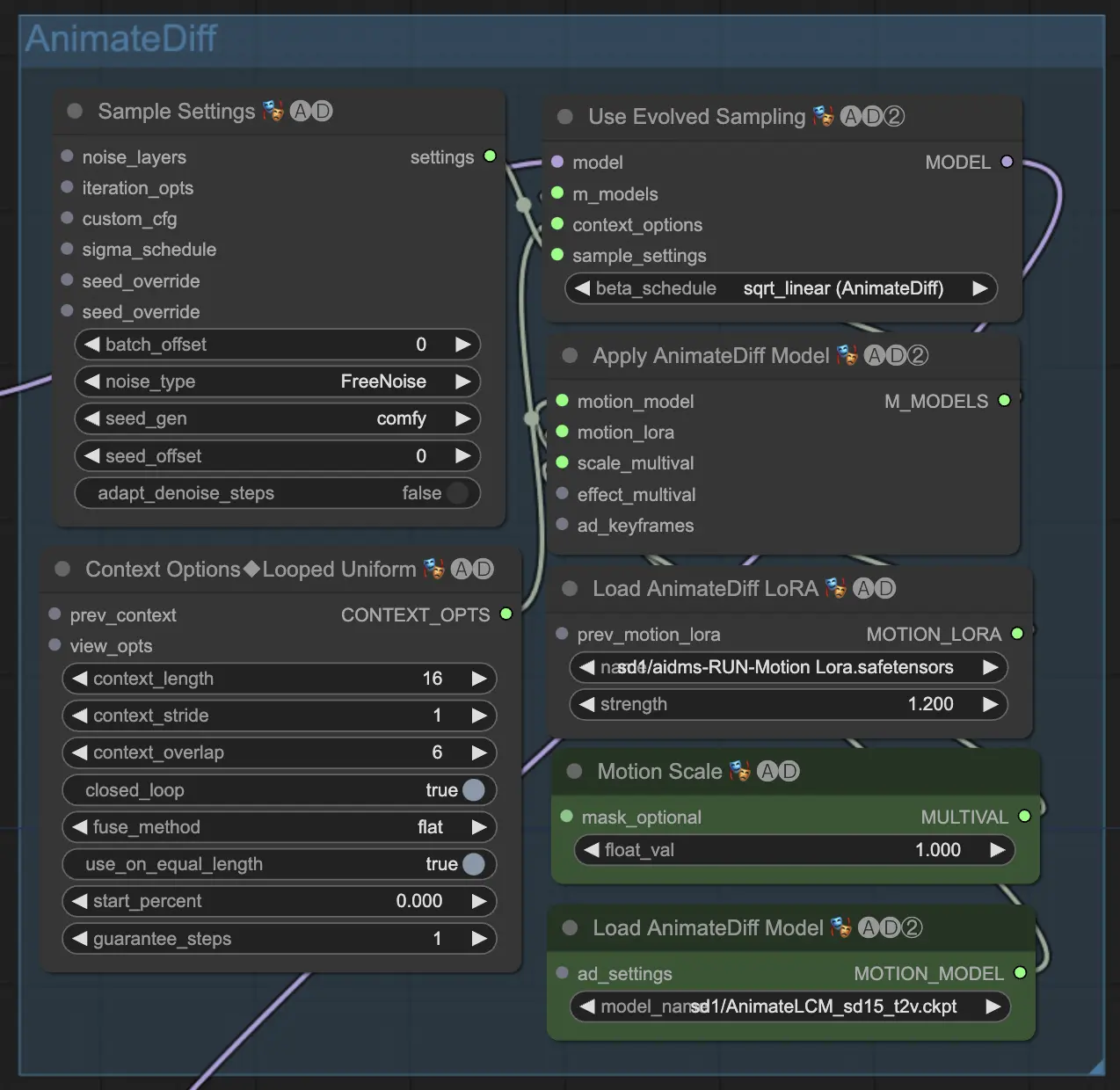

2.3 Bewegungstransfer mit AnimateDiff anwenden

- Der Kern des ComfyUI Vid2Vid Dance Transfer wird vom AnimateDiff Latent Condition Model (LCM) angetrieben. Dies wird mit der ADE_LoadAnimateDiffModel-Komponente in ComfyUI Vid2Vid geladen.

- Zusätzliche Komponenten wie ADE_AnimateDiffSamplingSettings, ADE_LoopedUniformContextOptions und ADE_ApplyAnimateDiffModelSimple werden verwendet, um die Sampling-Einstellungen, Kontextoptionen zu konfigurieren und das AnimateDiff-Modell entsprechend in ComfyUI Vid2Vid anzuwenden.

- Die ADE_UseEvolvedSampling-Komponente wird verwendet, um die geeignete Sampling-Methode für das AnimateDiff-Modell in ComfyUI Vid2Vid auszuwählen.

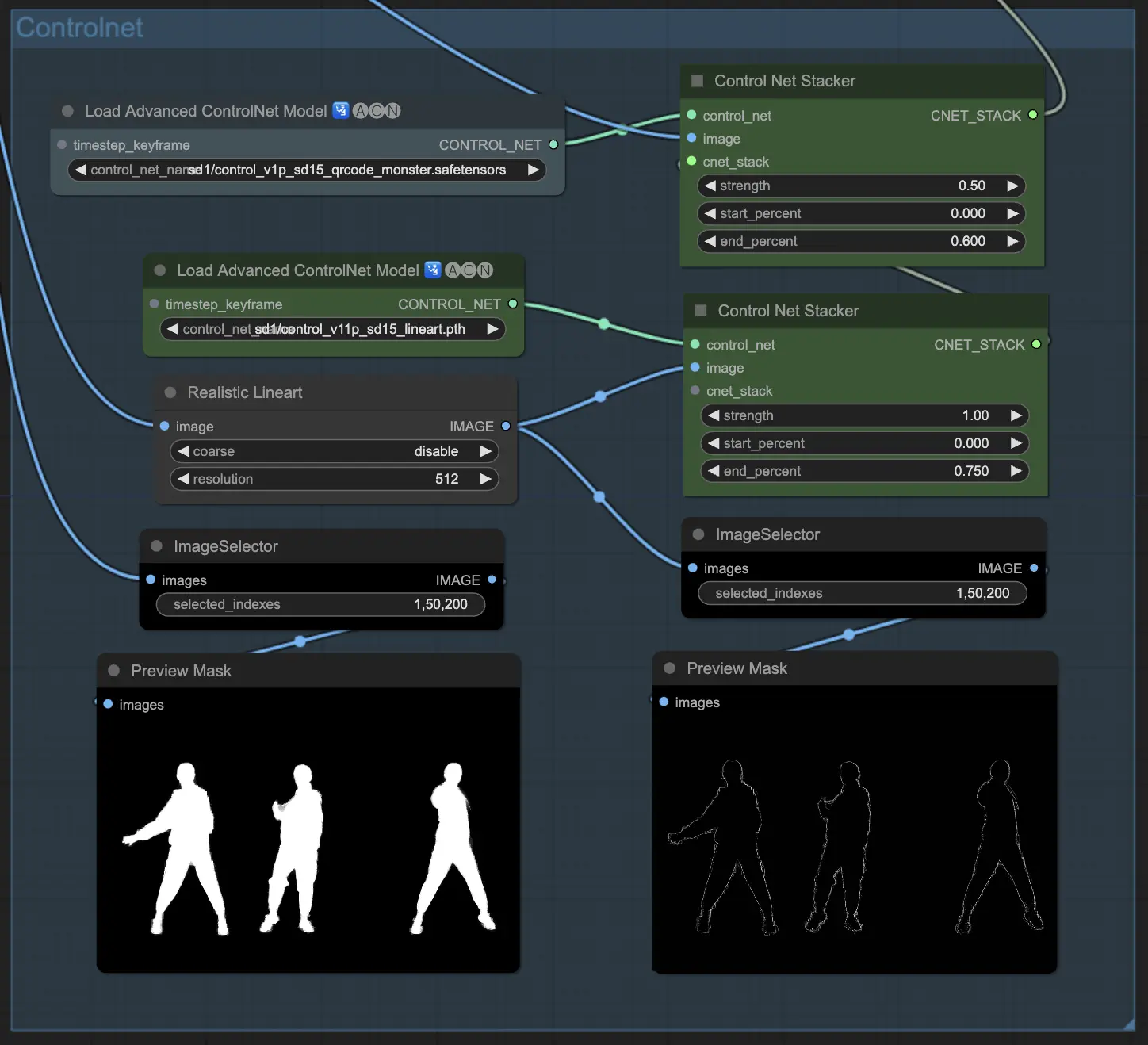

2.4 Ausgabe mit ControlNet leiten

- ControlNet wird verwendet, um die Form und Umrisse des Subjekts in der Ausgabesanimation zu leiten und zu definieren.

- Die ControlNetLoaderAdvanced-Komponenten werden verwendet, um die ControlNet-Modelle zu laden. Dieser Workflow verwendet zwei ControlNet-Modelle: QR Code Monster und Lineart.

- Die ControlNet Stacker-Komponenten werden verwendet, um die ControlNet-Ausgaben mit einstellbaren Stärken in ComfyUI Vid2Vid Transfer zu stapeln und zu kombinieren.

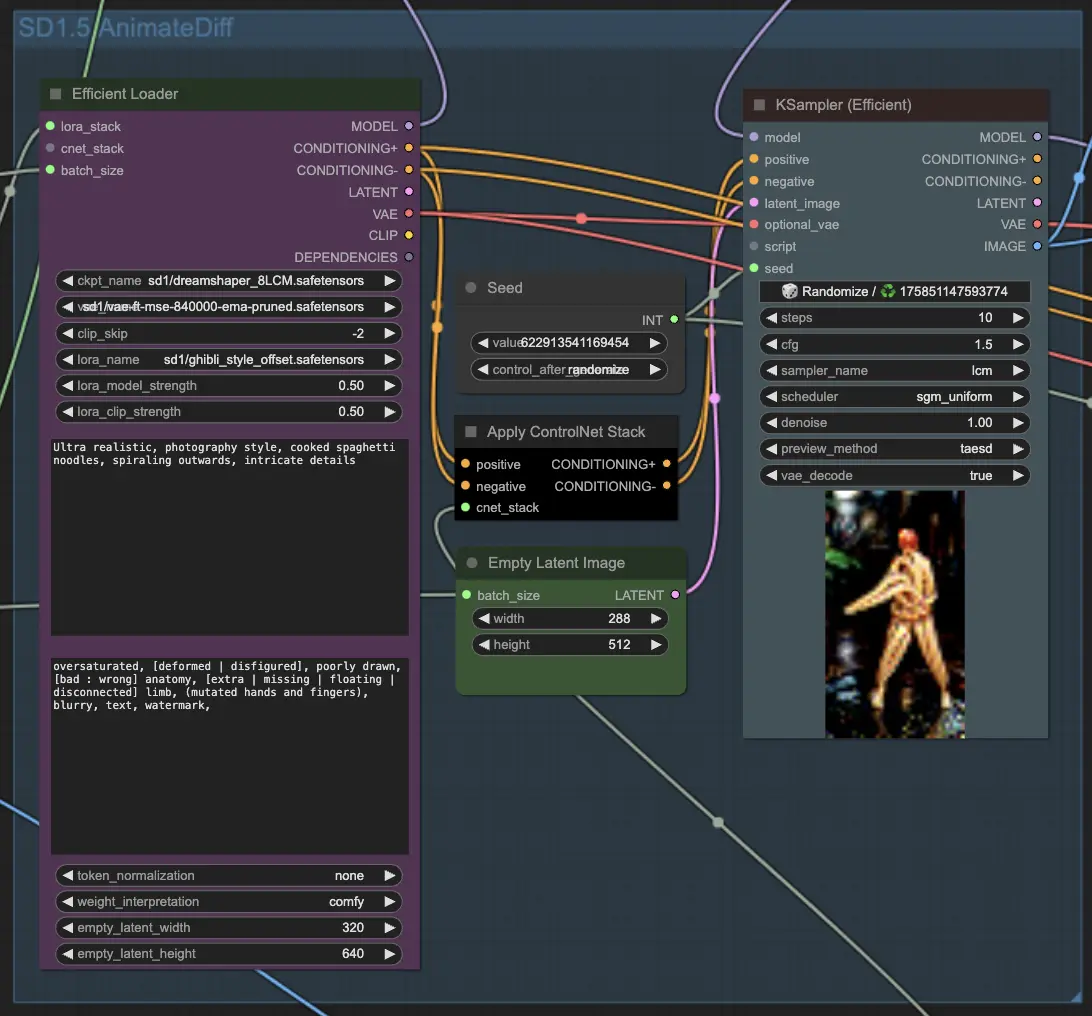

2.5 Ausgabeframes mit KSampler generieren

- Die KSampler (Efficient)-Komponenten in ComfyUI Vid2Vid sind für die Generierung der Ausgabeframes basierend auf allen bereitgestellten Konfigurationen und Eingaben verantwortlich.

- Die Haupt-KSampler-Komponente verarbeitet die Videoframes, um die Animationsvorschau zu erstellen. Sie nimmt das AnimateDiff-Modell, IPAdapter-Ausgaben, ControlNet-Stack und andere Einstellungen als Eingaben.

- Die zweite KSampler-Komponente wird zum Upscaling und Denoising der ComfyUI Vid2Vid-Ausgabeframes verwendet.

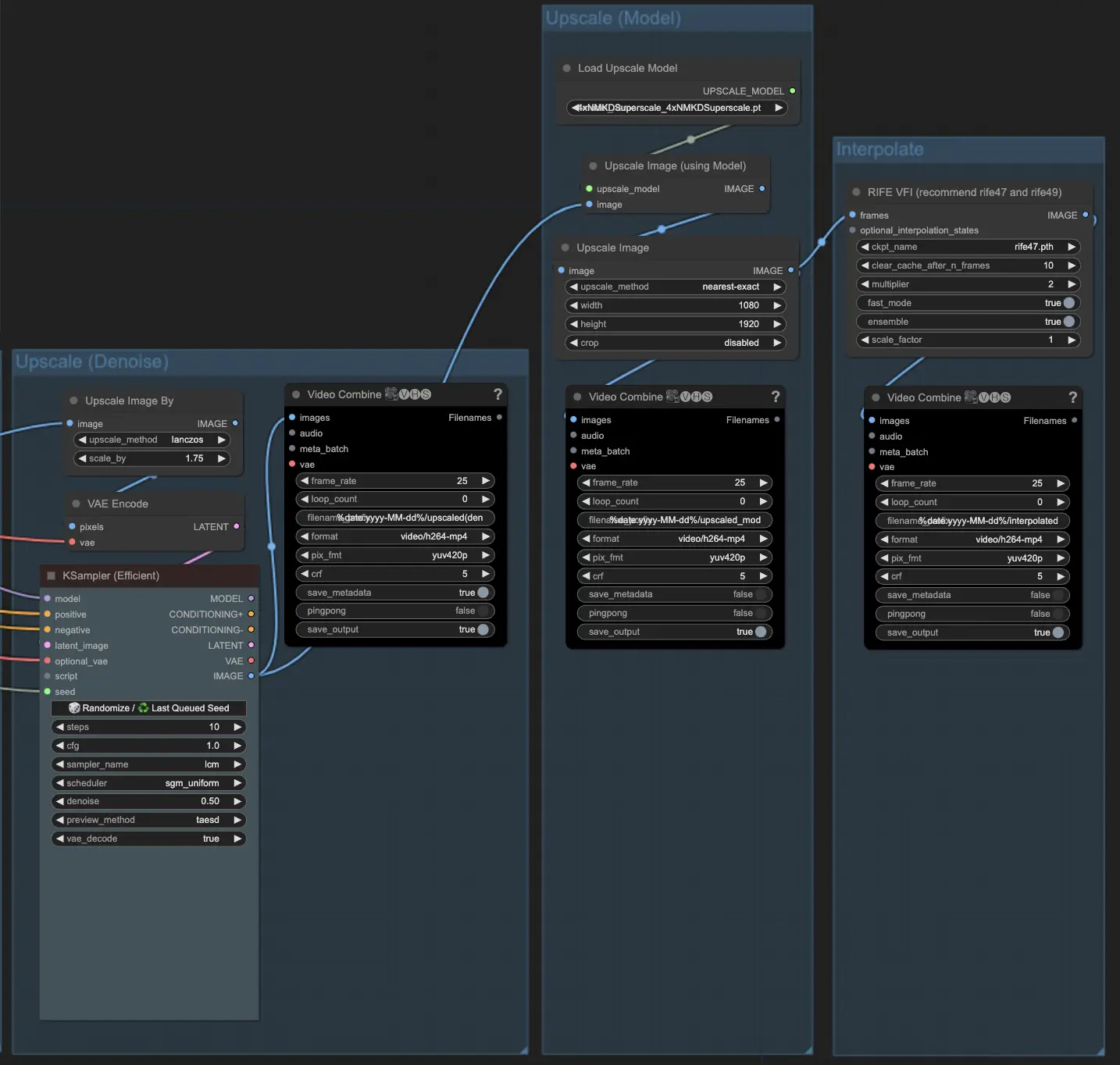

2.6 Falls erforderlich, Upscaling

- Die ImageScaleBy-Komponente wird verwendet, um die Auflösung der Ausgabeframes zu skalieren. Die ImageUpscaleWithModel-Komponente wird verwendet, um die Frames weiter mit einem ausgewählten Upscale-Modell zu skalieren. Der Workflow deaktiviert standardmäßig die Upscale-Komponenten. Wenn Sie es benötigen, aktivieren Sie diese Komponenten für ein besseres Ergebnis.