Dieser Workflow ist von enigmatic_e inspiriert, mit einigen Modifikationen. Für weitere Informationen besuchen Sie bitte seinen YouTube-Kanal.

Dieser Workflow ermöglicht es Ihnen, normale Videos mit AnimateDiff, ControlNet und IPAdapter in bezaubernde japanische Anime-Kreationen zu verwandeln. Experimentieren Sie mit verschiedenen Checkpoints, LoRA-Einstellungen und Referenzbildern für den IPAdapter, um Ihren einzigartigen Stil zu kreieren. Es ist eine unterhaltsame und kreative Art, Ihre Videos in der Anime-Welt zum Leben zu erwecken!

Bitte lesen Sie die Details unter Wie man AnimateDiff in ComfyUI verwendet

ControlNet revolutioniert die Art und Weise, wie wir Bilder generieren, indem es eine neue Ebene der räumlichen Kontrolle in Text-zu-Bild-Diffusionsmodelle einbringt. Diese hochmoderne neuronale Netzwerkarchitektur arbeitet wunderbar mit Giganten wie Stable Diffusion zusammen und nutzt deren riesige Bibliotheken - geschmiedet aus Milliarden von Bildern -, um räumliche Nuancen direkt in das Gewebe der Bilderstellung einzuweben. Vom Skizzieren von Kanten bis hin zur Abbildung menschlicher Haltungen, Tiefenwahrnehmung oder Segmentierung von Bildern ermöglicht ControlNet, die Bildgestaltung in einer Weise zu formen, die weit über den Bereich reiner Textanweisungen hinausgeht.

Im Kern ist ControlNet genial einfach. Es beginnt damit, die Integrität der ursprünglichen Modellparameter zu schützen und das Basistraining intakt zu halten. Dann führt ControlNet einen gespiegelten Satz der Kodierungsschichten des Modells ein, aber mit einer Besonderheit: Sie werden mit "Zero Convolutions" trainiert. Diese Nullen als Ausgangspunkt bedeuten, dass die Schichten sanft neue räumliche Bedingungen einfalten, ohne Unruhe zu verursachen, und so sicherstellen, dass die ursprünglichen Fähigkeiten des Modells erhalten bleiben, auch wenn es sich auf neue Lernpfade begibt.

Sowohl ControlNets als auch T2I-Adapter spielen eine entscheidende Rolle bei der Konditionierung der Bilderzeugung, wobei jeder von ihnen unterschiedliche Vorteile bietet. T2I-Adapter sind für ihre Effizienz bekannt, insbesondere in Bezug auf die Beschleunigung des Bildgenerierungsprozesses. Trotzdem sind ControlNets unübertroffen in ihrer Fähigkeit, den Generierungsprozess detailliert zu steuern, was sie zu einem leistungsstarken Werkzeug für Kreative macht.

In Anbetracht der funktionalen Überschneidungen zwischen vielen T2I-Adapter- und ControlNet-Modellen wird sich unsere Diskussion hauptsächlich auf ControlNets konzentrieren. Es ist jedoch erwähnenswert, dass die RunComfy-Plattform zur einfacheren Nutzung mehrere T2I-Adapter-Modelle vorgeladen hat. Wenn Sie mit T2I-Adaptern experimentieren möchten, können Sie diese Modelle nahtlos laden und in Ihre Projekte integrieren.

Die Wahl zwischen ControlNet- und T2I-Adapter-Modellen in ComfyUI hat keinen Einfluss auf die Verwendung von ControlNet-Nodes oder die Konsistenz des Workflows. Diese Einheitlichkeit gewährleistet einen optimierten Prozess, der es Ihnen ermöglicht, die einzigartigen Vorteile jedes Modelltyps entsprechend Ihren Projektanforderungen zu nutzen.

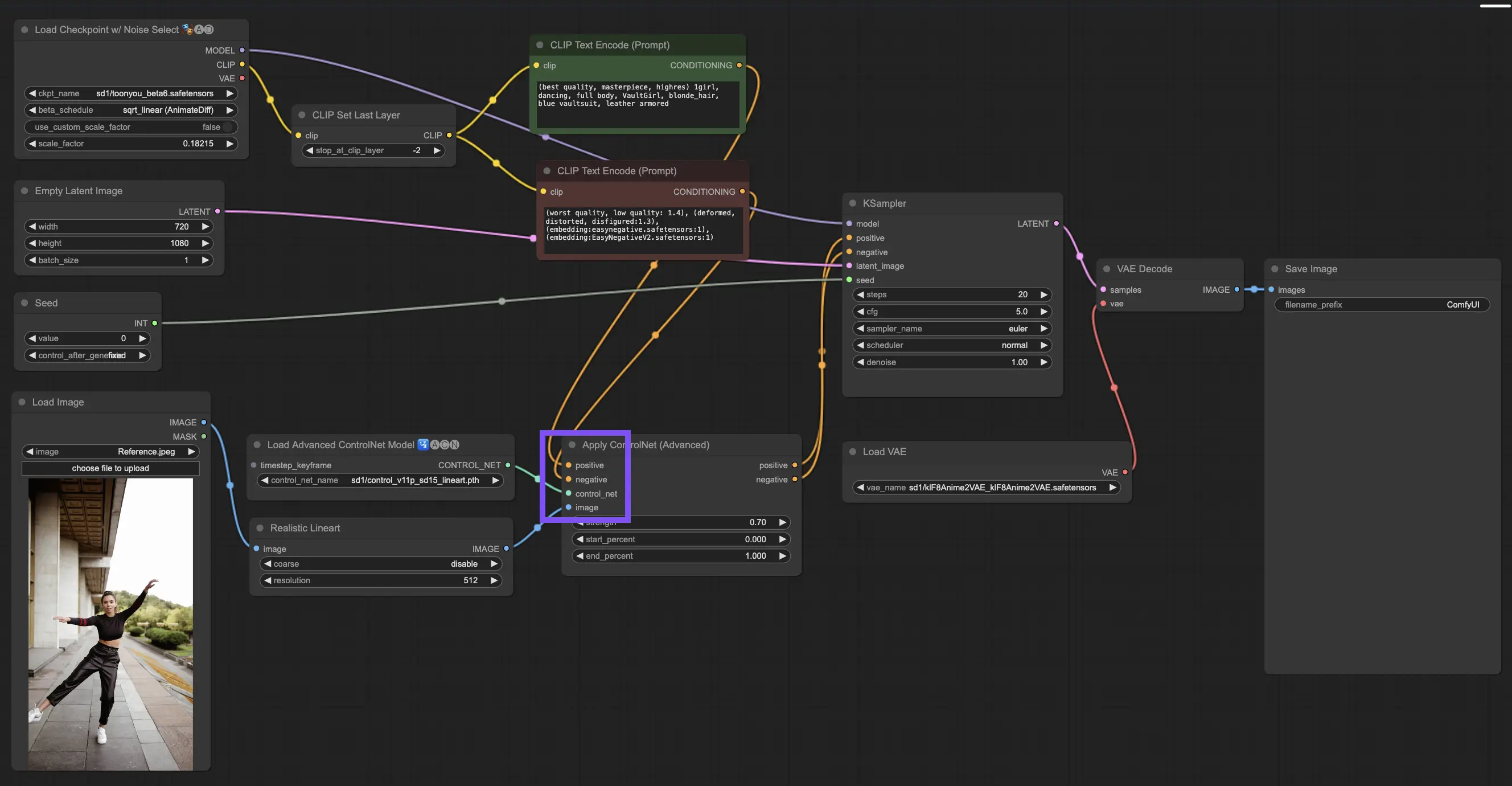

3.4.1. Laden des "Apply ControlNet"-Nodes

Zu Beginn müssen Sie den "Apply ControlNet"-Node in Ihr ComfyUI laden. Dies ist Ihr erster Schritt auf einer doppelt konditionierten Reise der Bilderstellung, die visuelle Elemente mit textuellen Prompts verbindet.

3.4.2. Die Eingänge des "Apply ControlNet"-Nodes verstehen

Positive und negative Konditionierung: Dies sind Ihre Werkzeuge, um das endgültige Bild zu formen - was es enthalten und was es vermeiden soll. Verbinden Sie diese mit den Slots "Positive prompt" und "Negative prompt", um sie mit dem textbasierten Teil Ihrer kreativen Anweisung zu synchronisieren.

Auswahl des ControlNet-Modells: Sie müssen diesen Eingang mit dem Ausgang des "Load ControlNet Model"-Nodes verbinden. Hier entscheiden Sie, ob Sie ein ControlNet- oder ein T2IAdaptor-Modell verwenden möchten, je nachdem, welche spezifischen Merkmale oder Stile Sie anstreben. Während wir uns auf ControlNet-Modelle konzentrieren, lohnt es sich, einige begehrte T2IAdaptors für einen umfassenden Überblick zu erwähnen.

Vorverarbeitung Ihres Bildes: Verbinden Sie Ihr Bild mit einem "ControlNet Preprocessor"-Node, der entscheidend dafür ist, dass Ihr Bild ControlNet-ready ist. Es ist wichtig, den Preprocessor auf Ihr ControlNet-Modell abzustimmen. Dieser Schritt passt Ihr Originalbild an die Anforderungen des Modells an - Größenänderung, Umfärben oder Anwenden notwendiger Filter -, um es für die Verwendung durch ControlNet vorzubereiten.

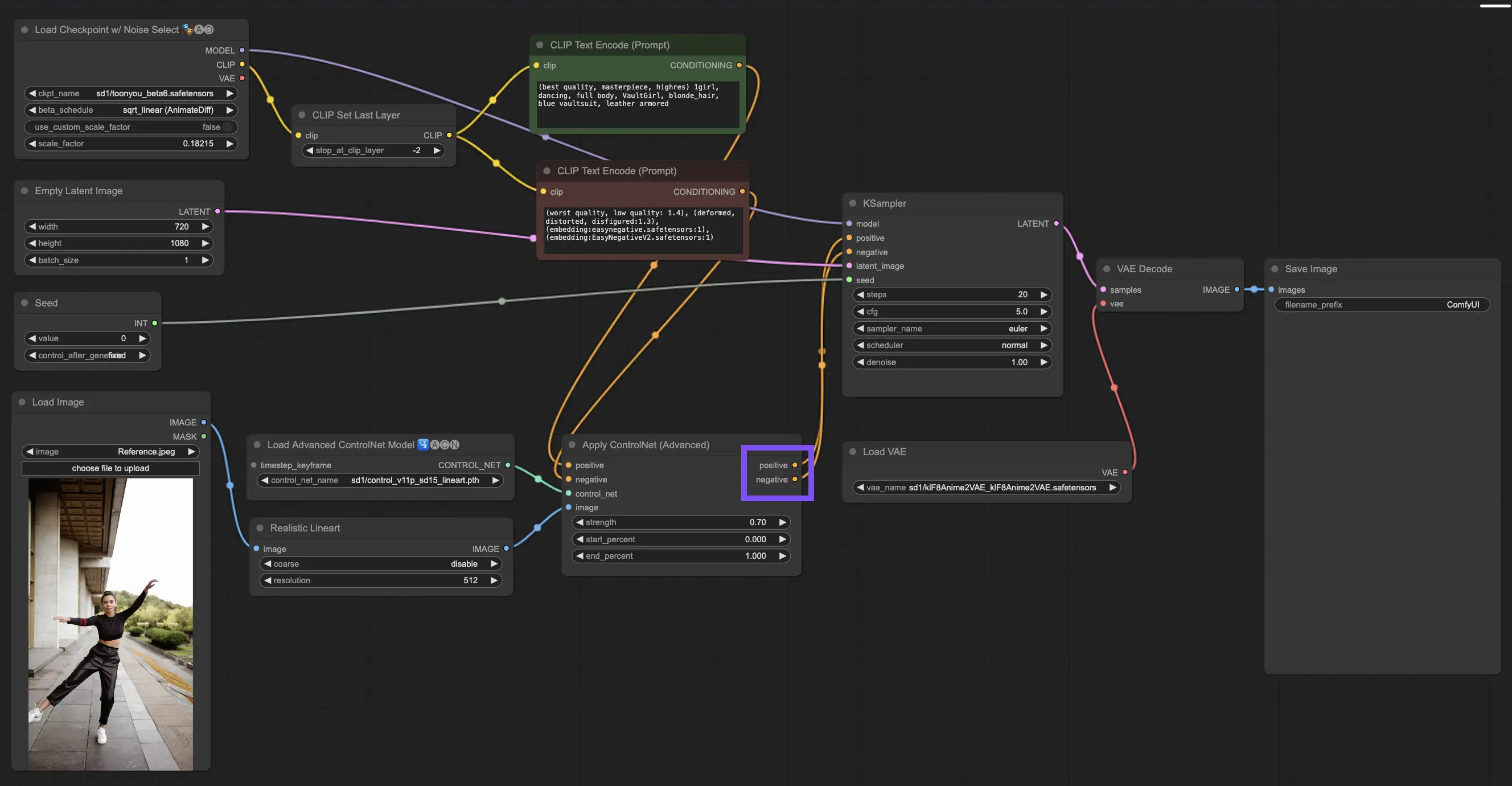

3.4.3. Die Ausgänge des "Apply ControlNet"-Nodes verstehen

Nach der Verarbeitung präsentiert der "Apply ControlNet"-Node zwei Ausgänge, die das komplexe Zusammenspiel von ControlNet und Ihrem kreativen Input widerspiegeln: Positive und negative Konditionierung. Diese Ausgänge steuern das Diffusionsmodell innerhalb von ComfyUI und führen zu Ihrer nächsten Wahl: Verfeinern Sie das Bild mit dem KSampler oder tauchen Sie tiefer ein, indem Sie weitere ControlNets für diejenigen stapeln, die unübertroffene Details und Anpassungen suchen.

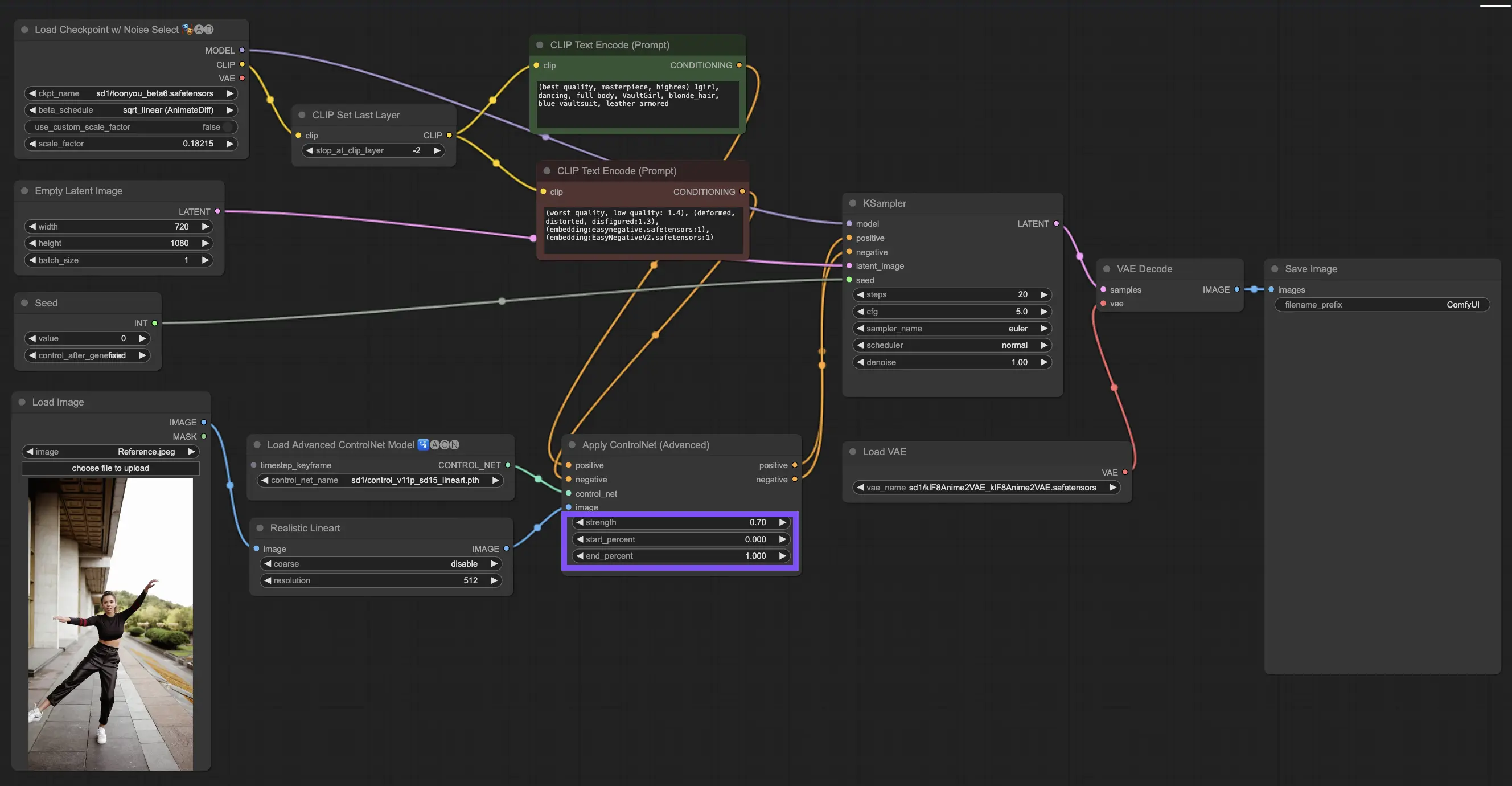

3.4.4. "Apply ControlNet" für beste Ergebnisse optimieren

Stärke bestimmen: Diese Einstellung steuert, wie stark ControlNet das resultierende Bild beeinflusst. Ein volles 1.0 bedeutet, dass der Input von ControlNet die Zügel in der Hand hat, während das Herunterdrehen auf 0.0 dem Modell erlaubt, ohne den Einfluss von ControlNet zu laufen.

Startprozent anpassen: Dies gibt an, wann ControlNet während des Diffusionsprozesses mit eingreift. Zum Beispiel bedeutet ein Start von 20%, dass ControlNet ab einem Fünftel des Weges beginnt, seine Spuren zu hinterlassen.

Endprozent einstellen: Dies ist die Kehrseite des Startprozents und markiert, wann ControlNet sich verabschiedet. Wenn Sie es auf 80% einstellen, verblasst der Einfluss von ControlNet, wenn sich das Bild den letzten Stadien nähert, und bleibt in der letzten Strecke unberührt von ControlNet.

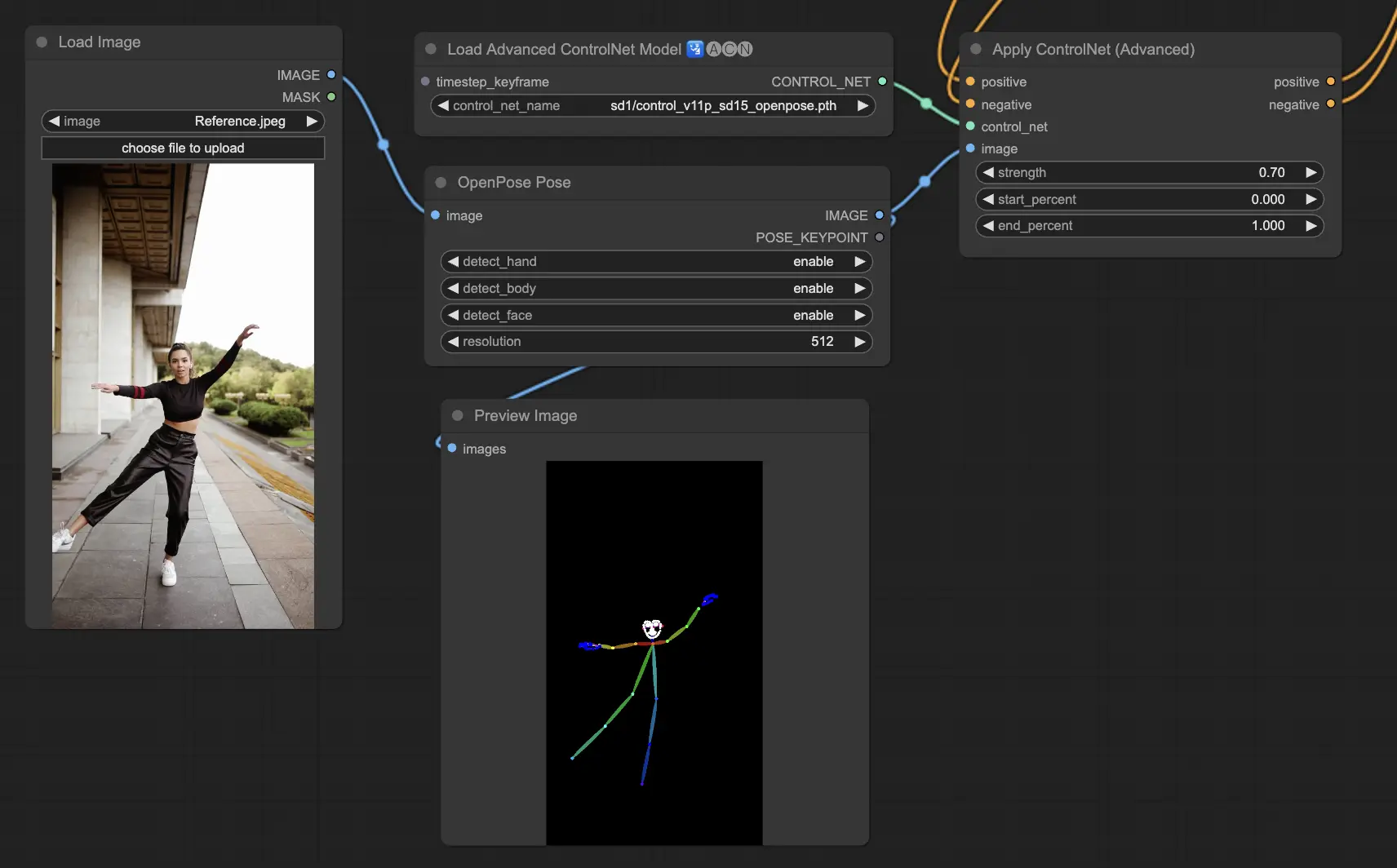

3.5.1. ControlNet-Modell: Openpose

Zu den Preprocessor-Optionen gehören: Openpose oder DWpose

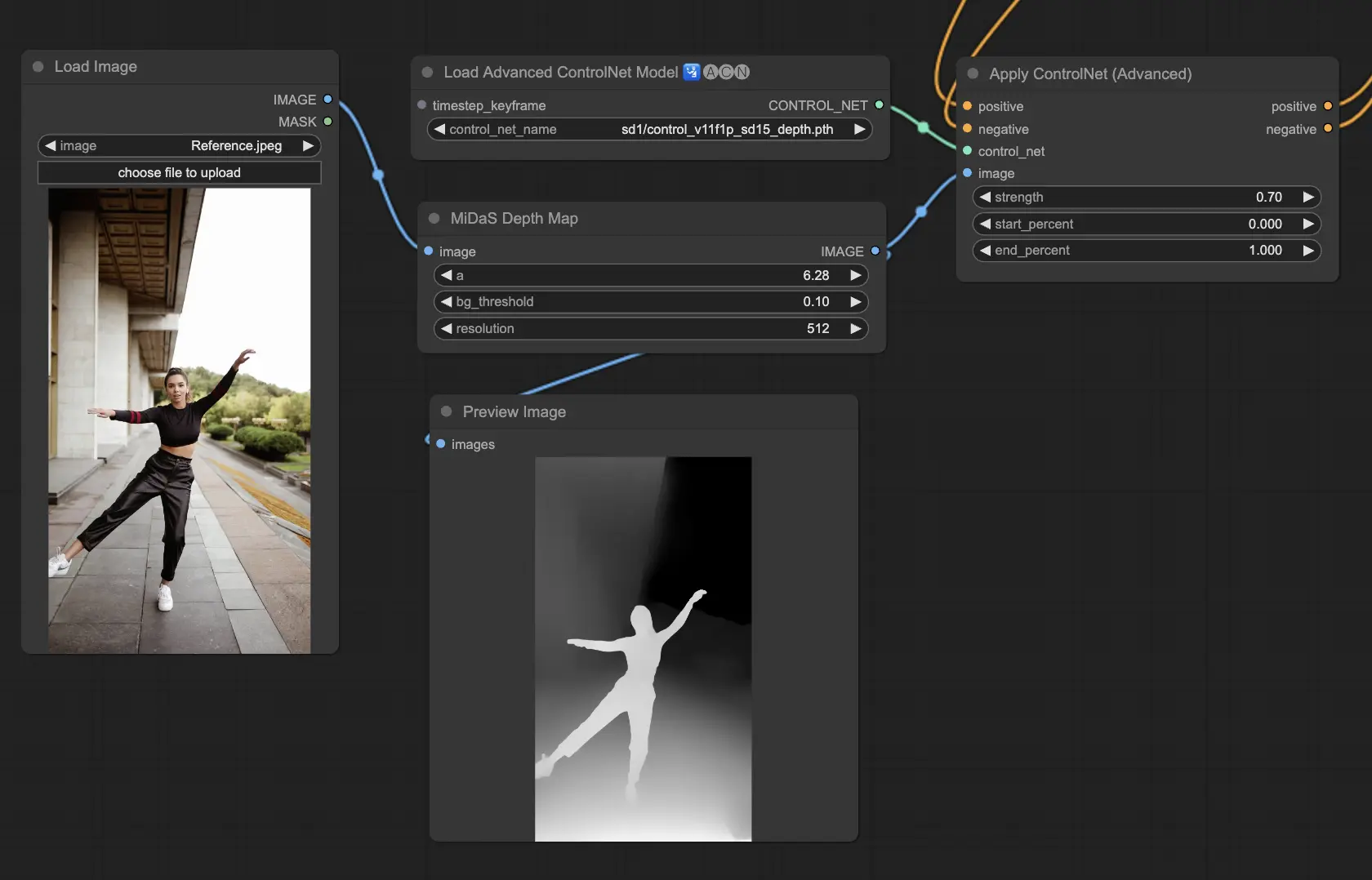

3.5.2. ControlNet-Modell: Depth

Depth-Modelle verwenden ein 2D-Bild, um die Tiefe abzuleiten und sie als Graustufenkarte darzustellen. Jedes hat seine Stärken in Bezug auf Detailgenauigkeit oder Hintergrundkonzentration:

Zu den empfohlenen Preprocessoren gehören: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Dieses Modell zeichnet sich durch Robustheit und Kompatibilität mit tatsächlichen Tiefenkarten von Rendering-Engines aus.

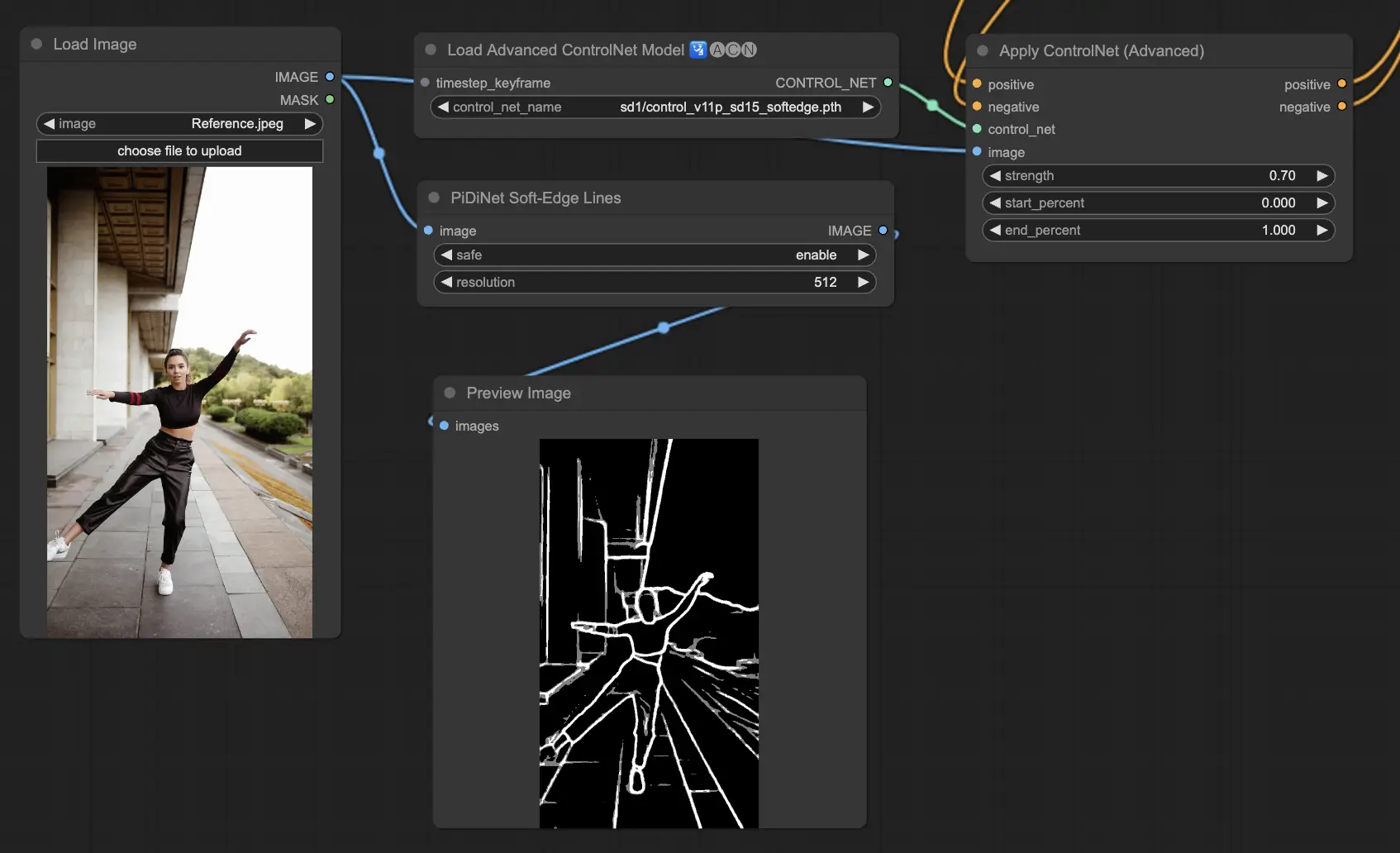

3.5.3. ControlNet-Modell: SoftEdge

ControlNet Soft Edge ist darauf ausgelegt, Bilder mit weicheren Kanten zu erzeugen, die Details verbessern und gleichzeitig ein natürliches Aussehen bewahren. Es nutzt modernste neuronale Netze für eine verfeinerte Bildmanipulation und bietet umfangreiche kreative Kontrolle und nahtlose Integration.

In Bezug auf die Robustheit: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Für die höchste Ergebnisqualität: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Als allgemeine Empfehlung ist SoftEdge_PIDI die erste Wahl, da es in der Regel hervorragende Ergebnisse liefert.

Zu den Preprocessoren gehören: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

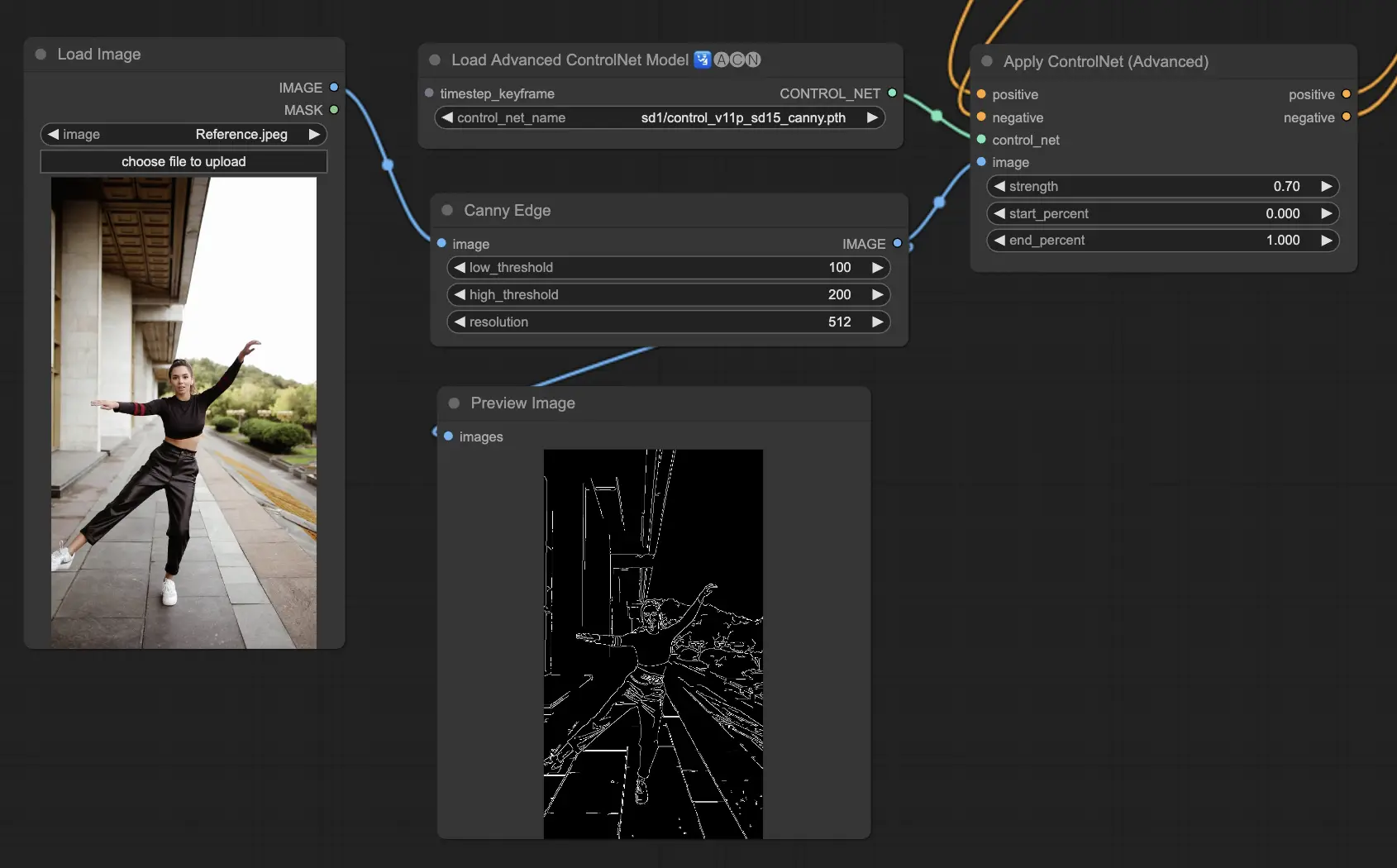

3.5.4. ControlNet-Modell: Canny

Das Canny-Modell implementiert die Canny-Kantenerkennung, um ein breites Spektrum von Kanten innerhalb von Bildern hervorzuheben. Dieses Modell eignet sich hervorragend, um die Integrität von Strukturelementen zu erhalten und gleichzeitig das Gesamterscheinungsbild des Bildes zu vereinfachen, was bei der Erstellung von stilisierter Kunst oder der Vorbereitung von Bildern für die weitere Bearbeitung hilfreich ist.

Verfügbare Preprocessoren: Canny

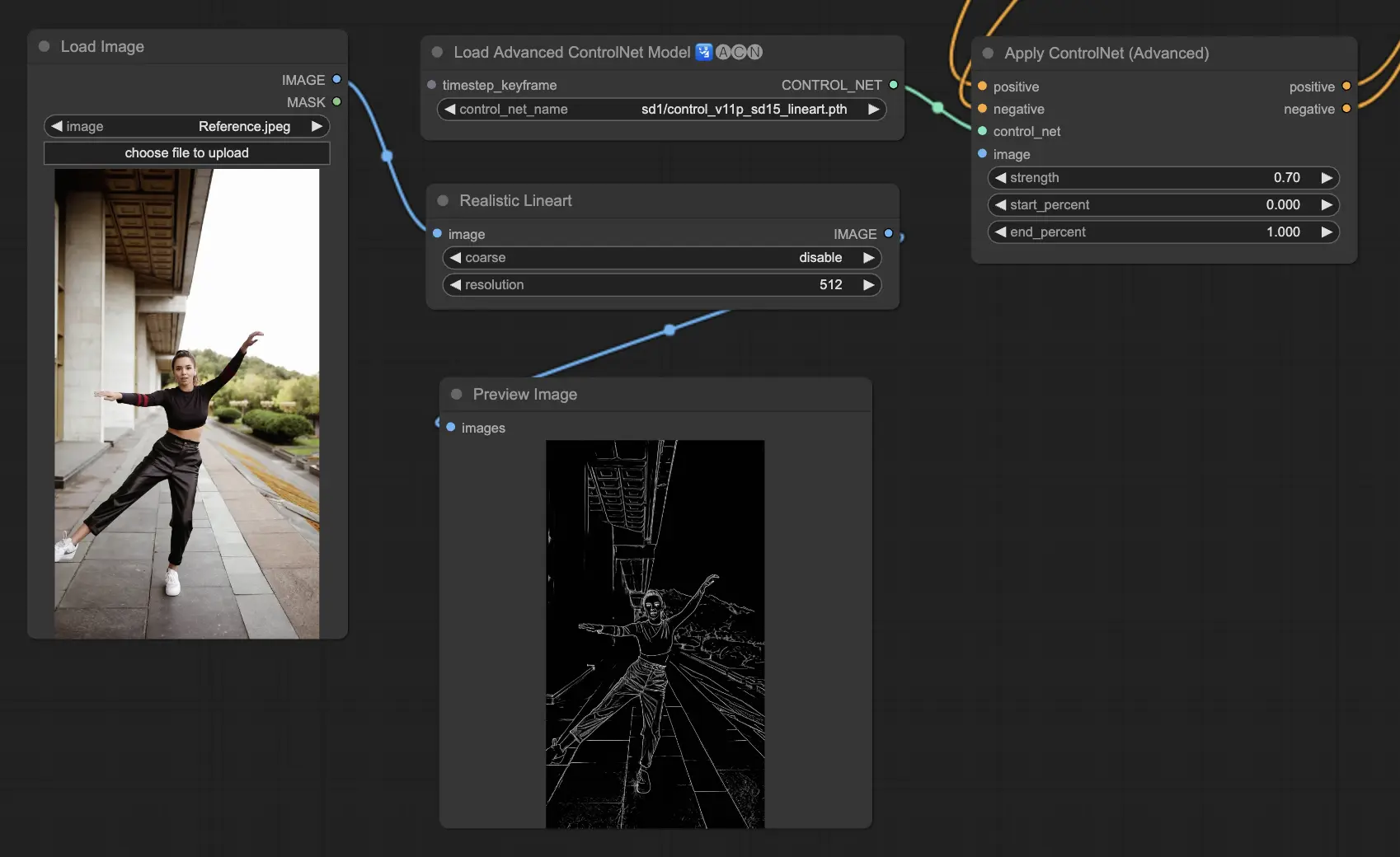

3.5.5. ControlNet-Modell: Lineart

Lineart-Modelle sind Ihre Werkzeuge, um Bilder in stilisierte Strichzeichnungen zu verwandeln, die für eine Vielzahl von künstlerischen Anwendungen geeignet sind:

Verfügbare Preprocessoren können entweder detaillierte oder ausgeprägtere Lineart erzeugen (Lineart und Lineart_Coarse).

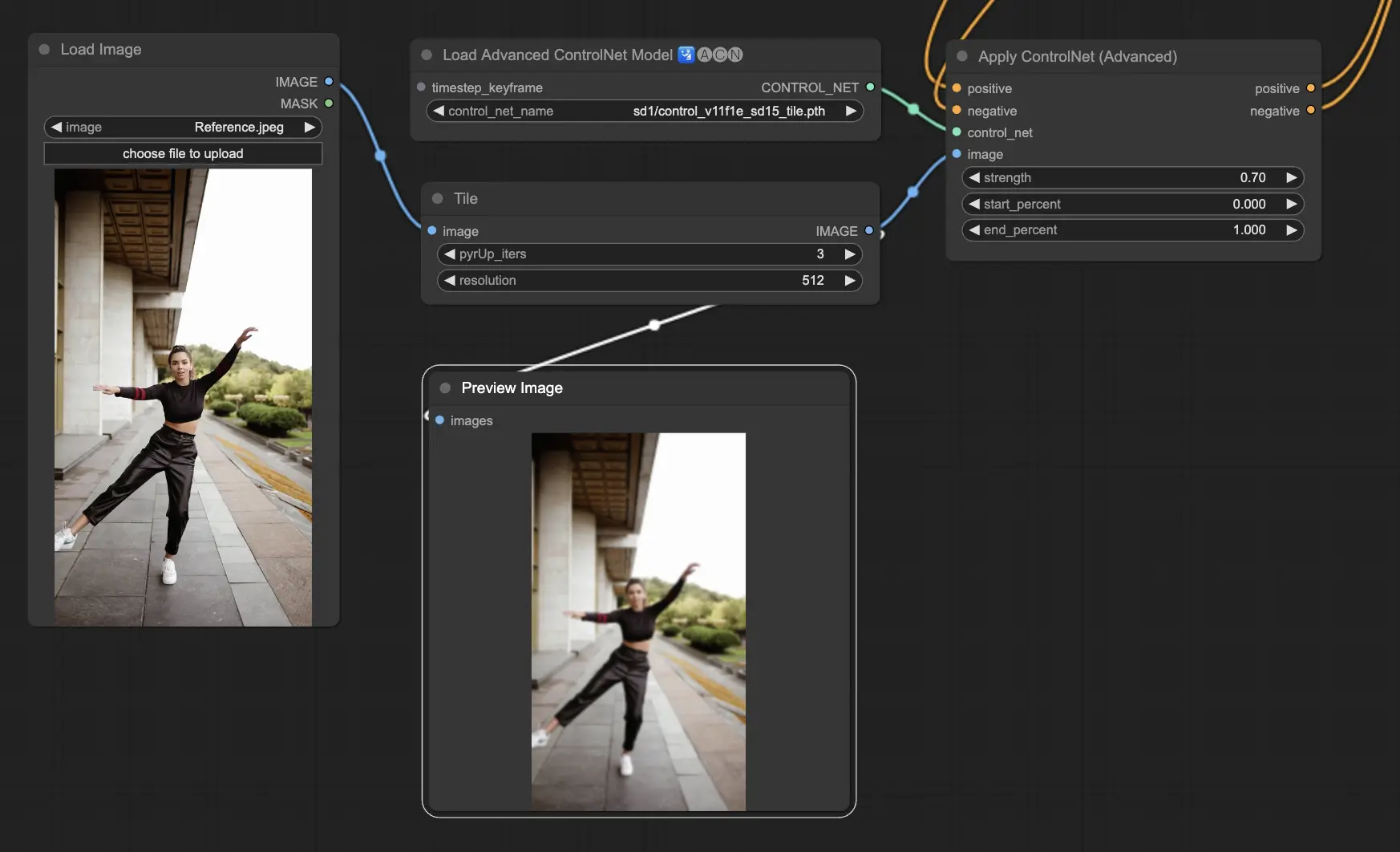

3.5.6. ControlNet-Modell: Tile

Das Tile Resample-Modell zeichnet sich dadurch aus, dass es Details in Bildern hervorhebt. Es ist besonders effektiv, wenn es zusammen mit einem Upscaler verwendet wird, um die Bildauflösung und -details zu verbessern, und wird häufig angewendet, um Bildtexturen und -elemente zu schärfen und zu bereichern.

Empfohlener Preprocessor: Tile

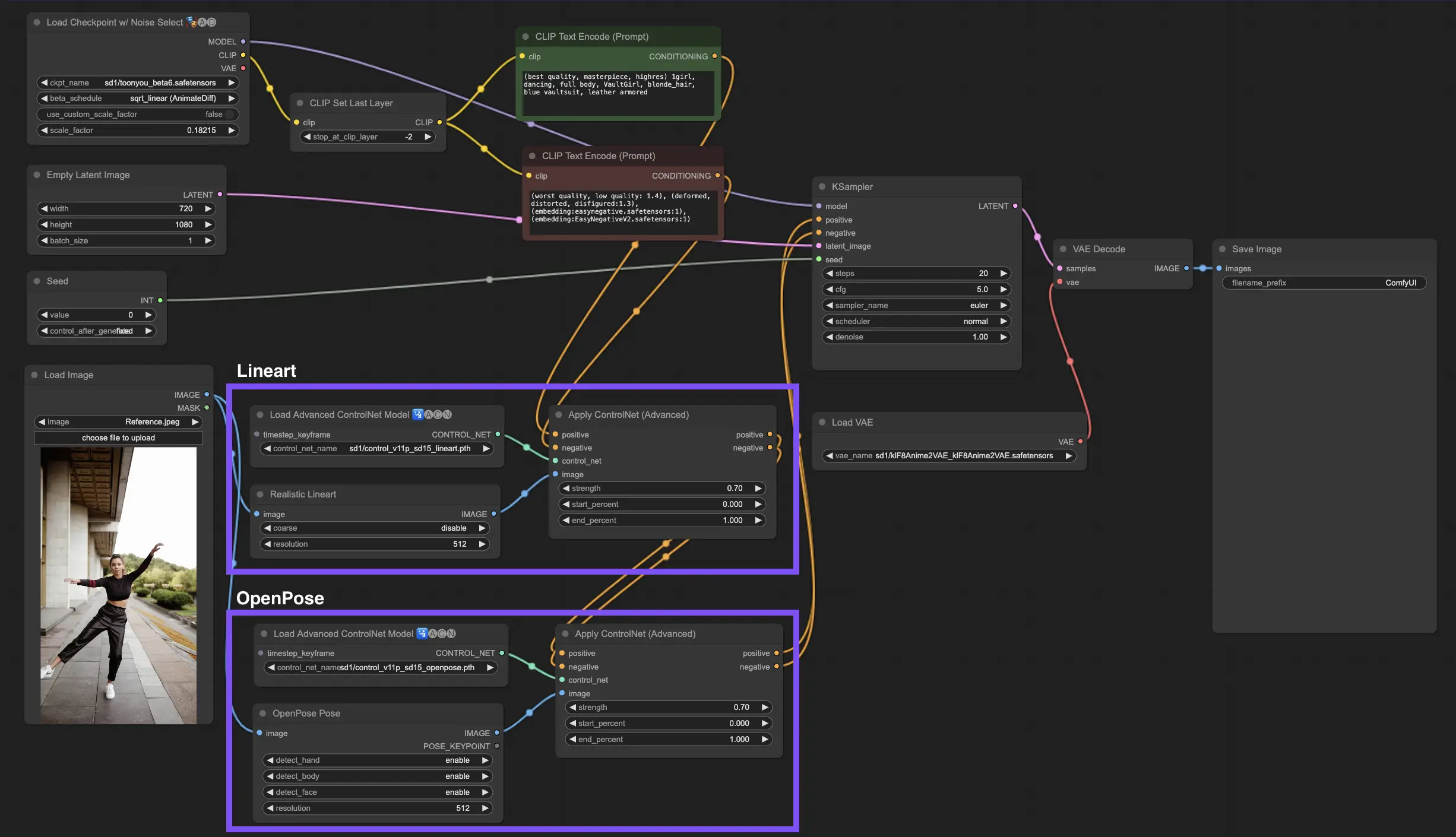

Die Einbindung mehrerer ControlNets oder T2I-Adapter ermöglicht die sequenzielle Anwendung verschiedener Konditionierungsarten auf Ihren Bildgenerierungsprozess. Zum Beispiel können Sie Lineart- und OpenPose-ControlNets für eine verbesserte Detaillierung kombinieren.

Lineart für Objektformen: Beginnen Sie mit der Integration eines Lineart-ControlNets, um Objekten oder Elementen in Ihren Bildern Tiefe und Details zu verleihen. Dieser Prozess beinhaltet die Vorbereitung einer Lineart- oder Canny-Karte für die Objekte, die Sie einbeziehen möchten.

OpenPose für die Posenkontrolle: Nach der Lineart-Detaillierung nutzen Sie das OpenPose-ControlNet, um die Pose der Personen innerhalb Ihres Bildes zu bestimmen. Sie müssen eine OpenPose-Karte generieren oder erwerben, die die gewünschte Pose erfasst.

Sequenzielle Anwendung: Um diese Effekte effektiv zu kombinieren, verbinden Sie den Ausgang des Lineart-ControlNets mit dem OpenPose-ControlNet. Diese Methode stellt sicher, dass sowohl die Pose der Personen als auch die Formen der Objekte gleichzeitig während des Generierungsprozesses gesteuert werden, was zu einem Ergebnis führt, das harmonisch mit allen Eingabespezifikationen übereinstimmt.

Bitte lesen Sie die Details unter Wie man IPAdapter in ComfyUI verwendet

RunComfy ist die führende ComfyUI Plattform, die ComfyUI online Umgebung und Services bietet, zusammen mit ComfyUI Workflows mit atemberaubenden Visualisierungen. RunComfy bietet auch AI-Spielplatz, Künstlern ermöglichen, die neuesten AI-Tools zu nutzen, um unglaubliche Kunst zu schaffen.