LatentSync| Lip-Sync-Modell

LatentSync definiert das Lip-Syncing mit audio-konditionierten latenten Diffusionsmodellen neu und umgeht Zwischenbewegungsdarstellungen für eine nahtlose audio-visuelle Ausrichtung. Durch die Nutzung von Stable Diffusion erfasst es komplexe Korrelationen und gewährleistet zeitliche Geschmeidigkeit. Im Gegensatz zu pixelbasierten Ansätzen sorgt LatentSync mit seinem innovativen Temporal REPresentation Alignment (TREPA)-Modul für überlegene zeitliche Konsistenz. Das TREPA-Modul hilft, unübertroffene Genauigkeit und Realismus zu liefern.ComfyUI LatentSync Arbeitsablauf

- Voll funktionsfähige Workflows

- Keine fehlenden Nodes oder Modelle

- Keine manuelle Einrichtung erforderlich

- Beeindruckende Visualisierungen

ComfyUI LatentSync Beispiele

ComfyUI LatentSync Beschreibung

LatentSync ist ein hochmodernes End-to-End-Lip-Sync-Framework, das die Leistung von audio-konditionierten latenten Diffusionsmodellen für die realistische Lip-Sync-Generierung nutzt. Was LatentSync auszeichnet, ist seine Fähigkeit, die komplexen Korrelationen zwischen Audio- und visuellen Komponenten direkt zu modellieren, ohne auf eine Zwischenbewegungsdarstellung angewiesen zu sein, und damit den Ansatz zur Lip-Sync-Synthese zu revolutionieren.

Im Kern der LatentSync-Pipeline steht die Integration von Stable Diffusion, einem leistungsstarken generativen Modell, das für seine außergewöhnliche Fähigkeit bekannt ist, qualitativ hochwertige Bilder zu erfassen und zu erzeugen. Durch die Nutzung der Fähigkeiten von Stable Diffusion kann LatentSync die komplexen Dynamiken zwischen Sprach-Audio und den entsprechenden Lippenbewegungen effektiv lernen und reproduzieren, was zu hochgradig genauen und überzeugenden Lip-Sync-Animationen führt.

Eine der größten Herausforderungen bei diffusionsbasierten Lip-Sync-Methoden ist die Aufrechterhaltung der zeitlichen Konsistenz über die erzeugten Frames hinweg, was für realistische Ergebnisse entscheidend ist. LatentSync geht dieses Problem mit seinem bahnbrechenden Temporal REPresentation Alignment (TREPA)-Modul direkt an, das speziell entwickelt wurde, um die zeitliche Kohärenz von Lip-Sync-Animationen zu verbessern. TREPA verwendet fortschrittliche Techniken, um zeitliche Darstellungen aus den erzeugten Frames mit großflächigen selbstüberwachten Videomodellen zu extrahieren. Durch die Ausrichtung dieser Darstellungen auf die Ground-Truth-Frames stellt das LatentSync-Framework ein hohes Maß an zeitlicher Kohärenz sicher, was zu bemerkenswert geschmeidigen und überzeugenden Lip-Sync-Animationen führt, die eng mit dem Audioeingang übereinstimmen.

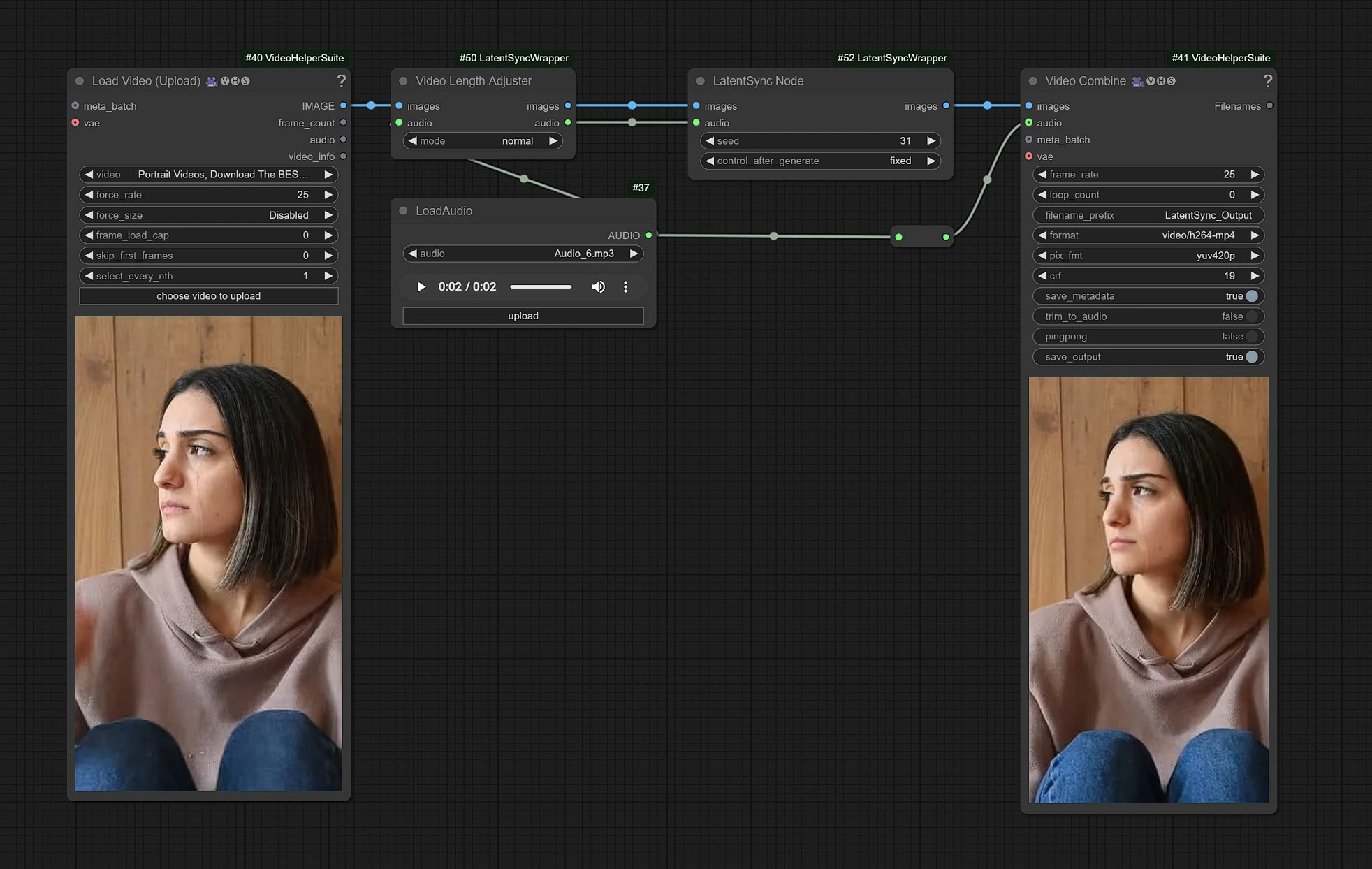

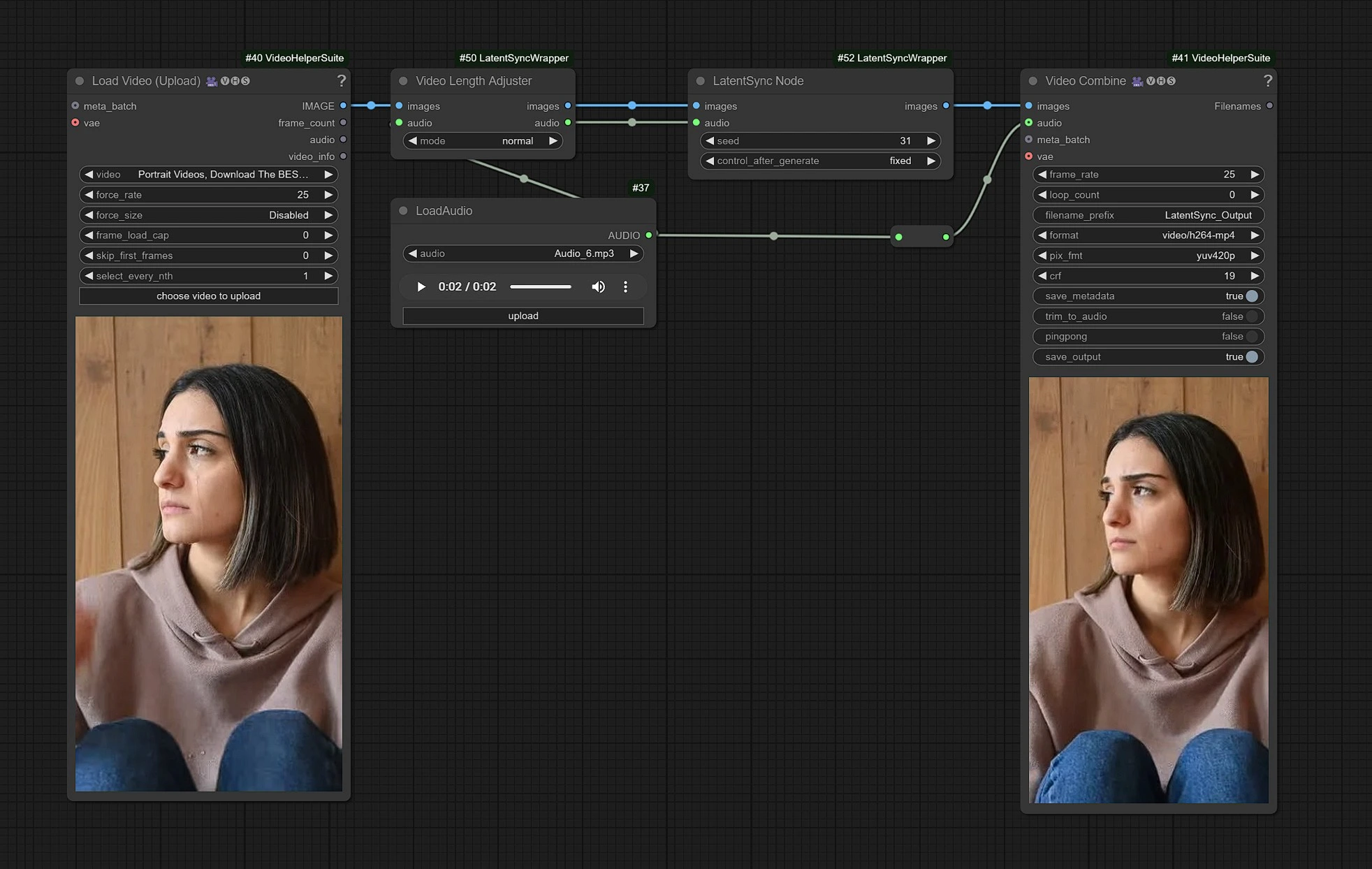

1.1 Wie verwendet man den LatentSync-Workflow?

Dies ist der LatentSync-Workflow. Auf der linken Seite befinden sich die Eingabeknoten für das Hochladen von Videos, in der Mitte die Verarbeitungsknoten von LatentSync und rechts der Ausgabeknoten.

- Laden Sie Ihr Video in den Eingabeknoten hoch.

- Laden Sie Ihr Audioeingang der Dialoge hoch.

- Klicken Sie auf Rendern!!!

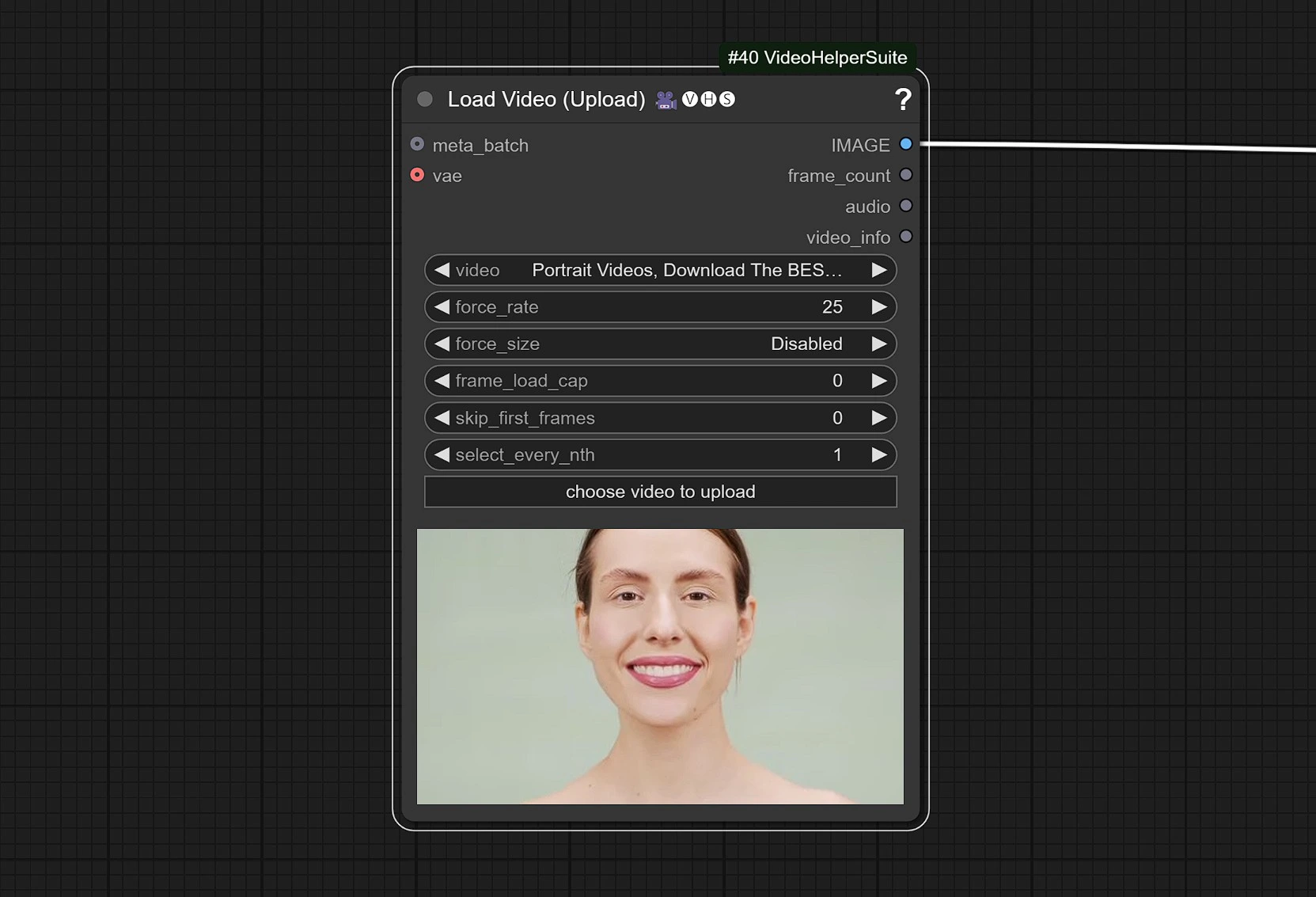

1.2 Videoeingang

- Klicken Sie und laden Sie Ihr Referenzvideo hoch, das ein Gesicht enthält.

Das Video wird auf 25 FPS eingestellt, um ordnungsgemäß mit dem Audiomodell zu synchronisieren.

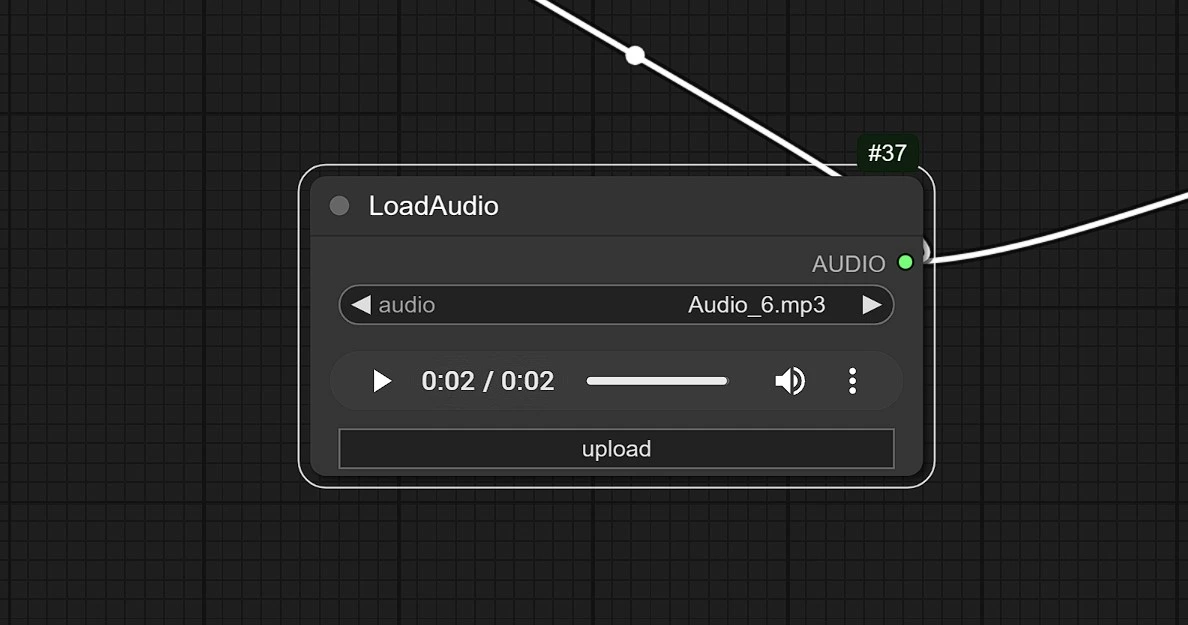

1.3 Audioeingang

- Klicken Sie und laden Sie hier Ihr Audio hoch.

LatentSync setzt mit seinem innovativen Ansatz zur audio-visuellen Generierung einen neuen Maßstab für Lip-Sync. Durch die Kombination von Präzision, zeitlicher Konsistenz und der Kraft von Stable Diffusion verändert LatentSync die Art und Weise, wie wir synchronisierte Inhalte erstellen. Definieren Sie, was im Lip-Sync möglich ist, mit LatentSync.