CogVideoX Tora | Modèle Image-à-Vidéo

CogVideoX Tora combine les forces des modèles de diffusion et des transformateurs en modélisant explicitement les trajectoires de mouvement, permettant un contrôle précis des mouvements et dynamiques des objets dans la génération vidéo. Cette approche orientée trajectoire améliore la cohérence temporelle et la fidélité visuelle, faisant de Tora une avancée significative pour des tâches telles que le montage vidéo, la synthèse et l'animation. Utilisez le workflow CogVideoX Tora pour créer des vidéos dynamiques et obtenir des transitions fluides et des mouvements dans les scènes animées.Flux de travail ComfyUI CogVideoX Tora

- Workflows entièrement opérationnels

- Aucun nœud ou modèle manquant

- Aucune configuration manuelle requise

- Propose des visuels époustouflants

Exemples ComfyUI CogVideoX Tora

Description ComfyUI CogVideoX Tora

Les nœuds et son workflow associé sont entièrement développés par Kijai. Nous rendons tout le crédit à Kijai pour ce travail innovant. Sur la plateforme RunComfy, nous présentons simplement les contributions de Kijai à la communauté. Il est important de noter qu'il n'y a actuellement aucune connexion formelle ou partenariat entre RunComfy et Kijai. Nous apprécions profondément le travail de Kijai!

CogVideoX Tora

Tora introduit un cadre novateur pour générer des vidéos de haute qualité en utilisant une guidance basée sur les trajectoires dans un modèle de transformateur de diffusion. En se concentrant sur les trajectoires de mouvement, Tora réalise une synthèse vidéo plus réaliste et cohérente dans le temps. Cette approche comble le fossé entre la modélisation spatio-temporelle et les cadres de diffusion générative.

Veuillez noter que cette version de Tora est basée sur le modèle CogVideoX-5B et est destinée uniquement à des fins de recherche académique. Pour les détails de licence, veuillez vous référer .

1.1 Comment utiliser le workflow CogVideoX Tora?

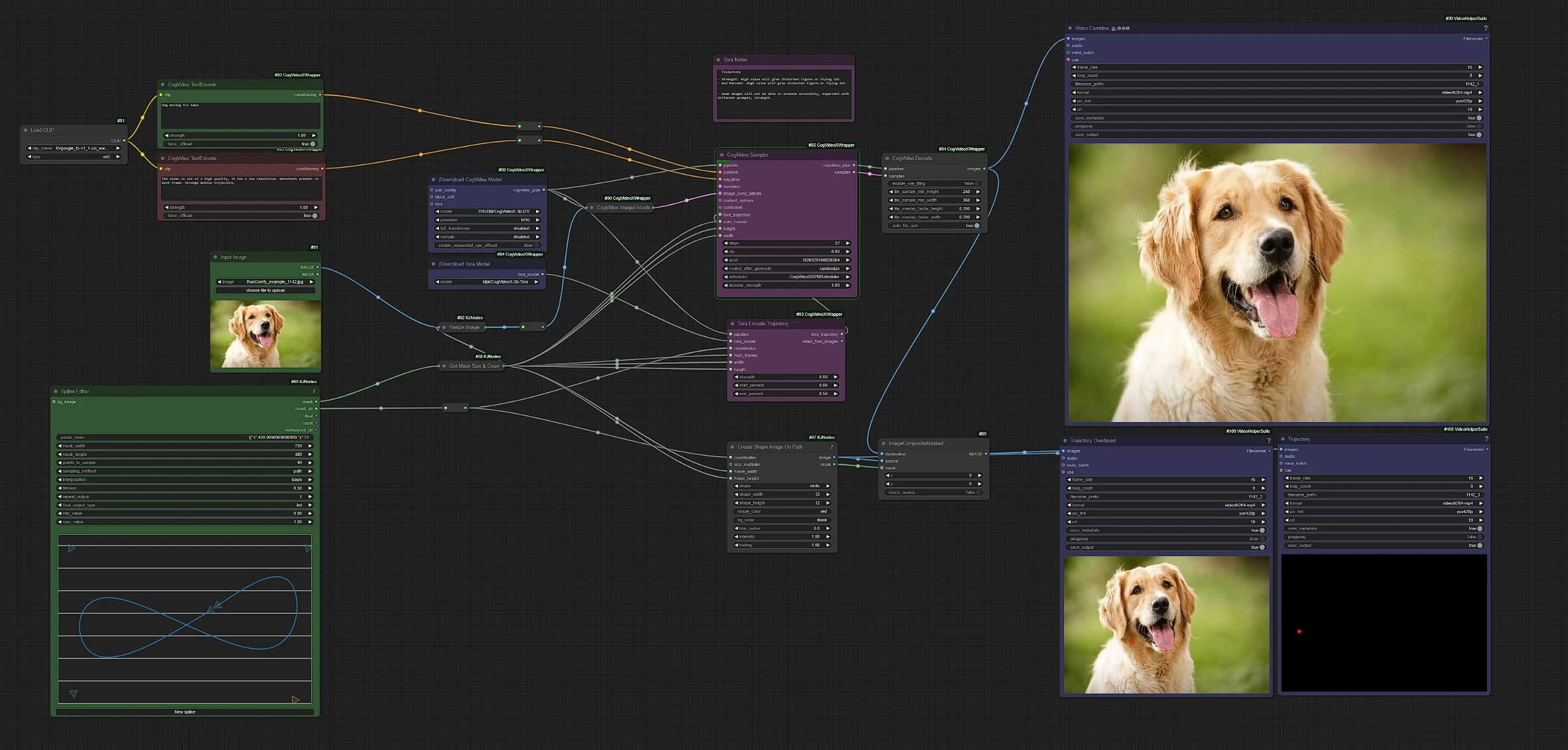

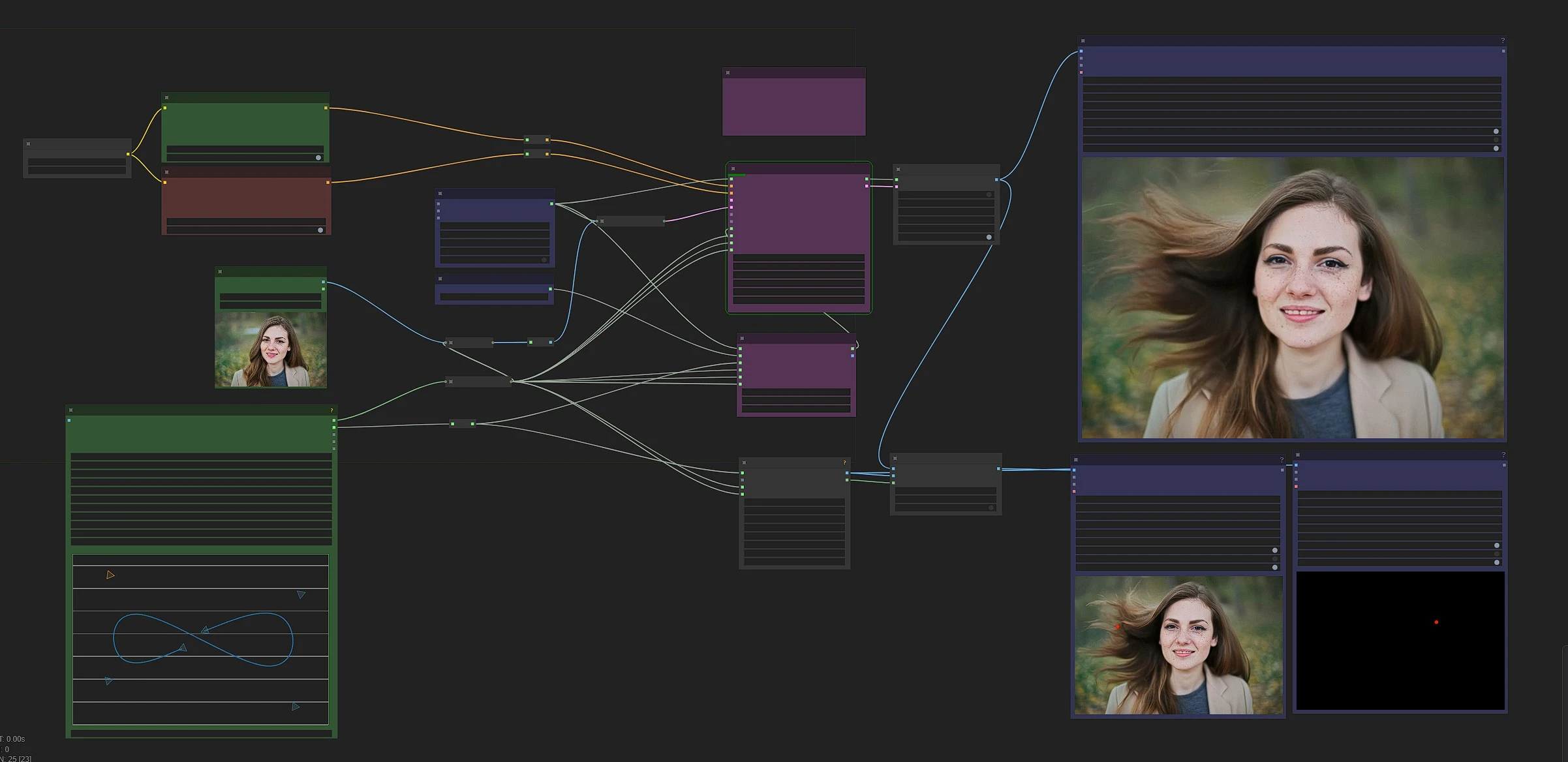

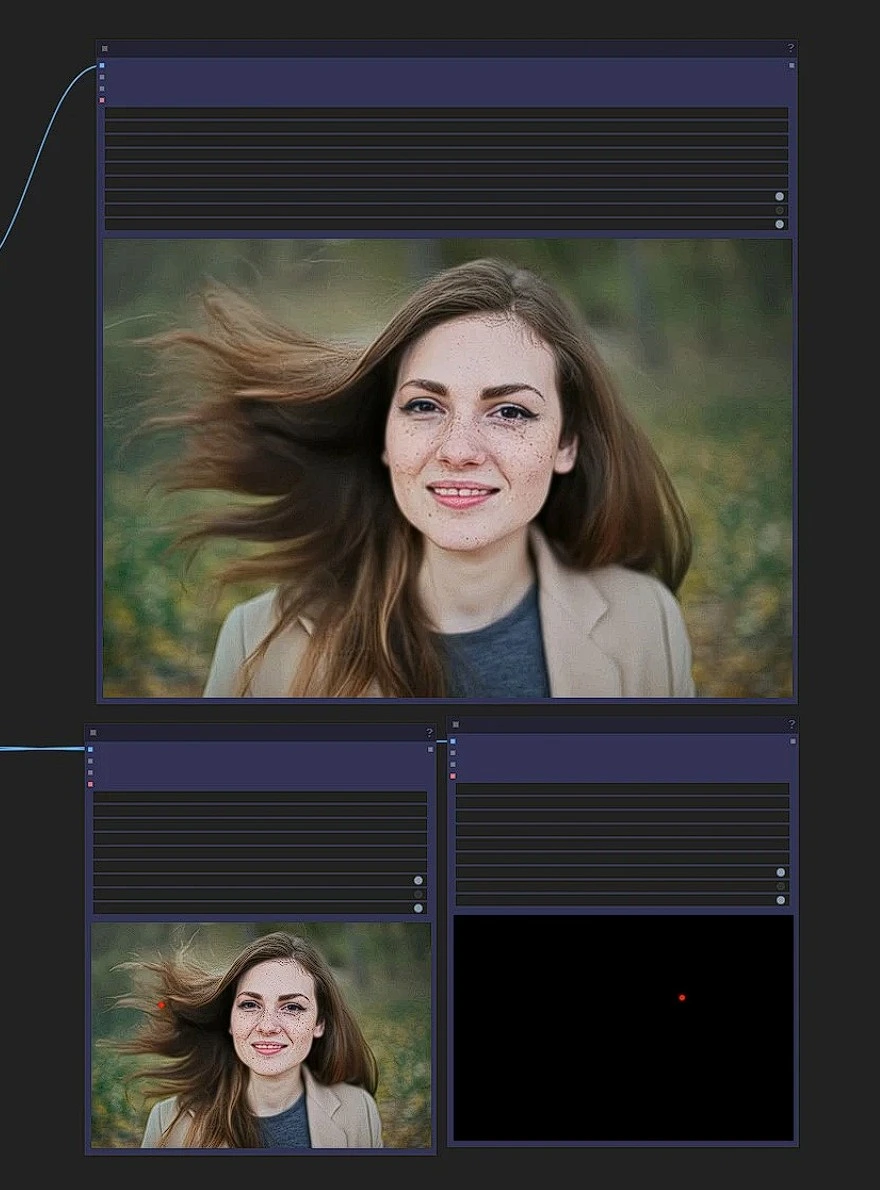

Ceci est le workflow CogVideoX Tora, les nœuds du côté gauche sont les entrées, ceux du milieu sont les nœuds de traitement tora, et ceux de droite sont les nœuds de sortie.

- Glissez et déposez votre image horizontale dans le nœud d'entrée.

- Écrivez vos invites d'action

- Faites un chemin de trajectoire

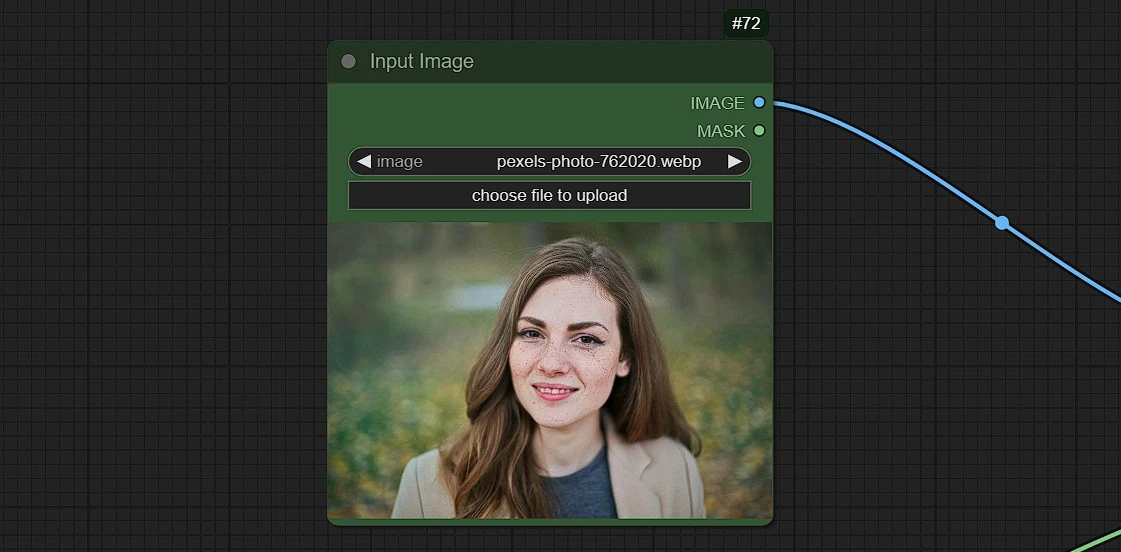

1.2 Charger l'image d'entrée

- Téléchargez, glissez et déposez ou copiez et collez (Ctrl+V) votre image dans le nœud de chargement d'image

[!CAUTION] Seules les images au format horizontal de dimensions - 720*480 fonctionneront. D'autres dimensions donneront une erreur.

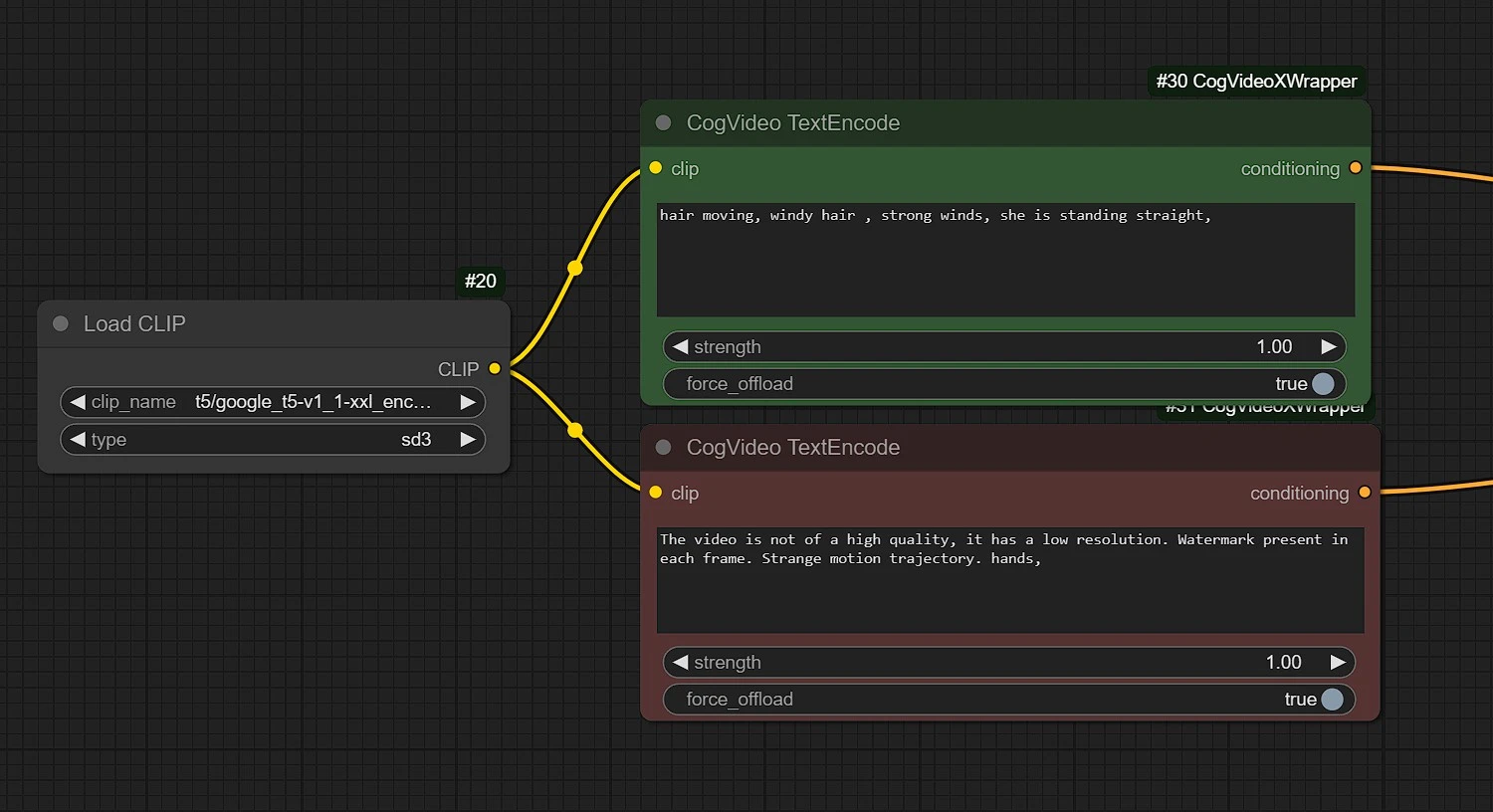

1.3 Ajoutez vos invites positives et négatives

Positive: Entrez les actions se déroulant avec le Sujet en fonction de la Trajectoire définie dans le nœud de trajectoire (déplacement, flux...etc).Negative: Entrez ce que vous ne voulez pas voir se produire (mains déformées, floues...etc)

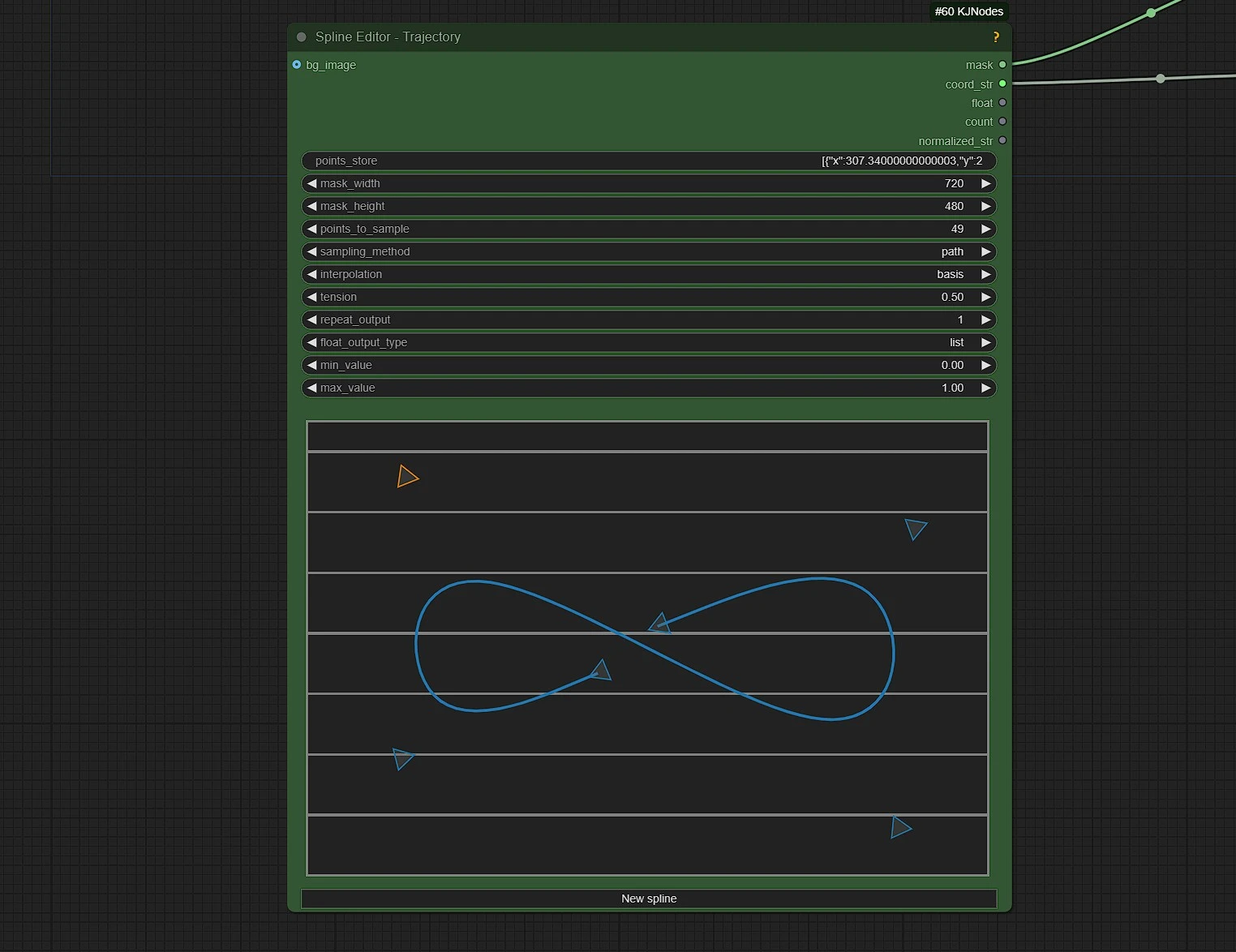

1.4 Créer la Trajectoire pour le mouvement

Ici, vous définissez le chemin de la Trajectoire du mouvement du sujet dans la photo téléchargée.

points_to_sample: Cela définit le nombre d'images pour le rendu, ou la durée de votre vidéo en images.mask_width: Par défaut, c'est 720. NE PAS CHANGER!mask_height: Par défaut, c'est 480. NE PAS CHANGER!

Guide des nœuds:

- Maj + clic pour ajouter un point de contrôle à la fin. Ctrl + clic pour ajouter un point de contrôle (subdiviser) entre deux points.

- Clic droit sur un point pour le supprimer.

- Notez que vous ne pouvez pas supprimer au début/à la fin.

- Clic droit sur la toile pour le menu contextuel:

- Ce sont des options purement visuelles, n'affectent pas la sortie:

Basculer la visibilité des poignées

- Afficher les points d'échantillon: afficher les points à retourner.

- La valeur de points_to_sample définit le nombre d'échantillons

- retournés à partir de la spline dessinée elle-même, cela est indépendant des

- points de contrôle réels, donc le type d'interpolation est important.

Méthode d'échantillonnage:

- temps: échantillons le long de l'axe temporel, utilisé pour les horaires

- chemin: échantillons le long du chemin lui-même, utile pour les coordonnées

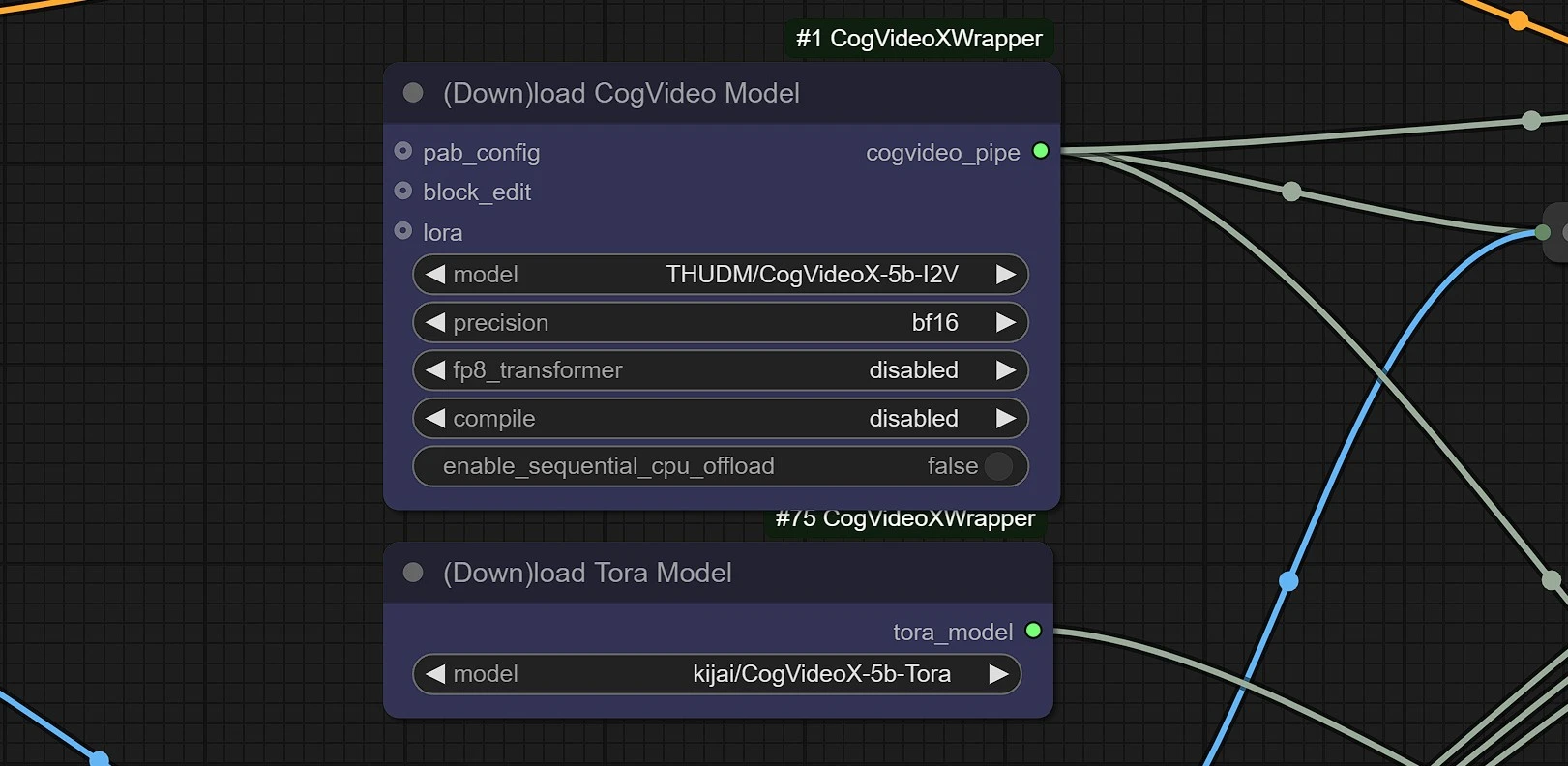

1.5 Charger les modèles CogVideoX & Tora

Ce sont les nœuds de téléchargement de modèles, ils téléchargeront automatiquement les modèles dans votre comfyui en 2-3 minutes.

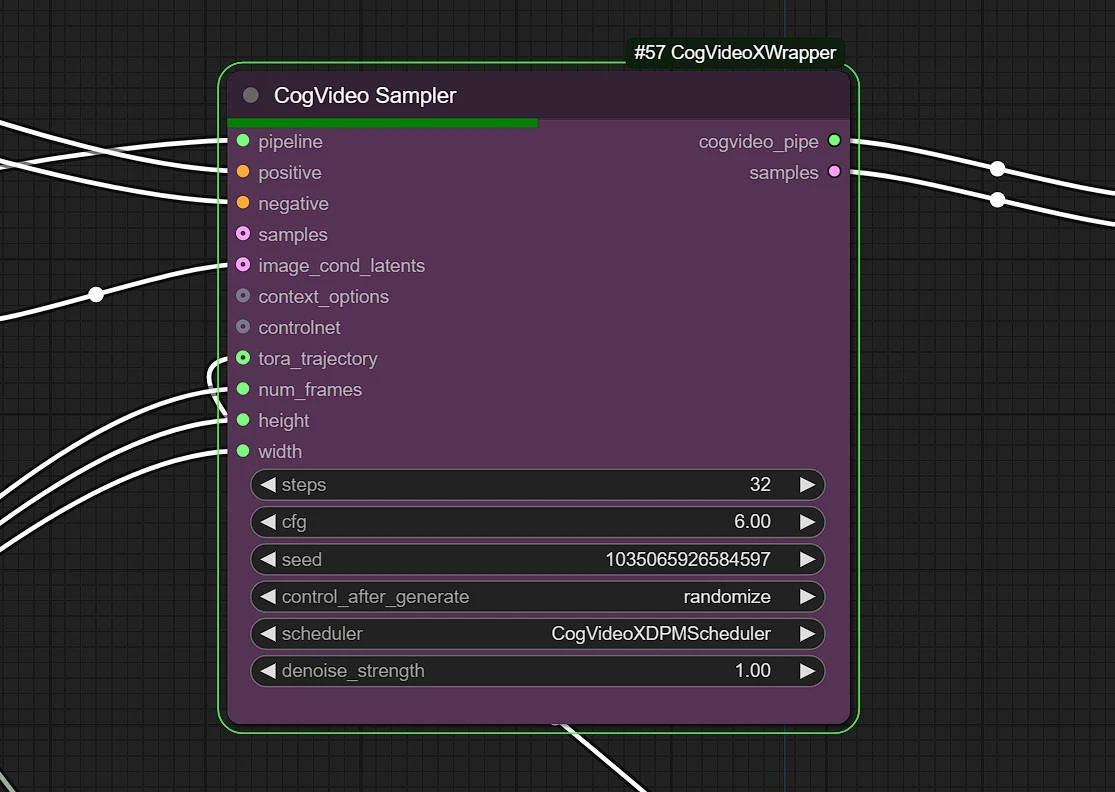

1.6 Échantillonneur CogVideo

Steps: Cette valeur détermine la qualité de votre rendu. Gardez entre 25 - 35 pour la meilleure valeur et la plus efficace.cfg: La valeur par défaut est 6.0 pour l'échantillonnage CogVideo.denoising strengthetScheduler: Ne pas changer cela.

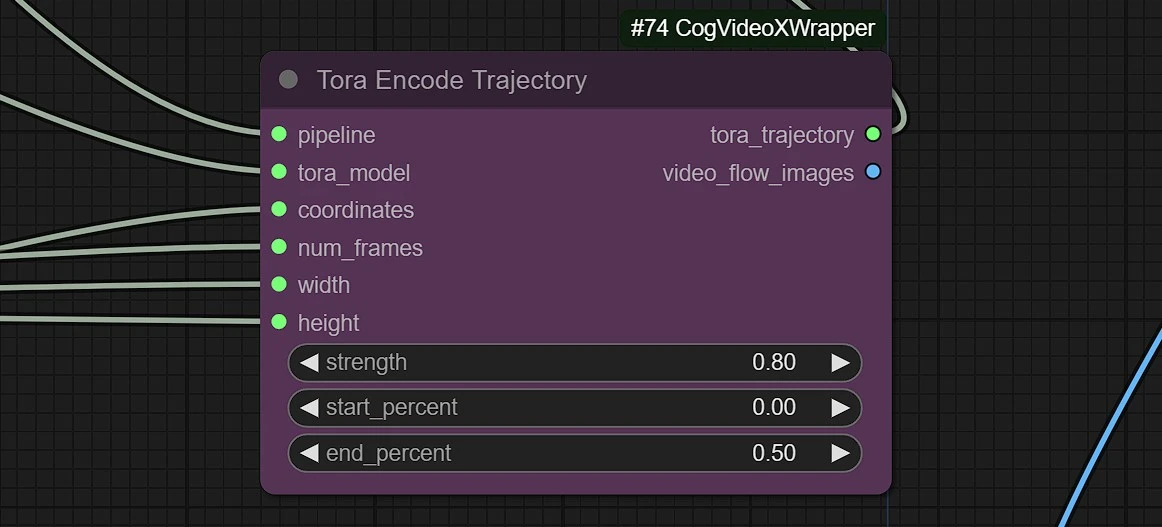

1.7 Poids et Force de la Trajectoire

Ce nœud définira la force de votre trajectoire de mouvement.

strength: Une valeur élevée donnera une figure déformée ou un point volant. Utilisez entre 0.5 - 0.9.start_percent: Utilisez cette valeur pour atténuer l'effet de force de mouvement.end_percent: - Une valeur élevée donnera une figure déformée ou un point volant. Utilisez entre 0.3 - 0.7

1.8 Sorties

Ces nœuds vous donneront 3 sorties.

- Vidéo rendue en sortie

- Chemin de trajectoire superposé sur la vidéo rendue

- Vidéo de trajectoire sur fond noir

"CogVideoX Tora: Transformateur de Diffusion Orienté Trajectoire pour la Génération Vidéo" présente une approche innovante pour la génération vidéo en introduisant une guidance basée sur les trajectoires au sein d'un cadre de transformateur de diffusion. Contrairement aux modèles de synthèse vidéo traditionnels qui peinent à maintenir la cohérence temporelle et le mouvement réaliste, CogVideoX Tora se concentre explicitement sur la modélisation des trajectoires de mouvement. Cela permet au système de générer des vidéos cohérentes et visuellement convaincantes en comprenant comment les objets et éléments évoluent au fil du temps. En combinant la puissance des modèles de diffusion, connus pour la génération d'images de haute qualité, avec les capacités de raisonnement temporel des transformateurs, CogVideoX Tora comble le fossé entre la modélisation spatiale et temporelle.

Le mécanisme orienté trajectoire de CogVideoX Tora offre un contrôle précis sur les mouvements des objets et les interactions dynamiques, le rendant particulièrement adapté aux applications nécessitant une guidance de mouvement précise, telles que le montage vidéo, l'animation et la génération d'effets spéciaux. La capacité du modèle à maintenir la cohérence temporelle et les transitions réalistes améliore son applicabilité dans la création de contenu vidéo fluide et cohérent. En intégrant des priorités de trajectoire, CogVideoX Tora améliore non seulement la dynamique des mouvements mais réduit également les artefacts souvent observés dans la génération basée sur les images. Cette avancée établit un nouveau standard pour la synthèse vidéo, offrant un outil puissant aux créateurs et développeurs dans des domaines tels que la réalisation de films, la réalité virtuelle et l'IA basée sur la vidéo.