Personnages Cohérents avec Flux

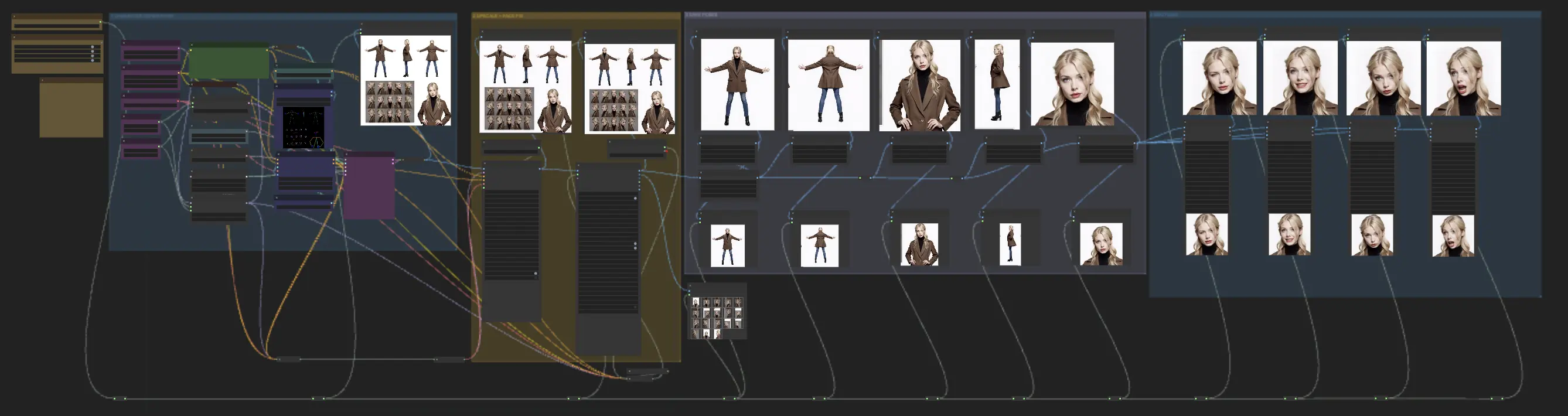

Le workflow Personnages Cohérents avec Flux, créé par Mickmumpitz, est un puissant outil ComfyUI qui maintient la cohérence des personnages générés par l'IA sur plusieurs sorties. Idéal pour les films IA cinématographiques, les livres pour enfants, ou tout projet nécessitant des apparences stables des personnages, ce workflow basé sur Flux simplifie le processus d'obtention de looks de personnages uniformes, réduisant le besoin de multiples invites et de réglages fins.Flux de travail ComfyUI Consistent Characters with Flux

- Workflows entièrement opérationnels

- Aucun nœud ou modèle manquant

- Aucune configuration manuelle requise

- Propose des visuels époustouflants

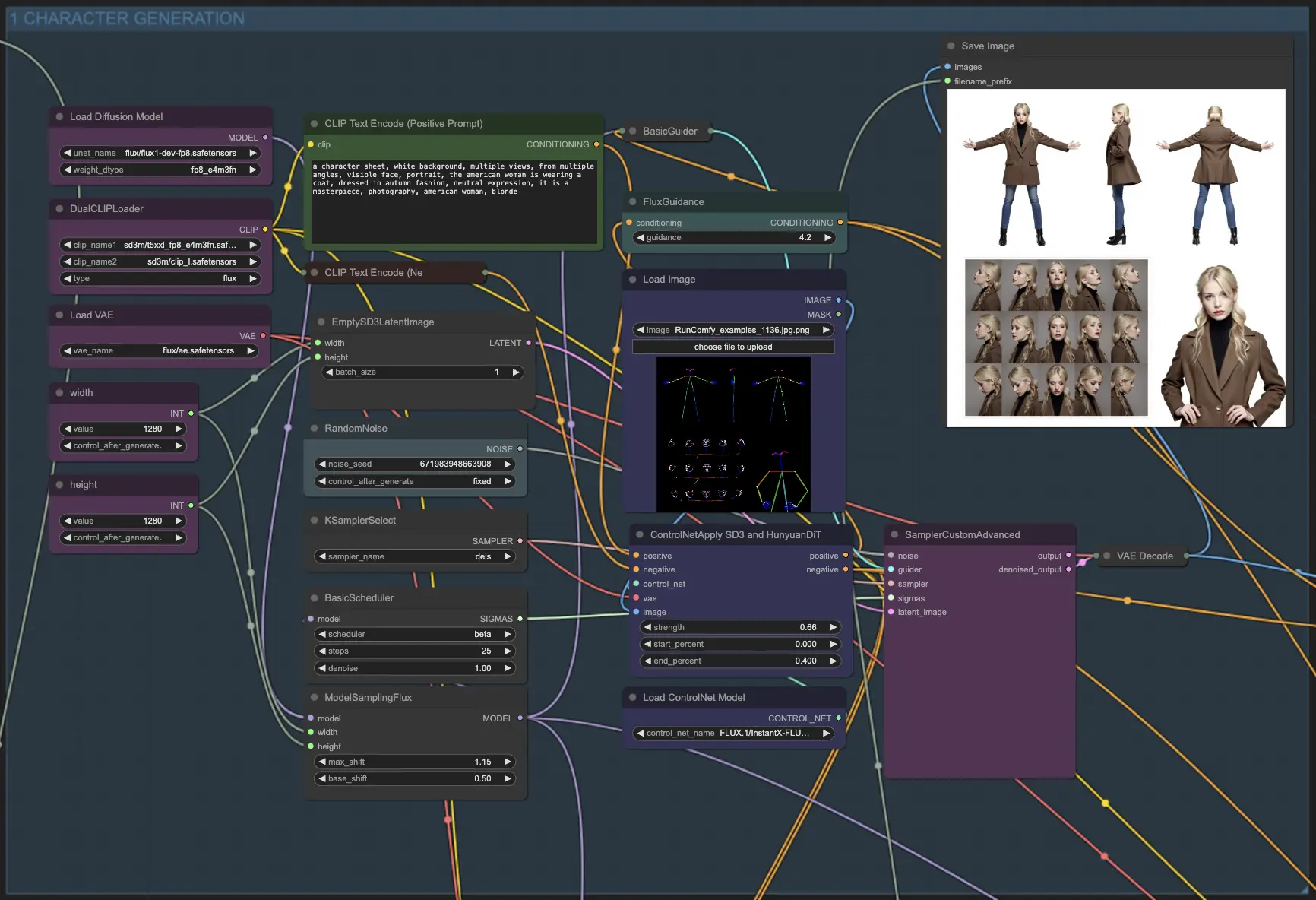

Exemples ComfyUI Consistent Characters with Flux

Description ComfyUI Consistent Characters with Flux

Ce workflow Personnages Cohérents avec Flux a été créé par . Nous vous recommandons vivement de consulter son tutoriel détaillé pour apprendre à utiliser efficacement ce puissant workflow Personnages Cohérents. Bien que nous ayons reproduit le workflow Personnages Cohérents et mis en place l'environnement pour votre commodité, tout le crédit revient à Mickmumpitz pour son excellent travail sur le développement de cette solution Personnages Cohérents basée sur Flux.

Les Personnages Cohérents avec Flux

Le Workflow Personnages Cohérents avec Flux est un puissant outil ComfyUI qui maintient la cohérence des personnages générés par l'IA sur plusieurs sorties. Il est idéal pour créer des films IA cinématographiques, des livres pour enfants, ou tout projet nécessitant des apparences stables des Personnages Cohérents. Ce workflow basé sur Flux simplifie le processus d'obtention d'apparences uniformes des Personnages Cohérents, réduisant le besoin de multiples invites et de réglages fins. En utilisant le modèle dev Flux.1, il améliore la stabilité des Personnages Cohérents générés, assurant qu'ils maintiennent le même look et ressenti, qu'ils soient animés ou rendus de manière réaliste.

Comment utiliser le Workflow Personnages Cohérents avec Flux ?

Le Workflow Personnages Cohérents avec Flux est divisé en quatre modules (Génération des Personnages, Upscale + Correction du Visage, Poses, Émotions), chacun conçu pour simplifier le processus de génération de Personnages Cohérents avec une apparence uniforme sur plusieurs sorties.

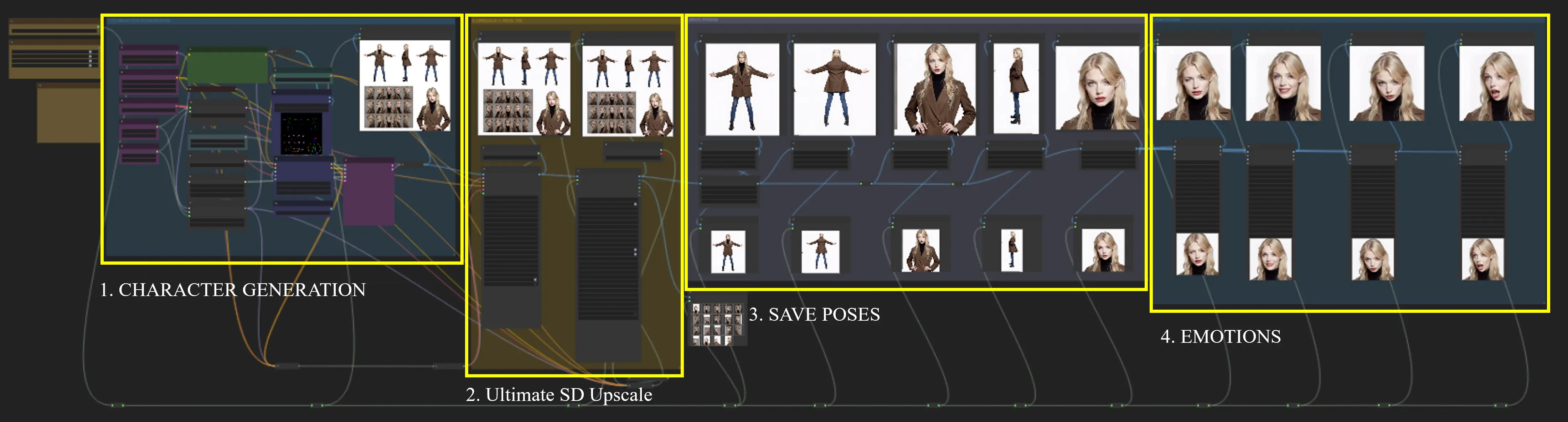

Noeud Fast Groups Muter (rgthree)

Après avoir chargé le noeud Fast Groups Muter (rgthree), les modules 2, 3 et 4 sont exécutés automatiquement, et aucune configuration supplémentaire n'est requise. Ce noeud contrôle les commutateurs pour les quatre modules, rendant le processus des Personnages Cohérents plus fluide et efficace.

Fast Groups Muter (rgthree) Node Control module switch (yes/no).

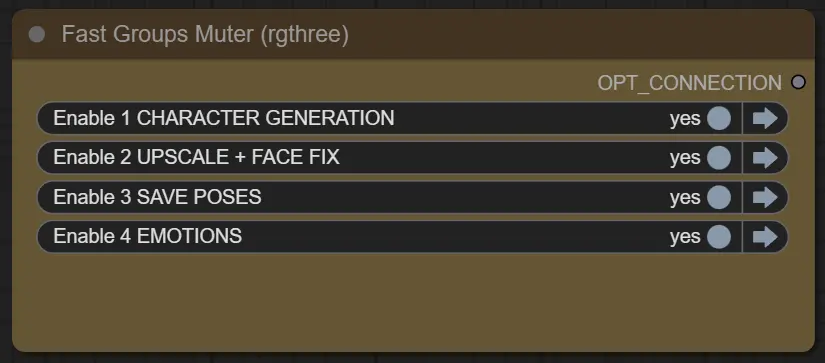

1. Génération des Personnages

Ce module utilise les modèles Flux et le modèle Flux ControlNet pour générer un tableau de Personnages Cohérents en guidant le processus de génération avec des invites. L'entrée, qui est une feuille de pose, sert de référence pour diriger la génération des Personnages Cohérents. En élaborant des invites appropriées, vous pouvez orienter le modèle pour créer les feuilles de Personnages Cohérents souhaitées.

Voici quelques exemples d'invites :

Une feuille de personnage présentant une femme américaine portant un manteau, habillée à la mode d'automne, avec une expression neutre. La feuille doit avoir un fond blanc, plusieurs vues sous différents angles, et un portrait de visage visible. Le style général doit ressembler à une photographie de chef-d'œuvre.

Une feuille de personnage représentant une ranger elfique portant une cape faite de feuilles d'automne, habillée en couleurs de forêt, avec une expression déterminée. La feuille doit avoir un fond de parchemin, plusieurs vues sous différents angles, et un portrait de visage visible. La ranger doit être accompagnée d'un cerf majestueux, portant un arc long et un carquois sur son dos. Le style général doit ressembler à une peinture numérique de chef-d'œuvre d'une elfe féminine aux longs cheveux dorés.

Conseil : Si la feuille de Personnages Cohérents générée ne répond pas à vos attentes, essayez d'ajuster la valeur de la graine pour régénérer la sortie avec des variations.

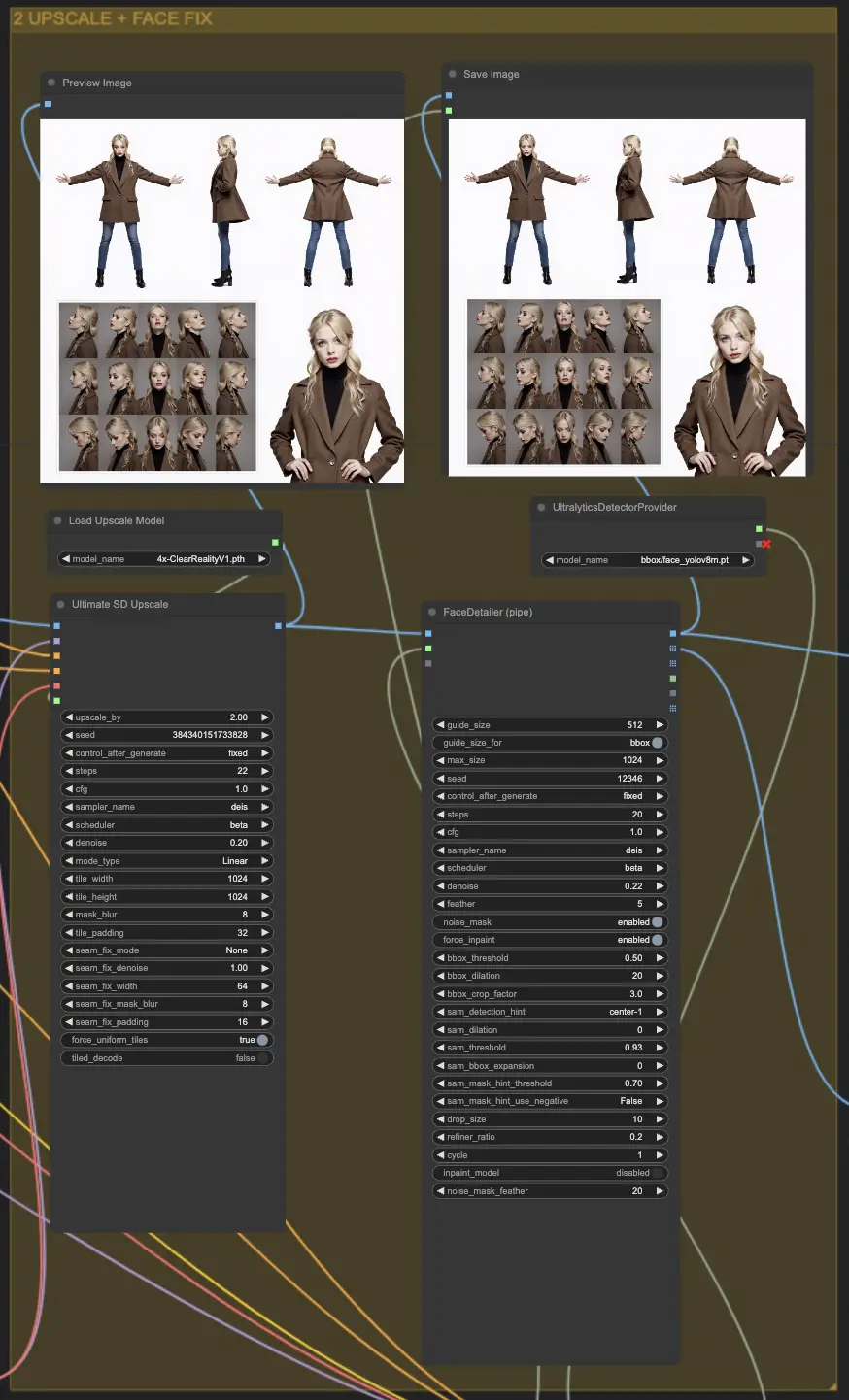

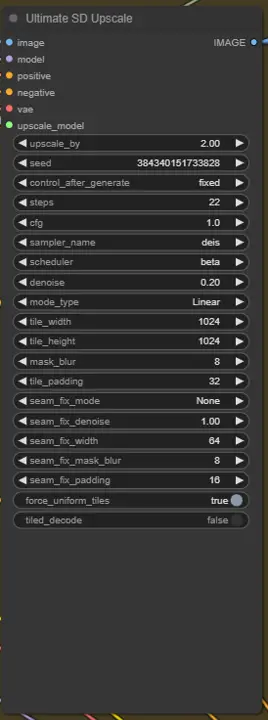

2. Upscale + Correction du Visage

2.1 Ultimate SD Upscale

Ultimate SD Upscale est un noeud utilisé dans les pipelines de génération d'images pour améliorer la résolution des images en divisant l'image en plus petites tuiles, en traitant chaque tuile individuellement, puis en les recousant ensemble. Ce processus permet de générer des images haute résolution tout en gérant l'utilisation de la mémoire et en réduisant les artefacts qui peuvent se produire lors de l'upscaling.

Paramètres :

upscale_by: Le facteur par lequel la largeur et la hauteur de l'image sont multipliées. Pour des dimensions précises, utilisez la version "No Upscale".seed: Contrôle l'aléatoire dans le processus de génération. Utiliser la même graine donne les mêmes résultats.control_after_generate: Ajuste les détails de l'image après génération.steps: Le nombre d'itérations pendant la génération d'image. Plus d'étapes donnent des détails plus fins mais un temps de traitement plus long.cfg: Échelle de Guidance sans Classificateur qui ajuste la rigueur avec laquelle le modèle suit les invites d'entrée.sampler_name: Spécifie la méthode d'échantillonnage utilisée pour la génération d'image.scheduler: Définit comment les ressources de calcul sont allouées tout au long de la génération.denoise: Contrôle le niveau de suppression du bruit, influençant la rétention des détails de l'image originale. Recommandé : 0.35 pour l'amélioration, 0.15-0.20 pour des changements minimes.mode_type: Détermine le mode de traitement, comme la façon dont les tuiles sont traitées.tile_widthettile_height: Dimensions des tuiles utilisées dans le traitement. Les tailles plus grandes réduisent les coutures mais nécessitent plus de mémoire.mask_blur: Floute les bords des masques utilisés pour le mélange des tuiles, adoucissant les transitions entre les tuiles.tile_padding: Nombre de pixels des tuiles voisines pris en compte lors du traitement pour réduire les coutures.seam_fix_mode: Méthode pour corriger les coutures visibles entre les tuiles :- Bands pass: Corrige les coutures le long des rangées et des colonnes.

- Half tile offset pass: Applique un décalage pour mieux mélanger les coutures.

- Half tile offset + intersections pass: Inclut des passes supplémentaires aux intersections.

seam_fix_denoise: Force de réduction du bruit lors de la correction des coutures.seam_fix_width: Largeur des zones traitées lors de la correction des coutures.seam_fix_mask_blur: Floute le masque pour des corrections de coutures plus douces.seam_fix_padding: Rembourrage autour des coutures lors de la correction pour assurer des résultats plus doux.force_uniform_tiles: Assure que les tuiles maintiennent une taille uniforme en étendant les tuiles de bordure si nécessaire, minimisant les artefacts.tiled_decode: Traite les tuiles d'image individuellement pour réduire l'utilisation de la mémoire lors de la génération haute résolution.- Type de taille cible: Détermine comment la taille finale de l'image est définie :

- À partir des paramètres img2img: Utilise la largeur et la hauteur par défaut.

- Taille personnalisée: Permet de définir manuellement la largeur et la hauteur (max 8192px).

- Échelle à partir de la taille de l'image: Évolue en fonction de la taille initiale de l'image.

- Upscaler: La méthode pour l'upscaling des images avant un traitement supplémentaire (e.g., ESRGAN).

- Redessiner: Contrôle comment l'image est redessinée :

- Linéaire: Traite les tuiles séquentiellement.

- Chess: Utilise un motif en damier pour le traitement afin de réduire les artefacts.

- Aucun: Désactive le redessin, se concentrant uniquement sur la correction des coutures.

2.2. FaceDetailer (pipe)

FaceDetailerPipe est un noeud conçu pour améliorer les détails faciaux dans les images, utilisant des techniques avancées de traitement d'image pour améliorer la netteté et la clarté des traits du visage. Il fait partie du ComfyUI Impact Pack, visant à fournir des améliorations de haute qualité des détails faciaux pour diverses applications.

Paramètres :

image: L'image d'entrée à améliorer, servant de sujet principal pour le détail du visage.guide_size: Un paramètre qui contrôle la taille de la zone de guidage utilisée pour améliorer les traits du visage, influençant combien de contexte est pris en compte.guide_size_for: Détermine si la taille du guide doit être appliquée pour des régions spécifiques.max_size: Définit la limite de taille maximale pour les images traitées, assurant la gestion de la mémoire.seed: Contrôle l'aléatoire dans le processus d'amélioration de l'image, permettant des résultats reproductibles lors de l'utilisation de la même graine.steps: Le nombre d'itérations pour améliorer les détails. Plus d'étapes donnent des détails plus fins mais nécessitent plus de temps de traitement.cfg: L'échelle de Guidance sans Classificateur, qui ajuste la fidélité avec laquelle le modèle suit le guidage d'entrée.sampler_name: Définit la méthode d'échantillonnage utilisée pour le raffinement des détails.scheduler: Détermine la stratégie de planification computationnelle pendant le traitement.denoise: Contrôle la force de réduction du bruit appliquée pendant le processus d'amélioration. Des valeurs plus basses conservent plus de détails originaux, tandis que des valeurs plus élevées produisent des résultats plus lisses.feather: Contrôle la douceur de la transition entre les zones améliorées et originales, aidant à mélanger les changements de manière homogène.noise_mask: Active ou désactive l'utilisation d'un masque de bruit pour cibler des zones spécifiques pour la réduction du bruit.force_inpaint: Force l'inpainting dans les régions nécessitant des améliorations ou corrections supplémentaires.bbox_threshold: Définit le seuil pour détecter les boîtes englobantes autour des traits du visage, influençant la sensibilité.bbox_dilation: Élargit les zones de boîtes englobantes détectées pour s'assurer que toutes les caractéristiques pertinentes sont incluses lors de l'amélioration.bbox_crop_factor: Ajuste le facteur de recadrage pour les boîtes englobantes détectées, contrôlant la zone de mise au point pour l'amélioration.sam_detection_hint: Spécifie des indices ou guides supplémentaires pour le processus de détection.sam_dilation: Ajuste la dilatation appliquée aux régions détectées, permettant une couverture plus large.sam_threshold: Définit le seuil pour la sensibilité de détection dans le processus SAM (Segment Anything Model).sam_bbox_expansion: Élargit les boîtes englobantes détectées par le SAM, aidant à inclure plus de contexte environnant.sam_mask_hint_threshold: Ajuste le seuil pour les indices de masque fournis par SAM, contrôlant comment les régions sont définies pour le masquage.sam_mask_hint_use_negative: Détermine si des indices négatifs doivent être utilisés, influençant le masquage de certaines régions.drop_size: Définit la taille des gouttes appliquées pendant le processus d'amélioration, ce qui peut influencer le niveau de raffinement.refiner_ratio: Contrôle le ratio pour affiner les détails faciaux, équilibrant entre la préservation des caractéristiques originales et l'ajout de clarté.cycle: Spécifie le nombre de cycles de raffinement à appliquer, affectant la profondeur de l'amélioration.- inpaint_model (Optionnel): Active l'utilisation d'un modèle d'inpainting pour remplir les zones manquantes ou floues pendant le processus de détail.

noise_mask_feather: Ajuste l'effacement du masque de bruit, fournissant une transition plus douce entre les zones bruyantes et débruitées.

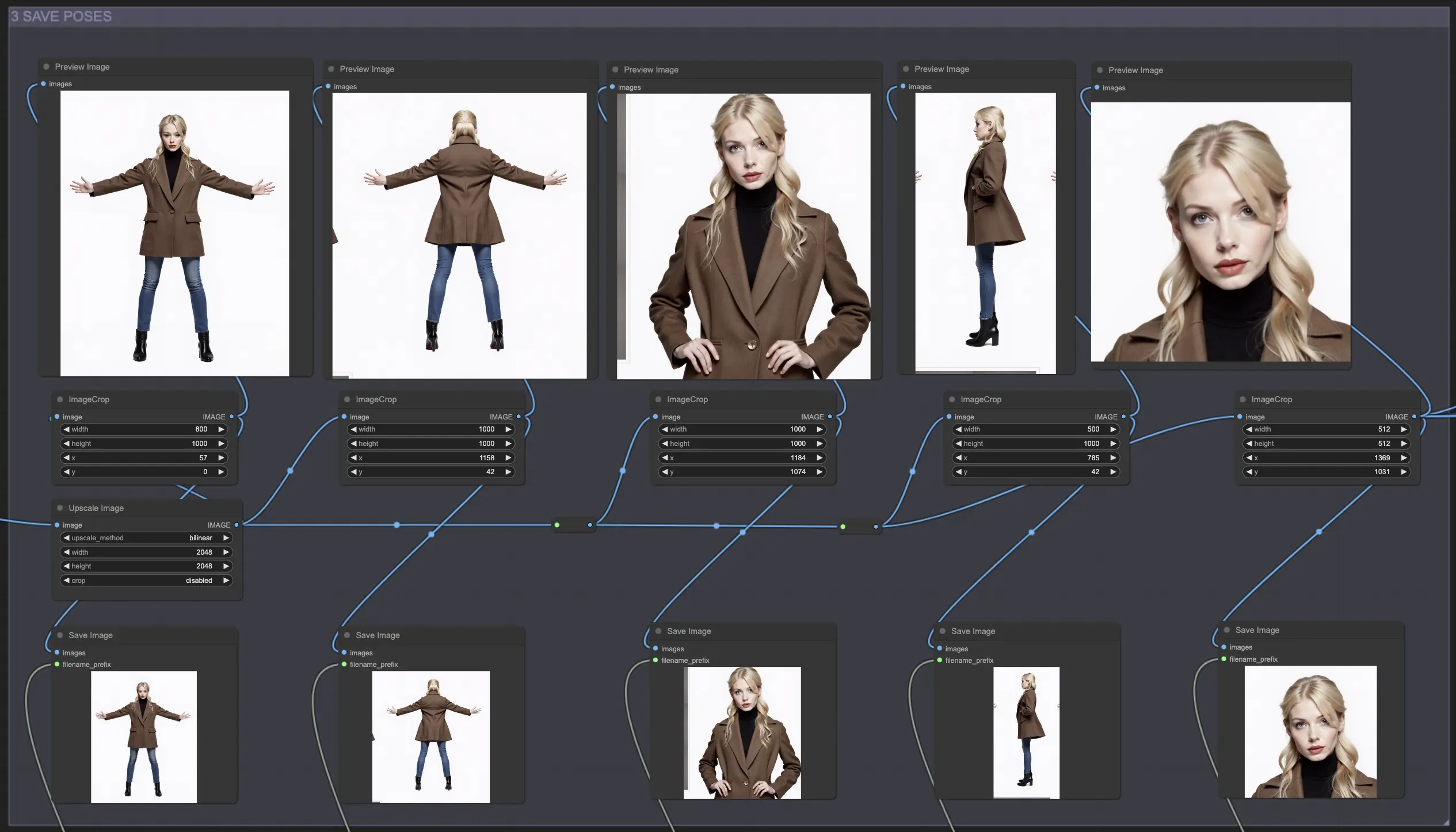

3. Poses

Ce module vous permet d'utiliser le noeud de recadrage d'image pour séparer chaque pose de la feuille de personnage générée et sauvegarder des poses individuelles du personnage pour une utilisation ou des ajustements ultérieurs.

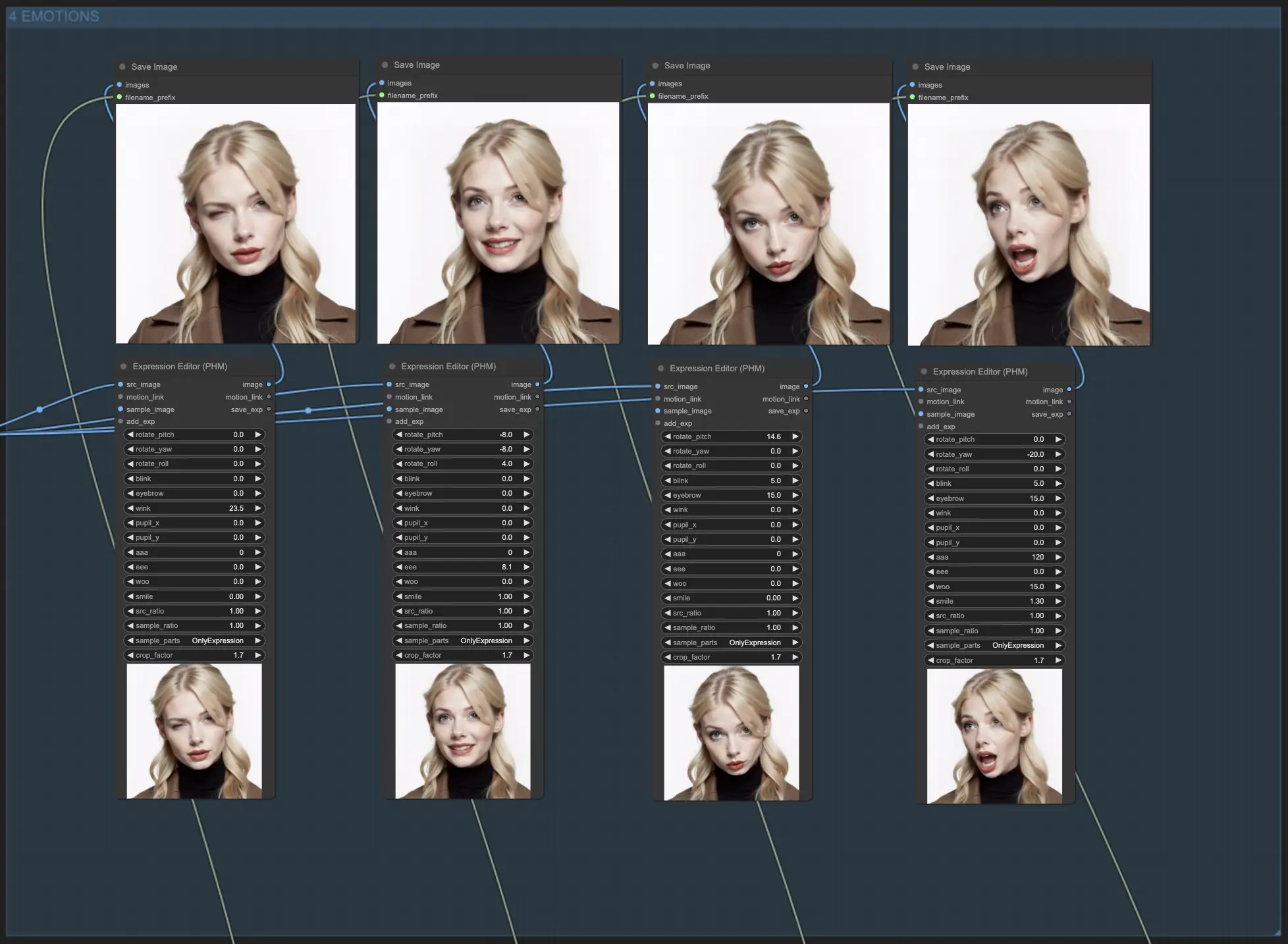

4. Émotions

Ce module utilise le noeud Photo Expression Editor (PHM) pour ajuster les expressions faciales dans les photos. Les paramètres permettent de peaufiner divers aspects faciaux, tels que les mouvements de tête, le clignement des yeux, et le sourire.

Paramètres de l'éditeur d'expression:

rotate_pitch: Contrôle le mouvement de haut en bas de la tête.rotate_yaw: Ajuste le mouvement latéral de la tête.rotate_roll: Détermine l'angle d'inclinaison de la tête.blink: Contrôle l'intensité des clignements d'yeux.eyebrow: Ajuste les mouvements des sourcils.wink: Contrôle le clin d'œil.pupil_x: Déplace les pupilles horizontalement.pupil_y: Déplace les pupilles verticalement.aaa: Contrôle la forme de la bouche pour le son de voyelle "aaa".eee: Contrôle la forme de la bouche pour le son de voyelle "eee".woo: Contrôle la forme de la bouche pour le son de voyelle "woo".smile: Ajuste le degré d'un sourire.src_ratio: Détermine le ratio de l'expression source à appliquer.sample_ratio: Détermine le ratio de l'expression échantillon à appliquer.sample_parts: Spécifie quelles parties de l'expression échantillon appliquer ("OnlyExpression", "OnlyRotation", "OnlyMouth", "OnlyEyes", "All").crop_factor: Contrôle le facteur de recadrage de la région du visage.

Les modèles Flux et les modules simplifiés du workflow vous permettent de maintenir facilement des apparences de Personnages Cohérents sur diverses sorties. Vous serez capable de donner vie à vos personnages comme jamais auparavant, créant une expérience vraiment immersive pour votre public !