AnimateDiff + ControlNet + IPAdapter V1 | Stile Anime Giapponese

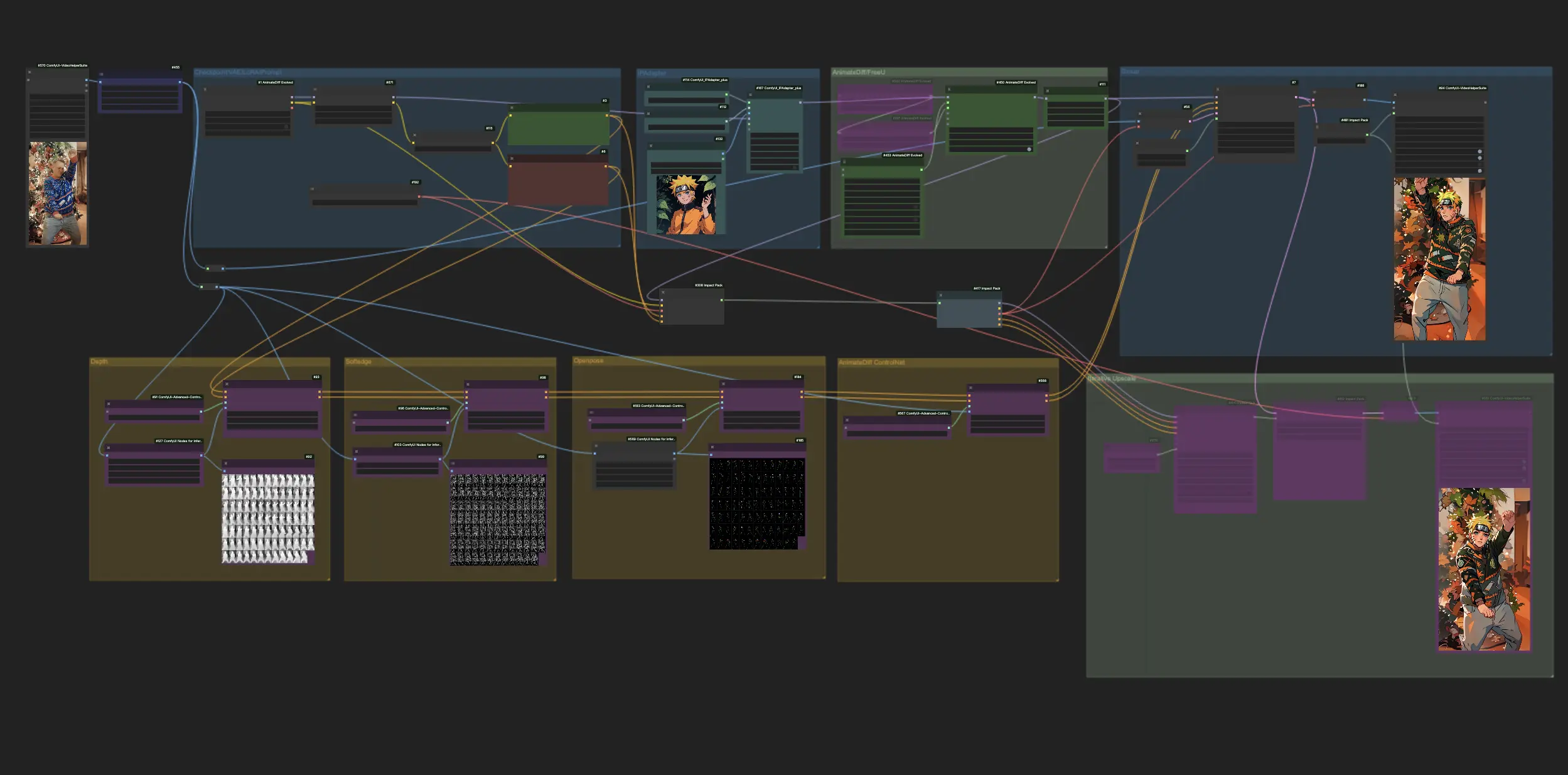

Vivi l'emozione della trasformazione anime mentre ComfyUI sfrutta il potere di AnimateDiff, ControlNet e IPAdapter per convertire i video standard in accattivanti rendering anime giapponesi. Questo workflow impiega abilmente tecniche avanzate come la percezione della profondità, dettagli a bordo morbido e la tecnologia OpenPose, insieme al tocco sfumato di Lora, assicurando che ogni video sia reimmaginato con un'autentica estetica anime. Immergiti nell'universo degli anime con una metamorfosi fluida e infusa di stile.ComfyUI Vid2Vid (Japanese Anime) Flusso di lavoro

- Workflow completamente operativi

- Nessun nodo o modello mancante

- Nessuna configurazione manuale richiesta

- Presenta visuali mozzafiato

ComfyUI Vid2Vid (Japanese Anime) Esempi

ComfyUI Vid2Vid (Japanese Anime) Descrizione

Questo workflow è ispirato da con alcune modifiche. Per ulteriori informazioni, visita il suo canale YouTube.

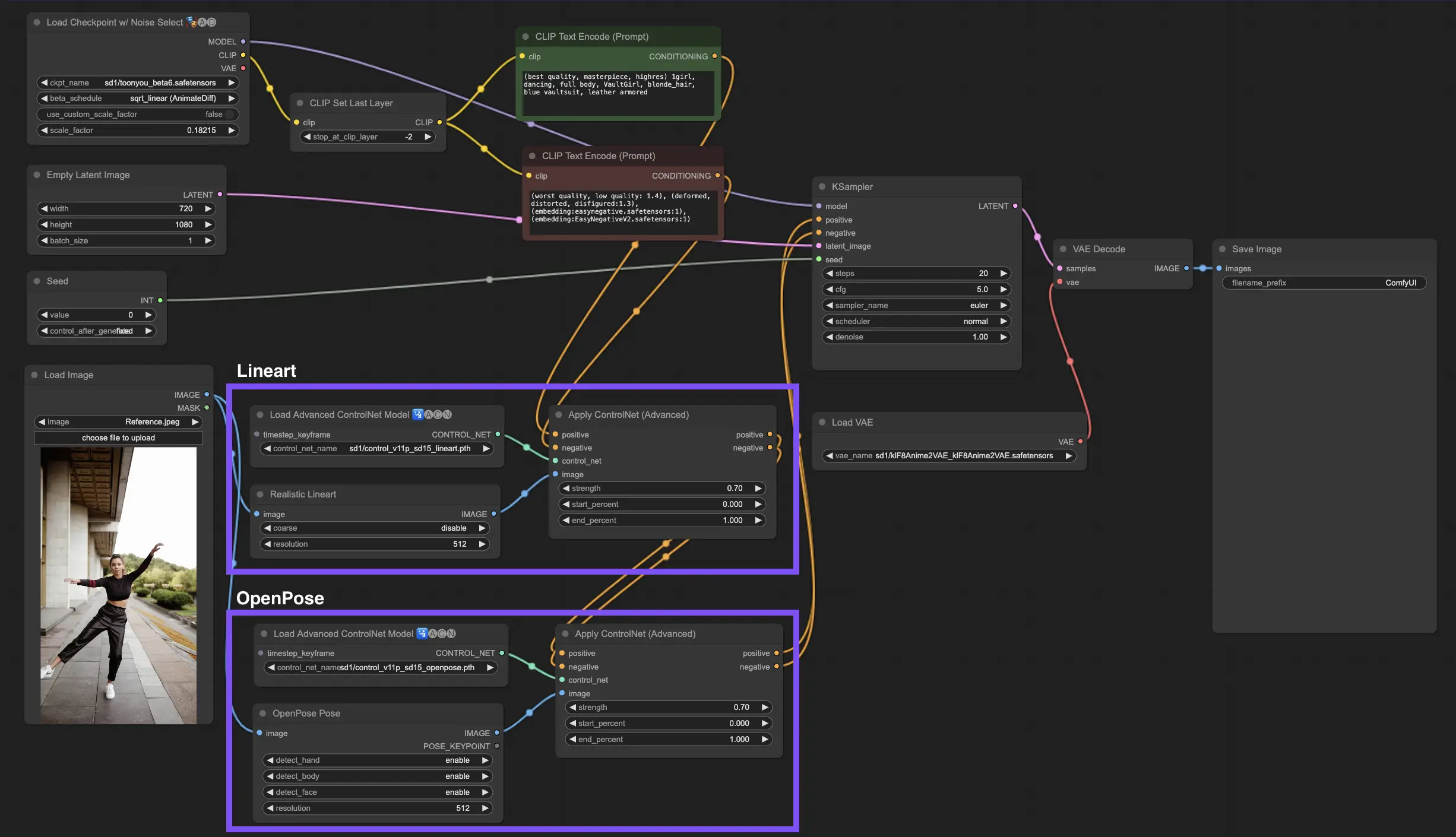

1. Workflow ComfyUI: AnimateDiff + ControlNet + IPAdapter | Stile Anime Giapponese

Questo workflow ti permette di trasformare video standard in affascinanti creazioni anime giapponesi utilizzando AnimateDiff, ControlNet e IPAdapter. Sentiti libero di sperimentare con vari checkpoint, impostazioni LoRA e immagini di riferimento per IPAdapter per creare il tuo stile unico. È un modo divertente e creativo per dare vita ai tuoi video nel mondo degli anime!

2. Panoramica di AnimateDiff

Per favore, consulta i dettagli su

3. Come usare ControlNet

3.1. Comprendere ControlNet

ControlNet rivoluziona il modo in cui generiamo le immagini portando un nuovo livello di controllo spaziale ai modelli di diffusione da testo a immagine. Questa all'avanguardia architettura di rete neurale si associa splendidamente a giganti come Stable Diffusion, sfruttando le loro vaste librerie—forgiate da miliardi di immagini—per intessere sfumature spaziali direttamente nel tessuto della creazione di immagini. Dallo schizzo dei bordi alla mappatura delle pose umane, dalla percezione della profondità alla segmentazione visiva, ControlNet ti consente di plasmare le immagini in modi che vanno ben oltre la portata dei semplici prompt testuali.

3.2. L'innovazione di ControlNet

Nel suo nucleo, ControlNet è ingegnosamente semplice. Inizia salvaguardando l'integrità dei parametri del modello originale—mantenendo intatta la formazione di base. Quindi, ControlNet introduce un set speculare di livelli di codifica del modello, ma con una svolta: sono addestrati utilizzando "convoluzioni zero". Questi zeri come punto di partenza significano che i livelli introducono delicatamente nuove condizioni spaziali senza causare confusione, assicurando che i talenti originali del modello siano preservati anche quando intraprende nuovi percorsi di apprendimento.

3.3. Comprendere ControlNet e T2I-Adapter

Sia ControlNet che T2I-Adapter svolgono ruoli cruciali nel condizionamento della generazione di immagini, ognuno con vantaggi distinti. T2I-Adapter è noto per la sua efficienza, in particolare in termini di accelerazione del processo di generazione delle immagini. Nonostante questo, ControlNet è impareggiabile nella sua capacità di guidare in modo intricato il processo di generazione, rendendolo un potente strumento per i creatori.

Considerando la sovrapposizione di funzionalità tra molti modelli T2I-Adapter e ControlNet, la nostra discussione si concentrerà principalmente su ControlNet. Tuttavia, vale la pena notare che la piattaforma RunComfy ha precaricato diversi modelli T2I-Adapter per facilitarne l'uso. Per coloro che sono interessati a sperimentare con T2I-Adapter, è possibile caricare facilmente questi modelli e integrarli nei progetti.

La scelta tra modelli ControlNet e T2I-Adapter in ComfyUI non influisce sull'uso dei nodi ControlNet o sulla coerenza del flusso di lavoro. Questa uniformità garantisce un processo semplificato, consentendoti di sfruttare i vantaggi unici di ciascun tipo di modello in base alle esigenze del progetto.

3.4. Uso dei nodi ControlNet

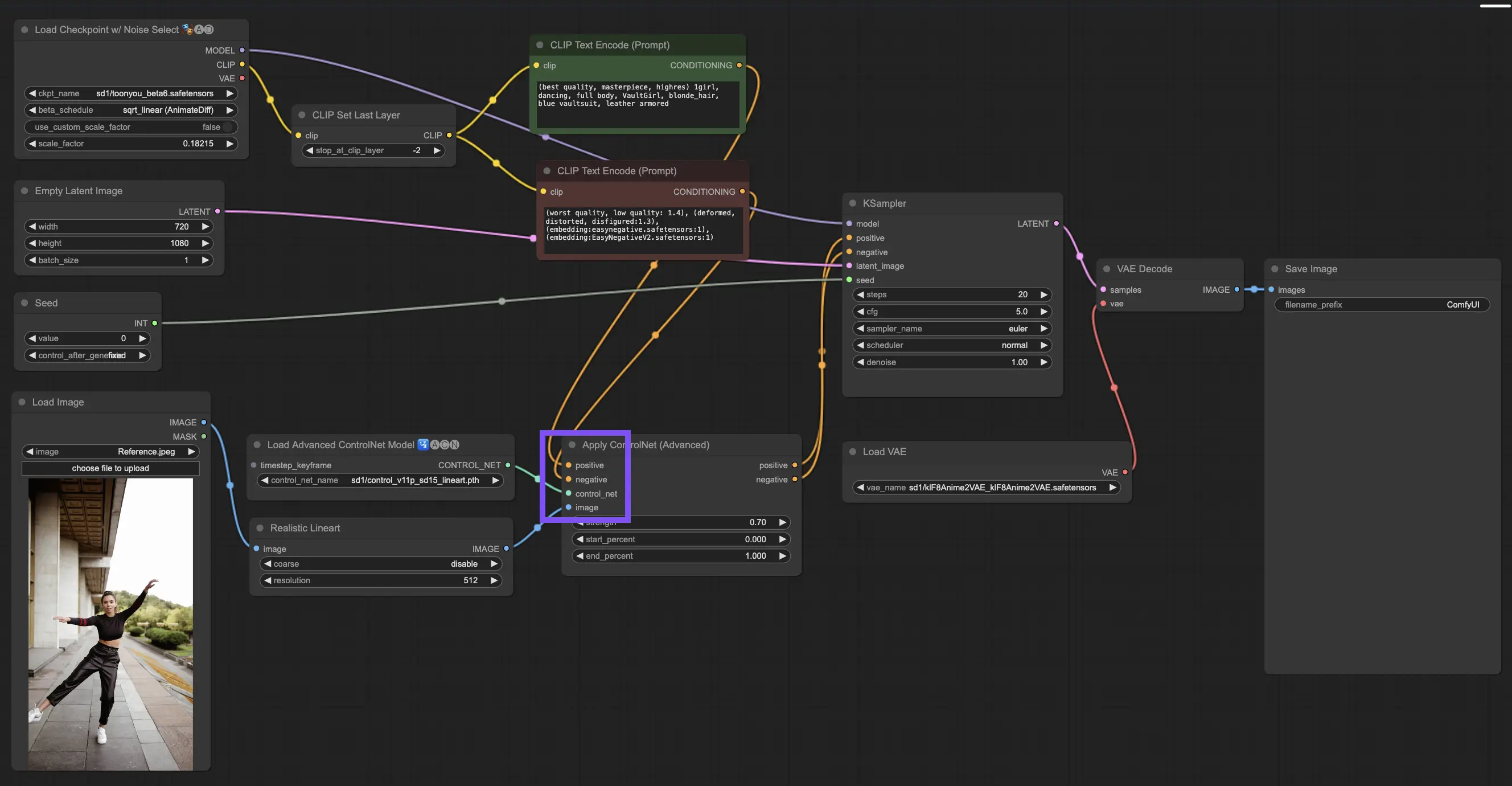

3.4.1. Caricamento del nodo "Apply ControlNet"

Per iniziare, dovrai caricare il nodo "Apply ControlNet" nel tuo ComfyUI. Questo è il tuo primo passo verso un viaggio di creazione di immagini a doppio condizionamento, mescolando elementi visivi con prompt testuali.

3.4.2. Comprendere gli input del nodo "Apply ControlNet"

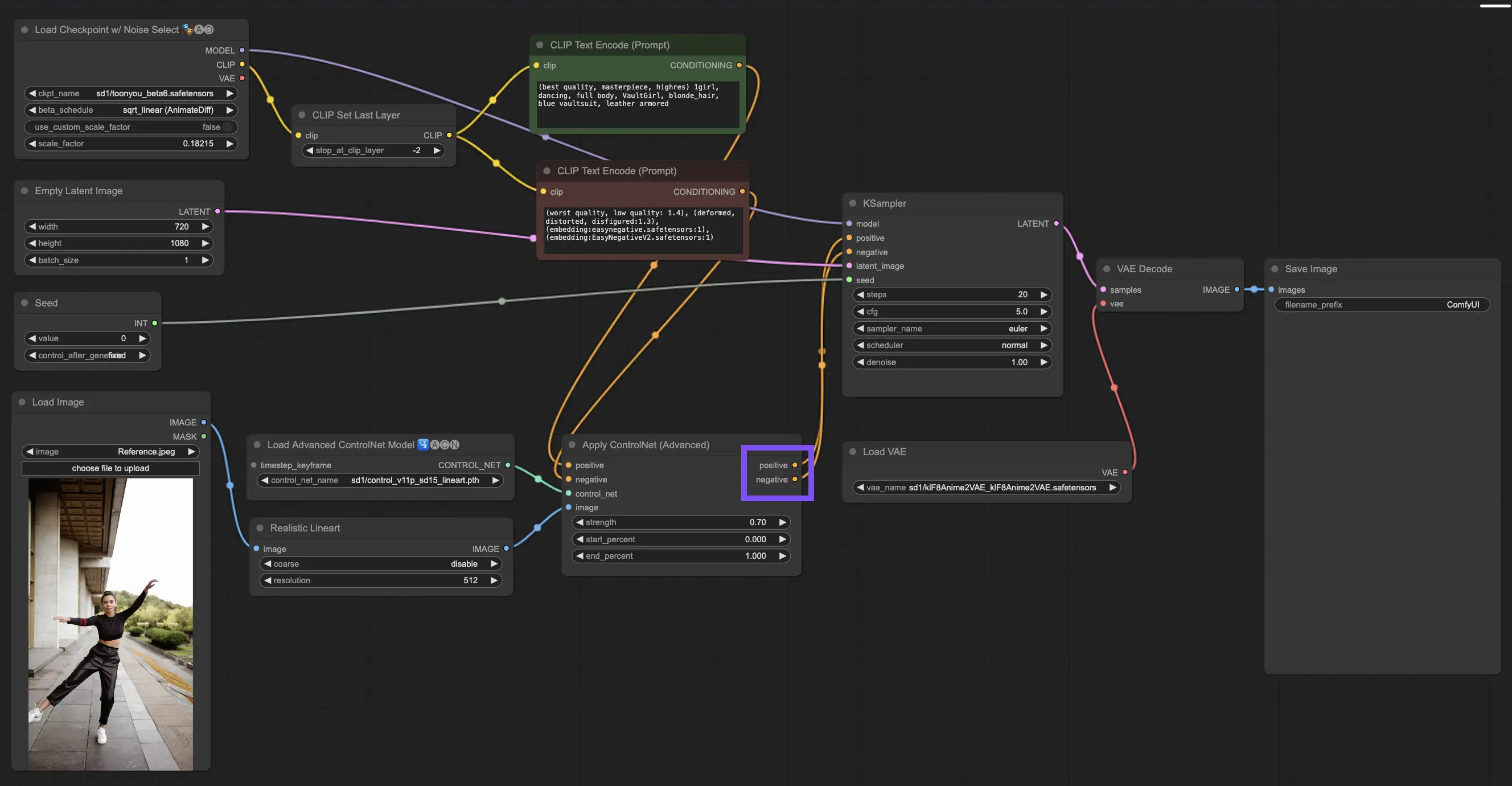

Condizionamento positivo e negativo: Questi sono i tuoi strumenti per modellare l'immagine finale—ciò che dovrebbe abbracciare e ciò che dovrebbe evitare. Collegali agli slot "Prompt positivo" e "Prompt negativo" per sincronizzarli con la parte basata su testo della tua direzione creativa.

Selezione del modello ControlNet: Dovrai collegare questo input all'output del nodo "Load ControlNet Model". Qui decidi se utilizzare un modello ControlNet o T2IAdaptor in base ai tratti o agli stili specifici che stai mirando. Mentre ci concentriamo sui modelli ControlNet, vale la pena menzionare alcuni ricercati T2IAdaptor per una visione completa.

Preprocessing dell'immagine: Collega la tua immagine a un nodo "ControlNet Preprocessor", che è vitale per garantire che la tua immagine sia pronta per ControlNet. È essenziale abbinare il preprocessore al tuo modello ControlNet. Questo passaggio regola la tua immagine originale per adattarla perfettamente alle esigenze del modello—ridimensionandola, ricolorandola o applicando i filtri necessari—preparandola per l'uso da parte di ControlNet.

3.4.3. Comprendere gli output del nodo "Apply ControlNet"

Dopo l'elaborazione, il nodo "Apply ControlNet" ti presenta due output che riflettono la sofisticata interazione di ControlNet e del tuo input creativo: Condizionamento positivo e negativo. Questi output guidano il modello di diffusione all'interno di ComfyUI, portandoti alla prossima scelta: perfezionare l'immagine utilizzando il KSampler o immergerti più a fondo impilando più ControlNet per coloro che cercano dettagli e personalizzazioni senza pari.

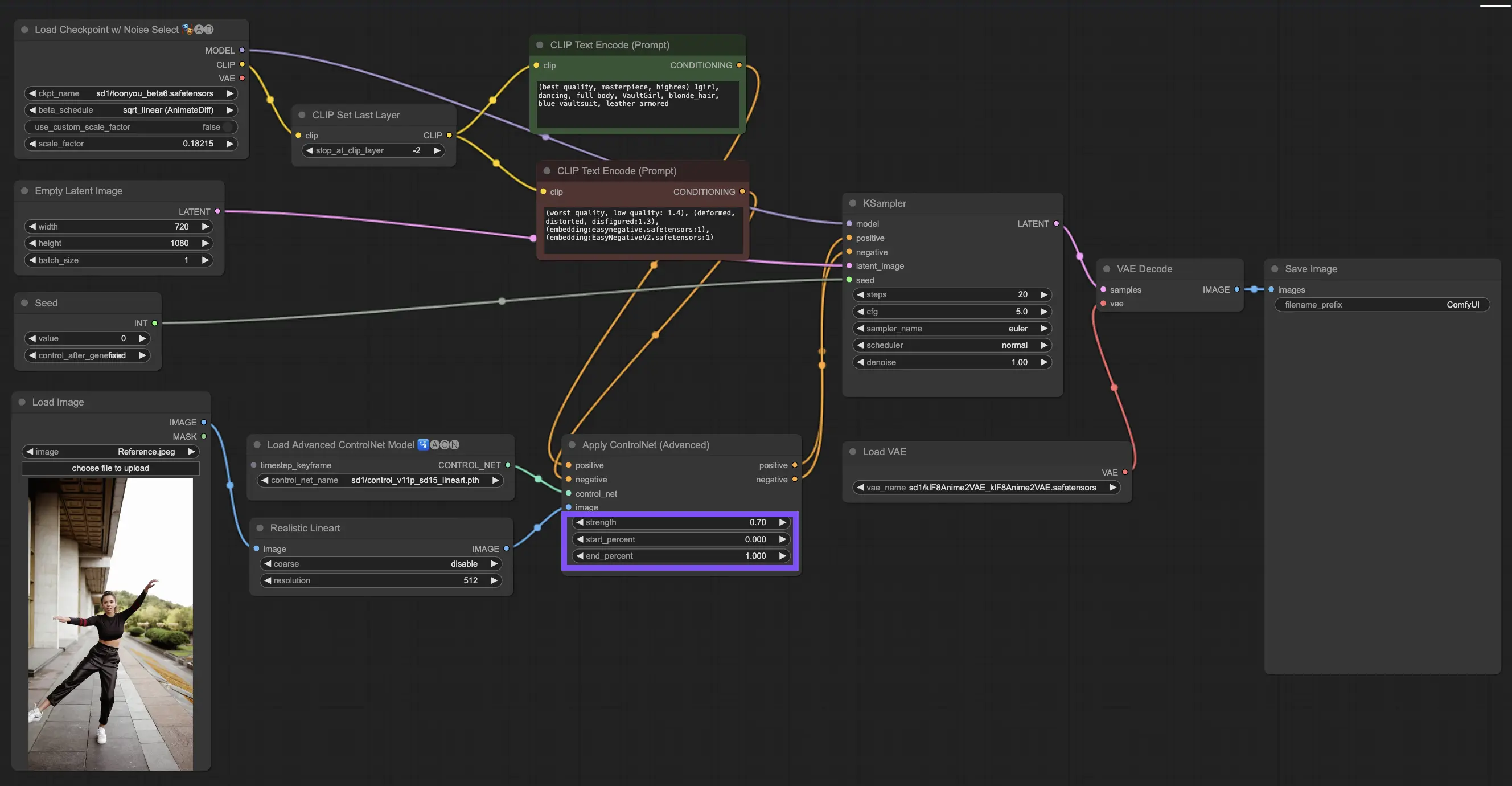

3.4.4. Ottimizzazione di "Apply ControlNet" per i migliori risultati

Determinazione della forza: Questa impostazione controlla quanto ControlNet influenza l'immagine risultante. Un 1.0 completo significa che l'input di ControlNet ha le redini, mentre passare a 0.0 lascia che il modello funzioni senza l'influenza di ControlNet.

Regolazione della percentuale di inizio: Questo ti dice quando ControlNet inizia a contribuire durante il processo di diffusione. Ad esempio, un inizio al 20% significa che da un quinto del percorso in poi, ControlNet inizia a lasciare il segno.

Impostazione della percentuale di fine: Questo è il lato opposto della percentuale di inizio, segnando quando ControlNet si inchina. Se lo imposti all'80%, l'influenza di ControlNet si affievolisce man mano che l'immagine si avvicina alle sue fasi finali, intoccata da ControlNet nell'ultimo tratto.

3.5. Guida al modello ControlNet: Openpose, Depth, SoftEdge, Canny, Lineart, Tile

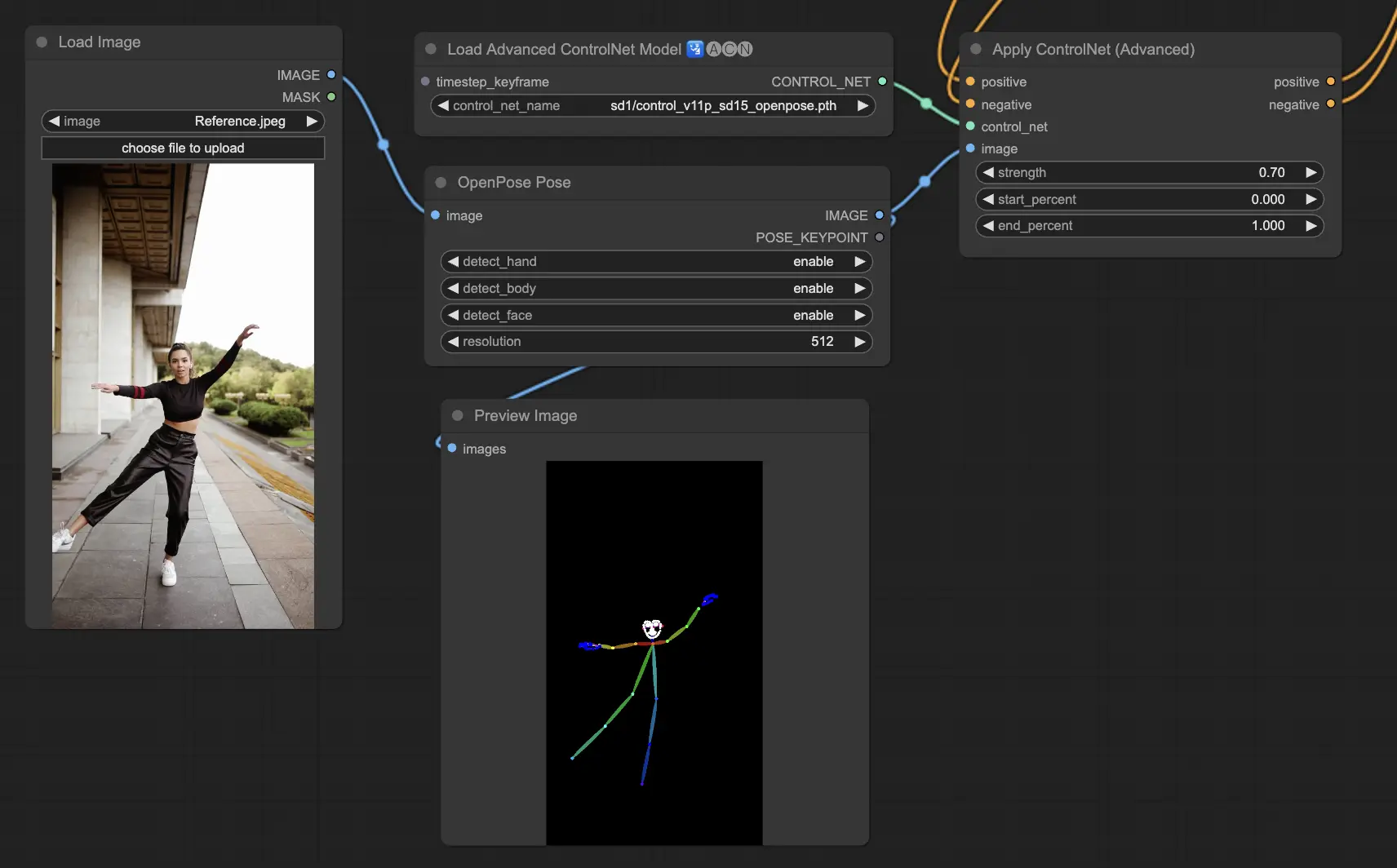

3.5.1. Modello ControlNet: Openpose

- Openpose (anche noto come Openpose body): Questo modello funge da pietra angolare di ControlNet per identificare i punti chiave del corpo umano, come gli occhi, il naso, il collo, le spalle, i gomiti, i polsi, le ginocchia e le caviglie. È perfetto per replicare semplici pose umane.

- Openpose_face: Questa versione di Openpose fa un passo avanti rilevando i punti chiave del viso, il che consente un'analisi dettagliata delle espressioni facciali e della direzione in cui è rivolto il viso. Se il tuo progetto è incentrato sulle espressioni facciali, questo modello è vitale.

- Openpose_hand: Questo miglioramento del modello Openpose si concentra sui dettagli fini dei movimenti di mani e dita, che è fondamentale per una comprensione dettagliata dei gesti e del posizionamento delle mani. Amplia la portata di ciò che Openpose può fare all'interno di ControlNet.

- Openpose_faceonly: Adattato per l'analisi dettagliata dei tratti del viso, questo modello salta i punti chiave del corpo per concentrarsi esclusivamente sulle espressioni e sull'orientamento del viso. Quando contano solo i lineamenti del viso, questo è il modello da scegliere.

- Openpose_full: Questo modello tutto in uno integra le capacità di Openpose, Openpose_face e Openpose_hand per il rilevamento completo dei punti chiave di corpo, viso e mani, rendendolo il punto di riferimento per un'analisi completa della posa umana all'interno di ControlNet.

- DW_Openpose_full: Basandosi su Openpose_full, questo modello introduce ulteriori miglioramenti per una migliore precisione e dettaglio nel rilevamento delle pose. È la versione più avanzata disponibile nella suite ControlNet.

Le opzioni del preprocessore includono: Openpose o DWpose

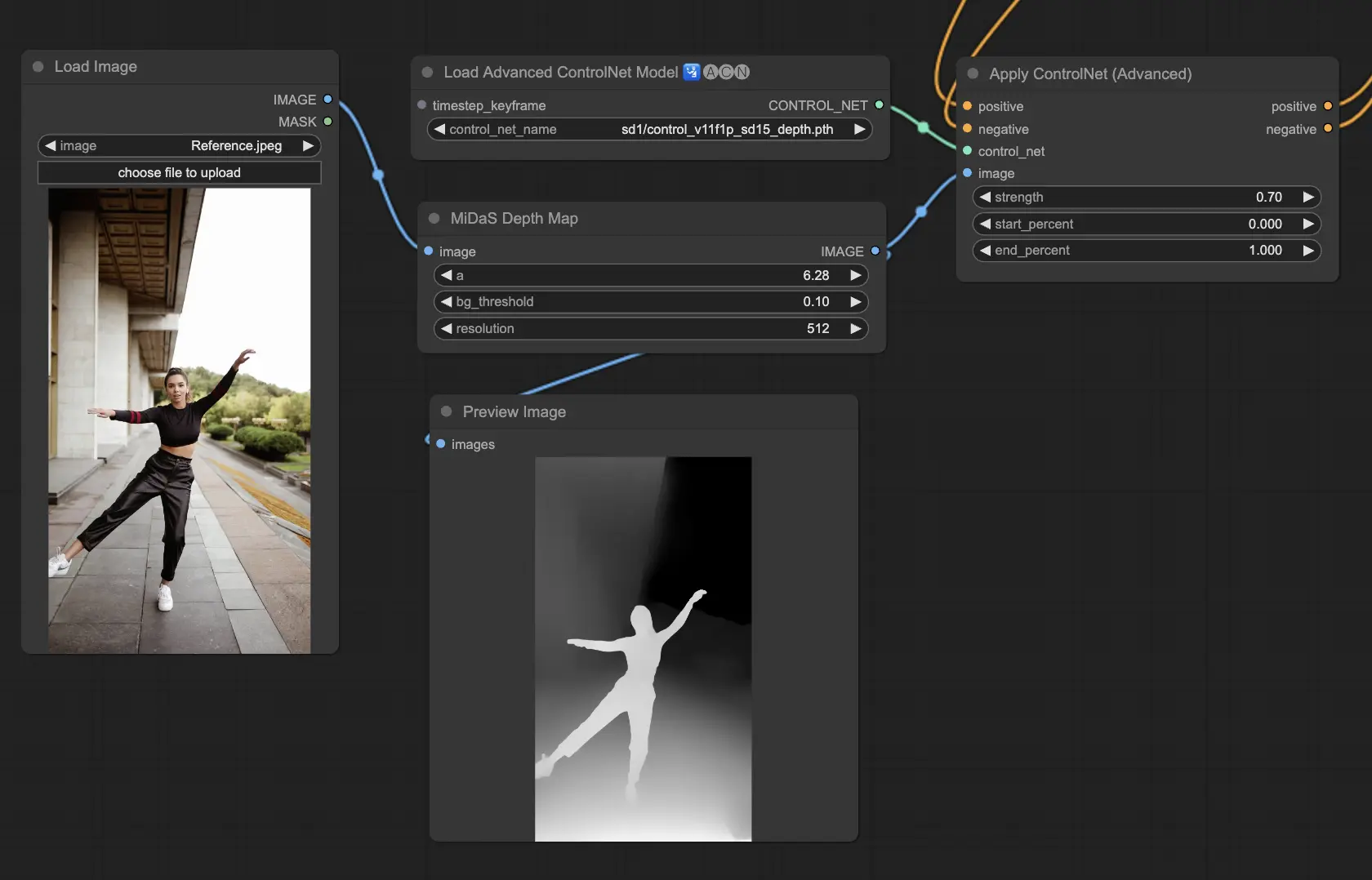

3.5.2. Modello ControlNet: Depth

I modelli Depth usano un'immagine 2D per dedurre la profondità, rappresentandola come una mappa in scala di grigi. Ognuno ha i suoi punti di forza in termini di dettaglio o messa a fuoco sullo sfondo:

- Depth Midas: Un approccio equilibrato alla stima della profondità, Depth Midas offre una via di mezzo nei dettagli e nella rappresentazione dello sfondo.

- Depth Leres: Pone l'accento sui dettagli pur catturando gli elementi di sfondo in modo più prominente.

- Depth Leres++: Spinge al limite i dettagli delle informazioni di profondità, il che è particolarmente utile per scene complesse.

- Zoe: Trova l'equilibrio tra i livelli di dettaglio dei modelli Midas e Leres.

- Depth Anything: Un modello migliorato per una stima versatile della profondità in diverse scene.

- Depth Hand Refiner: Affina specificamente i dettagli delle mani nelle mappe di profondità, rendendolo inestimabile per scene in cui il preciso posizionamento delle mani è essenziale.

Preprocessori da considerare: Depth_Midas, Depth_Leres, Depth_Zoe, Depth_Anything, MeshGraphormer_Hand_Refiner. Questo modello eccelle in robustezza e compatibilità con mappe di profondità reali da motori di rendering.

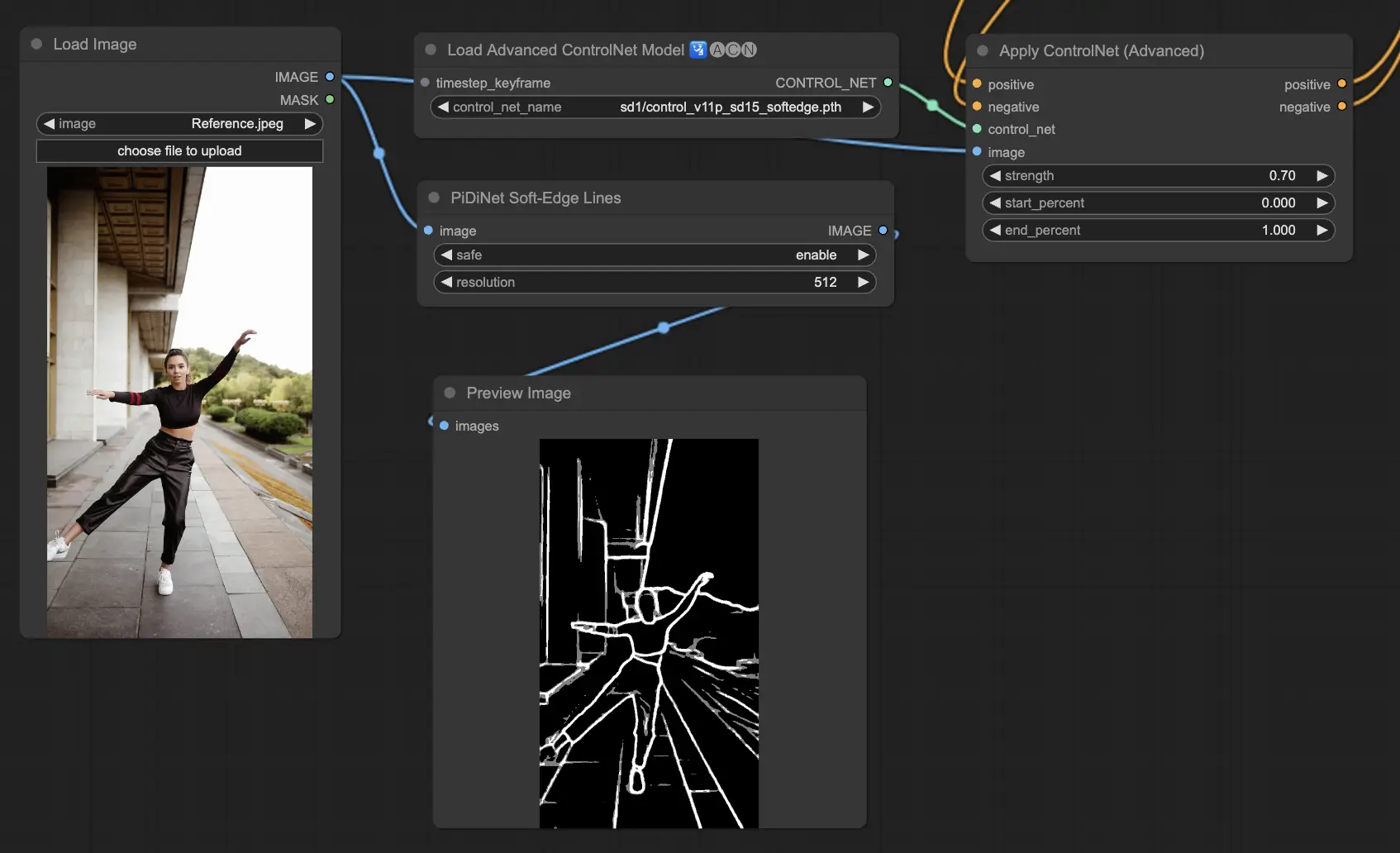

3.5.3. Modello ControlNet: SoftEdge

ControlNet Soft Edge è progettato per produrre immagini con bordi più morbidi, migliorando i dettagli pur mantenendo un aspetto naturale. Utilizza reti neurali all'avanguardia per una raffinata manipolazione delle immagini, offrendo un ampio controllo creativo e un'integrazione impeccabile.

In termini di robustezza: SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

Per risultati di massima qualità: SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

Come raccomandazione generale, SoftEdge_PIDI è l'opzione preferita poiché in genere fornisce risultati eccellenti.

I preprocessori includono: SoftEdge_PIDI, SoftEdge_PIDI_safe, SoftEdge_HED, SoftEdge_HED_safe.

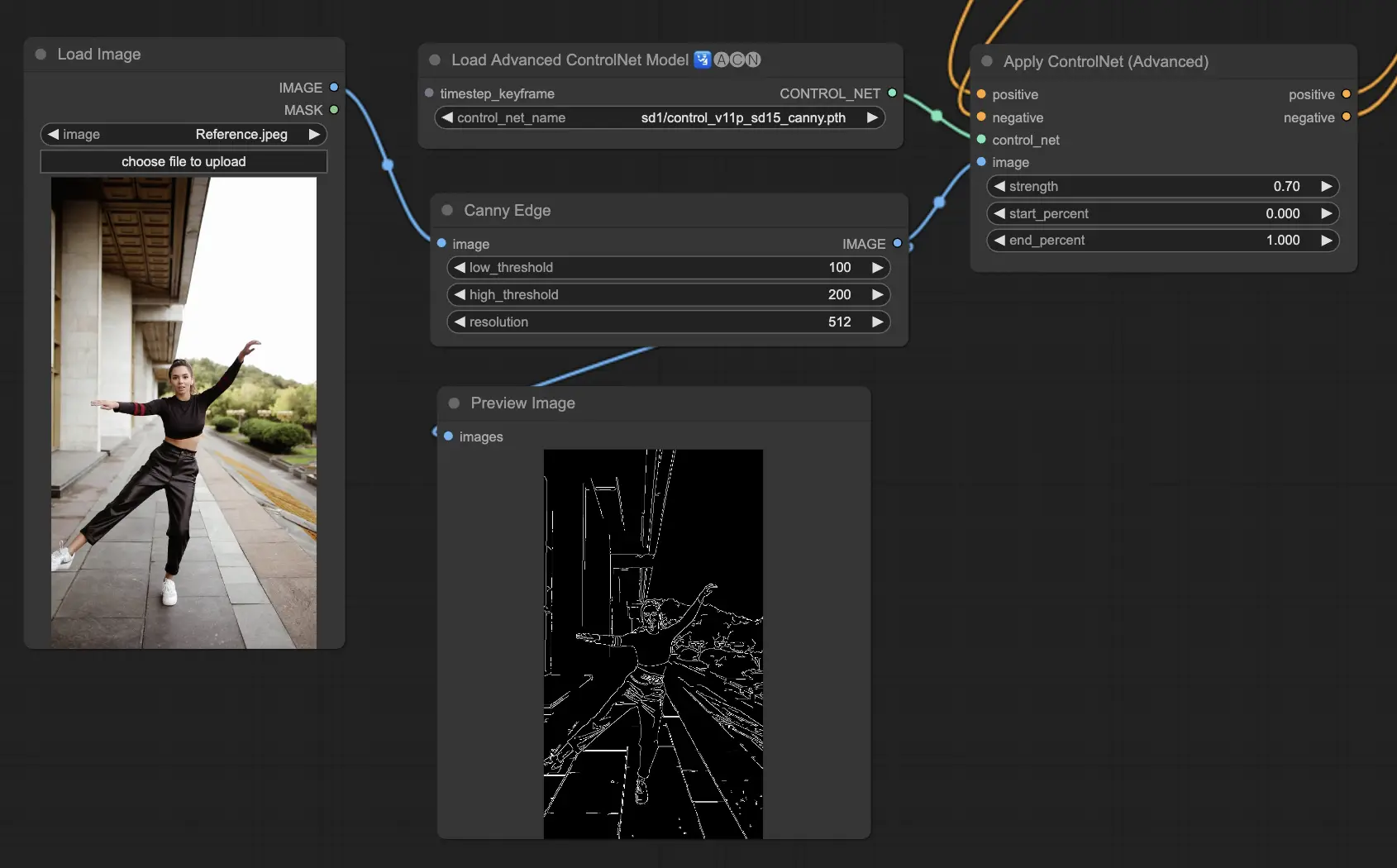

3.5.4. Modello ControlNet: Canny

Il modello Canny implementa il rilevamento dei bordi di Canny per evidenziare un'ampia gamma di bordi all'interno delle immagini. Questo modello è eccellente per mantenere l'integrità degli elementi strutturali pur semplificando l'aspetto generale dell'immagine, aiutando a creare arte stilizzata o a preparare le immagini per ulteriori manipolazioni.

Preprocessori disponibili: Canny

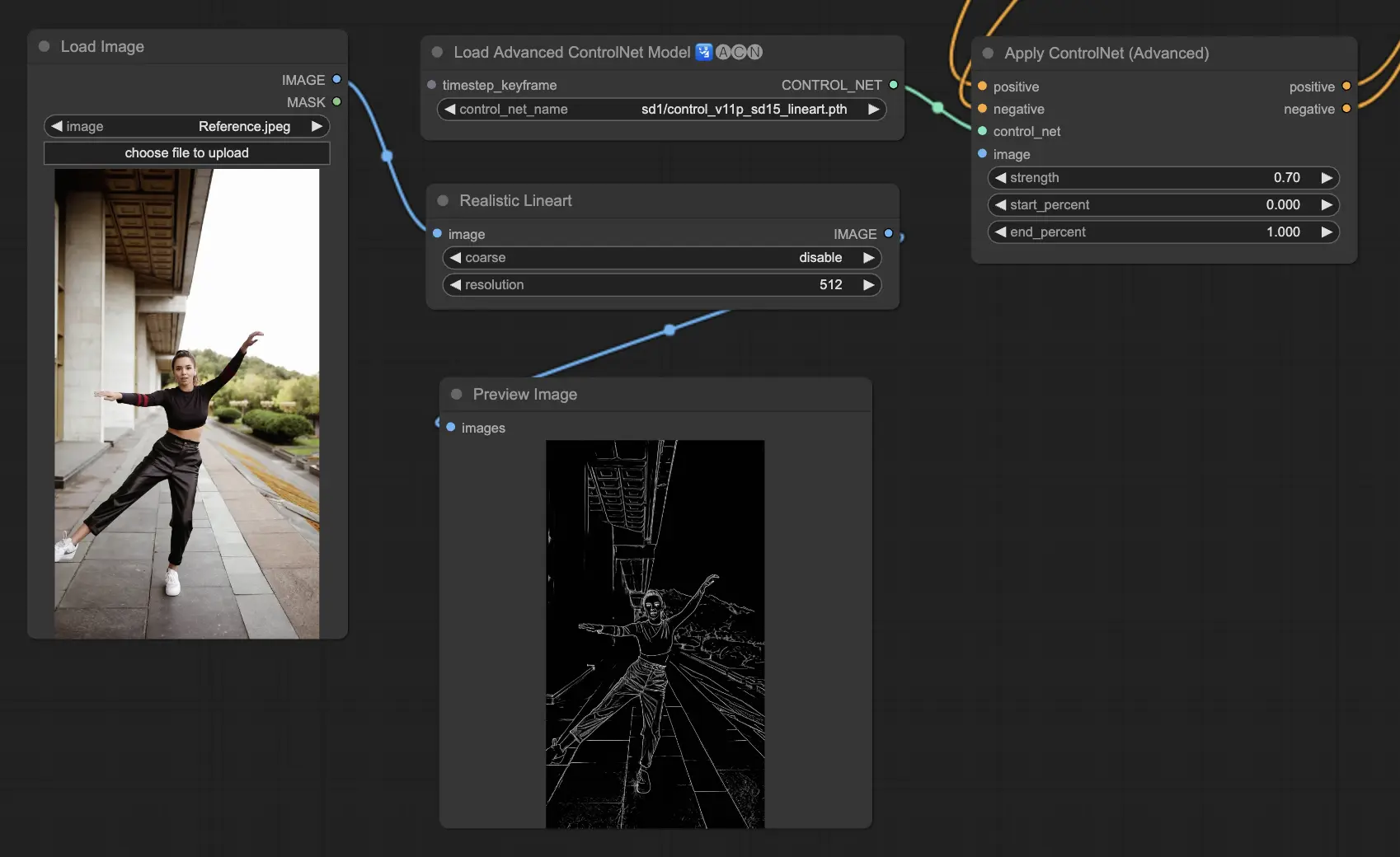

3.5.5. Modello ControlNet: Lineart

I modelli Lineart sono i tuoi strumenti per trasformare le immagini in disegni a linee stilizzati, adatti a una varietà di applicazioni artistiche:

- Lineart: La scelta standard per trasformare le immagini in disegni a linee, fornendo un versatile punto di partenza per diverse attività artistiche o creative.

- Lineart anime: Su misura per creare disegni a linee in stile anime puliti e precisi, perfetti per progetti che mirano a un look ispirato agli anime.

- Lineart realistic: Mira a catturare una rappresentazione più realistica nei disegni a linee, offrendo più dettagli per i progetti che richiedono realismo.

- Lineart coarse: Enfatizza linee più audaci e pronunciate per un impatto visivo sorprendente, ideale per affermazioni grafiche audaci.

I preprocessori disponibili possono produrre lineart dettagliati o più pronunciati (Lineart e Lineart_Coarse).

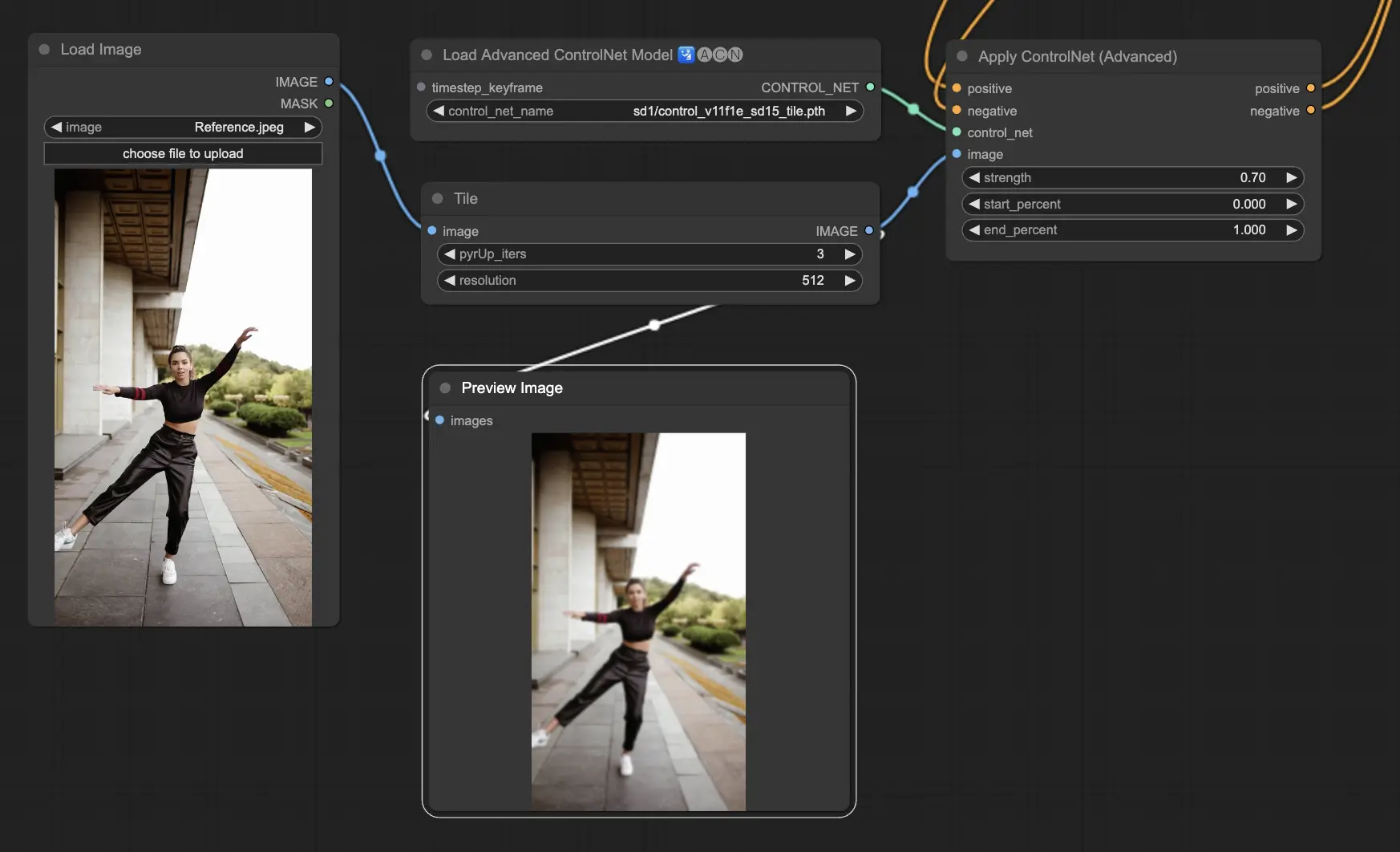

3.5.6. Modello ControlNet: Tile

Il modello Tile Resample eccelle nel far risaltare i dettagli nelle immagini. È particolarmente efficace quando usato in combinazione con un upscaler per migliorare la risoluzione e i dettagli dell'immagine, spesso applicato per affinare e arricchire le texture e gli elementi dell'immagine.

Preprocessore consigliato: Tile

3.6. Guida all'uso di più ControlNet

Incorporare più ControlNet o T2I-Adapter permette l'applicazione sequenziale di diversi tipi di condizionamento al processo di generazione delle immagini. Ad esempio, puoi combinare ControlNet Lineart e OpenPose per migliorare i dettagli.

Lineart per la forma degli oggetti: Inizia integrando un ControlNet Lineart per aggiungere profondità e dettagli a oggetti o elementi nelle tue immagini. Questo processo comporta la preparazione di una mappa lineart o canny per gli oggetti che desideri includere.

OpenPose per il controllo della posa: Dopo i dettagli lineart, utilizza il ControlNet OpenPose per dettare la posa degli individui all'interno dell'immagine. Sarà necessario generare o acquisire una mappa OpenPose che catturi la posa desiderata.

Applicazione sequenziale: Per combinare efficacemente questi effetti, collega l'output del ControlNet Lineart nel ControlNet OpenPose. Questo metodo garantisce che sia la posa dei soggetti che le forme degli oggetti siano guidate simultaneamente durante il processo di generazione, creando un risultato che si allinea armoniosamente con tutte le specifiche di input.

4. Panoramica di IPAdapter

Per favore, consulta i dettagli su