AnimateDiff + ControlNet + AutoMask | 코믹 스타일

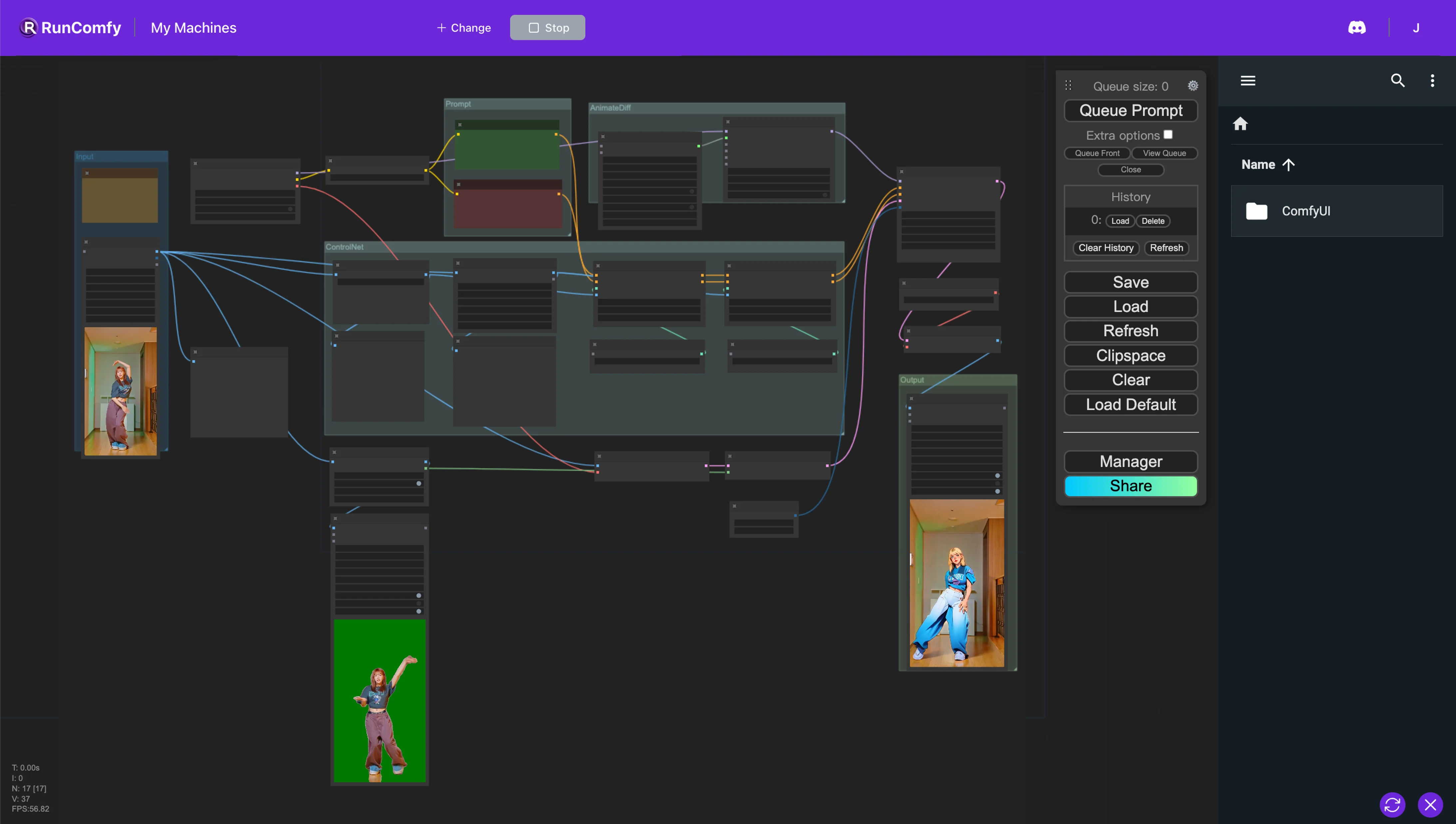

이 ComfyUI 워크플로우에서는 Animatediff, ControlNet(Depth 및 OpenPose 기능 포함), Auto Mask와 같은 사용자 지정 노드를 활용하여 비디오를 원활하게 리스타일링합니다. 이 프로세스는 실제와 같은 캐릭터를 애니메이션으로 변환하는 동시에 원본 배경을 꼼꼼하게 보존합니다.ComfyUI Vid2Vid 워크플로우

ComfyUI Vid2Vid 예제

ComfyUI Vid2Vid 설명

1. ComfyUI AnimateDiff, ControlNet 및 Auto Mask 워크플로우

이 ComfyUI 워크플로우는 캐릭터를 애니메이션 스타일로 변환하면서도 원본 배경을 유지하는 것을 목표로 하는 비디오 리스타일링에 대한 강력한 접근 방식을 소개합니다. 이 변환은 AnimateDiff, ControlNet, Auto Mask를 포함한 여러 핵심 구성 요소에 의해 지원됩니다.

AnimateDiff는 애니메이션 내에서 일관된 컨텍스트를 유지할 수 있도록 차등 애니메이션 기술을 위해 설계되었습니다. 이 구성 요소는 전환을 부드럽게 하고 리스타일링된 비디오 콘텐츠의 움직임 유동성을 향상시키는 데 초점을 맞춥니다.

ControlNet은 정확한 인간 포즈 복제 및 조작에서 중요한 역할을 합니다. 고급 포즈 추정을 활용하여 인간 움직임의 뉘앙스를 정확하게 포착하고 제어하여 캐릭터를 애니메이션 형식으로 변환하는 동시에 원래 포즈를 유지합니다.

Auto Mask는 자동 분할에 관여하며, 배경에서 캐릭터를 분리하는 데 능숙합니다. 이 기술을 통해 비디오 요소를 선택적으로 리스타일링할 수 있어 주변 환경을 변경하지 않고 캐릭터 변환을 수행할 수 있으며 원본 배경의 무결성을 유지합니다.

이 ComfyUI 워크플로우는 표준 비디오 콘텐츠를 스타일이 지정된 애니메이션으로 변환하며, 애니메이션 스타일 캐릭터 생성의 효율성과 품질에 중점을 둡니다.

2. AnimateDiff 개요

2.1. AnimateDiff 소개

AnimateDiff는 Stable Diffusion 모델과 특수 모션 모듈을 활용하여 정적 이미지와 텍스트 프롬프트를 동적 비디오로 애니메이션화하도록 설계된 AI 도구로 부상하고 있습니다. 이 기술은 프레임 간의 원활한 전환을 예측하여 애니메이션 프로세스를 자동화하여 코딩 기술이나 컴퓨팅 리소스가 없는 사용자도 무료 온라인 플랫폼을 통해 액세스할 수 있도록 합니다.

2.2. AnimateDiff의 주요 기능

2.2.1. 포괄적인 모델 지원: AnimateDiff는 Stable Diffusion V1.5용 AnimateDiff v1, v2, v3과 Stable Diffusion SDXL용 AnimateDiff sdxl 등 다양한 버전과 호환됩니다. 여러 모션 모델을 동시에 사용할 수 있어 복잡하고 계층화된 애니메이션을 만들 수 있습니다.

2.2.2. 애니메이션 길이를 결정하는 컨텍스트 배치 크기: AnimateDiff는 컨텍스트 배치 크기를 조정하여 무한한 길이의 애니메이션을 만들 수 있습니다. 이 기능을 통해 사용자는 특정 요구 사항에 맞게 애니메이션의 길이와 전환을 사용자 지정할 수 있어 매우 적응력 있는 애니메이션 프로세스를 제공합니다.

2.2.3. 부드러운 전환을 위한 컨텍스트 길이: AnimateDiff의 균일한 컨텍스트 길이의 목적은 애니메이션의 서로 다른 세그먼트 간의 원활한 전환을 보장하는 것입니다. 균일한 컨텍스트 길이를 조정하여 사용자는 장면 간 전환 역학을 제어할 수 있습니다. 더 부드럽고 원활한 전환을 위해 길이를 더 길게, 더 빠르고 두드러진 변화를 위해 길이를 더 짧게 조정할 수 있습니다.

2.2.4. 모션 역학: AnimateDiff v2에서는 애니메이션에 영화 같은 카메라 움직임을 추가하기 위해 특수 모션 LoRA를 사용할 수 있습니다. 이 기능은 애니메이션에 역동적인 레이어를 도입하여 시각적 매력을 크게 향상시킵니다.

2.2.5. 고급 지원 기능: AnimateDiff는 ControlNet, SparseCtrl, IPAdapter 등 다양한 도구와 함께 작동하도록 설계되어 프로젝트의 창의적 가능성을 확장하려는 사용자에게 상당한 이점을 제공합니다.

3. ControlNet 개요

3.1. ControlNet 소개

ControlNet은 조건부 입력으로 이미지 확산 모델을 강화하기 위한 프레임워크를 도입하여 이미지 합성 프로세스를 개선하고 안내하는 것을 목표로 합니다. 이를 위해 주어진 확산 모델 내의 신경망 블록을 두 세트로 복제합니다. 하나는 원래 기능을 유지하기 위해 "잠겨" 있고, 다른 하나는 "학습 가능"해져 제공된 특정 조건에 적응합니다. 이러한 이중 구조를 통해 개발자는 OpenPose, Tile, IP-Adapter, Canny, Depth, LineArt, MLSD, Normal Map, Scribbles, Segmentation, Shuffle, T2I Adapter와 같은 모델을 사용하여 다양한 조건부 입력을 통합함으로써 생성된 출력에 직접적인 영향을 미칠 수 있습니다. 이러한 메커니즘을 통해 ControlNet은 개발자에게 이미지 생성 프로세스를 제어하고 조작할 수 있는 강력한 도구를 제공하여 확산 모델의 유연성과 다양한 창의적 작업에 대한 적용 가능성을 향상시킵니다.

전처리기 및 모델 통합

3.1.1. 전처리 구성: ControlNet을 시작하려면 적합한 전처리기를 선택해야 합니다. 전처리 영향에 대한 시각적 이해를 위해 미리 보기 옵션을 활성화하는 것이 좋습니다. 전처리 후에는 전처리된 이미지를 사용하여 추가 처리 단계로 워크플로우가 전환됩니다.

3.1.2. 모델 매칭: ControlNet은 공유 키워드를 기반으로 모델을 해당 전처리기와 일치시켜 모델 선택 프로세스를 단순화하고 원활한 통합 프로세스를 촉진합니다.

3.2. ControlNet의 주요 기능

ControlNet 모델의 심층 탐구

3.2.1. OpenPose 스위트: 정확한 인간 포즈 감지를 위해 설계된 OpenPose 스위트는 신체 포즈, 얼굴 표정, 손 움직임을 탁월한 정확도로 감지하는 모델을 포함합니다. 다양한 OpenPose 전처리기는 기본 포즈 분석에서 얼굴 및 손의 뉘앙스에 이르기까지 특정 감지 요구 사항에 맞게 조정됩니다.

3.2.2. Tile Resample 모델: 이미지 해상도와 디테일을 향상시키는 Tile Resample 모델은 시각적 무결성을 손상시키지 않으면서 이미지 품질을 높이기 위해 업스케일링 도구와 함께 최적으로 사용됩니다.

3.2.3. IP-Adapter 모델: 이미지를 프롬프트로 혁신적으로 사용할 수 있도록 하는 IP-Adapter는 참조 이미지의 시각적 요소를 생성된 출력에 통합하여 텍스트 투 이미지 확산 기능을 병합하여 풍부한 시각적 콘텐츠를 제공합니다.

3.2.4. Canny 에지 감지기: 에지 감지 기능으로 높이 평가받는 Canny 모델은 이미지의 구조적 본질을 강조하여 핵심 구성을 유지하면서 창의적인 시각적 재해석을 가능하게 합니다.

3.2.5. Depth Perception 모델: 다양한 깊이 전처리기를 통해 ControlNet은 이미지에서 깊이 단서를 파생하고 적용하는 데 능숙하여 생성된 시각 자료에 계층화된 깊이 관점을 제공합니다.

3.2.6. LineArt 모델: LineArt 전처리기를 사용하여 이미지를 예술적인 선 그림으로 변환하십시오. 애니메이션에서 사실적인 스케치에 이르기까지 다양한 예술적 선호도를 수용하는 ControlNet은 다양한 스타일 욕구에 부응합니다.

3.2.7. Scribbles 처리: Scribble HED, Pidinet, xDoG와 같은 전처리기를 사용하여 ControlNet은 이미지를 독특한 낙서 예술로 변환하여 에지 감지 및 예술적 재해석을 위한 다양한 스타일을 제공합니다.

3.2.8. 분할 기술: ControlNet의 분할 기능은 이미지 요소를 정확하게 분류하여 개체 범주화를 기반으로 정밀한 조작을 가능하게 하므로 복잡한 장면 구성에 이상적입니다.

3.2.9. Shuffle 모델: 색상 구성표 혁신을 위한 방법을 도입하는 Shuffle 모델은 입력 이미지를 무작위로 재배열하여 새로운 색상 패턴을 생성하여 원본의 본질은 유지하면서 창의적으로 변경합니다.

3.2.10. T2I 어댑터 혁신: Color Grid 및 CLIP Vision Style을 포함한 T2I 어댑터 모델은 ControlNet을 새로운 창의적 영역으로 추진하여 원본의 색상 구성표 또는 양식 속성을 존중하는 시각적으로 매력적인 출력을 생성하기 위해 색상과 스타일을 혼합하고 조정합니다.

3.2.11. MLSD(Mobile Line Segment Detection): 직선 감지를 전문으로 하는 MLSD는 구조적 명확성과 정밀도를건축 및 인테리어 디자인에 중점을 둔 프로젝트에 매우 유용합니다.

3.2.12. Normal Map 처리: 표면 방향 데이터를 활용하는 Normal Map 전처리기는 참조 이미지의 3D 구조를 복제하여 자세한 표면 분석을 통해 생성된 콘텐츠의 사실성을 높입니다.