Stable Diffusion 3.5

Stable Diffusion 3.5 (SD3.5)는 텍스트 프롬프트로부터 다양한 고품질 이미지를 생성하는 새로운 오픈 소스 모델입니다. SD3.5는 다양한 스타일을 창조하고 프롬프트에 충실하게 따르는 데 뛰어납니다. 해부학적 정확성과 해상도에서 일부 한계가 있음에도 불구하고, SD3.5는 시각적 창작을 위한 강력한 도구입니다. ComfyUI에서 SD3.5를 탐색하여 쉽게 놀라운 비주얼을 만들어보세요.ComfyUI Stable Diffusion 3.5 워크플로우

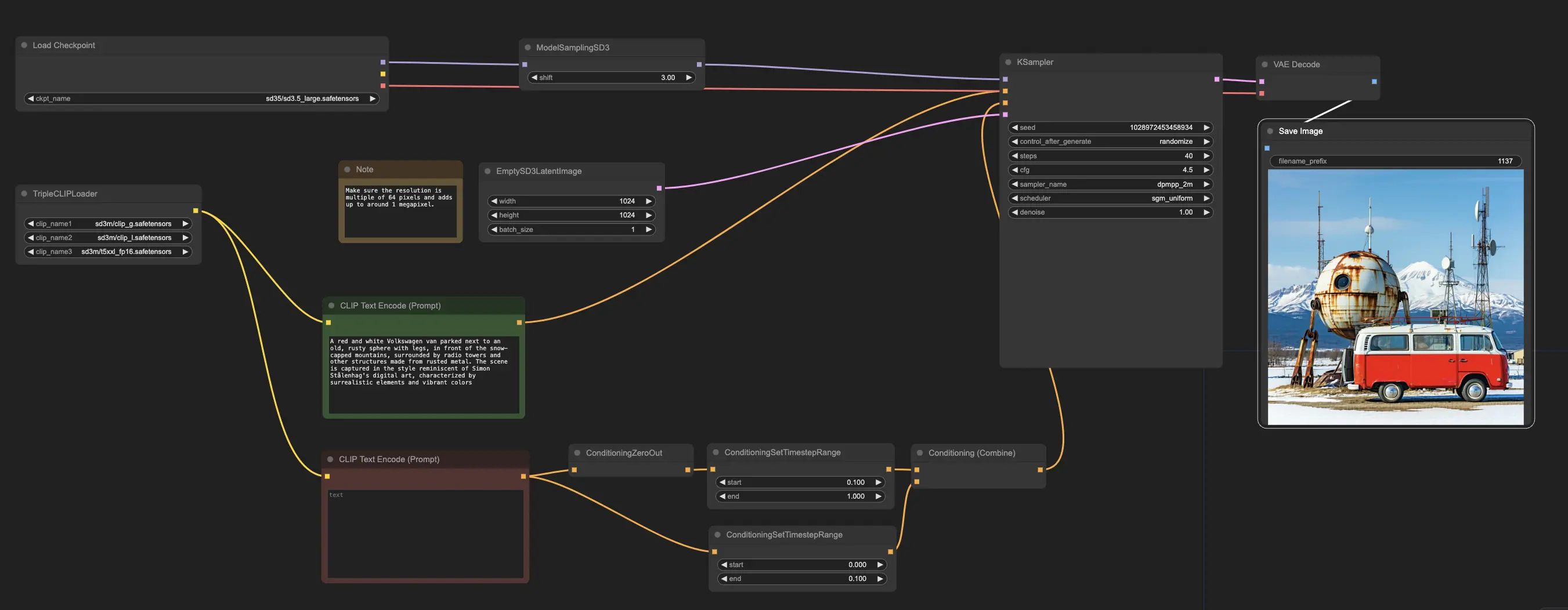

ComfyUI Stable Diffusion 3.5 예제

ComfyUI Stable Diffusion 3.5 설명

Stability AI는 를 공개했습니다. 이는 Stable Diffusion 3.5 (SD3.5) Large, Stable Diffusion 3.5 (SD3.5) Large Turbo, Stable Diffusion 3.5 (SD3.5) Medium을 포함한 여러 변형을 가진 오픈 소스 멀티모달 생성 AI 모델입니다. 이 모델들은 소비자 하드웨어에서 실행이 가능할 정도로 매우 맞춤화할 수 있습니다. SD3.5 Large 및 Large Turbo 모델은 즉시 사용할 수 있으며, Medium 버전은 2024년 10월 29일에 출시될 예정입니다.

1. Stable Diffusion 3.5 (SD3.5)의 작동 원리

기술적 수준에서, Stable Diffusion 3.5 (SD3.5)는 텍스트 프롬프트를 입력으로 받아, 변환기 기반 텍스트 인코더를 사용하여 잠재 공간으로 인코딩하고, 그런 다음 확산 기반 디코더를 사용하여 그 잠재 표현을 출력 이미지로 디코딩합니다. CLIP(Contrastive Language-Image Pre-training) 모델과 같은 변환기 텍스트 인코더는 입력 프롬프트를 잠재 공간에서 의미적으로 의미 있는 압축 표현으로 매핑합니다. 이 잠재 코드는 여러 시간 단계에 걸쳐 확산 디코더에 의해 점진적으로 잡음을 제거하여 최종 이미지 출력을 생성합니다. 확산 과정은 텍스트 임베딩을 조건으로 하여 초기의 잡음이 많은 잠재 표현에서 점진적으로 잡음을 제거하여 깨끗한 이미지를 생성하는 것을 포함합니다.

Stable Diffusion 3.5 (SD3.5)의 다양한 모델 크기(Large, Medium)는 학습 가능한 매개변수의 수를 나타냅니다 - Large 모델은 80억 개, Medium은 25억 개입니다. 더 많은 매개변수는 모델이 학습 데이터에서 더 많은 지식과 뉘앙스를 포착할 수 있게 해줍니다. 터보 모델들은 더 빠른 추론 속도를 위해 일부 품질을 희생하는 증류 버전입니다. 증류는 더 큰 "교사" 모델의 출력을 모방하도록 작은 "학생" 모델을 훈련하여 더 효율적인 아키텍처에서 대부분의 기능을 유지하는 것을 목표로 합니다.

2. Stable Diffusion 3.5 (SD3.5) 모델의 강점

2.1. 맞춤 가능성

Stable Diffusion 3.5 (SD3.5) 모델은 특정 응용 프로그램을 위해 쉽게 미세 조정되고 구축될 수 있도록 설계되었습니다. Query-Key Normalization은 변환기 블록에 통합되어 훈련을 안정화하고 추가 개발을 단순화했습니다. 이 기술은 변환기 레이어의 주의 점수를 정규화하여 모델을 더 견고하게 만들고 전이 학습을 통해 새로운 데이터셋에 쉽게 적응할 수 있게 합니다.

2.2. 출력의 다양성

Stable Diffusion 3.5 (SD3.5)는 광범위한 프롬프트 없이도 세계의 다양성을 대표하는 이미지를 생성하는 것을 목표로 합니다. 이는 다양한 피부 톤, 특징 및 미학을 가진 사람들을 묘사할 수 있습니다. 이는 인터넷 전반의 크고 다양한 이미지 데이터셋을 기반으로 모델이 훈련되었기 때문일 가능성이 큽니다.

2.3. 광범위한 스타일의 범위

Stable Diffusion 3.5 (SD3.5) 모델은 3D 렌더링, 사진 실사, 그림, 선화, 애니메이션 등 다양한 스타일의 이미지를 생성할 수 있습니다. 이 다재다능함은 많은 사용 사례에 적합합니다. 스타일의 다양성은 모델의 잠재 공간에서 많은 다른 시각적 패턴과 미학을 포착하는 확산 모델의 능력에서 비롯됩니다.

2.4. 강력한 프롬프트 준수

특히 Stable Diffusion 3.5 (SD3.5) Large 모델의 경우, SD3.5는 입력 텍스트 프롬프트의 의미와 일치하는 이미지를 생성하는 데 뛰어납니다. 이는 다른 모델에 비해 프롬프트 매칭 메트릭에서 높은 순위를 차지합니다. 텍스트를 이미지로 정확하게 변환하는 이 능력은 변환기 텍스트 인코더의 언어 이해 능력에 의해 구동됩니다.

3. Stable Diffusion 3.5 (SD3.5) 모델의 한계 및 단점

3.1. 해부학 및 객체 상호작용에서의 어려움

대부분의 텍스트-이미지 모델과 마찬가지로, Stable Diffusion 3.5 (SD3.5)도 여전히 현실적인 인체 해부학을 렌더링하는 데 어려움을 겪습니다. 특히 손, 발, 복잡한 자세의 얼굴이 그렇습니다. 객체와 손 사이의 상호작용은 종종 왜곡됩니다. 이는 2D 이미지에서 3D 공간 관계 및 물리학의 모든 뉘앙스를 학습하는 어려움 때문일 가능성이 큽니다.

3.2. 제한된 해상도

Stable Diffusion 3.5 (SD3.5) Large 모델은 1 메가픽셀 이미지(1024x1024)에 이상적이며, Medium은 약 2 메가픽셀에 도달합니다. SD3.5로 더 높은 해상도의 일관된 이미지를 생성하는 것은 어렵습니다. 이 제한은 확산 아키텍처의 계산 및 메모리 제약에서 비롯됩니다.

3.3. 가끔의 오류 및 환각

Stable Diffusion 3.5 (SD3.5) 모델은 동일한 프롬프트로부터 다양한 출력의 광범위한 다양성을 허용하기 때문에, 일부 예측 불가능성이 있을 수 있습니다. 구체성이 부족한 프롬프트는 결함이 있거나 예상치 못한 요소를 초래할 수 있습니다. 이는 무작위성을 포함하는 확산 샘플링 과정의 고유한 특성입니다.

3.4. 절대 첨단 기술에 미치지 못함

일부 초기 테스트에 따르면, 이미지 품질 및 일관성 측면에서 Stable Diffusion 3.5 (SD3.5)는 현재 Midjourney와 같은 최첨단 텍스트-이미지 모델의 성능에 미치지 못합니다. 그리고 Stable Diffusion 3.5 (SD3.5)와 FLUX.1의 초기 비교는 각 모델이 다른 영역에서 뛰어나다는 것을 보여줍니다. FLUX.1은 사진 실사 이미지 생성에서 우위를 점하고 있는 반면, SD3.5 Large는 추가 미세 조정이나 수정 없이 애니메이션 스타일의 아트를 생성하는 데 더 뛰어난 능력을 가지고 있습니다.

4. ComfyUI에서의 Stable Diffusion 3.5

RunComfy에서 우리는 Stable Diffusion 3.5 (SD3.5) 모델을 당신의 편의를 위해 미리 로드하여 쉽게 사용할 수 있도록 했습니다. 예제 워크플로우를 사용하여 바로 시작하고 추론을 실행할 수 있습니다

예제 워크플로우는 Stable Diffusion 3.5 Large 모델을 로드하는 CheckpointLoaderSimple 노드로 시작합니다. 그리고 모델이 이해할 수 있는 형식으로 텍스트 프롬프트를 번역하는 데 도움을 주기 위해 TripleCLIPLoader 노드는 해당 인코더를 로드하는 데 사용됩니다. 이러한 인코더는 제공된 텍스트에 기반하여 이미지 생성 과정을 안내하는 데 필수적입니다.

EmptySD3LatentImage 노드는 지정된 크기, 일반적으로 1024x1024 픽셀의 빈 캔버스를 생성하여 모델이 이미지를 생성할 시작점을 제공합니다. CLIPTextEncode 노드는 제공된 텍스트 프롬프트를 처리하며, 로드된 인코더를 사용하여 모델이 따를 지시 사항 세트를 생성합니다.

이 지시 사항이 모델에 전송되기 전에, ConditioningCombine, ConditioningZeroOut, ConditioningSetTimestepRange 노드를 통해 추가로 정제됩니다. 이러한 노드는 부정적인 프롬프트의 영향을 제거하고, 생성 과정 중 언제 프롬프트가 적용되어야 하는지를 지정하며, 지시 사항을 단일 통합 세트로 결합합니다.

마지막으로, ModelSamplingSD3 노드를 사용하여 샘플링 모드, 단계 수 및 모델 출력 스케일과 같은 다양한 설정을 조정하여 이미지 생성 과정을 미세 조정할 수 있습니다. 마지막으로, KSampler 노드는 단계 수, 지시 사항의 영향력(CFG 스케일), 생성에 사용되는 특정 알고리즘을 제어하여 원하는 결과를 달성할 수 있도록 합니다.