1. Fluxo de Trabalho ComfyUI AnimateLCM

O Fluxo de Trabalho ComfyUI AnimateLCM é projetado para aumentar a velocidade da animação de IA. Baseando-se nos fundamentos do ComfyUI-AnimateDiff-Evolved, este fluxo de trabalho incorpora o AnimateLCM para acelerar especificamente a criação de animações de texto para vídeo (t2v). Você pode experimentar com vários prompts e etapas para obter os resultados desejados.

2. Visão Geral do AnimateLCM

O advento de tecnologias como SDXL, LCM e SDXL Turbo impulsionou significativamente o ritmo da geração de imagens. O AnimateLCM impulsiona ainda mais o progresso na animação de IA. Ele suporta a geração rápida de imagem para vídeo e visa melhorar a velocidade e eficiência da produção de vídeos animados a partir de imagens estáticas ou descrições de texto, tornando-o particularmente útil para criar efeitos de animação personalizados rapidamente.

2.1. Introdução ao AnimateLCM

O AnimateLCM é projetado para acelerar a animação de modelos de difusão personalizados e adaptadores por meio do aprendizado de consistência desacoplado. É inspirado no Consistency Model (CM), que destila modelos de difusão de imagem pré-treinados para acelerar o processo de amostragem, e sua extensão, o Latent Consistency Model (LCM), que se concentra na geração de imagem condicional. O AnimateLCM aproveita essas bases para permitir a criação de vídeos com alta fidelidade em poucas etapas, baseando-se no sucesso das técnicas de difusão e geração de imagens para expandir suas capacidades para o domínio de vídeo.

2.2. Como usar o AnimateLCM em seu Fluxo de Trabalho ComfyUI

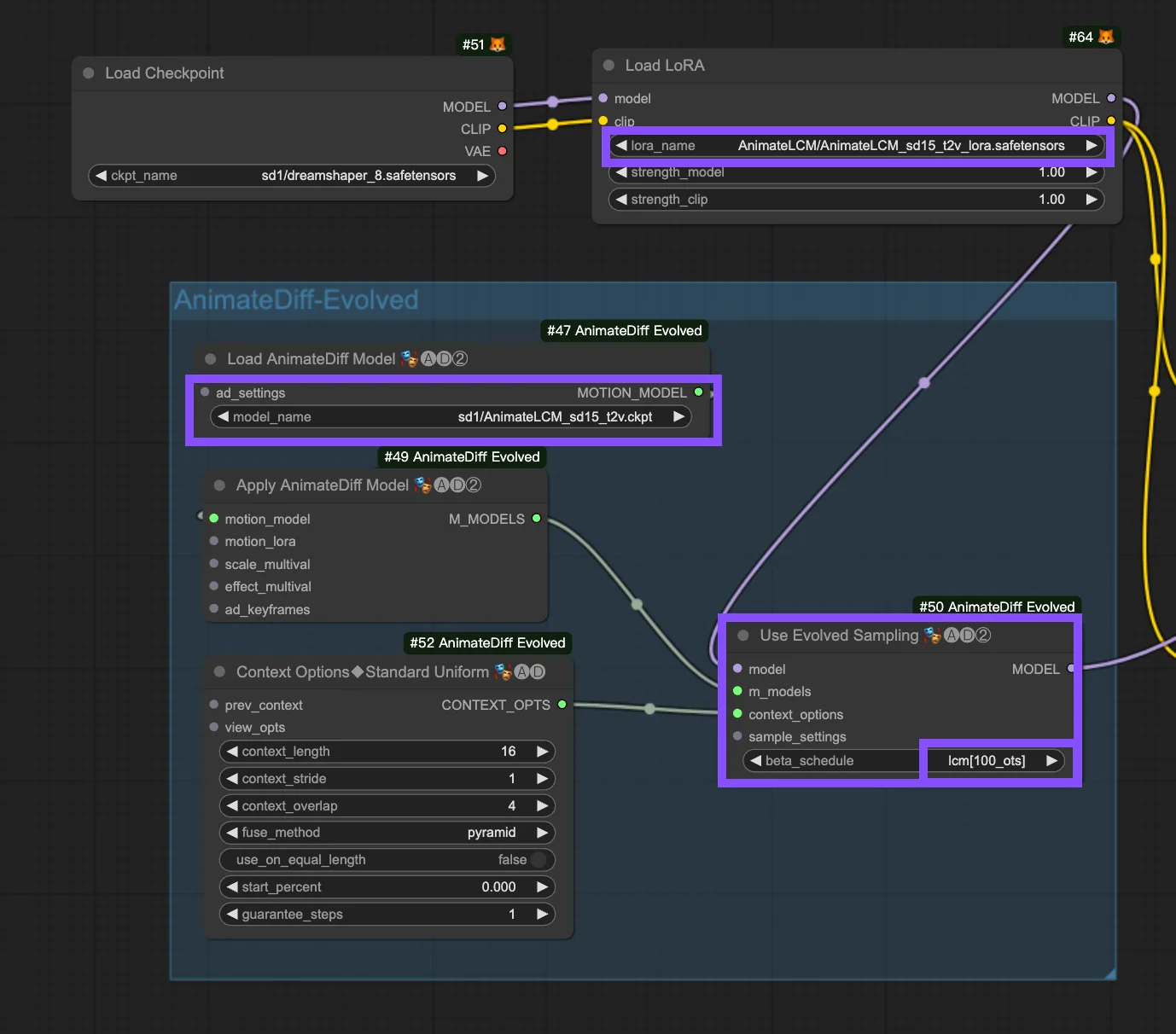

Este fluxo de trabalho se baseia no Fluxo de Trabalho ComfyUI-AnimateDiff-Evolved. A seguir estão os parâmetros de configuração no nó "Use Evolved Sampling".

Models: Defina o modelo de checkpoint e o modelo LoRA.

- Checkpoint: Refere-se às entradas do modelo StableDiffusion (SD) utilizadas para a criação de animação. Dependendo dos modelos de movimento escolhidos, a compatibilidade pode variar entre as versões do SD, como SD1.5 ou SDXL.

- LoRA: Incorpore o modelo AnimateLCM LoRA para integrar perfeitamente adaptadores existentes para uma variedade de funções, melhorando a eficiência e a qualidade de saída com foco no aprendizado de consistência sem sacrificar a velocidade de amostragem.

Motion Models (M Models): São as saídas do processo Apply AnimateDiff Model, permitindo o uso do AnimateLCM Motion Model.

Context Options: Essas configurações ajustam a operação do AnimateDiff durante a produção de animação, permitindo animações de qualquer comprimento por meio de janelas de contexto deslizantes em toda a Unet ou especificamente no módulo de movimento. Elas também permitem ajustes de tempo para sequências de animação complexas. Consulte aqui um guia abrangente sobre o AnimateDiff

Beta Schedule in Sample Settings: Opte por LCM. Dentro das Configurações de Amostra do AnimateDiff no ComfyUI, a seleção "beta schedule", incluindo opções como "lcm", "lineart", etc., ajusta os valores beta que regulam os níveis de ruído ao longo do processo de difusão. Essa personalização afeta o estilo visual e a fluidez da animação. Cada configuração atende a necessidades específicas de animação ou modelo de movimento.

- LCM (Latent Consistency Module): A configuração "lcm" é adaptada para LoRAs LCM, aprimorando a uniformidade da animação e reduzindo o tempo de criação. Ele alcança uma convergência mais rápida com menos etapas, exigindo redução de etapas (para um mínimo de ~4 etapas) e outros ajustes de parâmetros para uma retenção de detalhes ideal.

- Linear (AnimateDiff-SDXL): Recomendado para AnimateDiff com módulos de movimento SDXL, esta opção equilibra a preservação de detalhes e o movimento suave, indicando compatibilidade com versões específicas do modelo de movimento.

- Sqrt_lineart (AnimateDiff): Semelhante ao "lineart", essa variante é projetada para processos AnimateDiff, especialmente com módulos de movimento V2, modificando os níveis de ruído para complementar a saída do modelo de movimento para transições ou movimentos mais fluidos.