ComfyUI > Fluxos de Trabalho > Dilatação de Máscara Audioreativa | Animações Deslumbrantes

Dilatação de Máscara Audioreativa | Animações Deslumbrantes

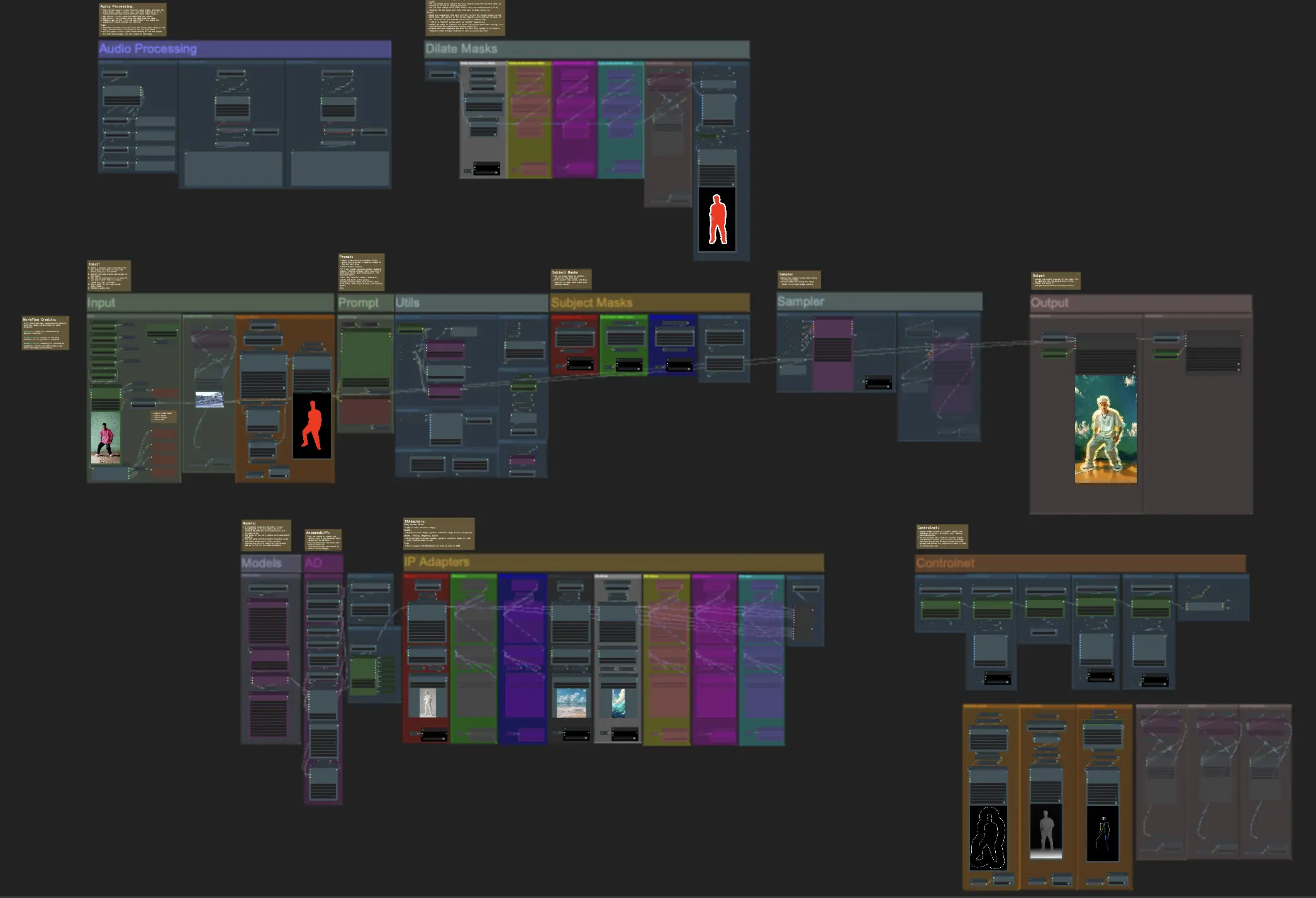

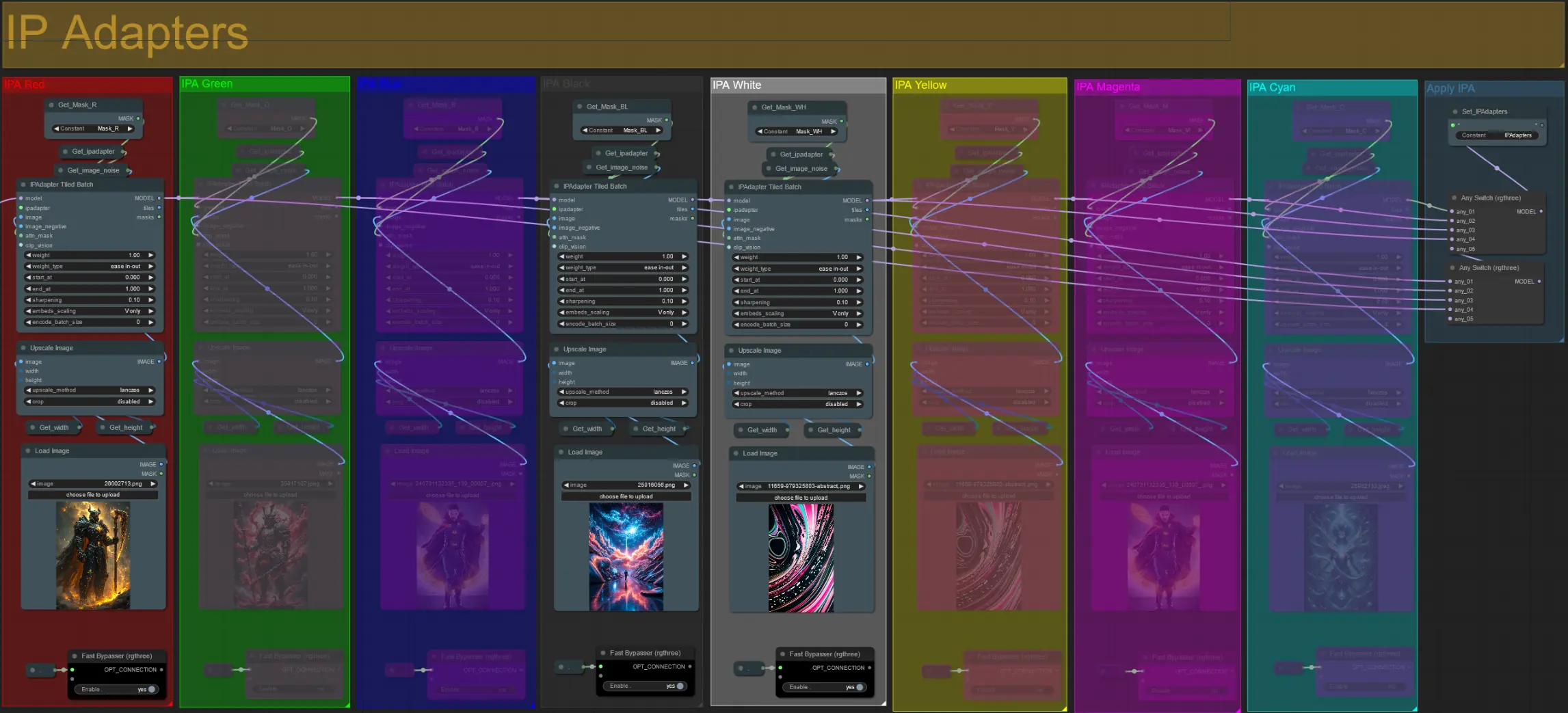

Este workflow de Dilatação de Máscara Audioreativa do ComfyUI permite que você transforme criativamente os sujeitos dos seus vídeos. Ele permite que você envolva seus sujeitos, seja um indivíduo ou um grupo de performers, com uma aura dinâmica e responsiva que se expande e contrai em perfeita sincronização com o ritmo da música. Este efeito adiciona uma dimensão visual cativante aos seus vídeos, aumentando seu impacto e engajamento geral.ComfyUI Audioreactive Mask Dilation Fluxo de Trabalho

Deseja executar este fluxo de trabalho?

- Fluxos de trabalho totalmente operacionais

- Sem nós ou modelos ausentes

- Nenhuma configuração manual necessária

- Apresenta visuais impressionantes

ComfyUI Audioreactive Mask Dilation Exemplos

ComfyUI Audioreactive Mask Dilation Descrição

Crie animações de vídeo deslumbrantes transformando seu sujeito (por exemplo, um dançarino) com uma aura dinâmica que se expande e contrai ritmicamente em sincronia com o ritmo. Use este workflow com sujeitos únicos ou múltiplos, como visto nos exemplos.

Como usar o Workflow de Dilatação de Máscara Audioreativa:

- Carregue um vídeo do sujeito na seção de Entrada

- Selecione a largura e altura desejadas para o vídeo final, juntamente com quantos quadros do vídeo de entrada devem ser pulados com 'every_nth'. Você também pode limitar o número total de quadros a serem renderizados com 'frame_load_cap'.

- Preencha o prompt positivo e negativo. Defina os tempos de batch frame para corresponder ao momento em que você gostaria que as transições de cena ocorressem.

- Carregue imagens para cada uma das cores padrão da máscara do sujeito do IP Adapter:

- Vermelho = sujeito (dançarino)

- Preto = Fundo

- Branco = Máscara de dilatação audioreativa branca

- Carregue um bom checkpoint LCM (eu uso ParadigmLCM por Machine Delusions) na seção 'Models'.

- Adicione quaisquer loras usando o Lora stacker abaixo do carregador de modelos

- Clique em Queue Prompt

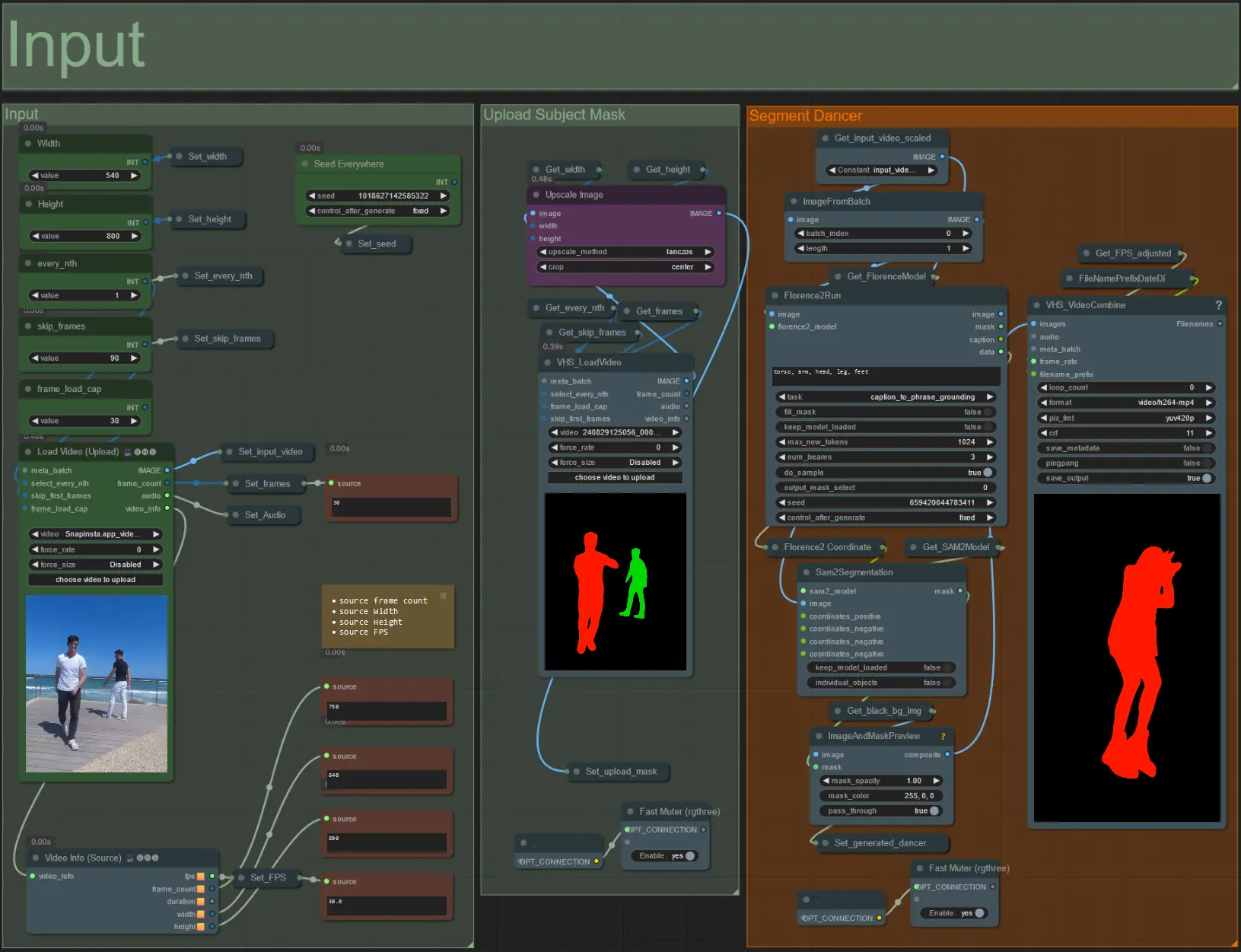

Input

- Carregue o vídeo do sujeito desejado no nó Load Video (Upload).

- Ajuste a largura e altura de saída usando as duas entradas no canto superior esquerdo.

- every_nth define se deve usar cada quadro, a cada dois quadros, a cada três quadros e assim por diante (2 = a cada dois quadros). Deixado em 1 por padrão.

- skip_frames é usado para pular quadros no início do vídeo. (100 = pular os primeiros 100 quadros do vídeo de entrada). Deixado em 0 por padrão.

- frame_load_cap é usado para especificar quantos quadros totais do vídeo de entrada devem ser carregados. Melhor manter baixo ao testar configurações (30 - 60, por exemplo) e então aumentar ou definir para 0 (sem limite de quadros) ao renderizar o vídeo final.

- Os campos numéricos no canto inferior direito exibem informações sobre o vídeo de entrada carregado: quadros totais, largura, altura e FPS de cima para baixo.

- Se você já tiver um vídeo de máscara do sujeito gerado, desmute a seção 'Upload Subject Mask' e carregue o vídeo da máscara. Opcionalmente, mute a seção 'Segment Dancer' para economizar tempo de processamento.

- Às vezes, o sujeito segmentado não será perfeito, então verifique a qualidade da máscara usando a caixa de visualização no canto inferior direito, conforme visto acima. Se for o caso, você pode brincar com o prompt no nó 'Florence2Run' para direcionar diferentes partes do corpo, como 'cabeça', 'peito', 'pernas', etc., e ver se obtém um resultado melhor.

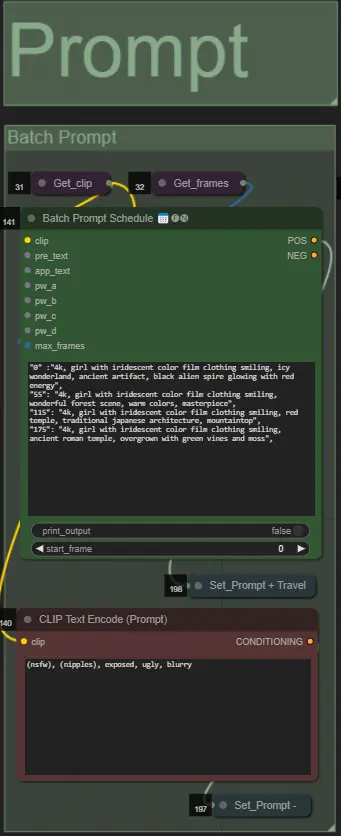

Prompt

- Defina o prompt positivo usando a formatação de batch:

- por exemplo, '0': '4k, masterpiece, 1girl standing on the beach, absurdres', '25': 'HDR, sunset scene, 1girl with black hair and a white jacket, absurdres', …

- O prompt negativo é no formato normal, adicione embeddings se desejar.

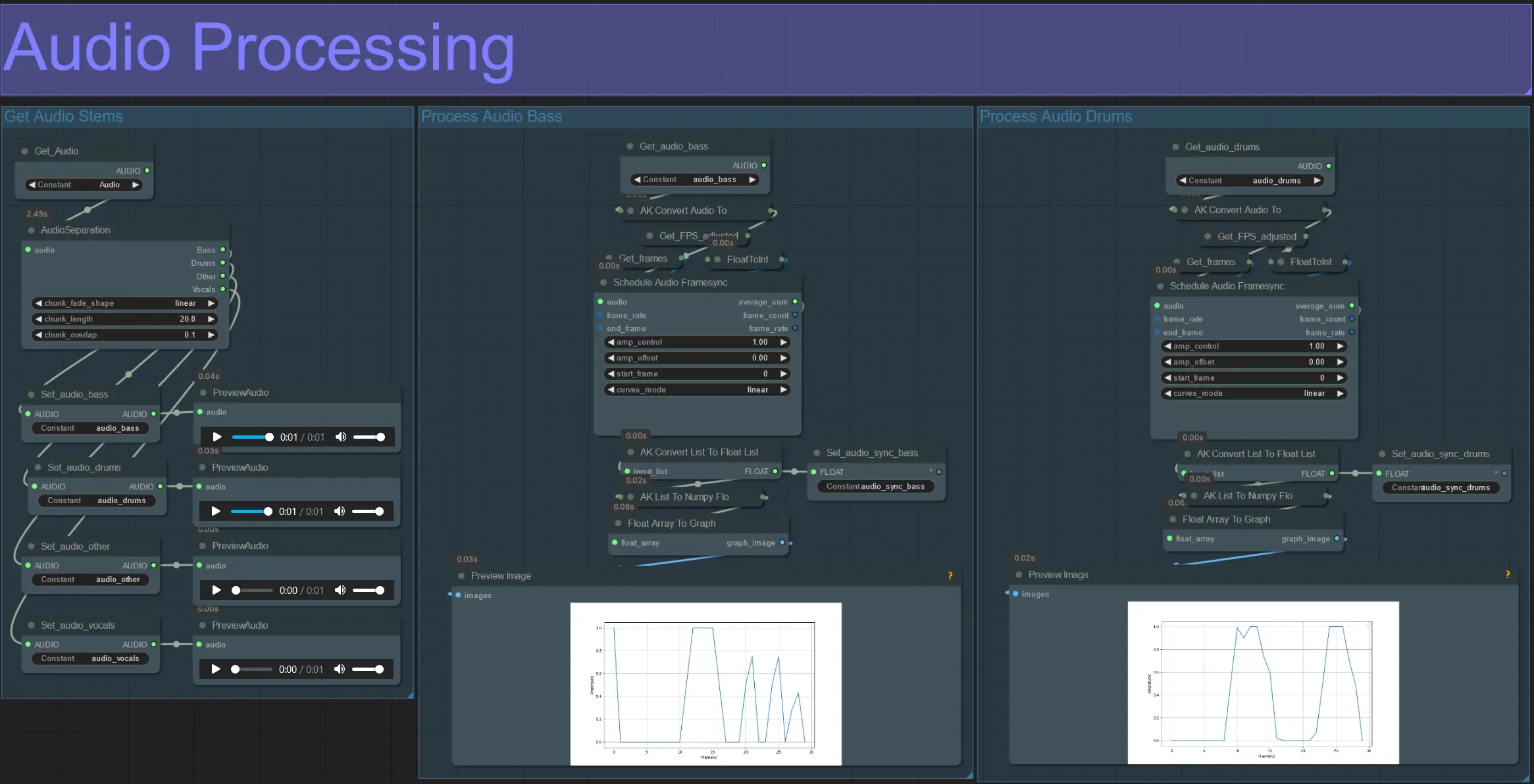

Processamento de Áudio

- Esta seção recebe o áudio do vídeo de entrada, extrai os stems (baixo, bateria, vocais, etc.) e depois converte para uma amplitude normalizada sincronizada com os quadros do vídeo de entrada.

- amp_control = alcance total que a amplitude pode percorrer.

- amp_offset = valor mínimo que a amplitude pode assumir.

- Exemplo: amp_control = 0.8 e amp_offset = 0.2 significa que o sinal percorrerá entre 0.2 e 1.0.

- Às vezes, o stem de Bateria contém as notas reais de Baixo da música; visualize cada um para determinar qual é o melhor para suas máscaras.

- Use os gráficos para obter uma compreensão clara de como o sinal para aquele stem muda ao longo da duração do vídeo.

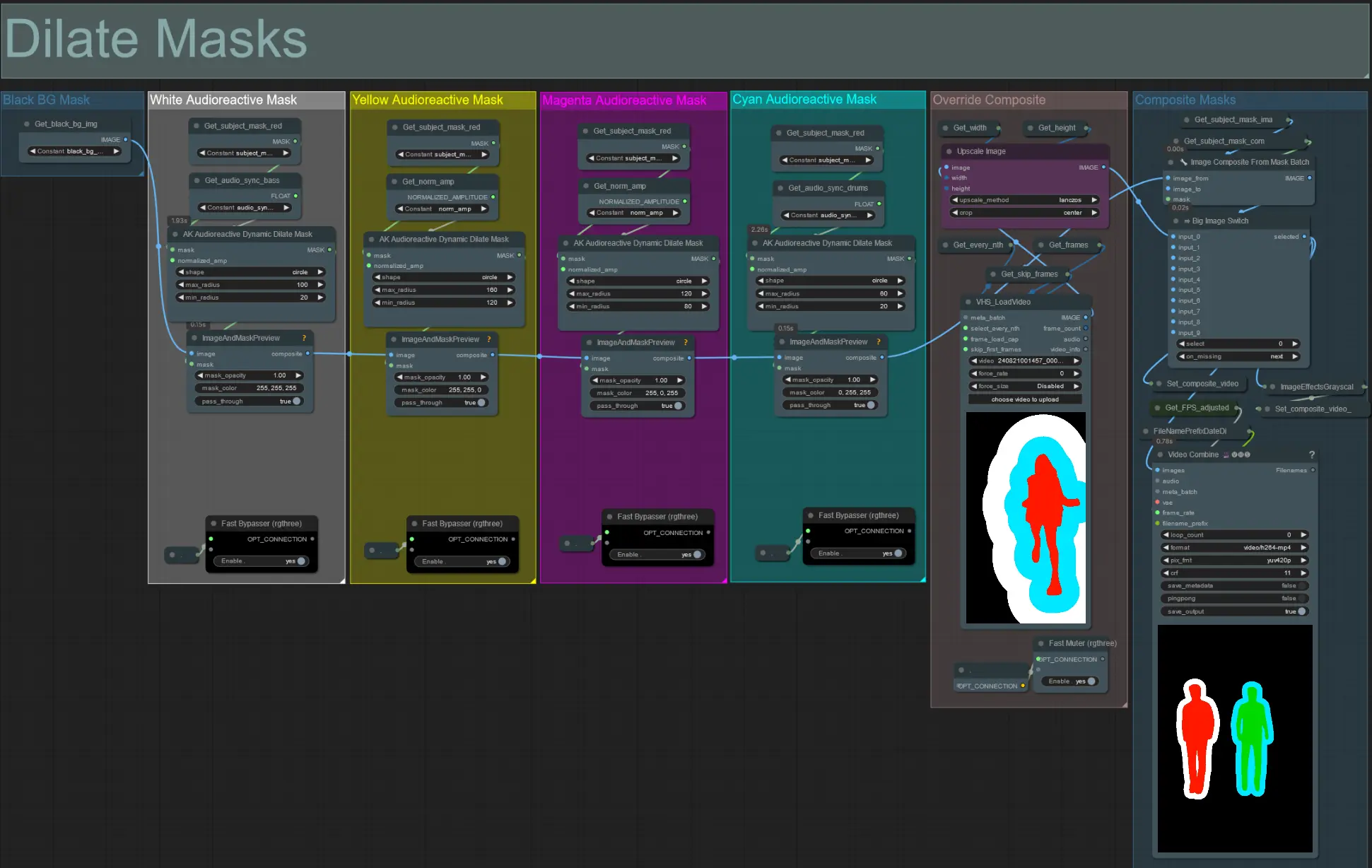

Dilatar Máscaras

- Cada grupo colorido corresponde à cor da máscara de dilatação que será gerada por ele.

- Defina o raio mínimo e máximo para a máscara de dilatação, junto com sua forma, usando o seguinte nó:

- forma: 'círculo' é o mais preciso, mas leva mais tempo para gerar. Defina isso quando estiver pronto para realizar a renderização final. 'quadrado' é rápido de calcular, mas menos preciso, melhor para testar o workflow e decidir sobre as imagens do IP adapter.

- max_radius: O raio da máscara em pixels quando o valor da amplitude é máximo (1.0).

- min_radius: O raio da máscara em pixels quando o valor da amplitude é mínimo (0.0).

- Se você já tem um vídeo de máscara composto gerado, pode desmutar o grupo 'Override Composite Mask' e carregá-lo. Recomenda-se ignorar os grupos de máscara de dilatação se estiver substituindo para economizar tempo de processamento.

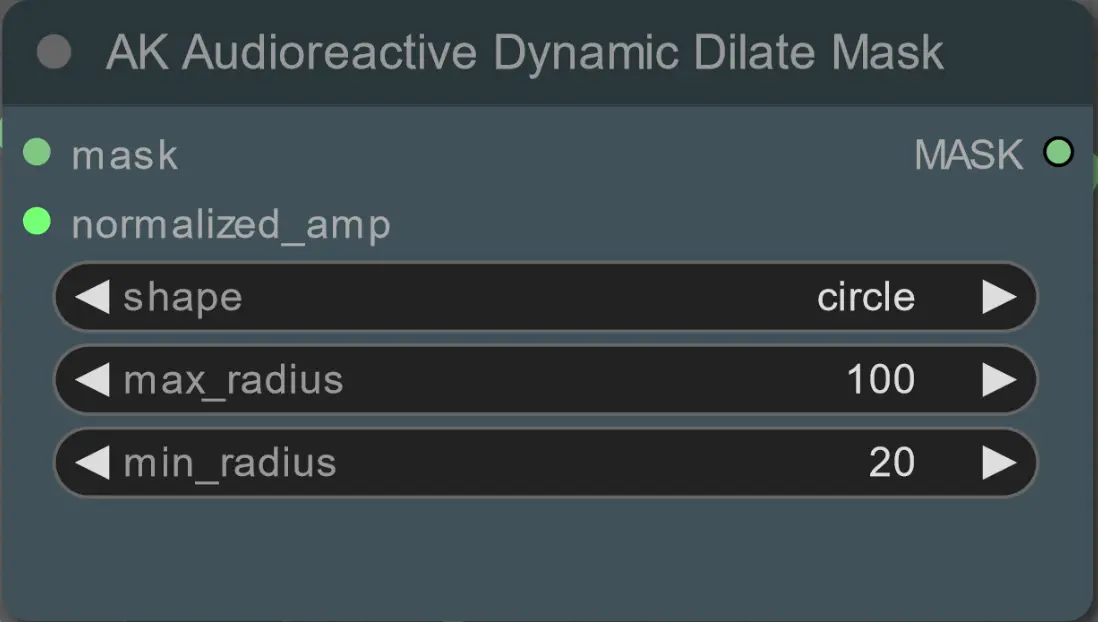

Modelos

- Use um bom modelo LCM para o checkpoint. Eu recomendo ParadigmLCM por Machine Delusions.

- Mescle vários modelos juntos usando o Model Merge Stack para obter vários efeitos interessantes. Certifique-se de que os pesos somem 1.0 para os modelos habilitados.

- Opcionalmente, especifique o AnimateLCM_sd15_t2v_lora.safetensors com um peso baixo de 0.18 para melhorar ainda mais o resultado final.

- Adicione quaisquer Loras adicionais ao modelo usando o Lora stacker abaixo do carregador de modelos.

AnimateDiff

- Defina um Motion Lora diferente do que eu usei (LiquidAF-0-1.safetensors)

- Aumente/diminua as floats Scale e Effect para aumentar/diminuir a quantidade de movimento na saída.

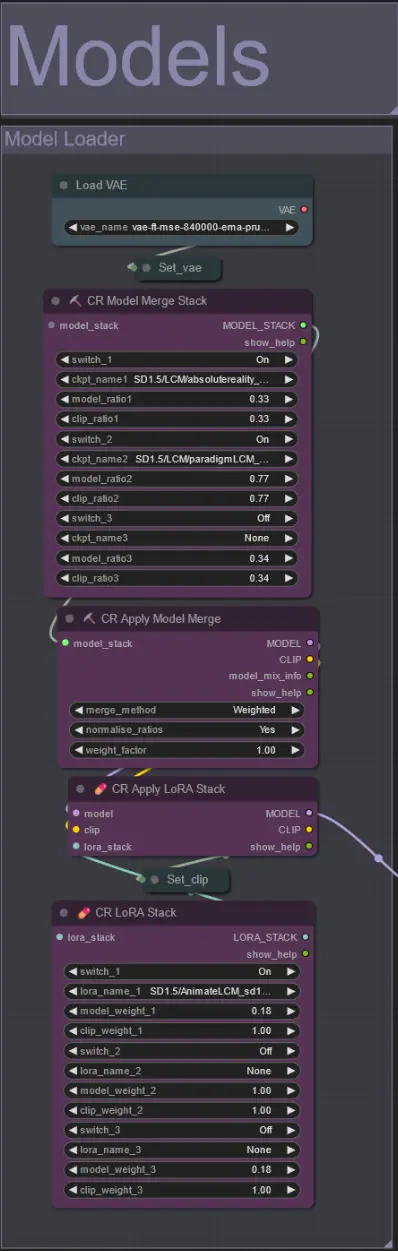

IP Adapters

- Aqui você pode especificar as imagens de referência que serão usadas para renderizar os fundos para cada uma das máscaras de dilatação, bem como seu(s) sujeito(s) do vídeo.

- A cor de cada grupo representa a máscara que ele direciona:

Vermelho, Verde, Azul:

- Imagens de referência da máscara do sujeito.

Preto:

- Imagem de máscara de fundo, carregue uma imagem de referência para o fundo.

Branco, Amarelo, Magenta, Ciano:

- Imagens de referência da máscara de dilatação, carregue uma imagem de referência para cada cor de máscara de dilatação em uso.

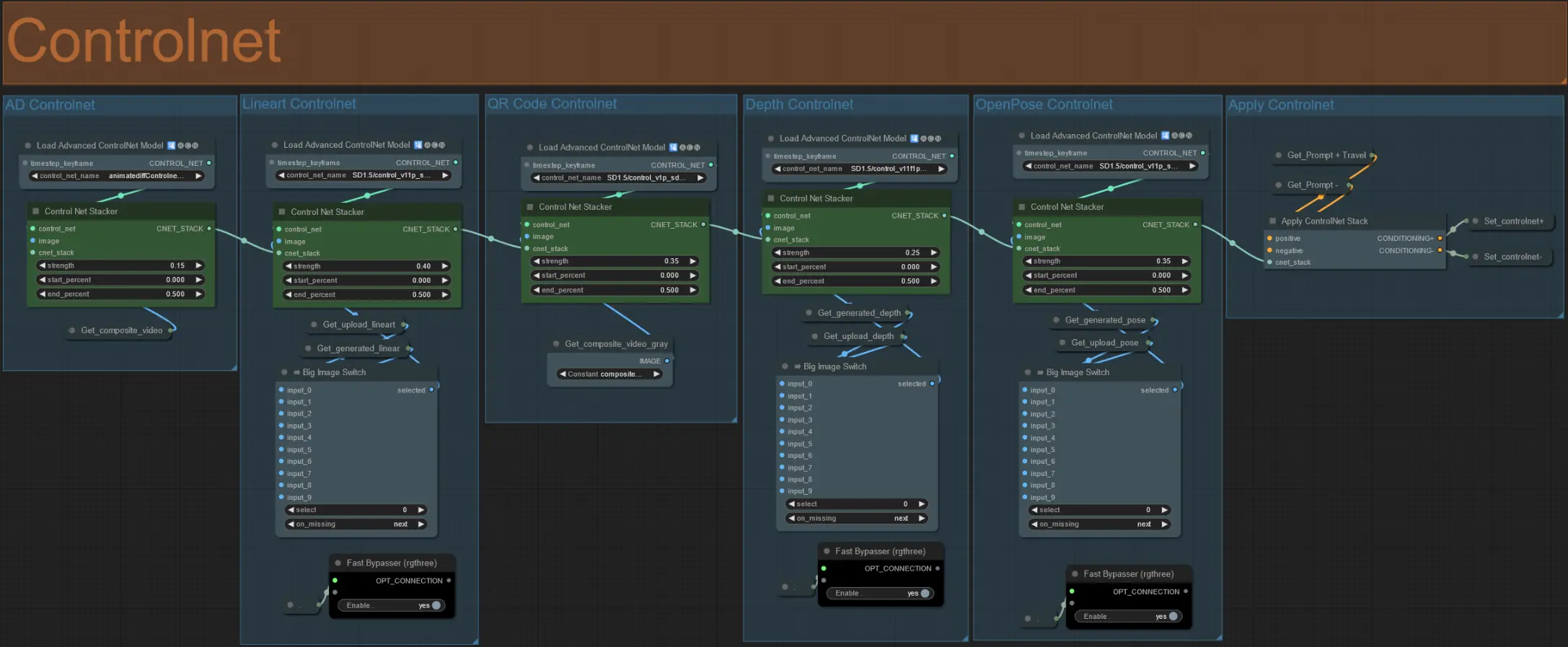

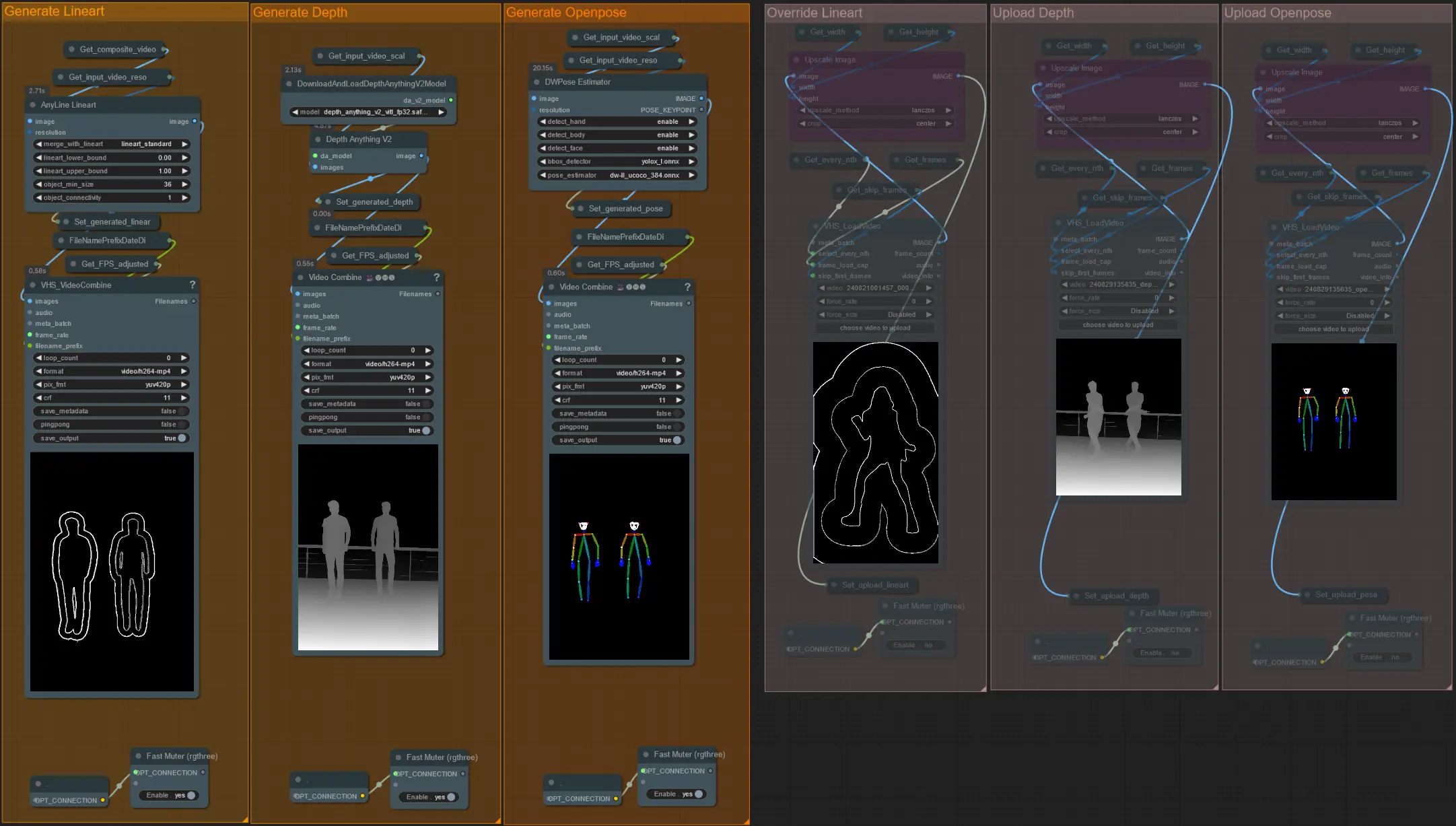

ControlNet

- Este workflow faz uso de 5 controlnets diferentes, incluindo AD, Lineart, QR Code, Depth e OpenPose.

- Todas as entradas para os controlnets são geradas automaticamente

- Você pode optar por substituir o vídeo de entrada para os controlnets Lineart, Depth e Openpose, se desejar, desmutando os grupos 'Override' como visto abaixo:

- Recomenda-se também mutar os grupos 'Generate' se estiver substituindo para economizar tempo de processamento.

Dica:

- Ignore o Ksampler e comece uma renderização com seu vídeo de entrada completo. Uma vez que todos os vídeos do pré-processador sejam gerados, salve-os e carregue-os nas respectivas substituições. A partir de agora, ao testar o workflow, você não precisará esperar que cada vídeo do pré-processador seja gerado individualmente.

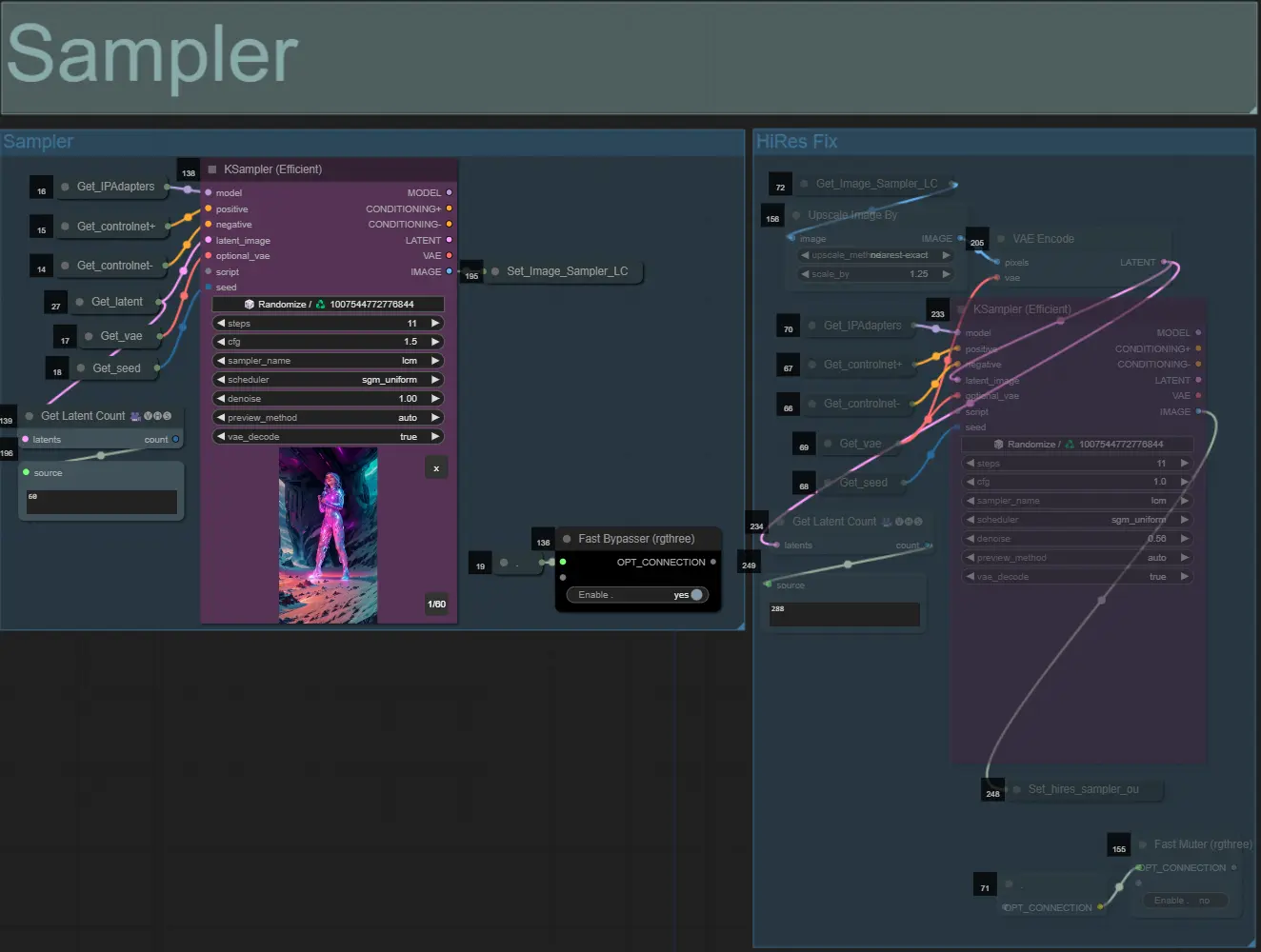

Sampler

- Por padrão, o grupo HiRes Fix sampler será mutado para economizar tempo de processamento durante os testes

- Recomendo ignorar o grupo Sampler também ao tentar experimentar configurações de máscara de dilatação para economizar tempo.

- Nas renderizações finais, você pode desmutar o grupo HiRes Fix, que aumentará a escala e adicionará detalhes ao resultado final.

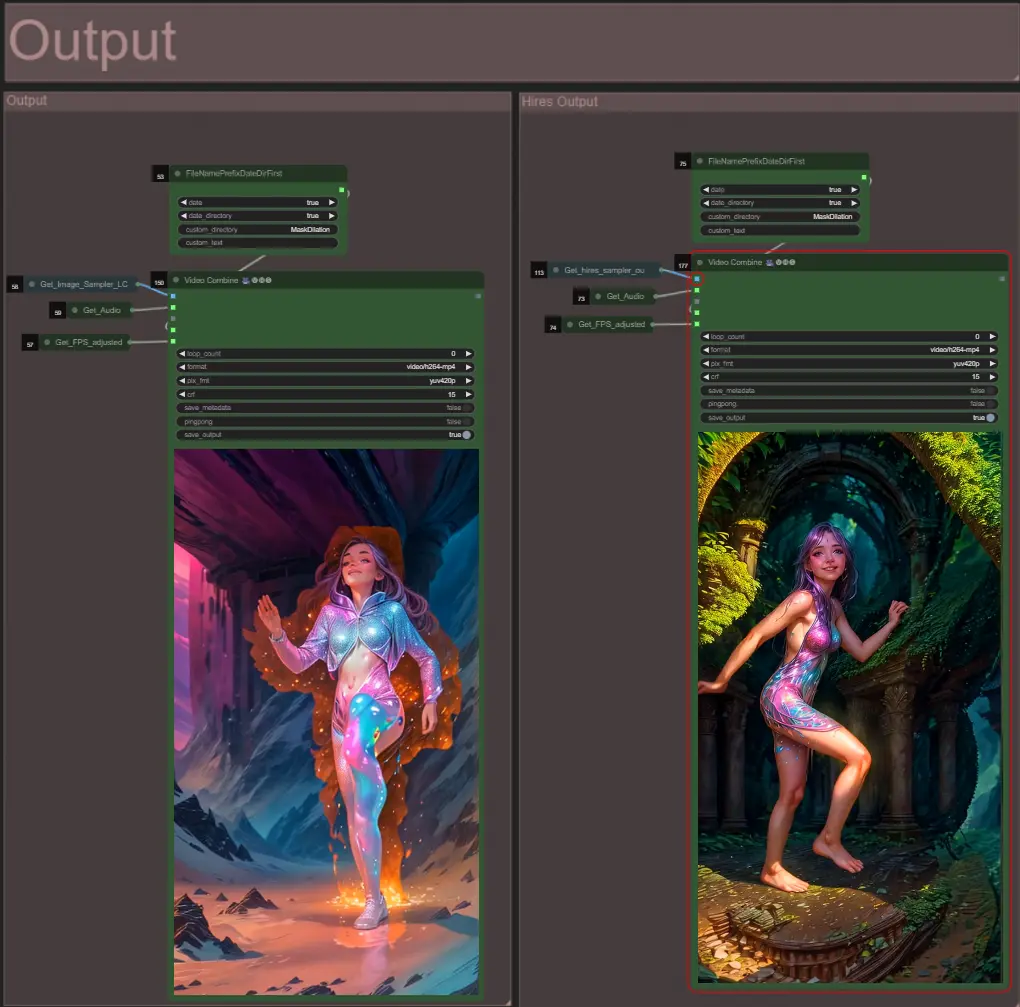

Saída

- Existem dois grupos de saída: o da esquerda é para saída de sampler padrão, e o da direita é para saída de HiRes Fix sampler.

Sobre o Autor

Akatz AI:

- Website:

- http://patreon.com/Akatz

- https://civitai.com/user/akatz

- https://www.youtube.com/@akatz_ai

- https://www.instagram.com/akatz.ai/

- https://www.tiktok.com/@akatz_ai

- https://x.com/akatz_ai

- https://github.com/akatz-ai

Contatos:

- Email: akatz.hello@gmail.com