MimicMotion | Geração de Vídeos de Movimento Humano

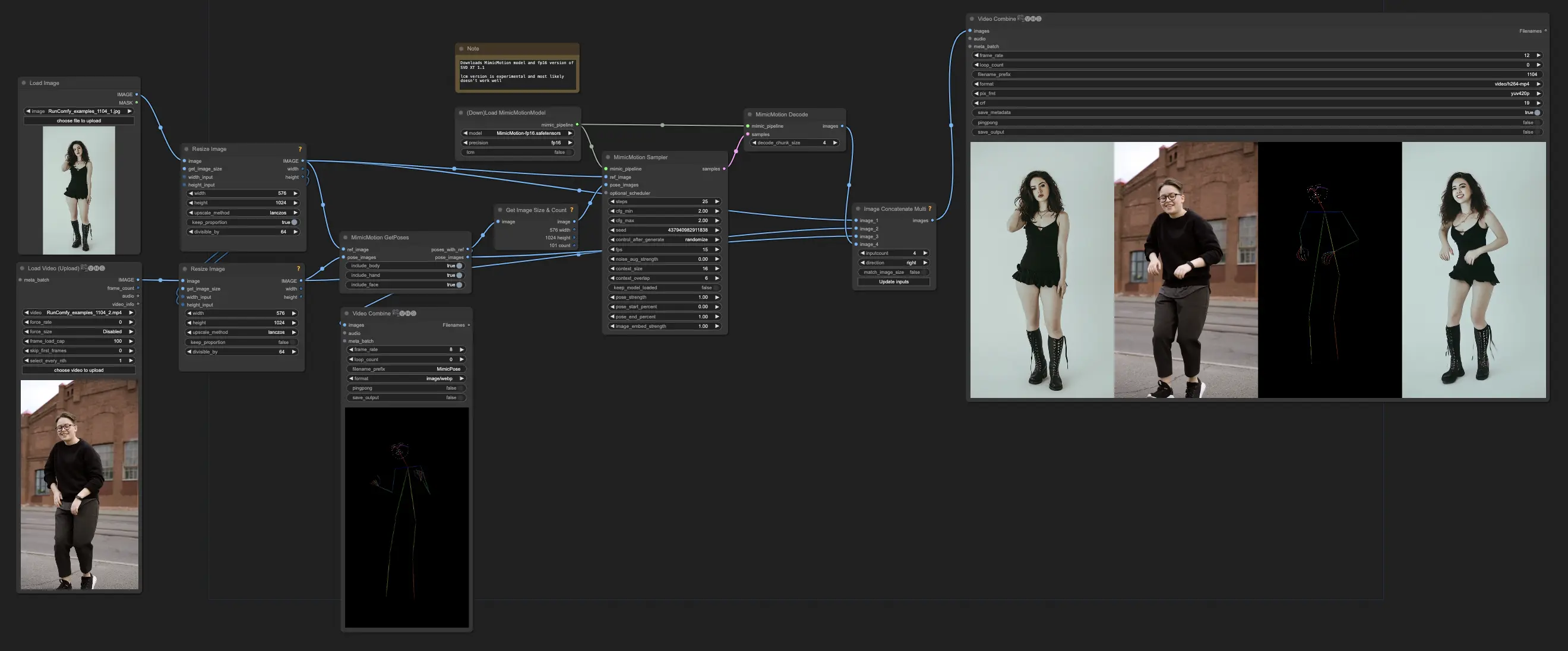

O fluxo de trabalho ComfyUI MimicMotion é uma ferramenta poderosa para gerar vídeos realistas de movimento humano. Ao integrar o MimicMotion, uma tecnologia desenvolvida pela Tencent e pela Universidade Jiao Tong de Xangai, este fluxo de trabalho permite a criação fácil de vídeos detalhados e com movimento suave. Você pode simplesmente fornecer uma imagem de referência e uma sequência de movimento, que o MimicMotion usa para gerar um vídeo que imita a aparência da imagem de referência.ComfyUI MimicMotion Fluxo de Trabalho

- Fluxos de trabalho totalmente operacionais

- Sem nós ou modelos ausentes

- Nenhuma configuração manual necessária

- Apresenta visuais impressionantes

ComfyUI MimicMotion Exemplos

ComfyUI MimicMotion Descrição

O que é MimicMotion

MimicMotion é uma estrutura de geração de vídeo controlável desenvolvida por pesquisadores da Tencent e da Universidade Jiao Tong de Xangai. Ele pode gerar vídeos de alta qualidade de comprimento arbitrário seguindo qualquer orientação de movimento fornecida. Comparado aos métodos anteriores, o MimicMotion se destaca na produção de vídeos com ricos detalhes, boa suavidade temporal e a capacidade de gerar sequências longas.

Como o MimicMotion Funciona

O MimicMotion usa uma imagem de referência e orientação de pose como entradas. Ele então gera um vídeo que corresponde à aparência da imagem de referência enquanto segue a sequência de movimento fornecida.

Algumas inovações chave permitem o forte desempenho do MimicMotion:

- Orientação de pose consciente de confiança: Ao incorporar informações de confiança de pose, o MimicMotion alcança melhor suavidade temporal e é mais robusto a dados de treinamento ruidosos. Isso ajuda a generalizar bem.

- Amplificação de perda regional: Focar a perda mais fortemente nas regiões de pose de alta confiança, especialmente as mãos, reduz significativamente a distorção da imagem nos vídeos gerados.

- Fusão latente progressiva: Para gerar vídeos longos e suaves de maneira eficiente, o MimicMotion gera segmentos de vídeo com quadros sobrepostos e funde progressivamente suas representações latentes. Isso permite gerar vídeos de comprimento arbitrário com custo computacional controlado.

O modelo é primeiro pré-treinado em grandes conjuntos de dados de vídeo, depois ajustado para a tarefa de imitação de movimento. Este pipeline de treinamento eficiente não requer grandes quantidades de dados especializados.

Como Usar o ComfyUI MimicMotion (ComfyUI-MimicMotionWrapper)

Após testar diferentes nós do MimicMotion disponíveis no ComfyUI, recomendamos usar para os melhores resultados.

Passo 1: Preparando Sua Entrada para o MimicMotion

Para começar a animar com o ComfyUI MimicMotion, você precisará de dois ingredientes chave:

- Uma imagem de referência: Este é o quadro inicial que serve como ponto de partida para sua animação. Escolha uma imagem que mostre claramente o sujeito que você deseja animar.

- Imagens de pose: Estas são as imagens que definem a sequência de movimento. Cada imagem de pose deve mostrar a posição ou pose desejada do seu sujeito em um ponto específico da animação. Você pode criar essas imagens de pose manualmente ou usar ferramentas de estimativa de pose para extrair poses de um vídeo.

🌟Certifique-se de que sua imagem de referência e as imagens de pose tenham a mesma resolução e proporção para resultados ótimos.🌟

Passo 2: Carregando o Modelo MimicMotion

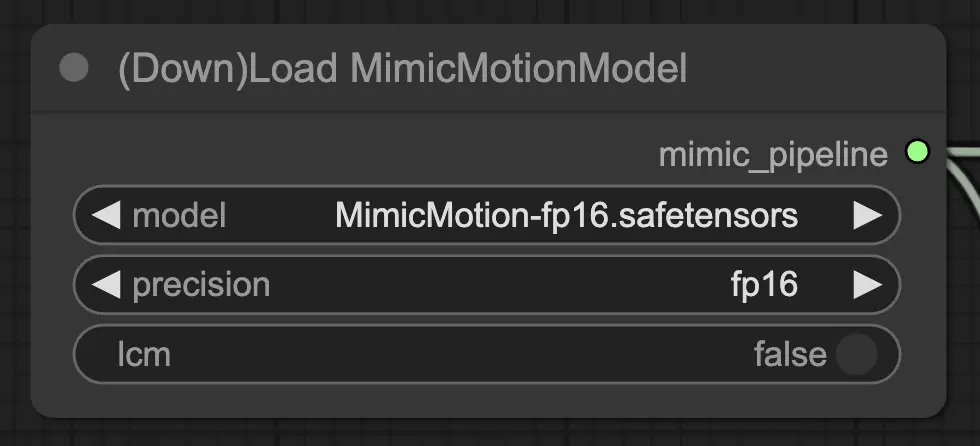

O ComfyUI MimicMotion requer o modelo MimicMotion para funcionar corretamente. No RunComfy, o modelo já está pré-carregado para sua conveniência. Para configurar o nó "DownLoadMimicMotionModel", siga estes passos:

- Defina o parâmetro "model" para "MimicMotion-fp16.safetensors" (ou o nome do arquivo de modelo apropriado, se diferente).

- Selecione a precisão desejada (fp32, fp16, ou bf16) com base nas capacidades da sua GPU. Esta escolha pode impactar o desempenho e a compatibilidade.

- Deixe o parâmetro "lcm" definido como False, a menos que você especificamente queira usar a variante LCM (Latent Conditional Motion) do modelo.

Uma vez configuradas as configurações do nó, conecte a saída do nó "DownloadAndLoadMimicMotionModel" à entrada do próximo nó no seu fluxo de trabalho. Isso garantirá que o modelo MimicMotion carregado seja devidamente utilizado nas etapas subsequentes do seu pipeline ComfyUI.

Passo 3: Configurando o Amostrador MimicMotion

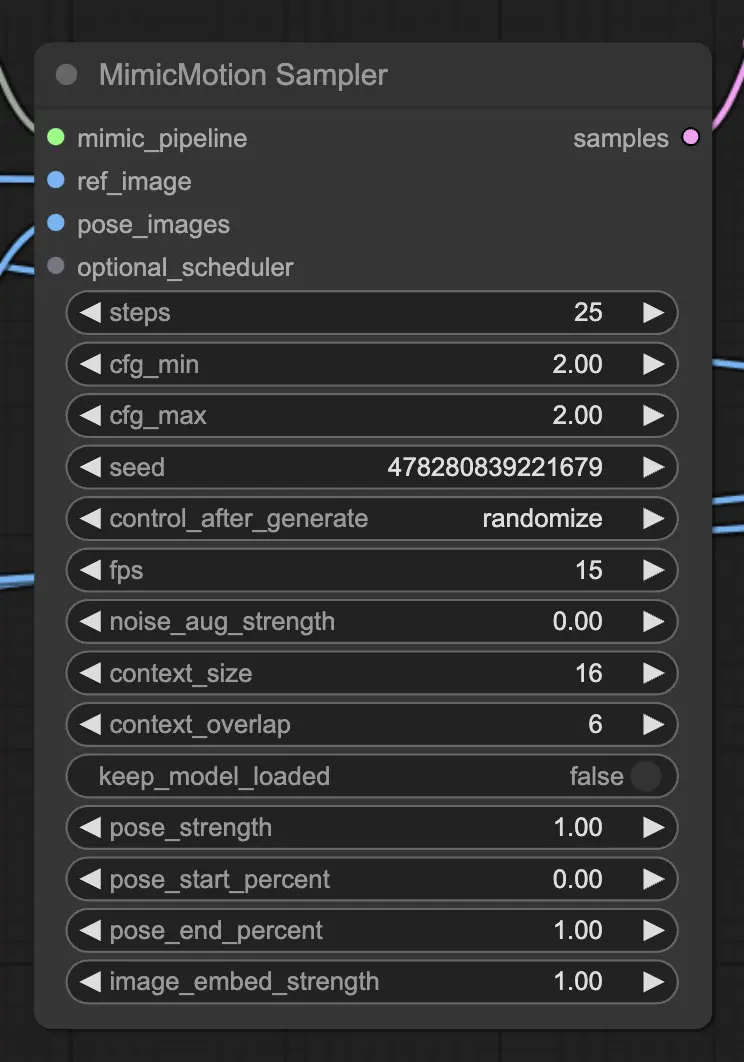

O nó "MimicMotionSampler" é responsável por gerar os quadros animados com base na sua entrada. Veja como configurá-lo:

- Adicione o nó "MimicMotionSampler" e conecte-o à saída do nó "DownloadAndLoadMimicMotionModel".

- Defina o parâmetro "ref_image" para sua imagem de referência e o parâmetro "pose_images" para sua sequência de imagens de pose.

- Ajuste as configurações de amostragem de acordo com suas preferências:

- "steps" determina o número de passos de difusão (valores mais altos levam a resultados mais suaves, mas tempos de processamento mais longos).

- "cfg_min" e "cfg_max" controlam a força da orientação condicional (valores mais altos aderem mais de perto às imagens de pose).

- "seed" define a semente aleatória para reprodutibilidade.

- "fps" especifica os quadros por segundo da animação gerada.

- Ajuste parâmetros adicionais como "noise_aug_strength", "context_size", e "context_overlap" para experimentar diferentes estilos e coerência temporal.

Passo 4: Decodificando as Amostras Latentes

O nó "MimicMotionSampler" gera representações no espaço latente dos quadros animados. Para converter esses latentes em imagens reais, você precisa usar o nó "MimicMotionDecode":

- Adicione o nó "MimicMotionDecode" e conecte-o à saída do nó "MimicMotionSampler".

- Defina o parâmetro "decode_chunk_size" para controlar o número de quadros decodificados simultaneamente (valores mais altos podem consumir mais memória da GPU). A saída do nó "MimicMotionDecode" será os quadros animados finais em formato de imagem.

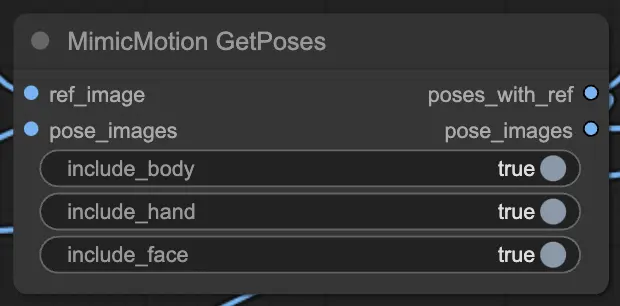

Passo 5: Melhorando as Poses com MimicMotionGetPoses

Se você quiser visualizar as poses extraídas junto com sua imagem de referência, pode usar o nó "MimicMotionGetPoses":

- Conecte a "ref_image" e as "pose_images" ao nó "MimicMotionGetPoses".

- Defina os parâmetros "include_body", "include_hand", e "include_face" para controlar quais pontos-chave de pose são exibidos. A saída incluirá a imagem de referência com a pose extraída e as imagens de pose individuais.

Dicas e Melhores Práticas

Aqui estão algumas dicas para ajudá-lo a obter o máximo do ComfyUI MimicMotion:

- Experimente diferentes imagens de referência e sequências de pose para criar uma variedade de animações.

- Ajuste as configurações de amostragem para equilibrar a qualidade e o tempo de processamento conforme suas necessidades.

- Use imagens de pose de alta qualidade e consistentes para os melhores resultados. Evite mudanças drásticas de perspectiva ou iluminação entre as poses.

- Monitore o uso de memória da sua GPU, especialmente ao trabalhar com imagens de alta resolução ou animações longas.

- Aproveite o nó "DiffusersScheduler" para personalizar a programação de ruído para efeitos únicos.

O ComfyUI MimicMotion é uma ferramenta poderosa e versátil que permite criar animações impressionantes sem esforço. Ao entender o fluxo de trabalho e explorar os vários parâmetros, você poderá animar qualquer pessoa com facilidade. À medida que você se aprofunda no mundo da animação, lembre-se de experimentar, iterar e se divertir durante todo o processo. Com o ComfyUI MimicMotion, as possibilidades são infinitas, então aproveite para dar vida às suas visões criativas!