Was ist MimicMotion

MimicMotion ist ein steuerbares Videoerstellungs-Framework, das von Forschern bei Tencent und der Shanghai Jiao Tong University entwickelt wurde. Es kann hochwertige Videos beliebiger Länge erstellen, die einer vorgegebenen Bewegungsführung folgen. Im Vergleich zu früheren Methoden zeichnet sich MimicMotion durch die Erstellung von Videos mit reichhaltigen Details, guter zeitlicher Glätte und der Fähigkeit zur Erstellung langer Sequenzen aus.

Wie MimicMotion funktioniert

MimicMotion nimmt ein Referenzbild und eine Posenvorgabe als Eingaben. Es generiert dann ein Video, das dem Aussehen des Referenzbildes entspricht, während es der vorgegebenen Bewegungssequenz folgt.

Einige wichtige Innovationen ermöglichen die starke Leistung von MimicMotion:

- Konfidenzbewusste Posenvorgabe: Durch die Einbeziehung von Konfidenzinformationen der Pose erreicht MimicMotion eine bessere zeitliche Glätte und ist robuster gegenüber verrauschten Trainingsdaten. Dies hilft ihm, gut zu generalisieren.

- Regionale Verlustverstärkung: Durch die stärkere Fokussierung des Verlustes auf hochkonfidente Posenregionen, insbesondere die Hände, wird die Bildverzerrung in den generierten Videos erheblich reduziert.

- Progressive latente Fusion: Um glatte, lange Videos effizient zu generieren, erstellt MimicMotion Videosegmente mit überlappenden Frames und fusioniert ihre latenten Repräsentationen schrittweise. Dies ermöglicht die Erstellung von Videos beliebiger Länge mit kontrollierten Rechenkosten.

Das Modell wird zunächst auf großen Videodatensätzen vortrainiert und dann für die Bewegungs-Nachahmungsaufgabe feinabgestimmt. Diese effiziente Trainingspipeline erfordert keine riesigen Mengen an spezialisierten Daten.

Wie man ComfyUI MimicMotion verwendet (ComfyUI-MimicMotionWrapper)

Nach dem Testen verschiedener MimicMotion-Knoten in ComfyUI empfehlen wir die Verwendung von kijai's ComfyUI-MimicMotionWrapper für die besten Ergebnisse.

Schritt 1: Vorbereitung Ihrer Eingabe für MimicMotion

Um mit ComfyUI MimicMotion zu animieren, benötigen Sie zwei wichtige Zutaten:

- Ein Referenzbild: Dies ist der Ausgangspunkt für Ihre Animation. Wählen Sie ein Bild, das das Motiv, das Sie animieren möchten, klar darstellt.

- Posenbilder: Dies sind die Bilder, die die Bewegungssequenz definieren. Jedes Posenbild sollte die gewünschte Position oder Pose Ihres Motivs zu einem bestimmten Zeitpunkt in der Animation zeigen. Sie können diese Posenbilder manuell erstellen oder Pose-Schätzungswerkzeuge verwenden, um Posen aus einem Video zu extrahieren.

🌟Stellen Sie sicher, dass Ihr Referenzbild und Ihre Posenbilder die gleiche Auflösung und das gleiche Seitenverhältnis haben, um optimale Ergebnisse zu erzielen.🌟

Schritt 2: Laden des MimicMotion-Modells

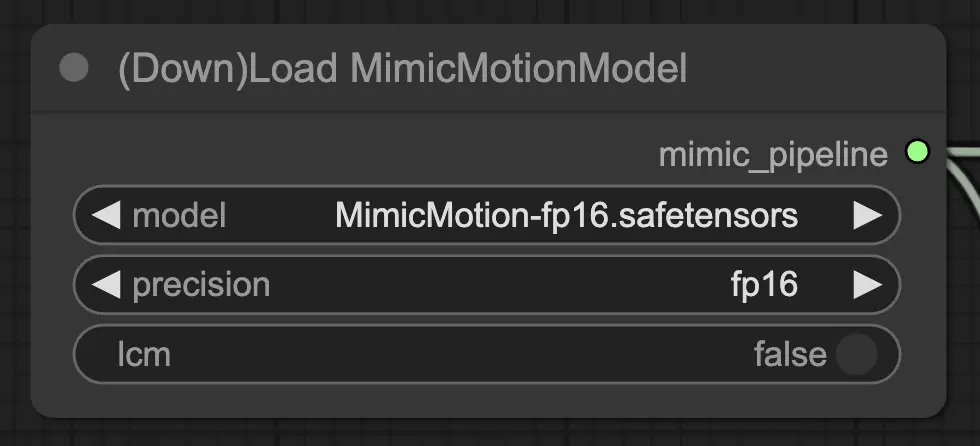

ComfyUI MimicMotion benötigt das MimicMotion-Modell, um ordnungsgemäß zu funktionieren. In RunComfy ist das Modell bereits für Ihre Bequemlichkeit vorinstalliert. Um den "DownLoadMimicMotionModel"-Knoten zu konfigurieren, folgen Sie diesen Schritten:

- Setzen Sie den "model"-Parameter auf "MimicMotion-fp16.safetensors" (oder den entsprechenden Modell-Dateinamen, falls abweichend).

- Wählen Sie die gewünschte Präzision (fp32, fp16 oder bf16) basierend auf den Fähigkeiten Ihrer GPU. Diese Wahl kann die Leistung und Kompatibilität beeinflussen.

- Lassen Sie den "lcm"-Parameter auf False gesetzt, es sei denn, Sie möchten speziell die LCM (Latent Conditional Motion) Variante des Modells verwenden.

Nachdem Sie die Knoteneinstellungen konfiguriert haben, verbinden Sie den Ausgang des "DownloadAndLoadMimicMotionModel"-Knotens mit dem Eingang des nächsten Knotens in Ihrem Workflow. Dies stellt sicher, dass das geladene MimicMotion-Modell in den folgenden Schritten Ihrer ComfyUI-Pipeline ordnungsgemäß genutzt wird.

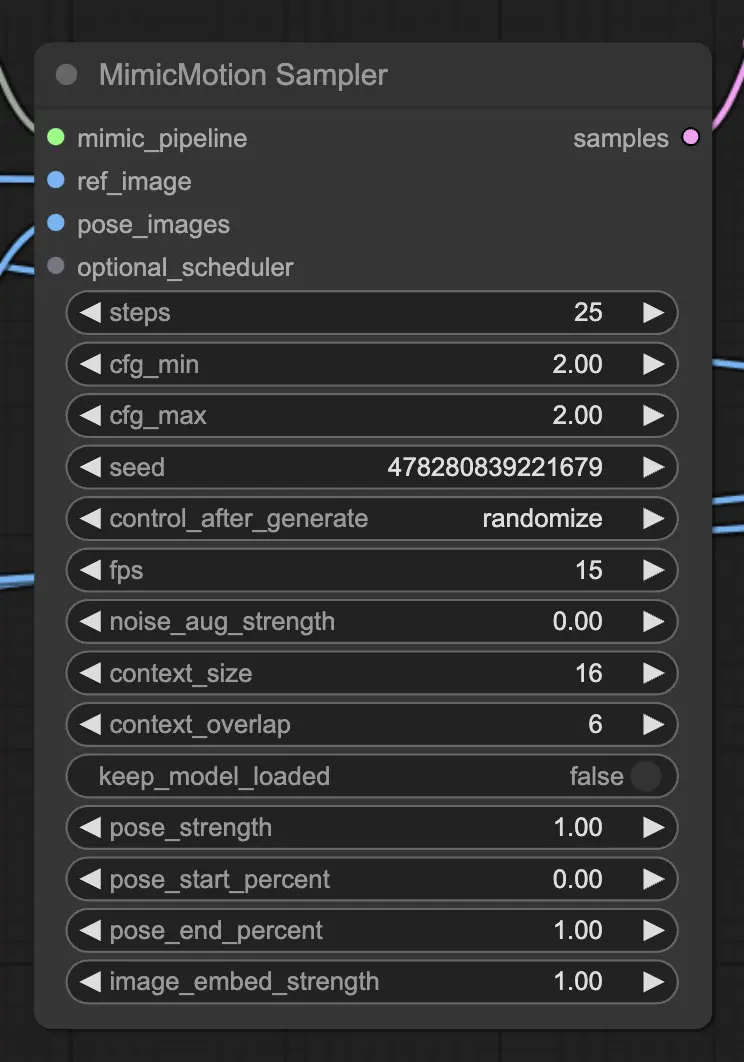

Schritt 3: Konfigurieren des MimicMotion-Samplers

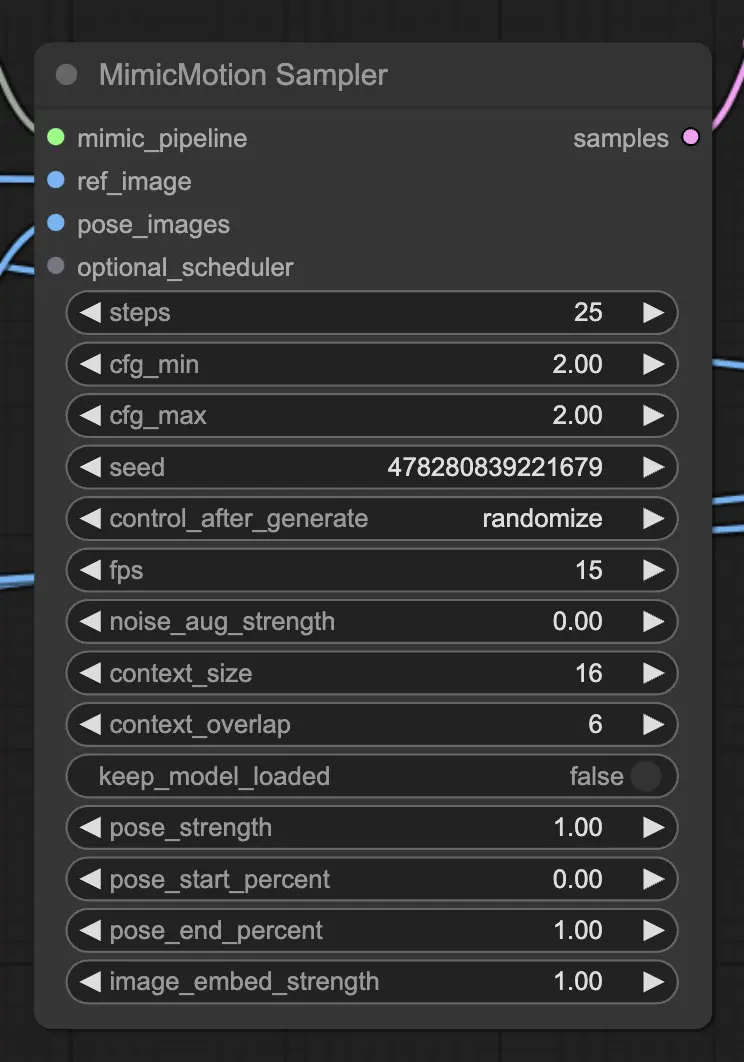

Der "MimicMotionSampler"-Knoten ist verantwortlich für die Erstellung der animierten Frames basierend auf Ihrer Eingabe. Hier ist, wie Sie ihn einrichten:

- Fügen Sie den "MimicMotionSampler"-Knoten hinzu und verbinden Sie ihn mit dem Ausgang des "DownloadAndLoadMimicMotionModel"-Knotens.

- Setzen Sie den "ref_image"-Parameter auf Ihr Referenzbild und den "pose_images"-Parameter auf Ihre Sequenz von Posenbildern.

- Passen Sie die Sampling-Einstellungen nach Ihren Vorlieben an:

- "steps" bestimmt die Anzahl der Diffusionsschritte (höhere Werte führen zu glatteren Ergebnissen, aber längeren Verarbeitungszeiten).

- "cfg_min" und "cfg_max" steuern die Stärke der bedingten Führung (höhere Werte halten sich enger an die Posenbilder).

- "seed" setzt den Zufallswert für die Reproduzierbarkeit.

- "fps" gibt die Bilder pro Sekunde der generierten Animation an.

- Feinabstimmung zusätzlicher Parameter wie "noise_aug_strength", "context_size" und "context_overlap", um mit verschiedenen Stilen und zeitlicher Kohärenz zu experimentieren.

Schritt 4: Decodieren der latenten Samples

Der "MimicMotionSampler"-Knoten gibt latente Raumdarstellungen der animierten Frames aus. Um diese Latenten in tatsächliche Bilder umzuwandeln, müssen Sie den "MimicMotionDecode"-Knoten verwenden:

- Fügen Sie den "MimicMotionDecode"-Knoten hinzu und verbinden Sie ihn mit dem Ausgang des "MimicMotionSampler"-Knotens.

- Setzen Sie den "decode_chunk_size"-Parameter, um die Anzahl der gleichzeitig decodierten Frames zu steuern (höhere Werte können mehr GPU-Speicher verbrauchen).

Der Ausgang des "MimicMotionDecode"-Knotens sind die endgültigen animierten Frames im Bildformat.

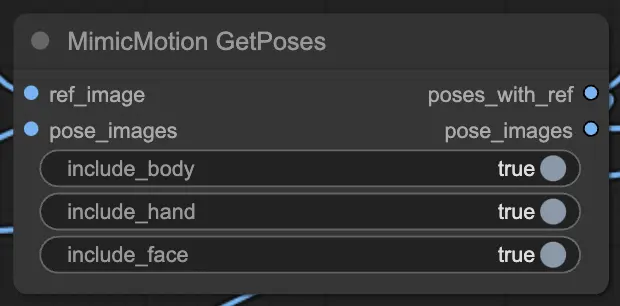

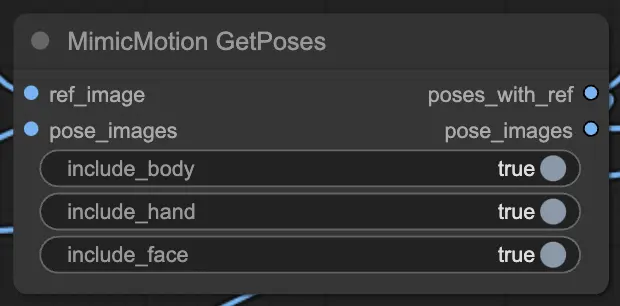

Schritt 5: Verbesserung der Posen mit MimicMotionGetPoses

Wenn Sie die extrahierten Posen zusammen mit Ihrem Referenzbild visualisieren möchten, können Sie den "MimicMotionGetPoses"-Knoten verwenden:

- Verbinden Sie das "ref_image" und die "pose_images" mit dem "MimicMotionGetPoses"-Knoten.

- Setzen Sie die Parameter "include_body", "include_hand" und "include_face", um zu steuern, welche Pose-Schlüsselpunkte angezeigt werden.

Der Ausgang wird das Referenzbild mit der extrahierten Pose und den einzelnen Posenbildern umfassen.

Tipps und Best Practices

Hier sind einige Tipps, die Ihnen helfen, das Beste aus ComfyUI MimicMotion herauszuholen:

- Experimentieren Sie mit verschiedenen Referenzbildern und Posensequenzen, um eine Vielzahl von Animationen zu erstellen.

- Passen Sie die Sampling-Einstellungen an, um Qualität und Verarbeitungszeit je nach Bedarf auszubalancieren.

- Verwenden Sie hochwertige, konsistente Posenbilder für die besten Ergebnisse. Vermeiden Sie drastische Änderungen in der Perspektive oder Beleuchtung zwischen den Posen.

- Überwachen Sie Ihren GPU-Speicherverbrauch, insbesondere bei der Arbeit mit hochauflösenden Bildern oder langen Animationen.

- Nutzen Sie den "DiffusersScheduler"-Knoten, um das Rauschzeitplanen für einzigartige Effekte anzupassen.

ComfyUI MimicMotion ist ein leistungsstarkes und vielseitiges Werkzeug, mit dem Sie mühelos atemberaubende Animationen erstellen können. Indem Sie den Workflow verstehen und die verschiedenen Parameter erkunden, können Sie jeden animieren. Während Sie in die Welt der Animation eintauchen, denken Sie daran, zu experimentieren, zu iterieren und Spaß am Prozess zu haben. Mit ComfyUI MimicMotion sind die Möglichkeiten endlos, also genießen Sie es, Ihre kreativen Visionen zum Leben zu erwecken!