Segment Anything V2, también conocido como SAM2, es un modelo de IA revolucionario desarrollado por Meta AI que revoluciona la segmentación de objetos tanto en imágenes como en videos.

Segment Anything V2 es un modelo de IA de última generación que permite la segmentación perfecta de objetos en imágenes y videos. Es el primer modelo unificado capaz de manejar tareas de segmentación de imágenes y videos con una precisión y eficiencia excepcionales. Segment Anything V2 (SAM2) se basa en el éxito de su predecesor, el Segment Anything Model (SAM), al extender sus capacidades de entrada al dominio del video.

Con Segment Anything V2 (SAM2), los usuarios pueden seleccionar un objeto en una imagen o fotograma de video utilizando varios métodos de entrada, como un clic, un cuadro delimitador o una máscara. El modelo luego segmenta inteligentemente el objeto seleccionado, permitiendo la extracción y manipulación precisas de elementos específicos dentro del contenido visual.

SAM2 extiende la capacidad de entrada de SAM a los videos introduciendo un módulo de memoria por sesión que captura la información del objeto objetivo, permitiendo el seguimiento de objetos a lo largo de los fotogramas, incluso con desapariciones temporales. La arquitectura de transmisión procesa los fotogramas de video uno a la vez, comportándose como SAM para imágenes cuando el módulo de memoria está vacío. Esto permite el procesamiento de video en tiempo real y la generalización natural de las capacidades de SAM. SAM2 también admite correcciones interactivas de predicción de máscaras basadas en indicaciones del usuario. El modelo utiliza una arquitectura de transformador con memoria de transmisión y está entrenado en el conjunto de datos SA-V, el conjunto de datos de segmentación de video más grande recolectado utilizando un motor de datos en el bucle que mejora tanto el modelo como los datos a través de la interacción del usuario.

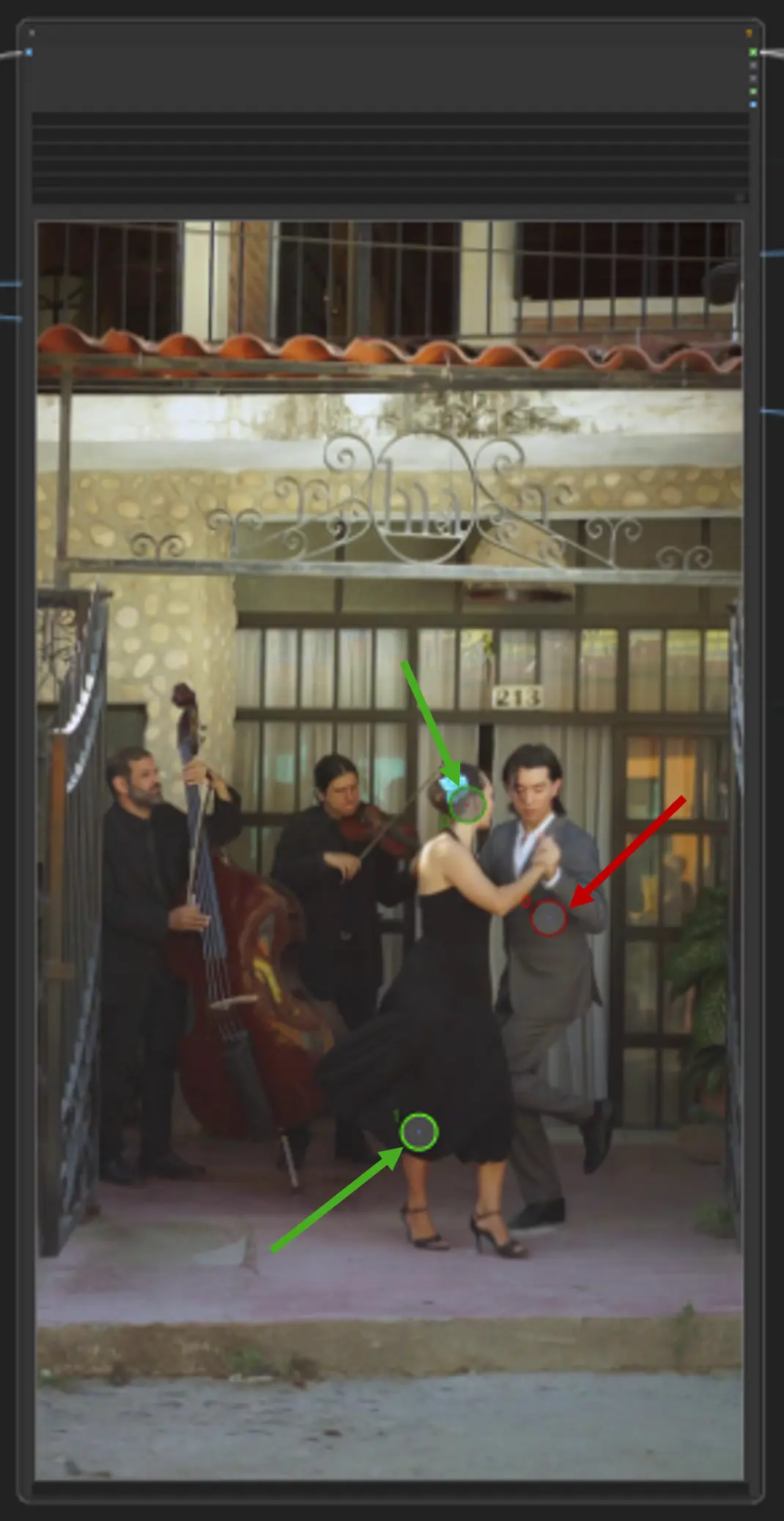

Este flujo de trabajo de ComfyUI admite la selección de un objeto en un fotograma de video utilizando un clic/punto.

Carga de Video: Selecciona y sube el video que deseas procesar.

punto clave: Coloca tres puntos clave en el lienzo—positive0, positive1 y negative0:

positive0 y positive1 marcan las regiones u objetos que deseas segmentar.

negative0 ayuda a excluir áreas no deseadas o distracciones.

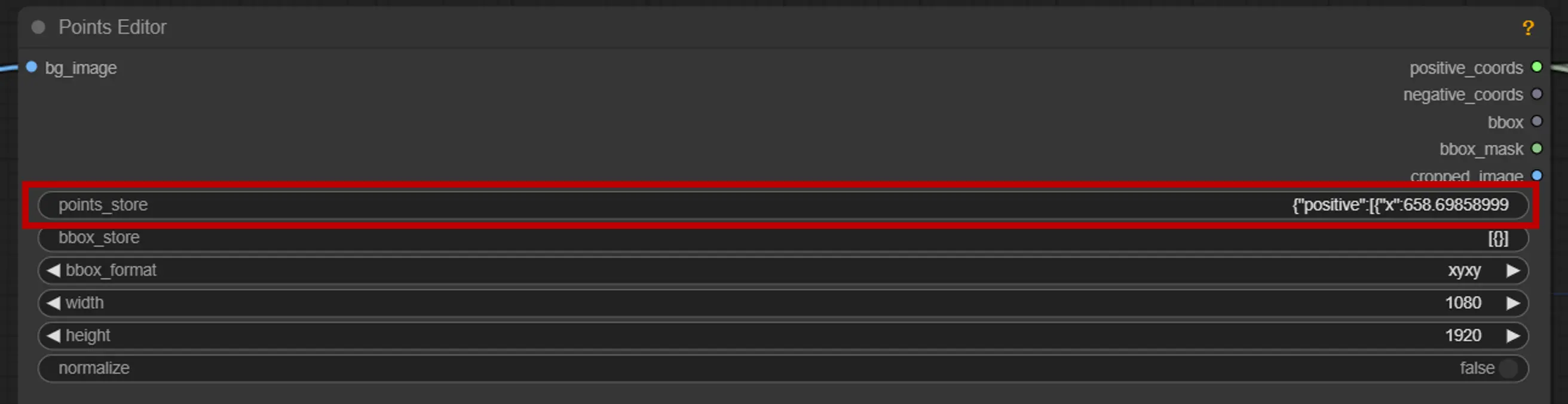

points_store: Te permite agregar o eliminar puntos según sea necesario para refinar el proceso de segmentación.

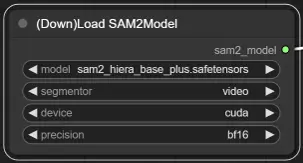

Opciones de Modelo: Elige entre los modelos SAM2 disponibles: tiny, small, large o base_plus. Los modelos más grandes proporcionan mejores resultados pero requieren más tiempo de carga.

Para más información, visita Kijai ComfyUI-segment-anything-2.

RunComfy es la principal ComfyUI plataforma, ofreciendo ComfyUI en línea entorno y servicios, junto con flujos de trabajo de ComfyUI con impresionantes imágenes. RunComfy también ofrece AI Playground, permitiendo a los artistas aprovechar las últimas herramientas de AI para crear arte increíble.