AnimateDiff + ControlNet | Estilo de Arte Cerâmica

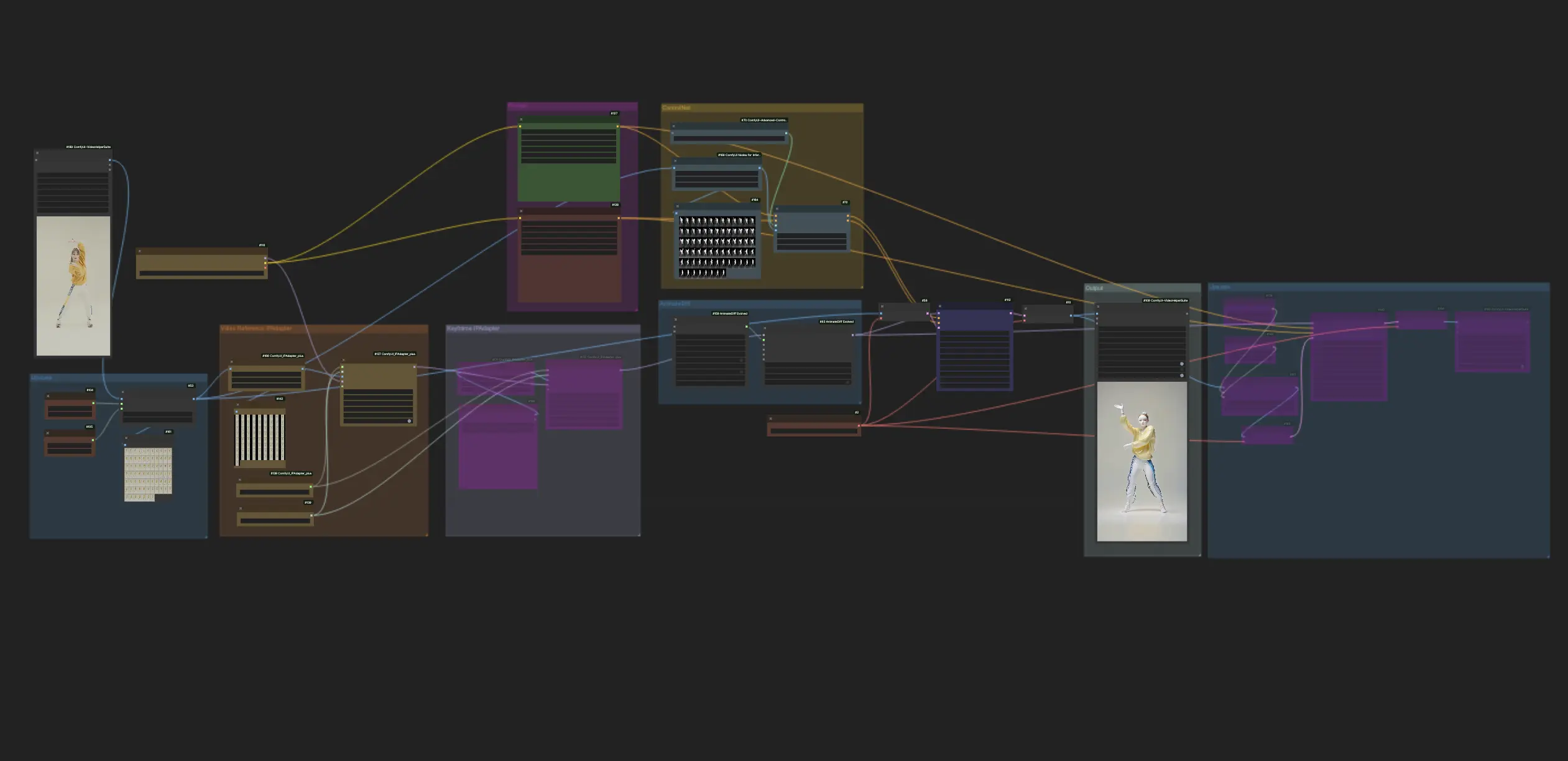

Este fluxo de trabalho no ComfyUI emprega AnimateDiff e ControlNet com foco na profundidade, entre outros como Lora, para transformar habilmente vídeos em Estilo de Arte Cerâmica. Ele permite que o conteúdo original adote um toque artístico distinto, elevando-o efetivamente ao domínio das obras-primas da arte cerâmica.ComfyUI Vid2Vid (Art) Fluxo de Trabalho

- Fluxos de trabalho totalmente operacionais

- Sem nós ou modelos ausentes

- Nenhuma configuração manual necessária

- Apresenta visuais impressionantes

ComfyUI Vid2Vid (Art) Exemplos

ComfyUI Vid2Vid (Art) Descrição

1. Fluxo de Trabalho ComfyUI: AnimateDiff + ControlNet | Estilo de Arte Cerâmica

Este fluxo de trabalho utiliza AnimateDiff, ControlNet com foco na profundidade e Lora específicos para transformar habilmente vídeos em um Estilo de Arte Cerâmica. Você é encorajado a usar diferentes prompts para alcançar vários estilos de arte, transformando suas ideias em realidade.

2. Como Usar AnimateDiff

AnimateDiff é projetado para animar imagens estáticas e prompts de texto em vídeos dinâmicos, aproveitando modelos Stable Diffusion e um módulo de movimento especializado. Ele automatiza o processo de animação prevendo transições perfeitas entre os quadros, tornando-o acessível a usuários sem habilidades de programação.

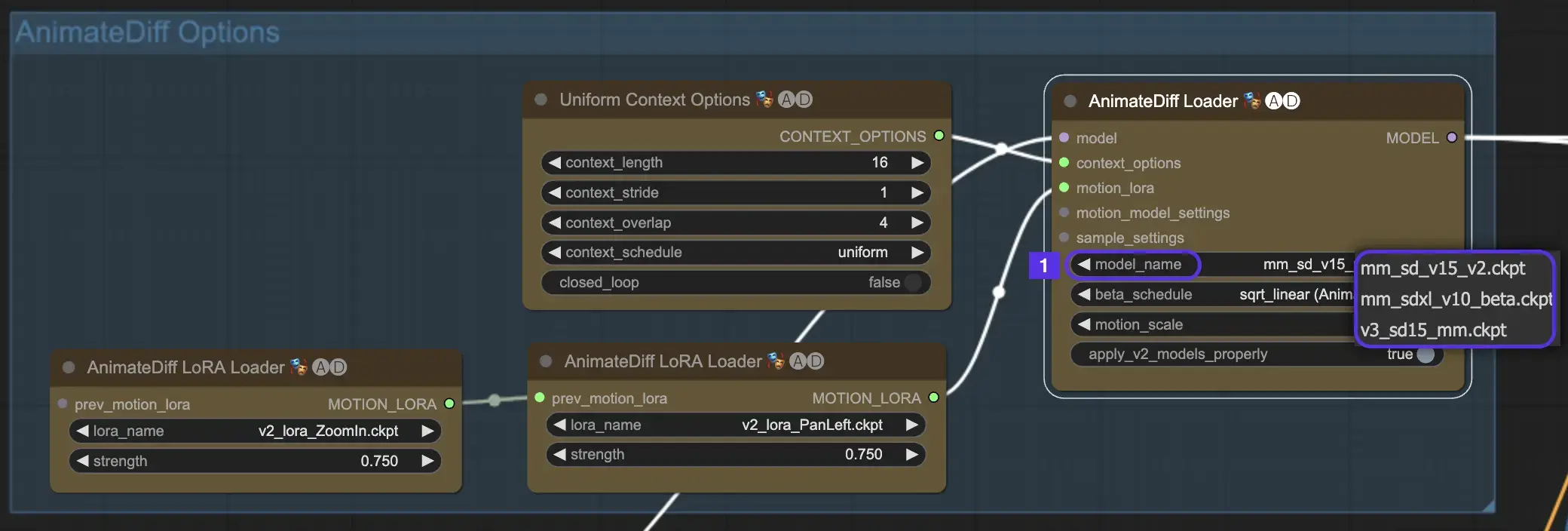

2.1 Módulos de Movimento AnimateDiff

Para começar, selecione o módulo de movimento AnimateDiff desejado no menu suspenso model_name:

- Use v3_sd15_mm.ckpt para AnimateDiff V3

- Use mm_sd_v15_v2.ckpt para AnimateDiff V2

- Use mm_sdxl_v10_beta.ckpt para AnimateDiff SDXL

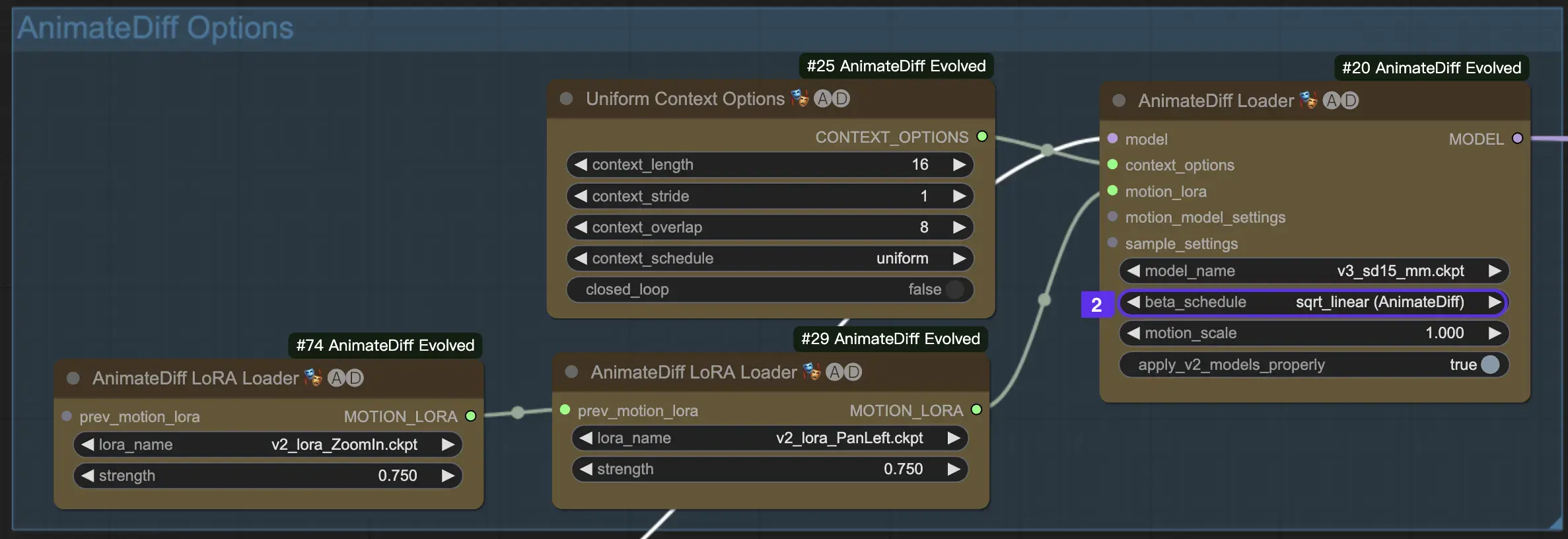

2.2 Beta Schedule

O Beta Schedule no AnimateDiff é crucial para ajustar o processo de redução de ruído durante a criação da animação.

Para as versões V3 e V2 do AnimateDiff, a configuração sqrt_linear é recomendada, embora experimentar com a configuração linear possa produzir efeitos únicos.

Para AnimateDiff SDXL, a configuração linear (AnimateDiff-SDXL) é aconselhada.

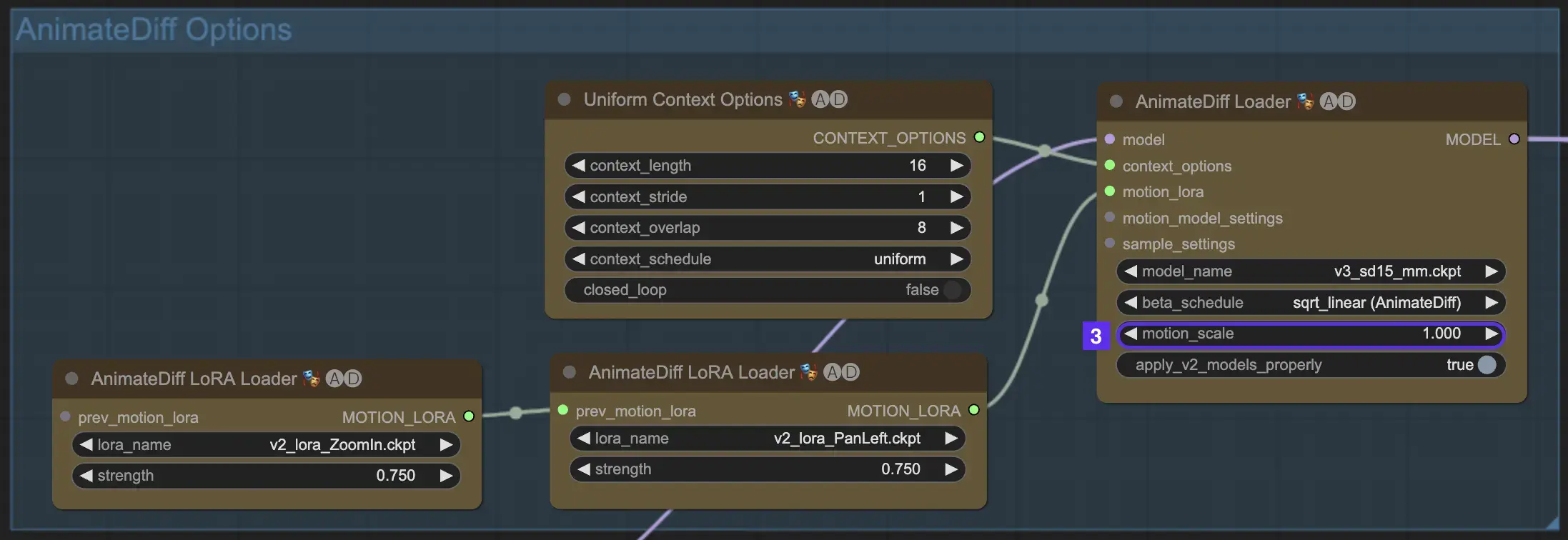

2.3 Motion Scale

O recurso Motion Scale no AnimateDiff permite ajustar a intensidade do movimento em suas animações. Uma Motion Scale abaixo de 1 resulta em um movimento mais sutil, enquanto uma escala acima de 1 amplifica o movimento.

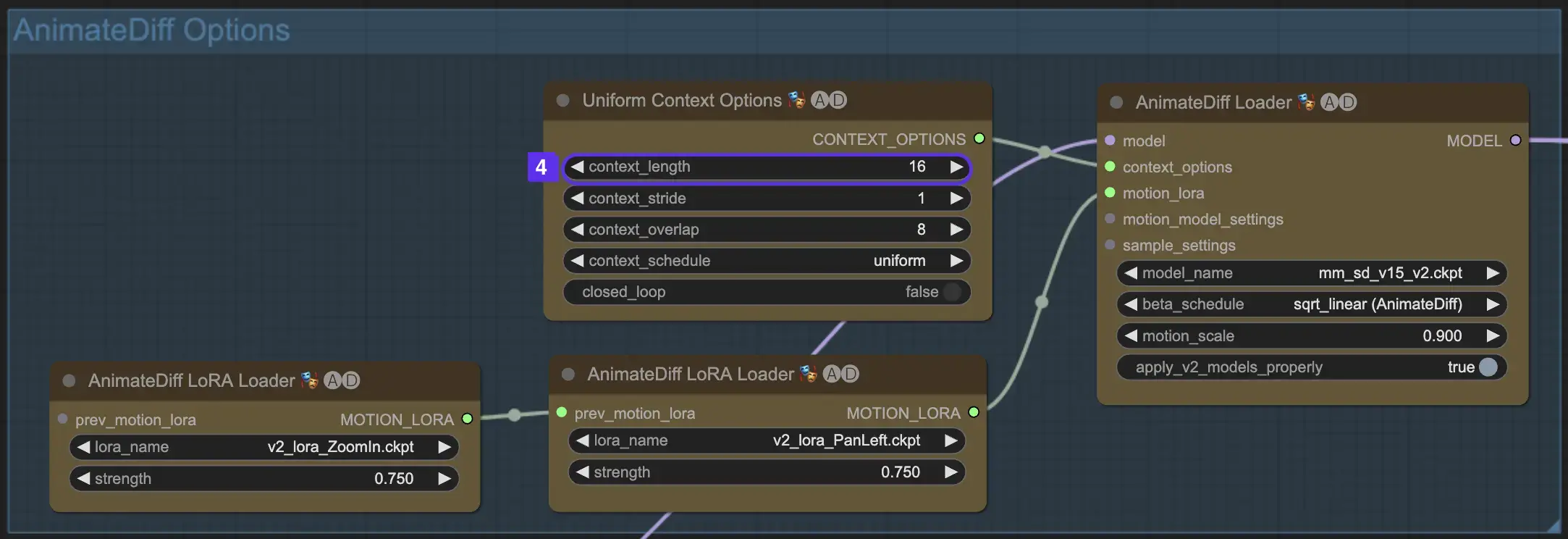

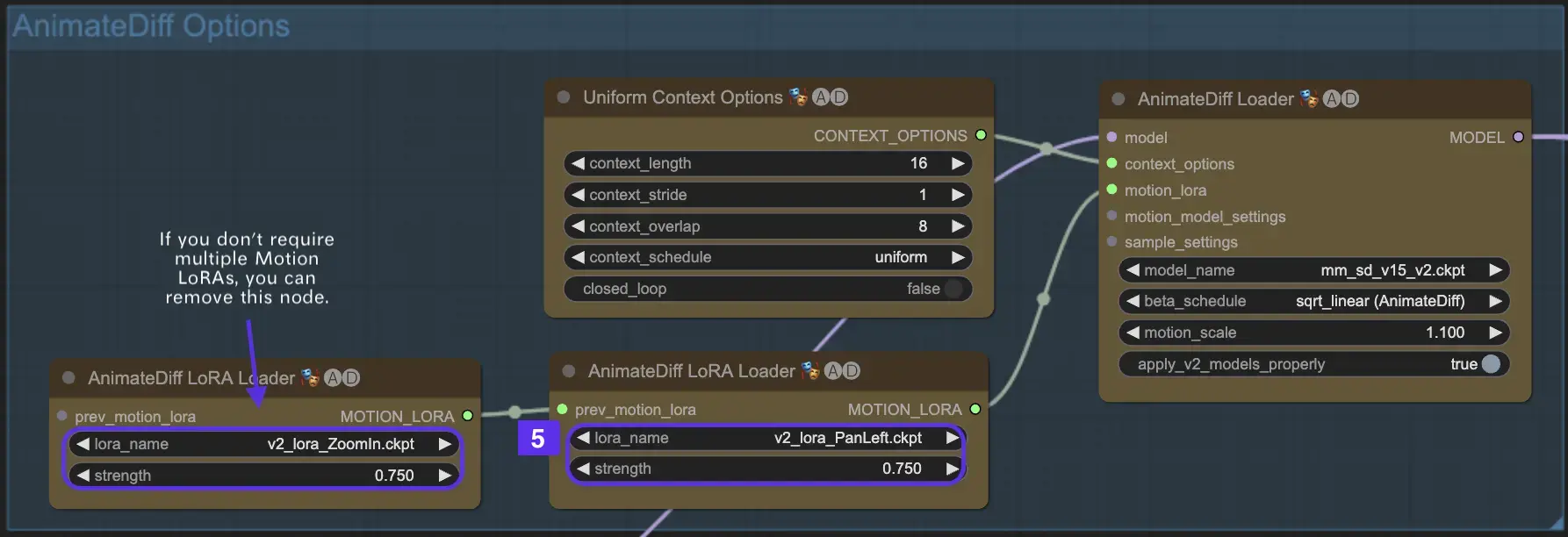

2.4 Context Length

O Uniform Context Length no AnimateDiff é essencial para garantir transições perfeitas entre as cenas definidas pelo seu Batch Size. Ele age como um editor especialista, conectando cenas perfeitamente para uma narração fluida. Definir um Uniform Context Length mais longo garante transições mais suaves, enquanto um comprimento mais curto oferece mudanças de cena mais rápidas e distintas, benéficas para certos efeitos. O Uniform Context Length padrão é definido como 16.

2.5 Utilizando Motion LoRA para Dinâmica de Câmera Aprimorada (Específico para AnimateDiff v2)

Motion LoRAs, compatíveis apenas com AnimateDiff v2, introduzem uma camada adicional de movimento dinâmico da câmera. Alcançar o equilíbrio ideal com o peso LoRA, normalmente em torno de 0,75, garante um movimento suave da câmera, livre de distorções de fundo.

Além disso, encadear vários modelos Motion LoRA permite uma dinâmica de câmera complexa. Isso permite que os criadores experimentem e descubram a combinação ideal para sua animação, elevando-a a um nível cinematográfico.

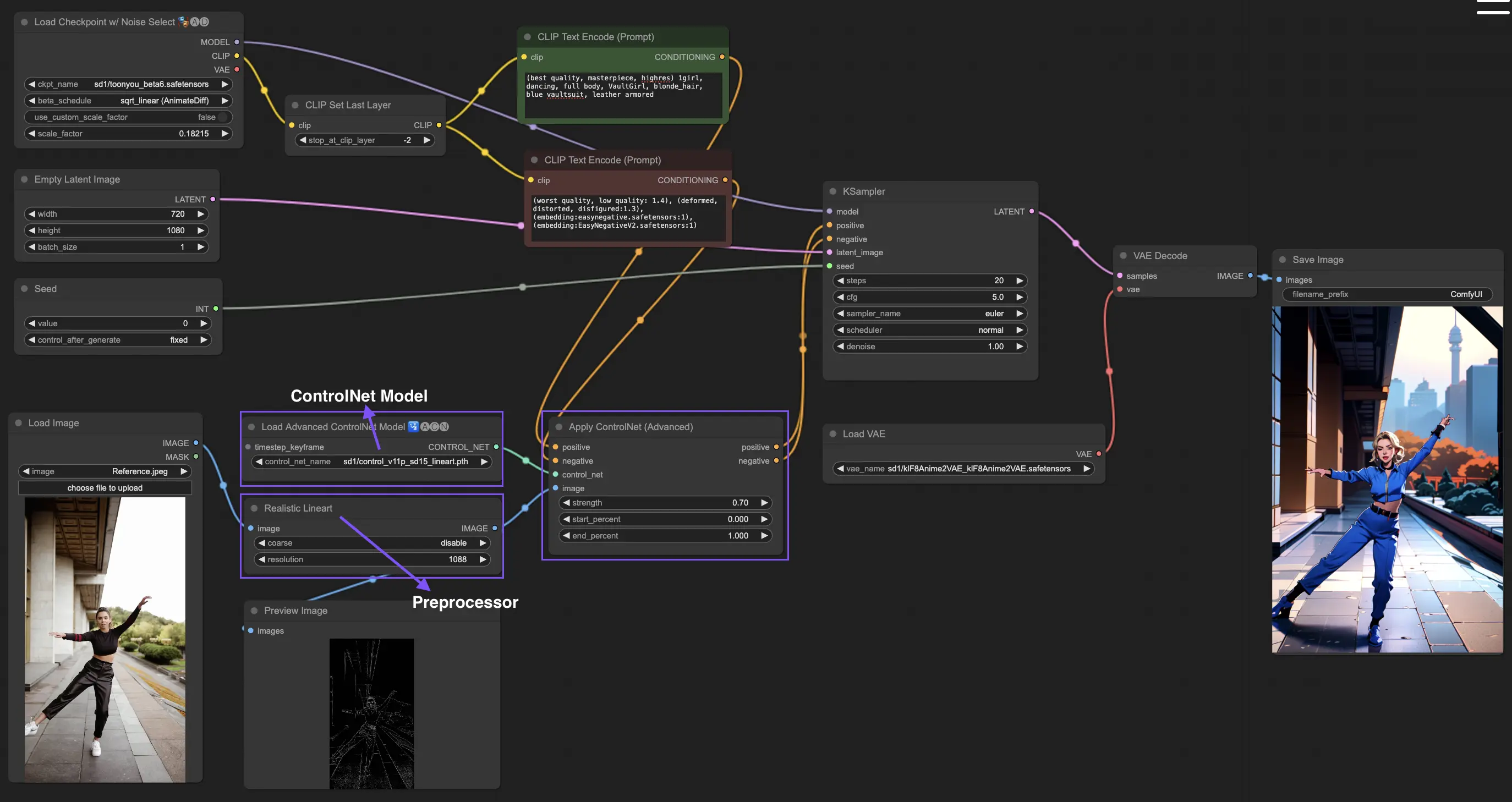

3. Como Usar ControlNet

ControlNet melhora a geração de imagens introduzindo controle espacial preciso para modelos de texto para imagem, permitindo que os usuários manipulem imagens de maneiras sofisticadas além de apenas prompts de texto, utilizando vastas bibliotecas de modelos como Stable Diffusion para tarefas intrincadas, como esboçar, mapear e segmentar elementos visuais.

A seguir está o fluxo de trabalho mais simples usando ControlNet.

3.1 Carregando o Nó "Apply ControlNet"

Comece a criação da sua imagem carregando o Nó "Apply ControlNet" no ComfyUI, definindo o cenário para combinar elementos visuais e textuais em seu design.

3.2 Entradas do Nó "Apply ControlNet"

Use Condicionamento Positivo e Negativo para moldar sua imagem, selecione um modelo ControlNet para definir características de estilo e pré-processe sua imagem para garantir que ela corresponda aos requisitos do modelo ControlNet, tornando-a pronta para transformação.

3.3 Saídas do Nó "Apply ControlNet"

As saídas do nó orientam o modelo de difusão, oferecendo uma escolha entre refinar ainda mais a imagem ou adicionar mais ControlNets para detalhes aprimorados e personalização com base na interação do ControlNet com suas entradas criativas.

3.4 Ajustando "Apply ControlNet" para Melhores Resultados

Controle a influência do ControlNet na sua imagem por meio de configurações como Determining Strength, Adjusting Start Percent e Setting End Percent para ajustar com precisão o processo criativo e o resultado da imagem.

Para informações mais detalhadas, confira

Este fluxo de trabalho é inspirado por com algumas modificações. Para mais informações, visite seu canal no YouTube.