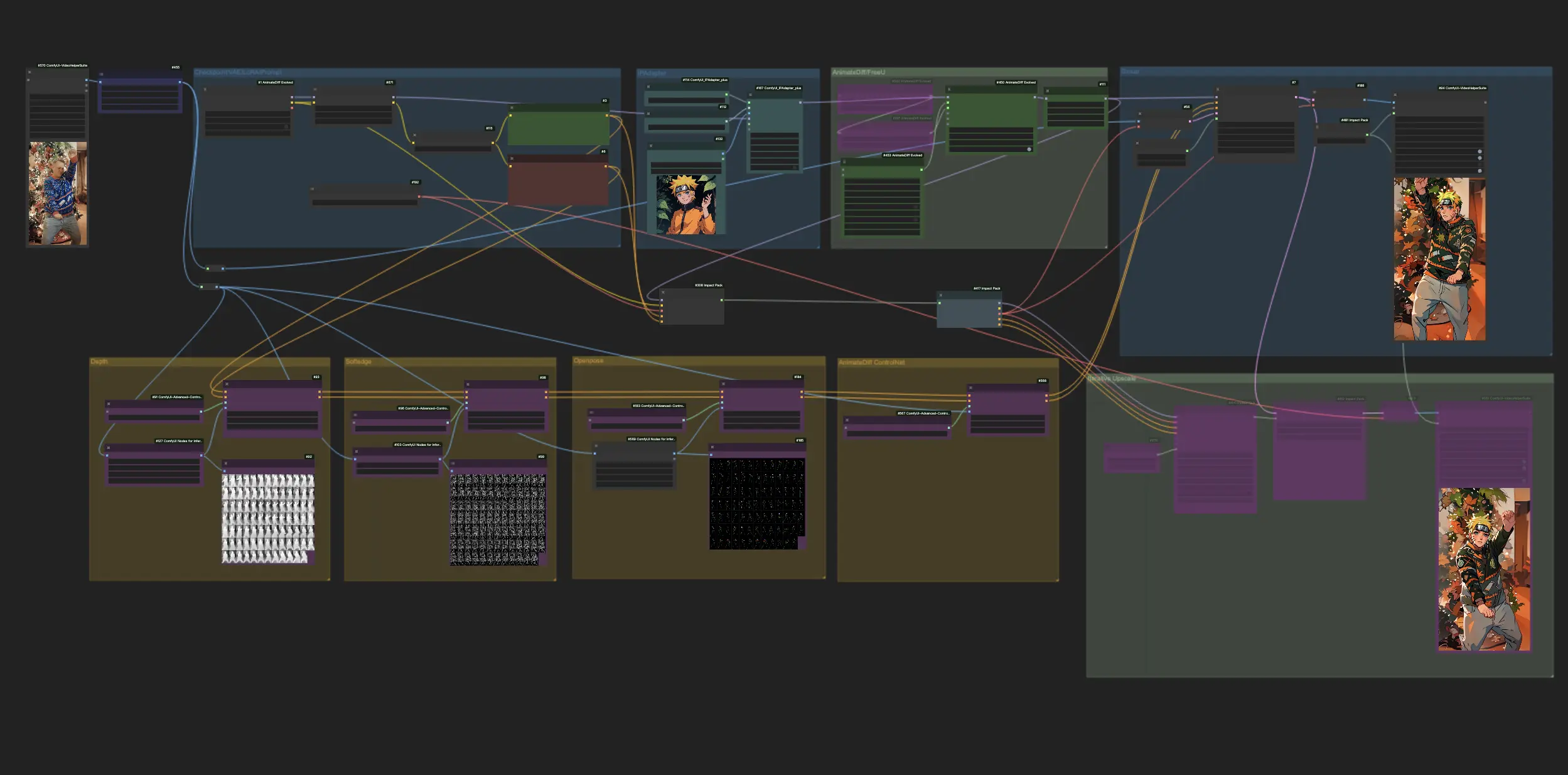

AnimateDiff + ControlNet + IPAdapter V1 | 日本动漫风格

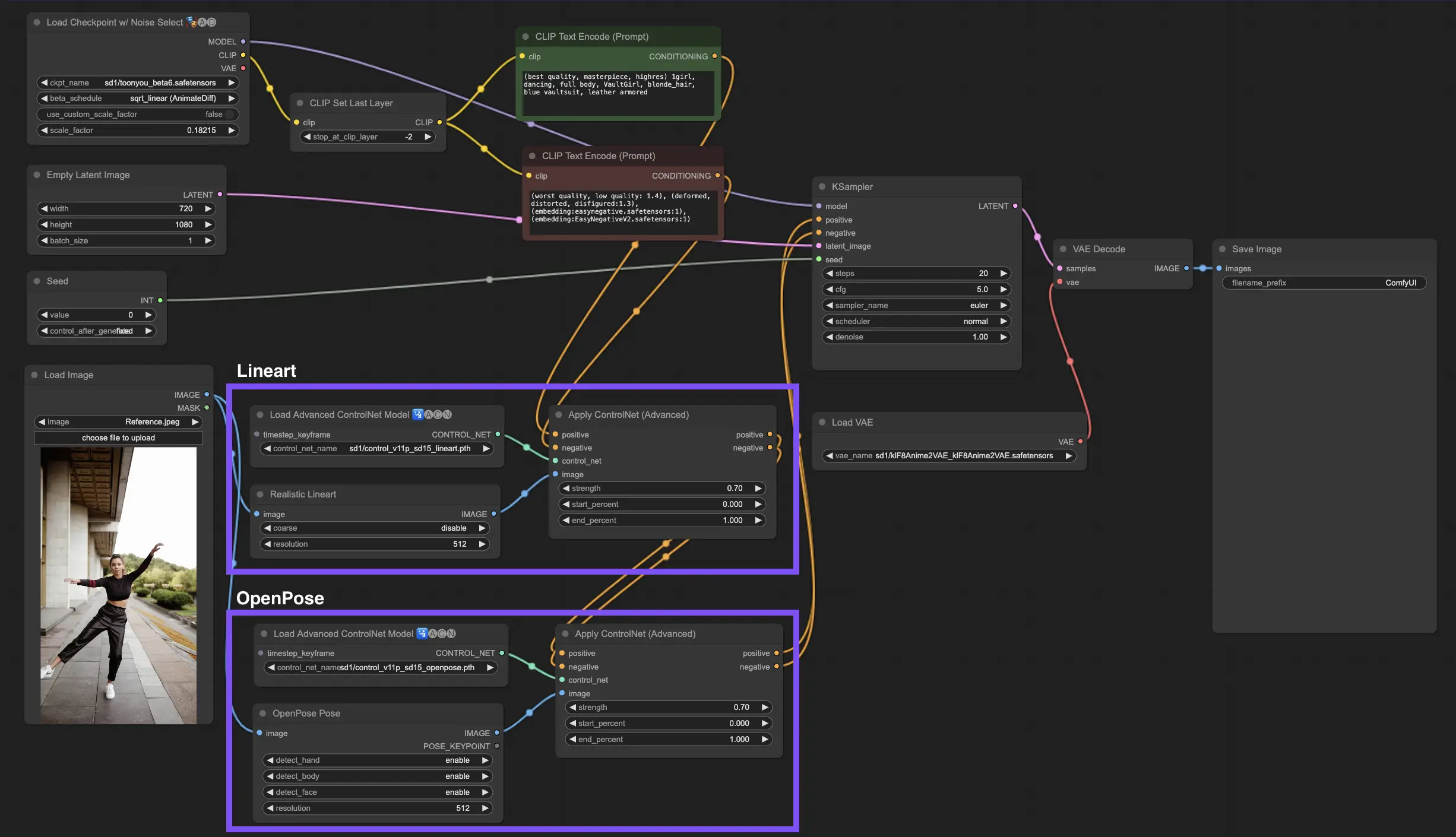

在ComfyUI利用AnimateDiff、ControlNet和IPAdapter的强大功能将标准视频转换为迷人的日本动漫渲染时,体验动漫转换的快感。这个工作流程巧妙地采用了深度感知、柔和边缘细节和OpenPose技术等先进技术,再加上Lora的细微触感,确保每个视频都以真实的动漫美学重新想象。在无缝、充满风格的变身中沉浸在动漫宇宙中。ComfyUI Vid2Vid (Japanese Anime) 工作流程

ComfyUI Vid2Vid (Japanese Anime) 示例

ComfyUI Vid2Vid (Japanese Anime) 描述

这个工作流程的灵感来自,并进行了一些修改。更多信息,请访问他的YouTube频道。

1. ComfyUI工作流程:AnimateDiff + ControlNet + IPAdapter | 日本动漫风格

这个工作流程可以让你使用AnimateDiff、ControlNet和IPAdapter将标准视频转换为迷人的日本动漫创作。欢迎尝试各种检查点、LoRA设置和IPAdapter的参考图像,打造您独特的风格。这是一种有趣且富有创意的方式,可以在动漫世界中赋予您的视频生命!

2. AnimateDiff概述

请查看的详细信息

3. 如何使用ControlNet

3.1. 了解ControlNet

ControlNet通过为文本到图像扩散模型带来新的空间控制水平,革新了我们生成图像的方式。这种尖端的神经网络架构与Stable Diffusion等巨头完美合作,利用它们从数十亿张图像中打造的巨大库,将空间细微差别直接编入图像创建的结构中。从勾画边缘到映射人体姿势、深度感知或视觉分割,ControlNet使您能够以远远超出单纯文本提示范围的方式塑造图像。

3.2. ControlNet的创新

ControlNet的核心非常简单。它首先保护原始模型参数的完整性,保持基础训练不变。然后,ControlNet引入了一组镜像的模型编码层,但有所不同:它们使用"零卷积"进行训练。这些零作为起点意味着这些层可以轻松地折叠新的空间条件,而不会引起混乱,确保即使模型开始新的学习路径,其原始才能也能得到保留。

3.3. 理解ControlNets和T2I-Adapters

ControlNets和T2I-Adapters在图像生成的调节中都扮演着关键角色,每一个都提供不同的优势。T2I-Adapters以其效率而闻名,特别是在加速图像生成过程方面。尽管如此,ControlNets在复杂地指导生成过程方面是无与伦比的,使其成为创作者的强大工具。

考虑到许多T2I-Adapter和ControlNet模型在功能上的重叠,我们的讨论将主要集中在ControlNets上。然而,值得注意的是,RunComfy平台预加载了几个T2I-Adapter模型以方便使用。对于有兴趣尝试T2I-Adapters的人来说,您可以无缝地加载这些模型并将其集成到您的项目中。

在ComfyUI中选择ControlNet和T2I-Adapter模型不会影响ControlNet节点的使用或工作流程的一致性。 这种一致性确保了流程的简化,使您能够根据项目需求利用每种模型类型的独特优势。

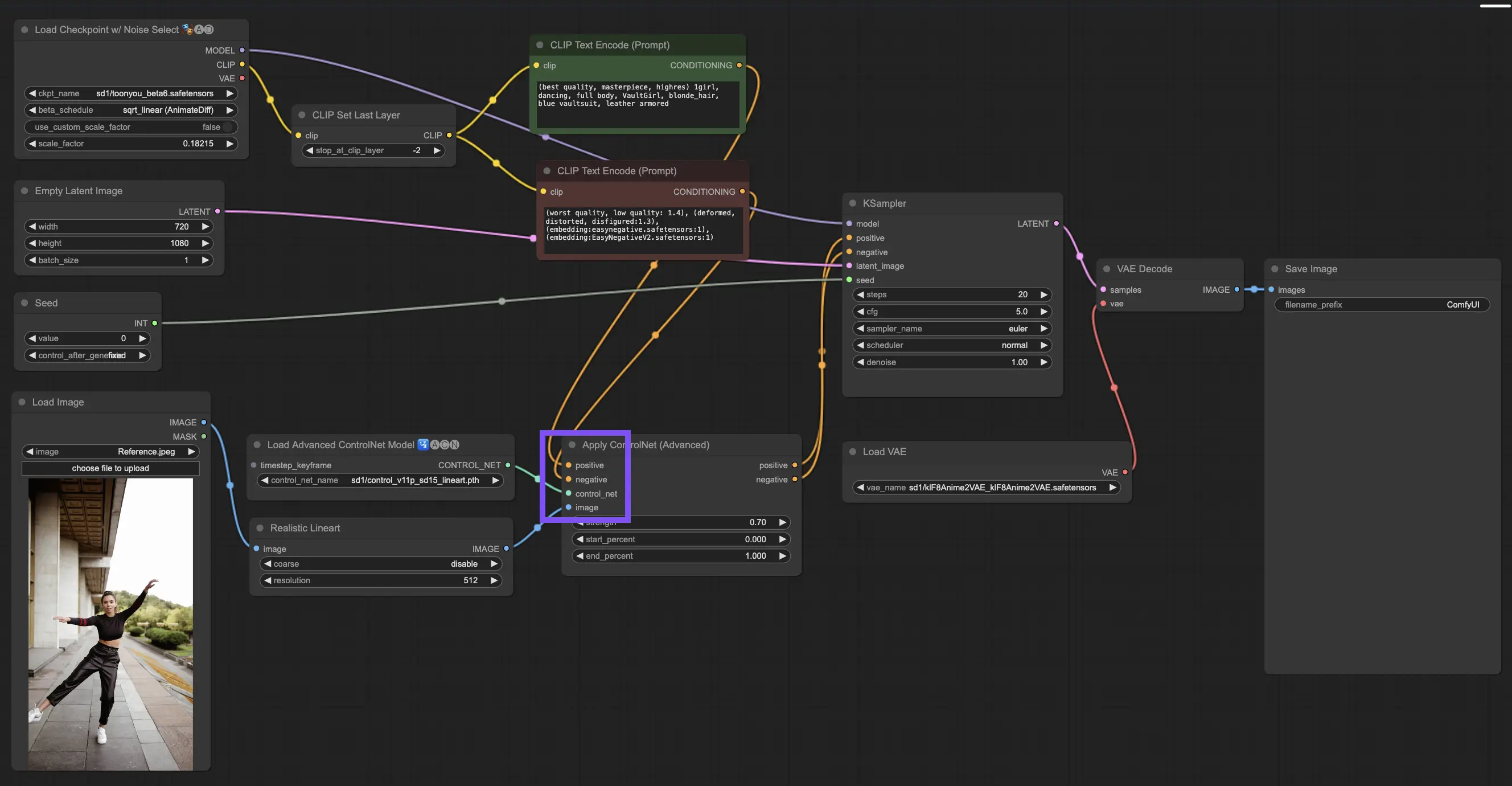

3.4. ControlNet节点的使用

3.4.1. 加载"Apply ControlNet"节点

首先,您需要将"Apply ControlNet"节点加载到您的ComfyUI中。这是您开始双重条件图像制作之旅的第一步,将视觉元素与文本提示相结合。

3.4.2. 理解"Apply ControlNet"节点的输入

正面和负面条件:这些是您塑造最终图像的工具——它应该包含什么,应该避免什么。将这些连接到"Positive prompt"和"Negative prompt"插槽,以将它们与基于文本的创意方向同步。

选择ControlNet模型:您需要将此输入链接到"Load ControlNet Model"节点的输出。在这里,您决定是使用ControlNet还是T2IAdaptor模型,这取决于您想要的特定特征或风格。虽然我们主要关注ControlNet模型,但值得一提的是一些受欢迎的T2IAdaptors,以获得全面的视角。

预处理您的图像:将您的图像连接到"ControlNet Preprocessor"节点,这对于确保您的图像已准备好用于ControlNet至关重要。将预处理器与您的ControlNet模型相匹配非常重要。此步骤将调整原始图像以完美适合模型的需求——调整大小、重新着色或应用必要的滤镜——为ControlNet使用做好准备。

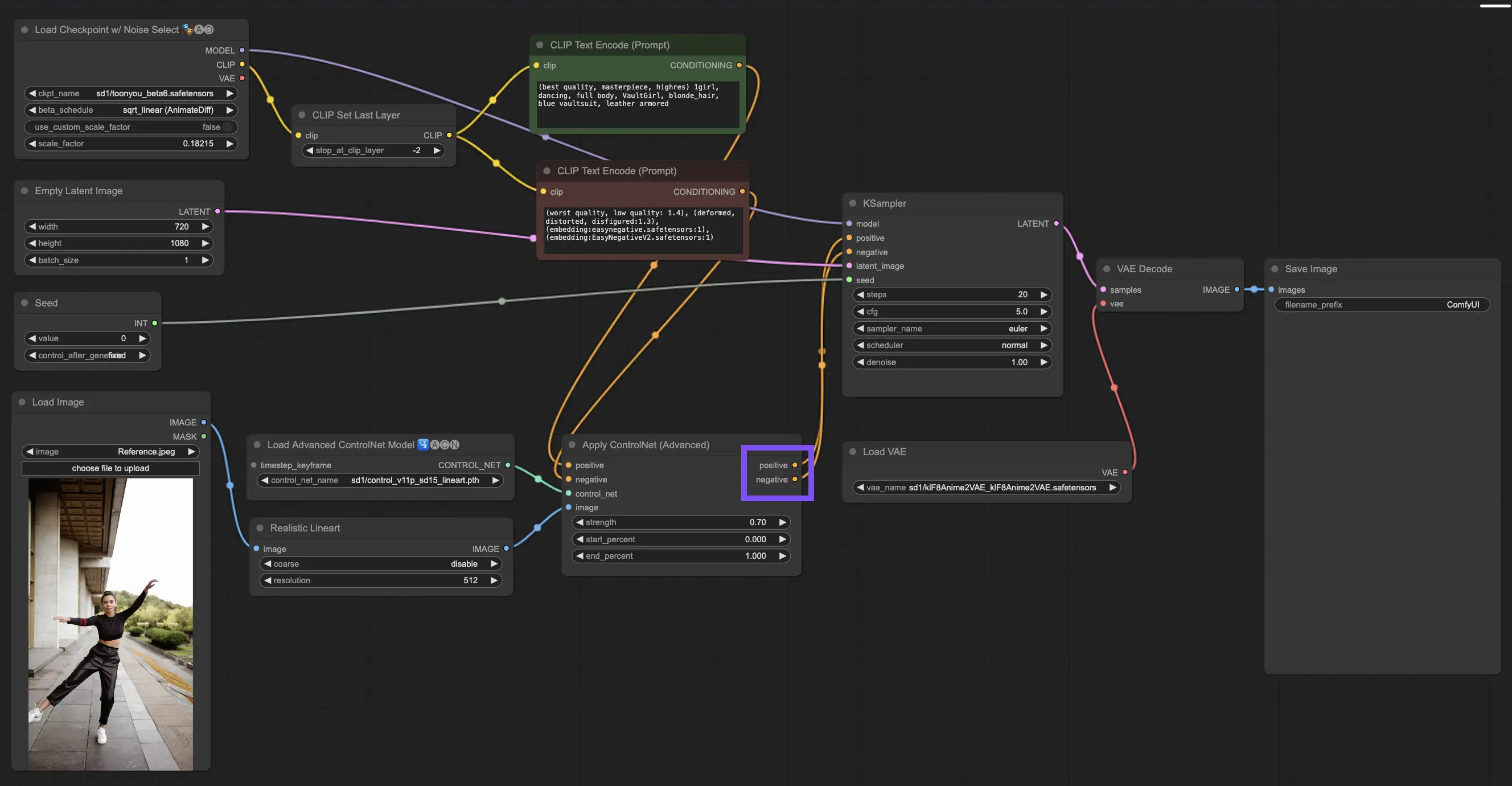

3.4.3. 理解"Apply ControlNet"节点的输出

经过处理后,"Apply ControlNet"节点会为您提供两个输出,反映了ControlNet和您的创意输入之间复杂的相互作用:正面和负面条件。这些输出指导ComfyUI中的扩散模型,引导您做出下一个选择:使用KSampler细化图像,或通过堆叠更多ControlNets深入研究,以实现无与伦比的细节和自定义。

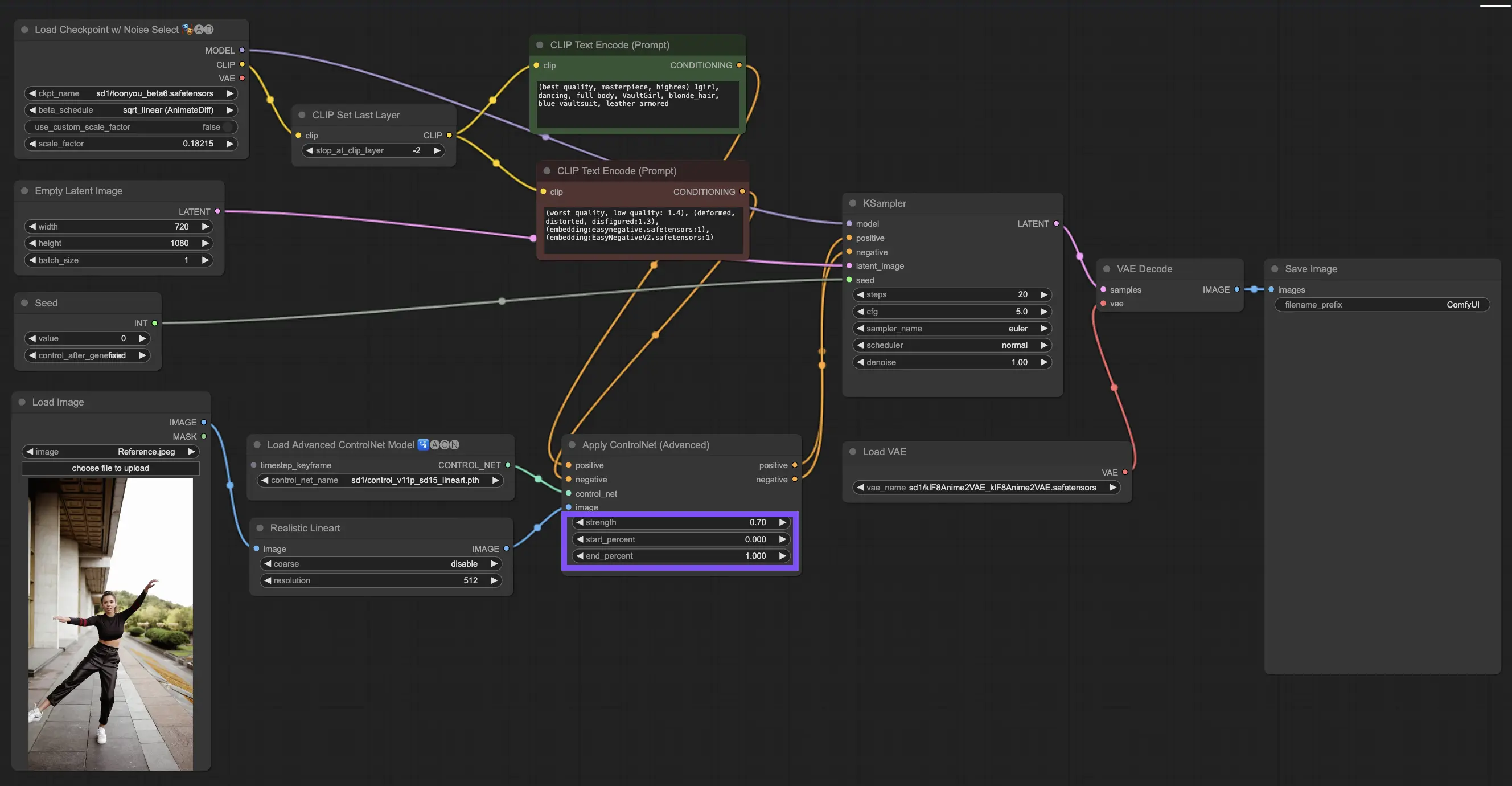

3.4.4. 调整"Apply ControlNet"以获得最佳效果

确定强度:此设置控制ControlNet对生成图像的影响程度。完全的1.0意味着ControlNet的输入掌控大局,而将其调低到0.0则让模型在没有ControlNet影响的情况下运行。

调整起始百分比:这告诉您ControlNet在扩散过程中何时开始起作用。例如,20%的起点意味着从五分之一的路程开始,ControlNet开始发挥作用。

设置结束百分比:这是起始百分比的另一面,标志着ControlNet何时退出。如果将其设置为80%,则在图像接近最后阶段时,ControlNet的影响会逐渐消失,在最后阶段不受ControlNet的影响。

3.5. ControlNet模型指南:Openpose、Depth、SoftEdge、Canny、Lineart、Tile

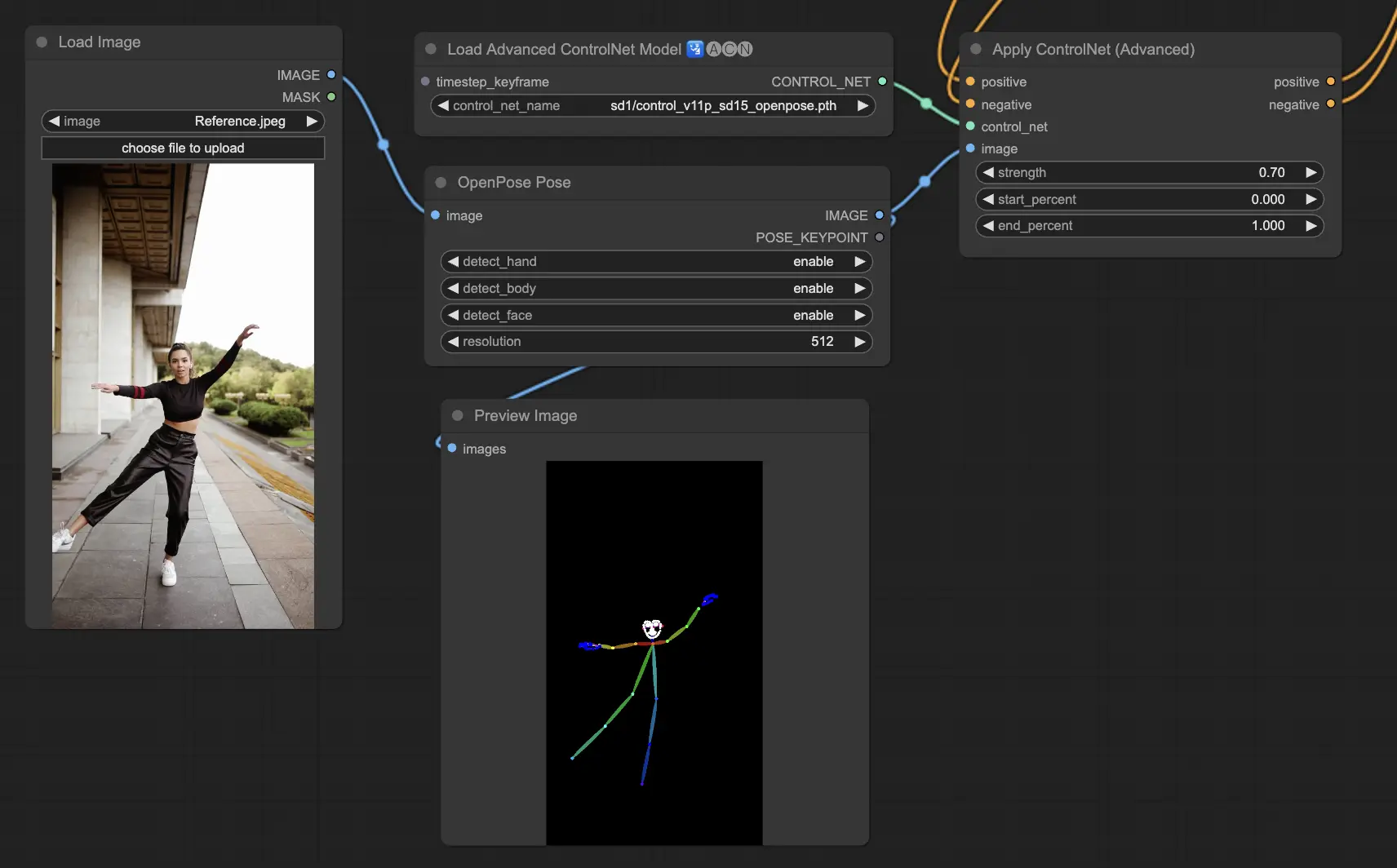

3.5.1. ControlNet模型:Openpose

- Openpose(也称为Openpose body):该模型是ControlNet识别人体关键点(如眼睛、鼻子、脖子、肩膀、肘部、手腕、膝盖和脚踝)的基础。它非常适合复制简单的人体姿势。

- Openpose_face:这个版本的Openpose更进一步,检测面部关键点,从而可以细致地分析面部表情和面部指向的方向。如果您的项目以面部表情为中心,则此模型至关重要。

- Openpose_hand:这个Openpose模型的增强功能侧重于手和手指运动的细节,这对于详细了解手势和定位至关重要。它扩大了Openpose在ControlNet中的作用范围。

- Openpose_faceonly:专为面部细节分析而定制,此模型跳过身体关键点,仅专注于面部表情和方向。当面部特征是唯一重要的时候,这就是要选择的模型。

- Openpose_full:这个一体化模型集成了Openpose、Openpose_face和Openpose_hand的功能,用于全身、面部和手部关键点检测,使其成为ControlNet中人体姿势分析的首选。

- DW_Openpose_full:在Openpose_full的基础上,该模型引入了进一步的增强功能,以提高姿势检测的细节和准确性。这是ControlNet套件中最先进的版本。

预处理器选项包括:Openpose或DWpose

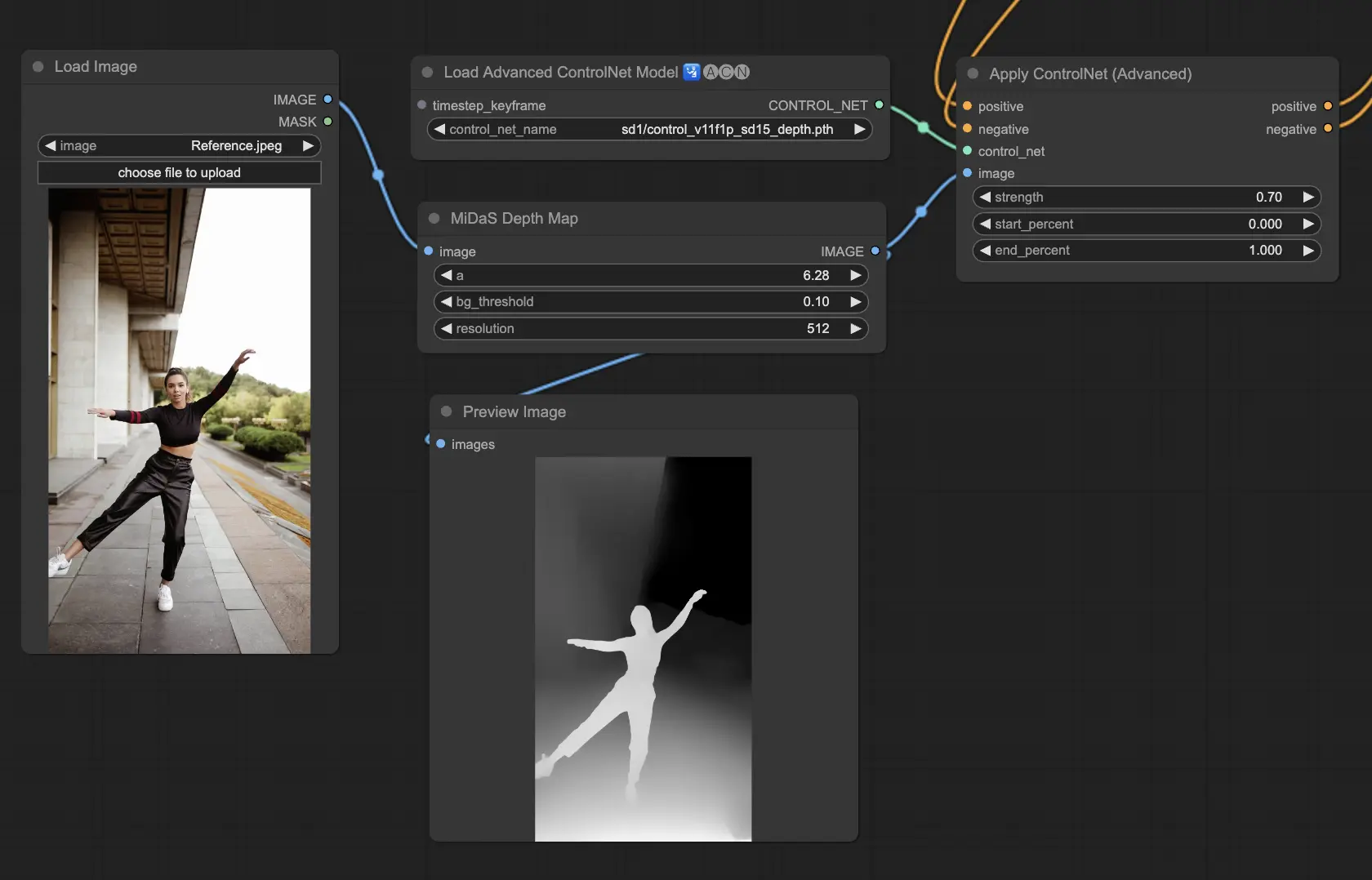

3.5.2. ControlNet模型:Depth

Depth模型使用2D图像推断深度,并将其表示为灰度图。每种模型在细节或背景焦点方面都有其优势:

- Depth Midas:Depth Midas在深度估计方面采用平衡方法,在细节和背景描绘方面提供了一个中间地带。

- Depth Leres:强调细节,同时仍然更突出地捕捉背景元素。

- Depth Leres++:在深度信息的细节方面更进一步,特别适用于复杂场景。

- Zoe:在Midas和Leres模型的细节级别之间找到平衡。

- Depth Anything:一个改进的模型,用于各种场景的通用深度估计。

- Depth Hand Refiner:专门微调深度图中手部的细节,对于手部放置精确至关重要的场景来说非常宝贵。

要考虑的预处理器:Depth_Midas、Depth_Leres、Depth_Zoe、Depth_Anything、MeshGraphormer_Hand_Refiner。该模型在鲁棒性和与渲染引擎的实际深度图兼容性方面表现出色。

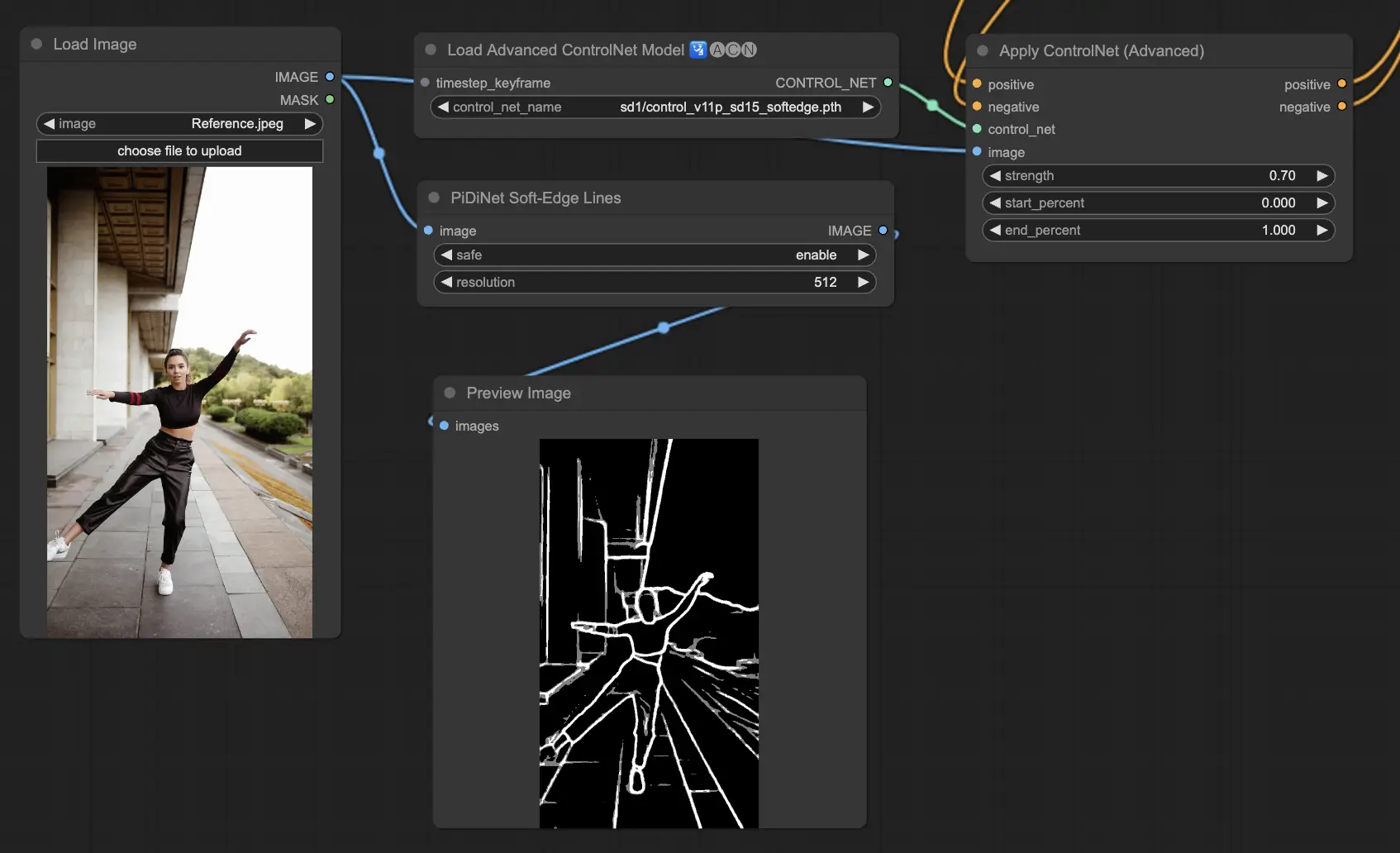

3.5.3. ControlNet模型:SoftEdge

ControlNet Soft Edge旨在生成具有更柔和边缘的图像,在提高细节的同时保持自然外观。它利用尖端的神经网络进行精细的图像处理,提供广泛的创意控制和无缝集成。

在鲁棒性方面:SoftEdge_PIDI_safe > SoftEdge_HED_safe >> SoftEdge_PIDI > SoftEdge_HED

为获得最高质量的结果:SoftEdge_HED > SoftEdge_PIDI > SoftEdge_HED_safe > SoftEdge_PIDI_safe

作为一般建议,SoftEdge_PIDI是首选,因为它通常能提供出色的结果。

预处理器包括:SoftEdge_PIDI、SoftEdge_PIDI_safe、SoftEdge_HED、SoftEdge_HED_safe。

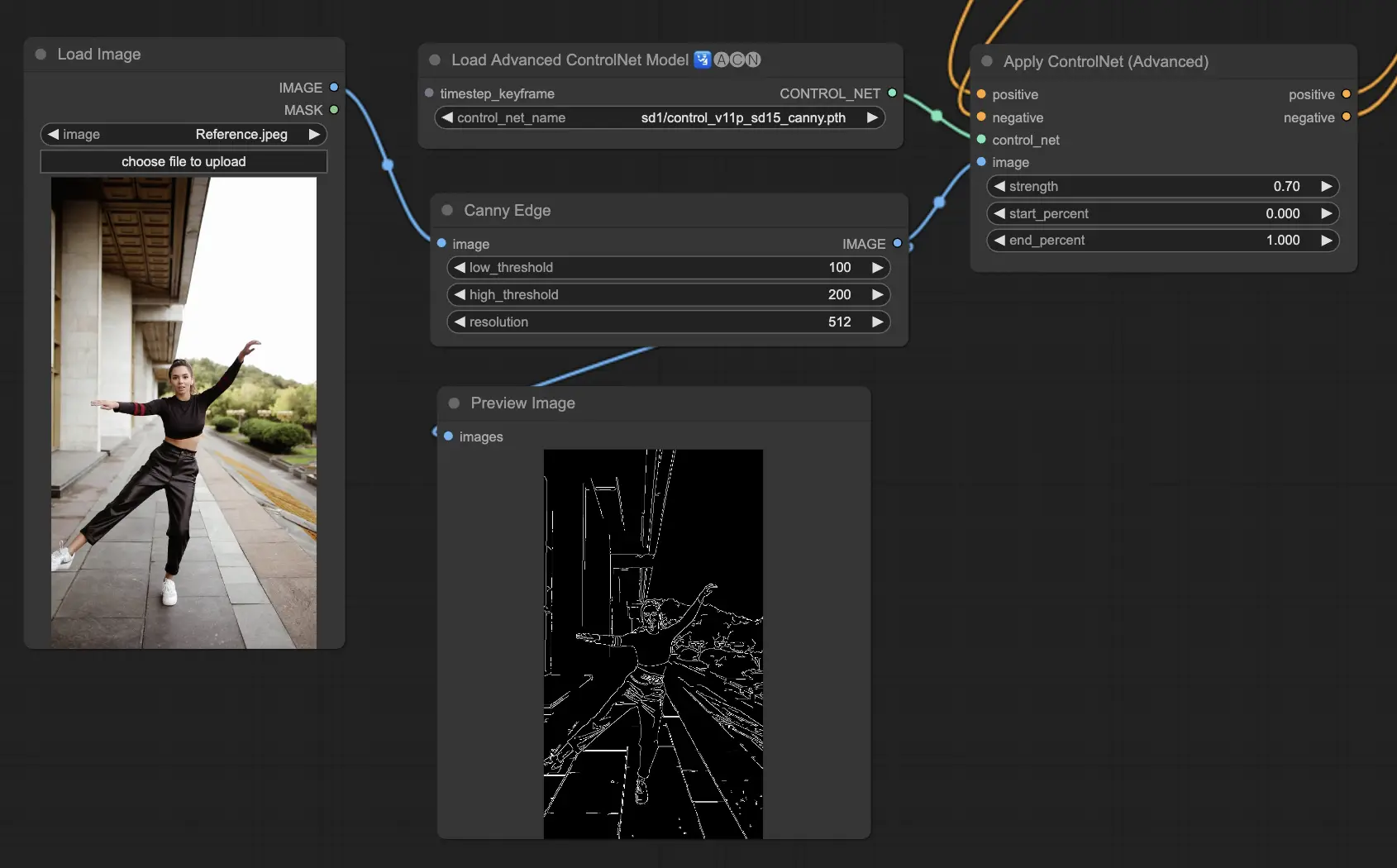

3.5.4. ControlNet模型:Canny

Canny模型实现了Canny边缘检测,以突出图像中的各种边缘。该模型擅长在简化图像整体外观的同时保持结构元素的完整性,有助于创建风格化的艺术品或为进一步操作准备图像。

可用的预处理器:Canny

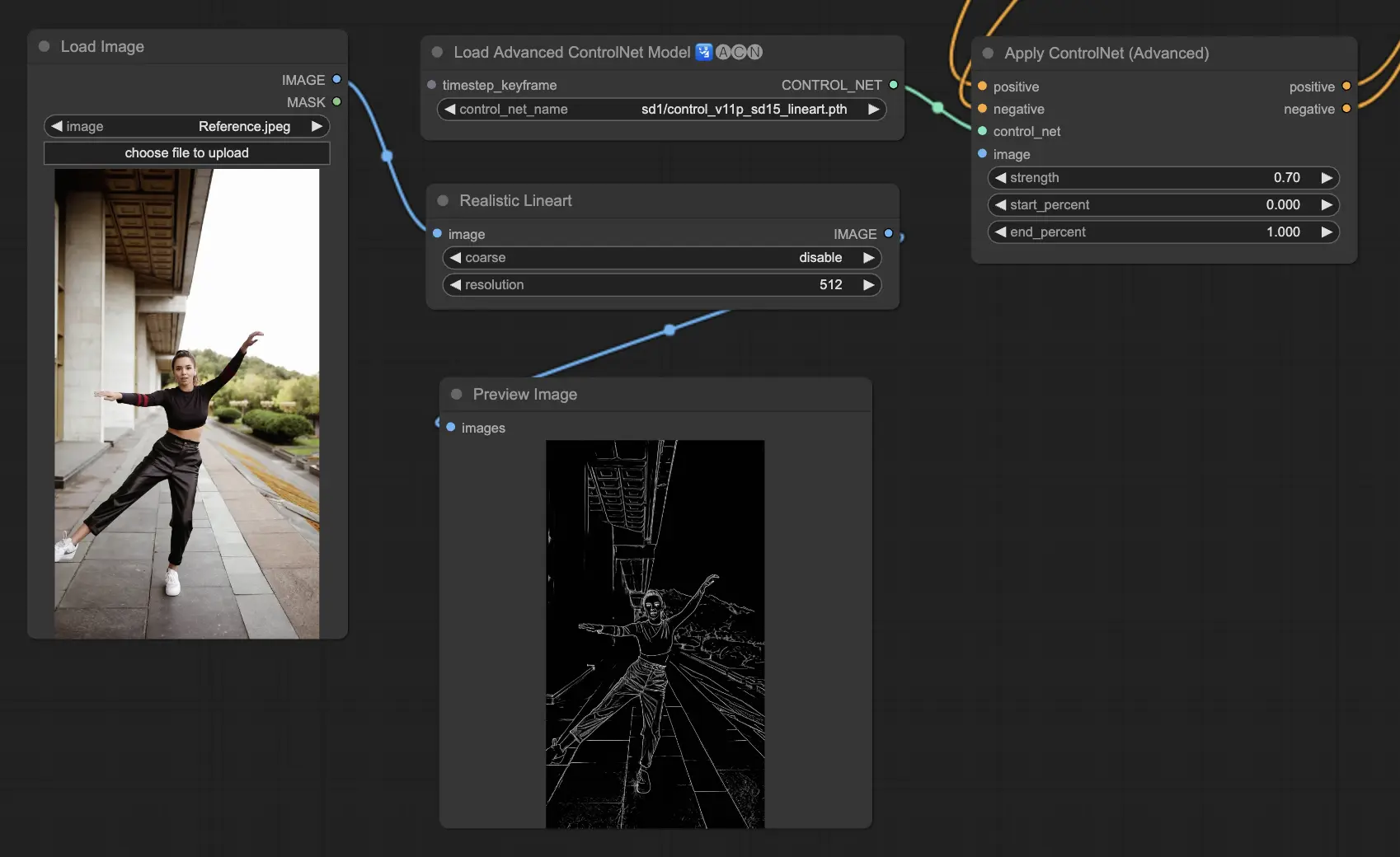

3.5.5. ControlNet模型:Lineart

Lineart模型是将图像转换为风格化线条图的工具,适用于各种艺术应用:

- Lineart:将图像转换为线条图的标准选择,为不同的艺术或创意endeavor提供多用途的起点。

- Lineart anime:专为创建干净、精确的日本动漫风格线条图而量身定制,非常适合以日本动漫风格为灵感的项目。

- Lineart realistic:旨在在线条图中捕捉更逼真的表现,为需要写实性的项目提供更多细节。

- Lineart coarse:强调更大胆、更明显的线条以产生强烈的视觉冲击力,非常适合大胆的图形语句。

可用的预处理器可以生成详细或更明显的线条图(Lineart和Lineart_Coarse)。

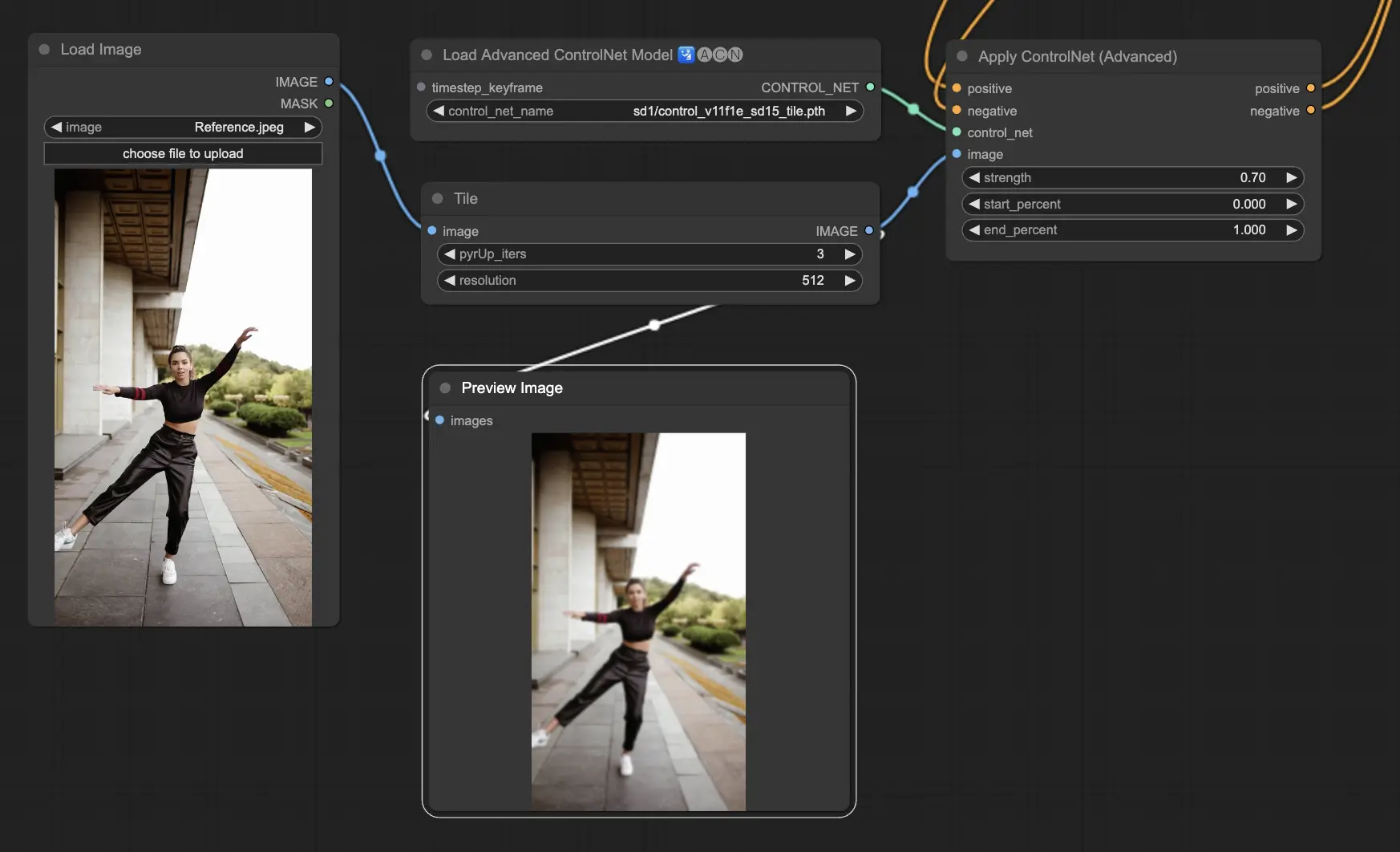

3.5.6. ControlNet模型:Tile

Tile Resample模型擅长突出图像中的细节。当与升频器一起使用以提高图像分辨率和细节时,它特别有效,通常用于锐化和丰富图像纹理和元素。

推荐的预处理器:Tile

3.6. 使用多个ControlNet的指南

结合多个ControlNets或T2I-Adapters允许对图像生成过程依次应用不同类型的调节。例如,您可以结合Lineart和OpenPose ControlNets以增强细节。

用于对象形状的Lineart:首先集成Lineart ControlNet,为图像中的对象或元素添加深度和细节。此过程涉及为您希望包含的对象准备线条图或Canny图。

用于姿势控制的OpenPose:在线条图细节之后,利用OpenPose ControlNet来指导图像中个人的姿势。您需要生成或获取捕捉所需姿势的OpenPose图。

顺序应用:为了有效地结合这些效果,将Lineart ControlNet的输出链接到OpenPose ControlNet中。这种方法确保在生成过程中同时引导主体的姿势和对象的形状,创建出与所有输入规范和谐一致的结果。

4. IPAdapter概述

请查看的详细信息