AnimateDiff + ControlNet + AutoMask | 漫画风格

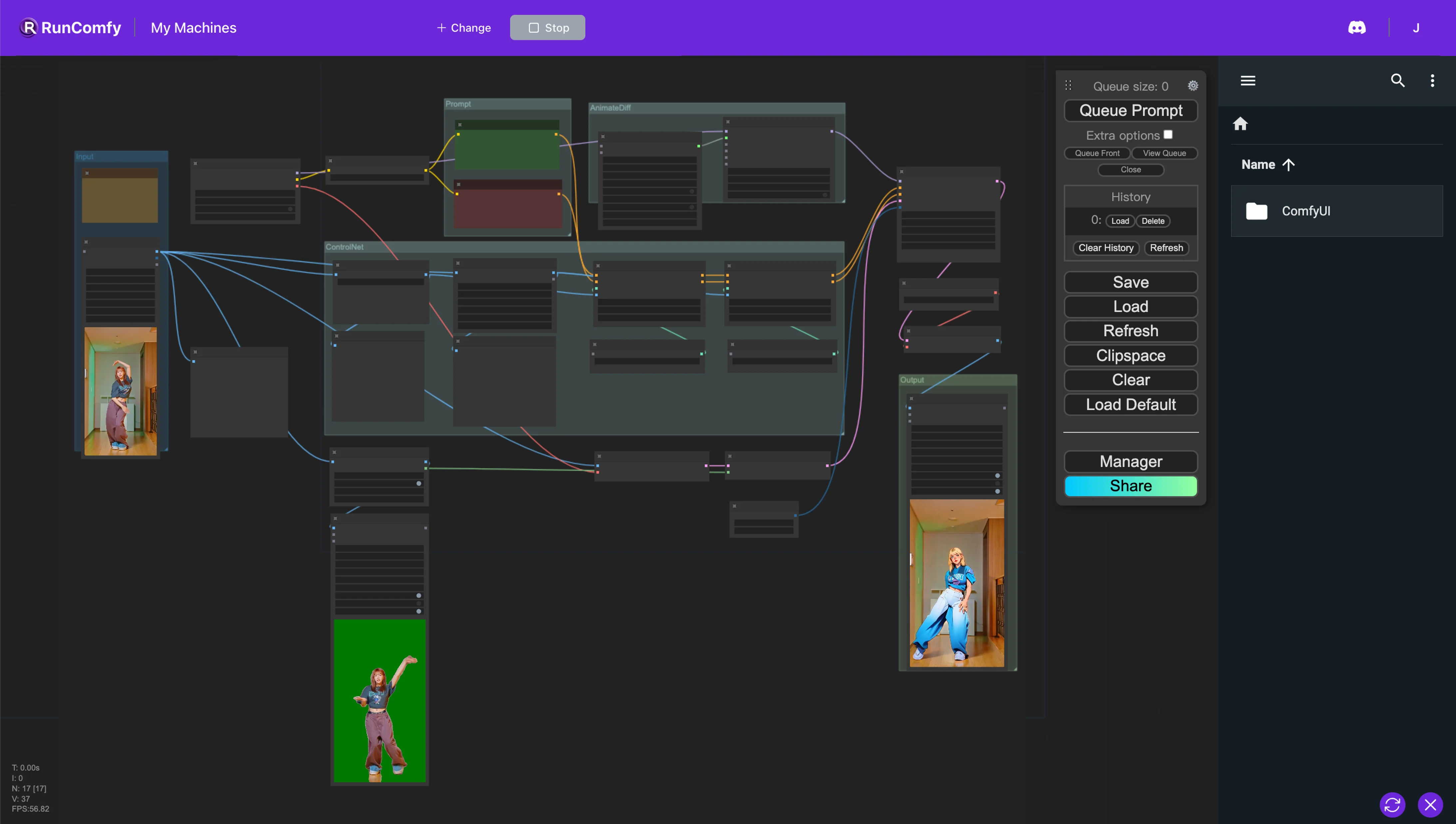

在这个 ComfyUI 工作流程中,我们利用自定义节点如 Animatediff、ControlNet(具有深度和 OpenPose 功能)以及自动蒙版来无缝地重塑视频风格。这个过程将真实的角色转变为动漫风格,同时细致地保留原始背景。ComfyUI Vid2Vid 工作流程

ComfyUI Vid2Vid 示例

ComfyUI Vid2Vid 描述

1. ComfyUI AnimateDiff、ControlNet 和自动蒙版工作流程

这个 ComfyUI 工作流程引入了一种强大的视频风格重塑方法,特别针对将人物转换为动漫风格,同时保留原始背景。这种转换由几个关键组件支持,包括 AnimateDiff、ControlNet 和 Auto Mask。

AnimateDiff 专为差分动画技术而设计,可在动画中保持一致的上下文。这个组件专注于平滑过渡,增强重塑视频内容中运动的流畅性。

ControlNet 在精确的人体姿势复制和操作中发挥关键作用。它利用先进的姿势估计来准确捕捉和控制人体运动的细微差别,有助于将人物转换为动漫形式,同时保留他们原始的姿势。

Auto Mask 参与自动分割,擅长将人物与背景隔离。这项技术允许选择性地重塑视频元素,确保在不改变周围环境的情况下执行人物转换,保持原始背景的完整性。

这个 ComfyUI 工作流程实现了将标准视频内容转换为风格化动画,重点是动漫风格人物生成的效率和质量。

2. AnimateDiff 概述

2.1. AnimateDiff 简介

AnimateDiff 作为一种 AI 工具,旨在利用 Stable Diffusion 模型和专门的运动模块将静态图像和文本提示制作成动态视频。该技术通过预测帧之间的无缝过渡来自动化动画过程,使没有编码技能或计算资源的用户也可以通过免费在线平台使用。

2.2. AnimateDiff 的主要特点

2.2.1. 全面的模型支持: AnimateDiff 兼容各种版本,包括用于 Stable Diffusion V1.5 的 AnimateDiff v1、v2、v3,以及用于 Stable Diffusion SDXL 的 AnimateDiff sdxl。它允许同时使用多个运动模型,有助于创建复杂和分层的动画。

2.2.2. 上下文批量大小决定动画长度: AnimateDiff 通过调整上下文批量大小,可以创建无限长度的动画。此功能允许用户自定义动画的长度和过渡,以满足其特定要求,提供高度适应性的动画过程。

2.2.3. 平滑过渡的上下文长度: 在 AnimateDiff 中使用统一上下文长度的目的是确保动画不同片段之间的无缝过渡。通过调整统一上下文长度,用户可以控制场景之间的过渡动态——更长的长度可获得更平滑、更无缝的过渡,而较短的长度可获得更快、更明显的变化。

2.2.4. 运动动态: 在 AnimateDiff v2 中,专门的运动 LoRA 可用于为动画添加电影般的摄像机运动。此功能为动画引入了动态层,显著增强了它们的视觉吸引力。

2.2.5. 高级支持功能: AnimateDiff 设计为与各种工具配合使用,包括 ControlNet、SparseCtrl 和 IPAdapter,为旨在扩展项目创作可能性的用户提供显著优势。

3. ControlNet 概述

3.1. ControlNet 简介

ControlNet 引入了一个框架,用于通过条件输入来增强图像扩散模型,旨在改进和指导图像合成过程。它通过将给定扩散模型中的神经网络块复制为两组来实现这一点:一组保持 "锁定" 以保留原始功能,而另一组变得 "可训练",以适应提供的特定条件。这种双重结构允许开发人员通过使用 OpenPose、Tile、IP-Adapter、Canny、Depth、LineArt、MLSD、Normal Map、Scribbles、Segmentation、Shuffle 和 T2I Adapter 等模型来合并各种条件输入,从而直接影响生成的输出。通过这种机制,ControlNet 为开发人员提供了一个强大的工具来控制和操纵图像生成过程,增强了扩散模型的灵活性及其在各种创意任务中的适用性。

预处理器和模型集成

3.1.1. 预处理配置: 启动 ControlNet 需要选择合适的预处理器。建议激活预览选项以直观了解预处理的影响。预处理后,工作流转变为利用预处理后的图像进行进一步的处理步骤。

3.1.2. 模型匹配: 为简化模型选择过程,ControlNet 通过根据共享关键字将模型与其对应的预处理器对齐,确保兼容性,从而实现无缝集成过程。

3.2. ControlNet 的主要特点

ControlNet 模型的深入探索

3.2.1. OpenPose 套件: OpenPose 套件专为精确的人体姿势检测而设计,包括用于以极高精度检测身体姿势、面部表情和手部动作的模型。各种 OpenPose 预处理器针对特定的检测要求量身定制,从基本的姿势分析到捕捉面部和手部细微差别的详细信息。

3.2.2. Tile Resample 模型: Tile Resample 模型通过增强图像分辨率和细节来优化使用,通常与升频工具一起使用,旨在在不影响视觉完整性的情况下丰富图像质量。

3.2.3. IP-Adapter 模型: IP-Adapter 通过促进图像作为提示的创新使用,将参考图像中的视觉元素集成到生成的输出中,融合文本到图像的扩散能力,丰富视觉内容。

3.2.4. Canny 边缘检测器: Canny 模型以其边缘检测能力著称,强调图像的结构本质,在保持核心构图的同时实现创造性的视觉重新诠释。

3.2.5. 深度感知模型: 通过多种深度预处理器,ControlNet 擅长从图像中推断和应用深度线索,在生成的视觉效果中提供分层深度视角。

3.2.6. LineArt 模型: 使用 LineArt 预处理器将图像转换为艺术线条画,从动漫到写实素描,满足各种艺术风格偏好,ControlNet 适应广泛的风格需求。

3.2.7. 涂鸦处理: 使用 Scribble HED、Pidinet 和 xDoG 等预处理器,ControlNet 将图像转换为独特的涂鸦艺术,为边缘检测和艺术重新诠释提供不同的风格。

3.2.8. 分割技术: ControlNet 的分割能力可以准确地对图像元素进行分类,实现基于对象分类的精确操作,非常适合复杂场景的构建。

3.2.9. Shuffle 模型: Shuffle 模型通过引入一种颜色方案创新方法,随机化输入图像以生成新的色彩模式,在保留原始本质的同时创造性地改变颜色。

3.2.10. T2I Adapter 创新: T2I Adapter 模型,包括 Color Grid 和 CLIP Vision Style,将 ControlNet 推向新的创意领域,融合和调整颜色和风格,生成视觉上引人注目的输出,同时尊重原始图像的配色方案或风格属性。

3.2.11. MLSD(移动线段检测): MLSD 专门用于检测直线,对于关注建筑和室内设计的项目至关重要,优先考虑结构清晰度和精确度。

3.2.12. 法线贴图处理: 法线贴图预处理器利用表面朝向数据,通过详细的表面分析复制参考图像的 3D 结构,增强生成内容的真实感。