ComfyUI IC-Light ワークフローによるビデオ再照明

ComfyUI IC-Light ワークフローを使用して、ライトマップを使用して「Human」キャラクタービデオの照明を強化し、ビデオプロジェクトの可能性を最大限に引き出します。ComfyUI IC-Lightを使用すると、プロンプトとライトマップの要素(形状やネオンライトなど)を提供するだけで、ビデオを簡単に変換できます。このツールは、照明が大幅に改善された新しいビデオを作成します。

ComfyUI IC-Light ワークフローの使い方

- ソースビデオのアップロード: 強化したいビデオをアップロードします。

- ライトマップビデオまたは単一のライトマップ画像のアップロード: 新しい照明テンプレートとして使用するライトマップビデオまたは単一の画像を選択します。

- ロードキャップおよびその他の設定を入力します。同じ設定がライトマップビデオにも適用されるべきです。

- 太陽光やネオンライトなどの新しい照明設定を説明するプロンプトを入力します。

- モデルを選択します。リアルなモデルが推奨されます。

- 必要に応じてライトマップの合成やその他の設定を変更します。

- レンダリングを開始します。

出力は ComfyUI > Outputs に保存されます。

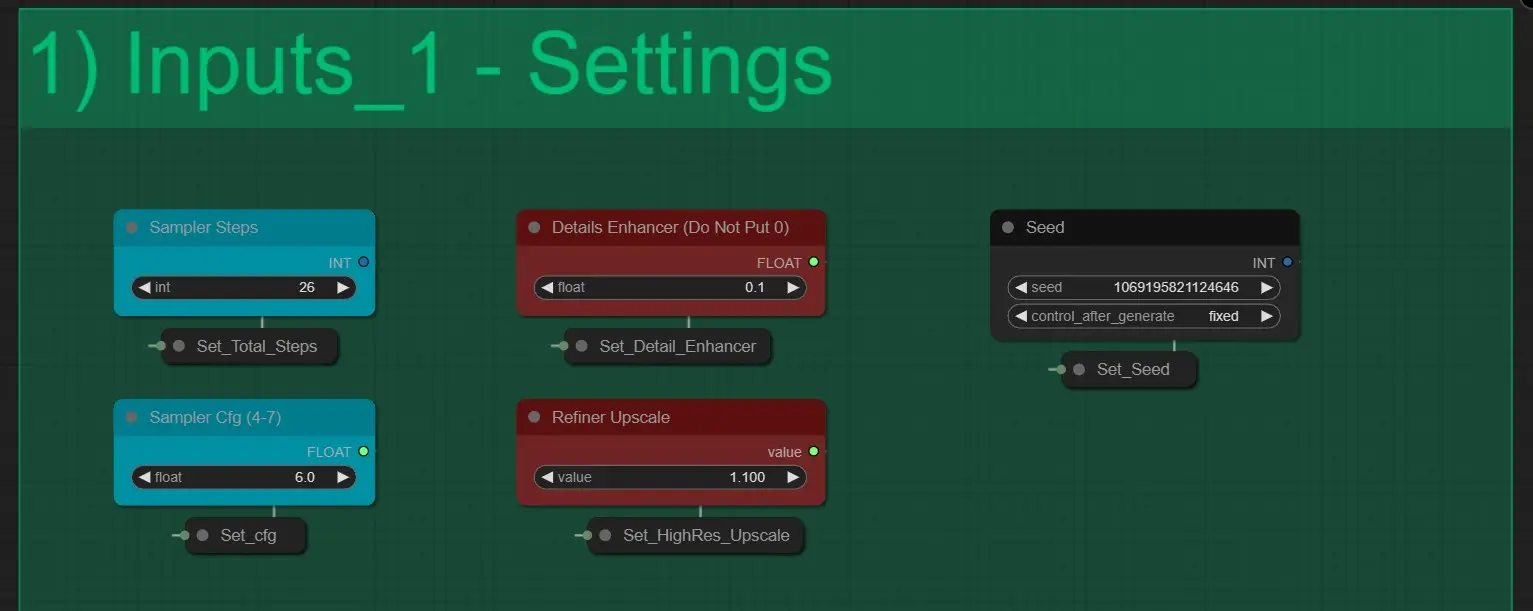

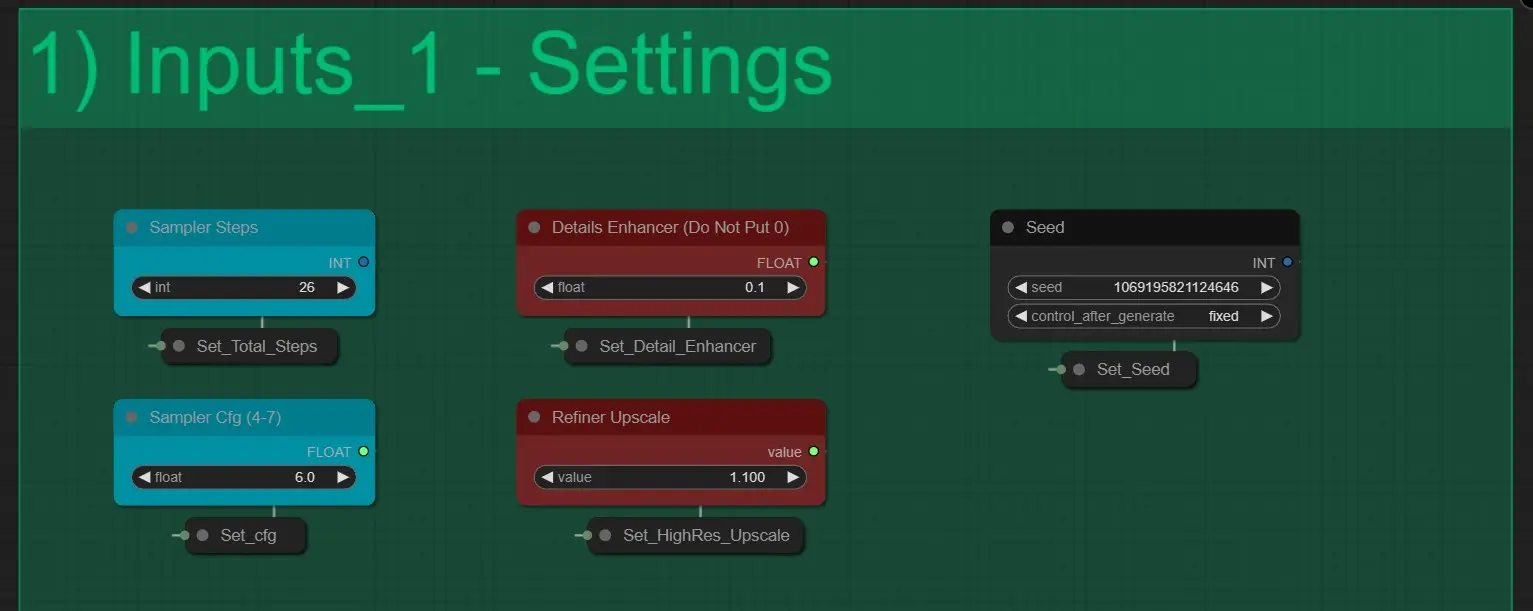

ここには5つの設定があります:

- サンプラーステップ: 画像をレンダリングするための KSampler の総ステップ数を決定します。変更しないでください。[デフォルト値 26]

- ディテールエンハンサー: 最終レンダリングで細かい詳細を増加させます。[0.1から1の間の値を使用]

- シード: 各 KSamplers の生成シードを制御します。

- サンプラーCFG: KSamplers の CFG 値を制御します。

- リファイナーアップスケール: Highres Fix 値のように機能します。[最良の結果を得るために 1.1 - 1.6 の間を使用]

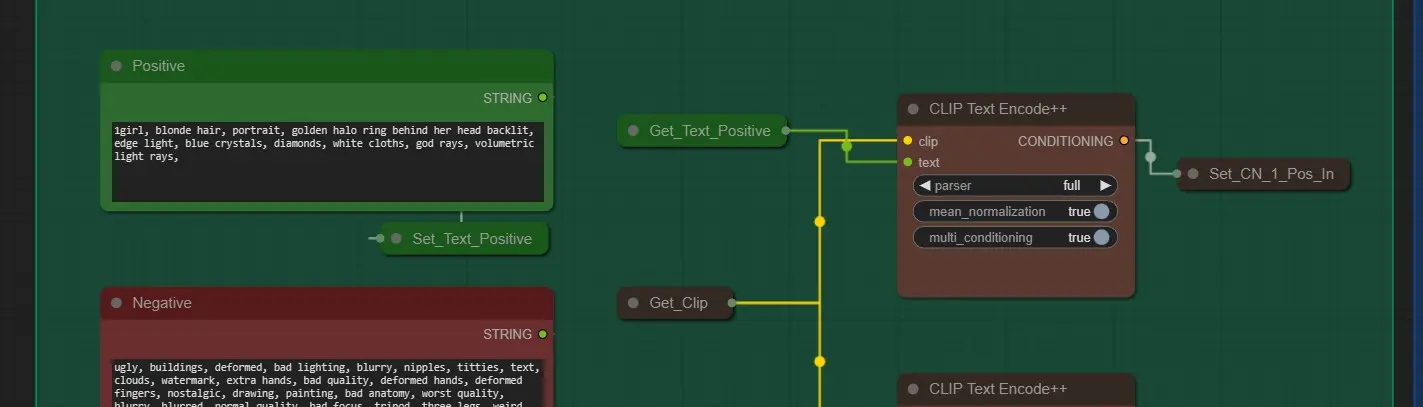

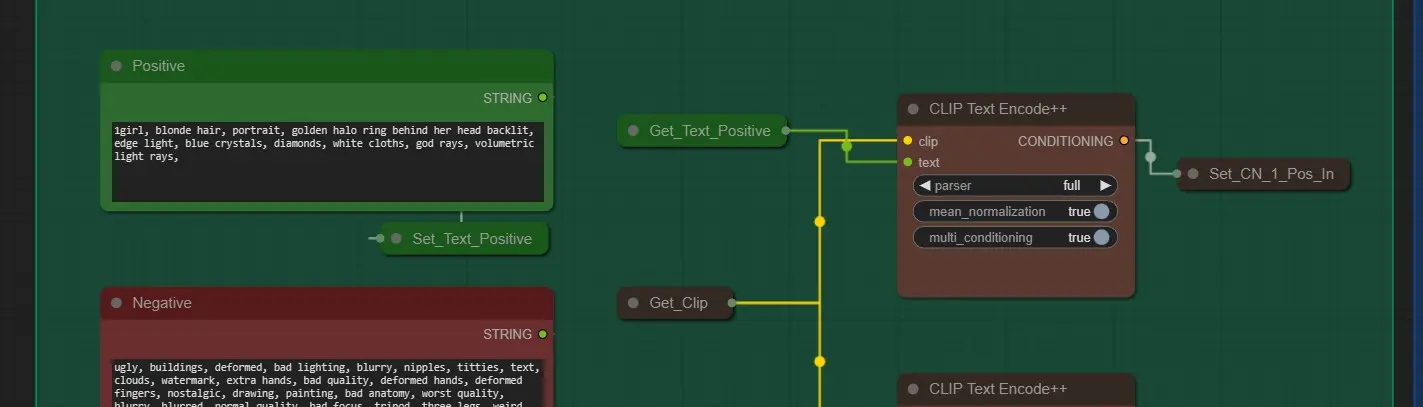

プロンプト

- ポジティブプロンプト: 新しい照明で画像を最もよく説明するプロンプトを入力します。

- ネガティブプロンプト: 最良の結果を得るために構成されています。自由に編集してください。

- クリップテキストエンコードノード: テキストをエンコードして品質を最大化するのに役立ちます。「full」のままにしておいてください。

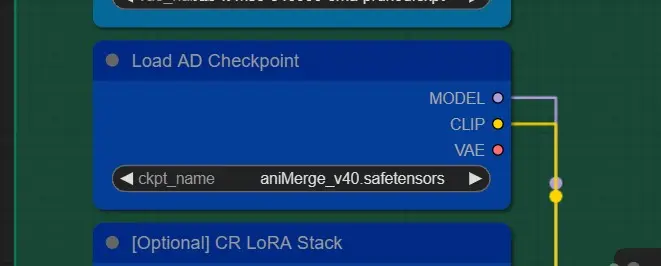

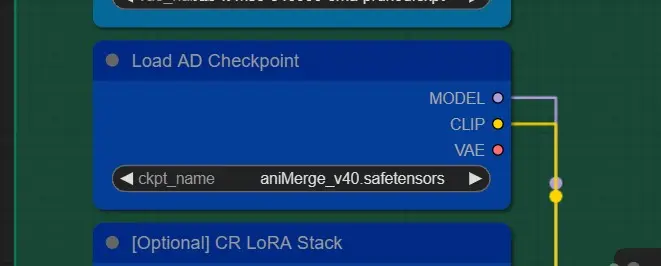

モデルとロラス

- チェックポイント: 正確な結果を得るために任意のリアルなSD 1.5モデルを選択します。スタイリスティックな結果を得るために任意のSD 1.5モデルを選択してください。

- ロラス: [オプション] 必要に応じてリストから任意のロラスを選択してください。フルストレングスで使用しないでください。最良の効果を得るために約0.5-0.7を使用します。

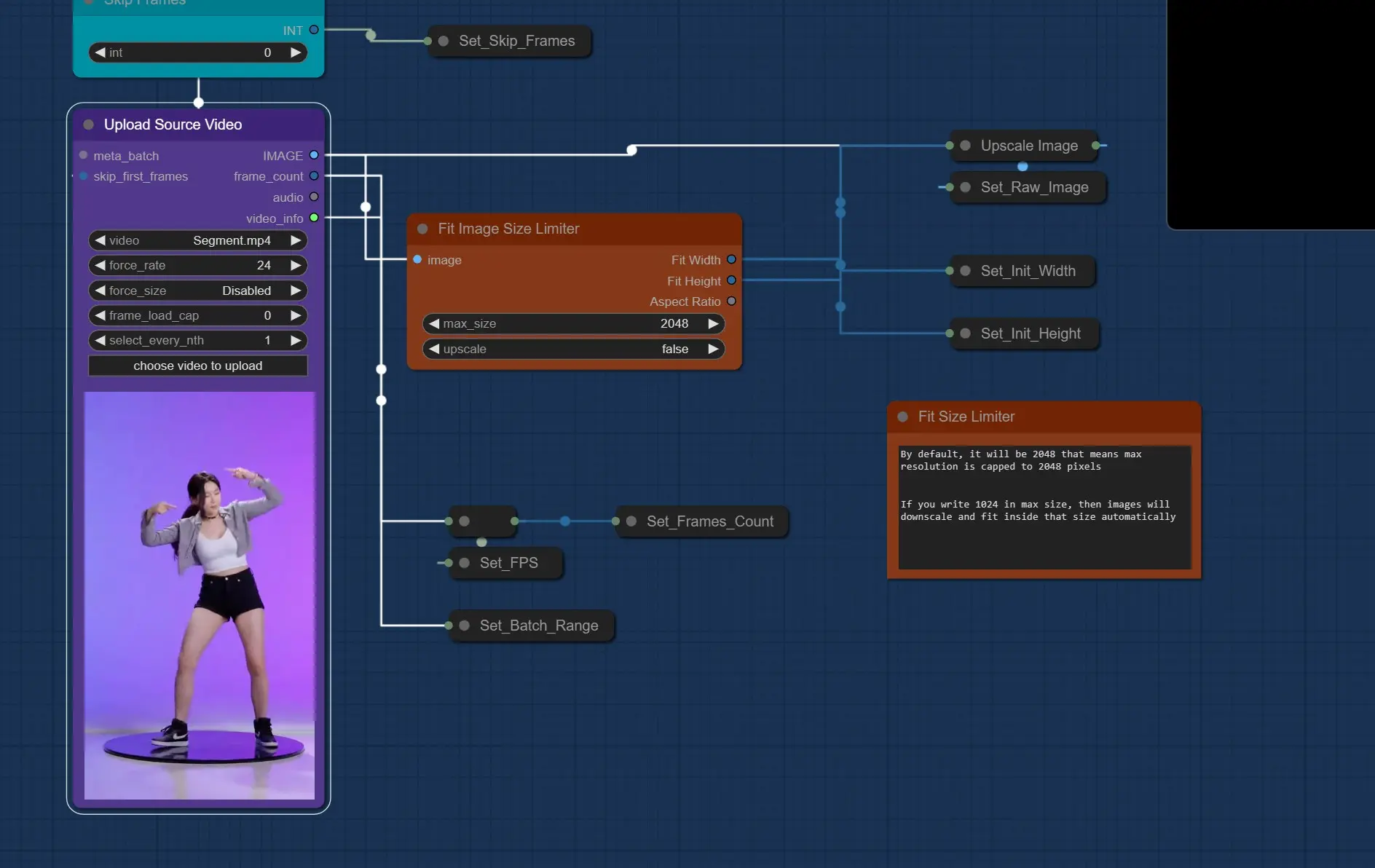

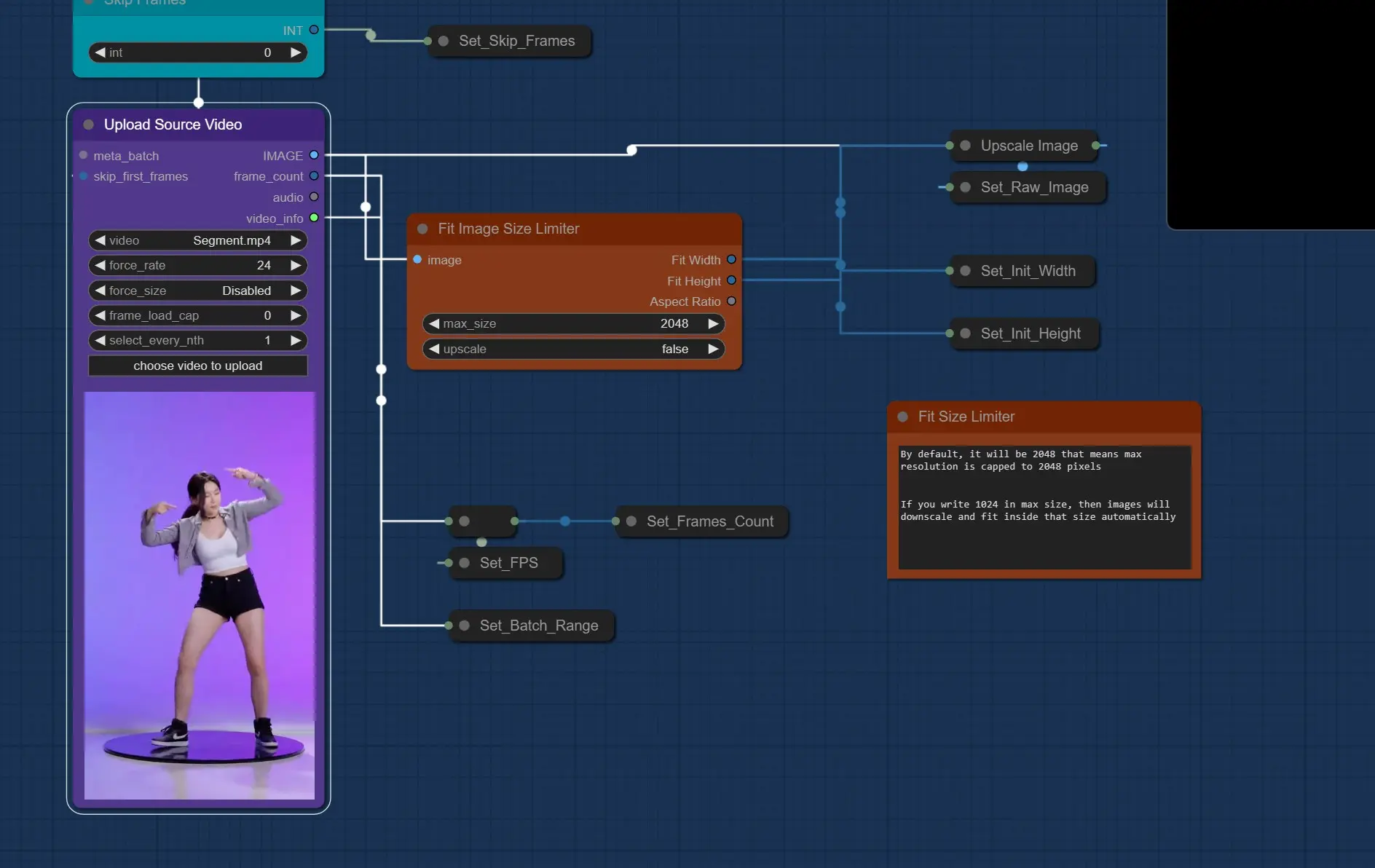

ソースビデオの入力

- ソースビデオのアップロード: ここでクリックして、照明を変更したい人間キャラクターのビデオをアップロードします。

- 100MB未満である必要があります。大きなサイズはアップロードに失敗します。

- 長さは15-20秒以内である必要があります。長いビデオはレンダリングに失敗する可能性があります。

- 720p以下である必要があります。

- スキップフレームノードを使用して、開始フレームをスキップする必要がある場合に使用します。[ライトマップビデオも同じフレームをスキップします]

- 画像サイズリミッターに合わせる: ここでレンダリング解像度を制限します。風景またはポートレートに関係なく、最大解像度は設定値以下になります。

- 800 - 1200の間の値を使用して最良の結果を得ます。[これはVramに影響します]

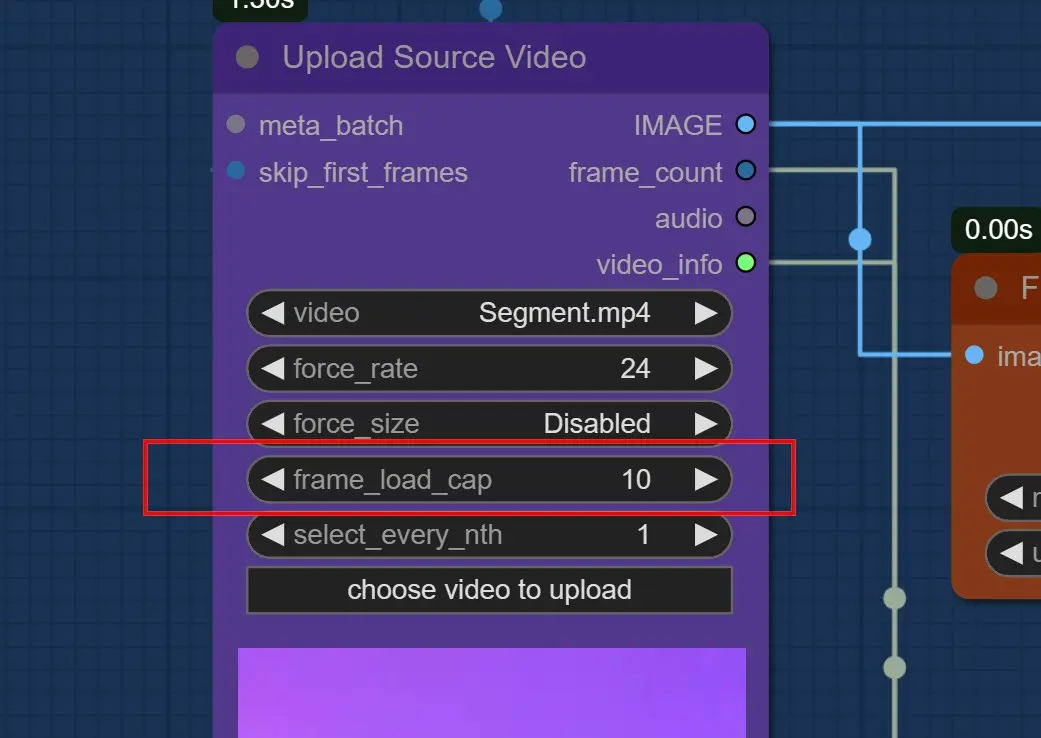

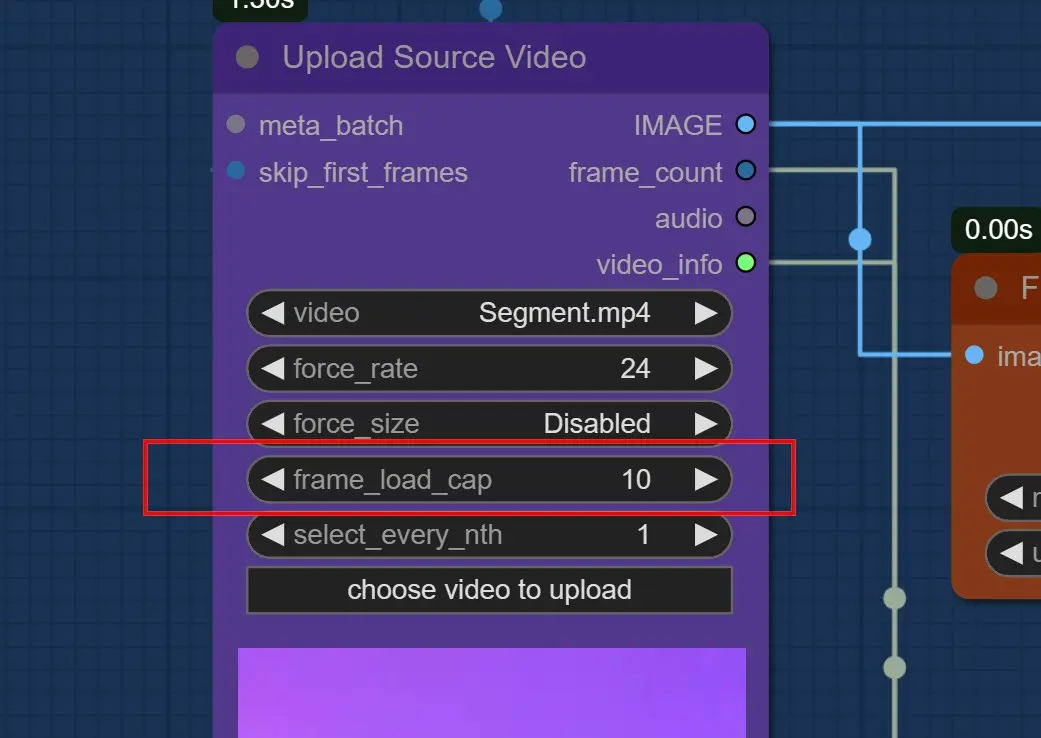

重要: 最初にテストするためにフレームロードキャップを10に設定します。

- 24GBを持っている場合は、1000 - 1200のフィットサイズで約200 - 300フレームを使用します。

- すべてのフレームをレンダリングしたい場合は0を使用します。[長いビデオには推奨されません]

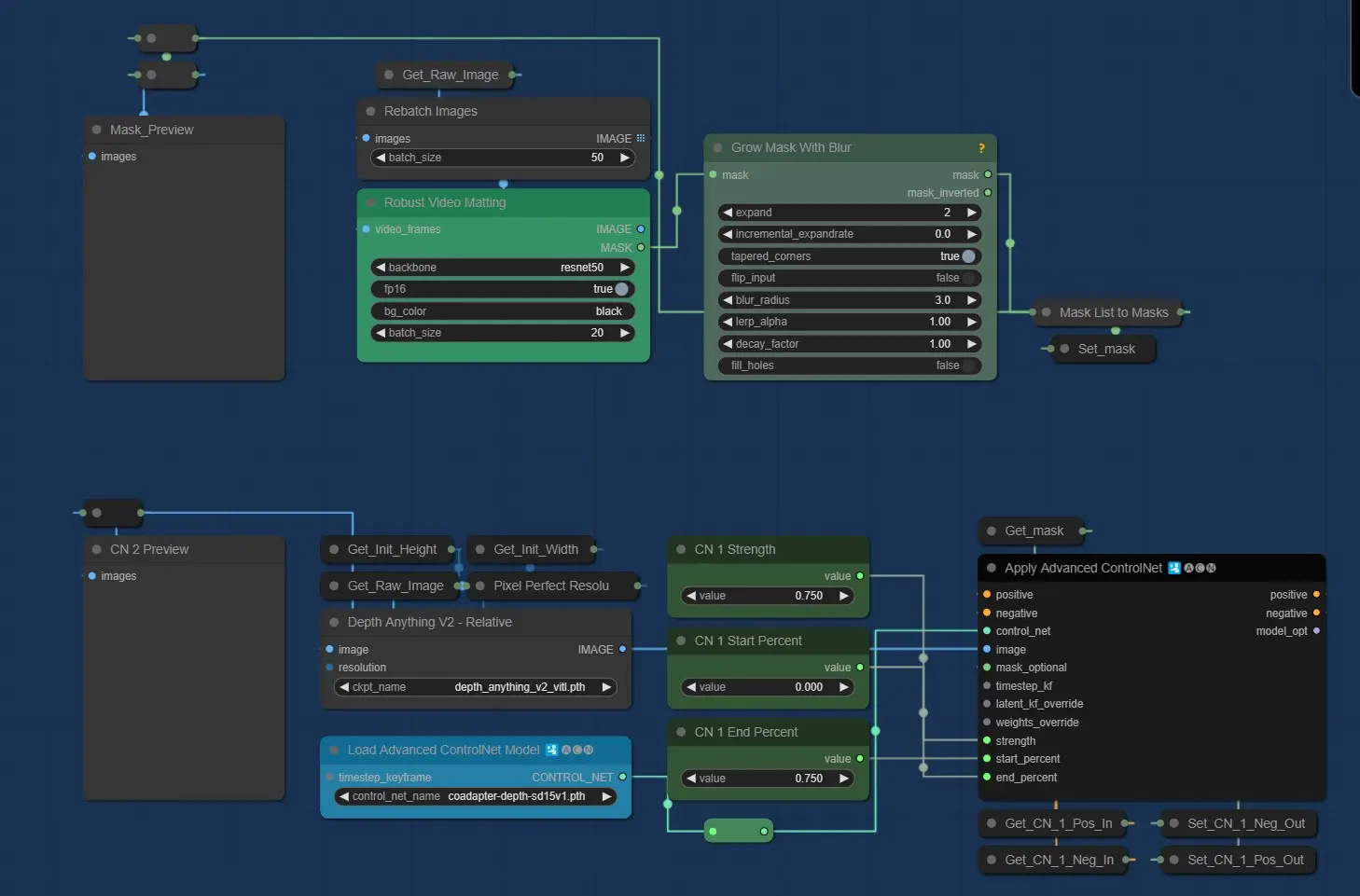

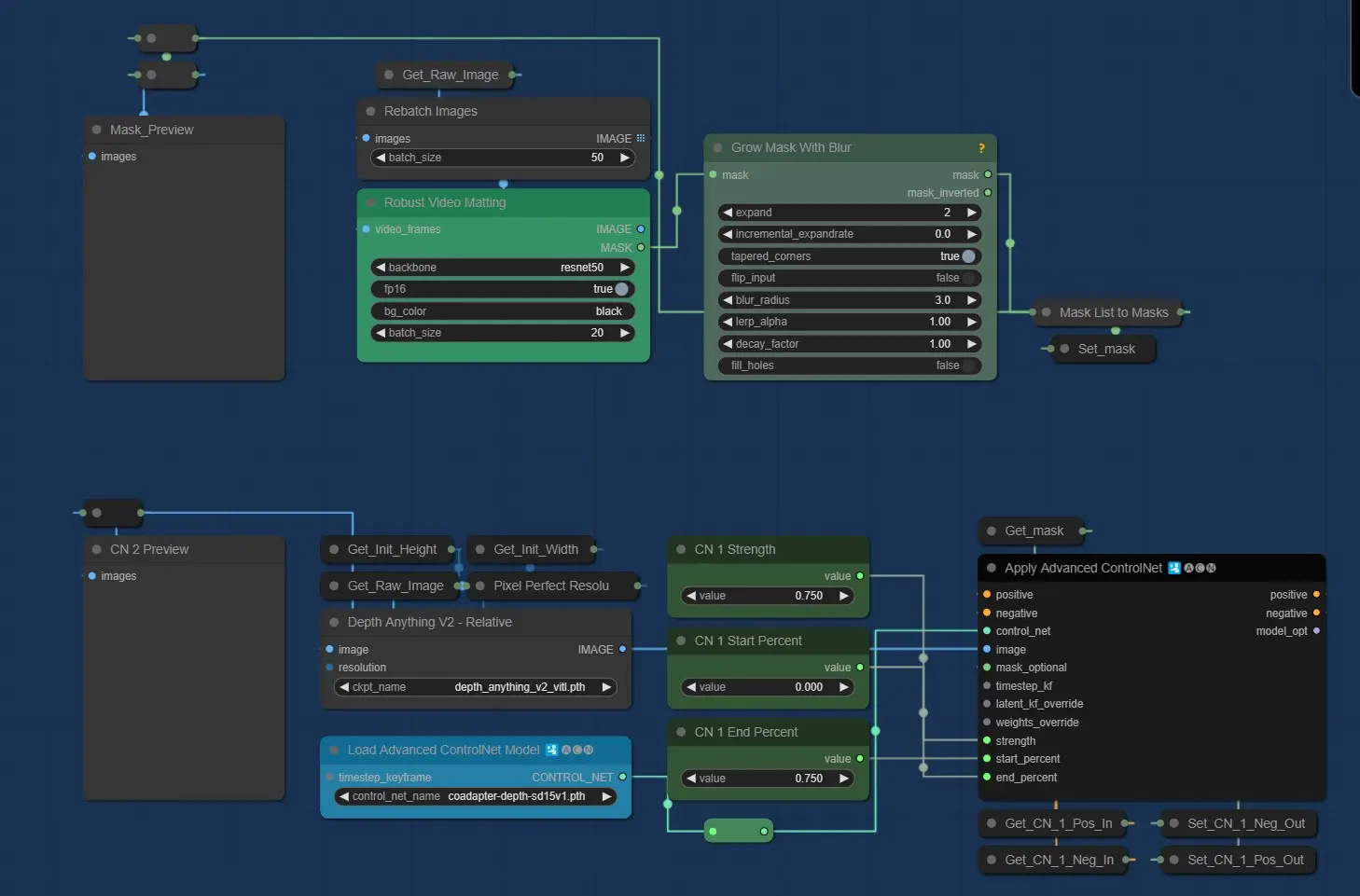

マスクと深度設定

- マスク: Robust Video Mattingを使用します。デフォルト設定で問題ありません。

- Depth ControlNet: 最新のDepthAnything v2モデルを使用します。

- 強度と終了パーセントは最適な結果を得るために75%に設定されています。

- 最良の結果を得るためにAdaptor Depthを使用します。

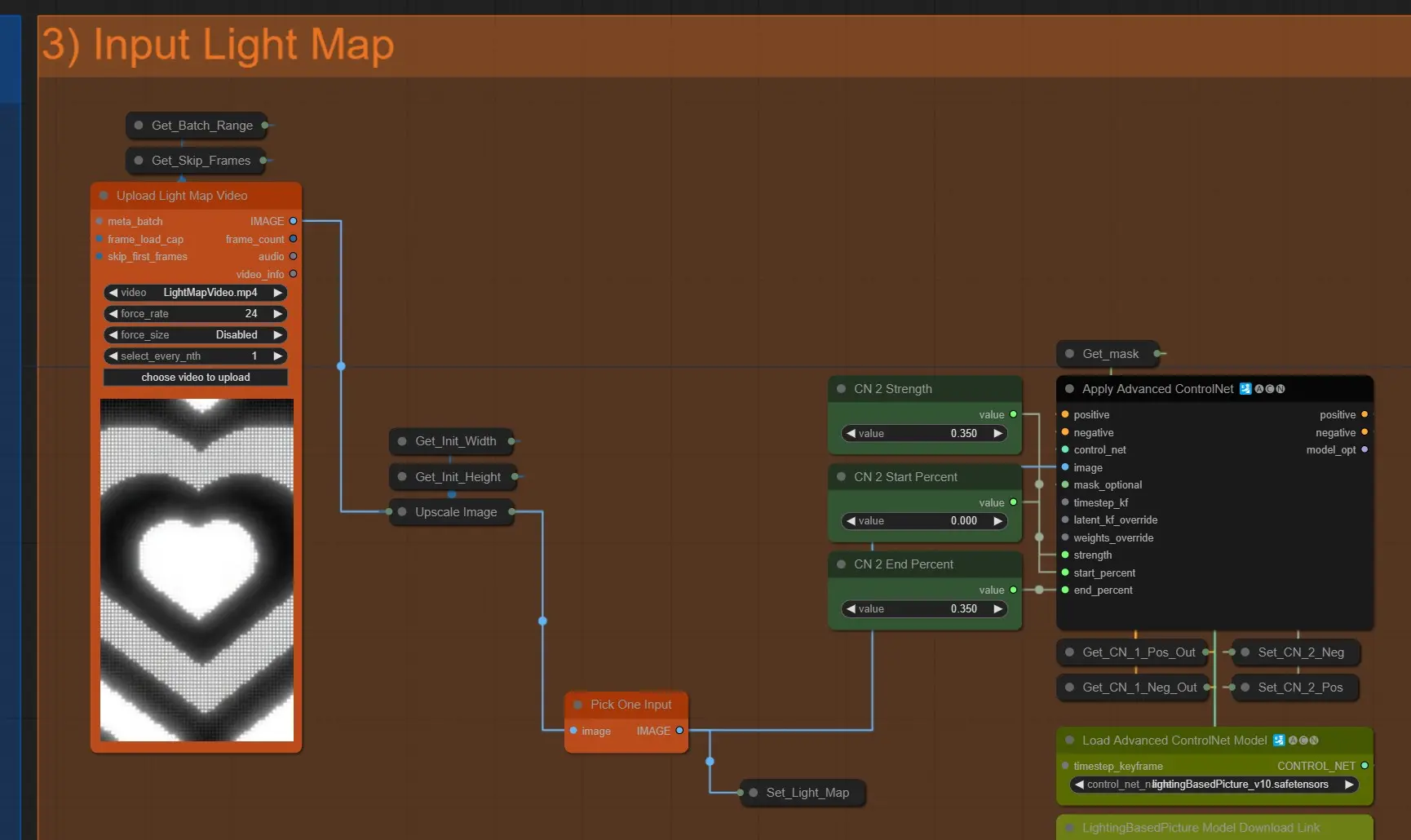

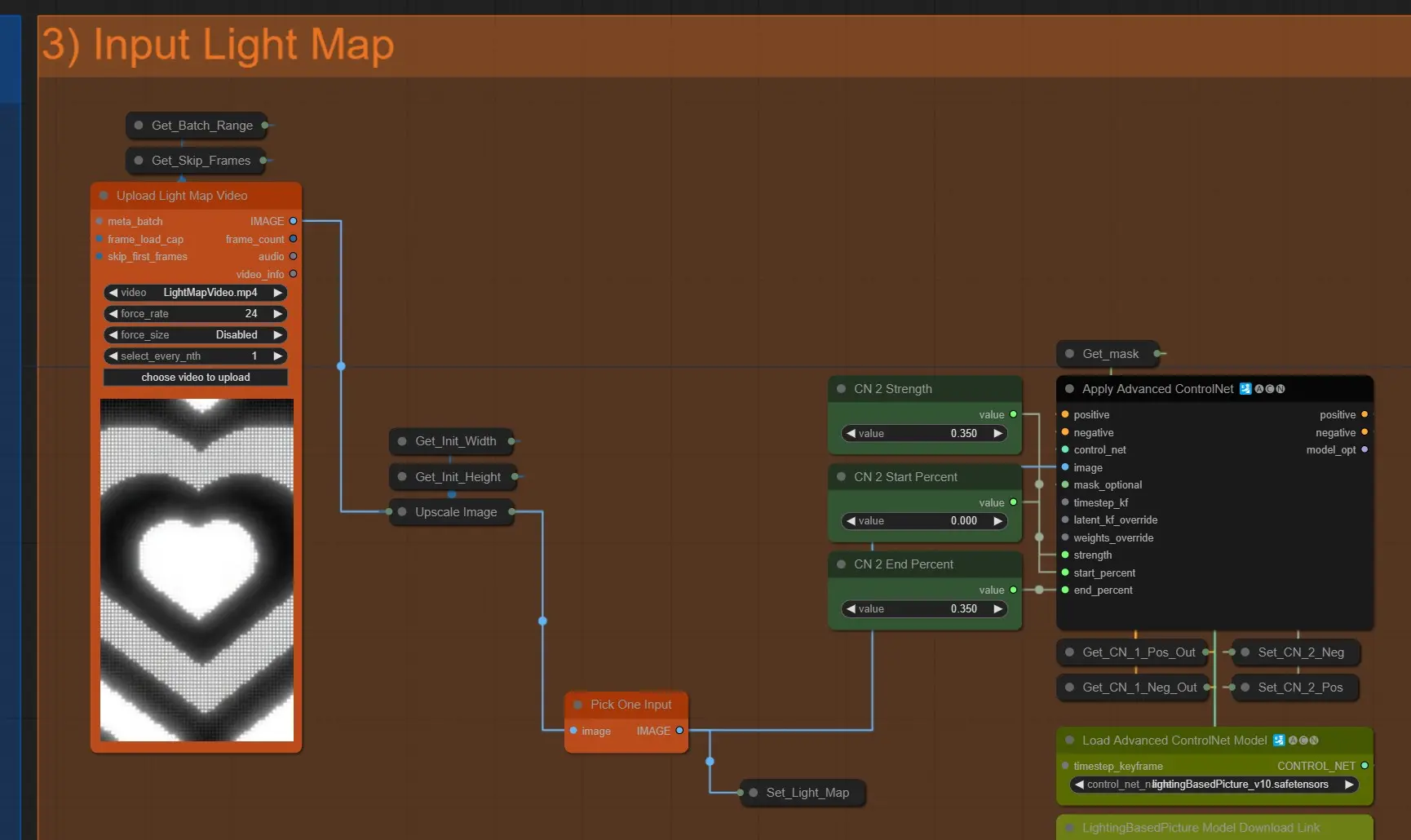

ライトマップ

- ライトマップのアップロード: クリックして希望のライトマップビデオをアップロードします。

- ソースビデオの寸法に自動的にスケールされます。

- ソースビデオの寸法と同じかそれ以上であることを確認してください。そうしないとエラーが発生します。

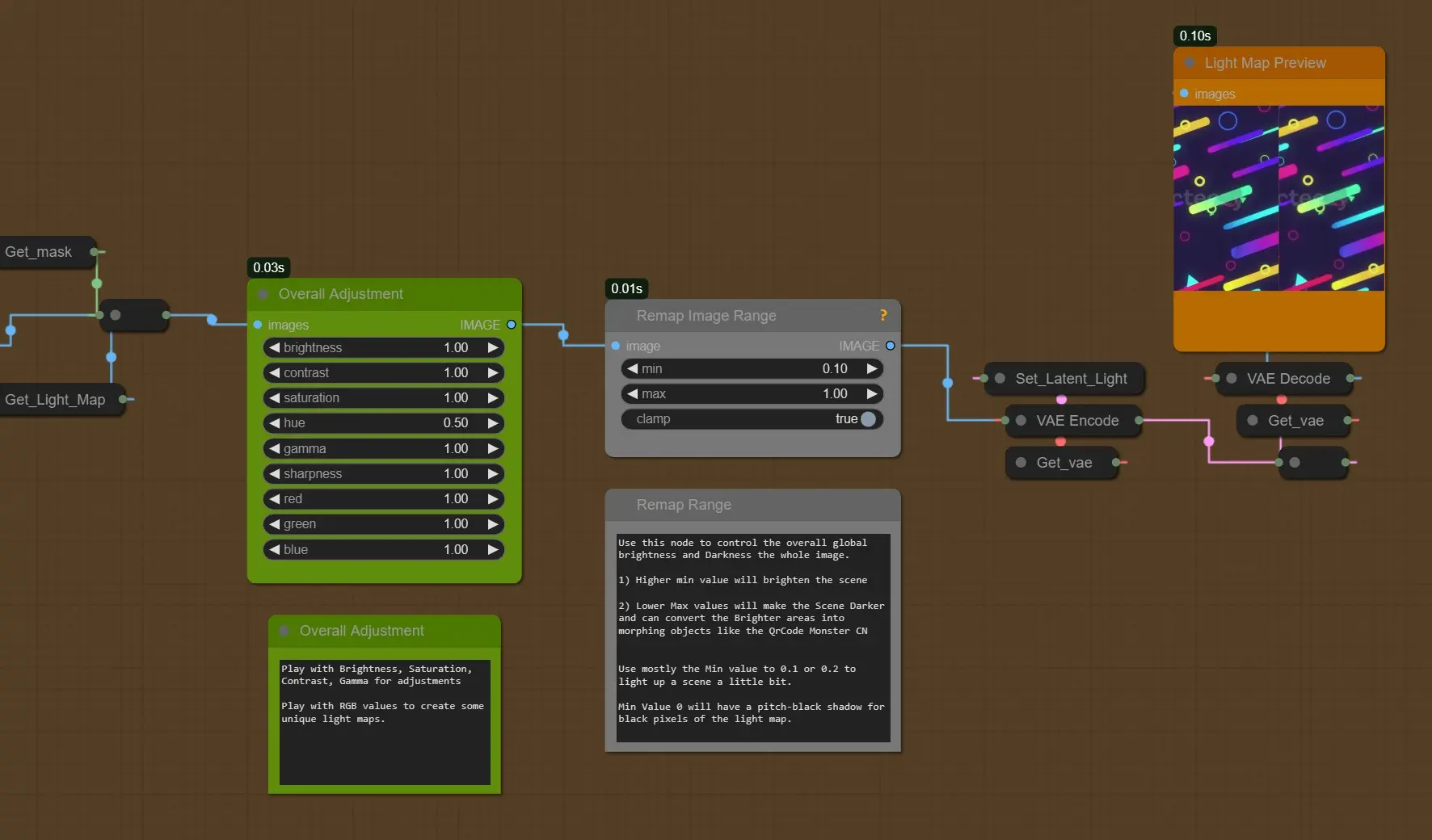

- ライトマップControlNet: このライトマップはこのモデルを使用してライトControlNetとしても使用されます。

- CN強度と終了パーセント: ここでは低い値を使用します。高い値は過剰露光や急激な光の変化を引き起こす可能性があります。

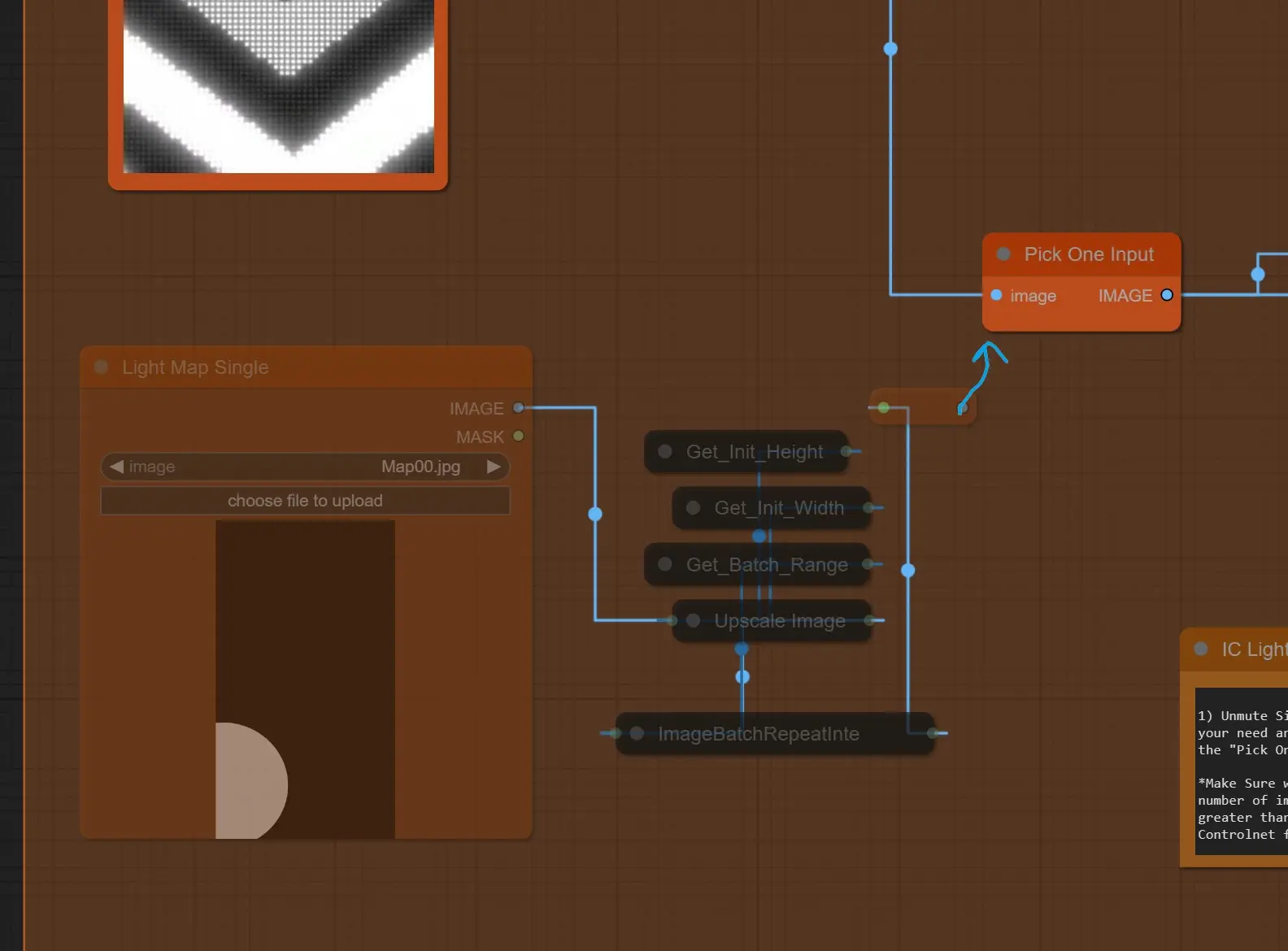

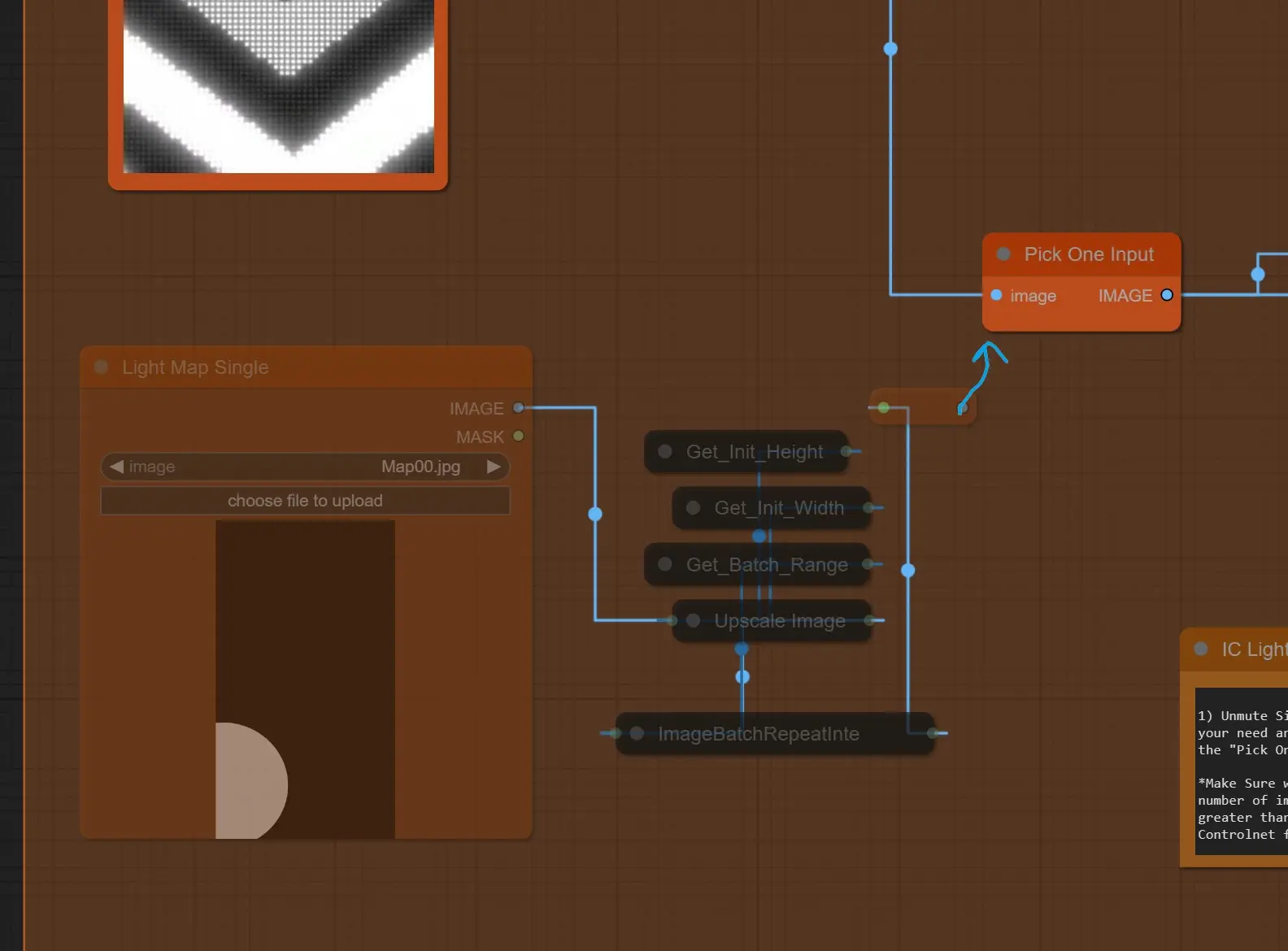

単一のライトマップ

- 単一の画像をライトマップとして使用するには、これらのノードをミュート解除し、リルートノードを「Pick one Input」ノードに接続します。

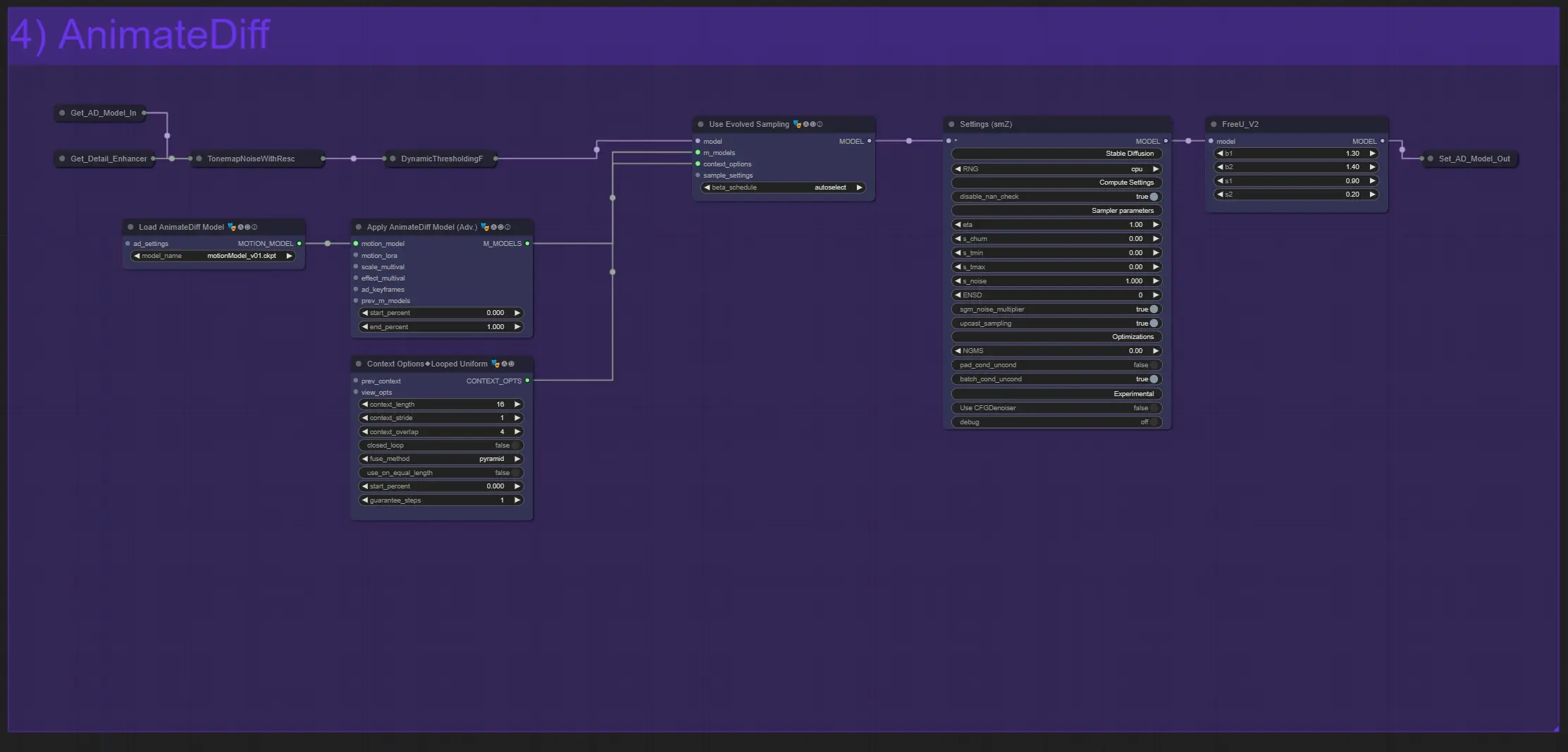

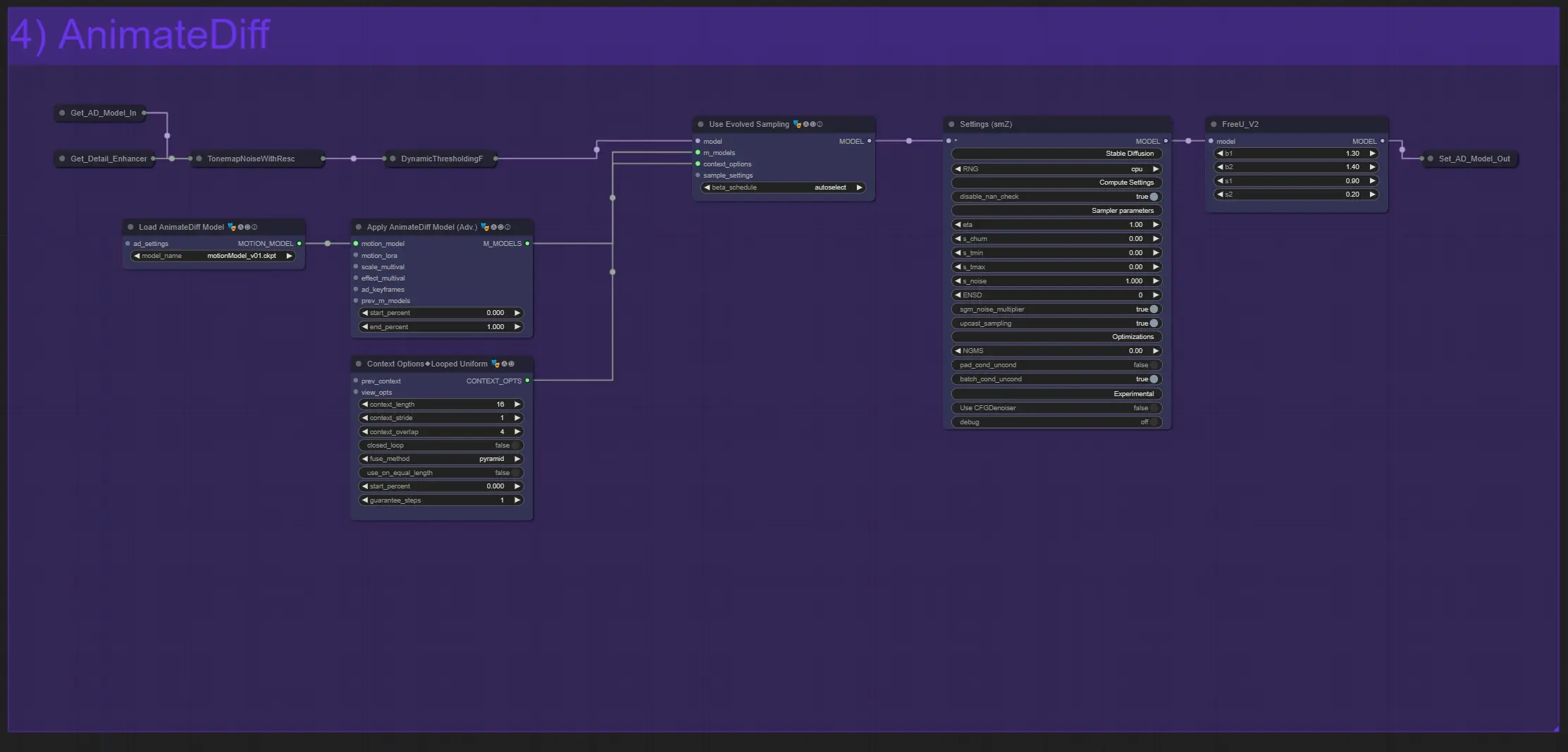

AnimateDiff

- Animatediffモデルの読み込み: 異なる効果のために任意のモデルを使用できます。

- Animatediffその他のノード: 他の設定を変更するためにAnimatediffの知識が必要です。[詳細はこちらで確認できます]

- Settings SMZ: モデルパイプラインの品質を向上させるためのノードで、すべての設定はうまく機能するように事前定義されています。

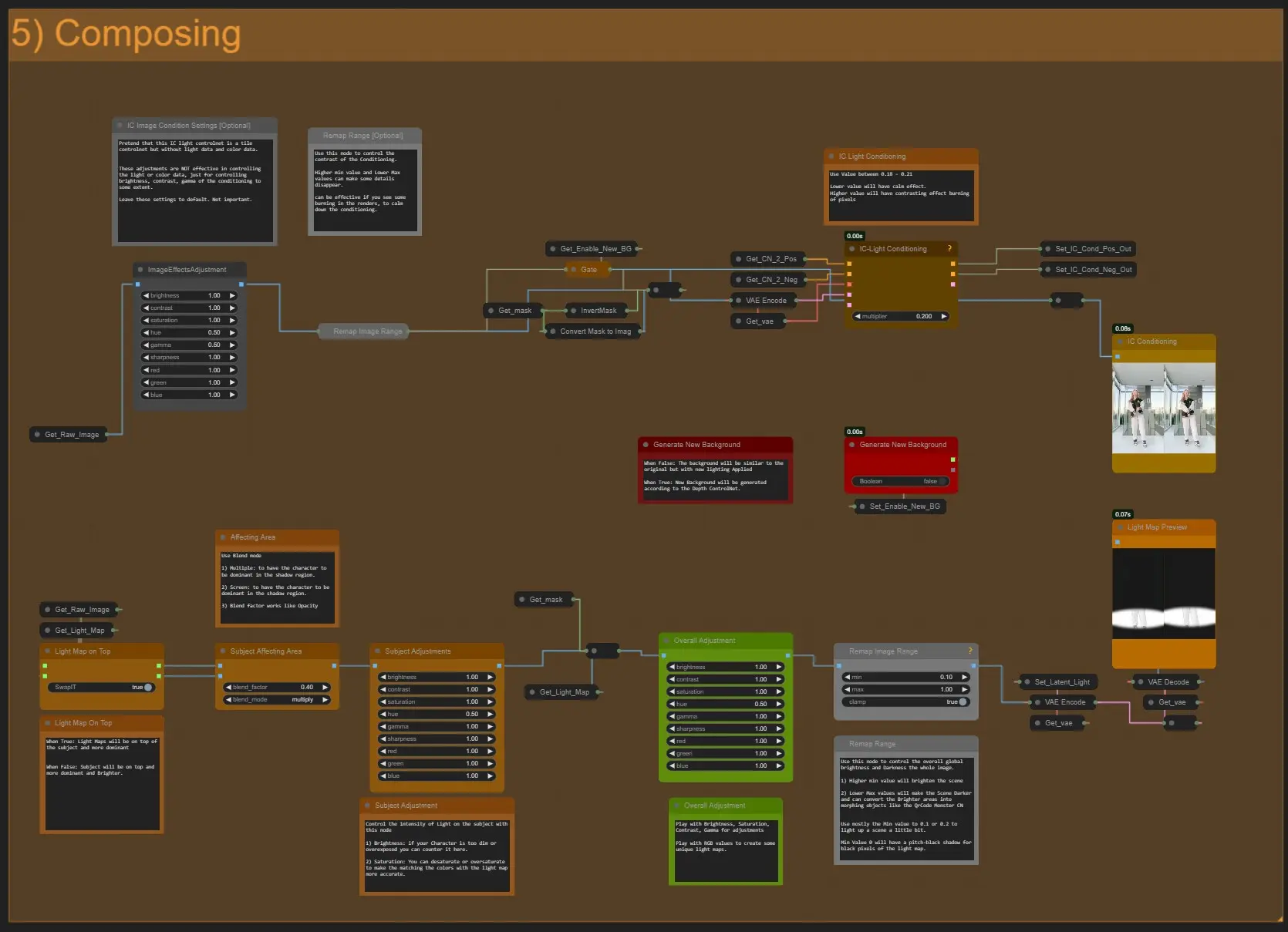

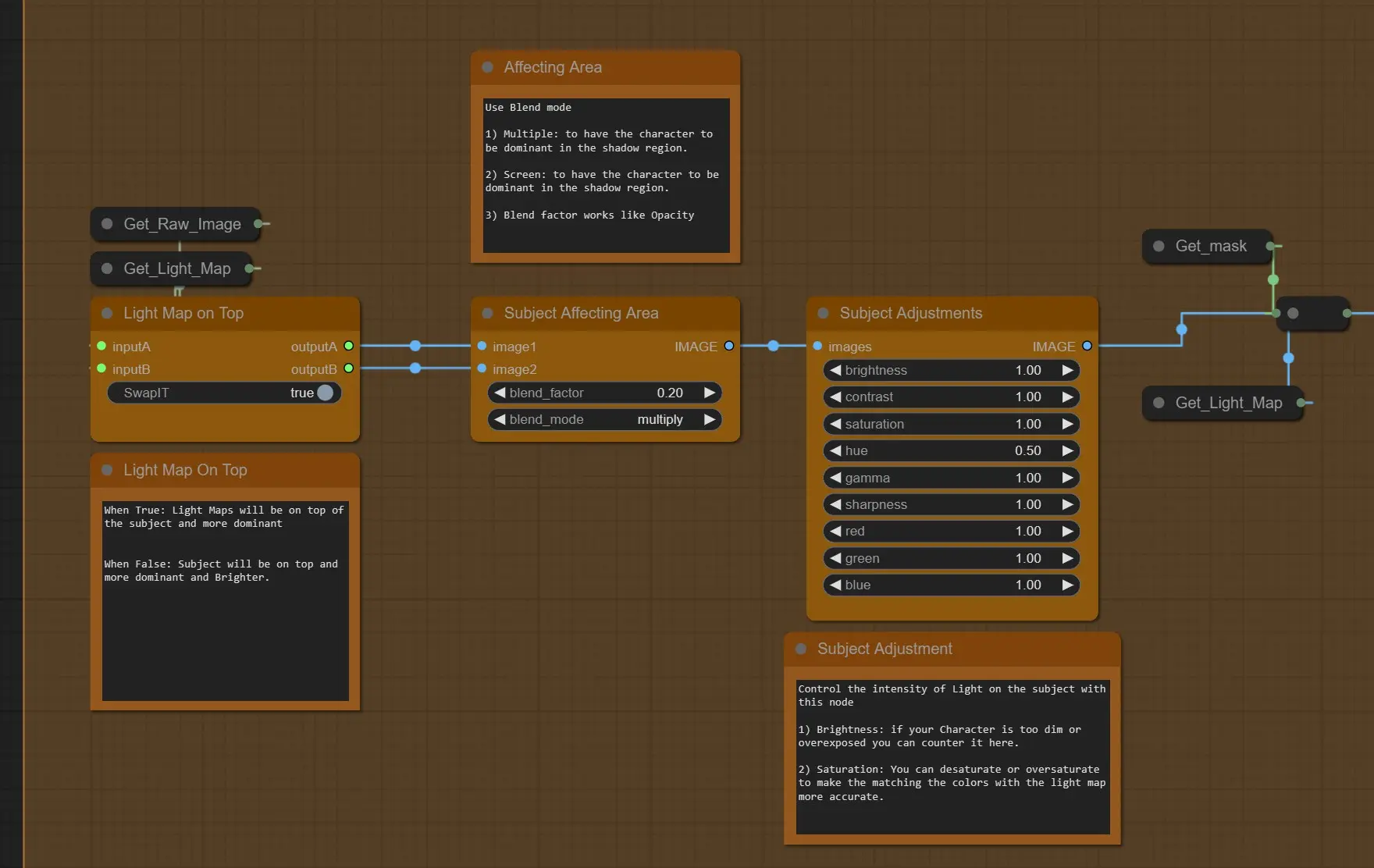

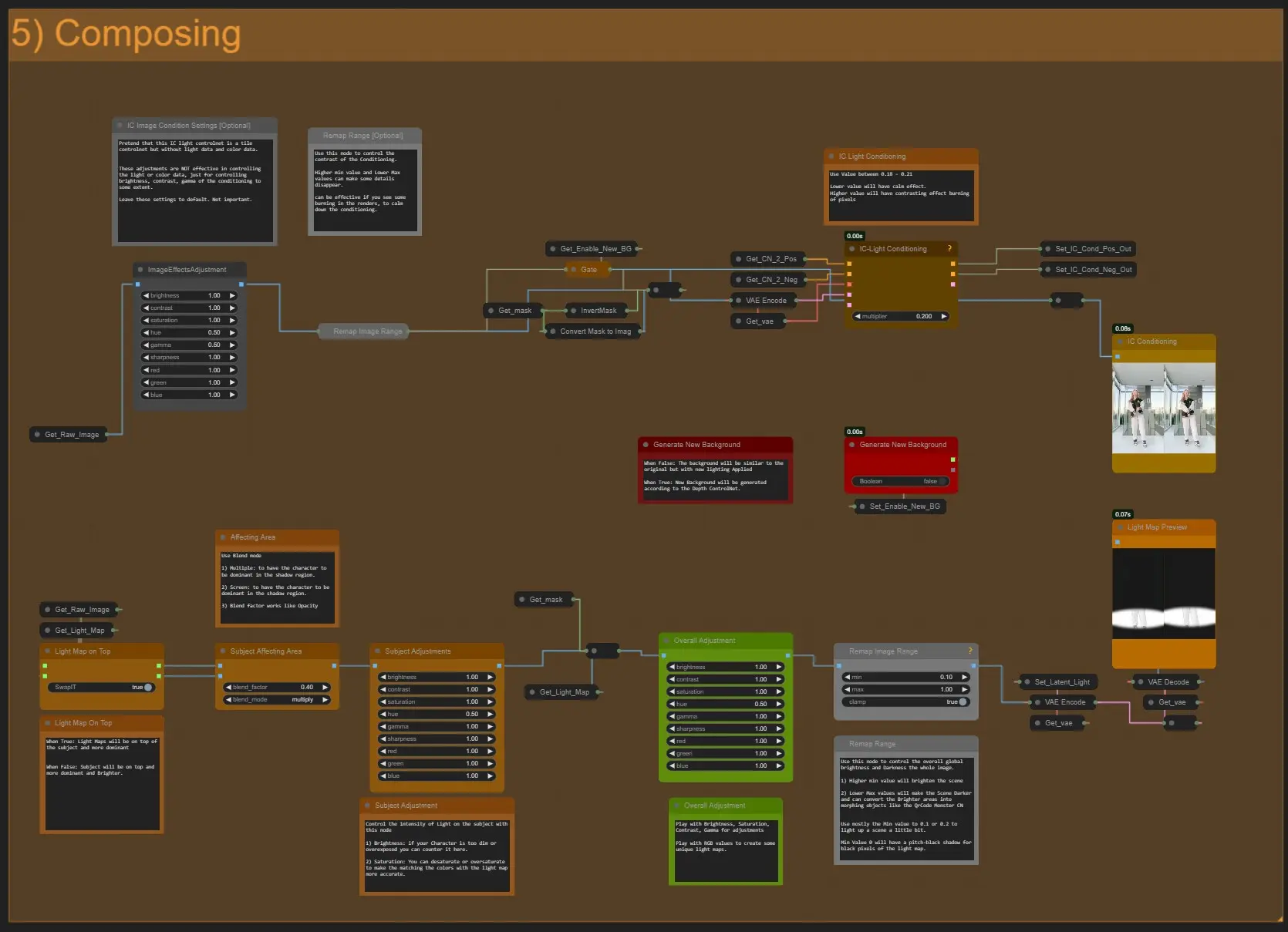

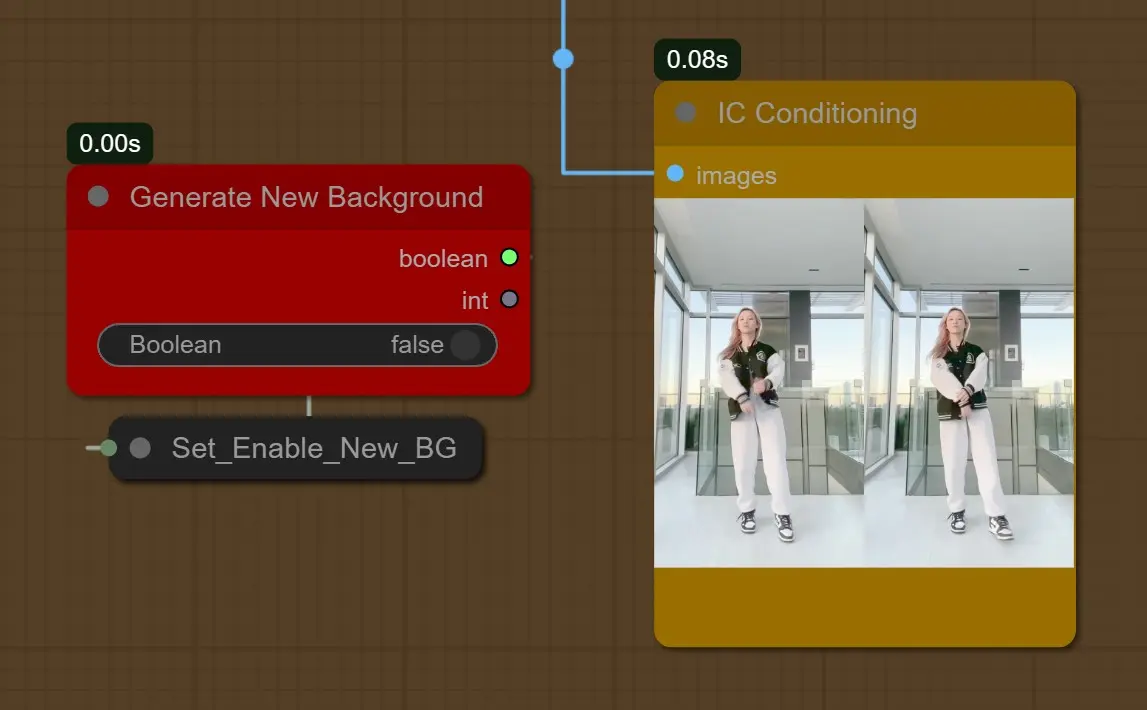

ライトマップとICコンディショニングの合成

- 上記のトップ調整ノード(グレー色)は、IC-Lightコンディショニングのコントラストを低くし、明るさを制御するためにあります。

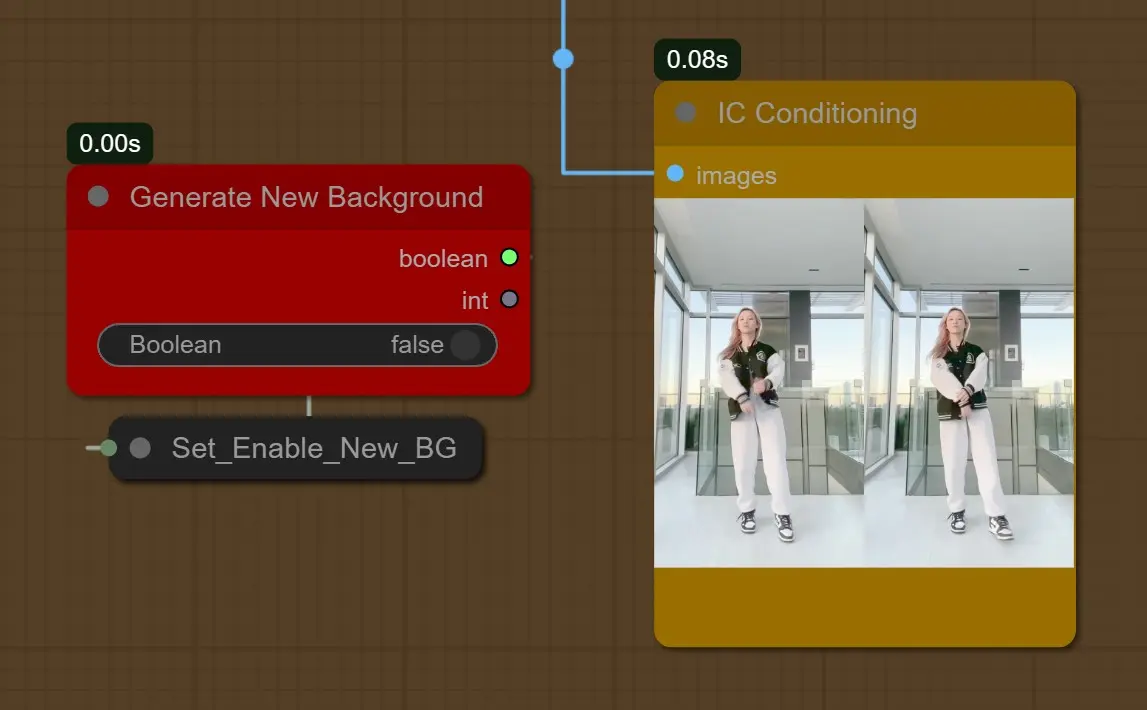

- 新しい背景の生成: 無効にすると、元の画像入力を使用し、「ポジティブプロンプトボックス」に「背景プロンプト」が存在する場合、それに応じてソースビデオの背景に似た詳細をマッピングしようとします。

[1girl, sunlight, sunset, white shirt, black short jeans, interior, room]

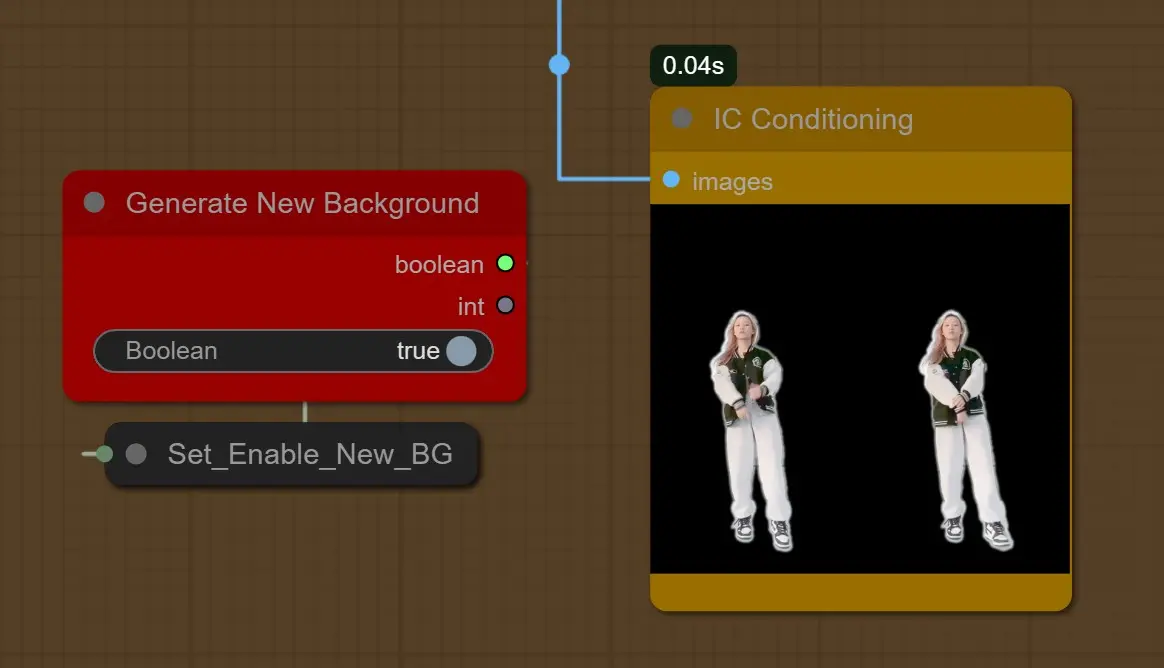

- 新しい背景の生成が有効な場合: 深度を考慮して新しい背景を生成します。

[1girl, sunlight, sunset, nature in the background, sky]

また、Depth ControlNetの強度と終了パーセントは45%に減少し、背景に開放的なエリアができました。

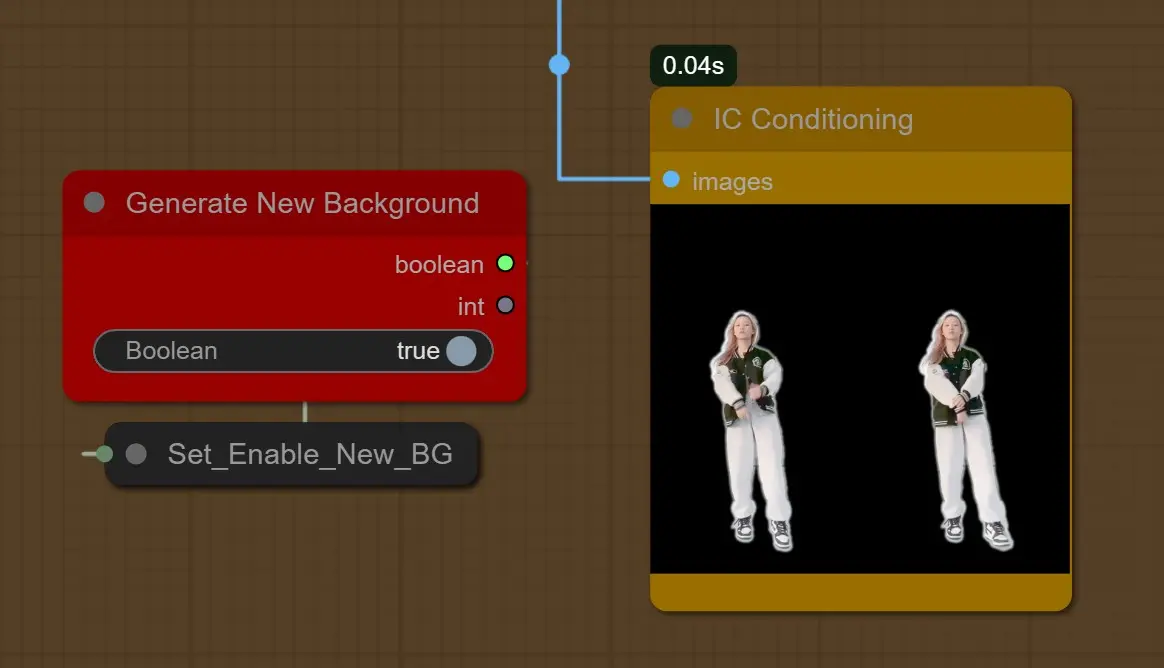

- ライトマップが上に: Trueの場合、ライトマップがソースビデオの上にあり、より支配的になります。Falseの場合、ソースが上にあり、より支配的で明るくなります。

- サブジェクト影響領域: 2つのブレンディングモードが最適です。

- 乗算: ライトマップが上または下にあるかに応じて、影の領域を暗くします。

- スクリーン: ライトマップが上または下にあるかに応じて、影の領域を明るくします。

- ブレンドファクターは強度のためのものです。

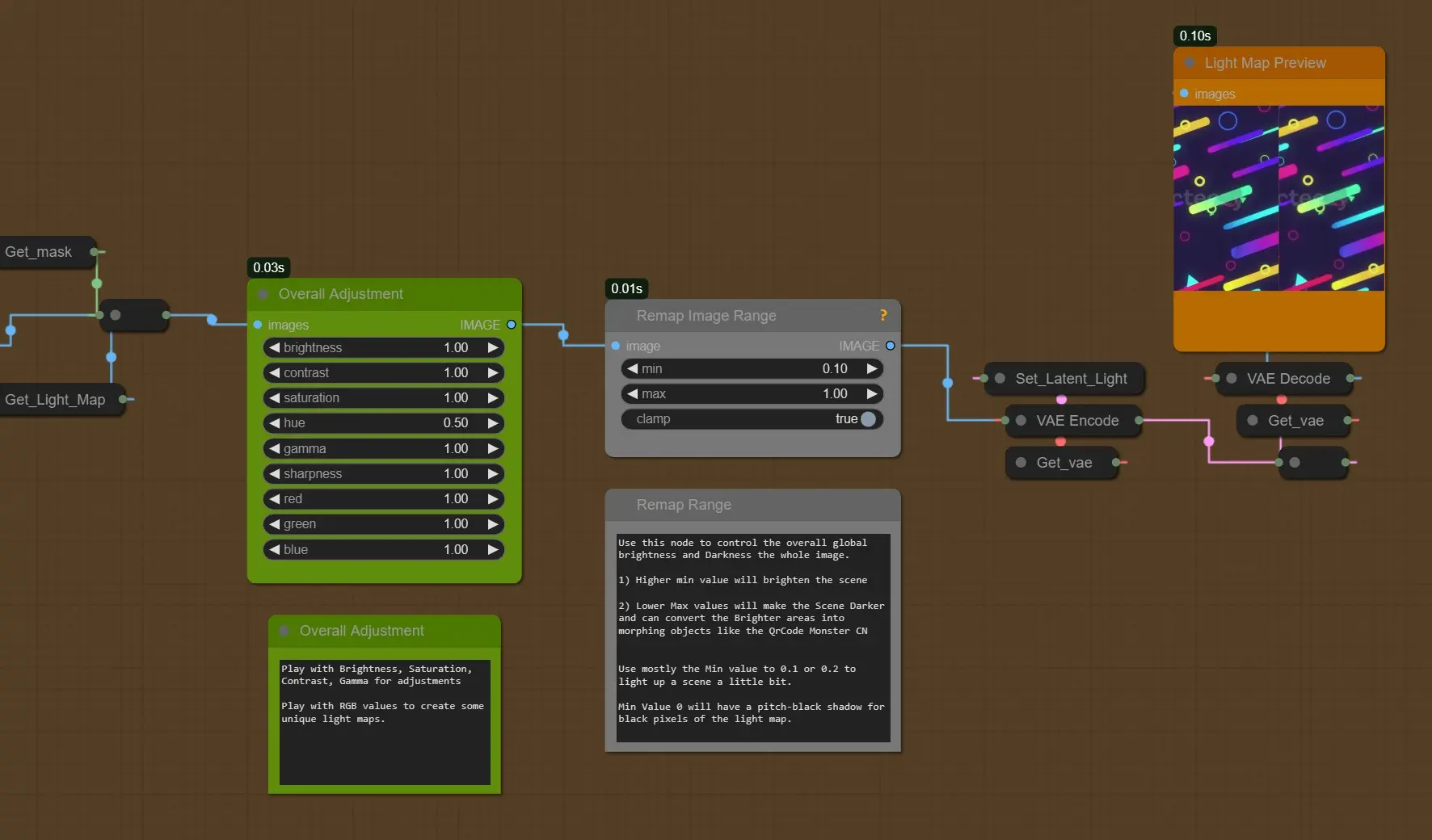

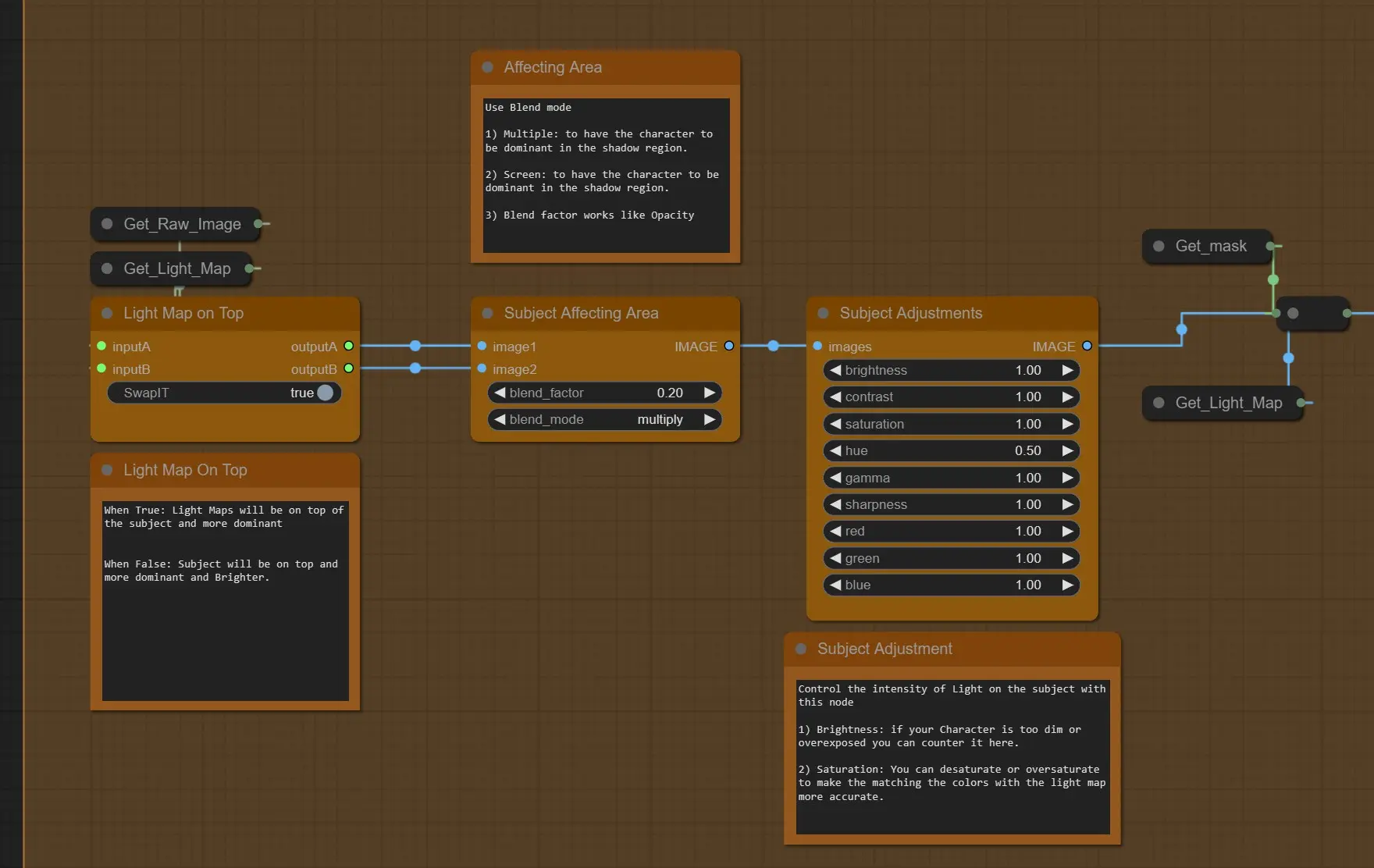

- 全体的な調整: 上記の最終処理されたライトマップの明るさ、コントラスト、ガンマ、ティントを制御します。

- 画像リマップ: このノードを使用して、全体的なグローバルな明るさと暗さを制御します。

- 高い最小値はシーンを明るくします。

- 低い最大値はシーンを暗くし、明るい領域をQRコードモンスターCNのように変換できます。

- シーンを少し明るくするために、最小値を0.1または0.2にすることが多いです。

- 最小値0は、ライトマップの黒いピクセルに対して真っ黒な影を持ちます。

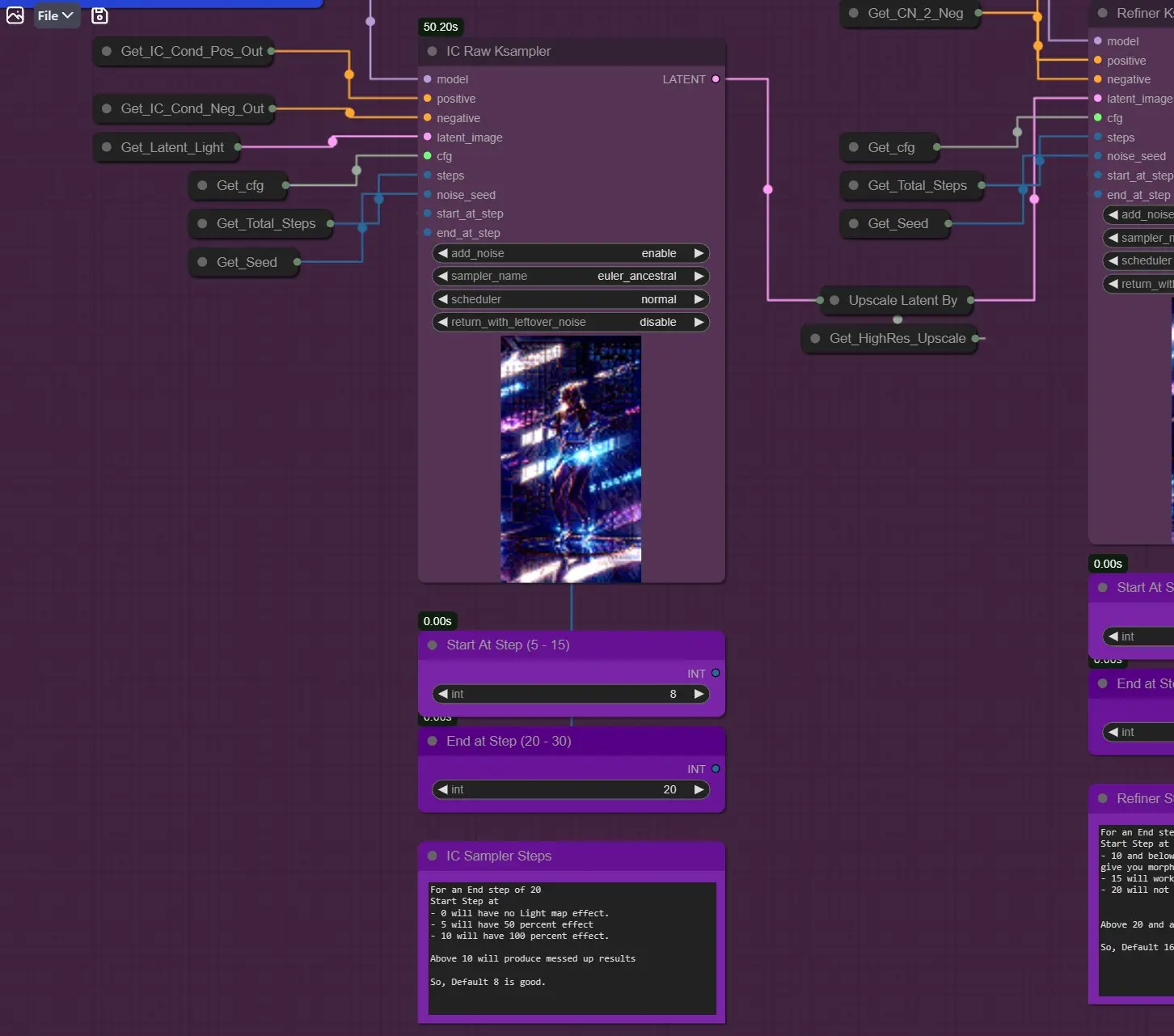

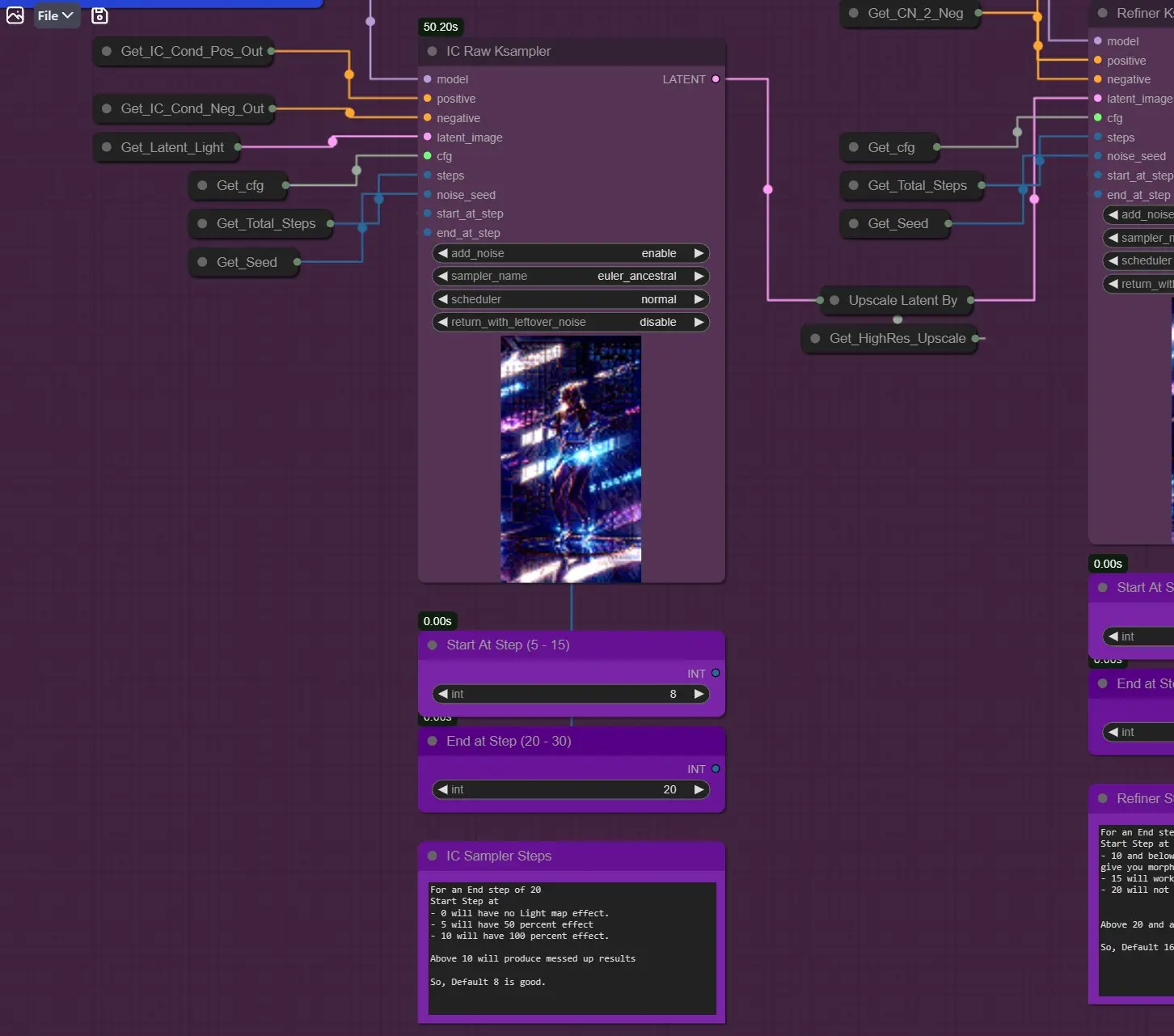

KSamplers (Raw and Refine)

IC Raw Ksampler: 他のサンプラーとは異なり、IC-Lightコンディションのためにステップ8から開始します(フレームは8ステップ目からデノイズされます)。

- 例えば、終了ステップが20の場合

- 開始ステップは

- 0ではライトマップ効果がありません。

- 5では50%の効果があります。

- 10では100%の効果があります。

- したがって、3-8の間が良い値です。

新しい背景を生成する場合、5以下でより良い結果が得られます。

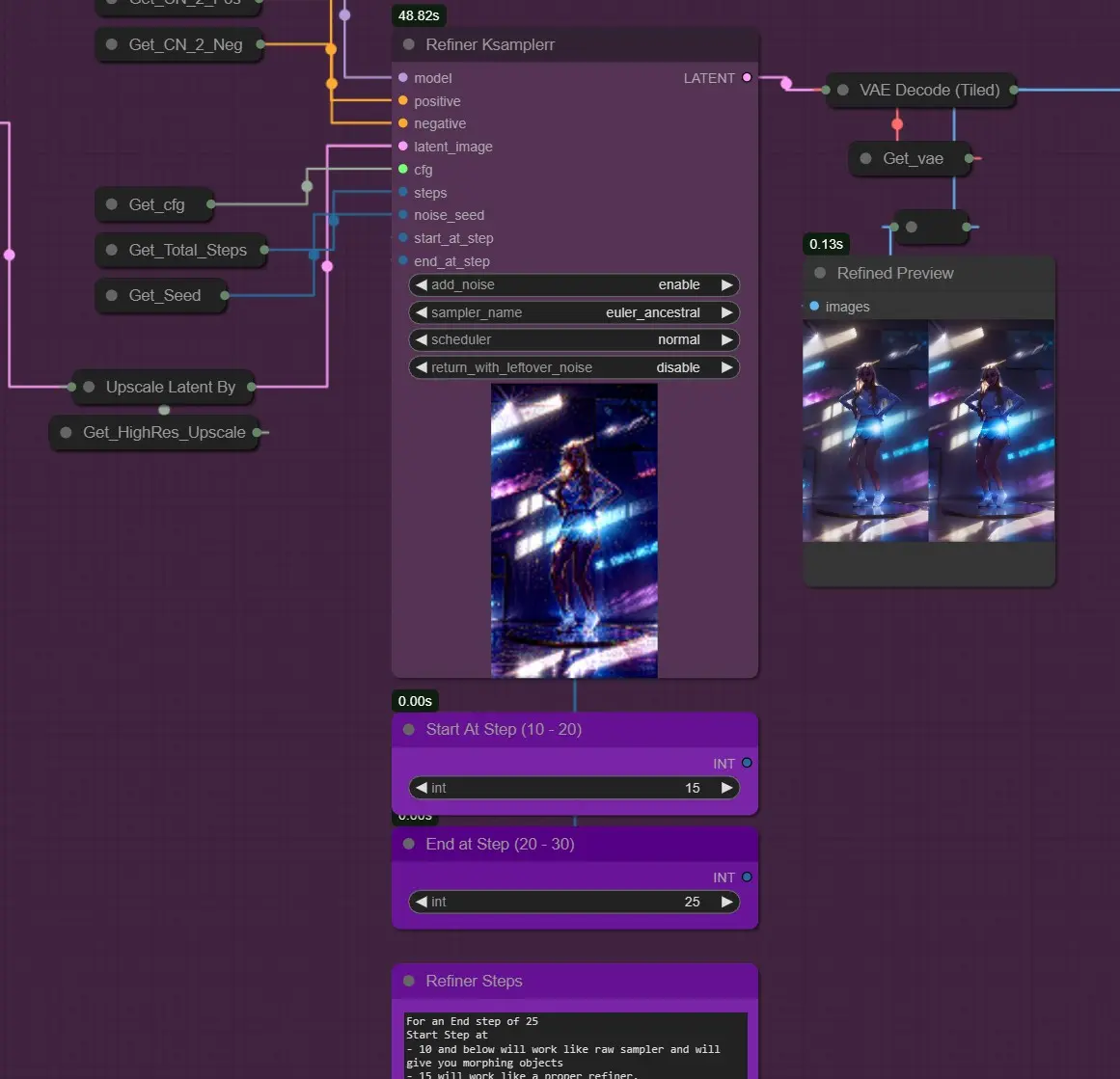

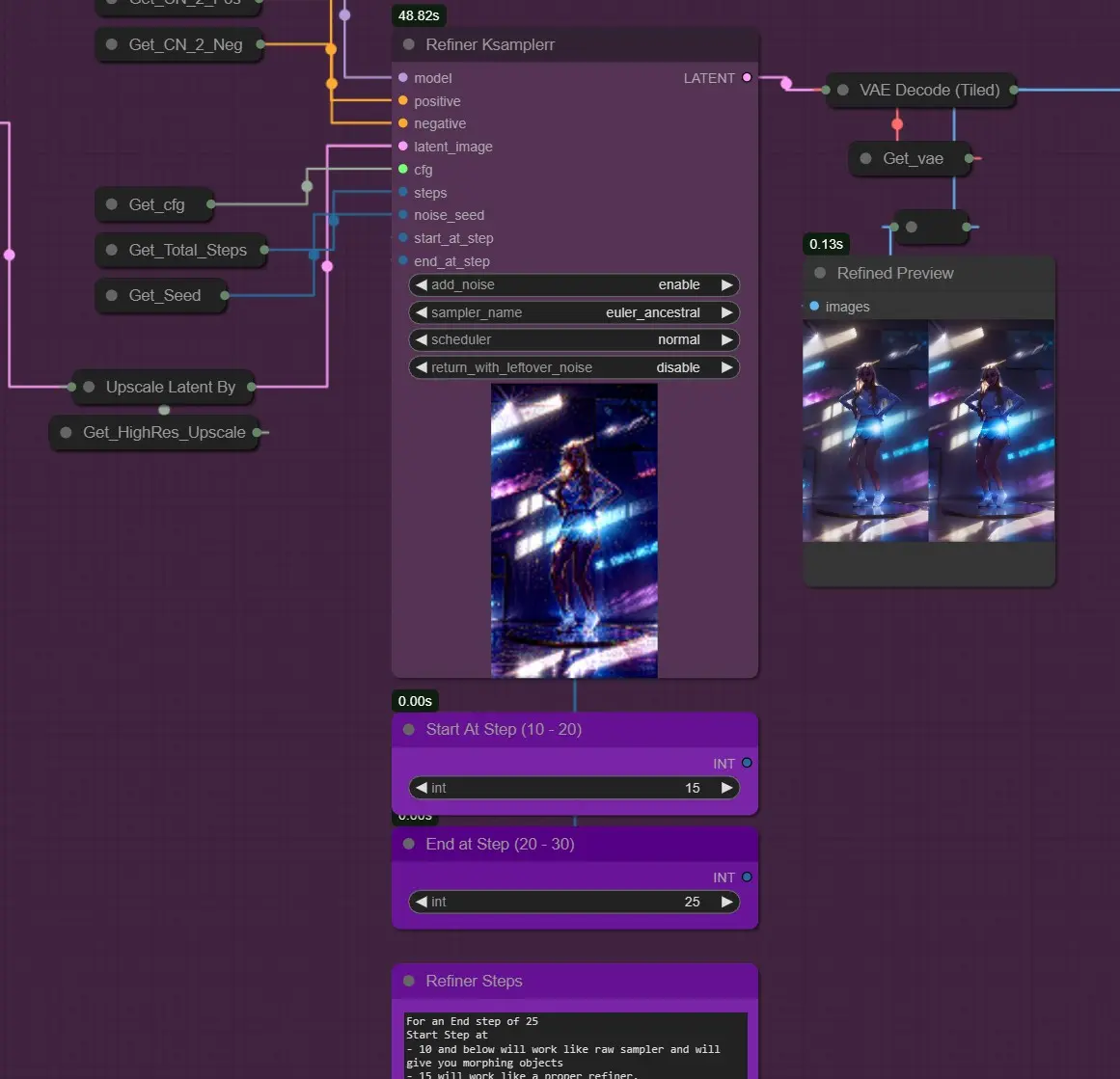

- Ksampler Refine: IC Raw Samplerの後にImg2Img Refinerのように機能します。

終了ステップが25の場合

- 開始ステップは

- 10以下ではRaw Samplerのように機能し、モーフィングオブジェクトを生成します。

- 15では適切なRefinerのように機能します。

- 20では適切に機能しません。

- 20以上では混乱した結果を生成します。

- したがって、デフォルトの16が良いです。

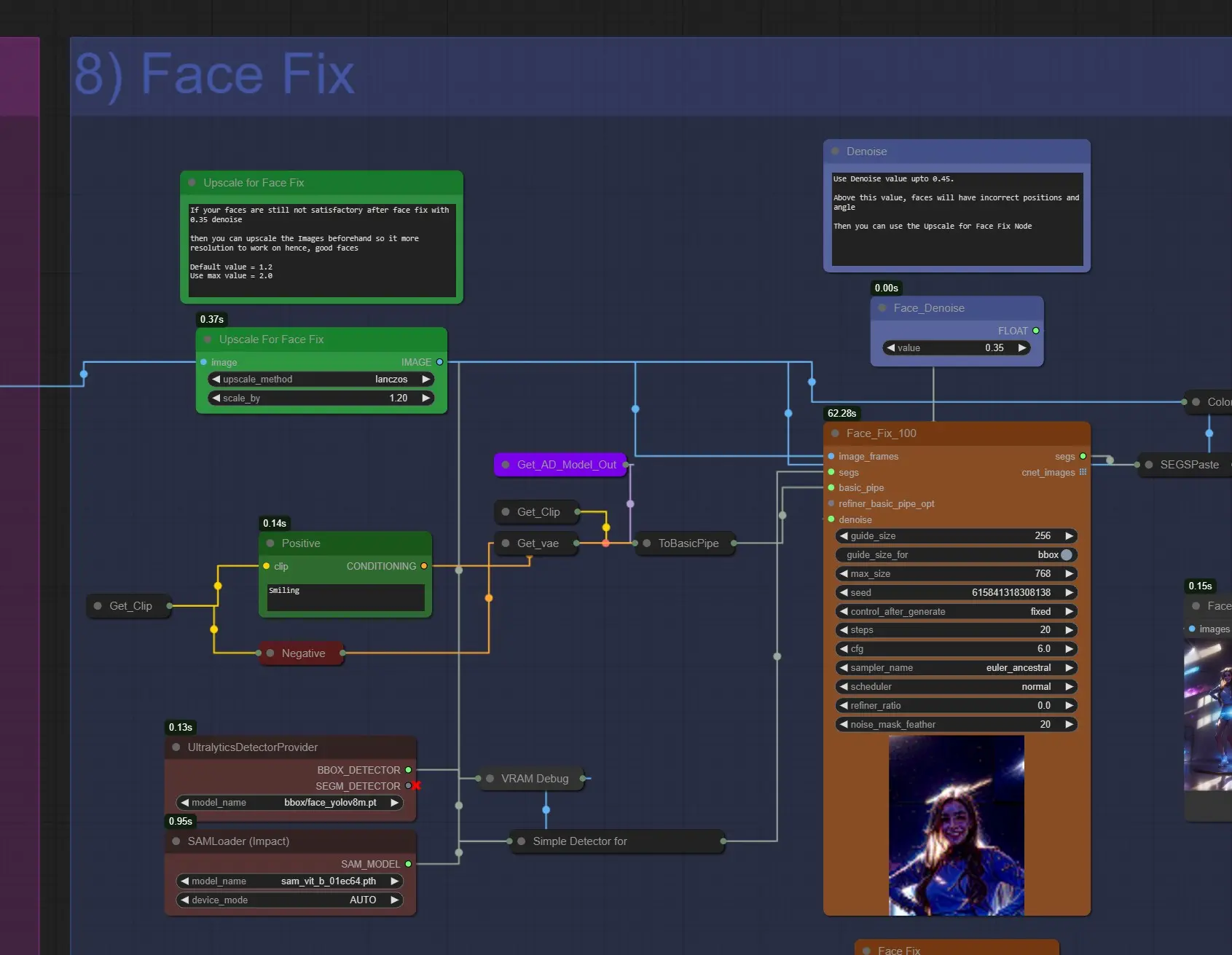

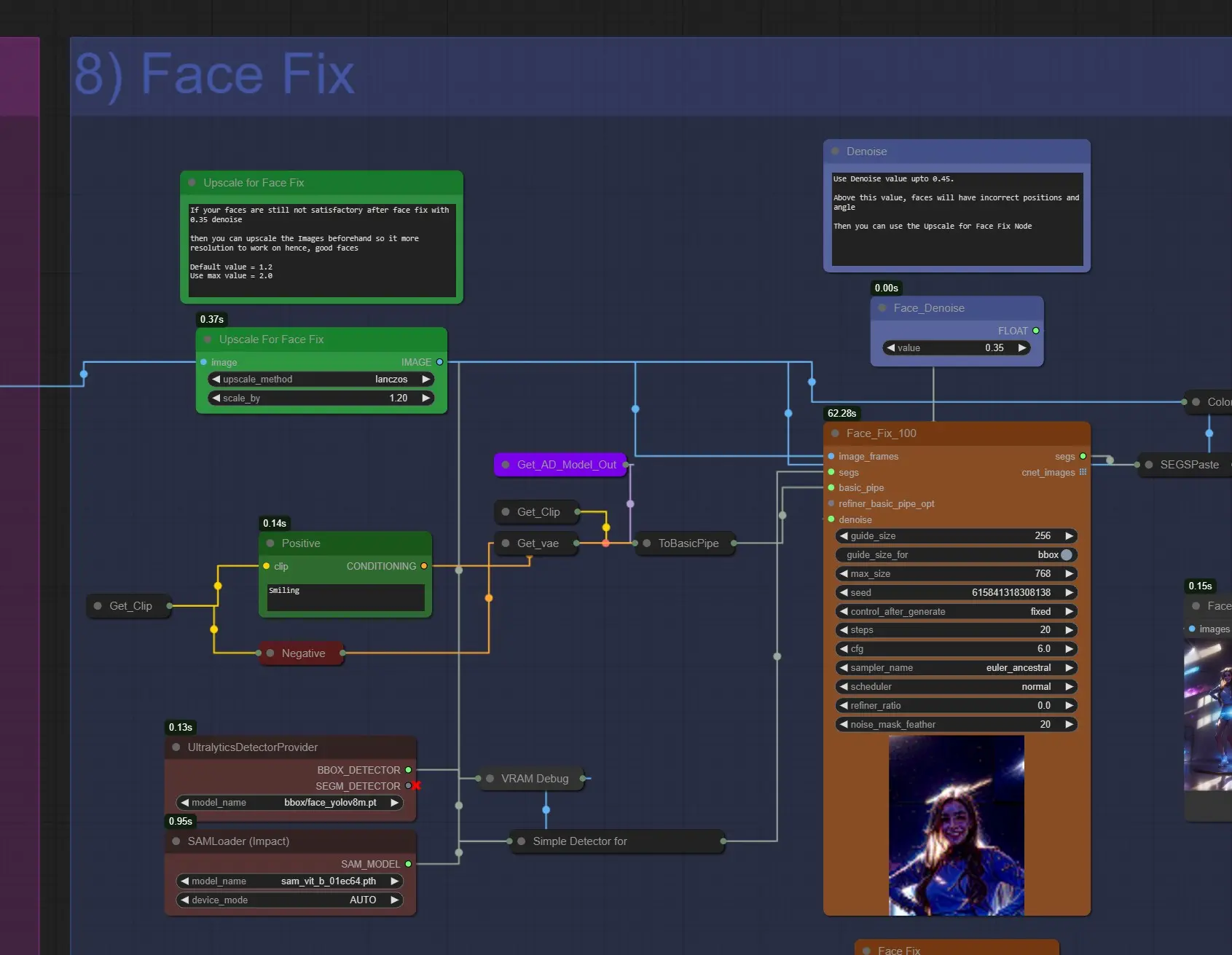

顔の修正

- 顔の修正のためのアップスケール: 顔の修正後に満足できない場合、1.2から1.6にアップスケールしてより良い顔を得ることができます。

- ポジティブプロンプト: ここに顔のプロンプトを書きます。デフォルトでは「smiling」に設定されています。変更できます。

- 顔のデノイズ: 約0.35から0.45を使用します。高すぎると顔が正しくレンダリングされず、スライディングフェイスの問題が発生する可能性があります。

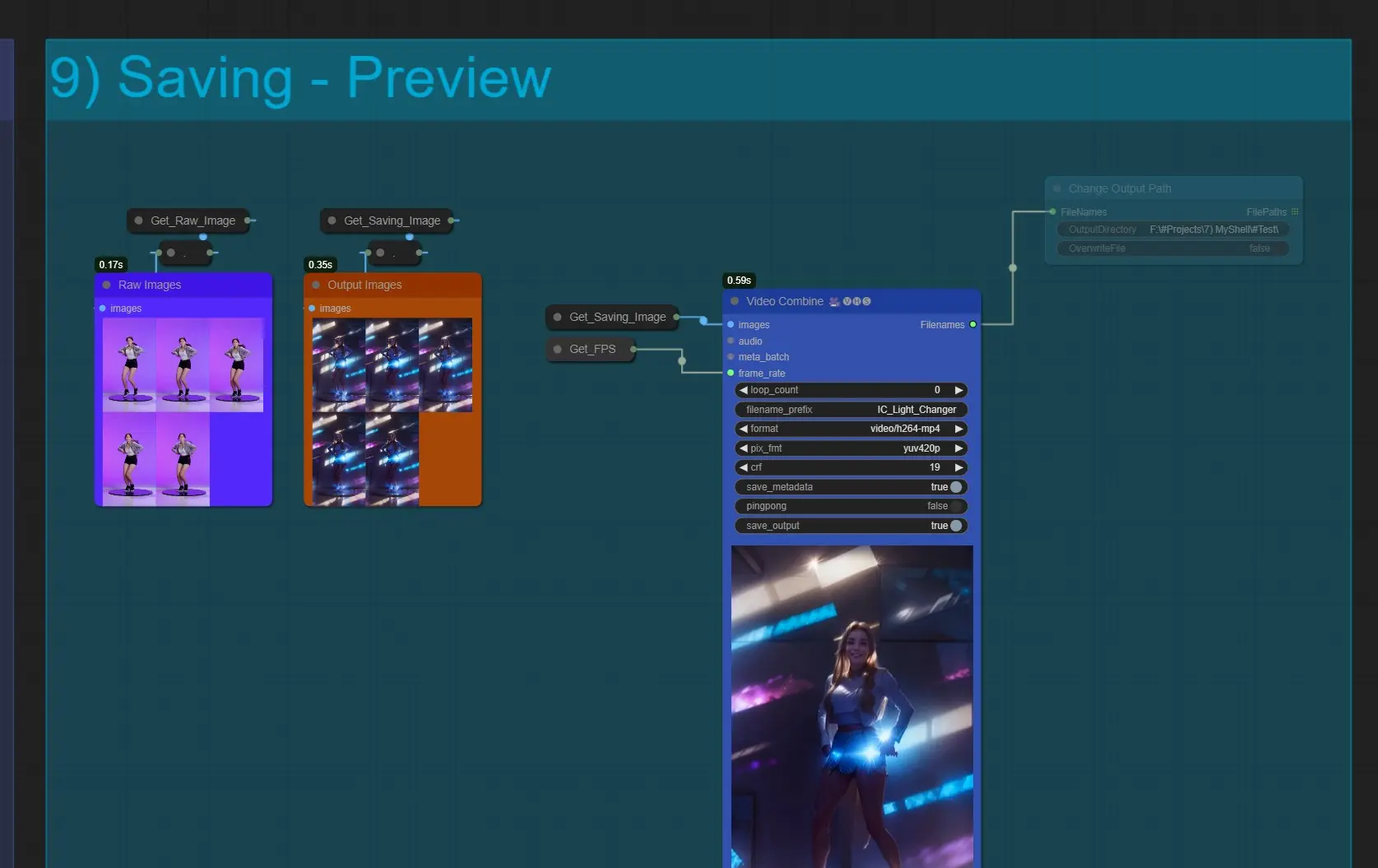

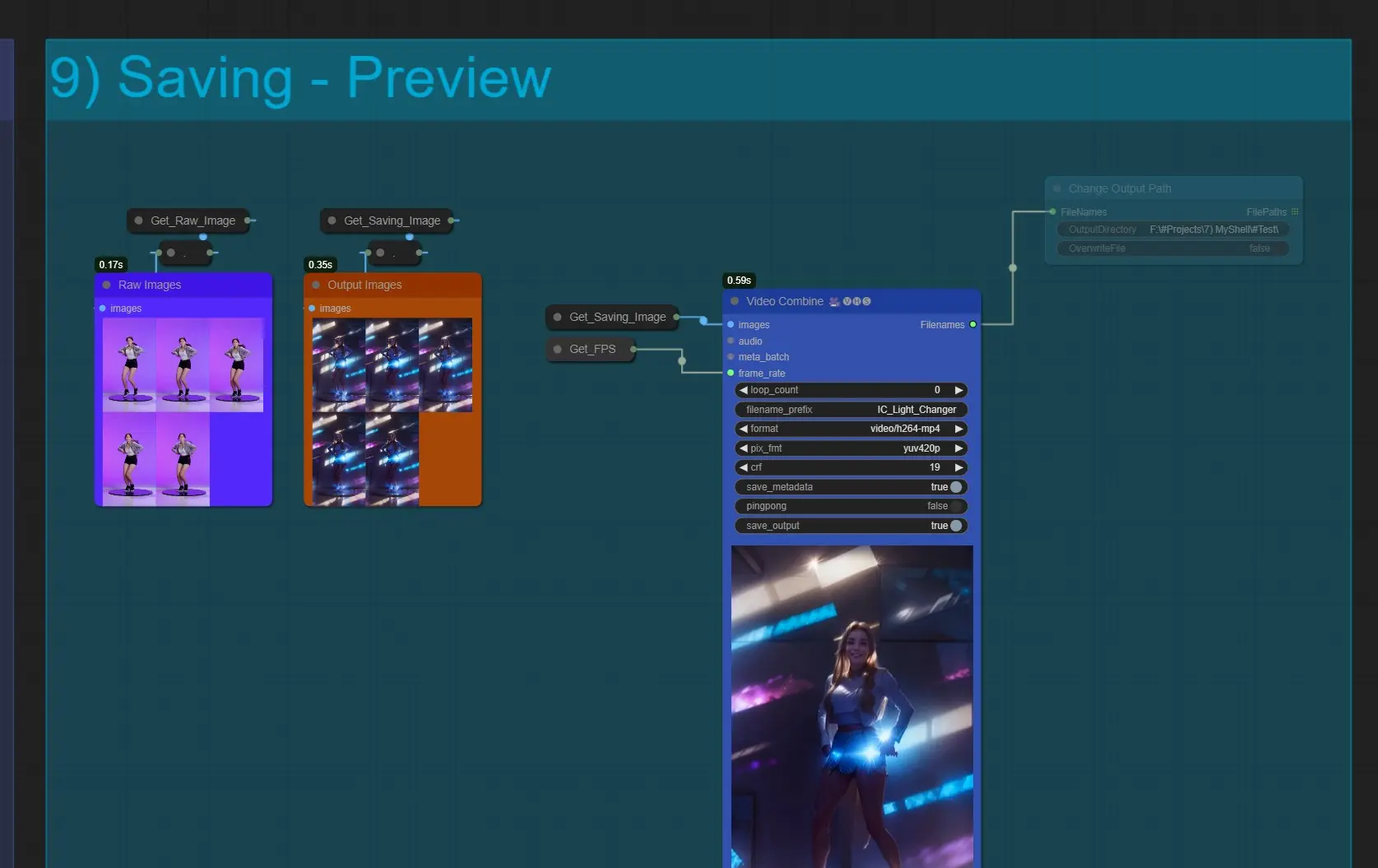

保存

- ビデオの結合: これにより、すべてのフレームがビデオ形式で出力されます。このノードが結合中に失敗する場合、フレームが多すぎてRAMが不足している可能性があります。その場合、フレームロードキャップを減らしてください。

- デフォルトでは ComfyUI > Outputs に保存されます。

- 出力パスの変更: 出力をカスタム保存場所に保存したい場合は、このノードをミュート解除します。

このワークフローの作者について

Jerry Davos

- YouTubeチャンネル: https://www.youtube.com/@jerrydavos

- Patreon: https://www.patreon.com/jerrydavos

連絡先

- Email: davos.jerry@gmail.com

- Discord: https://discord.gg/z9rgJyfPWJ